Verwenden Sie das Diffusionsmodell, um Texturen für 3D-Objekte zu generierenSie können es in nur einem Satz tun!

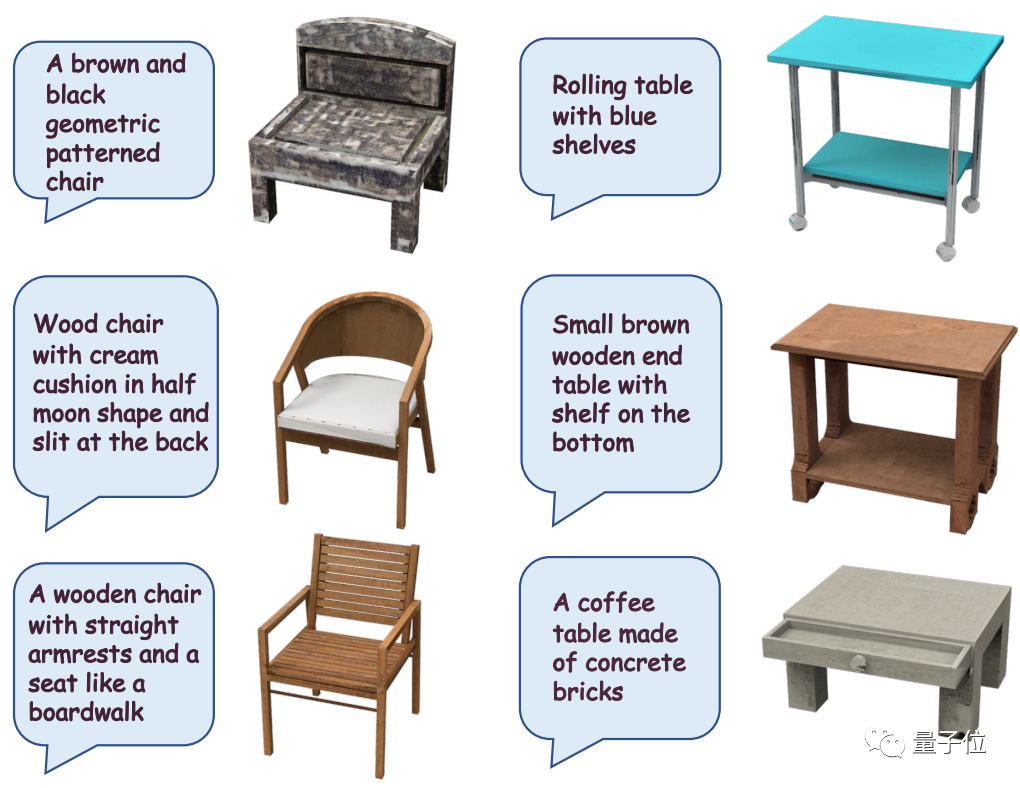

Wenn Sie „einen Stuhl mit einem braunen und schwarzen geometrischen Muster“ eingeben, fügt das Diffusionsmodell ihm sofort eine antike Textur hinzu und verleiht ihm ein historisches Gefühl

Die KI kann sich sofort vorstellen, Details hinzuzufügen Wenn Sie Holztexturen auf den Desktop übertragen möchten, können Sie auch nur einen Screenshot machen, ohne das Erscheinungsbild des Desktops zu zeigen.

Beim Entwerfen von Materialien müssen Sie mehrere Parameter wie Rauheit, Reflexion, Transparenz, Wirbel und Blüte berücksichtigen. Um gute Effekte zu entwerfen, müssen Sie nicht nur Kenntnisse über Materialien, Beleuchtung, Rendering usw. haben, sondern auch wiederholte Rendering-Tests und -Modifikationen durchführen. Wenn sich das Material ändert, muss das Design möglicherweise neu gestartet werden

Der Inhalt, der neu geschrieben werden muss, ist: der Effekt des Texturverlusts in der Spielszene

Allerdings sind die zuvor mithilfe künstlicher Intelligenz entworfenen Texturen nicht ideal Aussehen, also das Design Texturierung war schon immer eine zeitaufwändige und arbeitsintensive Aufgabe, die auch zu hohen Kosten geführt hat

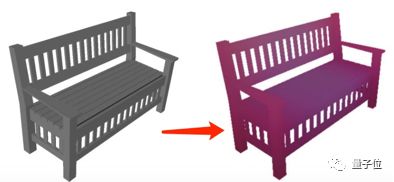

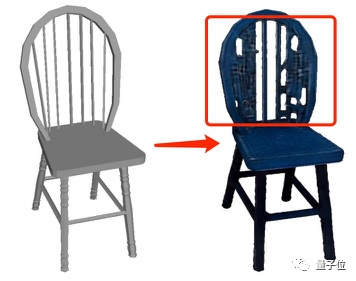

Während des Generierungsprozesses wird eine spezielle Bearbeitung der Geometrie des 3D-Objekts selbst durchgeführt, sodass die generierte Textur nicht perfekt zum Originalobjekt passen kann und seltsame Formen „herausspringen“

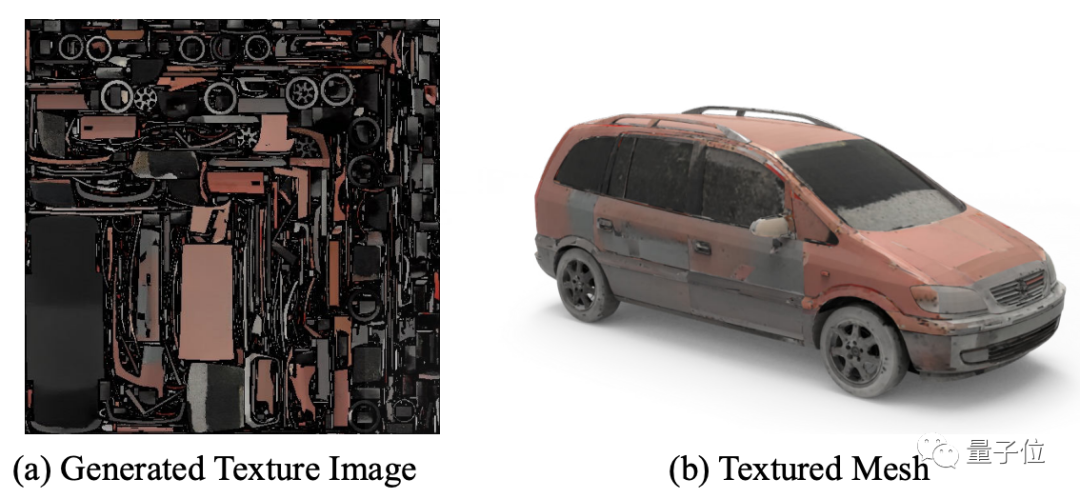

Daher in Um die Struktur des 3D-Objekts sicherzustellen. Um stabil und gleichzeitig detaillierte und realistische Texturen zu erzeugen, wurde im Rahmen dieser Forschung ein Framework namens „Punkt-UV-Diffusion“ entwickelt. Dieses Framework umfasst zwei Module: „Grobentwurf“ und „Endbearbeitung“, die beide auf dem

Dieses Framework umfasst zwei Module: „Grobentwurf“ und „Endbearbeitung“, die beide auf dem

basieren, die in beiden verwendeten Diffusionsmodelle sind jedoch unterschiedlich.

als Eingabebedingungen, um die Farbe jedes Punkts in der Objektform vorherzusagen und dadurch ein Rohbild zu generieren Texturbildeffekt:

Im Modul „Finishing“ wird auch ein 2D-Diffusionsmodell entwickelt, um das zuvor generierte grobe Texturbild und die Objektform als Eingabebedingungen weiter zu nutzen, um eine verfeinerte Textur zu erzeugen

Im Modul „Finishing“ wird auch ein 2D-Diffusionsmodell entwickelt, um das zuvor generierte grobe Texturbild und die Objektform als Eingabebedingungen weiter zu nutzen, um eine verfeinerte Textur zu erzeugen

Der Grund Der Grund für die Übernahme dieser Entwurfsstruktur liegt darin, dass der Rechenaufwand früherer Methoden zur Erzeugung hochauflösender Punktwolken normalerweise zu hoch ist

Der Grund Der Grund für die Übernahme dieser Entwurfsstruktur liegt darin, dass der Rechenaufwand früherer Methoden zur Erzeugung hochauflösender Punktwolken normalerweise zu hoch ist

Mit diesem zweistufigen Erzeugungsverfahren können nicht nur Rechenkosten eingespart werden, sondern auch die beiden Diffusionsmodelle können verwendet werden können ihre eigenen Rollen spielen, und im Vergleich zur vorherigen Methode bleibt nicht nur die Struktur des ursprünglichen 3D-Objekts erhalten, sondern auch die generierte Textur wird verfeinertWas die Steuerung des Generierungseffekts durch Eingabe von Text oder Bildern betrifft, ist dies der Fall „Beitrag“ von

CLIP. Um die ursprüngliche Bedeutung nicht zu verändern, muss der Inhalt ins Chinesische umgeschrieben werden. Was neu geschrieben werden muss, ist: Für die Eingabe verwendet der Autor zunächst das vorab trainierte CLIP-Modell, um den Einbettungsvektor des Textes oder Bildes zu extrahieren, gibt ihn dann in ein MLP-Modell ein und integriert schließlich die Bedingungen in das „grobe Design“. „ und „Endbearbeitung“ Im zweistufigen Netzwerk steuert

die durch Text und Bilder erzeugte Textur, um das endgültige Ausgabeergebnis zu erzielen. Welchen Implementierungseffekt hat dieses Modell also?

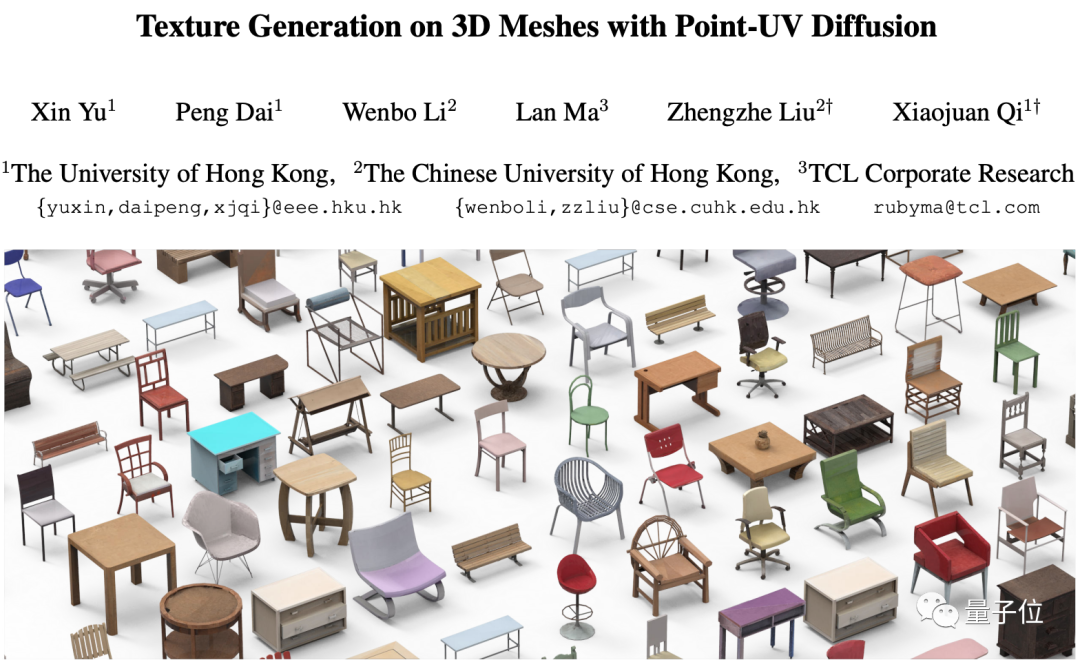

Werfen wir zunächst einen Blick auf den Erzeugungseffekt der Punkt-UV-Diffusion.

Wie aus den Renderings ersichtlich ist, gibt es neben Tischen und Stühlen auch eine Punkt-UV-Diffusion kann auch Objekte wie Autos generieren. Texturen, weitere Typen

kann nicht nur Texturen basierend auf Text generieren:

kann auch Textureffekte entsprechender Objekte basierend auf einem Bild generieren:

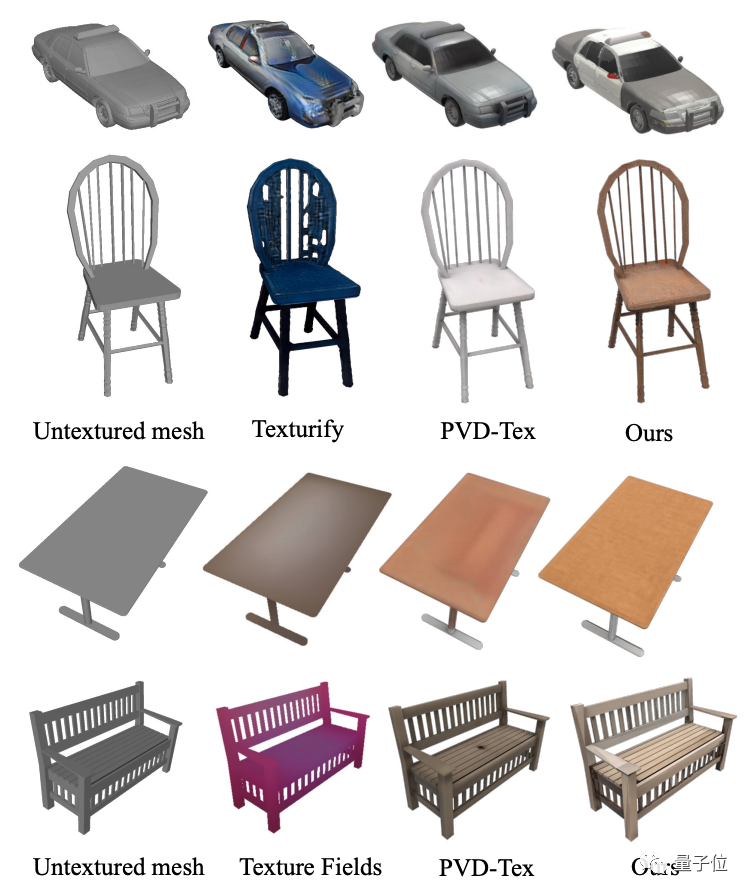

Die Autoren Generieren Sie auch Texturen für die Punkt-UV-Diffusion. Der Effekt wird mit der vorherigen Methode verglichen.

Durch Betrachten des Diagramms können Sie feststellen, dass im Vergleich zu anderen Texturerzeugungsmodellen wie Texture Fields, Texturify, PVD-Tex usw. Punkt- Die UV-Diffusion zeigt bessere Ergebnisse in Bezug auf Struktur und Feinheit

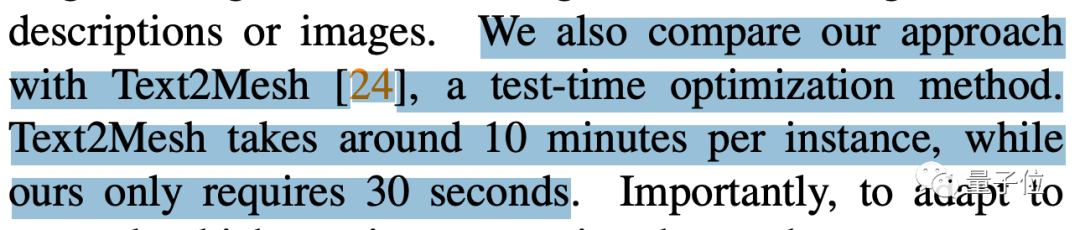

Der Autor erwähnte auch, dass die Punkt-UV-Diffusion bei derselben Hardwarekonfiguration im Vergleich zu Text2Mesh, dessen Berechnung 10 Minuten dauert, nur 30 Sekunden dauert.

Der Autor wies jedoch auch auf einige aktuelle Einschränkungen der Punkt-UV-Diffusion hin. Wenn die UV-Karte beispielsweise zu viele „fragmentierte“ Teile enthält, kann dennoch kein nahtloser Textureffekt erzielt werden. Da das Training auf 3D-Daten angewiesen ist und die aktuelle verfeinerte Qualität und Quantität von 3D-Daten nicht das Niveau von 2D-Daten erreichen kann, kann der generierte Effekt noch nicht den verfeinerten Effekt der 2D-Bilderzeugung erreichen

Für Interessierte Freunde dieser Forschung können auf den Link unten klicken, um das Papier zu lesen~

Papieradresse:https://cvmi-lab.github.io/Point-UV-Diffusion/paper/point_uv_diffusion.pdf

Projektadresse (noch im Aufbau): https://github.com/CVMI-Lab/Point-UV-Diffusion

Das obige ist der detaillierte Inhalt vonFühren Sie die Texturzuordnung von 3D-Modellen ganz einfach in 30 Sekunden durch, einfach und effizient!. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

So importieren Sie Daten in Access

So importieren Sie Daten in Access

Was bedeutet es, alle Cookies zu blockieren?

Was bedeutet es, alle Cookies zu blockieren?

die Funktionsnutzung

die Funktionsnutzung

Win11 „Mein Computer' zum Desktop-Tutorial hinzugefügt

Win11 „Mein Computer' zum Desktop-Tutorial hinzugefügt

So überprüfen Sie tote Links auf Websites

So überprüfen Sie tote Links auf Websites

Zu welcher Plattform gehört Tonglian Payment?

Zu welcher Plattform gehört Tonglian Payment?

Was ist der Unterschied zwischen Blockieren und Löschen bei WeChat?

Was ist der Unterschied zwischen Blockieren und Löschen bei WeChat?

Windows Ultimate

Windows Ultimate