Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Baichuan Intelligent hat das große Modell Baichuan2 veröffentlicht: Es ist Llama2 weit voraus und die Trainings-Slices sind ebenfalls Open Source

Baichuan Intelligent hat das große Modell Baichuan2 veröffentlicht: Es ist Llama2 weit voraus und die Trainings-Slices sind ebenfalls Open Source

Baichuan Intelligent hat das große Modell Baichuan2 veröffentlicht: Es ist Llama2 weit voraus und die Trainings-Slices sind ebenfalls Open Source

Als die Branche überrascht war, dass Baichuan Intelligent in durchschnittlich 28 Tagen ein großes Modell herausbrachte, gab das Unternehmen nicht auf.

Auf einer Pressekonferenz am Nachmittag des 6. September kündigte Baichuan Intelligence die offizielle Open Source des fein abgestimmten großen Baichuan-2-Modells an.

Zhang Bo, Akademiker der Chinesischen Akademie der Wissenschaften und Ehrendekan des Instituts für Künstliche Intelligenz der Tsinghua-Universität, war bei der Pressekonferenz.

Zhang Bo, Akademiker der Chinesischen Akademie der Wissenschaften und Ehrendekan des Instituts für Künstliche Intelligenz der Tsinghua-Universität, war bei der Pressekonferenz.

Dies ist eine weitere Neuerscheinung von Baichuan seit der Veröffentlichung des großen Modells Baichuan-53B im August. Zu den Open-Source-Modellen gehören Baichuan2-7B, Baichuan2-13B, Baichuan2-13B-Chat und ihre 4-Bit-quantisierten Versionen, und sie sind alle kostenlos und im Handel erhältlich.

Zusätzlich zur vollständigen Offenlegung des Modells hat Baichuan Intelligence dieses Mal auch den Check Point für das Modelltraining als Open Source bereitgestellt und den technischen Bericht zu Baichuan 2 veröffentlicht, in dem die Trainingsdetails des neuen Modells detailliert beschrieben werden. Wang Xiaochuan, Gründer und CEO von Baichuan Intelligence, äußerte die Hoffnung, dass dieser Schritt großen akademischen Institutionen, Entwicklern und Unternehmensanwendern helfen kann, ein tiefgreifendes Verständnis des Trainingsprozesses großer Modelle zu erlangen und die technologische Entwicklung großer Modelle besser voranzutreiben akademische Forschung und Gemeinschaften.

Baichuan 2 großes Modell Original-Link: https://github.com/baichuan-inc/Baichuan2

Technischer Bericht: https://cdn.baichuan-ai.com/paper/Baichuan2-technical-report.pdf

Heutige Open-Source-Modelle sind im Vergleich zu großen Modellen „kleiner“. Unter ihnen werden Baichuan2-7B-Base und Baichuan2-13B-Base beide auf der Grundlage von 2,6 Billionen hochwertigen mehrsprachigen Daten trainiert, wobei die vorherige Generation von Open-Source-Modellen beibehalten wird Aufgrund vieler Merkmale wie guter Generierungs- und Erstellungsfähigkeiten, reibungsloser Mehrrundendialogfähigkeiten und niedriger Bereitstellungsschwellen haben die beiden Modelle ihre Fähigkeiten in den Bereichen Mathematik, Codierung, Sicherheit, logisches Denken und semantisches Verständnis erheblich verbessert.

„Um es einfach auszudrücken: Das 7-Milliarden-Parametermodell von Baichuan7B ist bereits auf Augenhöhe mit dem 13-Milliarden-Parametermodell von LLaMA2 auf dem englischen Benchmark. Daher können wir das Kleine verwenden, um das Große zu machen, das kleine Modell entspricht dem.“ „Fähigkeit des großen Modells und im selben Körper Das quantitative Modell kann eine höhere Leistung erzielen und die Leistung von LLaMA2 umfassend übertreffen“, sagte Wang Xiaochuan.

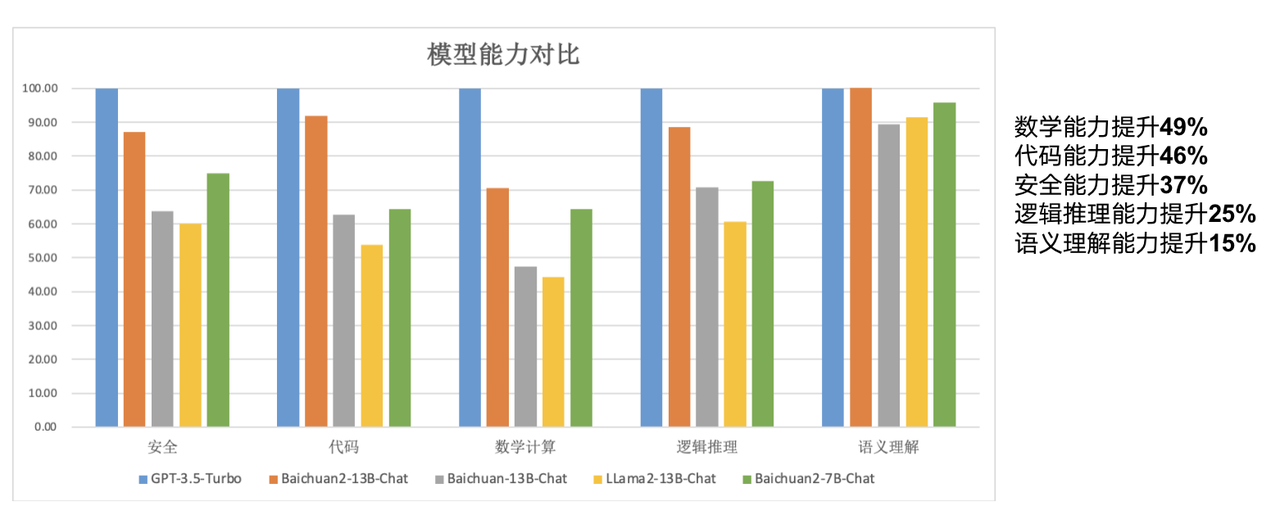

Im Vergleich zum 13B-Modell der vorherigen Generation hat Baichuan2-13B-Base seine mathematischen Fähigkeiten um 49 %, seine Codierungsfähigkeiten um 46 %, seine Sicherheitsfähigkeiten um 37 %, seine logischen Denkfähigkeiten um 25 % und seine semantischen Verständnisfähigkeiten um 15 % verbessert. .

Berichten zufolge haben Forscher von Baichuan Intelligence zahlreiche Optimierungen vorgenommen, von der Datenerfassung bis zur Feinabstimmung des neuen Modells.

„Wir haben auf mehr Erfahrungen aus früheren Suchvorgängen zurückgegriffen, eine Inhaltsqualitätsbewertung mit mehreren Granularitäten für eine große Menge an Modelltrainingsdaten durchgeführt, 260 Millionen T Korpusebene zum Trainieren von 7B- und 13B-Modellen verwendet und mehrsprachige Unterstützung hinzugefügt.“ sagte Wang Xiaochuan. „Wir können im Qianka A800-Cluster eine Trainingsleistung von 180 TFLOPS erreichen und die Maschinenauslastung übersteigt 50 %. Darüber hinaus haben wir auch viele Arbeiten zur Sicherheitsausrichtung abgeschlossen

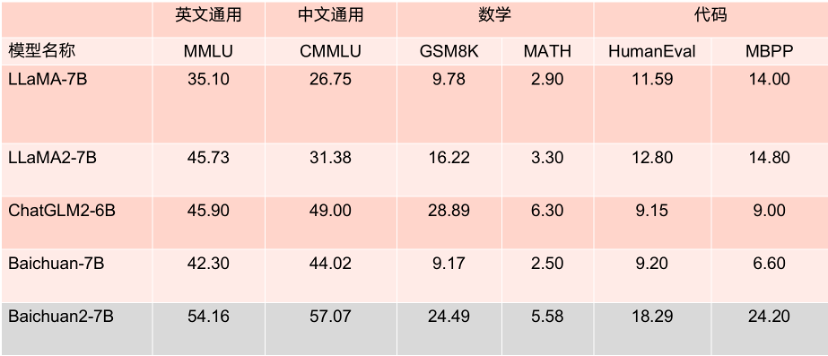

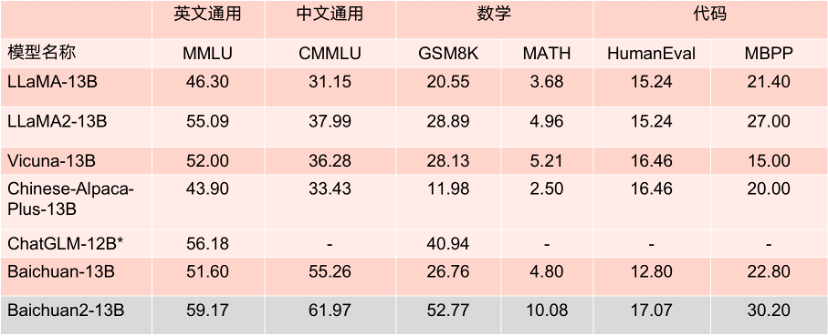

Die beiden Open-Source-Modelle sind dieses Mal weit verbreitet.“ Die Leistung auf der Bewertungsliste ist hervorragend. In mehreren maßgeblichen Bewertungsbenchmarks wie MMLU, CMMLU und GSM8K liegt es mit großem Abstand vor LLaMA2. Im Vergleich zu anderen Modellen mit der gleichen Anzahl von Parametern ist seine Leistung ebenfalls sehr hoch beeindruckend und seine Leistung ist deutlich besser als bei einem Konkurrenzprodukt mit dem gleichen Modell.

Was noch erwähnenswert ist, ist, dass Baichuan2-7B laut mehreren maßgeblichen englischen Bewertungsbenchmarks wie MMLU mit 13 Milliarden Parametern auf Augenhöhe mit LLaMA2 liegt, bei Standard-Englischaufgaben mit 7 Milliarden Parametern.

Benchmark-Ergebnisse des 7B-Parametermodells.

Benchmark-Ergebnisse des 13B-Parametermodells.

Baichuan2-7B und Baichuan2-13B stehen nicht nur der akademischen Forschung vollständig offen, sondern Entwickler können sie auch kostenlos kommerziell nutzen, nachdem sie per E-Mail eine offizielle kommerzielle Lizenz beantragt haben.

„Neben der Modellveröffentlichung hoffen wir auch, den akademischen Bereich stärker zu unterstützen“, sagte Wang Xiaochuan. „Zusätzlich zum technischen Bericht haben wir auch das Gewichtsparametermodell im Baichuan2-Trainingsprozess für große Modelle geöffnet. Dies kann jedem helfen, das Vortraining zu verstehen oder Feinabstimmungen und Verbesserungen durchzuführen. Dies ist auch das erste Mal in China.“ dass ein Unternehmen einen solchen Modelltrainingsprozess eröffnet hat. „Das Training großer Modelle umfasst mehrere Schritte wie die Erfassung umfangreicher, qualitativ hochwertiger Daten, das stabile Training großer Trainingscluster und die Optimierung des Modellalgorithmus.“ Jede Verbindung erfordert die Investition einer großen Menge an Talenten, Rechenleistung und anderen Ressourcen. Die hohen Kosten für das Training eines Modells von Grund auf haben die akademische Gemeinschaft daran gehindert, eingehende Forschung zum Training großer Modelle durchzuführen.

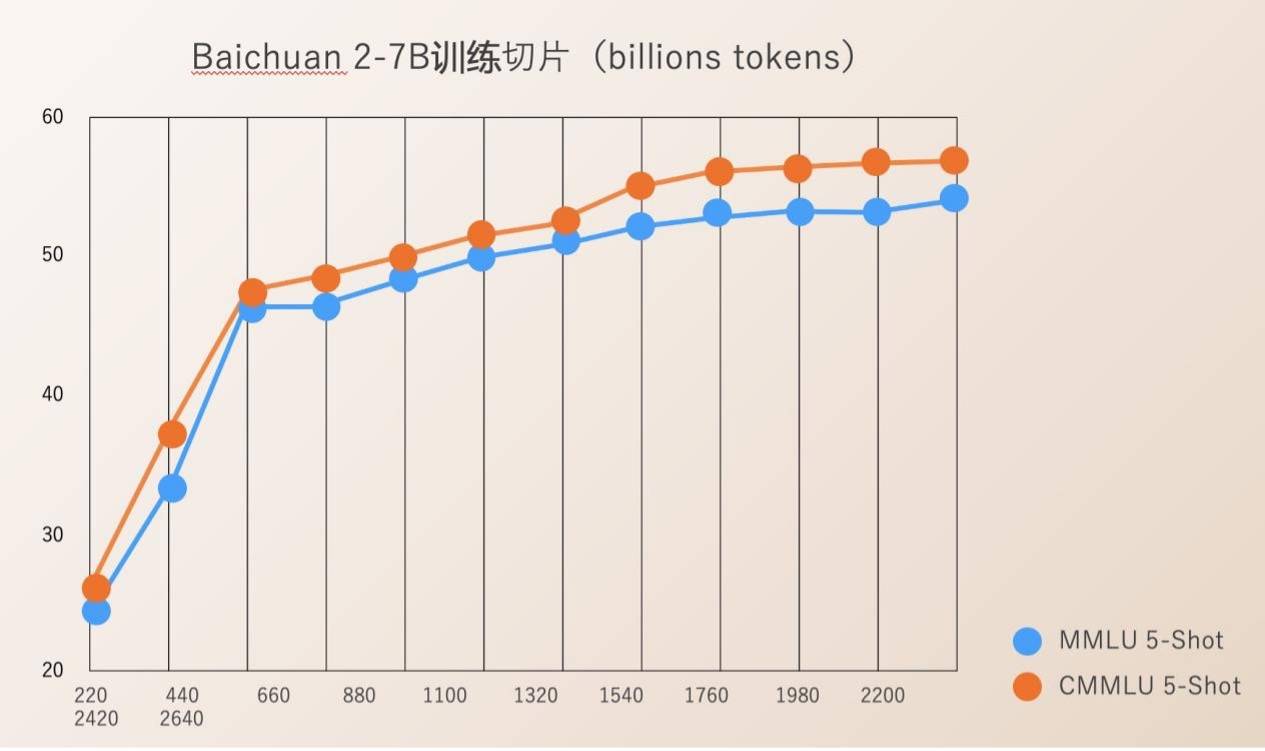

Baichuan Intelligence verfügt über Open-Source-Check Ponit für den gesamten Prozess des Modelltrainings von 220B bis 2640B. Dies ist für wissenschaftliche Forschungseinrichtungen von großem Wert, um den Trainingsprozess großer Modelle, die kontinuierliche Modellschulung und die Modellwertausrichtung usw. zu untersuchen, und kann den wissenschaftlichen Forschungsfortschritt inländischer großer Modelle fördern.

Früher gaben die meisten Open-Source-Modelle nur ihre eigenen Modellgewichte bekannt und selten erwähnte Trainingsdetails. Entwickler konnten nur begrenzte Feinabstimmungen durchführen, was die Durchführung eingehender Recherchen erschwerte.

Der von Baichuan Intelligence veröffentlichte technische Bericht zu Baichuan 2 beschreibt detailliert den gesamten Prozess des Baichuan 2-Trainings, einschließlich Datenverarbeitung, Optimierung der Modellstruktur, Skalierungsgesetz, Prozessindikatoren usw.

Seit seiner Gründung betrachtet Baichuan Intelligence die Förderung des Wohlstands der großen Modellökologie Chinas durch Open Source als eine wichtige Entwicklungsrichtung des Unternehmens. In weniger als vier Monaten seit seiner Gründung wurden zwei kostenlose kommerzielle chinesische Open-Source-Großmodelle, Baichuan-7B und Baichuan-13B, sowie ein durch die Suche erweitertes Großmodell Baichuan-53B veröffentlicht Es wird in vielen maßgeblichen Rezensionen bewertet und steht weit oben auf der Liste. Es wurde mehr als 5 Millionen Mal heruntergeladen.

Letzte Woche war die Einführung der ersten großformatigen Modellfotografie für den öffentlichen Dienst eine wichtige Neuigkeit im Technologiebereich. Unter den in diesem Jahr gegründeten großen Modellunternehmen ist Baichuan Intelligent das einzige, das im Rahmen der „Interim Measures for the Management of Generative Artificial Intelligence Services“ registriert wurde und offiziell Dienstleistungen für die Öffentlichkeit anbieten kann.

Mit branchenführenden grundlegenden F&E- und Innovationsfähigkeiten für große Modelle haben die beiden Open-Source-großen Baichuan-2-Modelle dieses Mal positive Reaktionen von vor- und nachgelagerten Unternehmen erhalten, darunter Tencent Cloud, Alibaba Cloud, Volcano Ark, Huawei, MediaTek und viele andere Namhafte Unternehmen Alle nahmen an dieser Konferenz teil und erzielten eine Zusammenarbeit mit Baichuan Intelligence. Berichten zufolge hat die Zahl der Downloads der großen Modelle von Baichuan Intelligence auf Hugging Face im vergangenen Monat 3,37 Millionen erreicht.

Nach dem vorherigen Plan von Baichuan Intelligence werden sie in diesem Jahr ein großes Modell mit 100 Milliarden Parametern veröffentlichen und im ersten Quartal nächsten Jahres eine „Superanwendung“ starten.

Das obige ist der detaillierte Inhalt vonBaichuan Intelligent hat das große Modell Baichuan2 veröffentlicht: Es ist Llama2 weit voraus und die Trainings-Slices sind ebenfalls Open Source. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1382

1382

52

52

Der Autor von ControlNet hat einen weiteren Hit! Der gesamte Prozess der Generierung eines Gemäldes aus einem Bild, der in zwei Tagen 1,4.000 Sterne verdient

Jul 17, 2024 am 01:56 AM

Der Autor von ControlNet hat einen weiteren Hit! Der gesamte Prozess der Generierung eines Gemäldes aus einem Bild, der in zwei Tagen 1,4.000 Sterne verdient

Jul 17, 2024 am 01:56 AM

Es ist ebenfalls ein Tusheng-Video, aber PaintsUndo ist einen anderen Weg gegangen. ControlNet-Autor LvminZhang begann wieder zu leben! Dieses Mal ziele ich auf den Bereich der Malerei. Das neue Projekt PaintsUndo hat nicht lange nach seinem Start 1,4.000 Sterne erhalten (die immer noch wahnsinnig steigen). Projektadresse: https://github.com/lllyasviel/Paints-UNDO Bei diesem Projekt gibt der Benutzer ein statisches Bild ein, und PaintsUndo kann Ihnen dabei helfen, automatisch ein Video des gesamten Malprozesses zu erstellen, vom Linienentwurf bis zum fertigen Produkt . Während des Zeichenvorgangs sind die Linienänderungen erstaunlich. Das Endergebnis des Videos ist dem Originalbild sehr ähnlich: Schauen wir uns eine vollständige Zeichnung an.

Die agentenlose Lösung von UIUC steht ganz oben auf der Liste der Open-Source-KI-Softwareentwickler und löst problemlos echte Programmierprobleme im SWE-Bench

Jul 17, 2024 pm 10:02 PM

Die agentenlose Lösung von UIUC steht ganz oben auf der Liste der Open-Source-KI-Softwareentwickler und löst problemlos echte Programmierprobleme im SWE-Bench

Jul 17, 2024 pm 10:02 PM

Die AIxiv-Kolumne ist eine Kolumne, in der diese Website akademische und technische Inhalte veröffentlicht. In den letzten Jahren sind in der AIxiv-Kolumne dieser Website mehr als 2.000 Berichte eingegangen, die Spitzenlabore großer Universitäten und Unternehmen auf der ganzen Welt abdecken und so den akademischen Austausch und die Verbreitung wirksam fördern. Wenn Sie hervorragende Arbeiten haben, die Sie teilen möchten, können Sie gerne einen Beitrag leisten oder uns für die Berichterstattung kontaktieren. Einreichungs-E-Mail: liyazhou@jiqizhixin.com; zhaoyunfeng@jiqizhixin.com Die Autoren dieses Artikels stammen alle aus dem Team von Lehrer Zhang Lingming an der University of Illinois in Urbana-Champaign, darunter: Steven Code Repair; Doktorand im vierten Jahr, Forscher

Posthume Arbeit des OpenAI Super Alignment Teams: Zwei große Modelle spielen ein Spiel und die Ausgabe wird verständlicher

Jul 19, 2024 am 01:29 AM

Posthume Arbeit des OpenAI Super Alignment Teams: Zwei große Modelle spielen ein Spiel und die Ausgabe wird verständlicher

Jul 19, 2024 am 01:29 AM

Wenn die Antwort des KI-Modells überhaupt unverständlich ist, würden Sie es wagen, sie zu verwenden? Da maschinelle Lernsysteme in immer wichtigeren Bereichen eingesetzt werden, wird es immer wichtiger zu zeigen, warum wir ihren Ergebnissen vertrauen können und wann wir ihnen nicht vertrauen sollten. Eine Möglichkeit, Vertrauen in die Ausgabe eines komplexen Systems zu gewinnen, besteht darin, vom System zu verlangen, dass es eine Interpretation seiner Ausgabe erstellt, die für einen Menschen oder ein anderes vertrauenswürdiges System lesbar ist, d. h. so vollständig verständlich, dass mögliche Fehler erkannt werden können gefunden. Um beispielsweise Vertrauen in das Justizsystem aufzubauen, verlangen wir von den Gerichten, dass sie klare und lesbare schriftliche Stellungnahmen abgeben, die ihre Entscheidungen erläutern und stützen. Für große Sprachmodelle können wir auch einen ähnlichen Ansatz verfolgen. Stellen Sie bei diesem Ansatz jedoch sicher, dass das Sprachmodell generiert wird

arXiv-Artikel können als „Barrage' gepostet werden, die Diskussionsplattform von Stanford alphaXiv ist online, LeCun gefällt es

Aug 01, 2024 pm 05:18 PM

arXiv-Artikel können als „Barrage' gepostet werden, die Diskussionsplattform von Stanford alphaXiv ist online, LeCun gefällt es

Aug 01, 2024 pm 05:18 PM

Prost! Wie ist es, wenn es bei einer Papierdiskussion auf Worte ankommt? Kürzlich haben Studenten der Stanford University alphaXiv erstellt, ein offenes Diskussionsforum für arXiv-Artikel, das es ermöglicht, Fragen und Kommentare direkt zu jedem arXiv-Artikel zu posten. Website-Link: https://alphaxiv.org/ Tatsächlich ist es nicht erforderlich, diese Website speziell zu besuchen. Ändern Sie einfach arXiv in einer beliebigen URL in alphaXiv, um den entsprechenden Artikel direkt im alphaXiv-Forum zu öffnen: Sie können die Absätze darin genau lokalisieren das Papier, Satz: Im Diskussionsbereich auf der rechten Seite können Benutzer Fragen stellen, um dem Autor Fragen zu den Ideen und Details des Papiers zu stellen. Sie können beispielsweise auch den Inhalt des Papiers kommentieren, wie zum Beispiel: „Gegeben an.“

Ein bedeutender Durchbruch in der Riemann-Hypothese! Tao Zhexuan empfiehlt dringend neue Arbeiten vom MIT und Oxford, und der 37-jährige Fields-Medaillengewinner nahm daran teil

Aug 05, 2024 pm 03:32 PM

Ein bedeutender Durchbruch in der Riemann-Hypothese! Tao Zhexuan empfiehlt dringend neue Arbeiten vom MIT und Oxford, und der 37-jährige Fields-Medaillengewinner nahm daran teil

Aug 05, 2024 pm 03:32 PM

Kürzlich gelang der Riemann-Hypothese, die als eines der sieben großen Probleme des Jahrtausends bekannt ist, ein neuer Durchbruch. Die Riemann-Hypothese ist ein sehr wichtiges ungelöstes Problem in der Mathematik, das sich auf die genauen Eigenschaften der Verteilung von Primzahlen bezieht (Primzahlen sind Zahlen, die nur durch 1 und sich selbst teilbar sind, und sie spielen eine grundlegende Rolle in der Zahlentheorie). In der heutigen mathematischen Literatur gibt es mehr als tausend mathematische Thesen, die auf der Aufstellung der Riemann-Hypothese (oder ihrer verallgemeinerten Form) basieren. Mit anderen Worten: Sobald die Riemann-Hypothese und ihre verallgemeinerte Form bewiesen sind, werden diese mehr als tausend Sätze als Theoreme etabliert, die einen tiefgreifenden Einfluss auf das Gebiet der Mathematik haben werden, und wenn sich die Riemann-Hypothese als falsch erweist, dann unter anderem Auch diese Sätze werden teilweise ihre Gültigkeit verlieren. Neuer Durchbruch kommt von MIT-Mathematikprofessor Larry Guth und der Universität Oxford

Axiomatisches Training ermöglicht es LLM, kausales Denken zu erlernen: Das 67-Millionen-Parameter-Modell ist vergleichbar mit der Billionen-Parameter-Ebene GPT-4

Jul 17, 2024 am 10:14 AM

Axiomatisches Training ermöglicht es LLM, kausales Denken zu erlernen: Das 67-Millionen-Parameter-Modell ist vergleichbar mit der Billionen-Parameter-Ebene GPT-4

Jul 17, 2024 am 10:14 AM

Zeigen Sie LLM die Kausalkette und es lernt die Axiome. KI hilft Mathematikern und Wissenschaftlern bereits bei der Forschung. Beispielsweise hat der berühmte Mathematiker Terence Tao wiederholt seine Forschungs- und Forschungserfahrungen mit Hilfe von KI-Tools wie GPT geteilt. Damit KI in diesen Bereichen konkurrenzfähig sein kann, sind starke und zuverlässige Fähigkeiten zum kausalen Denken unerlässlich. Die in diesem Artikel vorgestellte Forschung ergab, dass ein Transformer-Modell, das auf die Demonstration des kausalen Transitivitätsaxioms für kleine Graphen trainiert wurde, auf das Transitivitätsaxiom für große Graphen verallgemeinern kann. Mit anderen Worten: Wenn der Transformer lernt, einfache kausale Überlegungen anzustellen, kann er für komplexere kausale Überlegungen verwendet werden. Der vom Team vorgeschlagene axiomatische Trainingsrahmen ist ein neues Paradigma zum Erlernen des kausalen Denkens auf der Grundlage passiver Daten, nur mit Demonstrationen

Um ein neues wissenschaftliches und komplexes Frage-Antwort-Benchmark- und Bewertungssystem für große Modelle bereitzustellen, haben UNSW, Argonne, die University of Chicago und andere Institutionen gemeinsam das SciQAG-Framework eingeführt

Jul 25, 2024 am 06:42 AM

Um ein neues wissenschaftliches und komplexes Frage-Antwort-Benchmark- und Bewertungssystem für große Modelle bereitzustellen, haben UNSW, Argonne, die University of Chicago und andere Institutionen gemeinsam das SciQAG-Framework eingeführt

Jul 25, 2024 am 06:42 AM

Herausgeber | Der Frage-Antwort-Datensatz (QA) von ScienceAI spielt eine entscheidende Rolle bei der Förderung der Forschung zur Verarbeitung natürlicher Sprache (NLP). Hochwertige QS-Datensätze können nicht nur zur Feinabstimmung von Modellen verwendet werden, sondern auch effektiv die Fähigkeiten großer Sprachmodelle (LLMs) bewerten, insbesondere die Fähigkeit, wissenschaftliche Erkenntnisse zu verstehen und zu begründen. Obwohl es derzeit viele wissenschaftliche QS-Datensätze aus den Bereichen Medizin, Chemie, Biologie und anderen Bereichen gibt, weisen diese Datensätze immer noch einige Mängel auf. Erstens ist das Datenformular relativ einfach, die meisten davon sind Multiple-Choice-Fragen. Sie sind leicht auszuwerten, schränken jedoch den Antwortauswahlbereich des Modells ein und können die Fähigkeit des Modells zur Beantwortung wissenschaftlicher Fragen nicht vollständig testen. Im Gegensatz dazu offene Fragen und Antworten

Das erste Mamba-basierte MLLM ist da! Modellgewichte, Trainingscode usw. waren alle Open Source

Jul 17, 2024 am 02:46 AM

Das erste Mamba-basierte MLLM ist da! Modellgewichte, Trainingscode usw. waren alle Open Source

Jul 17, 2024 am 02:46 AM

Die AIxiv-Kolumne ist eine Kolumne, in der diese Website akademische und technische Inhalte veröffentlicht. In den letzten Jahren sind in der AIxiv-Kolumne dieser Website mehr als 2.000 Berichte eingegangen, die Spitzenlabore großer Universitäten und Unternehmen auf der ganzen Welt abdecken und so den akademischen Austausch und die Verbreitung wirksam fördern. Wenn Sie hervorragende Arbeiten haben, die Sie teilen möchten, können Sie gerne einen Beitrag leisten oder uns für die Berichterstattung kontaktieren. E-Mail-Adresse: liyazhou@jiqizhixin.com; zhaoyunfeng@jiqizhixin.com. Einleitung In den letzten Jahren hat die Anwendung multimodaler großer Sprachmodelle (MLLM) in verschiedenen Bereichen bemerkenswerte Erfolge erzielt. Als Grundmodell für viele nachgelagerte Aufgaben besteht aktuelles MLLM jedoch aus dem bekannten Transformer-Netzwerk, das