Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Meta veröffentlicht FACET-Datensatz zur Bewertung der KI-Fairness

Meta veröffentlicht FACET-Datensatz zur Bewertung der KI-Fairness

Meta veröffentlicht FACET-Datensatz zur Bewertung der KI-Fairness

Nachrichten vom 4. September: Meta hat kürzlich einen Open-Source-Datensatz namens FACET veröffentlicht, der Forschern dabei helfen soll, Vorurteile in Computer-Vision-Modellen zu prüfen.

In einem Blogbeitrag erläuterte Meta, dass es schwierig sei, die Fairness von KI mithilfe aktueller Benchmarking-Methoden zu beurteilen. Laut Meta wird FACET diese Aufgabe vereinfachen, indem es einen großen Bewertungsdatensatz bereitstellt, den Forscher zur Prüfung verschiedener Arten von Computer-Vision-Modellen verwenden können.

Meta-Forscher führen in einem Blogbeitrag ausführlich aus: „Der Datensatz besteht aus 32.000 Bildern von 50.000 Personen, die von erfahrenen menschlichen Annotatoren mit demografischen Attributen wie wahrgenommener Geschlechtsdarstellung, wahrgenommener Altersgruppe, zusätzlichen physischen Attributen wie wahrgenommener Hautfarbe, Frisur, und personenbezogene Kategorien wie Basketballspieler, Ärzte usw. FACET enthält auch Personen-, Haar- und Kleidungsetiketten für 69.000 Masken in SA-1B. Computer-Vision-Modelle verarbeiten Fotos in FACET, um auf Fairness-Probleme zu prüfen. Von dort aus können sie Analysen durchführen, um festzustellen, ob die Genauigkeit der Modellergebnisse von Foto zu Foto variiert. Diese Abweichung in der Genauigkeit könnte ein Zeichen dafür sein, dass die KI voreingenommen ist.

Forscher können diesen Datensatz verwenden, um Verzerrungen in neuronalen Netzen zu erkennen, die für die Klassifizierung optimiert sind, also die Aufgabe, ähnliche Bilder zu gruppieren. Darüber hinaus erleichtert es die Bewertung von Objekterkennungsmodellen. Dieses Modell ist darauf ausgelegt, interessante Elemente auf Fotos automatisch zu erkennen.

FACET kann auch KI-Anwendungen prüfen, die Instanzsegmentierung und visuelle Erdung durchführen, zwei spezielle Objekterkennungsaufgaben. Bei der Instanzsegmentierung werden interessante Elemente in einem Foto hervorgehoben, beispielsweise durch das Zeichnen eines Rahmens um sie herum. Das Vision-Basismodell wiederum ist ein neuronales Netzwerk, das Fotos nach Objekten durchsucht, die Benutzer in natürlicher Sprache beschreiben.

Meta-Forscher sagten: „Während FACET nur zu Forschungsbewertungszwecken dient und nicht für Schulungen verwendet werden kann, besteht unser Ziel bei der Veröffentlichung des Datensatzes und des Datensatzbrowsers darin, dass FACET zu einem Standard-Benchmark für die Fairnessbewertung von Computer-Vision-Modellen werden kann.“

Das obige ist der detaillierte Inhalt vonMeta veröffentlicht FACET-Datensatz zur Bewertung der KI-Fairness. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

Bytedance Cutting führt SVIP-Supermitgliedschaft ein: 499 Yuan für ein fortlaufendes Jahresabonnement, das eine Vielzahl von KI-Funktionen bietet

Jun 28, 2024 am 03:51 AM

Bytedance Cutting führt SVIP-Supermitgliedschaft ein: 499 Yuan für ein fortlaufendes Jahresabonnement, das eine Vielzahl von KI-Funktionen bietet

Jun 28, 2024 am 03:51 AM

Diese Seite berichtete am 27. Juni, dass Jianying eine von FaceMeng Technology, einer Tochtergesellschaft von ByteDance, entwickelte Videobearbeitungssoftware ist, die auf der Douyin-Plattform basiert und grundsätzlich kurze Videoinhalte für Benutzer der Plattform produziert Windows, MacOS und andere Betriebssysteme. Jianying kündigte offiziell die Aktualisierung seines Mitgliedschaftssystems an und führte ein neues SVIP ein, das eine Vielzahl von KI-Schwarztechnologien umfasst, wie z. B. intelligente Übersetzung, intelligente Hervorhebung, intelligente Verpackung, digitale menschliche Synthese usw. Preislich beträgt die monatliche Gebühr für das Clipping von SVIP 79 Yuan, die Jahresgebühr 599 Yuan (Hinweis auf dieser Website: entspricht 49,9 Yuan pro Monat), das fortlaufende Monatsabonnement beträgt 59 Yuan pro Monat und das fortlaufende Jahresabonnement beträgt 499 Yuan pro Jahr (entspricht 41,6 Yuan pro Monat). Darüber hinaus erklärte der Cut-Beamte auch, dass diejenigen, die den ursprünglichen VIP abonniert haben, das Benutzererlebnis verbessern sollen

Kontexterweiterter KI-Codierungsassistent mit Rag und Sem-Rag

Jun 10, 2024 am 11:08 AM

Kontexterweiterter KI-Codierungsassistent mit Rag und Sem-Rag

Jun 10, 2024 am 11:08 AM

Verbessern Sie die Produktivität, Effizienz und Genauigkeit der Entwickler, indem Sie eine abrufgestützte Generierung und ein semantisches Gedächtnis in KI-Codierungsassistenten integrieren. Übersetzt aus EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG, Autor JanakiramMSV. Obwohl grundlegende KI-Programmierassistenten natürlich hilfreich sind, können sie oft nicht die relevantesten und korrektesten Codevorschläge liefern, da sie auf einem allgemeinen Verständnis der Softwaresprache und den gängigsten Mustern beim Schreiben von Software basieren. Der von diesen Coding-Assistenten generierte Code eignet sich zur Lösung der von ihnen zu lösenden Probleme, entspricht jedoch häufig nicht den Coding-Standards, -Konventionen und -Stilen der einzelnen Teams. Dabei entstehen häufig Vorschläge, die geändert oder verfeinert werden müssen, damit der Code in die Anwendung übernommen wird

Kann LLM durch Feinabstimmung wirklich neue Dinge lernen: Die Einführung neuen Wissens kann dazu führen, dass das Modell mehr Halluzinationen hervorruft

Jun 11, 2024 pm 03:57 PM

Kann LLM durch Feinabstimmung wirklich neue Dinge lernen: Die Einführung neuen Wissens kann dazu führen, dass das Modell mehr Halluzinationen hervorruft

Jun 11, 2024 pm 03:57 PM

Large Language Models (LLMs) werden auf riesigen Textdatenbanken trainiert und erwerben dort große Mengen an realem Wissen. Dieses Wissen wird in ihre Parameter eingebettet und kann dann bei Bedarf genutzt werden. Das Wissen über diese Modelle wird am Ende der Ausbildung „verdinglicht“. Am Ende des Vortrainings hört das Modell tatsächlich auf zu lernen. Richten Sie das Modell aus oder verfeinern Sie es, um zu erfahren, wie Sie dieses Wissen nutzen und natürlicher auf Benutzerfragen reagieren können. Aber manchmal reicht Modellwissen nicht aus, und obwohl das Modell über RAG auf externe Inhalte zugreifen kann, wird es als vorteilhaft angesehen, das Modell durch Feinabstimmung an neue Domänen anzupassen. Diese Feinabstimmung erfolgt mithilfe von Eingaben menschlicher Annotatoren oder anderer LLM-Kreationen, wobei das Modell auf zusätzliches Wissen aus der realen Welt trifft und dieses integriert

Das neue erschwingliche Meta Quest 3S VR-Headset erscheint bei FCC, was auf eine baldige Markteinführung hindeutet

Sep 04, 2024 am 06:51 AM

Das neue erschwingliche Meta Quest 3S VR-Headset erscheint bei FCC, was auf eine baldige Markteinführung hindeutet

Sep 04, 2024 am 06:51 AM

Die Meta Connect 2024-Veranstaltung findet vom 25. bis 26. September statt. Bei dieser Veranstaltung wird das Unternehmen voraussichtlich ein neues erschwingliches Virtual-Reality-Headset vorstellen. Gerüchten zufolge handelt es sich bei dem VR-Headset um das Meta Quest 3S, das offenbar auf der FCC-Liste aufgetaucht ist. Dieser Vorschlag

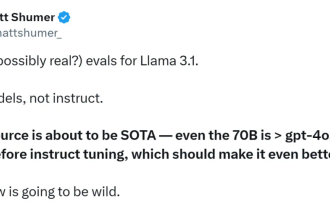

Das erste Open-Source-Modell, das das GPT4o-Niveau übertrifft! Llama 3.1 durchgesickert: 405 Milliarden Parameter, Download-Links und Modellkarten sind verfügbar

Jul 23, 2024 pm 08:51 PM

Das erste Open-Source-Modell, das das GPT4o-Niveau übertrifft! Llama 3.1 durchgesickert: 405 Milliarden Parameter, Download-Links und Modellkarten sind verfügbar

Jul 23, 2024 pm 08:51 PM

Machen Sie Ihre GPU bereit! Llama3.1 ist endlich erschienen, aber die Quelle ist nicht offiziell von Meta. Heute gingen die durchgesickerten Nachrichten über das neue Llama-Großmodell auf Reddit viral. Zusätzlich zum Basismodell enthält es auch Benchmark-Ergebnisse von 8B, 70B und den maximalen Parameter von 405B. Die folgende Abbildung zeigt die Vergleichsergebnisse jeder Version von Llama3.1 mit OpenAIGPT-4o und Llama38B/70B. Es ist ersichtlich, dass selbst die 70B-Version in mehreren Benchmarks GPT-4o übertrifft. Bildquelle: https://x.com/mattshumer_/status/1815444612414087294 Offensichtlich Version 3.1 von 8B und 70

Um ein neues wissenschaftliches und komplexes Frage-Antwort-Benchmark- und Bewertungssystem für große Modelle bereitzustellen, haben UNSW, Argonne, die University of Chicago und andere Institutionen gemeinsam das SciQAG-Framework eingeführt

Jul 25, 2024 am 06:42 AM

Um ein neues wissenschaftliches und komplexes Frage-Antwort-Benchmark- und Bewertungssystem für große Modelle bereitzustellen, haben UNSW, Argonne, die University of Chicago und andere Institutionen gemeinsam das SciQAG-Framework eingeführt

Jul 25, 2024 am 06:42 AM

Herausgeber | Der Frage-Antwort-Datensatz (QA) von ScienceAI spielt eine entscheidende Rolle bei der Förderung der Forschung zur Verarbeitung natürlicher Sprache (NLP). Hochwertige QS-Datensätze können nicht nur zur Feinabstimmung von Modellen verwendet werden, sondern auch effektiv die Fähigkeiten großer Sprachmodelle (LLMs) bewerten, insbesondere die Fähigkeit, wissenschaftliche Erkenntnisse zu verstehen und zu begründen. Obwohl es derzeit viele wissenschaftliche QS-Datensätze aus den Bereichen Medizin, Chemie, Biologie und anderen Bereichen gibt, weisen diese Datensätze immer noch einige Mängel auf. Erstens ist das Datenformular relativ einfach, die meisten davon sind Multiple-Choice-Fragen. Sie sind leicht auszuwerten, schränken jedoch den Antwortauswahlbereich des Modells ein und können die Fähigkeit des Modells zur Beantwortung wissenschaftlicher Fragen nicht vollständig testen. Im Gegensatz dazu offene Fragen und Antworten

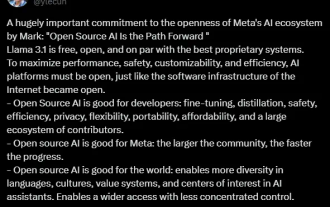

Das stärkste Modell Llama 3.1 405B wird offiziell veröffentlicht, Zuckerberg: Open Source leitet eine neue Ära ein

Jul 24, 2024 pm 08:23 PM

Das stärkste Modell Llama 3.1 405B wird offiziell veröffentlicht, Zuckerberg: Open Source leitet eine neue Ära ein

Jul 24, 2024 pm 08:23 PM

Gerade jetzt wurde das lang erwartete Llama 3.1 offiziell veröffentlicht! Meta gab offiziell bekannt, dass „Open Source eine neue Ära einläutet“. Im offiziellen Blog sagte Meta: „Bis heute sind große Open-Source-Sprachmodelle hinsichtlich Funktionalität und Leistung meist hinter geschlossenen Modellen zurückgeblieben. Jetzt läuten wir eine neue Ära ein, die von Open Source angeführt wird. Wir haben MetaLlama3.1405B öffentlich veröffentlicht.“ , von dem wir glauben, dass es sich um das größte und leistungsfähigste Open-Source-Basismodell der Welt handelt, die Gesamtzahl der Downloads aller Llama-Versionen hat gerade 300 Millionen Mal überschritten, und wir haben gerade erst damit begonnen, eine zu schreiben Artikel. Langer Artikel „OpenSourceAIIsthePathForward“,

Analyst bespricht Einführungspreise für das gemunkelte Meta Quest 3S VR-Headset

Aug 27, 2024 pm 09:35 PM

Analyst bespricht Einführungspreise für das gemunkelte Meta Quest 3S VR-Headset

Aug 27, 2024 pm 09:35 PM

Seit Metas Erstveröffentlichung von Quest 3 (aktuell 499,99 $ bei Amazon) ist mittlerweile über ein Jahr vergangen. Seitdem hat Apple das deutlich teurere Vision Pro ausgeliefert, während Byte Dance nun in China die Pico 4 Ultra vorgestellt hat. Es gibt jedoch eine