Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Die Statistiklegende C.R. Rao ist verstorben. Er war Zeuge der jahrhundertealten Geschichte der Statistik

Die Statistiklegende C.R. Rao ist verstorben. Er war Zeuge der jahrhundertealten Geschichte der Statistik

Die Statistiklegende C.R. Rao ist verstorben. Er war Zeuge der jahrhundertealten Geschichte der Statistik

Der legendäre Meister der Statistik C. R. Rao ist im Alter von 102 Jahren gestorben

Jeder, der Statistik studiert hat, kennt seinen Namen –

Die Cramér-Rao-Ungleichung ist nach ihm und Harald Cramér benannt

Ein Satz, den er geschrieben hat Auf der Titelseite von „Statistik und Wahrheit“ ist in der chinesischen Welt weit verbreitet:

Letztendlich ist alles Wissen Geschichte;

Im abstrakten Sinne ist jede Wissenschaft Mathematik;

In einer rationalen Welt sind es alle Urteile Statistiken.

Von 1920 bis 2023 war Professor Raos Leben fast synchron mit der gesamten Entwicklungsgeschichte der modernen Statistik

Im Jahr 2021 bewertete ein im „International Statistical Review“ veröffentlichter Artikel sein Leben als „Statistik“. Ein Jahrhundert des Lernens „

Seine Karriere ist eng mit der Geschichte der modernen Statistik verbunden und deckt die Entwicklung von der Ära von Pearson und Fisher bis zur Ära von Big Data und künstlicher Intelligenz ab.

Legendärer Statistiker

Rao Mr. wurde in Indien geboren September 1920

Seine Karriere in der Statistik begann in den 1940er Jahren: Er erwarb zunächst einen Master-Abschluss in Mathematik an der Universität Andhra und 1943 einen Master-Abschluss in Statistik an der Universität Kalkutta und ging dann nach Cambridge, England, um an der King's University zu promovieren College, Universität, unter der Leitung von Ronald Fisher, einem der Begründer der modernen Statistik. Bereits zu Beginn zeigte Rao außergewöhnliches Talent

1943 bestand er seine Masterarbeit in Statistik an der Universität von Kalkutta mit einer Punktzahl von 87 %. Dieser Rekord wurde von der Universität Kalkutta noch nicht gebrochen. Der Rezensent bewertete diese Arbeit auch mit „PhD-Niveau“

Im Jahr 1945 veröffentlichte Rao, der damals erst 25 Jahre alt war, eine wichtige statistische Arbeit mit dem Titel „Achieverable Accuracy in Information and Statistical Parameter Estimation“

In dieser 10- Auf dieser Seite bewies Rao die

Cramér-Rao-Ungleichungund den Rao-Blackwell-Theorem. Beides sind wichtige Bestandteile der modernen statistischen Methodik. Die Cramér-Rao-Ungleichung liefert eine Untergrenze für den Fehler bei der unverzerrten Parameterschätzung und stellt einen Maßstab für die Leistung des Schätzers dar. Die Varianz eines Schätzers kann nicht kleiner als diese Untergrenze sein

Das Rao-Blackwell-Theorem beschreibt, wie eine beliebige grobe Schätzung in eine Schätzung umgewandelt wird, die durch das Kriterium des mittleren quadratischen Fehlers oder ähnliche Kriterien optimiert wird. Die Kernidee besteht darin, die effektiven Informationen in den Daten zur Schätzung zu verwenden. Im Vergleich zur direkten Verwendung aller Daten ist der Effekt besser. Dieser Artikel legt auch den Rahmen für die Theorie der Informationsgeometrie fest. Informationsgeometrie ist in der aktuellen Forschung im Bereich der künstlichen Intelligenz weit verbreitet und wurde auch für die Messung des Higgs-Bosons im Large Hadron Collider verwendet.

Betrachten Sie die parametrisierte Familie als Riemannsche Mannigfaltigkeit und die Fisher-Informationsmatrix als Riemannschen metrischen Tensor.

Vorgeschlagen, die Fisher-Rao-Distanz zu verwenden, um die Differenz zwischen zwei Wahrscheinlichkeitsverteilungen zu messen.

Dieser Artikel ist eine der frühesten Arbeiten zur Anwendung von Methoden der Differentialgeometrie auf probabilistische Modelle.

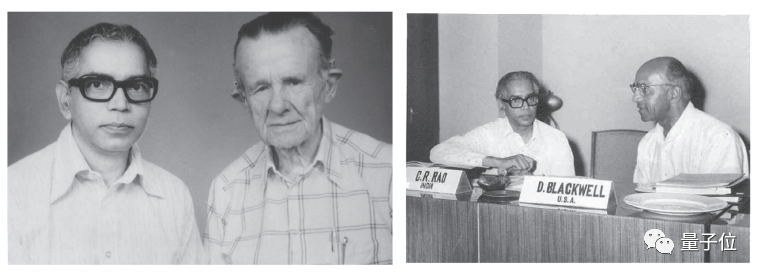

- Der Inhalt, der neu geschrieben werden muss, ist: Raos Foto mit Cramér und Blackwell

- 1946 ging Rao nach Cambridge und wurde Schüler von Fisher. 1948 schlug er unter Fishers Anleitung den berühmten „

- Score Test (Score Test)“ vor.

Score-Test ist eine der drei Hauptmethoden zum Testen statistischer Hypothesen

Score-Test ist eine der drei Hauptmethoden zum Testen statistischer Hypothesen

, die die Einschränkungen statistischer Parameter basierend auf dem Gradienten der Wahrscheinlichkeitsfunktion bewertet. Im Vergleich zum Wald-Test und dem Likelihood-Ratio-Test liegt sein Hauptvorteil in der Bequemlichkeit der BerechnungFür heutige Statistikpraktiker kann man sagen, dass der Score-Test ein wesentliches statistisches Grundwissen darstellt

Es ist dieses Jahr, 102 Jahre alt Professor Rao gewann den International Prize in Statistics, die höchste Auszeichnung für Leistungen in der Statistik.Der Grund für die Auszeichnung ist:

Seine Arbeit vor mehr als 70 Jahren hat immer noch tiefgreifende Auswirkungen auf die wissenschaftliche Gemeinschaft.Seine Arbeit aus dem Jahr 1945, die im Bulletin der Calcutta Mathematical Society veröffentlicht wurde, zeigte drei grundlegende Ergebnisse auf, die den Weg für die moderne Statistik ebneten und statistische Werkzeuge lieferten, die heute in der wissenschaftlichen Gemeinschaft weit verbreitet sind.

Professor Rao gewann in seinem Leben viele Auszeichnungen und war Akademiker der Akademie der Wissenschaften in 8 Ländern, darunter Indien, dem Vereinigten Königreich, den Vereinigten Staaten und Italien

Erwähnenswert ist, dass er im Laufe seines Lebens mehr als 50 Ärzte ausgebildet hat. Unter ihnen sind Dabeeru C. Rao, Direktor der Abteilung für Biostatistik an der Washington University School of Medicine, Fellow der American Statistical Association, und die indische Statistikerin Debabrata Basu. Sie waren alle seine Schüler Vollständig in den Ruhestand gehen. Als emeritierter Professor an der Pennsylvania State University und Forschungsprofessor an der University at Buffalo zitierte ihn mit den Worten, der letzte Satz lautete: „Alle Methoden des Wissenserwerbs sind im Wesentlichen Statistiken.“

Alle Methoden des Wissenserwerbs können im Wesentlichen als Statistiken zusammengefasst werden

Das obige ist der detaillierte Inhalt vonDie Statistiklegende C.R. Rao ist verstorben. Er war Zeuge der jahrhundertealten Geschichte der Statistik. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1359

1359

52

52

Was ist der EM-Algorithmus in Python?

Jun 05, 2023 am 08:51 AM

Was ist der EM-Algorithmus in Python?

Jun 05, 2023 am 08:51 AM

Der EM-Algorithmus in Python ist eine iterative Methode, die auf der Maximum-Likelihood-Schätzung basiert und häufig für Parameterschätzprobleme beim unbeaufsichtigten Lernen verwendet wird. In diesem Artikel werden die Definition, die Grundprinzipien, Anwendungsszenarien und die Python-Implementierung des EM-Algorithmus vorgestellt. 1. Definition des EM-Algorithmus Der EM-Algorithmus ist die Abkürzung für Expectation-MaximizationAlgorithm. Es handelt sich um einen iterativen Algorithmus, der entwickelt wurde, um anhand der beobachteten Daten die Maximum-Likelihood-Schätzung zu ermitteln. Im EM-Algorithmus ist es notwendig

Detaillierte Erklärung des EM-Algorithmus in Python

Jun 09, 2023 pm 10:25 PM

Detaillierte Erklärung des EM-Algorithmus in Python

Jun 09, 2023 pm 10:25 PM

Der EM-Algorithmus ist ein häufig verwendeter Algorithmus beim statistischen Lernen und wird in verschiedenen Bereichen häufig verwendet. Als hervorragende Programmiersprache bietet Python große Vorteile bei der Implementierung des EM-Algorithmus. In diesem Artikel wird der EM-Algorithmus in Python ausführlich vorgestellt. Zuerst müssen wir verstehen, was der EM-Algorithmus ist. Der vollständige Name des EM-Algorithmus lautet Expectation-MaximizationAlgorithm. Es handelt sich um einen iterativen Algorithmus, der häufig zur Lösung von Parameterschätzungen verwendet wird, die versteckte Variablen oder fehlende Daten enthalten.

Demonstration der 68-95-99,7-Regel in der Statistik mit Python

Sep 05, 2023 pm 01:33 PM

Demonstration der 68-95-99,7-Regel in der Statistik mit Python

Sep 05, 2023 pm 01:33 PM

Statistiken stellen uns leistungsstarke Werkzeuge zur Analyse und zum Verständnis von Daten zur Verfügung. Eines der Grundkonzepte der Statistik ist die 68-95-99,7-Regel, auch bekannt als Faustregel oder Drei-Sigma-Regel. Diese Regel ermöglicht es uns, anhand ihrer Standardabweichung wichtige Rückschlüsse auf die Verteilung von Daten zu ziehen. In diesem Blogbeitrag werden wir die 68-95-99,7-Regel untersuchen und zeigen, wie man sie mit Python anwendet. Überblick über die 68-95-99,7-Regel Die 68-95-99,7-Regel bietet eine Möglichkeit, den Prozentsatz der Daten in einer Normalverteilung zu schätzen, der innerhalb einer bestimmten Standardabweichung vom Mittelwert liegt. Nach dieser Regel liegen etwa 68 % der Daten innerhalb einer Standardabweichung vom Mittelwert. Etwa 95 % der Daten liegen innerhalb von zwei Standardabweichungen vom Mittelwert. Um

Die Statistiklegende C.R. Rao ist verstorben. Er war Zeuge der jahrhundertealten Geschichte der Statistik

Sep 11, 2023 pm 01:05 PM

Die Statistiklegende C.R. Rao ist verstorben. Er war Zeuge der jahrhundertealten Geschichte der Statistik

Sep 11, 2023 pm 01:05 PM

Der legendäre Meister der Statistik C.R. Rao ist im Alter von 102 Jahren verstorben. Jeder, der Statistik studiert hat, wird seinen Namen kennen – die Cramér-Rao-Ungleichung ist nach ihm und Harald Cramér benannt Der auf der Titelseite geschriebene Satz ist in der chinesischen Welt weit verbreitet: Letztlich ist alles Wissen Geschichte im abstrakten Sinne, alle Wissenschaft ist Mathematik, in der rationalen Welt ist jedes Urteil Statistik. Von 1920 bis 2023 verlief das Leben von Professor Rao nahezu synchron mit der gesamten Entwicklungsgeschichte der modernen Statistik. In einem im Jahr 2021 veröffentlichten Artikel wurde sein Leben als „ein Jahrhundert der Statistik“ bewertet

Häufig verwendete Regressionsalgorithmen und ihre Eigenschaften in Anwendungen des maschinellen Lernens

Nov 29, 2023 pm 05:29 PM

Häufig verwendete Regressionsalgorithmen und ihre Eigenschaften in Anwendungen des maschinellen Lernens

Nov 29, 2023 pm 05:29 PM

Regression ist eines der leistungsstärksten Werkzeuge in der Statistik. Algorithmen für überwachtes Lernen durch maschinelles Lernen werden in zwei Typen unterteilt: Klassifizierungsalgorithmen und Regressionsalgorithmen. Regressionsalgorithmen werden für die Vorhersage kontinuierlicher Verteilungen verwendet und können kontinuierliche Daten und nicht nur diskrete Kategoriebezeichnungen vorhersagen. Die Regressionsanalyse wird häufig im Bereich des maschinellen Lernens verwendet, z. B. zur Vorhersage von Produktverkäufen, Verkehrsströmen, Immobilienpreisen und Wetterbedingungen. Der Regressionsalgorithmus ist ein häufig verwendeter Algorithmus für maschinelles Lernen, mit dem die Beziehung zwischen der unabhängigen Variablen X und hergestellt wird die abhängige Variable Y. Aus Sicht des maschinellen Lernens wird es zum Erstellen eines Algorithmusmodells (einer Funktion) verwendet, um die Zuordnungsbeziehung zwischen Attribut X und Beschriftung Y zu erreichen. Während des Lernprozesses versucht der Algorithmus, die beste Parameterbeziehung zu finden, damit der Anpassungsgrad am besten ist. Im Regressionsalgorithmus ist das Endergebnis des Algorithmus (Funktion) kontinuierlich

Tipps zur Varianzanalyse in Python

Jun 10, 2023 pm 02:15 PM

Tipps zur Varianzanalyse in Python

Jun 10, 2023 pm 02:15 PM

Python ist heute eine der beliebtesten Programmiersprachen und eine weit verbreitete Sprache im Bereich Datenwissenschaft und statistische Analyse. In der statistischen Analyse ist die Varianzanalyse eine sehr verbreitete Technik, mit der die Auswirkungen verschiedener Faktoren auf Variablen untersucht werden können. In diesem Artikel wird erläutert, wie Sie mit Python eine Varianzanalyse durchführen. Was ist Varianzanalyse? (ANOVA) ist eine statistische Analysemethode, die zur Analyse der Unterschiede zwischen kontinuierlichen Variablen einer oder mehrerer kategorialer Variablen verwendet wird. Es

Kann maschinelles Lernen wirklich zu intelligenten Entscheidungen führen?

May 17, 2023 am 08:16 AM

Kann maschinelles Lernen wirklich zu intelligenten Entscheidungen führen?

May 17, 2023 am 08:16 AM

Nach drei Jahren haben wir 2022 das Meisterwerk „“ von Judea Pearl fertiggestellt, Gewinnerin des Turing Award, Professorin für Informatik an der University of California, Los Angeles, Akademikerin der National Academy of Sciences und bekannt als „Vater von“. Bayesianische Netzwerke“ Kausalität: Modelle, Argumentation und Schlussfolgerung. Die ursprüngliche Erstausgabe dieses Buches wurde im Jahr 2000 geschrieben. Es entwickelte neue Ideen und Methoden für die kausale Analyse und Schlussfolgerung. Es erhielt sofort nach seiner Veröffentlichung großes Lob und förderte neue Entwicklungen in den Bereichen Datenwissenschaft, künstliche Intelligenz und maschinelles Lernen , Kausalanalyse und andere Bereiche der Revolution, die einen großen Einfluss auf die Wissenschaft hatten. Später wurde die zweite Auflage im Jahr 2009 überarbeitet und der Inhalt aufgrund der neuen Entwicklungen in der Ursachenforschung zu dieser Zeit erheblich geändert. Die englische Originalversion des Buches, das wir derzeit übersetzen, wurde 2009 veröffentlicht. Bisher ist es soweit

„Black Mirror'-Produzent nutzt KI zum Schreiben von Drehbüchern und die Ergebnisse sehen beschissen aus. „Arrival'-Autor: KI ist im Moment nur angewandte Statistik

Jun 07, 2023 pm 01:21 PM

„Black Mirror'-Produzent nutzt KI zum Schreiben von Drehbüchern und die Ergebnisse sehen beschissen aus. „Arrival'-Autor: KI ist im Moment nur angewandte Statistik

Jun 07, 2023 pm 01:21 PM

Der Produzent von „Black Mirror“ hat KI zum Schreiben von Skripten verwendet, und das Ergebnis war scheiße. „Arrival“-Autor: KI ist derzeit nur angewandte Statistik Charlie Bullock Time Network News Die Popularität von ChatGPT hat in diesem Jahr künstliche Intelligenz (KI) hervorgerufen ) Menschen beim Schreiben von Drehbüchern ersetzen, ein heißes Thema Thema: Kürzlich erzählte „Black Mirror“-Produzent Charlie Bullock ausländischen Medien, dass er einmal ChatGPT verwendet habe, um eine Episode des „Black Mirror“-Drehbuchs zu schreiben, und das Ergebnis sei „wie Scheiße“ gewesen. Darüber hinaus sagte Jiang Fengnan, der ursprüngliche Autor von „Arrival“, dass es sich beim aktuellen ChatGPT lediglich um angewandte Statistiken und überhaupt nicht um künstliche Intelligenz handelt. Charlie Bullock gab die Worte „Black Mirror-Skript generieren“ in ChatGPT ein, und dann wurde das sogenannte Skript generiert: „Auf den ersten Blick scheint es vernünftig, aber auf den zweiten Blick ist es ein Stück Scheiße. Was es ist.“ ist das so

Score-Test ist eine der drei Hauptmethoden zum Testen statistischer Hypothesen

Score-Test ist eine der drei Hauptmethoden zum Testen statistischer Hypothesen