Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Verwendung von GPU-Instanzen zur Demonstration der Unterstützung von Alibaba Cloud Linux 3 für das KI-Ökosystem

Verwendung von GPU-Instanzen zur Demonstration der Unterstützung von Alibaba Cloud Linux 3 für das KI-Ökosystem

Verwendung von GPU-Instanzen zur Demonstration der Unterstützung von Alibaba Cloud Linux 3 für das KI-Ökosystem

Vor Kurzem hat Alibaba Cloud Linux 3 einige Optimierungen und Upgrades bereitgestellt, um die KI-Entwicklung effizienter zu gestalten. Dieser Artikel ist eine Vorschau auf die Artikelreihe „Einführung in die KI-Funktionen von Alibaba Cloud Linux 3“. Instanz als Beispiel zur Demonstration von Alibaba Cloud Linux 3. Unterstützung für das KI-Ökosystem. Als nächstes werden zwei Artikelserien veröffentlicht, in denen hauptsächlich das auf Alinux basierende Cloud-Markt-Image vorgestellt wird, um Benutzern eine sofort einsatzbereite KI-Basissoftwareumgebung bereitzustellen, und die Differenzierung der KI-Funktionen auf Basis von AMD vorgestellt wird. Bleiben Sie dran. Weitere Informationen zu Alibaba Cloud Linux 3 finden Sie auf der offiziellen Website: https://www.aliyun.com/product/ecs/alinux

Bei der Entwicklung von Anwendungen für künstliche Intelligenz (KI) auf Linux-Betriebssystemen können Entwickler auf einige Herausforderungen stoßen, darunter unter anderem:

1. GPU-Treiber: Um eine NVIDIA-GPU für Training oder Inferenz auf einem Linux-System verwenden zu können, muss der richtige NVIDIA-GPU-Treiber installiert und konfiguriert werden. Möglicherweise sind einige zusätzliche Arbeiten erforderlich, da unterschiedliche Betriebssysteme und GPU-Modelle möglicherweise unterschiedliche Treiber erfordern.

2. AI-Framework-Kompilierung: Beim Programmieren mit einem AI-Framework auf einem Linux-System müssen Sie den entsprechenden Compiler und andere Abhängigkeiten installieren und konfigurieren. Diese Frameworks erfordern häufig eine Kompilierung. Sie müssen daher sicherstellen, dass der Compiler und andere Abhängigkeiten korrekt installiert sind und dass der Compiler richtig konfiguriert ist.

3. Softwarekompatibilität: Das Linux-Betriebssystem unterstützt viele verschiedene Software und Tools, es kann jedoch zu Kompatibilitätsproblemen zwischen verschiedenen Versionen und Distributionen kommen. Dies kann dazu führen, dass einige Programme nicht ordnungsgemäß ausgeführt werden oder auf einigen Betriebssystemen nicht verfügbar sind. Daher müssen F&E-Mitarbeiter die Softwarekompatibilität ihrer Arbeitsumgebung verstehen und die erforderlichen Konfigurationen und Änderungen vornehmen.

4. Leistungsprobleme: Der KI-Software-Stack ist ein äußerst komplexes System, das normalerweise eine professionelle Optimierung verschiedener CPU- und GPU-Modelle erfordert, um seine beste Leistung zu erzielen. Die Leistungsoptimierung der Software- und Hardware-Zusammenarbeit ist eine anspruchsvolle Aufgabe für KI-Software-Stacks und erfordert ein hohes Maß an Technologie und Fachwissen.

Alibaba Cloud Linux 3, das Cloud-Server-Betriebssystem der dritten Generation von Alibaba Cloud (im Folgenden als „Alinux 3“ bezeichnet), ist ein kommerzielles Betriebssystem, das auf Basis von Anolis OS entwickelt wurde und Entwicklern eine leistungsstarke KI-Entwicklungsplattform bietet Alinux 3, das Dragon Lizard Ecological Repo (epao), hat die Mainstream-Nvidia-GPU und das CUDA-Ökosystem vollständig unterstützt und macht die KI-Entwicklung bequemer und effizienter. Darüber hinaus unterstützt Alinux 3 auch die Optimierung von KI durch verschiedene CPU-Plattformen wie die Mainstream-KI-Frameworks TensorFlow/PyTorch und Intel/amd. Es wird auch native Unterstützung für große Modell-SDKs wie Modelscope und Huggingface einführen und Entwicklern umfangreiche Ressourcen bieten Werkzeug. Diese Unterstützung macht Alinux 3 zu einer vollständigen KI-Entwicklungsplattform, die die Probleme von KI-Entwicklern löst, ohne sich mit der Umgebung herumschlagen zu müssen, wodurch die KI-Entwicklungserfahrung einfacher und effizienter wird. Alinux 3 bietet Entwicklern eine leistungsstarke KI-Entwicklungsplattform. Um die oben genannten Herausforderungen zu lösen, auf die Entwickler stoßen können, bietet Alinux 3 die folgenden Optimierungs-Upgrades: 1.

Alinux 3 unterstützt Entwickler bei der Installation gängiger NVIDIA-GPU-Treiber und CUDA-Beschleunigungsbibliotheken mit einem Klick durch die Einführung des Dragon Lizard Ecological Software Repository (epao)und spart Entwicklern die Zeit für das Abgleichen von Treiberversionen und die manuelle Installation.

2. Das epao-Warehouse bietet auch Unterstützung für Versionen des Mainstream-KI-Frameworks Tensorflow/PyTorch

Gleichzeitig wird das Abhängigkeitsproblem des KI-Frameworks während des Installationsprozesses automatisch gelöst um eine zusätzliche Kompilierung durchzuführen und es schnell mit der System-Python-Entwicklung zu verwenden.3. Bevor die KI-Funktionen von Alinux 3 den Entwicklern zur Verfügung gestellt werden, wurden alle Komponenten auf Kompatibilität getestet

Entwickler können die entsprechenden KI-Funktionen mit einem Klick installieren und so Systemabhängigkeiten beseitigen, die in der Umgebungskonfiguration auftreten können um die Stabilität während des Gebrauchs zu verbessern.4. Alinux 3 wurde speziell für KI für CPUs auf verschiedenen Plattformen wie Intel/AMD optimiert, um die volle Leistung der Hardware besser auszuschöpfen.

5. Um sich schneller an die schnelle Entwicklung der AIGC-Branche anzupassen, wird Alinux 3 auch native Unterstützung für große Modell-SDKs wie ModelScope und HuggingFace einführen und Entwicklern eine Fülle von Ressourcen und Tools zur Verfügung stellen. Mit der Unterstützung der mehrdimensionalen Optimierung ist Alinux 3 zu einer vollständigen KI-Entwicklungsplattform geworden, die die Schwachstellen von KI-Entwicklern löst und die KI-Entwicklungserfahrung einfacher und effizienter macht.

Im Folgenden werden Alibaba Cloud GPU-Instanzen als Beispiel verwendet, um die Unterstützung von Alinux 3 für das KI-Ökosystem zu demonstrieren:

1. Kaufen Sie eine GPU-Instanz

2. Wählen Sie das Alinux 3-Image aus

3. Installieren Sie die Epao-Repo-Konfiguration

dnf install -y anolis-epao-release

4. Installieren Sie den NVIDIA GPU-Treiber

Stellen Sie vor der Installation des NVIDIA-Treibers sicher, dass kernel-devel installiert ist, um sicherzustellen, dass der NVIDIA-Treiber erfolgreich installiert wird.

dnf install -y kernel-devel-$(uname-r)

Nvidia-Treiber installieren:

dnf install -y nvidia-driver nvidia-driver-cuda

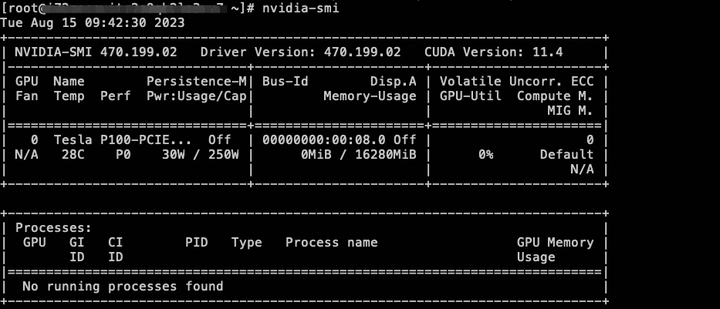

Nachdem die Installation abgeschlossen ist, können Sie den GPU-Gerätestatus über den Befehl nvidia-smi überprüfen.

5. Installieren Sie die ökologische Cuda-Bibliothek

dnf install -y cuda

6. Installieren Sie das AI-Framework Tensorflow/Pytorch

Derzeit wird die CPU-Version von Tensorflow/Pytorch bereitgestellt und die GPU-Version des AI-Frameworks wird in Zukunft unterstützt.

dnf install tensorflow -y dnf install pytorch -y

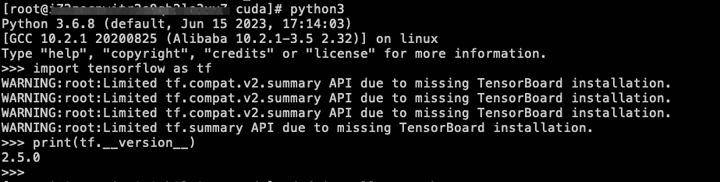

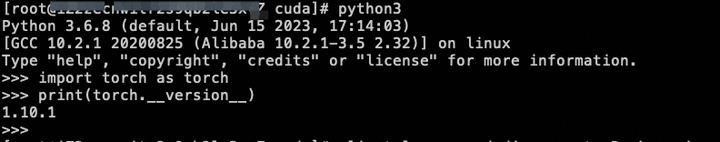

Nachdem die Installation abgeschlossen ist, können Sie mit einem einfachen Befehl überprüfen, ob die Installation erfolgreich war:

7. Bereitstellungsmodell

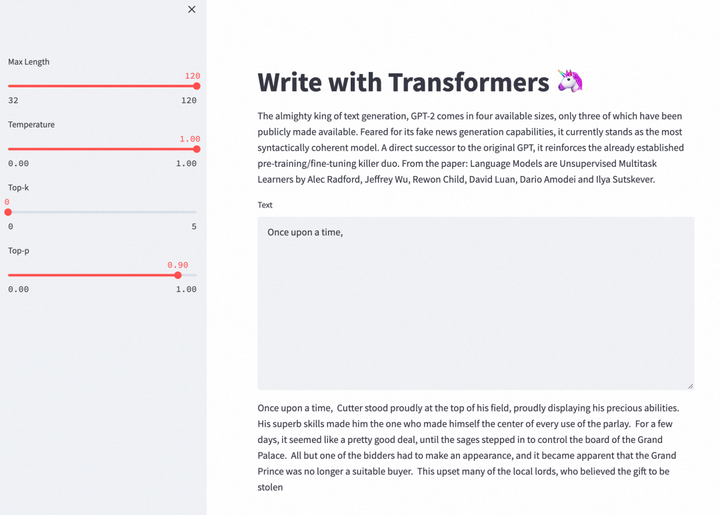

Mit der ökologischen KI-Unterstützung von Alinux 3 kann das GPT-2 Large-Modell eingesetzt werden, um die Aufgabe, diesen Artikel zu schreiben, fortzusetzen.

Installieren Sie Git und Git LFS, um spätere Modell-Downloads zu erleichtern.

dnf install -y git git-lfs wget

Aktualisieren Sie pip, um die spätere Bereitstellung der Python-Umgebung zu erleichtern.

python -m pip install --upgrade pip

Git LFS-Unterstützung aktivieren.

git lfs installieren

Laden Sie den Quellcode des Write-with-Transformer-Projekts und das vorab trainierte Modell herunter. Das Write-with-Transformer-Projekt ist eine Web-Schreib-App, die das GPT-2-Großmodell verwenden kann, um weiterhin Inhalte zu schreiben.

Git-Klon https://huggingface.co/spaces/merve/write-with-transformer

GIT_LFS_SKIP_SMUDGE=1 Git-Klon https://huggingface.co/gpt2-large

wget https://huggingface.co/gpt2-large/resolve/main/pytorch_model.bin -O gpt2-large/pytorch_model.bin

Installieren Sie die für Write-with-Transformer erforderlichen Abhängigkeiten.

cd ~/write-with-transformer

pip install --ignore-installed pyyaml==5.1

pip install -r Anforderungen.txt

Nachdem die Umgebung bereitgestellt wurde, können Sie die Webversion der APP ausführen, um den Spaß am Schreiben mithilfe von GPT-2 zu erleben. Derzeit unterstützt GPT-2 nur die Textgenerierung in Englisch.

cd ~/write-with-transformer

sed -i 's?"gpt2-large"?"../gpt2-large"?g' app.py

sed -i '34s/10/32/;34s/30/120/' app.py

Streamlit führen Sie app.py --server.port 7860 aus

Externe URL: http://

Klicken Sie hier, um das Cloud-Produkt jetzt kostenlos zu testen: https://click.aliyun.com/m/1000373503/

Originallink: https://click.aliyun.com/m/1000379727/

Dieser Artikel ist Originalinhalt von Alibaba Cloud und darf nicht ohne Genehmigung reproduziert werden.

Das obige ist der detaillierte Inhalt vonVerwendung von GPU-Instanzen zur Demonstration der Unterstützung von Alibaba Cloud Linux 3 für das KI-Ökosystem. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Ich habe versucht, die Vibe -Codierung mit Cursor AI und es ist erstaunlich!

Mar 20, 2025 pm 03:34 PM

Ich habe versucht, die Vibe -Codierung mit Cursor AI und es ist erstaunlich!

Mar 20, 2025 pm 03:34 PM

Die Vibe -Codierung verändert die Welt der Softwareentwicklung, indem wir Anwendungen mit natürlicher Sprache anstelle von endlosen Codezeilen erstellen können. Inspiriert von Visionären wie Andrej Karpathy, lässt dieser innovative Ansatz Dev

Top 5 Genai Starts vom Februar 2025: GPT-4,5, GROK-3 & MEHR!

Mar 22, 2025 am 10:58 AM

Top 5 Genai Starts vom Februar 2025: GPT-4,5, GROK-3 & MEHR!

Mar 22, 2025 am 10:58 AM

Februar 2025 war ein weiterer bahnbrechender Monat für die Generative KI, die uns einige der am meisten erwarteten Modell-Upgrades und bahnbrechenden neuen Funktionen gebracht hat. Von Xais Grok 3 und Anthropics Claude 3.7 -Sonett, um g zu eröffnen

Wie benutze ich Yolo V12 zur Objekterkennung?

Mar 22, 2025 am 11:07 AM

Wie benutze ich Yolo V12 zur Objekterkennung?

Mar 22, 2025 am 11:07 AM

Yolo (Sie schauen nur einmal) war ein führender Echtzeit-Objekterkennungsrahmen, wobei jede Iteration die vorherigen Versionen verbessert. Die neueste Version Yolo V12 führt Fortschritte vor, die die Genauigkeit erheblich verbessern

Ist Chatgpt 4 o verfügbar?

Mar 28, 2025 pm 05:29 PM

Ist Chatgpt 4 o verfügbar?

Mar 28, 2025 pm 05:29 PM

Chatgpt 4 ist derzeit verfügbar und weit verbreitet, wodurch im Vergleich zu seinen Vorgängern wie ChatGPT 3.5 signifikante Verbesserungen beim Verständnis des Kontextes und des Generierens kohärenter Antworten zeigt. Zukünftige Entwicklungen können mehr personalisierte Inters umfassen

Gencast von Google: Wettervorhersage mit Gencast Mini Demo

Mar 16, 2025 pm 01:46 PM

Gencast von Google: Wettervorhersage mit Gencast Mini Demo

Mar 16, 2025 pm 01:46 PM

Gencast von Google Deepmind: Eine revolutionäre KI für die Wettervorhersage Die Wettervorhersage wurde einer dramatischen Transformation unterzogen, die sich von rudimentären Beobachtungen zu ausgefeilten AI-angetriebenen Vorhersagen überschreitet. Google DeepMinds Gencast, ein Bodenbrei

Welche KI ist besser als Chatgpt?

Mar 18, 2025 pm 06:05 PM

Welche KI ist besser als Chatgpt?

Mar 18, 2025 pm 06:05 PM

Der Artikel erörtert KI -Modelle, die Chatgpt wie Lamda, Lama und Grok übertreffen und ihre Vorteile in Bezug auf Genauigkeit, Verständnis und Branchenauswirkungen hervorheben. (159 Charaktere)

O1 gegen GPT-4O: Ist OpenAIs neues Modell besser als GPT-4O?

Mar 16, 2025 am 11:47 AM

O1 gegen GPT-4O: Ist OpenAIs neues Modell besser als GPT-4O?

Mar 16, 2025 am 11:47 AM

Openais O1: Ein 12-tägiger Geschenkbummel beginnt mit ihrem bisher mächtigsten Modell Die Ankunft im Dezember bringt eine globale Verlangsamung, Schneeflocken in einigen Teilen der Welt, aber Openai fängt gerade erst an. Sam Altman und sein Team starten ein 12-tägiges Geschenk Ex

Beste KI -Kunstgeneratoren (kostenlos & amp; bezahlt) für kreative Projekte

Apr 02, 2025 pm 06:10 PM

Beste KI -Kunstgeneratoren (kostenlos & amp; bezahlt) für kreative Projekte

Apr 02, 2025 pm 06:10 PM

Der Artikel überprüft Top -KI -Kunstgeneratoren, diskutiert ihre Funktionen, Eignung für kreative Projekte und Wert. Es zeigt MidJourney als den besten Wert für Fachkräfte und empfiehlt Dall-E 2 für hochwertige, anpassbare Kunst.