Hören Sie mir zu, Transformer ist eine Support-Vektor-Maschine

Transformer ist eine Support Vector Machine (SVM), eine neue Theorie, die Diskussionen in der akademischen Gemeinschaft ausgelöst hat.

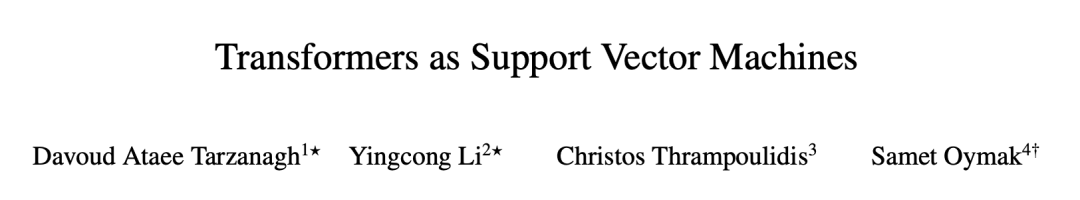

Letztes Wochenende wurde in einem Artikel der University of Pennsylvania und der University of California, Riverside versucht, die Prinzipien der Transformer-Struktur anhand großer Modelle, ihrer optimierten Geometrie in der Aufmerksamkeitsschicht und der Trennung optimaler Eingabe-Tokens zu untersuchen Es wird eine formale Äquivalenz zwischen den hart begrenzten SVM-Problemen hergestellt.

Der Autor erklärte auf Hackernews, dass diese Theorie das Problem löst, dass SVM in jeder Eingabesequenz „gute“ Token von „schlechten“ Token trennt. Als Token-Selektor mit hervorragender Leistung unterscheidet sich diese SVM wesentlich von der herkömmlichen SVM, die der Eingabe 0-1 Labels zuweist.

Diese Theorie erklärt auch, wie Aufmerksamkeit durch Softmax zu Sparsity führt: „schlechte“ Token, die auf der falschen Seite der SVM-Entscheidungsgrenze liegen, werden von der Softmax-Funktion unterdrückt, während „gute“ Token diejenigen sind, die am Ende nicht- Null-Softmax-Wahrscheinlichkeitstoken. Erwähnenswert ist auch, dass diese SVM von den exponentiellen Eigenschaften von Softmax abgeleitet ist.

Nachdem das Papier auf arXiv hochgeladen wurde, äußerten die Leute nacheinander ihre Meinung. Einige Leute sagten: Die Richtung der KI-Forschung dreht sich wirklich, wird sie wieder zurückgehen?

Nachdem sich der Kreis geschlossen hat, sind Support-Vektor-Maschinen immer noch nicht veraltet.

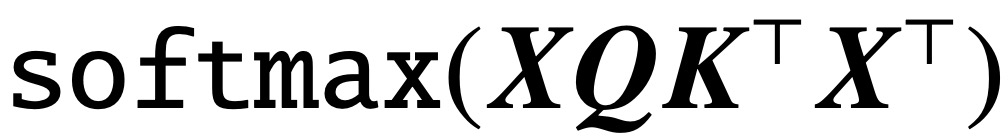

Seit der Veröffentlichung des Klassikers „Attention is All You Need“ hat die Transformer-Architektur revolutionäre Fortschritte auf dem Gebiet der Verarbeitung natürlicher Sprache (NLP) gebracht. Die Aufmerksamkeitsschicht in Transformer akzeptiert eine Reihe von Eingabe-Tokens  Jetzt stellt ein neues Papier mit dem Titel „Transformers as Support Vector Machines“ eine formale Äquivalenz zwischen der Optimierungsgeometrie der Selbstaufmerksamkeit und dem Hard-Margin-SVM-Problem her, indem das lineare äußere Produkt von Token-Paaren mit Einschränkungen optimale Eingabe-Token trennt von nicht optimalen Token.

Jetzt stellt ein neues Papier mit dem Titel „Transformers as Support Vector Machines“ eine formale Äquivalenz zwischen der Optimierungsgeometrie der Selbstaufmerksamkeit und dem Hard-Margin-SVM-Problem her, indem das lineare äußere Produkt von Token-Paaren mit Einschränkungen optimale Eingabe-Token trennt von nicht optimalen Token.

Link zum Papier: https://arxiv.org/pdf/2308.16898.pdf

Link zum Papier: https://arxiv.org/pdf/2308.16898.pdf

Diese formale Äquivalenz basiert auf dem Papier „Max-Margin Token Selection in Attention Mechanism“ von Davoud Ataee Tarzanagh et al. „Auf der Grundlage der Vanishing-Regularisierung, Konvergenz zu einer SVM-Lösung, die die Kernnorm der kombinierten Parameter minimiert

. Im Gegensatz dazu minimiert die Parametrisierung direkt über W das SVM-Ziel der Frobenius-Norm. Der Artikel beschreibt diese Konvergenz und betont, dass sie eher in Richtung eines lokalen Optimums als in Richtung eines globalen Optimums auftreten kann.

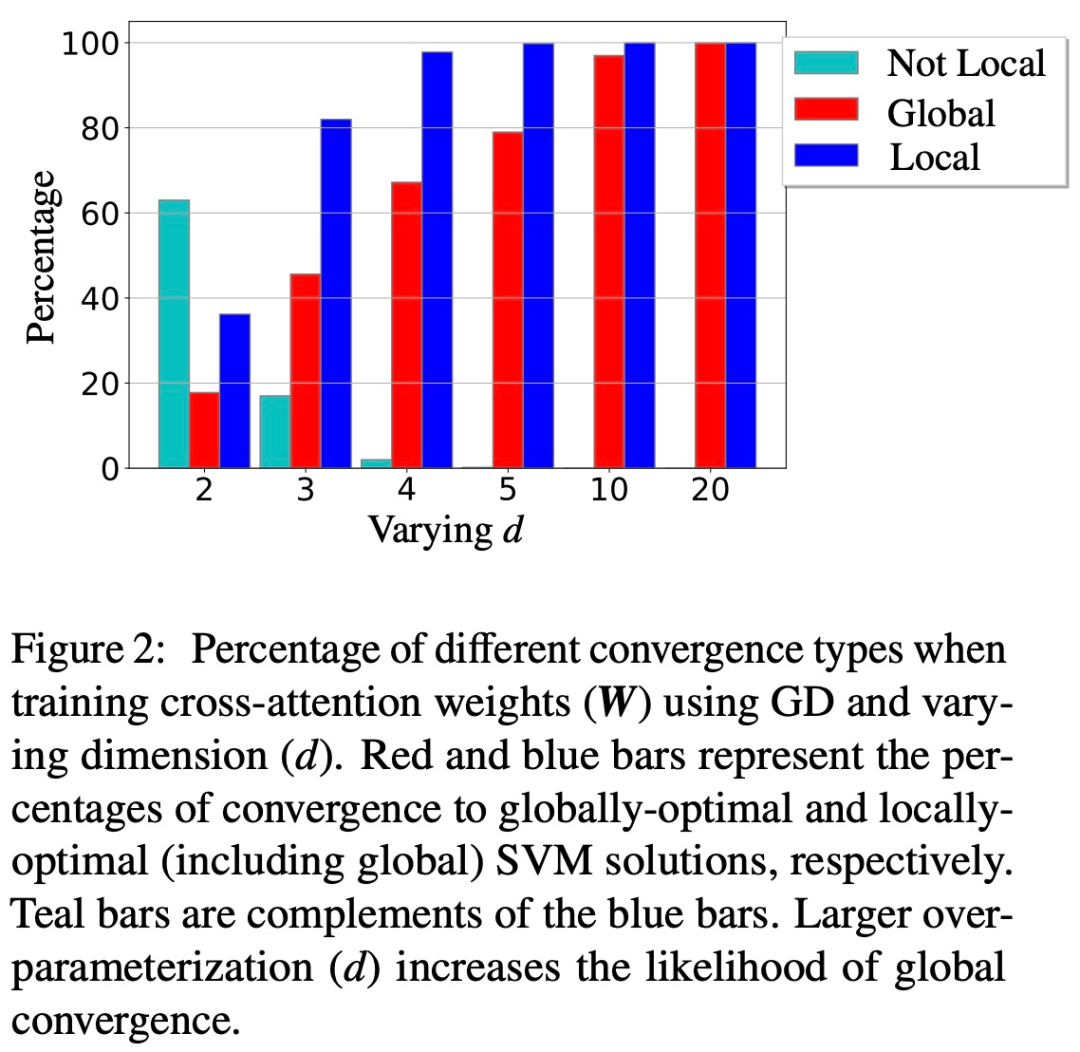

(2) Der Artikel demonstriert auch die lokale/globale Richtungskonvergenz des W-Parametrisierungsgradientenabstiegs unter geeigneten geometrischen Bedingungen. Wichtig ist, dass die Überparametrisierung die globale Konvergenz katalysiert, indem sie die Machbarkeit des SVM-Problems sicherstellt und eine harmlose Optimierungsumgebung ohne stationäre Punkte gewährleistet.  (3) Während die Theorie dieser Studie hauptsächlich auf lineare Vorhersageköpfe anwendbar ist, schlägt das Forschungsteam ein allgemeineres SVM-Äquivalent vor, das die implizite Vorspannung von 1-Schicht-Transformatoren mit nichtlinearen Köpfen/MLPs vorhersagen kann.

(3) Während die Theorie dieser Studie hauptsächlich auf lineare Vorhersageköpfe anwendbar ist, schlägt das Forschungsteam ein allgemeineres SVM-Äquivalent vor, das die implizite Vorspannung von 1-Schicht-Transformatoren mit nichtlinearen Köpfen/MLPs vorhersagen kann.

Im Allgemeinen sind die Ergebnisse dieser Studie auf allgemeine Datensätze anwendbar und können auf Aufmerksamkeitsebenen erweitert werden, und die praktische Gültigkeit der Studienschlussfolgerungen wurde durch gründliche numerische Experimente überprüft. Diese Studie begründet eine neue Forschungsperspektive, die mehrschichtige Transformatoren als SVM-Hierarchien betrachtet, die die besten Token trennen und auswählen.

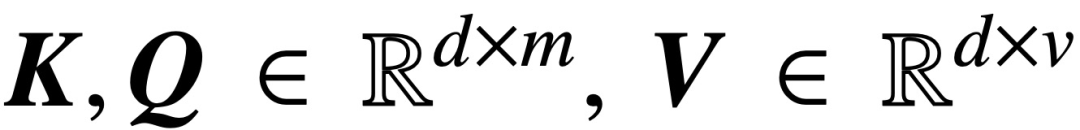

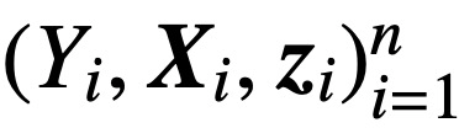

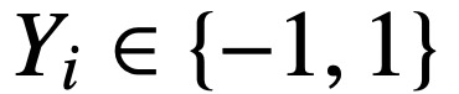

Konkret analysiert diese Studie bei gegebener Eingabesequenz der Länge T und der Einbettungsdimension d

die Kernmodelle der Queraufmerksamkeit und Selbstaufmerksamkeit:

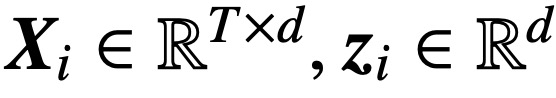

wobei K, Q, V jeweils trainierbare Schlüssel-, Abfrage- und Wertematrizen sind,  ; S (・) stellt Softmax-Nichtlinearität dar, die Zeile für Zeile angewendet wird

; S (・) stellt Softmax-Nichtlinearität dar, die Zeile für Zeile angewendet wird  . Die Studie geht davon aus, dass der erste Token von Z (bezeichnet mit z) zur Vorhersage verwendet wird. Insbesondere bei einem Trainingsdatensatz

. Die Studie geht davon aus, dass der erste Token von Z (bezeichnet mit z) zur Vorhersage verwendet wird. Insbesondere bei einem Trainingsdatensatz  ,

,  ,

,  verwendet diese Studie die abnehmende Verlustfunktion

verwendet diese Studie die abnehmende Verlustfunktion  , um Folgendes zu minimieren:

, um Folgendes zu minimieren:

Hier h (・):  . ist Der Vorhersageheader enthält das Wertgewicht V. In dieser Formulierung stellt das Modell f (・) genau einen einschichtigen Transformator dar, bei dem auf die Aufmerksamkeitsschicht ein MLP folgt. Der Autor stellt die Selbstaufmerksamkeit in (2) wieder her, indem er

. ist Der Vorhersageheader enthält das Wertgewicht V. In dieser Formulierung stellt das Modell f (・) genau einen einschichtigen Transformator dar, bei dem auf die Aufmerksamkeitsschicht ein MLP folgt. Der Autor stellt die Selbstaufmerksamkeit in (2) wieder her, indem er  setzt, wobei x_i das erste Token der Sequenz X_i darstellt. Aufgrund der nichtlinearen Natur der Softmax-Operation stellt sie eine große Herausforderung für die Optimierung dar. Selbst wenn der Vorhersagekopf fest und linear ist, ist das Problem nicht konvex und nicht linear. In dieser Studie konzentrieren sich die Autoren auf die Optimierung der Aufmerksamkeitsgewichte (K, Q oder W) und die Bewältigung dieser Herausforderungen, um die grundlegende Äquivalenz von SVMs festzustellen.

setzt, wobei x_i das erste Token der Sequenz X_i darstellt. Aufgrund der nichtlinearen Natur der Softmax-Operation stellt sie eine große Herausforderung für die Optimierung dar. Selbst wenn der Vorhersagekopf fest und linear ist, ist das Problem nicht konvex und nicht linear. In dieser Studie konzentrieren sich die Autoren auf die Optimierung der Aufmerksamkeitsgewichte (K, Q oder W) und die Bewältigung dieser Herausforderungen, um die grundlegende Äquivalenz von SVMs festzustellen.

Die Struktur des Papiers ist wie folgt: Kapitel 2 stellt das vorläufige Wissen über Selbstaufmerksamkeit und Optimierung vor. Kapitel 3 analysiert die Optimierungsgeometrie der Selbstaufmerksamkeit und zeigt, dass der Aufmerksamkeitsparameter RP zur maximalen Randlösung konvergiert; Kapitel 4 und Kapitel 5 stellen die globale bzw. lokale Gradientenabstiegsanalyse vor und zeigen, dass die Schlüsselabfragevariable W zur Lösung von (Att-SVM) konvergiert. Kapitel 6 liefert Ergebnisse zur Äquivalenz von nichtlinearen Vorhersageköpfen und verallgemeinertem SVM 6 Kapitel 7 erweitert die Theorie auf sequentielle und kausale Vorhersagen; Kapitel 8 diskutiert die entsprechende Literatur. Abschließend schließt Kapitel 9 mit Vorschlägen für offene Fragen und zukünftige Forschungsrichtungen ab.

Der Hauptinhalt des Artikels lautet wie folgt:

Implizite Voreingenommenheit in der Aufmerksamkeitsschicht (Kapitel 2-3)

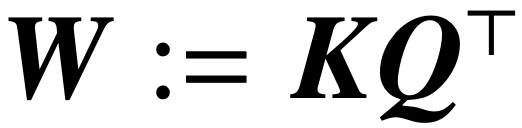

Optimierung der Aufmerksamkeitsparameter (K, Q), wenn die Regularisierung verschwindet, It konvergiert zur maximalen Randlösung von  in der Richtung, und sein nukleares Normziel ist der Kombinationsparameter

in der Richtung, und sein nukleares Normziel ist der Kombinationsparameter  . Im Fall der direkten Parametrisierung der Queraufmerksamkeit mit dem kombinierten Parameter W konvergiert der Regularisierungspfad (RP) direktional zur (Att-SVM)-Lösung, die auf die Frobenius-Norm abzielt.

. Im Fall der direkten Parametrisierung der Queraufmerksamkeit mit dem kombinierten Parameter W konvergiert der Regularisierungspfad (RP) direktional zur (Att-SVM)-Lösung, die auf die Frobenius-Norm abzielt.

Dies ist das erste Ergebnis, das die parametrische Optimierungsdynamik von W und (K, Q) formal unterscheidet und Verzerrungen niedriger Ordnung in letzterer aufdeckt. Die Theorie dieser Studie beschreibt klar die Optimalität ausgewählter Token und erstreckt sich natürlich auf Sequenz-zu-Sequenz- oder kausale Klassifizierungseinstellungen.

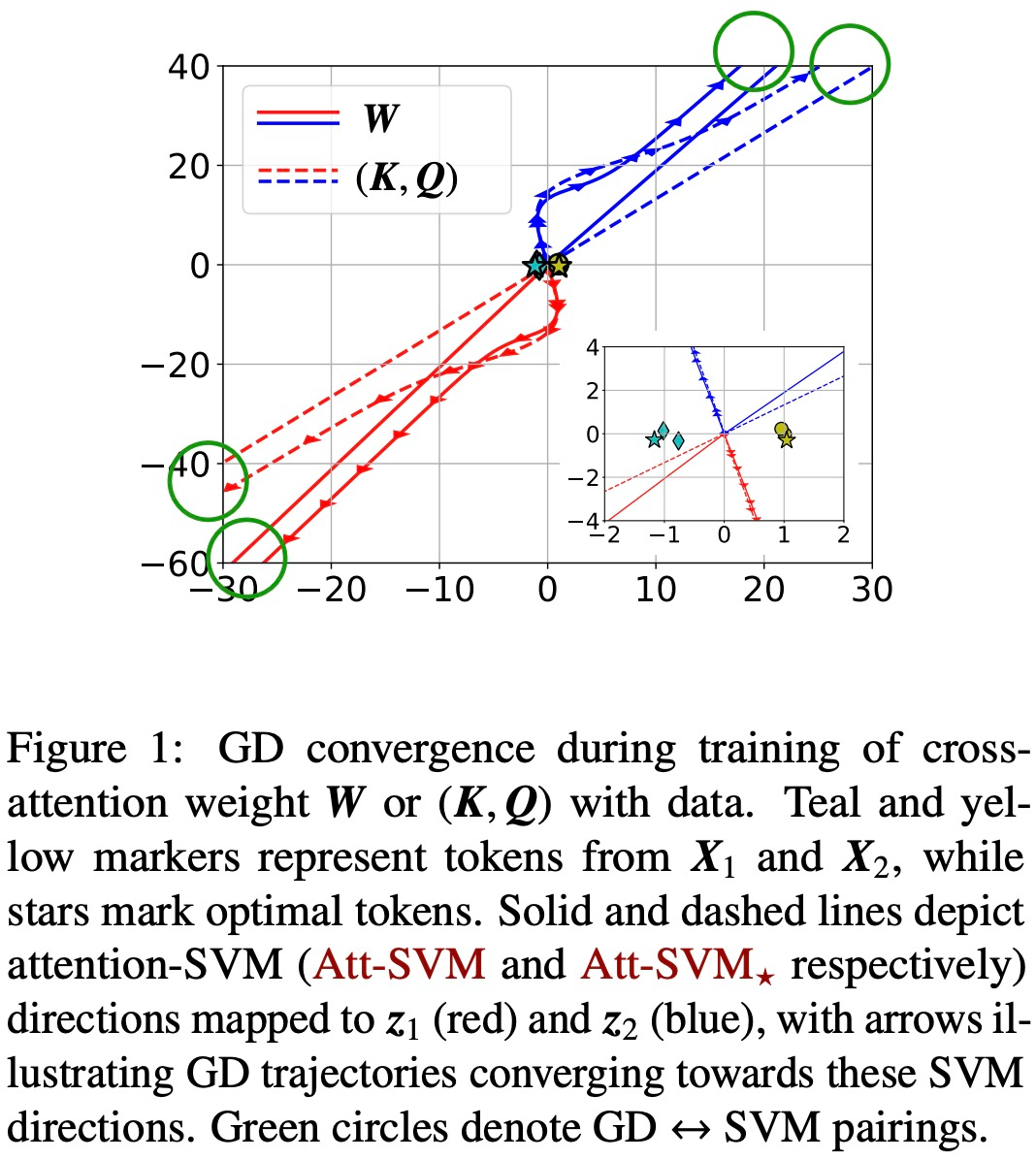

Konvergenz des Gradientenabstiegs (Kapitel 4-5)

Bei entsprechender Initialisierung und linearem Kopf h (・) konvergieren Gradientenabstiegsiterationen (GD) der kombinierten Schlüssel-Abfragevariablen W in der Richtung zu die lokal optimale Lösung von (Att-SVM) (Abschnitt 5). Um ein lokales Optimum zu erreichen, muss der ausgewählte Token eine höhere Punktzahl haben als benachbarte Token.

Die lokal optimale Richtung ist nicht unbedingt eindeutig und kann anhand der geometrischen Eigenschaften des Problems bestimmt werden [TLZO23]. Als wichtigen Beitrag identifizieren die Autoren geometrische Bedingungen, die die Konvergenz in Richtung des globalen Optimums gewährleisten (Kapitel 4). Zu diesen Bedingungen gehören:

- Der beste Token weist einen deutlichen Unterschied in der Punktzahl auf.

- Die anfängliche Gradientenrichtung stimmt mit dem besten Token überein.

Darüber hinaus zeigt das Papier auch, dass eine Überparametrisierung (d. h. die Dimension d ist groß und die gleichen Bedingungen gelten) durch Sicherstellung der Durchführbarkeit von (1) (Att-SVM) und (2) harmlos ist Optimierungslandschaft (d. h. es gibt keine stationären Punkte und falschen lokalen optimalen Richtungen), um die globale Konvergenz zu katalysieren (siehe Abschnitt 5.2).

Die Abbildungen 1 und 2 veranschaulichen dies.

Allgemeingültigkeit des SVM-Äquivalents (Kapitel 6)

Bei der Optimierung mit linearem h (・) Grundvoreingenommenheit zur Auswahl eines Tokens jede Sequenz (auch bekannt als harte Aufmerksamkeit). Dies spiegelt sich in (Att-SVM) wider, wo der Ausgabetoken eine konvexe Kombination der Eingabetoken ist. Im Gegensatz dazu zeigen die Autoren, dass nichtlineare Köpfe aus mehreren Token bestehen müssen, was ihre Bedeutung für die Transformatordynamik hervorhebt (Abschnitt 6.1). Basierend auf Erkenntnissen aus der Theorie schlagen die Autoren einen allgemeineren äquivalenten Ansatz für SVM vor.

Sie zeigen insbesondere, dass unsere Methode die implizite Tendenz der durch Gradientenabstieg trainierten Aufmerksamkeit in allgemeinen Fällen, die nicht von der Theorie abgedeckt werden (z. B. h (・) ist ein MLP), genau vorhersagen kann. Konkret entkoppelt unsere allgemeine Formel das Aufmerksamkeitsgewicht in zwei Teile: einen von SVM gesteuerten Richtungsteil, der Marker durch Anwenden einer 0-1-Maske auswählt, und einen endlichen Teil, der die Softmax-Wahrscheinlichkeit anpasst, die die genaue Zusammensetzung des ausgewählten Tokens bestimmt;

Ein wichtiges Merkmal dieser Erkenntnisse ist, dass sie auf beliebige Datensätze anwendbar sind (sofern SVM machbar ist) und numerisch verifiziert werden können. Die Autoren haben die maximale Randäquivalenz und die implizite Vorspannung des Transformators ausführlich experimentell überprüft. Die Autoren glauben, dass diese Ergebnisse zum Verständnis von Transformatoren als hierarchischem Token-Auswahlmechanismus mit maximaler Marge beitragen und den Grundstein für kommende Forschungen zu ihrer Optimierungs- und Generalisierungsdynamik legen können.

Das obige ist der detaillierte Inhalt vonHören Sie mir zu, Transformer ist eine Support-Vektor-Maschine. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

Open Source! Jenseits von ZoeDepth! DepthFM: Schnelle und genaue monokulare Tiefenschätzung!

Apr 03, 2024 pm 12:04 PM

Open Source! Jenseits von ZoeDepth! DepthFM: Schnelle und genaue monokulare Tiefenschätzung!

Apr 03, 2024 pm 12:04 PM

0.Was bewirkt dieser Artikel? Wir schlagen DepthFM vor: ein vielseitiges und schnelles generatives monokulares Tiefenschätzungsmodell auf dem neuesten Stand der Technik. Zusätzlich zu herkömmlichen Tiefenschätzungsaufgaben demonstriert DepthFM auch hochmoderne Fähigkeiten bei nachgelagerten Aufgaben wie dem Tiefen-Inpainting. DepthFM ist effizient und kann Tiefenkarten innerhalb weniger Inferenzschritte synthetisieren. Lassen Sie uns diese Arbeit gemeinsam lesen ~ 1. Titel der Papierinformationen: DepthFM: FastMonocularDepthEstimationwithFlowMatching Autor: MingGui, JohannesS.Fischer, UlrichPrestel, PingchuanMa, Dmytr

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Stellen Sie sich ein Modell der künstlichen Intelligenz vor, das nicht nur die Fähigkeit besitzt, die traditionelle Datenverarbeitung zu übertreffen, sondern auch eine effizientere Leistung zu geringeren Kosten erzielt. Dies ist keine Science-Fiction, DeepSeek-V2[1], das weltweit leistungsstärkste Open-Source-MoE-Modell, ist da. DeepSeek-V2 ist ein leistungsstarkes MoE-Sprachmodell (Mix of Experts) mit den Merkmalen eines wirtschaftlichen Trainings und einer effizienten Inferenz. Es besteht aus 236B Parametern, von denen 21B zur Aktivierung jedes Markers verwendet werden. Im Vergleich zu DeepSeek67B bietet DeepSeek-V2 eine stärkere Leistung, spart gleichzeitig 42,5 % der Trainingskosten, reduziert den KV-Cache um 93,3 % und erhöht den maximalen Generierungsdurchsatz auf das 5,76-fache. DeepSeek ist ein Unternehmen, das sich mit allgemeiner künstlicher Intelligenz beschäftigt

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI verändert tatsächlich die Mathematik. Vor kurzem hat Tao Zhexuan, der diesem Thema große Aufmerksamkeit gewidmet hat, die neueste Ausgabe des „Bulletin of the American Mathematical Society“ (Bulletin der American Mathematical Society) weitergeleitet. Zum Thema „Werden Maschinen die Mathematik verändern?“ äußerten viele Mathematiker ihre Meinung. Der gesamte Prozess war voller Funken, knallhart und aufregend. Der Autor verfügt über eine starke Besetzung, darunter der Fields-Medaillengewinner Akshay Venkatesh, der chinesische Mathematiker Zheng Lejun, der NYU-Informatiker Ernest Davis und viele andere bekannte Wissenschaftler der Branche. Die Welt der KI hat sich dramatisch verändert. Viele dieser Artikel wurden vor einem Jahr eingereicht.

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas tritt offiziell in die Ära der Elektroroboter ein! Gestern hat sich der hydraulische Atlas einfach „unter Tränen“ von der Bühne der Geschichte zurückgezogen. Heute gab Boston Dynamics bekannt, dass der elektrische Atlas im Einsatz ist. Es scheint, dass Boston Dynamics im Bereich kommerzieller humanoider Roboter entschlossen ist, mit Tesla zu konkurrieren. Nach der Veröffentlichung des neuen Videos wurde es innerhalb von nur zehn Stunden bereits von mehr als einer Million Menschen angesehen. Die alten Leute gehen und neue Rollen entstehen. Das ist eine historische Notwendigkeit. Es besteht kein Zweifel, dass dieses Jahr das explosive Jahr der humanoiden Roboter ist. Netizens kommentierten: Die Weiterentwicklung der Roboter hat dazu geführt, dass die diesjährige Eröffnungsfeier wie Menschen aussieht, und der Freiheitsgrad ist weitaus größer als der von Menschen. Aber ist das wirklich kein Horrorfilm? Zu Beginn des Videos liegt Atlas ruhig auf dem Boden, scheinbar auf dem Rücken. Was folgt, ist atemberaubend

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

Anfang dieses Monats schlugen Forscher des MIT und anderer Institutionen eine vielversprechende Alternative zu MLP vor – KAN. KAN übertrifft MLP in Bezug auf Genauigkeit und Interpretierbarkeit. Und es kann MLP, das mit einer größeren Anzahl von Parametern ausgeführt wird, mit einer sehr kleinen Anzahl von Parametern übertreffen. Beispielsweise gaben die Autoren an, dass sie KAN nutzten, um die Ergebnisse von DeepMind mit einem kleineren Netzwerk und einem höheren Automatisierungsgrad zu reproduzieren. Konkret verfügt DeepMinds MLP über etwa 300.000 Parameter, während KAN nur etwa 200 Parameter hat. KAN hat eine starke mathematische Grundlage wie MLP und basiert auf dem universellen Approximationssatz, während KAN auf dem Kolmogorov-Arnold-Darstellungssatz basiert. Wie in der folgenden Abbildung gezeigt, hat KAN

Langsame Internetgeschwindigkeiten für Mobilfunkdaten auf dem iPhone: Korrekturen

May 03, 2024 pm 09:01 PM

Langsame Internetgeschwindigkeiten für Mobilfunkdaten auf dem iPhone: Korrekturen

May 03, 2024 pm 09:01 PM

Stehen Sie vor einer Verzögerung oder einer langsamen mobilen Datenverbindung auf dem iPhone? Normalerweise hängt die Stärke des Mobilfunk-Internets auf Ihrem Telefon von mehreren Faktoren ab, wie z. B. der Region, dem Mobilfunknetztyp, dem Roaming-Typ usw. Es gibt einige Dinge, die Sie tun können, um eine schnellere und zuverlässigere Mobilfunk-Internetverbindung zu erhalten. Fix 1 – Neustart des iPhone erzwingen Manchmal werden durch einen erzwungenen Neustart Ihres Geräts viele Dinge zurückgesetzt, einschließlich der Mobilfunkverbindung. Schritt 1 – Drücken Sie einfach einmal die Lauter-Taste und lassen Sie sie los. Drücken Sie anschließend die Leiser-Taste und lassen Sie sie wieder los. Schritt 2 – Der nächste Teil des Prozesses besteht darin, die Taste auf der rechten Seite gedrückt zu halten. Lassen Sie das iPhone den Neustart abschließen. Aktivieren Sie Mobilfunkdaten und überprüfen Sie die Netzwerkgeschwindigkeit. Überprüfen Sie es erneut. Fix 2 – Datenmodus ändern 5G bietet zwar bessere Netzwerkgeschwindigkeiten, funktioniert jedoch besser, wenn das Signal schwächer ist

Die Vitalität der Superintelligenz erwacht! Aber mit der Einführung der sich selbst aktualisierenden KI müssen sich Mütter keine Sorgen mehr über Datenengpässe machen

Apr 29, 2024 pm 06:55 PM

Die Vitalität der Superintelligenz erwacht! Aber mit der Einführung der sich selbst aktualisierenden KI müssen sich Mütter keine Sorgen mehr über Datenengpässe machen

Apr 29, 2024 pm 06:55 PM

Ich weine zu Tode. Die Daten im Internet reichen überhaupt nicht aus. Das Trainingsmodell sieht aus wie „Die Tribute von Panem“, und KI-Forscher auf der ganzen Welt machen sich Gedanken darüber, wie sie diese datenhungrigen Esser ernähren sollen. Dieses Problem tritt insbesondere bei multimodalen Aufgaben auf. Zu einer Zeit, als sie ratlos waren, nutzte ein Start-up-Team der Abteilung der Renmin-Universität von China sein eigenes neues Modell, um als erstes in China einen „modellgenerierten Datenfeed selbst“ in die Realität umzusetzen. Darüber hinaus handelt es sich um einen zweigleisigen Ansatz auf der Verständnisseite und der Generierungsseite. Beide Seiten können hochwertige, multimodale neue Daten generieren und Datenrückmeldungen an das Modell selbst liefern. Was ist ein Modell? Awaker 1.0, ein großes multimodales Modell, das gerade im Zhongguancun-Forum erschienen ist. Wer ist das Team? Sophon-Motor. Gegründet von Gao Yizhao, einem Doktoranden an der Hillhouse School of Artificial Intelligence der Renmin University.

Die U.S. Air Force präsentiert ihren ersten KI-Kampfjet mit großem Aufsehen! Der Minister führte die Testfahrt persönlich durch, ohne in den gesamten Prozess einzugreifen, und 100.000 Codezeilen wurden 21 Mal getestet.

May 07, 2024 pm 05:00 PM

Die U.S. Air Force präsentiert ihren ersten KI-Kampfjet mit großem Aufsehen! Der Minister führte die Testfahrt persönlich durch, ohne in den gesamten Prozess einzugreifen, und 100.000 Codezeilen wurden 21 Mal getestet.

May 07, 2024 pm 05:00 PM

Kürzlich wurde die Militärwelt von der Nachricht überwältigt: US-Militärkampfflugzeuge können jetzt mithilfe von KI vollautomatische Luftkämpfe absolvieren. Ja, erst kürzlich wurde der KI-Kampfjet des US-Militärs zum ersten Mal der Öffentlichkeit zugänglich gemacht und sein Geheimnis gelüftet. Der vollständige Name dieses Jägers lautet „Variable Stability Simulator Test Aircraft“ (VISTA). Er wurde vom Minister der US-Luftwaffe persönlich geflogen, um einen Eins-gegen-eins-Luftkampf zu simulieren. Am 2. Mai startete US-Luftwaffenminister Frank Kendall mit einer X-62AVISTA auf der Edwards Air Force Base. Beachten Sie, dass während des einstündigen Fluges alle Flugaktionen autonom von der KI durchgeführt wurden! Kendall sagte: „In den letzten Jahrzehnten haben wir über das unbegrenzte Potenzial des autonomen Luft-Luft-Kampfes nachgedacht, aber es schien immer unerreichbar.“ Nun jedoch,