Huawei Cloud bringt KI-Rechenleistung in die Welt

Das ganze Jahr 2023 über freut sich die globale Technologie-Community auf große Modelle. Als kürzester Weg zwischen großen KI-Modellen und Industrieszenarien hat die Cloud-Computing-Branche in der Welle großer Modelle natürlich viel Aufmerksamkeit auf sich gezogen. Zu diesem Zeitpunkt sind Cloud-Anbieter einer nach dem anderen in die Branche der großen Modelle eingestiegen und haben die Möglichkeiten, die große Modelle der Cloud-Computing-Branche bieten, aus verschiedenen Blickwinkeln untersucht.

Aber wir neigen dazu, einen solchen Schlüsselknoten zu ignorieren: Die erste Herausforderung großer Modelle mit „Hunderten von Modellen und Tausenden von Zuständen“ ist die Rechenleistung der KI. Um bei großen Modelldiensten gute Arbeit zu leisten, müssen wir auch bei Rechenleistungsdiensten gute Arbeit leisten.

In der grundlegendsten Fähigkeit der KI-Rechenleistung liegt die eigentliche Antwort darauf, wie KI-Cloud-Dienste noch weiter gehen können.

Am 21. September hielt Zhang Pingan, Geschäftsführer von Huawei und CEO von Huawei Cloud, während der Huawei Connected Conference 2023 eine Grundsatzrede mit dem Schwerpunkt „Aufbau einer Cloud-Basis für eine intelligente Welt, die KI ermöglicht, Tausende von Industrien neu zu gestalten“ und veröffentlichte das Pangu-Modell Innovative Dienstleistungen in den Bereichen Bergbau, Regierungsangelegenheiten, Automobile, Meteorologie, Medizin, digitale Menschen, Forschung und Entwicklung usw. und kündigten den offiziellen Start des Huawei Cloud Ascend AI Cloud-Dienstes an, der die Realisierung umfassender integrativer Vorteile für beschleunigt Tausende Branchen. Das Thema der Huawei Cloud-Freigabe konzentriert sich diesmal auf die Umsetzung des Pangu-Großmodells und lautet „Schwierige Probleme lösen und schwierige Dinge tun“. Das erste Problem, das Huawei Cloud löst, besteht darin, die KI-Rechenleistung nutzbar, ausreichend, benutzerfreundlich und von großem Nutzen zu machen.

Während die Rechenleistung das Land erreicht, beginnt die KI durchzustarten.

Um diese wichtige „schwierige Sache“ zu erledigen, hat sich der Shengteng AI Cloud Service vorgenommen.

Große Berge und Flüsse erfordern enorme KI-Rechenleistung

Seit der Informationsrevolution hat der Mensch nach und nach herausgefunden, dass das Ausmaß technologischer Innovation direkt proportional zum Verbrauch von Rechenleistung ist. Dies wurde erneut durch große Modelle bestätigt.

Das Aufkommen und die Reife großer Modelle haben der Intelligenz Tausender Branchen neue Möglichkeiten eröffnet. Man kann sagen, dass jede Szene in jeder Branche es wert ist, in das große Modell integriert zu werden, und selbst die meisten von ihnen können durch das große Modell umgestaltet werden. Ob es sich um die Eigenschaften des großen Modells selbst mit großem Modellmaßstab und vielen Datenparametern handelt oder um die aufkommende Nachfrage nach großen Modellen in verschiedenen Branchen, sie alle deuten auf das gleiche Ergebnis hin: die vom sozialen Produktionssystem verbrauchte KI-Rechenleistung wird exponentiell zunehmen.

Große Modelle erfordern eine große Rechenleistung, was zu einem Branchenkonsens geworden ist. Wenn wir dieses Thema jedoch konkret aufgreifen, werden wir feststellen, dass die industriellen Herausforderungen rund um die KI-Rechenleistung sehr vielfältig sind. Wir können es in vier Typen zusammenfassen: Widerspruch zwischen Angebot und Nachfrage, Herausforderungen bei der Energieeffizienz, Betriebs- und Wartungsanforderungen und Sicherheitsbedenken.

Werfen wir zunächst einen Blick auf die zentrale Herausforderung der KI-Rechenleistung, nämlich das objektive Ungleichgewicht zwischen Angebot und Nachfrage.

Stand Juli 2023 wurden in China insgesamt 130 große Modelle auf den Markt gebracht. Der „Battle of 100 Models“ hat zu einem enormen Anstieg der KI-Rechenleistung geführt. Relevanten Datenberichten zufolge ist der weltweite Bedarf an KI-Rechenleistung in den letzten 10 Jahren um das 300.000-fache gestiegen, und wir werden in den nächsten 10 Jahren mit einem 500-fachen Anstieg der Nachfrage konfrontiert sein. Laut dem „2022-2023 China Artificial Intelligence Computing Power Development Assessment Report“ hat die Gesamtmenge der im Jahr 2022 in China durchgeführten KI-Rechenleistungen die allgemeine Rechenleistung übertroffen. In absehbarer Zukunft wird KI-Rechenleistung die Rechenform mit der größten Nachfrage aus allen Lebensbereichen, der größten Lücke zwischen Angebot und Nachfrage und der ressourcenbeschränktesten Rechenleistung sein.

Zweitens bringen große Modelle und große Rechenleistung akute Probleme mit der Energieeffizienz mit sich.

Da das Training großer Modelle geclustertes KI-Computing erfordert, hängen seine Trainingsaufgaben stark von Rechenzentren ab. Die Leistungsdichte von KI-Servern übersteigt die von gewöhnlichen Servern bei weitem und der Stromverbrauch eines einzelnen Schranks ist sechs- bis achtmal höher als in der Vergangenheit . Im Zusammenhang mit Dual Carbon muss die Energieeffizienzquote von Rechenzentren weiter sinken. Daher ist das durch große Modelle verursachte Problem der Rechenenergieeffizienz geworden. Wie ein Gleichgewicht zwischen der Verbesserung der KI-Rechenleistung und der Verringerung der Energieeffizienzquote hergestellt werden kann, ist zu einem Problem geworden, mit dem sich die Branche auseinandersetzen muss.

Darüber hinaus müssen wir während des Anwendungsprozesses der KI-Rechenleistung eine Reihe von Betriebs- und Wartungsproblemen sehen. Da die Schulungs- und Bereitstellungsziele großer Modelle unterschiedlich sind und auch ihre jeweiligen Schulungs- und Bereitstellungsumgebungen sehr unterschiedlich sind, treten in diesem Zeitraum natürlich Betriebs- und Wartungsprobleme wie Netzwerkverzögerung, Modellzuverlässigkeit sowie Schwellenwerte für das Betriebs- und Wartungsmanagement auf. Beispielsweise erfordern einige große Modelle extrem große Rechenleistungscluster, um sie zu unterstützen, und es treten häufig Probleme bei der Koordination zwischen einer großen Anzahl von Servern und Recheneinheiten auf. Sobald ein Problem mit der Recheneinheit auftritt, müssen Entwickler das Training neu starten. Der enorme Zeit-, Talent- und Rechenleistungsaufwand beim Training großer Modelle entsteht durch häufige Fehler und Neustarts von Trainingsaufgaben. Daher benötigen große Modelle nicht nur ausreichend KI-Rechenleistung, sondern auch hochentwickelte Rechenleistungsdienste, um Benutzern dabei zu helfen, allgemeine Betriebs- und Wartungsprobleme zu reduzieren.

Schließlich werden wir auch sehen, dass große Modelle neue Sicherheitsbedenken mit sich bringen.

Da sich die Einsatzszenarien großer Modelle meist auf die Volkswirtschaft und den Lebensunterhalt der Menschen beziehen, müssen alle Sicherheitsrisiken beseitigt werden. In Bereichen wie Datenzugriff, Speicherverschlüsselung und Übertragungssicherheit weisen große Modelle immer noch viele Sicherheitsrisiken auf.

Insgesamt handelt es sich bei großen Modellen nicht um sehr konsistente Produkte. Seine technische Klassifizierung ist komplex und die technischen Pfade sind veränderbar, außerdem muss jeder Benutzer das große Modell entsprechend seinen eigenen Bedürfnissen verfeinern und anpassen. Diese Probleme führen dazu, dass große Modelle aus verschiedenen Aspekten und Blickwinkeln differenzierte Anforderungen an KI-Rechenleistungsdienste stellen.

Die Erfüllung der KI-Rechenleistungsanforderungen großer Modelle ist zur ersten Testfrage im Zeitalter großer Modelle geworden.

Machen Sie Shengteng AI Cloud-Dienste praktisch, raffiniert und wettbewerbsfähig

Damit Huawei Cloud die Frage nach der Rechenleistung gut beantworten kann, müssen zwei Aspekte der Konstruktion berücksichtigt werden: Einer ist, wie die KI-Rechenleistung ausreichend und verfügbar gemacht werden kann, und der andere ist, wie die Rechenleistungsdienste im Betrieb verteilt werden können und Herausforderungen in den Bereichen Wartung, Sicherheit und Energieeffizienz usw. KI-Rechenleistung muss sowohl praktisch als auch präzise sein.

Im Juli dieses Jahres veröffentlichte Huawei Cloud den neuesten Ascend AI Cloud-Dienst, der Benutzern in Tausenden von Branchen eine enorme KI-Rechenleistung bieten kann. Dahinter steckt der solide Aufbau der Computing-Infrastruktur von Huawei Cloud.

Bisher hat Huawei Cloud drei große KI-Rechenzentren in Gui'an, Ulanqab und Wuhu gebaut. Auf dieser Grundlage hat der Shengteng AI Cloud Service landesweit einen Latenzkreis von 20 ms erreicht. Benutzer können einen Nahzugriff erhalten, und eine einzige Glasfaser kann eine Verbindung zur wachsenden KI-Rechenleistung herstellen, und der Dienst kann sofort genutzt werden. Um die Sicherheit großer Modelltrainingsdaten über den gesamten Lebenszyklus zu gewährleisten, nutzt der Shengteng AI Cloud-Dienst außerdem mehrere Technologien wie Datenübertragung und Speicherverschlüsselung, Datensicherheitsklärung, Datenzugriffskontrolle und Datenwasserzeichen, um Lecks zu verhindern. Es ist erwähnenswert, dass Cloud-Dienste im Dual-Carbon-Zeitalter die energieeffizienteste Möglichkeit sind, KI-Rechenleistung zu erhalten, sei es für Unternehmen oder die Gesellschaft als Ganzes.

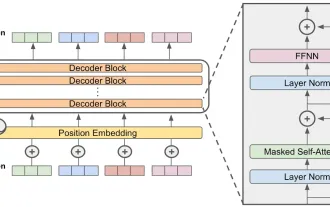

Um die ultimative Leistung der KI-Rechenleistung zu erreichen, hat Huawei Cloud zusätzlich zur Infrastruktur auch technische Optimierungen für KI-Cloud-Dienste durchgeführt. ModelArts bietet beispielsweise eine dreistufige Beschleunigung von Daten, Training und Inferenz. Durch die DataTurbo-Datenbeschleunigungstechnologie kann es Rechenknotenspeicherressourcen nutzen, um einen verteilten Cache aufzubauen, wodurch die Datenleselatenz auf weniger als Millisekunden reduziert wird. Die TrainTurbo-Trainingsbeschleunigungstechnologie kann die Datenlesezeit um 50 % verkürzen, wenn die Trainingsdaten 100 T überschreiten, und die gesamte Trainingseffizienz um mehr als 20 % verbessern. Im Inferenzprozess des Modells beschleunigt die InferTurbo-Inferenzbeschleunigungstechnologie die Modellinferenz durch die Graphkompilierungstechnologie und verbessert die Inferenzleistung großer Modelle durch vertikale kollaborative Optimierung mit vollständiger Verbindung um 30 %.

Mit der Unterstützung einer solch leistungsstarken Infrastruktur und Kerntechnologie können Benutzer die ultimative KI-Rechenleistung erzielen. Um die Rechenleistung nicht nur „ausreichend“, sondern auch „benutzerfreundlich“ zu machen, hat Huawei Cloud eine Reihe von „ KI-Rechenleistung effizienter gestalten.“ „Essenz“-Erkundung.

Zum Beispiel ist die KI-Entwicklung auf umfassende Tools und Plattformen angewiesen. Hinter dem Ascend AI Cloud-Dienst stehen eine Reihe von KI-basierten Entwicklungstools und Technologieplattformen, die Huawei weiterhin aufbaut, wie die heterogene Computerarchitektur CANN, das vollständige Szenario-KI-Framework MindSpore und die KI-Entwicklungsproduktionslinie ModelArts , um verteilte parallele Beschleunigung für große Modelle bereitzustellen. Schlüsselfunktionen wie Operator- und Kompilierungsoptimierung sowie Kommunikationsoptimierung auf Clusterebene bilden die Grundlage für KI-Rechenleistungsdienste.

Wie oben erwähnt, stehen wir im Prozess der Schulung und Bereitstellung großer Modelle auch vor einer Reihe von Problemen bei Betrieb und Wartung, Energieeffizienz und anderen Problemen. Im Hinblick auf die Optimierung der Rechenleistungsdienste kann der Ascend AI Cloud Service längere und stabilere KI-Rechenleistungsdienste bereitstellen. Die 30-Tage-Langzeitstabilitätsrate des Kilokalorientrainings erreicht auch eine Informationserfassung auf Minutenebene. 2-Stunden-Abgrenzung und 24-Stunden-Bereitstellung Lösung: Die Wiederherstellungszeit für den Haltepunkt beträgt nicht mehr als 10 Minuten und die Wiederherstellungszeit für die Aufgabe beträgt weniger als eine halbe Stunde.

In Bezug auf die Modellmigration stellt Huawei Cloud Benutzern eine Migrationstoolkette zur Verfügung und integriert Full-Stack-Entwicklungstools, mit denen eine typische Modellmigrationseffizienz in nur zwei Wochen und eine Self-Service-Migration in Mainstream-Szenarien erreicht werden können. Darüber hinaus ist der Ascend AI Cloud-Dienst auch an die gängigen Open-Source-Großmodelle der Branche wie LLAMA, Stable Diffusion usw. angepasst, sodass der Ascend AI Cloud-Dienst wirklich die Anforderungen „verschiedener Modelle und Tausender Zustände“ erfüllen kann große Modelle.

Für Sportler ist die Grundkompetenz Wettbewerbsfähigkeit. Im Sinne des Cloud + Large-Modells hat Huawei Cloud auch KI-Rechenleistung entwickelt, um durch die Integration von Infrastruktur, Technologie und Diensten wettbewerbsfähig zu werden.

Die benutzerfreundliche KI-Rechenleistung von Paper ist der Grundstein für die Industrialisierung großer Modelle und der Anfang aller Geschichten.

Rechenleistung, Technologie, Szenarien: Aufbau eines großen modellpositiven Kreislaufs

Angesichts der plötzlichen enormen intelligenten Möglichkeiten großer Modelle haben Benutzer aus Tausenden von Branchen enorme und differenzierte Bedürfnisse. Manchen fehlt es an Rechenleistung, manche brauchen Modelle, manche suchen nach Szenarien und manche brauchen die Hilfe spezifischer technischer Tools. Das Fehlen einer einzigen Bedingung verhindert, dass sich das Schwungrad des großen Modells dreht.

Aus einer anderen Perspektive betrachtet kann der szenariobasierte Einsatz von Rechenressourcen, technischen Werkzeugen und Modellen zu Dreh- und Angelpunkten werden. Diese Elemente können Geschäftsanwendern und Entwicklern dabei helfen, durch umfassende Zusammenarbeit und gegenseitige Förderung den Weg zu großen Modellen einzuschlagen.

Der von Huawei Cloud bereitgestellte KI-Cloud-Dienst Shengteng verfügt nicht nur über nutzbare, ausreichende und benutzerfreundliche KI-Rechenleistung, sondern kann auch mit einer Reihe von Layouts der Huawei Cloud verknüpft werden, um große Modelle von nun an „nützlich“ zu machen , wodurch gemeinsam die Pangu-Ära verwirklicht wird. Modelle lösen schwierige Probleme und tun schwierige Dinge.

Wir können zum Beispiel sehen, dass sich viele technologische Innovationen und Ascend AI Cloud-Dienste ergänzen und gemeinsam die Herausforderung der hohen Nachfrage nach KI-Rechenleistung und der Schwierigkeit bei der Versorgung lösen. Die neu veröffentlichte verteilte QingTian-Architektur von Huawei Cloud hat einen solchen Effekt.

Der Rechenleistungsbedarf großer Modellanwendungen, die durch AIGC repräsentiert werden, hängt stark von verteilten Rechenfunktionen ab, was auch neue Herausforderungen an die Rechenleistungsarchitektur stellt. Als eine neue Generation der Peer-to-Peer-Architektur kann die verteilte QingTian-Architektur den traditionellen Rechenzentrums-Computing-Cluster zu einem Peer-to-Peer-Pool-Systemcluster auf Basis von Hochgeschwindigkeitsbussen weiterentwickeln und so die Leistungsbeschränkungen eines einzelnen Systems überwinden Komponente und ermöglicht die Zusammenarbeit sowie Verwaltung und Kontrolle von Software und Hardware, ohne Ressourcen- und Leistungsverluste und bietet Benutzern letztendlich das ultimative Erlebnis in Bezug auf Leistung, Zuverlässigkeit, Sicherheit und Vertrauenswürdigkeit.

Darüber hinaus hat Huawei Cloud auch in einer Reihe von Bereichen technologische Innovationen wie KI-Cloud-Speicher, GaussDB-Vektordatenbank, Digital Intelligence Fusion, Serverless+ Large Model Engineering Suite usw. hervorgebracht und sich dabei auf die sich ständig weiterentwickelnden KI-Anforderungen konzentriert Die Schicht, die Modellschulungsschicht und die Anwendungsentwicklungsschicht erreichen systematische Innovationen und beseitigen so die Hindernisse für Benutzer bei der Nutzung von KI-Cloud-Diensten und ermöglichen eine wirkliche Anpassung der KI-Rechenleistung an die szenariobasierten Anforderungen Tausender Branchen.

Zusätzlich zur grundlegenden KI-Rechenleistung und einer Reihe technologischer Innovationen gibt es die Pangu-Serie großer Modelle, die von Huawei Cloud bereitgestellt wird. Auf der Huawei Full Connection Conference 2023 können wir auch sehen, dass das Pangu-Großmodell in tiefergehenden Szenarien in der Branche umgesetzt wurde.

In der Automobilindustrie können die großen Modelle von Pangu Automobile Design, Produktion, Marketing, Forschung und Entwicklung sowie andere Aspekte von Automobilunternehmen abdecken und in Bereichen wie dem autonomen Fahrtraining und der Implementierung spezieller Szenen einen einzigartigen Wert darstellen. Im Bereich des autonomen Fahrens kann das große Modell von Pangu Automobile auf der Grundlage der von der tatsächlichen Szene gesammelten Fotos und Videos einen digitalen Zwillingsraum der Szene erstellen und bewegliche Objekte, bearbeitbares Wetter, Beleuchtung usw. hinzufügen, um Szenenbeispiele für autonomes Fahren zu generieren Fahrlernen. In Betriebsszenarien wie Häfen und Bergbaugebieten kann der Multi-Szenario- und Multi-Fahrzeug-Steuerungsalgorithmus des großen Modells von Pangu Automobile den seitlichen Fehler eines 60-Tonnen-Schwerlastwagens auf weniger als 0,2 Meter und den genauen Andockfehler auf weniger als 0,1 Meter reduzieren . Derzeit sind 23 unbemannte Schwerlastkraftwagen 24 Stunden am Tag in den Minen im Xinjiang Jiangna Mining Industry und im Yimin Tagebau in der Inneren Mongolei im Einsatz.

Im Bereich Live-Übertragung + digitale Menschen ist das Pangu Digital People's Congress-Modell auf der Grundlage hochwertiger Live-Übertragungs-Sprachfähigkeiten auf 100.000 Ebenen vortrainiert. Es kann automatisch professionelle Sprachfähigkeiten generieren, um Produkte präzise und flüssig vorzustellen Erfassen Sie außerdem automatisch Sperrfeuer und interaktives Echtzeit-Publikum. In Danzhai, Guizhou, hat das digitale NPC-Modell Pangu die Batik der Industrie des immateriellen Kulturerbes der Welt zugänglich gemacht.

Zusammenfassend ist es nicht schwer festzustellen, dass Huawei Cloud einen „positiven Zyklus eines großen Modells“ mit KI-Rechenleistung als Basis, technologischer Innovation als Treiber und der Integration des Pangu-Großmodells in Branchenszenarien gebildet hat. Die Rechenleistung von ThePaper AI kann den Einsatz großer Modelle vorantreiben; technologische Innovationen werden die Schwelle für große Modelle weiter senken; Branchenszenarien werden die groß angelegte Implementierung großer Modelle vorantreiben. Rechenleistung fördert die Entwicklung von Szenarien und Technologie; der technologische Fortschritt ermöglicht die vollständige Freisetzung von Rechenleistung, und der Fortschritt von Szenarien wird den Aufbau von Rechenleistung vorantreiben und den technologischen Fortschritt vorantreiben. Die drei sind auf dem Vormarsch und locken Tausende von Branchen dazu, in der Cloud nach Antworten auf große Modelle zu suchen.

Lassen Sie die KI basierend auf der Rechenleistung und der Nutzung der Rechenleistung als Schlüssel in die Berge und Flüsse integrieren – das ist der KI-Langzeitsong von Huawei Cloud.

Das obige ist der detaillierte Inhalt vonHuawei Cloud bringt KI-Rechenleistung in die Welt. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1393

1393

52

52

1205

1205

24

24

Beste KI -Kunstgeneratoren (kostenlos & amp; bezahlt) für kreative Projekte

Apr 02, 2025 pm 06:10 PM

Beste KI -Kunstgeneratoren (kostenlos & amp; bezahlt) für kreative Projekte

Apr 02, 2025 pm 06:10 PM

Der Artikel überprüft Top -KI -Kunstgeneratoren, diskutiert ihre Funktionen, Eignung für kreative Projekte und Wert. Es zeigt MidJourney als den besten Wert für Fachkräfte und empfiehlt Dall-E 2 für hochwertige, anpassbare Kunst.

Ist Chatgpt 4 o verfügbar?

Mar 28, 2025 pm 05:29 PM

Ist Chatgpt 4 o verfügbar?

Mar 28, 2025 pm 05:29 PM

Chatgpt 4 ist derzeit verfügbar und weit verbreitet, wodurch im Vergleich zu seinen Vorgängern wie ChatGPT 3.5 signifikante Verbesserungen beim Verständnis des Kontextes und des Generierens kohärenter Antworten zeigt. Zukünftige Entwicklungen können mehr personalisierte Inters umfassen

Erste Schritte mit Meta Lama 3.2 - Analytics Vidhya

Apr 11, 2025 pm 12:04 PM

Erste Schritte mit Meta Lama 3.2 - Analytics Vidhya

Apr 11, 2025 pm 12:04 PM

Metas Lama 3.2: Ein Sprung nach vorne in der multimodalen und mobilen KI Meta hat kürzlich Lama 3.2 vorgestellt, ein bedeutender Fortschritt in der KI mit leistungsstarken Sichtfunktionen und leichten Textmodellen, die für mobile Geräte optimiert sind. Aufbau auf dem Erfolg o

Beste AI -Chatbots verglichen (Chatgpt, Gemini, Claude & amp; mehr)

Apr 02, 2025 pm 06:09 PM

Beste AI -Chatbots verglichen (Chatgpt, Gemini, Claude & amp; mehr)

Apr 02, 2025 pm 06:09 PM

Der Artikel vergleicht Top -KI -Chatbots wie Chatgpt, Gemini und Claude und konzentriert sich auf ihre einzigartigen Funktionen, Anpassungsoptionen und Leistung in der Verarbeitung und Zuverlässigkeit natürlicher Sprache.

Top -KI -Schreibassistenten, um Ihre Inhaltserstellung zu steigern

Apr 02, 2025 pm 06:11 PM

Top -KI -Schreibassistenten, um Ihre Inhaltserstellung zu steigern

Apr 02, 2025 pm 06:11 PM

In dem Artikel werden Top -KI -Schreibassistenten wie Grammarly, Jasper, Copy.ai, Writesonic und RYTR erläutert und sich auf ihre einzigartigen Funktionen für die Erstellung von Inhalten konzentrieren. Es wird argumentiert, dass Jasper in der SEO -Optimierung auszeichnet, während KI -Tools dazu beitragen, den Ton zu erhalten

Wie kann ich Falcon 3 zugreifen? - Analytics Vidhya

Mar 31, 2025 pm 04:41 PM

Wie kann ich Falcon 3 zugreifen? - Analytics Vidhya

Mar 31, 2025 pm 04:41 PM

Falcon 3: Ein revolutionäres Open-Source-Großsprachmodell Falcon 3, die neueste Iteration in der gefeierten Falcon -Serie von LLMs, stellt einen erheblichen Fortschritt in der AI -Technologie dar. Entwickelt vom Technology Innovation Institute (TII), diesem offen

Auswahl des besten KI -Sprachgenerators: Top -Optionen überprüft

Apr 02, 2025 pm 06:12 PM

Auswahl des besten KI -Sprachgenerators: Top -Optionen überprüft

Apr 02, 2025 pm 06:12 PM

Der Artikel überprüft Top -KI -Sprachgeneratoren wie Google Cloud, Amazon Polly, Microsoft Azure, IBM Watson und Descript, wobei sie sich auf ihre Funktionen, die Sprachqualität und die Eignung für verschiedene Anforderungen konzentrieren.

Top 7 Agentenlagersystem zum Aufbau von KI -Agenten

Mar 31, 2025 pm 04:25 PM

Top 7 Agentenlagersystem zum Aufbau von KI -Agenten

Mar 31, 2025 pm 04:25 PM

2024 veränderte sich von einfacher Verwendung von LLMs für die Erzeugung von Inhalten zum Verständnis ihrer inneren Funktionsweise. Diese Erkundung führte zur Entdeckung von AI -Agenten - autonome Systeme zur Handhabung von Aufgaben und Entscheidungen mit minimalem menschlichen Eingreifen. Bauen