Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

IT Industrie

IT Industrie

Alibaba Cloud gab bekannt, dass es Tongyi Qianwens 14-Milliarden-Parameter-Modell Qwen-14B und sein Dialogmodell als Open Source veröffentlichen wird, die für die kommerzielle Nutzung kostenlos sein werden.

Alibaba Cloud gab bekannt, dass es Tongyi Qianwens 14-Milliarden-Parameter-Modell Qwen-14B und sein Dialogmodell als Open Source veröffentlichen wird, die für die kommerzielle Nutzung kostenlos sein werden.

Alibaba Cloud gab bekannt, dass es Tongyi Qianwens 14-Milliarden-Parameter-Modell Qwen-14B und sein Dialogmodell als Open Source veröffentlichen wird, die für die kommerzielle Nutzung kostenlos sein werden.

Alibaba Cloud hat heute ein Open-Source-Projekt namens Qwen-14B angekündigt, das ein parametrisches Modell und ein Konversationsmodell umfasst. Dieses Open-Source-Projekt ermöglicht die kostenlose kommerzielle Nutzung

Aussage dieser Website: Alibaba Cloud hat zuvor ein Parametermodell Qwen-7B im Wert von 7 Milliarden als Open-Source-Quelle bereitgestellt, und das Downloadvolumen hat in mehr als einem Monat die 1-Millionen-Marke überschritten

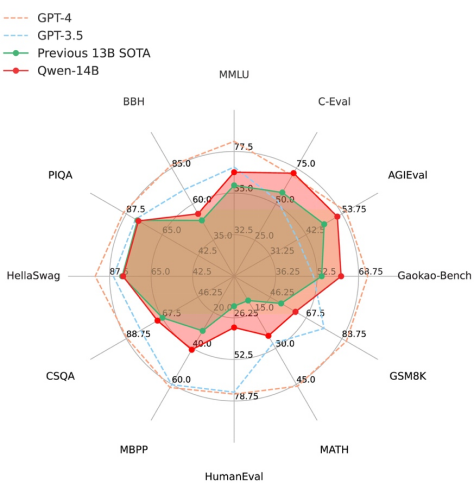

Den von Alibaba Cloud bereitgestellten Daten zufolge übertrifft Qwen-14B in mehreren maßgeblichen Bewertungen Modelle gleicher Größe, und einige Indikatoren liegen sogar nahe an Llama2-70B.

Berichten zufolge handelt es sich bei Qwen-14B um ein leistungsstarkes Open-Source-Modell, das mehrere Sprachen unterstützt. Seine gesamten Trainingsdaten übersteigen 3 Billionen Token, verfügen über stärkere Argumentations-, Erkenntnis-, Planungs- und Gedächtnisfähigkeiten und unterstützen eine maximale Kontextfensterlänge von 8k

Im Gegensatz dazu basiert Qwen-14B-Chat auf dem Basismodell. Das durch erhaltene Dialogmodell Eine verfeinerte SFT kann genauere Inhalte liefern, die den menschlichen Vorlieben besser entsprechen, und außerdem die Vorstellungskraft und den Reichtum der Inhaltserstellung erweitern.

Ab heute können Benutzer Modelle direkt aus der Alibaba Moda-Community herunterladen und über die Alibaba Cloud Lingji-Plattform auch auf Qwen-14B und Qwen-14B-Chat zugreifen und diese anrufen.

Zhou Jingren, CTO von Alibaba Cloud, sagte, dass Alibaba Cloud weiterhin Open Source und Offenheit fördern und den Aufbau von Chinas großem Modell-Ökosystem fördern werde. Alibaba Cloud glaubt fest an die Leistungsfähigkeit von Open Source und übernimmt die Führung bei selbst entwickelten Open-Source-Großmodellen, in der Hoffnung, die Technologie großer Modelle schneller für kleine und mittlere Unternehmen und einzelne Entwickler bereitzustellen.

Modell-Zero-Code-Erstellungsraum-Erfahrungsadresse:

https://modelscope.cn/stud/qwen/Qwen-14B-Chat-Demo

Umgebungskonfiguration und -installation

Python-Version 3.8 und höher

-

Pytorch-Version 1.12 und höher, Version 2.0 und höher empfohlen

Es wird empfohlen, CUDA 11.4 und höher zu verwenden (GPU-Benutzer müssen diese Option in Betracht ziehen)

Verwendungsschritte

Hinweis: Unter der Umgebungskonfiguration von ausführen PAI-DSW (Sie können eine einzelne Karte zum Ausführen verwenden, die Mindestanforderung an den Videospeicher beträgt 11 GB)

Qwen-14B-Chat-Modell-Link:

https://modelscope.cn/models/qwen/Qwen -14B-Chat

Qwen-14B-Modell-Link:

https://modelscope.cn/models/qwen/Qwen-14B

Qwen-14B-Chat-Int4-Modell-Link :

https://www .modelscope.cn/models/qwen/Qwen-14B-Chat-Int4

Die Community unterstützt das direkte Herunterladen des Repos des Modells:

from modelscope.hub.snapshot_download import snapshot_download<br>model_dir = snapshot_download('qwen/Qwen-14B-Chat', 'v1.0.0')

Werbehinweis: Externer Sprung Die im Artikel enthaltenen Links (einschließlich, aber nicht beschränkt auf Hyperlinks, QR-Code, Passwort usw.) dienen der Übermittlung weiterer Informationen und der Zeitersparnis bei der Auswahl. Die Ergebnisse dienen nur als Referenz. Alle Artikel auf dieser Website enthalten diese Erklärung.

Das obige ist der detaillierte Inhalt vonAlibaba Cloud gab bekannt, dass es Tongyi Qianwens 14-Milliarden-Parameter-Modell Qwen-14B und sein Dialogmodell als Open Source veröffentlichen wird, die für die kommerzielle Nutzung kostenlos sein werden.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1375

1375

52

52

Alibaba Cloud gab bekannt, dass die Yunqi-Konferenz 2024 vom 19. bis 21. September in Hangzhou stattfinden wird. Kostenlose Anmeldung für kostenlose Tickets

Aug 07, 2024 pm 07:12 PM

Alibaba Cloud gab bekannt, dass die Yunqi-Konferenz 2024 vom 19. bis 21. September in Hangzhou stattfinden wird. Kostenlose Anmeldung für kostenlose Tickets

Aug 07, 2024 pm 07:12 PM

Laut Nachrichten dieser Website vom 5. August gab Alibaba Cloud bekannt, dass die Yunqi-Konferenz 2024 vom 19. bis 21. September in der Stadt Yunqi in Hangzhou stattfinden wird. Es wird ein dreitägiges Hauptforum, 400 Unterforen und parallele Themen geben. sowie knapp vierzehntausend Quadratmeter Ausstellungsfläche. Die Yunqi-Konferenz ist kostenlos und für die Öffentlichkeit zugänglich. Ab sofort kann die Öffentlichkeit kostenlose Tickets über die offizielle Website der Yunqi-Konferenz erwerben. Die Ticket-Website ist auf dieser Website angehängt. https://yunqi.aliyun.com/2024 /ticket-list Berichten zufolge entstand die Yunqi-Konferenz im Jahr 2009 und hieß ursprünglich „First China Website Development Forum“. Im Jahr 2015 entwickelte sie sich zur Alibaba Cloud Developer Conference , wurde sie offiziell in „Yunqi-Konferenz“ umbenannt und verlief weiterhin erfolgreich

Wo finde ich die Alibaba-ID?

Mar 08, 2024 pm 09:49 PM

Wo finde ich die Alibaba-ID?

Mar 08, 2024 pm 09:49 PM

Sobald Sie in der Alibaba-Software erfolgreich ein Konto registriert haben, weist Ihnen das System eine eindeutige ID zu, die als Ihre Identität auf der Plattform dient. Viele Benutzer möchten jedoch ihre ID abfragen, wissen aber nicht, wie das geht. Dann wird Ihnen der Herausgeber dieser Website unten eine detaillierte Einführung in die Strategieschritte geben. Ich hoffe, es kann Ihnen helfen! Wo finde ich die Antwort auf die Alibaba-ID: [Alibaba]-[My]. 1. Öffnen Sie zuerst die Alibaba-Software. Nachdem Sie die Startseite aufgerufen haben, müssen Sie auf [Mein] in der unteren rechten Ecke klicken. 2. Nachdem wir zur „Mein“-Seite gelangt sind, können wir oben auf der Seite [ID] sehen Ist die ID dieselbe wie die Taobao-ID? Alibaba ID und Taobao ID sind unterschiedlich, aber die beiden

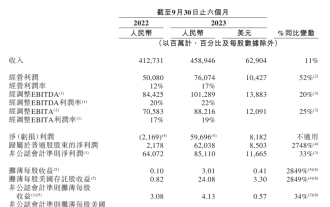

Aus dem halbjährlichen Finanzbericht von Alibaba für das Geschäftsjahr 2024 geht hervor, dass der Umsatz 458,946 Milliarden Yuan erreichte, was einem Anstieg von 11 % gegenüber dem Vorjahr entspricht, und dass der der Muttergesellschaft zuzurechnende Nettogewinn im Jahresvergleich um 2748 % stieg.

Jan 04, 2024 pm 06:44 PM

Aus dem halbjährlichen Finanzbericht von Alibaba für das Geschäftsjahr 2024 geht hervor, dass der Umsatz 458,946 Milliarden Yuan erreichte, was einem Anstieg von 11 % gegenüber dem Vorjahr entspricht, und dass der der Muttergesellschaft zuzurechnende Nettogewinn im Jahresvergleich um 2748 % stieg.

Jan 04, 2024 pm 06:44 PM

Laut Nachrichten dieser Website vom 23. Dezember gab Alibaba seinen Zwischenbericht für das Geschäftsjahr 2024 (sechs Monate bis zum 30. September 2023) bekannt und erzielte einen Umsatz von 458,946 Milliarden Yuan, was einer Steigerung des Betriebsgewinns von 11 % gegenüber dem Vorjahr entspricht 76,074 Milliarden Yuan, ein Anstieg von 52 % gegenüber dem Vorjahr; der den Muttergesellschaften zuzurechnende Nettogewinn betrug 62,038 Milliarden Yuan, ein verwässerter Gewinn pro Aktie von 3,01 % gegenüber dem Vorjahr; -Jahressteigerung von 2849 %. Auf dieser Website wurde festgestellt, dass der Umsatz der Taotian Group im Vergleich zum Vorjahr um 8 % gestiegen ist. Das Auslandsgeschäft der Alibaba International Digital Business Group entwickelte sich stark und der Umsatz stieg um 47 %. Der Umsatz der Cainiao Group stieg um 29 %. Der Umsatz der Local Living Group stieg um 22 %. Der Umsatz der Dawen Entertainment Group stieg im sechsmonatigen Zeitraum bis zum 30. September 2023 um 21 %, Cainiao

Die DAMO Academy gibt die letzten Testfragen des Alibaba Global Mathematics Competition 2024 bekannt: fünf Tracks, Ergebnisse im August

Jun 23, 2024 pm 06:36 PM

Die DAMO Academy gibt die letzten Testfragen des Alibaba Global Mathematics Competition 2024 bekannt: fünf Tracks, Ergebnisse im August

Jun 23, 2024 pm 06:36 PM

Laut Nachrichten dieser Website vom 23. Juni erfuhr diese Website aus dem öffentlichen DAMO WeChat-Konto, dass am 22. Juni um 24:00 Uhr (Pekinger Zeit) das Finale des Alibaba Global Mathematics Competition 2024 offiziell endete. Mehr als 800 Teilnehmer aus 17 Ländern und Regionen auf der ganzen Welt wurden für das diesjährige Finale in die engere Wahl gezogen. Als nächstes tritt es in die unabhängige Bewertungsphase der Expertengruppe ein. Die Benotung umfasst eine vorläufige Bewertung, ein Kreuzverhör, eine abschließende Überprüfung und andere Prozesse. In den fünf Finalstrecken werden je nach Ergebnis 1 Goldmedaille, 2 Silbermedaillen, 4 Bronzemedaillen und 10 Excellence Awards vergeben. Insgesamt 85 Gewinner werden im August bekannt gegeben. Die Alibaba Damo Academy hat auch die Themen für das Mathematik-Finale bekannt gegeben: 1. Algebra und Zahlentheorie; 4. Kombination und Wahrscheinlichkeit; und Berechnung.

Der globale Hauptsitz von Alibaba in Hangzhou wurde am 10. Mai in Betrieb genommen

May 07, 2024 pm 02:43 PM

Der globale Hauptsitz von Alibaba in Hangzhou wurde am 10. Mai in Betrieb genommen

May 07, 2024 pm 02:43 PM

Diese Website berichtete am 7. Mai, dass am 10. Mai Alibabas globaler Hauptsitz (Xixi Area C) in der Hangzhou Future Science and Technology City offiziell in Betrieb genommen wird und außerdem der Alibaba Beijing Chaoyang Science and Technology Park eröffnet wird. Damit steigt die Zahl der Bürogebäude in der Alibaba-Zentrale weltweit auf vier. ▲Alibaba Global Headquarters (Zone C, Xixi) Der 10. Mai ist auch Alibabas 20. „Alibaba Day“. An diesem Tag veranstaltet das Unternehmen jedes Jahr Feierlichkeiten und zwei neue Parks werden für Alibabas Verwandte, Freunde und Alumni geöffnet. Xixi Area C ist derzeit Alibabas größter eigener Park und bietet Platz für 30.000 Menschen für Büroarbeiten. ▲Alibaba Beijing Chaoyang Science and Technology Park Der globale Hauptsitz von Alibaba befindet sich in der Hangzhou Future Science and Technology City, nördlich der Wenyi West Road und östlich der Gaojiao Road, mit einer Gesamtbaufläche von 984.500 Quadratmetern

So bezahlen Sie mit WeChat auf Alibaba_So bezahlen Sie mit WeChat auf Alibaba 1688

Mar 20, 2024 pm 05:51 PM

So bezahlen Sie mit WeChat auf Alibaba_So bezahlen Sie mit WeChat auf Alibaba 1688

Mar 20, 2024 pm 05:51 PM

Alibaba 1688 ist eine Einkaufs- und Großhandelswebsite, und die Artikel dort sind viel günstiger als bei Taobao. Wie nutzt Alibaba die WeChat-Zahlung? Der Herausgeber hat einige relevante Inhalte zusammengestellt, die Sie mit Ihnen teilen können. Freunde in Not können vorbeikommen und einen Blick darauf werfen. Wie nutzt Alibaba WeChat zum Bezahlen? Antwort: WeChat-Zahlung kann vorerst nicht verwendet werden gehen Sie zu [Alipay, gestaffelte Zahlung], Kassierer] kann ausgewählt werden;

So geben Sie Waren auf Alibaba zurück

Mar 02, 2024 am 08:16 AM

So geben Sie Waren auf Alibaba zurück

Mar 02, 2024 am 08:16 AM

Bei der Alibaba-Software entscheiden sich viele Benutzer dafür, online einzukaufen. Allerdings gibt es manchmal Situationen, in denen eine Rückgabe erforderlich ist, aber viele Benutzer sind sich immer noch nicht sicher, wie sie eine Rückgabe und Rückerstattung bei Alibaba durchführen sollen. Daher wird der Herausgeber dieser Website die Schritte im Folgenden ausführlich erläutern. Bitte lesen Sie weiter unten! Wie gebe ich Waren auf Alibaba zurück? Antwort: [Alibaba]-[Meine]-[Meine Bestellung]-[Mehr]-[Eine Rückerstattung beantragen]-[Nächster Schritt]-[Eine Rückerstattung beantragen]. Spezifische Schritte: 1. Öffnen Sie zuerst die Alibaba-Software und klicken Sie nach dem Aufrufen der Startseite auf [Mein] in der unteren rechten Ecke. 2. Klicken Sie dann auf der Seite „Meine Bestellung“ auf die Funktion „Meine Bestellung“. Meine Bestellung

Was sind die Caching-Mechanismen von Alibaba Cloud?

Nov 15, 2023 am 11:22 AM

Was sind die Caching-Mechanismen von Alibaba Cloud?

Nov 15, 2023 am 11:22 AM

Zu den Caching-Mechanismen von Alibaba Cloud gehören Alibaba Cloud Redis, Alibaba Cloud Memcache, der verteilte Cache-Dienst DSC, Alibaba Cloud Table Store, CDN usw. Ausführliche Einführung: 1. Alibaba Cloud Redis: Eine von Alibaba Cloud bereitgestellte verteilte Speicherdatenbank, die schnelles Lesen und Schreiben sowie Datenpersistenz unterstützt. Durch die Speicherung von Daten im Speicher können Datenzugriff mit geringer Latenz und hohe Parallelitätsverarbeitungsfunktionen bereitgestellt werden. 2. Alibaba Cloud Memcache: das von Alibaba Cloud usw. bereitgestellte Cache-System.