Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Neuer Titel: TextDiffuser: Keine Angst vor Text in Bildern, sorgt für eine qualitativ hochwertigere Textwiedergabe

Neuer Titel: TextDiffuser: Keine Angst vor Text in Bildern, sorgt für eine qualitativ hochwertigere Textwiedergabe

Neuer Titel: TextDiffuser: Keine Angst vor Text in Bildern, sorgt für eine qualitativ hochwertigere Textwiedergabe

Der Bereich Text-to-Image hat in den letzten Jahren enorme Fortschritte gemacht, insbesondere im Zeitalter der durch künstliche Intelligenz generierten Inhalte (AIGC). Mit dem Aufkommen des DALL-E-Modells sind in der akademischen Gemeinschaft immer mehr Text-to-Image-Modelle entstanden, wie z. B. Imagen, Stable Diffusion, ControlNet und andere Modelle. Trotz der rasanten Entwicklung des Text-zu-Bild-Bereichs stehen bestehende Modelle jedoch immer noch vor einigen Herausforderungen bei der stabilen Generierung von Bildern mit Text

Nachdem wir das vorhandene Sota-Text-zu-Bild-Modell ausprobiert haben, können wir feststellen, dass der Textteil Die vom Modell generierten Daten sind grundsätzlich unleserlich und ähneln verstümmelten Zeichen, was sich stark auf die Gesamtästhetik des Bildes auswirkt.

Die vom bestehenden Sota-Textgenerierungsmodell generierten Textinformationen sind schlecht lesbar

Nach einer Untersuchung gibt es in der akademischen Gemeinschaft weniger Forschung in diesem Bereich. Tatsächlich sind Bilder mit Text im täglichen Leben weit verbreitet, beispielsweise auf Postern, Buchumschlägen und Straßenschildern. Wenn KI solche Bilder effektiv erzeugen kann, wird sie Designer bei ihrer Arbeit unterstützen, Design-Inspirationen anregen und den Designaufwand reduzieren. Darüber hinaus möchten Benutzer möglicherweise nur den Textteil der Ergebnisse des Vincent-Diagrammmodells ändern und die Ergebnisse in anderen Nicht-Textbereichen beibehalten.

Um die ursprüngliche Bedeutung nicht zu verändern, muss der Inhalt ins Chinesische umgeschrieben werden. Der Originalsatz muss nicht erscheinen. textdiffuser/

- Code-Adresse: https://github.com/microsoft/unilm/tree/master/textdiffuser

- Demo-Adresse: https://huggingface.co/spaces/microsoft/TextDiffuser

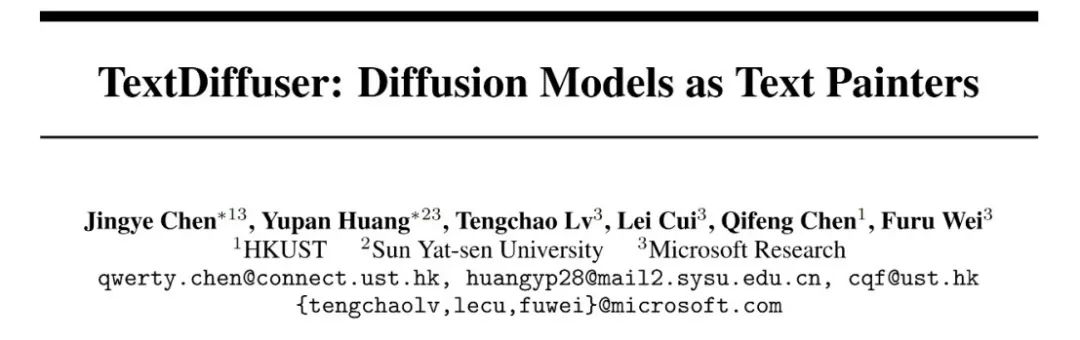

- Drei Funktionen von TextDiffuser

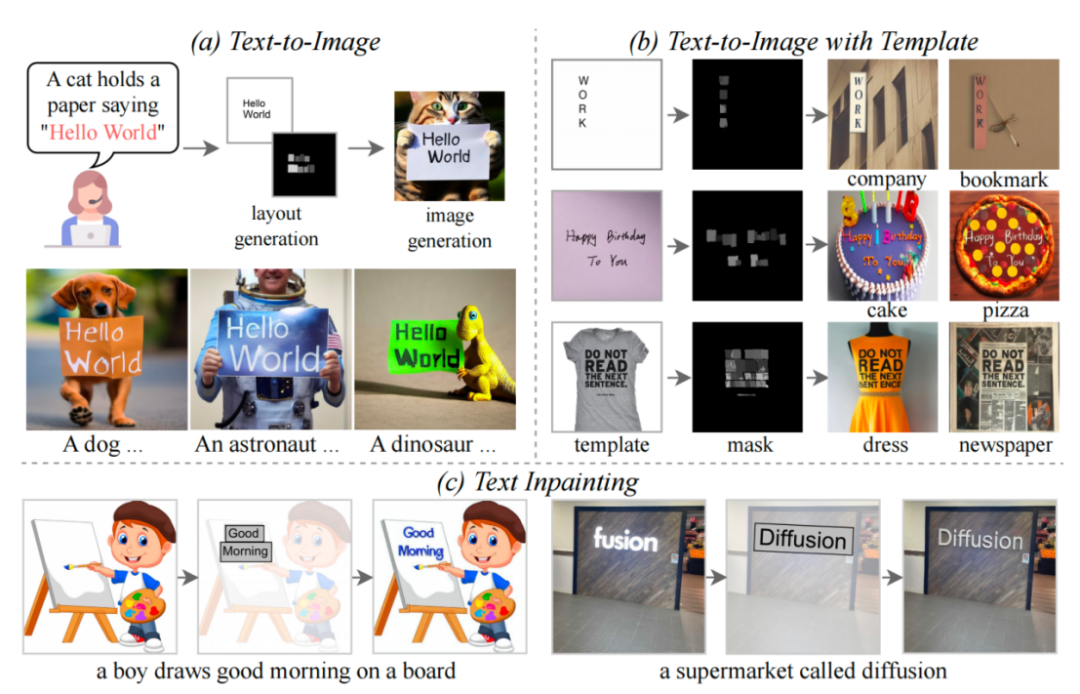

- In diesem Artikel wird das TextDiffuser-Modell vorgeschlagen, das zwei Stufen enthält: Die erste Stufe generiert das Layout und die zweite Stufe generiert Bilder.

Das Modell akzeptiert eine Textaufforderung und bestimmt dann das Layout (dh das Koordinatenfeld) jedes Schlüsselworts basierend auf den Schlüsselwörtern in die Aufforderung. Die Forscher verwendeten Layout Transformer, verwendeten ein Encoder-Decoder-Formular, um das Koordinatenfeld der Schlüsselwörter autoregressiv auszugeben, und verwendeten die PILLOW-Bibliothek von Python zum Rendern des Textes. In diesem Prozess können Sie auch die vorgefertigte API von Pillow verwenden, um die Koordinatenbox jedes Zeichens abzurufen, was dem Abrufen der Segmentierungsmaske auf Zeichenebene auf Boxebene entspricht. Basierend auf diesen Informationen versuchten die Forscher, die stabile Diffusion zu optimieren.

Sie betrachteten zwei Situationen: Die eine besteht darin, dass der Benutzer das gesamte Bild direkt generieren möchte (sogenannte Whole-Image-Generierung). Eine andere Situation ist die Part-Image-Generierung, auch Text-Inpainting im Papier genannt, was bedeutet, dass der Benutzer ein Bild vorgibt und bestimmte Textbereiche im Bild ändern muss.

Um die beiden oben genannten Ziele zu erreichen, haben die Forscher die Eingabefunktionen neu gestaltet und die Dimension von ursprünglich 4 Dimensionen auf 17 Dimensionen erhöht. Dazu gehören vierdimensionale verrauschte Bildmerkmale, achtdimensionale Zeicheninformationen, eindimensionale Bildmasken und vierdimensionale unmaskierte Bildmerkmale. Handelt es sich um eine ganze Bildgeneration, legen die Forscher den Maskenbereich auf das gesamte Bild fest, handelt es sich hingegen um eine Teilbildgeneration, wird nur ein Teil des Bildes maskiert. Der Trainingsprozess des Diffusionsmodells ähnelt dem von LDM. Interessierte Freunde können sich auf die Methodenbeschreibung im Originalartikel beziehen

Um die beiden oben genannten Ziele zu erreichen, haben die Forscher die Eingabefunktionen neu gestaltet und die Dimension von ursprünglich 4 Dimensionen auf 17 Dimensionen erhöht. Dazu gehören vierdimensionale verrauschte Bildmerkmale, achtdimensionale Zeicheninformationen, eindimensionale Bildmasken und vierdimensionale unmaskierte Bildmerkmale. Handelt es sich um eine ganze Bildgeneration, legen die Forscher den Maskenbereich auf das gesamte Bild fest, handelt es sich hingegen um eine Teilbildgeneration, wird nur ein Teil des Bildes maskiert. Der Trainingsprozess des Diffusionsmodells ähnelt dem von LDM. Interessierte Freunde können sich auf die Methodenbeschreibung im Originalartikel beziehen

In der Inferenzphase verfügt TextDiffuser über eine sehr flexible Verwendungsweise, die unterteilt werden kann in drei Typen:

- Bilder basierend auf den Anweisungen des Benutzers erstellen. Darüber hinaus kann der Benutzer, wenn er mit dem im ersten Schritt der Layout-Generierung erstellten Layout nicht zufrieden ist, die Koordinaten und den Inhalt des Textes ändern, was die Steuerbarkeit des Modells erhöht.

- Starten Sie direkt ab der zweiten Etappe. Das Endergebnis wird basierend auf dem Vorlagenbild generiert, wobei das Vorlagenbild ein gedrucktes Textbild, ein handgeschriebenes Textbild oder ein Szenentextbild sein kann. Die Forscher trainierten speziell ein Zeichensatz-Segmentierungsnetzwerk, um das Layout aus Vorlagenbildern zu extrahieren.

- Beginnt ebenfalls mit der zweiten Stufe. Der Benutzer gibt das Bild an und gibt den Bereich und den Textinhalt an, der geändert werden muss. Und dieser Vorgang kann mehrmals durchgeführt werden, bis der Benutzer mit den generierten Ergebnissen zufrieden ist.

Konstruierte MARIO-Daten

Um TextDiffuser zu trainieren, sammelten die Forscher zehn Millionen Textbilder, wie in der Abbildung oben gezeigt, darunter drei Teilmengen: MARIO-LAION, MARIO-TMDB und MARIO - OpenLibrary

Die Forscher haben beim Filtern der Daten mehrere Aspekte berücksichtigt: Beispielsweise werden nach der OCR des Bildes nur Bilder mit einer Textmenge von [1,8] beibehalten. Sie haben Texte mit mehr als 8 Texten herausgefiltert, da diese Texte häufig eine große Menge an dichtem Text enthalten und die OCR-Ergebnisse im Allgemeinen weniger genau sind, beispielsweise bei Zeitungen oder komplexen Konstruktionszeichnungen. Darüber hinaus legen sie den Textbereich auf mehr als 10 % fest. Diese Regel soll verhindern, dass der Textbereich im Bild zu klein wird.

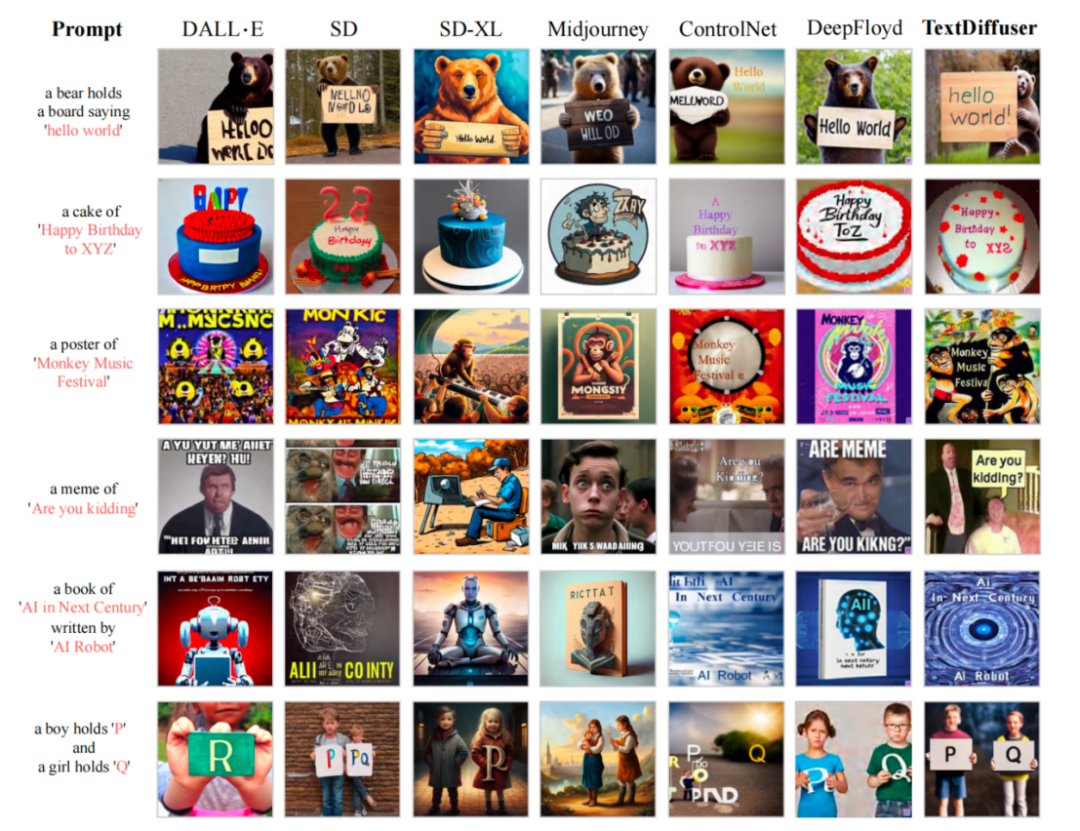

Nach dem Training mit dem MARIO-10M-Datensatz führten die Forscher quantitative und qualitative Vergleiche von TextDiffuser mit bestehenden Methoden durch. Bei der Gesamtbildgenerierungsaufgabe haben die von unserer Methode generierten Bilder beispielsweise einen klareren und lesbareren Text, und der Textbereich ist besser in den Hintergrundbereich integriert, wie in der folgenden Abbildung dargestellt bestehende Arbeit Rendering-Leistung

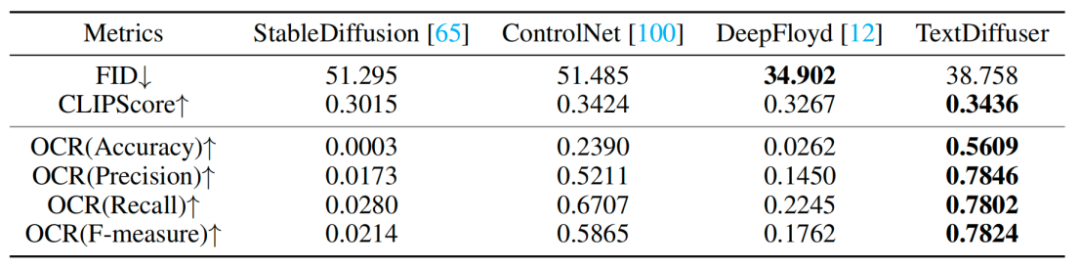

Die Forscher führten auch eine Reihe qualitativer Experimente durch, und die Ergebnisse sind in Tabelle 1 dargestellt. Zu den Bewertungsindikatoren gehören FID, CLIPScore und OCR. Insbesondere für den OCR-Index hat sich diese Forschungsmethode im Vergleich zur Vergleichsmethode deutlich verbessert. Der Forscher versucht, einem bestimmten Bild Zeichen hinzuzufügen oder zu ändern, und experimentelle Ergebnisse zeigen, dass TextDiffuser sehr natürliche Ergebnisse generiert.

Die Forscher führten auch eine Reihe qualitativer Experimente durch, und die Ergebnisse sind in Tabelle 1 dargestellt. Zu den Bewertungsindikatoren gehören FID, CLIPScore und OCR. Insbesondere für den OCR-Index hat sich diese Forschungsmethode im Vergleich zur Vergleichsmethode deutlich verbessert. Der Forscher versucht, einem bestimmten Bild Zeichen hinzuzufügen oder zu ändern, und experimentelle Ergebnisse zeigen, dass TextDiffuser sehr natürliche Ergebnisse generiert.

Visualisierung der Textreparaturfunktion

Insgesamt hat das in diesem Artikel vorgeschlagene TextDiffuser-Modell erhebliche Fortschritte im Bereich der Textwiedergabe gemacht und ist in der Lage, qualitativ hochwertige Bilder mit lesbarem Text zu generieren. Zukünftig werden Forscher die Wirkung von TextDiffuser weiter verbessern.

Das obige ist der detaillierte Inhalt vonNeuer Titel: TextDiffuser: Keine Angst vor Text in Bildern, sorgt für eine qualitativ hochwertigere Textwiedergabe. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

Warum ist es notwendig, Zeiger zu verabschieden, wenn sie GO- und Viper -Bibliotheken verwenden?

Apr 02, 2025 pm 04:00 PM

Warum ist es notwendig, Zeiger zu verabschieden, wenn sie GO- und Viper -Bibliotheken verwenden?

Apr 02, 2025 pm 04:00 PM

Go Zeigersyntax und Probleme bei der Verwendung der Viper -Bibliothek bei der Programmierung in Go -Sprache. Es ist entscheidend, die Syntax und Verwendung von Zeigern zu verstehen, insbesondere in ...

GO Language Slice: Warum meldet es keinen Fehler, wenn ein Einzelelement-Slice-Index 1 Intercept?

Apr 02, 2025 pm 02:24 PM

GO Language Slice: Warum meldet es keinen Fehler, wenn ein Einzelelement-Slice-Index 1 Intercept?

Apr 02, 2025 pm 02:24 PM

Go Language Slice Index: Warum fasst ein Einzelelement-Slice aus Index 1 ohne Fehler ab? In der GO -Sprache sind Scheiben eine flexible Datenstruktur, die sich auf den Boden beziehen kann ...

Warum werden alle Werte das letzte Element, wenn sie für den Bereich in der GO -Sprache verwendet werden, um Scheiben zu durchqueren und Karten zu speichern?

Apr 02, 2025 pm 04:09 PM

Warum werden alle Werte das letzte Element, wenn sie für den Bereich in der GO -Sprache verwendet werden, um Scheiben zu durchqueren und Karten zu speichern?

Apr 02, 2025 pm 04:09 PM

Warum bewirkt die Kartendiseration in Go alle Werte zum letzten Element? In Go -Sprache begegnen Sie, wenn Sie einige Interviewfragen konfrontiert sind, häufig Karten ...

GO Language Slice Index: Warum geht das Interception von Single-Element Slice nicht über die Grenzen hinaus?

Apr 02, 2025 pm 02:36 PM

GO Language Slice Index: Warum geht das Interception von Single-Element Slice nicht über die Grenzen hinaus?

Apr 02, 2025 pm 02:36 PM

Untersuchung des Problems des grenzüberschreitenden GO-Slicing-Index: Ein-Element-Schnittscheiben in GO sind eine flexible Datenstruktur, die für Arrays oder andere ...

Wie kann ich benutzerdefinierte Pakete unter Go -Modulen korrekt importieren?

Apr 02, 2025 pm 03:42 PM

Wie kann ich benutzerdefinierte Pakete unter Go -Modulen korrekt importieren?

Apr 02, 2025 pm 03:42 PM

In der GO -Sprachentwicklung ist die ordnungsgemäße Einführung kundenspezifischer Pakete ein entscheidender Schritt. Dieser Artikel richtet sich an "Golang ...

Wie nenne ich in einer Geschwisterdatei innerhalb desselben Pakets eine Funktion?

Apr 02, 2025 pm 12:33 PM

Wie nenne ich in einer Geschwisterdatei innerhalb desselben Pakets eine Funktion?

Apr 02, 2025 pm 12:33 PM

Wie rufe ich Funktionen in Geschwisterdateien im selben Paket auf? Bei der Go -Programmierung ist die Organisation der Projektstruktur und des Imports von Paketen sehr wichtig. Wir...

Wie unterscheidet ich zwischen dem Debug -Modus und dem normalen Betriebsmodus, wenn das GO -Programm ausgeführt wird?

Apr 02, 2025 pm 01:45 PM

Wie unterscheidet ich zwischen dem Debug -Modus und dem normalen Betriebsmodus, wenn das GO -Programm ausgeführt wird?

Apr 02, 2025 pm 01:45 PM

Wenn das GO -Sprachprogramm ausgeführt wird, wie kann man zwischen dem Debug -Modus und dem normalen Betriebsmodus unterscheiden? Viele Entwickler möchten GO -Programme nach verschiedenen Betriebsmodi entwickeln ...

Bytes.Buffer in Go -Sprache verursacht Speicherleck: Wie schließt der Client den Antwortkörper korrekt, um die Speicherverwendung zu vermeiden?

Apr 02, 2025 pm 02:27 PM

Bytes.Buffer in Go -Sprache verursacht Speicherleck: Wie schließt der Client den Antwortkörper korrekt, um die Speicherverwendung zu vermeiden?

Apr 02, 2025 pm 02:27 PM

Analyse von Speicherlecks, die durch Bytes verursacht werden.