Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Je mehr Wörter das Dokument enthält, desto aufgeregter wird das Model sein! KOSMOS-2.5: Multimodales großes Sprachmodell zum Lesen von „textdichten Bildern'

Je mehr Wörter das Dokument enthält, desto aufgeregter wird das Model sein! KOSMOS-2.5: Multimodales großes Sprachmodell zum Lesen von „textdichten Bildern'

Je mehr Wörter das Dokument enthält, desto aufgeregter wird das Model sein! KOSMOS-2.5: Multimodales großes Sprachmodell zum Lesen von „textdichten Bildern'

Ein klarer Trend geht derzeit in Richtung der Erstellung größerer und komplexerer Modelle mit Dutzenden/Hunderten Milliarden von Parametern, die eine beeindruckende Sprachausgabe erzeugen können.

Bestehende große Sprachmodelle konzentrieren sich jedoch hauptsächlich auf Textinformationen und sind nicht in der Lage, visuelle Informationen zu verstehen.

Fortschritte auf dem Gebiet der multimodalen großen Sprachmodelle (MLLMs) zielen darauf ab, diese Einschränkung zu beseitigen. MLLMs verschmelzen visuelle und textliche Informationen in einem einzigen transformatorbasierten Modell, sodass sich das Modell an beide Lernmodalitäten anpassen und Inhalte generieren kann.

MLLMs zeigen Potenzial in verschiedenen praktischen Anwendungen, einschließlich des natürlichen Bildverständnisses und des Textbildverständnisses. Diese Modelle nutzen die Sprachmodellierung als gemeinsame Schnittstelle zur Behandlung multimodaler Probleme und ermöglichen es ihnen, Antworten basierend auf Text- und visuellen Eingaben zu verarbeiten und zu generieren

Derzeit liegt der Schwerpunkt jedoch auf MLLMs mit natürlichen Bildern mit niedrigerer Auflösung dicht für Text. Es gibt relativ wenig Forschung zu Bildern. Daher ist die umfassende Nutzung groß angelegter multimodaler Vorschulungen zur Verarbeitung von Textbildern zu einer wichtigen Richtung der MLLM-Forschung geworden kann neue Wege mit hochauflösenden neuen Möglichkeiten für multimodale Anwendungen von textdichten Bildern eröffnen.

Bilder

Papieradresse: https://arxiv.org/abs/2309.11419

Papieradresse: https://arxiv.org/abs/2309.11419

KOSMOS-2.5 ist ein multimodales, groß angelegtes Sprachmodell, das auf Bildern mit hoher Textdichte basiert entwickelt in KOSMOS- Auf Basis von 2 entwickelt, hebt es die multimodalen Lese- und Verständnisfähigkeiten textintensiver Bilder hervor (Multimodal Literate Model).

Der Vorschlag dieses Modells unterstreicht seine hervorragende Leistung beim Verstehen textintensiver Bilder und schließt die Lücke zwischen Vision und Text.

Gleichzeitig markiert es auch die Entwicklung des Aufgabenparadigmas gegenüber der vorherigen Codierung Decoder-Decoder-Architektur zur reinen Decoder-Architektur

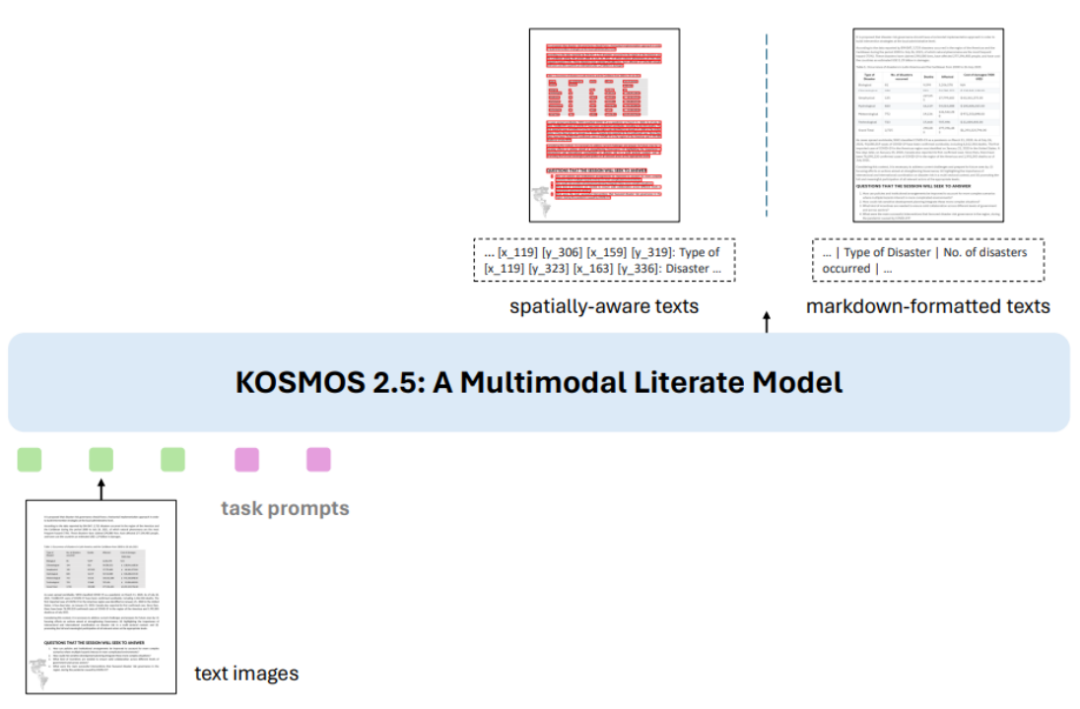

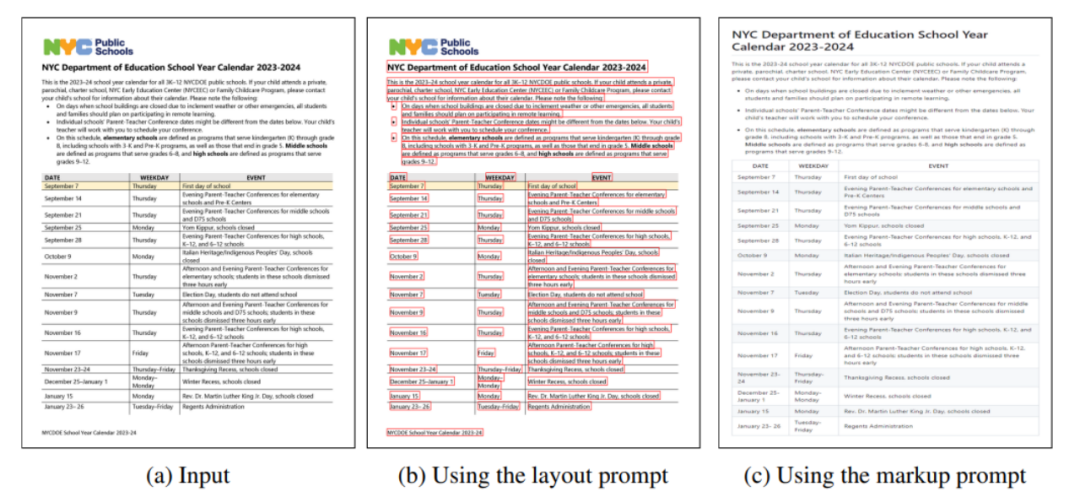

Das Ziel von KOSMOS-2.5 ist es, eine nahtlose visuelle und textuelle Datenverarbeitung in textreichen Bildern zu ermöglichen, um Bildinhalte zu verstehen und strukturierte Textbeschreibungen zu generieren. Abbildung 1: Übersicht über KOSMOS-2.5 Die erste Aufgabe besteht darin, einen raumbezogenen Textblock zu generieren, also gleichzeitig den Inhalt und den Koordinatenrahmen des Textblocks zu generieren. Was neu geschrieben werden muss, ist: Die erste Aufgabe besteht darin, einen räumlich bewussten Textblock zu generieren, d. h. den Inhalt des Textblocks und des Koordinatenfelds gleichzeitig zu generieren. Die zweite Aufgabe besteht darin, eine strukturierte Textausgabe im Markdown-Format zu generieren. und Erfassen verschiedener Stile und Strukturen

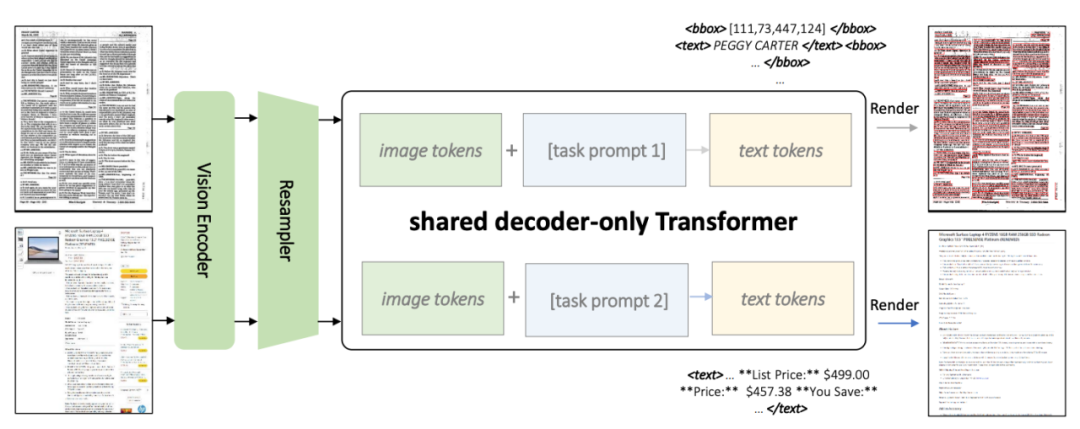

Abbildung 2: KOSMOS-2.5-Architekturdiagramm

Wie in Abbildung 2 gezeigt, verwenden beide Aufgaben eine gemeinsame Transformer-Architektur und aufgabenspezifische Hinweise

Wie in Abbildung 2 gezeigt, verwenden beide Aufgaben eine gemeinsame Transformer-Architektur und aufgabenspezifische Hinweise

KOSMOS-2.5 kombiniert einen visuellen Encoder auf Basis von ViT (Vision Transformer) mit einem Decoder auf Basis der Transformer-Architektur, verbunden über ein Resampling-Modul. Abbildung 3: Datensatz vor dem Training

Abbildung 4: Beispiel eines Trainingsbeispiels für Textzeilen mit BegrenzungsrahmenAbbildung 5: Beispiel eines Trainingsbeispiels im Markdown-Format

Dieser Datensatz enthält verschiedene Arten von Bildern mit hoher Textdichte, einschließlich Textzeilen mit Begrenzungsrahmen und einfachem Text im Markdown-Format. Die Abbildungen 4 und 5 sind Beispielvisualisierungen für das Training.

Dieser Datensatz enthält verschiedene Arten von Bildern mit hoher Textdichte, einschließlich Textzeilen mit Begrenzungsrahmen und einfachem Text im Markdown-Format. Die Abbildungen 4 und 5 sind Beispielvisualisierungen für das Training.

Diese Multitasking-Trainingsmethode verbessert die gesamten multimodalen Fähigkeiten von KOSMOS-2.5

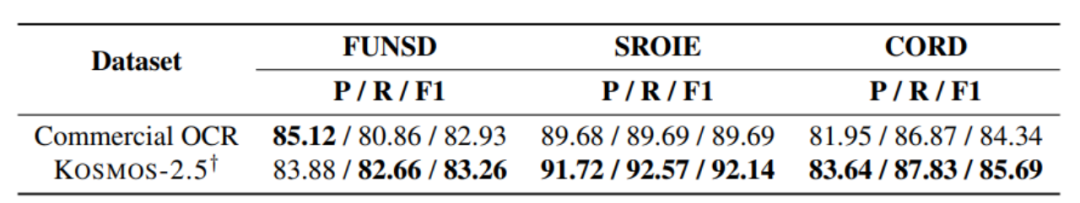

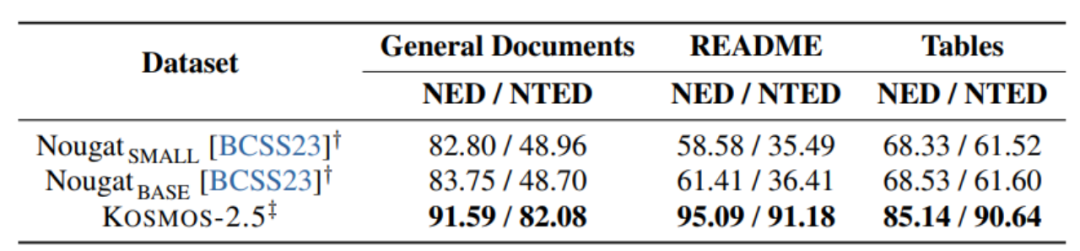

[Abbildung 6] End-to-End-Experiment zur Texterkennung auf Dokumentebene

[Abbildung 6] End-to-End-Experiment zur Texterkennung auf Dokumentebene

Abbildung 7: Experiment zur Generierung von Text im Markdown-Format aus Bildern

Abbildung 7: Experiment zur Generierung von Text im Markdown-Format aus Bildern

Wie in Abbildung 6 und Abbildung 7 gezeigt, KOSMOS- 2.5 Es wird anhand von zwei Aufgaben bewertet: End-to-End-Texterkennung auf Dokumentebene und Generierung von Markdown-formatiertem Text aus Bildern.

KOSMOS-2.5 schneidet bei der Verarbeitung textintensiver Bildaufgaben gut ab, und die experimentellen Ergebnisse zeigen dies

Abbildung 8: Eingabe- und Ausgabebeispielanzeige von KOSMOS-2.5

Abbildung 8: Eingabe- und Ausgabebeispielanzeige von KOSMOS-2.5

KOSMOS- 2.5 demonstriert Vielversprechende Fähigkeiten sowohl in Wenig-Schuss-Lernszenarien als auch in Null-Schuss-Lernszenarien, was es zu einem vielseitigen Werkzeug für praktische Anwendungen bei der Verarbeitung textreicher Bilder macht. Es kann als vielseitiges Werkzeug angesehen werden, das textreiche Bilder effektiv verarbeiten kann und vielversprechende Fähigkeiten im Falle von Wenig-Schuss-Lernen und Null-Schuss-Lernen zeigt. Der Autor weist darauf hin, dass die Feinabstimmung von Anweisungen sehr vielversprechend ist Das Tool „Prospect“ kann eine breitere Anwendungsfähigkeit des Modells erreichen.

Im breiteren Forschungsfeld liegt eine wichtige Richtung in der Weiterentwicklung der Fähigkeit zur Erweiterung von Modellparametern.

Da Aufgaben immer umfangreicher und komplexer werden, ist die Skalierung von Modellen zur Verarbeitung größerer Datenmengen von entscheidender Bedeutung für die Entwicklung textintensiver multimodaler Modelle.

Das ultimative Ziel besteht darin, ein Modell zu entwickeln, das visuelle und textliche Daten effektiv interpretieren und erfolgreich auf textintensivere multimodale Aufgaben verallgemeinern kann.

Beim Umschreiben des Inhalts muss er ins Chinesische umgeschrieben werden und der Originalsatz muss nicht erscheinen

https://arxiv.org/abs/2309.11419

Das obige ist der detaillierte Inhalt vonJe mehr Wörter das Dokument enthält, desto aufgeregter wird das Model sein! KOSMOS-2.5: Multimodales großes Sprachmodell zum Lesen von „textdichten Bildern'. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Stellen Sie sich ein Modell der künstlichen Intelligenz vor, das nicht nur die Fähigkeit besitzt, die traditionelle Datenverarbeitung zu übertreffen, sondern auch eine effizientere Leistung zu geringeren Kosten erzielt. Dies ist keine Science-Fiction, DeepSeek-V2[1], das weltweit leistungsstärkste Open-Source-MoE-Modell, ist da. DeepSeek-V2 ist ein leistungsstarkes MoE-Sprachmodell (Mix of Experts) mit den Merkmalen eines wirtschaftlichen Trainings und einer effizienten Inferenz. Es besteht aus 236B Parametern, von denen 21B zur Aktivierung jedes Markers verwendet werden. Im Vergleich zu DeepSeek67B bietet DeepSeek-V2 eine stärkere Leistung, spart gleichzeitig 42,5 % der Trainingskosten, reduziert den KV-Cache um 93,3 % und erhöht den maximalen Generierungsdurchsatz auf das 5,76-fache. DeepSeek ist ein Unternehmen, das sich mit allgemeiner künstlicher Intelligenz beschäftigt

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

Anfang dieses Monats schlugen Forscher des MIT und anderer Institutionen eine vielversprechende Alternative zu MLP vor – KAN. KAN übertrifft MLP in Bezug auf Genauigkeit und Interpretierbarkeit. Und es kann MLP, das mit einer größeren Anzahl von Parametern ausgeführt wird, mit einer sehr kleinen Anzahl von Parametern übertreffen. Beispielsweise gaben die Autoren an, dass sie KAN nutzten, um die Ergebnisse von DeepMind mit einem kleineren Netzwerk und einem höheren Automatisierungsgrad zu reproduzieren. Konkret verfügt DeepMinds MLP über etwa 300.000 Parameter, während KAN nur etwa 200 Parameter hat. KAN hat eine starke mathematische Grundlage wie MLP und basiert auf dem universellen Approximationssatz, während KAN auf dem Kolmogorov-Arnold-Darstellungssatz basiert. Wie in der folgenden Abbildung gezeigt, hat KAN

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas tritt offiziell in die Ära der Elektroroboter ein! Gestern hat sich der hydraulische Atlas einfach „unter Tränen“ von der Bühne der Geschichte zurückgezogen. Heute gab Boston Dynamics bekannt, dass der elektrische Atlas im Einsatz ist. Es scheint, dass Boston Dynamics im Bereich kommerzieller humanoider Roboter entschlossen ist, mit Tesla zu konkurrieren. Nach der Veröffentlichung des neuen Videos wurde es innerhalb von nur zehn Stunden bereits von mehr als einer Million Menschen angesehen. Die alten Leute gehen und neue Rollen entstehen. Das ist eine historische Notwendigkeit. Es besteht kein Zweifel, dass dieses Jahr das explosive Jahr der humanoiden Roboter ist. Netizens kommentierten: Die Weiterentwicklung der Roboter hat dazu geführt, dass die diesjährige Eröffnungsfeier wie Menschen aussieht, und der Freiheitsgrad ist weitaus größer als der von Menschen. Aber ist das wirklich kein Horrorfilm? Zu Beginn des Videos liegt Atlas ruhig auf dem Boden, scheinbar auf dem Rücken. Was folgt, ist atemberaubend

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI verändert tatsächlich die Mathematik. Vor kurzem hat Tao Zhexuan, der diesem Thema große Aufmerksamkeit gewidmet hat, die neueste Ausgabe des „Bulletin of the American Mathematical Society“ (Bulletin der American Mathematical Society) weitergeleitet. Zum Thema „Werden Maschinen die Mathematik verändern?“ äußerten viele Mathematiker ihre Meinung. Der gesamte Prozess war voller Funken, knallhart und aufregend. Der Autor verfügt über eine starke Besetzung, darunter der Fields-Medaillengewinner Akshay Venkatesh, der chinesische Mathematiker Zheng Lejun, der NYU-Informatiker Ernest Davis und viele andere bekannte Wissenschaftler der Branche. Die Welt der KI hat sich dramatisch verändert. Viele dieser Artikel wurden vor einem Jahr eingereicht.

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Das neueste Video von Teslas Roboter Optimus ist veröffentlicht und er kann bereits in der Fabrik arbeiten. Bei normaler Geschwindigkeit sortiert es Batterien (Teslas 4680-Batterien) so: Der Beamte hat auch veröffentlicht, wie es bei 20-facher Geschwindigkeit aussieht – auf einer kleinen „Workstation“, pflücken und pflücken und pflücken: Dieses Mal wird es freigegeben. Eines der Highlights Der Vorteil des Videos besteht darin, dass Optimus diese Arbeit in der Fabrik völlig autonom und ohne menschliches Eingreifen während des gesamten Prozesses erledigt. Und aus Sicht von Optimus kann es auch die krumme Batterie aufnehmen und platzieren, wobei der Schwerpunkt auf der automatischen Fehlerkorrektur liegt: In Bezug auf die Hand von Optimus gab der NVIDIA-Wissenschaftler Jim Fan eine hohe Bewertung ab: Die Hand von Optimus ist der fünffingrige Roboter der Welt am geschicktesten. Seine Hände sind nicht nur taktil

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

Die Zielerkennung ist ein relativ ausgereiftes Problem in autonomen Fahrsystemen, wobei die Fußgängererkennung einer der ersten Algorithmen ist, die eingesetzt werden. In den meisten Arbeiten wurde eine sehr umfassende Recherche durchgeführt. Die Entfernungswahrnehmung mithilfe von Fischaugenkameras für die Rundumsicht ist jedoch relativ wenig untersucht. Aufgrund der großen radialen Verzerrung ist es schwierig, die standardmäßige Bounding-Box-Darstellung in Fischaugenkameras zu implementieren. Um die obige Beschreibung zu vereinfachen, untersuchen wir erweiterte Begrenzungsrahmen-, Ellipsen- und allgemeine Polygondesigns in Polar-/Winkeldarstellungen und definieren eine mIOU-Metrik für die Instanzsegmentierung, um diese Darstellungen zu analysieren. Das vorgeschlagene Modell „fisheyeDetNet“ mit polygonaler Form übertrifft andere Modelle und erreicht gleichzeitig 49,5 % mAP auf dem Valeo-Fisheye-Kameradatensatz für autonomes Fahren

Mit einer einzelnen Karte läuft Llama 70B schneller als mit zwei Karten, Microsoft hat gerade FP6 in A100 integriert |

Apr 29, 2024 pm 04:55 PM

Mit einer einzelnen Karte läuft Llama 70B schneller als mit zwei Karten, Microsoft hat gerade FP6 in A100 integriert |

Apr 29, 2024 pm 04:55 PM

FP8 und die geringere Gleitkomma-Quantifizierungsgenauigkeit sind nicht länger das „Patent“ von H100! Lao Huang wollte, dass jeder INT8/INT4 nutzt, und das Microsoft DeepSpeed-Team begann, FP6 auf A100 ohne offizielle Unterstützung von NVIDIA auszuführen. Testergebnisse zeigen, dass die FP6-Quantisierung der neuen Methode TC-FPx auf A100 nahe an INT4 liegt oder gelegentlich schneller als diese ist und eine höhere Genauigkeit aufweist als letztere. Darüber hinaus gibt es eine durchgängige Unterstützung großer Modelle, die als Open-Source-Lösung bereitgestellt und in Deep-Learning-Inferenz-Frameworks wie DeepSpeed integriert wurde. Dieses Ergebnis wirkt sich auch unmittelbar auf die Beschleunigung großer Modelle aus – in diesem Rahmen ist der Durchsatz bei Verwendung einer einzelnen Karte zum Ausführen von Llama 2,65-mal höher als der von Doppelkarten. eins

Yolov10: Ausführliche Erklärung, Bereitstellung und Anwendung an einem Ort!

Jun 07, 2024 pm 12:05 PM

Yolov10: Ausführliche Erklärung, Bereitstellung und Anwendung an einem Ort!

Jun 07, 2024 pm 12:05 PM

1. Einleitung In den letzten Jahren haben sich YOLOs aufgrund ihres effektiven Gleichgewichts zwischen Rechenkosten und Erkennungsleistung zum vorherrschenden Paradigma im Bereich der Echtzeit-Objekterkennung entwickelt. Forscher haben das Architekturdesign, die Optimierungsziele, Datenerweiterungsstrategien usw. von YOLO untersucht und erhebliche Fortschritte erzielt. Gleichzeitig behindert die Verwendung von Non-Maximum Suppression (NMS) bei der Nachbearbeitung die End-to-End-Bereitstellung von YOLO und wirkt sich negativ auf die Inferenzlatenz aus. In YOLOs fehlt dem Design verschiedener Komponenten eine umfassende und gründliche Prüfung, was zu erheblicher Rechenredundanz führt und die Fähigkeiten des Modells einschränkt. Es bietet eine suboptimale Effizienz und ein relativ großes Potenzial zur Leistungsverbesserung. Ziel dieser Arbeit ist es, die Leistungseffizienzgrenze von YOLO sowohl in der Nachbearbeitung als auch in der Modellarchitektur weiter zu verbessern. zu diesem Zweck