Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Zuckerbergs einstündiges „Live-Gespräch' im Metaverse überraschte die Welt

Zuckerbergs einstündiges „Live-Gespräch' im Metaverse überraschte die Welt

Zuckerbergs einstündiges „Live-Gespräch' im Metaverse überraschte die Welt

„Eine Zeit lang vergaß ich, dass die Person vor mir keine echte Person war.“

„Dies ist ein Gespräch zwischen Zuckerberg und mir im Metaversum. Mark und ich sind physisch Hunderte Meilen voneinander entfernt „Aber ich habe das Gefühl, dass wir ihm gegenüber von Angesicht zu Angesicht am selben Ort sind. Da unsere Bilder mit fotorealistischen 3D-Modellen modelliert sind, ist diese Technologie meiner Meinung nach erstaunlich, wie Menschen in Zukunft im Internet kommunizieren werden.“ Fridmann.

Gestern wurde ein Gespräch über Funk zwischen MIT-Wissenschaftler Lex Fridman und Meta-CEO Mark Zuckerberg zum größten Hit in den sozialen Netzwerken. Das Video ihres einstündigen Interviews im Metaversum erreichte schnell zig Millionen Aufrufe.

Im Metaversum können unsere Bilder jetzt fast genau denen echter Menschen entsprechen. Von den Details des gesamten Körpers bis hin zu den Ausdrücken und Bewegungen sind sie alle so natürlich und erstaunlich.

So dass wir es in der realen Welt brauchen Achten Sie darauf, unsere Ausdrücke zu verwalten:

Im Gegensatz zu Metas ursprünglichem Avatar wurde die vorherige Technologie als beinlos, stumpfäugig und unbequem belächelt, das Bild der neuen Generation wirkt äußerst real und die Verzögerung ist vernachlässigbar. So haben Sie das Gefühl, mit anderen in der virtuellen Welt zusammen zu sein.

- CEL-Verteidigung gealtert ▲ △ △ △ △ △ △ △ △ zu sein, um im Codec-Bild erstellt zu werden?  Zuckerbergs Interview war im Metaverse und der Inhalt des Gesprächs war auch im Metaverse. Während des einstündigen Gesprächs sprach Zuckerberg über das Metaversum, Augmented Reality, große Modelle und andere Themen.

Zuckerbergs Interview war im Metaverse und der Inhalt des Gesprächs war auch im Metaverse. Während des einstündigen Gesprächs sprach Zuckerberg über das Metaversum, Augmented Reality, große Modelle und andere Themen.

So beeindruckend die Avatare auch sind, aber es kann einige Zeit dauern, bis sie es tun sind weit verbreitet. Kann umgeschrieben werden als: Obwohl Avatare beeindruckend sind, kann es einige Zeit dauern, bis sie allgemein angenommen werden

Zuckerberg erwähnte im Interview, dass das Ziel von Meta darin besteht, Menschen das schnelle Scannen über ihr Smartphone zu ermöglichen.

Zuckerberg sagte zu Lex Fridman, dass man sein Telefon, solange man es in die Hand nimmt, ein paar Minuten lang vor sich hin schüttelt und sagt ein paar Worte Kurz gesagt, machen Sie eine Reihe von Ausdrücken, und KI kann die hochwertigen Dinge produzieren, die wir jetzt haben

Zuckerberg sagte, dass Meta plant, diese Technologie in den nächsten Jahren in Produkte zu integrieren

Der aktuelle Projektionseffekt ist Dasselbe wie im Vergleich zu den Cartoon-Avataren, die von Metas kostenlosen VR-Spielen und der sozialen Plattform Horizon Worlds verwendet werden, hat das Selbstporträt des Yuan-Universums von Zuckerberg erheblich verbessert.

Das Erstaunliche ist, dass sich die Technologie in nur einem Jahr so schnell weiterentwickelt hatWie der KI-Wissenschaftler Lex Fridman während des Interviews beklagte: „Ich weiß wirklich nicht wie Um dieses Gefühl zu beschreiben, ist es, als wären wir im selben Raum, wie in der Zukunft.“

Zuckerberg arbeitet weiterhin hart daran, den Eindruck der Menschen von Horizon Worlds zu verändern. Er sagte gegenüber Lex Fridman, dass realistische Avatare dazu beitragen könnten, Menschen anzulocken, die von den Bildern im Metaverse abgeschreckt werden: „Die Leute waren von der Erfahrung überwältigt, aber wir haben einige Rückmeldungen erhalten, in denen die Leute sagten, dass sich der Avatar in dieser Umgebung nicht realistisch anfühlt.“ genug.“Offensichtlich werden die heutigen Metaverse-Fähigkeiten große Veränderungen in der Art und Weise mit sich bringen, wie wir interagieren. Zugegebenermaßen ist dies die beeindruckendste Demonstration von Zuckerbergs Metaverse-Projekt überhaupt.对 „veränderte sich, unsere Wahrnehmung des Yuan-Universums begann sich zu verändern“ – das ist bahnbrechende Technologie. Wenn Meta diesen Effekt bald auf Konsumgüter erzielen kann, kann es zu einer bahnbrechenden Anwendung werden.Schreiben Sie den Inhalt neu, ohne die ursprüngliche Bedeutung zu ändern. Die Sprache muss in Chinesisch geändert werden in Mark Zuckerbergs neuem Metaverse ist jetzt noch menschlicher

https://futurism.com/the-byte/new-metaverse-lifelike-avatar

https://twitter.com/lexfridman /status/1707453830344868204Das obige ist der detaillierte Inhalt vonZuckerbergs einstündiges „Live-Gespräch' im Metaverse überraschte die Welt. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1392

1392

52

52

Der Autor von ControlNet hat einen weiteren Hit! Der gesamte Prozess der Generierung eines Gemäldes aus einem Bild, der in zwei Tagen 1,4.000 Sterne verdient

Jul 17, 2024 am 01:56 AM

Der Autor von ControlNet hat einen weiteren Hit! Der gesamte Prozess der Generierung eines Gemäldes aus einem Bild, der in zwei Tagen 1,4.000 Sterne verdient

Jul 17, 2024 am 01:56 AM

Es ist ebenfalls ein Tusheng-Video, aber PaintsUndo ist einen anderen Weg gegangen. ControlNet-Autor LvminZhang begann wieder zu leben! Dieses Mal ziele ich auf den Bereich der Malerei. Das neue Projekt PaintsUndo hat nicht lange nach seinem Start 1,4.000 Sterne erhalten (die immer noch wahnsinnig steigen). Projektadresse: https://github.com/lllyasviel/Paints-UNDO Bei diesem Projekt gibt der Benutzer ein statisches Bild ein, und PaintsUndo kann Ihnen dabei helfen, automatisch ein Video des gesamten Malprozesses zu erstellen, vom Linienentwurf bis zum fertigen Produkt . Während des Zeichenvorgangs sind die Linienänderungen erstaunlich. Das Endergebnis des Videos ist dem Originalbild sehr ähnlich: Schauen wir uns eine vollständige Zeichnung an.

Die agentenlose Lösung von UIUC steht ganz oben auf der Liste der Open-Source-KI-Softwareentwickler und löst problemlos echte Programmierprobleme im SWE-Bench

Jul 17, 2024 pm 10:02 PM

Die agentenlose Lösung von UIUC steht ganz oben auf der Liste der Open-Source-KI-Softwareentwickler und löst problemlos echte Programmierprobleme im SWE-Bench

Jul 17, 2024 pm 10:02 PM

Die AIxiv-Kolumne ist eine Kolumne, in der diese Website akademische und technische Inhalte veröffentlicht. In den letzten Jahren sind in der AIxiv-Kolumne dieser Website mehr als 2.000 Berichte eingegangen, die Spitzenlabore großer Universitäten und Unternehmen auf der ganzen Welt abdecken und so den akademischen Austausch und die Verbreitung wirksam fördern. Wenn Sie hervorragende Arbeiten haben, die Sie teilen möchten, können Sie gerne einen Beitrag leisten oder uns für die Berichterstattung kontaktieren. Einreichungs-E-Mail: liyazhou@jiqizhixin.com; zhaoyunfeng@jiqizhixin.com Die Autoren dieses Artikels stammen alle aus dem Team von Lehrer Zhang Lingming an der University of Illinois in Urbana-Champaign, darunter: Steven Code Repair; Doktorand im vierten Jahr, Forscher

Das neue erschwingliche Meta Quest 3S VR-Headset erscheint bei FCC, was auf eine baldige Markteinführung hindeutet

Sep 04, 2024 am 06:51 AM

Das neue erschwingliche Meta Quest 3S VR-Headset erscheint bei FCC, was auf eine baldige Markteinführung hindeutet

Sep 04, 2024 am 06:51 AM

Die Meta Connect 2024-Veranstaltung findet vom 25. bis 26. September statt. Bei dieser Veranstaltung wird das Unternehmen voraussichtlich ein neues erschwingliches Virtual-Reality-Headset vorstellen. Gerüchten zufolge handelt es sich bei dem VR-Headset um das Meta Quest 3S, das offenbar auf der FCC-Liste aufgetaucht ist. Dieser Vorschlag

Posthume Arbeit des OpenAI Super Alignment Teams: Zwei große Modelle spielen ein Spiel und die Ausgabe wird verständlicher

Jul 19, 2024 am 01:29 AM

Posthume Arbeit des OpenAI Super Alignment Teams: Zwei große Modelle spielen ein Spiel und die Ausgabe wird verständlicher

Jul 19, 2024 am 01:29 AM

Wenn die Antwort des KI-Modells überhaupt unverständlich ist, würden Sie es wagen, sie zu verwenden? Da maschinelle Lernsysteme in immer wichtigeren Bereichen eingesetzt werden, wird es immer wichtiger zu zeigen, warum wir ihren Ergebnissen vertrauen können und wann wir ihnen nicht vertrauen sollten. Eine Möglichkeit, Vertrauen in die Ausgabe eines komplexen Systems zu gewinnen, besteht darin, vom System zu verlangen, dass es eine Interpretation seiner Ausgabe erstellt, die für einen Menschen oder ein anderes vertrauenswürdiges System lesbar ist, d. h. so vollständig verständlich, dass mögliche Fehler erkannt werden können gefunden. Um beispielsweise Vertrauen in das Justizsystem aufzubauen, verlangen wir von den Gerichten, dass sie klare und lesbare schriftliche Stellungnahmen abgeben, die ihre Entscheidungen erläutern und stützen. Für große Sprachmodelle können wir auch einen ähnlichen Ansatz verfolgen. Stellen Sie bei diesem Ansatz jedoch sicher, dass das Sprachmodell generiert wird

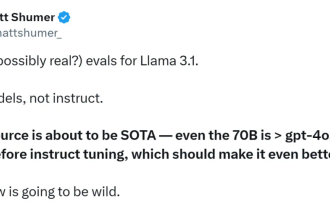

Das erste Open-Source-Modell, das das GPT4o-Niveau übertrifft! Llama 3.1 durchgesickert: 405 Milliarden Parameter, Download-Links und Modellkarten sind verfügbar

Jul 23, 2024 pm 08:51 PM

Das erste Open-Source-Modell, das das GPT4o-Niveau übertrifft! Llama 3.1 durchgesickert: 405 Milliarden Parameter, Download-Links und Modellkarten sind verfügbar

Jul 23, 2024 pm 08:51 PM

Machen Sie Ihre GPU bereit! Llama3.1 ist endlich erschienen, aber die Quelle ist nicht offiziell von Meta. Heute gingen die durchgesickerten Nachrichten über das neue Llama-Großmodell auf Reddit viral. Zusätzlich zum Basismodell enthält es auch Benchmark-Ergebnisse von 8B, 70B und den maximalen Parameter von 405B. Die folgende Abbildung zeigt die Vergleichsergebnisse jeder Version von Llama3.1 mit OpenAIGPT-4o und Llama38B/70B. Es ist ersichtlich, dass selbst die 70B-Version in mehreren Benchmarks GPT-4o übertrifft. Bildquelle: https://x.com/mattshumer_/status/1815444612414087294 Offensichtlich Version 3.1 von 8B und 70

Ein bedeutender Durchbruch in der Riemann-Hypothese! Tao Zhexuan empfiehlt dringend neue Arbeiten vom MIT und Oxford, und der 37-jährige Fields-Medaillengewinner nahm daran teil

Aug 05, 2024 pm 03:32 PM

Ein bedeutender Durchbruch in der Riemann-Hypothese! Tao Zhexuan empfiehlt dringend neue Arbeiten vom MIT und Oxford, und der 37-jährige Fields-Medaillengewinner nahm daran teil

Aug 05, 2024 pm 03:32 PM

Kürzlich gelang der Riemann-Hypothese, die als eines der sieben großen Probleme des Jahrtausends bekannt ist, ein neuer Durchbruch. Die Riemann-Hypothese ist ein sehr wichtiges ungelöstes Problem in der Mathematik, das sich auf die genauen Eigenschaften der Verteilung von Primzahlen bezieht (Primzahlen sind Zahlen, die nur durch 1 und sich selbst teilbar sind, und sie spielen eine grundlegende Rolle in der Zahlentheorie). In der heutigen mathematischen Literatur gibt es mehr als tausend mathematische Thesen, die auf der Aufstellung der Riemann-Hypothese (oder ihrer verallgemeinerten Form) basieren. Mit anderen Worten: Sobald die Riemann-Hypothese und ihre verallgemeinerte Form bewiesen sind, werden diese mehr als tausend Sätze als Theoreme etabliert, die einen tiefgreifenden Einfluss auf das Gebiet der Mathematik haben werden, und wenn sich die Riemann-Hypothese als falsch erweist, dann unter anderem Auch diese Sätze werden teilweise ihre Gültigkeit verlieren. Neuer Durchbruch kommt von MIT-Mathematikprofessor Larry Guth und der Universität Oxford

arXiv-Artikel können als „Barrage' gepostet werden, die Diskussionsplattform von Stanford alphaXiv ist online, LeCun gefällt es

Aug 01, 2024 pm 05:18 PM

arXiv-Artikel können als „Barrage' gepostet werden, die Diskussionsplattform von Stanford alphaXiv ist online, LeCun gefällt es

Aug 01, 2024 pm 05:18 PM

Prost! Wie ist es, wenn es bei einer Papierdiskussion auf Worte ankommt? Kürzlich haben Studenten der Stanford University alphaXiv erstellt, ein offenes Diskussionsforum für arXiv-Artikel, das es ermöglicht, Fragen und Kommentare direkt zu jedem arXiv-Artikel zu posten. Website-Link: https://alphaxiv.org/ Tatsächlich ist es nicht erforderlich, diese Website speziell zu besuchen. Ändern Sie einfach arXiv in einer beliebigen URL in alphaXiv, um den entsprechenden Artikel direkt im alphaXiv-Forum zu öffnen: Sie können die Absätze darin genau lokalisieren das Papier, Satz: Im Diskussionsbereich auf der rechten Seite können Benutzer Fragen stellen, um dem Autor Fragen zu den Ideen und Details des Papiers zu stellen. Sie können beispielsweise auch den Inhalt des Papiers kommentieren, wie zum Beispiel: „Gegeben an.“

Das erste Mamba-basierte MLLM ist da! Modellgewichte, Trainingscode usw. waren alle Open Source

Jul 17, 2024 am 02:46 AM

Das erste Mamba-basierte MLLM ist da! Modellgewichte, Trainingscode usw. waren alle Open Source

Jul 17, 2024 am 02:46 AM

Die AIxiv-Kolumne ist eine Kolumne, in der diese Website akademische und technische Inhalte veröffentlicht. In den letzten Jahren sind in der AIxiv-Kolumne dieser Website mehr als 2.000 Berichte eingegangen, die Spitzenlabore großer Universitäten und Unternehmen auf der ganzen Welt abdecken und so den akademischen Austausch und die Verbreitung wirksam fördern. Wenn Sie hervorragende Arbeiten haben, die Sie teilen möchten, können Sie gerne einen Beitrag leisten oder uns für die Berichterstattung kontaktieren. E-Mail-Adresse: liyazhou@jiqizhixin.com; zhaoyunfeng@jiqizhixin.com. Einleitung In den letzten Jahren hat die Anwendung multimodaler großer Sprachmodelle (MLLM) in verschiedenen Bereichen bemerkenswerte Erfolge erzielt. Als Grundmodell für viele nachgelagerte Aufgaben besteht aktuelles MLLM jedoch aus dem bekannten Transformer-Netzwerk, das

In der „First Metaverse Conversation“ im Lex Fridman Podcast stellte Zuckerberg Metas neuen Codec-Virtual-Reality-Avatar vor, der mithilfe von Scan-Technologie ein 3D-Modell des Gesichts des Benutzers erstellt, das dann maschinell gesteuert wird Lernumsetzung. Während eines Gesprächs erkennt das neue Headset die Mimik des Benutzers und ordnet sie in Echtzeit den Bewegungen des 3D-Avatars zu.

In der „First Metaverse Conversation“ im Lex Fridman Podcast stellte Zuckerberg Metas neuen Codec-Virtual-Reality-Avatar vor, der mithilfe von Scan-Technologie ein 3D-Modell des Gesichts des Benutzers erstellt, das dann maschinell gesteuert wird Lernumsetzung. Während eines Gesprächs erkennt das neue Headset die Mimik des Benutzers und ordnet sie in Echtzeit den Bewegungen des 3D-Avatars zu.