Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

ICCV'23-Papierpreis „Fighting of Gods'! Meta Divide Everything und ControlNet wurden gemeinsam ausgewählt, und es gab einen weiteren Artikel, der die Jury überraschte

ICCV'23-Papierpreis „Fighting of Gods'! Meta Divide Everything und ControlNet wurden gemeinsam ausgewählt, und es gab einen weiteren Artikel, der die Jury überraschte

ICCV'23-Papierpreis „Fighting of Gods'! Meta Divide Everything und ControlNet wurden gemeinsam ausgewählt, und es gab einen weiteren Artikel, der die Jury überraschte

ICCV 2023, die Top-Computer-Vision-Konferenz in Paris, Frankreich, ist gerade zu Ende gegangen!

Der diesjährige Best Paper Award ist einfach ein „Kampf zwischen Göttern“.

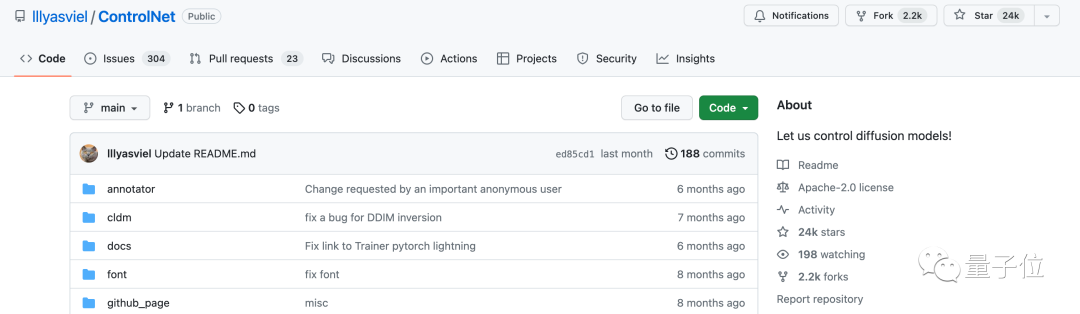

Zu den beiden Arbeiten, die mit dem Best Paper Award ausgezeichnet wurden, gehört beispielsweise die Arbeit, die das Gebiet der vinzentinischen KI untergraben hat – ControlNet.

Seit Open Source hat ControlNet 24.000 Sterne auf GitHub erhalten. Ob für das Diffusionsmodell oder den gesamten Bereich der Computer Vision, die Auszeichnung dieser Arbeit ist wohlverdient

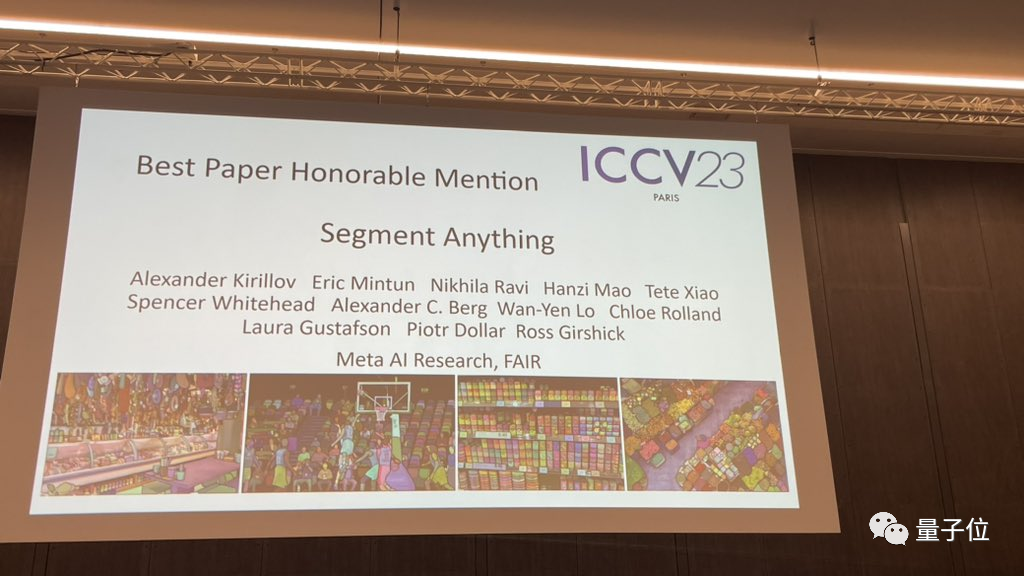

Die lobende Erwähnung für den Best Paper Award ging an eine andere ebenso berühmte Arbeit, Metas „Split Everything“ Modell SAM.

Seit seiner Einführung ist „Segment Everything“ zum „Benchmark“ für verschiedene Bildsegmentierungs-KI-Modelle geworden, darunter viele von hinten aufgekommene FastSAM, LISA und SegGPT, die es alle als Referenzbenchmark für Wirksamkeitstests verwenden.

Die Papiernominierungen sind alle so schwer, wie hart ist die Konkurrenz in diesem ICCV 2023?

ICCV 2023 hat insgesamt 8068 Arbeiten eingereicht, aber nur etwa ein Viertel, also 2160 Arbeiten, wurden angenommen

Fast 10 % der Arbeiten kamen aus China Für ICCV 2023 wurden 49 Arbeiten aus Wissenschaft und Technologie und gemeinsamen Laboratorien von SenseTime ausgewählt, und 14 Arbeiten von Megvii wurden ausgewählt.

Werfen wir einen Blick darauf, welche Arbeiten beim ICCV 2023 ausgezeichnet wurden? Bestes Paper des ICCV Auch bekannt als „Marr-Preis“ (Marr-Preis), „wird alle zwei Jahre ausgewählt“ und gilt als eine der höchsten Auszeichnungen im Bereich Computer Vision.

Diese Auszeichnung ist nach David Marr benannt, einem Pionier auf dem Gebiet der Computer Vision und Begründer der Computational Neuroscience.

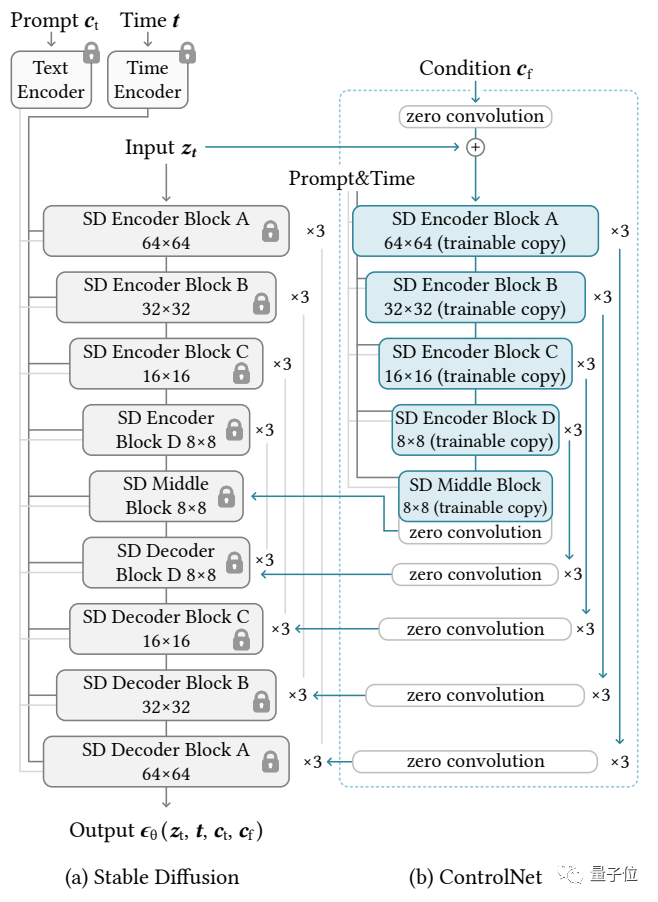

Der erste Gewinner des Best Paper Award ist „Adding Conditional Control for Text-to-Image Diffusion Models“ von Stanford

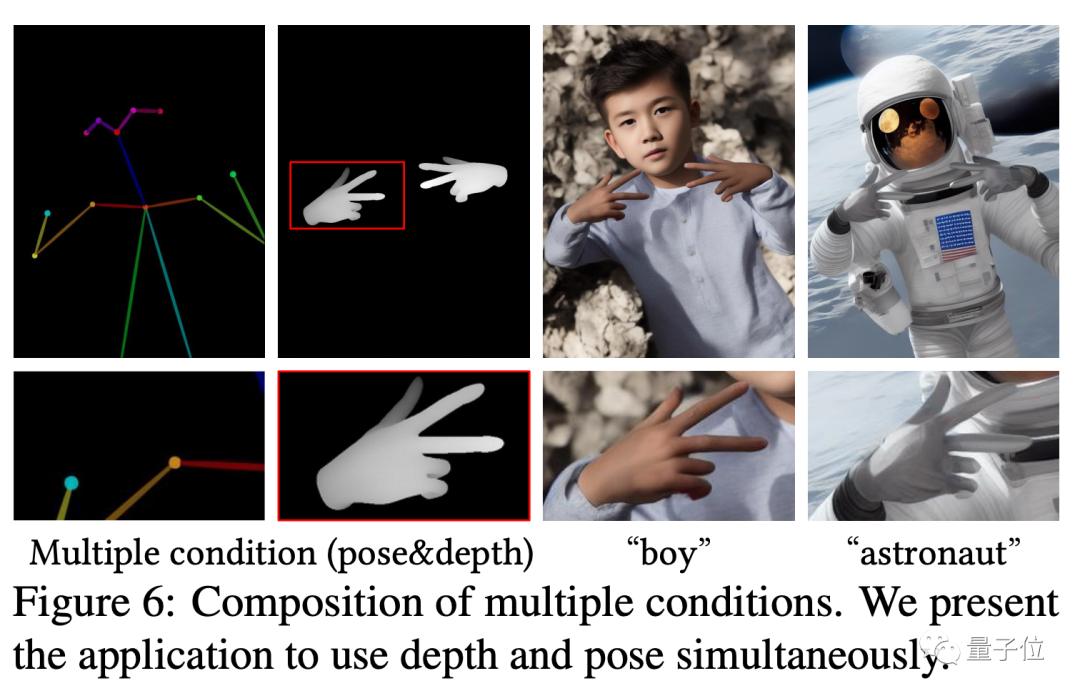

Dieses Papier schlägt ein Modell namens ControlNet vor, das die Details seiner Erzeugung steuern kann, indem es einfach eine zusätzliche Eingabe zum vorab trainierten Diffusionsmodell hinzufügt. Die Eingabe hier kann verschiedener Art sein, einschließlich Skizzen, Kantenbildern, semantischen Segmentierungsbildern, Schlüsselpunktmerkmalen des menschlichen Körpers, geraden Linien zur Hough-Transformationserkennung, Tiefenkarten, menschlichen Knochen usw. Die sogenannte „KI kann Hände zeichnen“. ", der Kern Die Technologie stammt aus diesem Artikel.

Seine Idee und Architektur sind wie folgt: Das Kontrollnetzwerk kopiert zunächst die Gewichte des Diffusionsmodells, um eine „trainierbare Kopie“ zu erhalten.

Das Kontrollnetzwerk kopiert zunächst die Gewichte des Diffusionsmodells, um eine „trainierbare Kopie“ zu erhalten.

Im Gegensatz dazu wurde das ursprüngliche Diffusionsmodell auf Milliarden von vorab trainiert images , daher sind die Parameter „gesperrt“. Und diese „trainierbare Kopie“ muss nur an einem kleinen Datensatz einer bestimmten Aufgabe trainiert werden, um die bedingte Steuerung zu erlernen. Auch wenn die Datenmenge sehr gering ist (nicht mehr als 50.000 Bilder), ist die vom Modell nach dem Training generierte bedingte Kontrolle sehr gut.

Verbunden durch eine 1×1-Faltungsschicht bilden das „gesperrte Modell“ und die „trainierbare Kopie“ eine Struktur namens „0-Faltungsschicht“. Die Gewichte und Vorspannungen dieser 0-Faltungsschicht werden auf 0 initialisiert, sodass während des Trainingsprozesses eine sehr hohe Geschwindigkeit erreicht werden kann, die nahe an der Geschwindigkeit der Feinabstimmung des Diffusionsmodells liegt, und sogar auf persönlichen Geräten trainiert werden kann

Wenn Sie beispielsweise 200.000 Bilddaten verwenden, um eine NVIDIA RTX 3090TI zu trainieren, dauert es nur weniger als eine Woche.

Zhang Lingmin ist der Erstautor des ControlNet-Artikels und derzeit Doktorand an der Stanford University. Neben ControlNet schuf er auch berühmte Werke wie Style2Paints und Fooocus

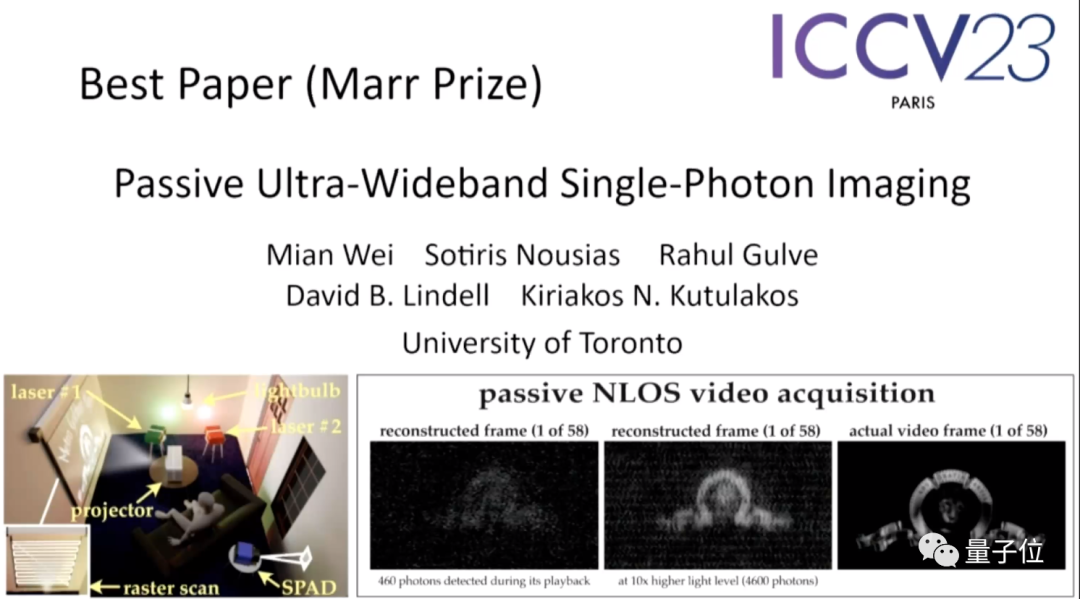

Papieradresse: https://arxiv.org/abs/2302.05543Das zweite Papier „Passive Ultra-Wideband Single-Photon lmaging“ von Universität Toronto.

Diese Arbeit wurde von der Auswahlkommission als „die überraschendste Arbeit zu diesem Thema“ bezeichnet, und zwar so sehr, dass einer der Juroren sagte: „Es war für ihn fast unmöglich, daran zu denken, so etwas auszuprobieren.“

Die Zusammenfassung des Papiers lautet wie folgt:

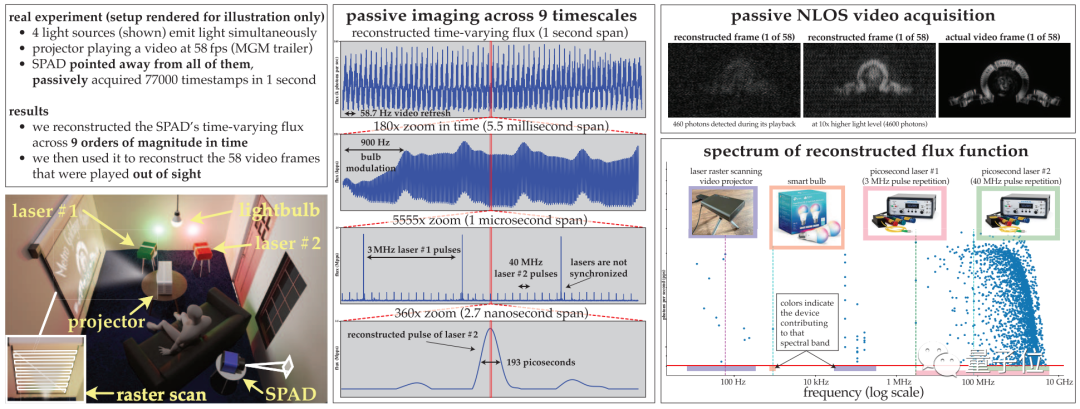

In diesem Papier wird erläutert, wie dynamische Szenen gleichzeitig in extremen Zeitskalen (von Sekunden bis Pikosekunden) abgebildet werden können, während gleichzeitig eine passive Bildgebung erforderlich ist (ohne aktiv große Mengen an Lichtsignalen zu senden) und es wird bei sehr schlechten Lichtverhältnissen durchgeführt und ist nicht auf Zeitsignale der Lichtquelle angewiesen.

Da bestehende Techniken zur Schätzung des optischen Flusses für Einzelphotonenkameras in diesem Bereich versagen, wird in diesem Artikel eine Theorie zur Detektion des optischen Flusses entwickelt, die auf der Idee der stochastischen Berechnung basiert, um von monoton steigenden Photonen-Detektionszeiten auszugehen rekonstruierte Pixel im Poke-Stream.

Basierend auf dieser Theorie führt das Papier vor allem drei Dinge durch:

(1) Zeigt, dass eine passive freilaufende Einzelphotonen-Wellenlängendetektorkamera unter Bedingungen mit geringem optischen Fluss eine erreichbare Frequenzbandbreite von DC bis 31 GHz aufweist Spektrum des Bereichs;

(2) einen neuartigen Fourier-Domänen-Algorithmus zur optischen Flussrekonstruktion zum Scannen von Zeitstempeldaten nach Frequenzen mit statistisch signifikanter Unterstützung ableiten;

(3) sicherstellen, dass das Rauschmodell des Algorithmus auch bei sehr geringen Photonenzahlen oder nicht wirksam ist; vernachlässigbare Totzeiten.

Die Autoren demonstrierten experimentell das Potenzial dieser asynchronen Bildgebungsmethode, einschließlich einiger beispielloser Fähigkeiten:

(1) Bildverarbeitung mit unterschiedlichen Geschwindigkeiten ohne Synchronisation (z. B. Glühbirnen, Projektoren, Multipulslaser) Abbildung der durch Lauflicht beleuchteten Szene Quellen gleichzeitig;

(2) Passive Non-Line-of-Sight-Videosammlung; mit einer Milliardstelsekunde wiedergegeben werden, um zu zeigen, wie sich Licht ausbreitet.

Bitte klicken Sie auf den folgenden Link, um das Papier anzusehen: https://openaccess.thecvf.com/content/ICCV2023/papers/Wei_Passive_Ultra-Wideband_Single-Photon_Imaging_ICCV_2023_paper.pdf

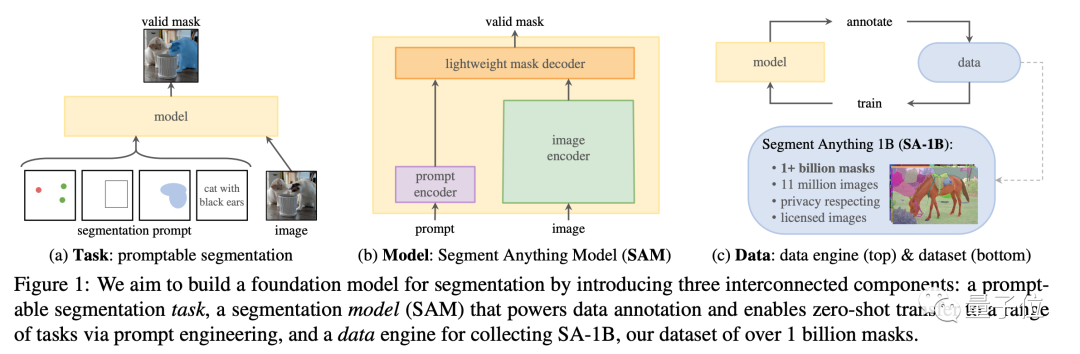

„Dividing Everything“ erhielt eine lobende Erwähnungat Auf dieser Konferenz erhielt Metas „Split Everything“-Modell neben dem mit Spannung erwarteten ControNet auch eine lobende Erwähnung für den Best Paper Award und wurde zu einem mit Spannung erwarteten Thema. Dieses Papier schlug nicht nur eines der größten aktuellen Themen vor Der Segmentierungsdatensatz enthält mehr als 1 Milliarde Masken auf 11 Millionen Bildern, und zu diesem Zweck wurde ein SAM-Modell trainiert, das unsichtbare Bilder schnell segmentieren kann.

Papieradresse: https://arxiv.org/abs/2304.02643

Projekthomepage: https://segment-anything.com/

Projekthomepage: https://segment-anything.com/

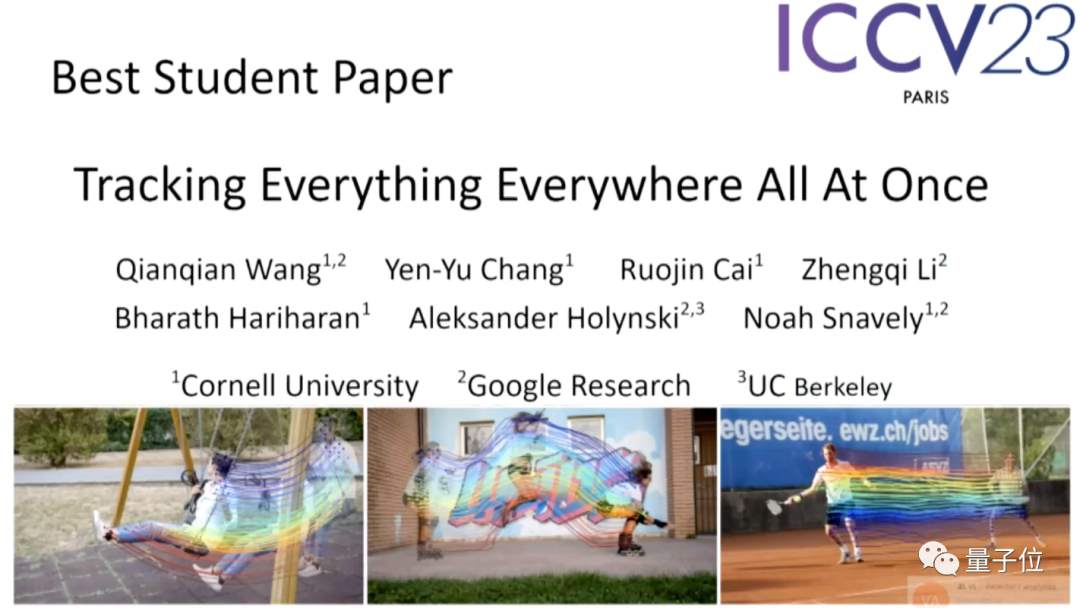

In den studentischen Arbeiten sticht das „Track Everything“-Modell von Google hervor

Genau wie der Titel des Artikels kann dieses Modell gleichzeitig Objekte in Bildern verfolgen an jedem Ort Verfolgung beliebiger (mehrerer) Objekte auf Pixelebene.

Der erste Autor dieses Projekts ist Qianqian Wang, ein chinesischer Doktorand der Cornell University, der derzeit als Postdoktorand an der UCB forscht.

Papieradresse: https://arxiv.org/abs/2306.05422

Projekthomepage: https://omnimotion.github.io/

Projekthomepage: https://omnimotion.github.io/

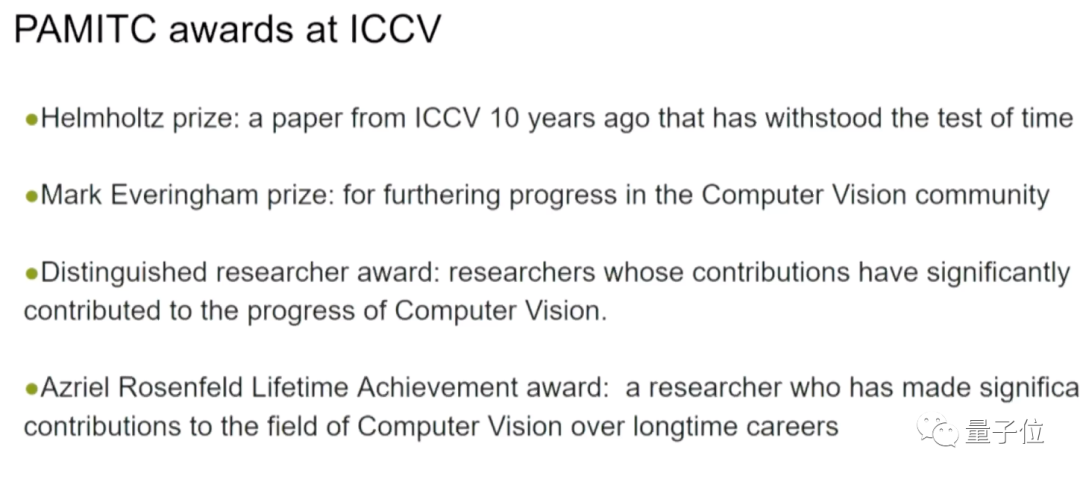

Bei der Eröffnungszeremonie wurden auch besondere Auszeichnungen bekannt gegeben, die von Mitgliedern des PAMITC-Komitees gestiftet wurden, das auch Auszeichnungen für zwei Computer-Vision-Feldkonferenzen, CVPR und WACV, spendete.

Die folgenden vier Auszeichnungen waren enthalten:

- hai Mkhize Award: ICCV-Artikel, der vor zehn Jahren großen Einfluss auf die Computer-Vision-Forschung hatte

- Everingham Award: Fortschritte auf dem Gebiet der Computer-Vision

- Herausragender Forscher: Forscher, die bedeutende Beiträge zur Weiterentwicklung der Computer-Vision geleistet haben

- Rosenfeld Lifetime Achievements Award: Forscher, die im Laufe ihrer langen Karriere bedeutende Beiträge zum Bereich Computer Vision geleistet haben

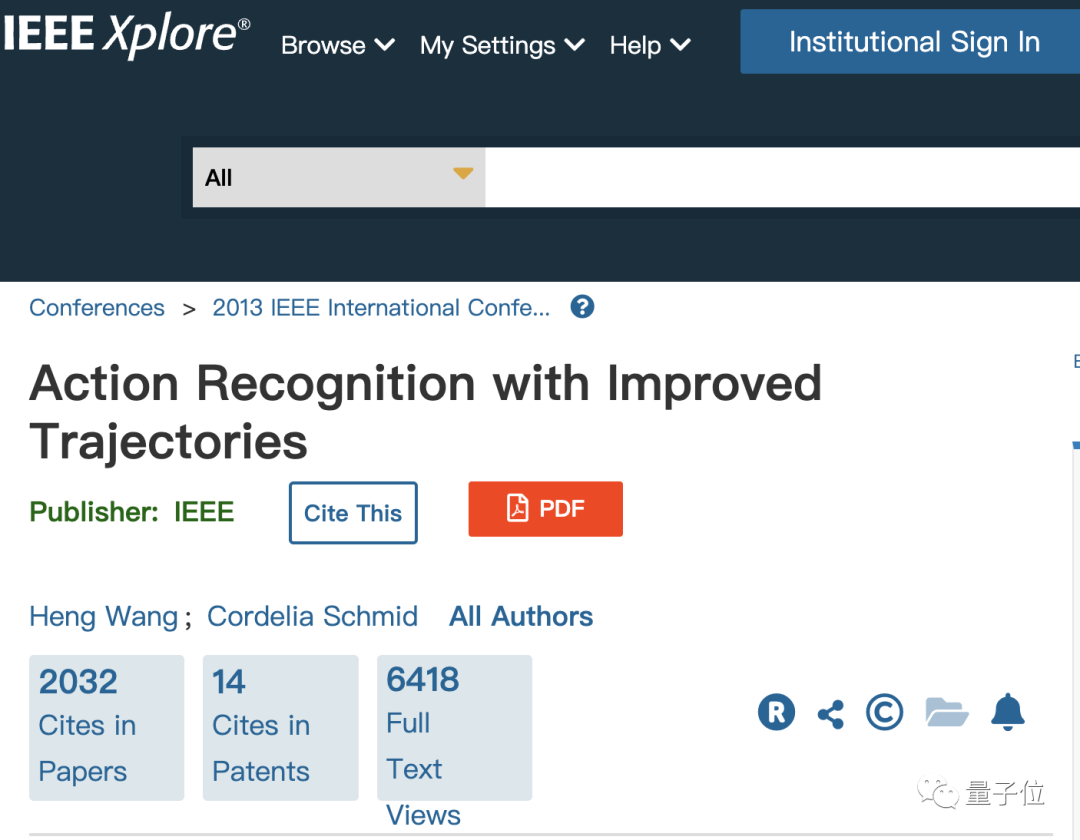

Die Wissenschaftler, die den Helmholtz-Preis gewonnen haben, sind die chinesische Wissenschaftlerin Heng Wang und Cordelia Schmid von Google, die Mitglieder von Meta AI sind

Sie haben gewonnen Auszeichnung für eine 2013 veröffentlichte Arbeit über die Anerkennung von Maßnahmen.

Zu dieser Zeit arbeiteten beide im Lear-Labor des französischen Nationalinstituts für Informatik und Automatisierung (französische Abkürzung: INRIA), und Schmid war zu dieser Zeit der Leiter des Labors.

Bitte klicken Sie auf den folgenden Link, um das Papier anzusehen: https://ieeexplore.ieee.org/document/6751553

Der Everingham-Preis wurde an zwei Teams verliehen

Der Gewinner der ersten Gruppe ist Samer von Google Agarwal, Keir Mierle und ihrem Team

Die beiden Gewinner haben ihren Abschluss an der University of Washington bzw. der University of Toronto gemacht. Ihre Leistung besteht darin, ein Open-Source-C++-Bibliotheks-Ceres-Solver-Projekt zu entwickeln, das weit verbreitet ist im Bereich Computer Vision Homepage-Link: http://ceres-solver.org/

Ein weiteres preisgekröntes Ergebnis ist der COCO-Datensatz, der eine große Anzahl von Bildern und Anmerkungen enthält und über umfangreiche Inhalte und Aufgaben verfügt. und sind wichtige Daten zum Testen von Computer-Vision-Modellen.

Ein weiteres preisgekröntes Ergebnis ist der COCO-Datensatz, der eine große Anzahl von Bildern und Anmerkungen enthält und über umfangreiche Inhalte und Aufgaben verfügt. und sind wichtige Daten zum Testen von Computer-Vision-Modellen.

Dieser Datensatz wurde von Microsoft vorgeschlagen. Der chinesische Wissenschaftler Tsung-Yi Lin hat seinen Doktortitel erworben und arbeitet jetzt als Forscher bei NVIDIA Labs.

Papieradresse: https://arxiv.org/abs/1405.0312

Projekthomepage: https://cocodataset.org/

Projekthomepage: https://cocodataset.org/

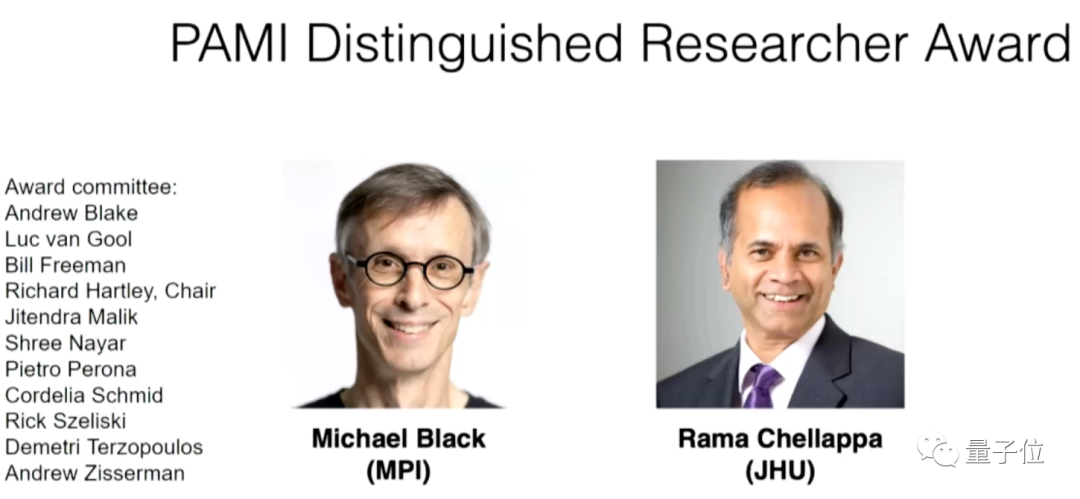

Der Gewinner der Auszeichnung „Outstanding Researcher“ ist der Deutsche Max Die Planck-Professoren Michael Black vom Institut und Rama Chellappa von der Johns Hopkins University.

Das obige ist der detaillierte Inhalt vonICCV'23-Papierpreis „Fighting of Gods'! Meta Divide Everything und ControlNet wurden gemeinsam ausgewählt, und es gab einen weiteren Artikel, der die Jury überraschte. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1359

1359

52

52

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Stellen Sie sich ein Modell der künstlichen Intelligenz vor, das nicht nur die Fähigkeit besitzt, die traditionelle Datenverarbeitung zu übertreffen, sondern auch eine effizientere Leistung zu geringeren Kosten erzielt. Dies ist keine Science-Fiction, DeepSeek-V2[1], das weltweit leistungsstärkste Open-Source-MoE-Modell, ist da. DeepSeek-V2 ist ein leistungsstarkes MoE-Sprachmodell (Mix of Experts) mit den Merkmalen eines wirtschaftlichen Trainings und einer effizienten Inferenz. Es besteht aus 236B Parametern, von denen 21B zur Aktivierung jedes Markers verwendet werden. Im Vergleich zu DeepSeek67B bietet DeepSeek-V2 eine stärkere Leistung, spart gleichzeitig 42,5 % der Trainingskosten, reduziert den KV-Cache um 93,3 % und erhöht den maximalen Generierungsdurchsatz auf das 5,76-fache. DeepSeek ist ein Unternehmen, das sich mit allgemeiner künstlicher Intelligenz beschäftigt

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas tritt offiziell in die Ära der Elektroroboter ein! Gestern hat sich der hydraulische Atlas einfach „unter Tränen“ von der Bühne der Geschichte zurückgezogen. Heute gab Boston Dynamics bekannt, dass der elektrische Atlas im Einsatz ist. Es scheint, dass Boston Dynamics im Bereich kommerzieller humanoider Roboter entschlossen ist, mit Tesla zu konkurrieren. Nach der Veröffentlichung des neuen Videos wurde es innerhalb von nur zehn Stunden bereits von mehr als einer Million Menschen angesehen. Die alten Leute gehen und neue Rollen entstehen. Das ist eine historische Notwendigkeit. Es besteht kein Zweifel, dass dieses Jahr das explosive Jahr der humanoiden Roboter ist. Netizens kommentierten: Die Weiterentwicklung der Roboter hat dazu geführt, dass die diesjährige Eröffnungsfeier wie Menschen aussieht, und der Freiheitsgrad ist weitaus größer als der von Menschen. Aber ist das wirklich kein Horrorfilm? Zu Beginn des Videos liegt Atlas ruhig auf dem Boden, scheinbar auf dem Rücken. Was folgt, ist atemberaubend

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

Anfang dieses Monats schlugen Forscher des MIT und anderer Institutionen eine vielversprechende Alternative zu MLP vor – KAN. KAN übertrifft MLP in Bezug auf Genauigkeit und Interpretierbarkeit. Und es kann MLP, das mit einer größeren Anzahl von Parametern ausgeführt wird, mit einer sehr kleinen Anzahl von Parametern übertreffen. Beispielsweise gaben die Autoren an, dass sie KAN nutzten, um die Ergebnisse von DeepMind mit einem kleineren Netzwerk und einem höheren Automatisierungsgrad zu reproduzieren. Konkret verfügt DeepMinds MLP über etwa 300.000 Parameter, während KAN nur etwa 200 Parameter hat. KAN hat eine starke mathematische Grundlage wie MLP und basiert auf dem universellen Approximationssatz, während KAN auf dem Kolmogorov-Arnold-Darstellungssatz basiert. Wie in der folgenden Abbildung gezeigt, hat KAN

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Die von Google geförderte Leistung von JAX hat in jüngsten Benchmark-Tests die von Pytorch und TensorFlow übertroffen und belegt bei 7 Indikatoren den ersten Platz. Und der Test wurde nicht auf der TPU mit der besten JAX-Leistung durchgeführt. Obwohl unter Entwicklern Pytorch immer noch beliebter ist als Tensorflow. Aber in Zukunft werden möglicherweise mehr große Modelle auf Basis der JAX-Plattform trainiert und ausgeführt. Modelle Kürzlich hat das Keras-Team drei Backends (TensorFlow, JAX, PyTorch) mit der nativen PyTorch-Implementierung und Keras2 mit TensorFlow verglichen. Zunächst wählen sie eine Reihe von Mainstream-Inhalten aus

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI verändert tatsächlich die Mathematik. Vor kurzem hat Tao Zhexuan, der diesem Thema große Aufmerksamkeit gewidmet hat, die neueste Ausgabe des „Bulletin of the American Mathematical Society“ (Bulletin der American Mathematical Society) weitergeleitet. Zum Thema „Werden Maschinen die Mathematik verändern?“ äußerten viele Mathematiker ihre Meinung. Der gesamte Prozess war voller Funken, knallhart und aufregend. Der Autor verfügt über eine starke Besetzung, darunter der Fields-Medaillengewinner Akshay Venkatesh, der chinesische Mathematiker Zheng Lejun, der NYU-Informatiker Ernest Davis und viele andere bekannte Wissenschaftler der Branche. Die Welt der KI hat sich dramatisch verändert. Viele dieser Artikel wurden vor einem Jahr eingereicht.

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Das neueste Video von Teslas Roboter Optimus ist veröffentlicht und er kann bereits in der Fabrik arbeiten. Bei normaler Geschwindigkeit sortiert es Batterien (Teslas 4680-Batterien) so: Der Beamte hat auch veröffentlicht, wie es bei 20-facher Geschwindigkeit aussieht – auf einer kleinen „Workstation“, pflücken und pflücken und pflücken: Dieses Mal wird es freigegeben. Eines der Highlights Der Vorteil des Videos besteht darin, dass Optimus diese Arbeit in der Fabrik völlig autonom und ohne menschliches Eingreifen während des gesamten Prozesses erledigt. Und aus Sicht von Optimus kann es auch die krumme Batterie aufnehmen und platzieren, wobei der Schwerpunkt auf der automatischen Fehlerkorrektur liegt: In Bezug auf die Hand von Optimus gab der NVIDIA-Wissenschaftler Jim Fan eine hohe Bewertung ab: Die Hand von Optimus ist der fünffingrige Roboter der Welt am geschicktesten. Seine Hände sind nicht nur taktil

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

Die Zielerkennung ist ein relativ ausgereiftes Problem in autonomen Fahrsystemen, wobei die Fußgängererkennung einer der ersten Algorithmen ist, die eingesetzt werden. In den meisten Arbeiten wurde eine sehr umfassende Recherche durchgeführt. Die Entfernungswahrnehmung mithilfe von Fischaugenkameras für die Rundumsicht ist jedoch relativ wenig untersucht. Aufgrund der großen radialen Verzerrung ist es schwierig, die standardmäßige Bounding-Box-Darstellung in Fischaugenkameras zu implementieren. Um die obige Beschreibung zu vereinfachen, untersuchen wir erweiterte Begrenzungsrahmen-, Ellipsen- und allgemeine Polygondesigns in Polar-/Winkeldarstellungen und definieren eine mIOU-Metrik für die Instanzsegmentierung, um diese Darstellungen zu analysieren. Das vorgeschlagene Modell „fisheyeDetNet“ mit polygonaler Form übertrifft andere Modelle und erreicht gleichzeitig 49,5 % mAP auf dem Valeo-Fisheye-Kameradatensatz für autonomes Fahren

DualBEV: BEVFormer und BEVDet4D deutlich übertreffen, öffnen Sie das Buch!

Mar 21, 2024 pm 05:21 PM

DualBEV: BEVFormer und BEVDet4D deutlich übertreffen, öffnen Sie das Buch!

Mar 21, 2024 pm 05:21 PM

In diesem Artikel wird das Problem der genauen Erkennung von Objekten aus verschiedenen Blickwinkeln (z. B. Perspektive und Vogelperspektive) beim autonomen Fahren untersucht, insbesondere wie die Transformation von Merkmalen aus der Perspektive (PV) in den Raum aus der Vogelperspektive (BEV) effektiv ist implementiert über das Modul Visual Transformation (VT). Bestehende Methoden lassen sich grob in zwei Strategien unterteilen: 2D-zu-3D- und 3D-zu-2D-Konvertierung. 2D-zu-3D-Methoden verbessern dichte 2D-Merkmale durch die Vorhersage von Tiefenwahrscheinlichkeiten, aber die inhärente Unsicherheit von Tiefenvorhersagen, insbesondere in entfernten Regionen, kann zu Ungenauigkeiten führen. Während 3D-zu-2D-Methoden normalerweise 3D-Abfragen verwenden, um 2D-Features abzutasten und die Aufmerksamkeitsgewichte der Korrespondenz zwischen 3D- und 2D-Features über einen Transformer zu lernen, erhöht sich die Rechen- und Bereitstellungszeit.