Originaltitel: Cross-Dataset Experimental Study of Radar-Camera Fusion in Bird's-Eye View

Link zum Papier: https://arxiv.org/pdf/2309.15465.pdf

Autorenzugehörigkeit: Opel Automobile GmbH Rheinland-Pfalzische Technische Universität Kaiserslautern- Deutsches Forschungszentrum für Künstliche Intelligenz Landau

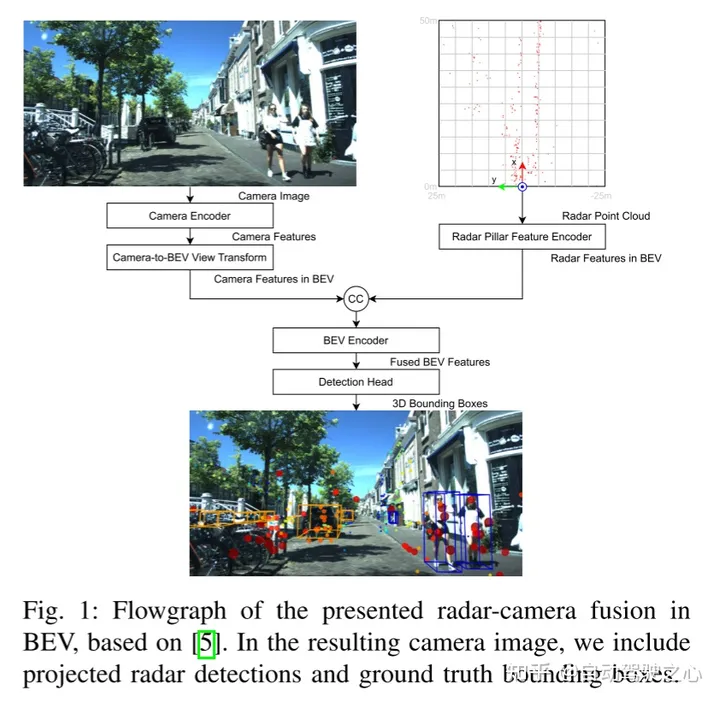

Durch die Nutzung komplementärer Sensorinformationen haben Millimeterwellenradar- und Kamerafusionssysteme das Potenzial, hochrobuste und autonome Fahrfunktionen für fortschrittliche Fahrerassistenzsysteme bereitzustellen Autonome Fahrfunktionen. Zuverlässiges Sensorsystem. Jüngste Fortschritte bei der kamerabasierten Objekterkennung bieten neue Möglichkeiten für die Fusion von Millimeterwellenradar und Kameras, die Feature-Maps aus der Vogelperspektive für die Fusion nutzen können. Diese Studie schlägt ein neuartiges und flexibles Fusionsnetzwerk vor und bewertet seine Leistung anhand von zwei Datensätzen (nuScenes und View-of-Delft). Experimentelle Ergebnisse zeigen, dass der Kamerazweig zwar große und vielfältige Trainingsdaten erfordert, der Millimeterwellenradarzweig jedoch stärker von Hochleistungs-Millimeterwellenradar profitiert. Durch Transferlernen verbessert diese Studie die Kameraleistung bei kleineren Datensätzen. Die Forschungsergebnisse zeigen außerdem, dass die Fusionsmethode von Millimeterwellenradar und Kamera deutlich besser ist als die Basismethode, bei der nur Kamera oder nur Millimeterwellenradar verwendet werden die Merkmale von Bildern Konvertieren in eine gängige Vogelperspektive (BEV)-Darstellung. Diese Darstellung bietet eine flexible Fusionsarchitektur, die zwischen mehreren Kameras oder mithilfe von Entfernungssensoren fusioniert werden kann. In dieser Arbeit erweitern wir die BEVFusion-Methode, die ursprünglich für die Laserkamerafusion verwendet wurde, für die Millimeterwellen-Radarkamerafusion. Wir haben unsere vorgeschlagene Fusionsmethode anhand eines ausgewählten Millimeterwellenradardatensatzes trainiert und bewertet. In mehreren Experimenten diskutieren wir die Vor- und Nachteile jedes Datensatzes. Abschließend wenden wir Transferlernen an, um weitere Verbesserungen zu erzielen

Der Inhalt, der neu geschrieben werden muss, ist: A. Kamera-Encoder und Kamera-zu-BEV-Ansichtstransformation

Der Inhalt, der neu geschrieben werden muss, ist: A. Kamera-Encoder und Kamera-zu-BEV-Ansichtstransformation

Der Kamera-Encoder und die Ansichtstransformation übernehmen die Idee von [15], einem flexiblen Framework, das beliebige externe Kameras extrahieren kann und Bild-BEV-Funktionen interner Parameter. Zunächst werden mithilfe eines Tiny-Swin-Transformer-Netzwerks Merkmale aus jedem Bild extrahiert. Als nächstes verwendet dieser Artikel die Lift- und Splat-Schritte von [14], um die Merkmale des Bildes in die BEV-Ebene umzuwandeln. Zu diesem Zweck folgt auf die dichte Tiefenvorhersage ein regelbasierter Block, in dem Merkmale in Pseudopunktwolken umgewandelt, gerastert und in einem BEV-Gitter akkumuliert werden.

Radar Column Feature Encoder

Der Zweck dieses Blocks besteht darin, die Millimeterwellen-Radarpunktwolke in BEV-Features im gleichen Raster wie die Bild-BEV-Features zu codieren. Zu diesem Zweck nutzt dieser Artikel die Pillar-Feature-Encoding-Technologie von [16], um die Punktwolke in unendlich hohe Voxel, die sogenannte Säule, zu rastern.

Der Inhalt, der neu geschrieben werden muss, ist: C. BEV-Encoder

Ähnlich wie [5] werden die BEV-Funktionen von Millimeterwellenradar und -kameras durch Kaskadenfusion erreicht. Die fusionierten Merkmale werden von einem gemeinsamen Faltungs-BEV-Encoder verarbeitet, sodass das Netzwerk räumliche Fehlausrichtungen berücksichtigen und die Synergie zwischen verschiedenen Modalitäten nutzen kann Karte. Weitere Regressionsköpfe sagen die Größe, Rotation und Höhe von Objekten sowie die Geschwindigkeits- und Klasseneigenschaften von nuScenes voraus. Die Wärmekarte wird mithilfe des Gaußschen Fokusverlusts trainiert, und die übrigen Erkennungsköpfe werden mithilfe des L1-Verlusts trainiert. Experimentelle Ergebnisse:

Stäcker, L., Heidenreich, P., Rambach, J., & Stricker, D. (2023). „Eine datensatzübergreifende experimentelle Studie der Radar-Kamera-Fusion aus der Vogelperspektive“ . ArXiv. / abs/2309.15465

Der Inhalt, der neu geschrieben werden muss, ist: https://mp.weixin.qq.com/s/5mA5up5a4KJO2PBwUcuIdQ

Das obige ist der detaillierte Inhalt vonExperimentelle Studie zur Radar-Kamera-Fusion über Datensätze hinweg unter BEV. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!