Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Weit voraus! BEVHeight++: Eine neue Lösung für die visuelle 3D-Zielerkennung am Straßenrand!

Weit voraus! BEVHeight++: Eine neue Lösung für die visuelle 3D-Zielerkennung am Straßenrand!

Weit voraus! BEVHeight++: Eine neue Lösung für die visuelle 3D-Zielerkennung am Straßenrand!

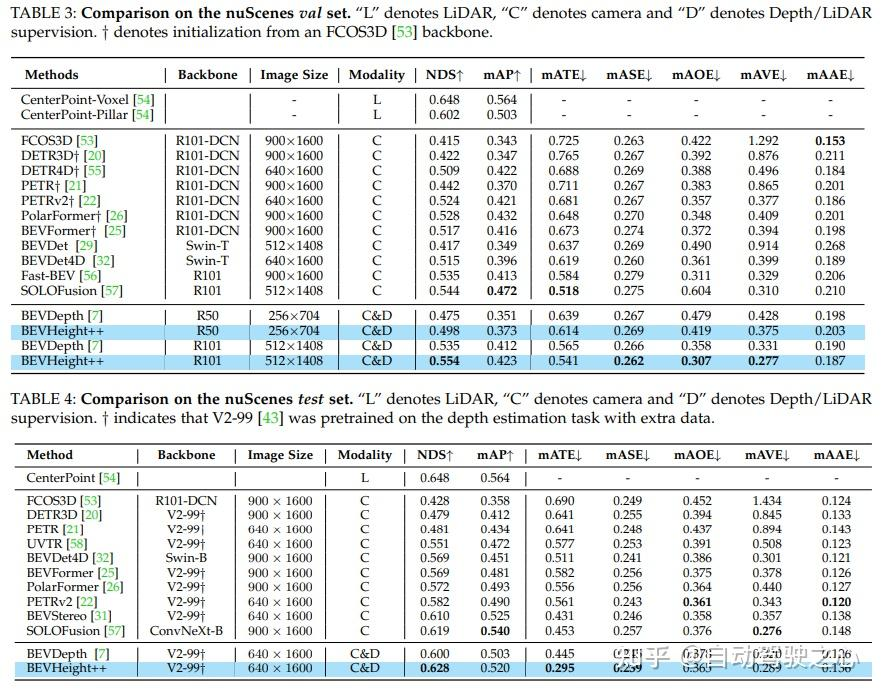

Regress auf die Höhe des Bodens, um eine entfernungsunabhängige Formulierung zu erreichen und so den Optimierungsprozess für nur kamerabewusste Methoden zu vereinfachen. Beim 3D-Erkennungs-Benchmark von Straßenkameras übertrifft die Methode alle bisherigen sichtzentrierten Methoden deutlich. Es führt zu erheblichen Verbesserungen von +1,9 % NDS und +1,1 % mAP gegenüber BEVDepth. Auf dem nuScenes-Testset erzielte die Methode erhebliche Fortschritte, wobei NDS und mAP um +2,8 % bzw. +1,7 % anstiegen.

Titel: BEVHeight++: Auf dem Weg zu einer robusten visionszentrierten 3D-Objekterkennung

Link zum Papier: https://arxiv.org/pdf/2309.16179.pdf

Autorenzugehörigkeit: Tsinghua University, Sun Yat-sen University, Cainiao Network, Peking Universität

Von der ersten autonomen Fahrgemeinschaft in China: Der Bau von mehr als 20 technischen Richtungslernrouten (BEV-Wahrnehmung/3D-Erkennung/Multisensor-Fusion/SLAM und Planung usw.) wurde endlich abgeschlossen.

Obwohl die jüngsten autonomen Fahrsystem konzentriert sich auf die Entwicklung von Erfassungsmethoden für Fahrzeugsensoren, aber eine oft übersehene Alternative ist der Einsatz intelligenter Straßenkameras, um die Erfassungsfähigkeiten über den Sichtbereich hinaus zu erweitern. Die Autoren stellten fest, dass hochmoderne visionszentrierte BEV-Erkennungsmethoden bei Straßenkameras schlecht funktionieren. Dies liegt daran, dass sich diese Methoden hauptsächlich auf die Wiederherstellung der Tiefe um die Kameramitte konzentrieren, wo der Tiefenunterschied zwischen dem Auto und dem Boden mit der Entfernung schnell abnimmt. In diesem Artikel schlägt der Autor eine einfache, aber effektive Methode namens BEVHeight++ vor, um dieses Problem zu lösen. Im Wesentlichen regressieren die Autoren auf die Höhe des Bodens, um eine entfernungsunabhängige Formulierung zu erreichen und dadurch den Optimierungsprozess für rein kamerabewusste Methoden zu vereinfachen. Durch die Kombination von Höhen- und Tiefenkodierungstechniken wird eine genauere und robustere Projektion vom 2D- in den BEV-Raum erreicht. Die Methode übertrifft alle bisherigen sichtzentrierten Methoden beim beliebten 3D-Erkennungs-Benchmark für Straßenkameras deutlich. Bei Selbstfahrzeugszenen übertrifft BEVHeight++ reine Tiefenmethoden. Insbesondere führt es zu deutlichen Verbesserungen von +1,9 % NDS und +1,1 % mAP gegenüber BEVDepth, wenn es mit dem nuScenes-Validierungssatz ausgewertet wird. Darüber hinaus erzielt die Methode im nuScenes-Testset erhebliche Fortschritte, wobei NDS und mAP um +2,8 % bzw. +1,7 % anstiegen.

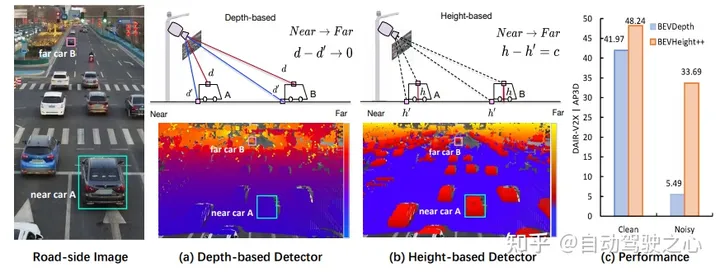

Abbildung 1: (a) Um 3D-Begrenzungsrahmen aus monokularen Bildern zu generieren, sagen moderne Methoden zunächst die Tiefe pro Pixel voraus, entweder explizit oder implizit, um die 3D-Position von Vordergrundobjekten im Vergleich zu zu bestimmen Hintergrund. Als wir jedoch die Tiefe pro Pixel auf dem Bild aufzeichneten, stellten wir fest, dass der Unterschied zwischen Punkten auf dem Dach und dem umgebenden Boden schnell kleiner wird, wenn sich das Auto von der Kamera entfernt, was die Optimierung insbesondere für entfernte Objekte suboptimal macht . (b) Stattdessen zeichnen wir die Höhe pro Pixel zum Boden auf und stellen fest, dass dieser Unterschied unabhängig von der Entfernung unabhängig ist und für das Netzwerk visuell besser geeignet ist, Objekte zu erkennen. Die 3D-Position kann jedoch nicht direkt durch die Vorhersage der Höhe allein zurückgeführt werden. (c) Zu diesem Zweck schlagen wir ein neues Framework BEVHeight++ vor, um dieses Problem zu lösen. Empirische Ergebnisse zeigen, dass unsere Methode die beste Methode bei sauberen Einstellungen um 5,49 % und bei lauten Einstellungen um 28,2 % übertrifft.

Abbildung 1: (a) Um 3D-Begrenzungsrahmen aus monokularen Bildern zu generieren, sagen moderne Methoden zunächst die Tiefe pro Pixel voraus, entweder explizit oder implizit, um die 3D-Position von Vordergrundobjekten im Vergleich zu zu bestimmen Hintergrund. Als wir jedoch die Tiefe pro Pixel auf dem Bild aufzeichneten, stellten wir fest, dass der Unterschied zwischen Punkten auf dem Dach und dem umgebenden Boden schnell kleiner wird, wenn sich das Auto von der Kamera entfernt, was die Optimierung insbesondere für entfernte Objekte suboptimal macht . (b) Stattdessen zeichnen wir die Höhe pro Pixel zum Boden auf und stellen fest, dass dieser Unterschied unabhängig von der Entfernung unabhängig ist und für das Netzwerk visuell besser geeignet ist, Objekte zu erkennen. Die 3D-Position kann jedoch nicht direkt durch die Vorhersage der Höhe allein zurückgeführt werden. (c) Zu diesem Zweck schlagen wir ein neues Framework BEVHeight++ vor, um dieses Problem zu lösen. Empirische Ergebnisse zeigen, dass unsere Methode die beste Methode bei sauberen Einstellungen um 5,49 % und bei lauten Einstellungen um 28,2 % übertrifft.

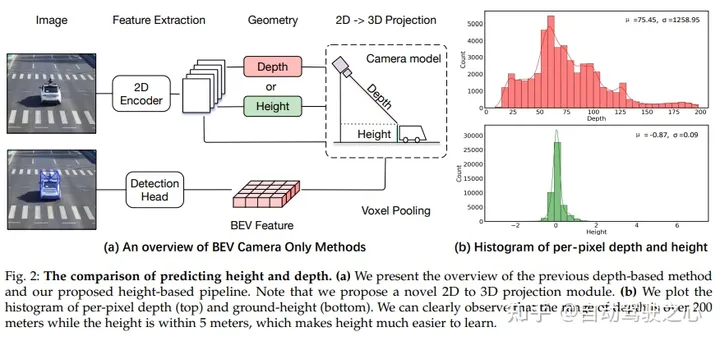

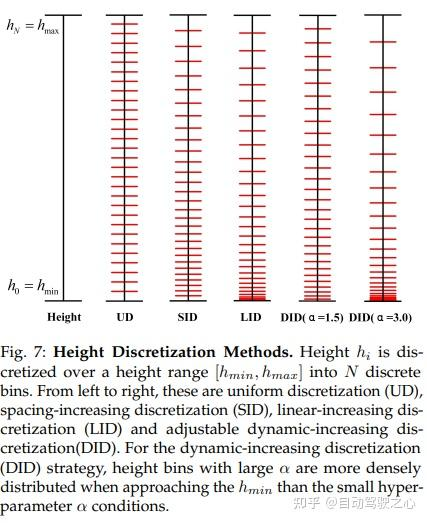

Vergleich der Vorhersagehöhe und -tiefe. (a) Überblick über frühere tiefenbasierte Methoden und unsere vorgeschlagene höhenbasierte Pipeline. Bitte beachten Sie, dass in diesem Artikel ein neuartiges 2D-zu-3D-Projektionsmodul vorgeschlagen wird. (b) Wenn man Histogramme der Tiefe pro Pixel (oben) und der Bodenhöhe (unten) zeichnet, kann man deutlich erkennen, dass der Tiefenbereich über 200 Meter liegt, während die Höhe innerhalb von 5 Metern liegt, was das Erlernen der Höhe erleichtert.

Vergleich der Vorhersagehöhe und -tiefe. (a) Überblick über frühere tiefenbasierte Methoden und unsere vorgeschlagene höhenbasierte Pipeline. Bitte beachten Sie, dass in diesem Artikel ein neuartiges 2D-zu-3D-Projektionsmodul vorgeschlagen wird. (b) Wenn man Histogramme der Tiefe pro Pixel (oben) und der Bodenhöhe (unten) zeichnet, kann man deutlich erkennen, dass der Tiefenbereich über 200 Meter liegt, während die Höhe innerhalb von 5 Metern liegt, was das Erlernen der Höhe erleichtert.

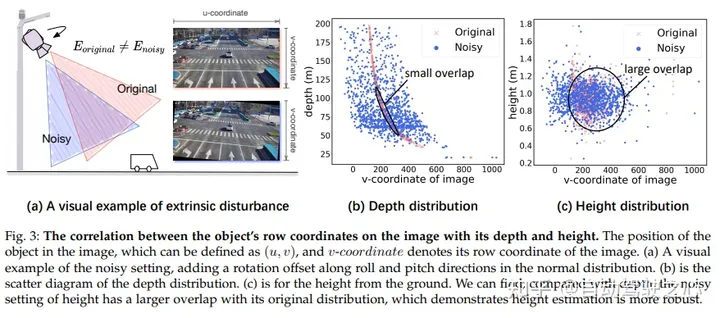

Im Bild besteht ein Zusammenhang zwischen den Reihenkoordinaten des Ziels und seiner Tiefe und Höhe. Die Position des Ziels im Bild kann durch (u, v) definiert werden, wobei v die Zeilenkoordinate des Bildes darstellt. In (a) zeigen wir ein visuelles Beispiel für die Einführung von Lärm durch Hinzufügen von Rotationsversätzen in Roll- und Nickrichtung zu einer Normalverteilung. In (b) zeigen wir ein Streudiagramm der Tiefenverteilung. In (c) zeigen wir die Höhe über dem Boden. Wir können beobachten, dass die Rauscheinstellung für die Höhe im Vergleich zur Tiefe eine größere Überlappung mit ihrer ursprünglichen Verteilung aufweist, was darauf hindeutet, dass die Höhenschätzung robuster ist

Im Bild besteht ein Zusammenhang zwischen den Reihenkoordinaten des Ziels und seiner Tiefe und Höhe. Die Position des Ziels im Bild kann durch (u, v) definiert werden, wobei v die Zeilenkoordinate des Bildes darstellt. In (a) zeigen wir ein visuelles Beispiel für die Einführung von Lärm durch Hinzufügen von Rotationsversätzen in Roll- und Nickrichtung zu einer Normalverteilung. In (b) zeigen wir ein Streudiagramm der Tiefenverteilung. In (c) zeigen wir die Höhe über dem Boden. Wir können beobachten, dass die Rauscheinstellung für die Höhe im Vergleich zur Tiefe eine größere Überlappung mit ihrer ursprünglichen Verteilung aufweist, was darauf hindeutet, dass die Höhenschätzung robuster ist

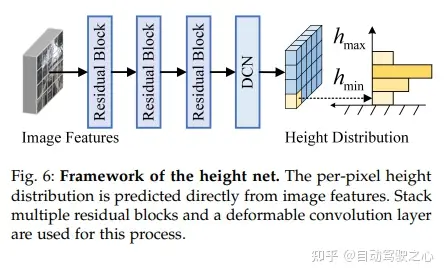

Das Gesamtgerüst von BEVHeight++ enthält drei Teilnetzwerke, nämlich den tiefenbasierten Zweig (Cyan), den höhenbasierten Zweig (grün) und den Feature-Fusion-Prozess (grau). Die tiefenbasierte Pipeline wandelt Bildansichtsmerkmale unter Verwendung der geschätzten Tiefe pro Pixel in tiefenbasierte BEV-Merkmale (D-basiertes BEV) um. Die höhenbasierte Pipeline generiert höhenbasierte BEV-Merkmale (H-basiertes BEV) mithilfe von Bodenhöhenvorhersagen von Hebemerkmalen in Bildansichten. Die Feature-Fusion umfasst die Bildfusion und die Fusion aus der Vogelperspektive. Durch die Bild-Ansicht-Fusion werden Fusionsmerkmale durch kaskadierende Höhenverteilung und Bildmerkmale erhalten, die für nachfolgende Aktualisierungsvorgänge verwendet werden. Die Fusion aus der Vogelperspektive erhält durch verformbare Queraufmerksamkeit fusionierte BEV-Merkmale aus höhenbasierten BEV-Merkmalen und tiefenbasierten BEV-Merkmalen und verwendet sie dann als Eingabe des Erkennungskopfes

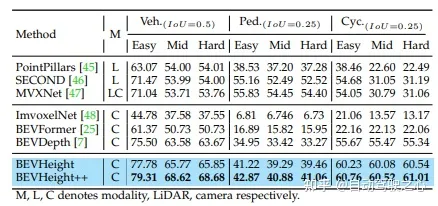

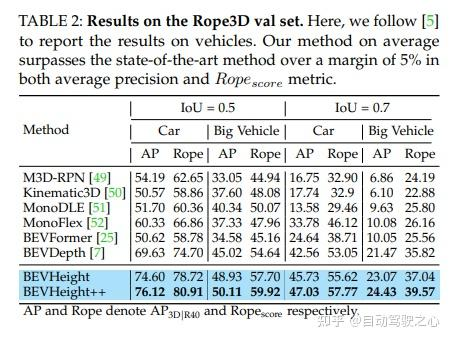

Experimentelle Ergebnisse

Der Inhalt, der neu geschrieben werden muss, ist: Originallink: https://mp.weixin.qq.com/s/AdCXYzHIy2lTfAHk2AZ4_w

Das obige ist der detaillierte Inhalt vonWeit voraus! BEVHeight++: Eine neue Lösung für die visuelle 3D-Zielerkennung am Straßenrand!. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1661

1661

14

14

1418

1418

52

52

1311

1311

25

25

1261

1261

29

29

1234

1234

24

24

CUDAs universelle Matrixmultiplikation: vom Einstieg bis zur Kompetenz!

Mar 25, 2024 pm 12:30 PM

CUDAs universelle Matrixmultiplikation: vom Einstieg bis zur Kompetenz!

Mar 25, 2024 pm 12:30 PM

Die allgemeine Matrixmultiplikation (GEMM) ist ein wesentlicher Bestandteil vieler Anwendungen und Algorithmen und außerdem einer der wichtigen Indikatoren zur Bewertung der Leistung der Computerhardware. Eingehende Forschung und Optimierung der Implementierung von GEMM können uns helfen, Hochleistungsrechnen und die Beziehung zwischen Software- und Hardwaresystemen besser zu verstehen. In der Informatik kann eine effektive Optimierung von GEMM die Rechengeschwindigkeit erhöhen und Ressourcen einsparen, was für die Verbesserung der Gesamtleistung eines Computersystems von entscheidender Bedeutung ist. Ein tiefgreifendes Verständnis des Funktionsprinzips und der Optimierungsmethode von GEMM wird uns helfen, das Potenzial moderner Computerhardware besser zu nutzen und effizientere Lösungen für verschiedene komplexe Computeraufgaben bereitzustellen. Durch Optimierung der Leistung von GEMM

Wie lässt sich das Long-Tail-Problem in autonomen Fahrszenarien lösen?

Jun 02, 2024 pm 02:44 PM

Wie lässt sich das Long-Tail-Problem in autonomen Fahrszenarien lösen?

Jun 02, 2024 pm 02:44 PM

Gestern wurde ich während des Interviews gefragt, ob ich irgendwelche Long-Tail-Fragen gestellt hätte, also dachte ich, ich würde eine kurze Zusammenfassung geben. Das Long-Tail-Problem des autonomen Fahrens bezieht sich auf Randfälle bei autonomen Fahrzeugen, also mögliche Szenarien mit geringer Eintrittswahrscheinlichkeit. Das wahrgenommene Long-Tail-Problem ist einer der Hauptgründe, die derzeit den betrieblichen Designbereich intelligenter autonomer Einzelfahrzeugfahrzeuge einschränken. Die zugrunde liegende Architektur und die meisten technischen Probleme des autonomen Fahrens wurden gelöst, und die verbleibenden 5 % der Long-Tail-Probleme wurden nach und nach zum Schlüssel zur Einschränkung der Entwicklung des autonomen Fahrens. Zu diesen Problemen gehören eine Vielzahl fragmentierter Szenarien, Extremsituationen und unvorhersehbares menschliches Verhalten. Der „Long Tail“ von Randszenarien beim autonomen Fahren bezieht sich auf Randfälle in autonomen Fahrzeugen (AVs). Randfälle sind mögliche Szenarien mit geringer Eintrittswahrscheinlichkeit. diese seltenen Ereignisse

Das intelligente Fahrsystem Qiankun ADS3.0 von Huawei wird im August auf den Markt kommen und erstmals auf dem Xiangjie S9 eingeführt

Jul 30, 2024 pm 02:17 PM

Das intelligente Fahrsystem Qiankun ADS3.0 von Huawei wird im August auf den Markt kommen und erstmals auf dem Xiangjie S9 eingeführt

Jul 30, 2024 pm 02:17 PM

Am 29. Juli nahm Yu Chengdong, Huawei-Geschäftsführer, Vorsitzender von Terminal BG und Vorsitzender von Smart Car Solutions BU, an der Übergabezeremonie des 400.000sten Neuwagens von AITO Wenjie teil, hielt eine Rede und kündigte an, dass die Modelle der Wenjie-Serie dies tun werden Dieses Jahr auf den Markt kommen Im August wurde die Huawei Qiankun ADS 3.0-Version auf den Markt gebracht und es ist geplant, die Upgrades sukzessive von August bis September voranzutreiben. Das Xiangjie S9, das am 6. August auf den Markt kommt, wird erstmals mit dem intelligenten Fahrsystem ADS3.0 von Huawei ausgestattet sein. Mit Hilfe von Lidar wird Huawei Qiankun ADS3.0 seine intelligenten Fahrfähigkeiten erheblich verbessern, über integrierte End-to-End-Funktionen verfügen und eine neue End-to-End-Architektur von GOD (allgemeine Hinderniserkennung)/PDP (prädiktiv) einführen Entscheidungsfindung und Kontrolle), Bereitstellung der NCA-Funktion für intelligentes Fahren von Parkplatz zu Parkplatz und Aktualisierung von CAS3.0

SIMPL: Ein einfacher und effizienter Multi-Agent-Benchmark zur Bewegungsvorhersage für autonomes Fahren

Feb 20, 2024 am 11:48 AM

SIMPL: Ein einfacher und effizienter Multi-Agent-Benchmark zur Bewegungsvorhersage für autonomes Fahren

Feb 20, 2024 am 11:48 AM

Originaltitel: SIMPL: ASimpleandEfficientMulti-agentMotionPredictionBaselineforAutonomousDriving Paper-Link: https://arxiv.org/pdf/2402.02519.pdf Code-Link: https://github.com/HKUST-Aerial-Robotics/SIMPL Autor: Hong Kong University of Science und Technologie DJI-Papieridee: Dieses Papier schlägt eine einfache und effiziente Bewegungsvorhersagebasislinie (SIMPL) für autonome Fahrzeuge vor. Im Vergleich zum herkömmlichen Agent-Cent

Dieser Artikel reicht aus, um etwas über autonomes Fahren und Flugbahnvorhersage zu lesen!

Feb 28, 2024 pm 07:20 PM

Dieser Artikel reicht aus, um etwas über autonomes Fahren und Flugbahnvorhersage zu lesen!

Feb 28, 2024 pm 07:20 PM

Die Trajektorienvorhersage spielt eine wichtige Rolle beim autonomen Fahren. Unter autonomer Fahrtrajektorienvorhersage versteht man die Vorhersage der zukünftigen Fahrtrajektorie des Fahrzeugs durch die Analyse verschiedener Daten während des Fahrvorgangs. Als Kernmodul des autonomen Fahrens ist die Qualität der Trajektorienvorhersage von entscheidender Bedeutung für die nachgelagerte Planungssteuerung. Die Trajektorienvorhersageaufgabe verfügt über einen umfangreichen Technologie-Stack und erfordert Vertrautheit mit der dynamischen/statischen Wahrnehmung des autonomen Fahrens, hochpräzisen Karten, Fahrspurlinien, Fähigkeiten in der neuronalen Netzwerkarchitektur (CNN&GNN&Transformer) usw. Der Einstieg ist sehr schwierig! Viele Fans hoffen, so schnell wie möglich mit der Flugbahnvorhersage beginnen zu können und Fallstricke zu vermeiden. Heute werde ich eine Bestandsaufnahme einiger häufiger Probleme und einführender Lernmethoden für die Flugbahnvorhersage machen! Einführungsbezogenes Wissen 1. Sind die Vorschaupapiere in Ordnung? A: Schauen Sie sich zuerst die Umfrage an, S

Sprechen wir über End-to-End- und autonome Fahrsysteme der nächsten Generation sowie über einige Missverständnisse über End-to-End-Autonomes Fahren?

Apr 15, 2024 pm 04:13 PM

Sprechen wir über End-to-End- und autonome Fahrsysteme der nächsten Generation sowie über einige Missverständnisse über End-to-End-Autonomes Fahren?

Apr 15, 2024 pm 04:13 PM

Im vergangenen Monat hatte ich aus bekannten Gründen einen sehr intensiven Austausch mit verschiedenen Lehrern und Mitschülern der Branche. Ein unvermeidliches Thema im Austausch ist natürlich End-to-End und der beliebte Tesla FSDV12. Ich möchte diese Gelegenheit nutzen, einige meiner aktuellen Gedanken und Meinungen als Referenz und Diskussion darzulegen. Wie definiert man ein durchgängiges autonomes Fahrsystem und welche Probleme sollten voraussichtlich durchgängig gelöst werden? Gemäß der traditionellsten Definition bezieht sich ein End-to-End-System auf ein System, das Rohinformationen von Sensoren eingibt und für die Aufgabe relevante Variablen direkt ausgibt. Bei der Bilderkennung kann CNN beispielsweise als End-to-End bezeichnet werden, verglichen mit der herkömmlichen Methode zum Extrahieren von Merkmalen + Klassifizieren. Bei autonomen Fahraufgaben werden Eingabedaten verschiedener Sensoren (Kamera/LiDAR) benötigt

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

Die Zielerkennung ist ein relativ ausgereiftes Problem in autonomen Fahrsystemen, wobei die Fußgängererkennung einer der ersten Algorithmen ist, die eingesetzt werden. In den meisten Arbeiten wurde eine sehr umfassende Recherche durchgeführt. Die Entfernungswahrnehmung mithilfe von Fischaugenkameras für die Rundumsicht ist jedoch relativ wenig untersucht. Aufgrund der großen radialen Verzerrung ist es schwierig, die standardmäßige Bounding-Box-Darstellung in Fischaugenkameras zu implementieren. Um die obige Beschreibung zu vereinfachen, untersuchen wir erweiterte Begrenzungsrahmen-, Ellipsen- und allgemeine Polygondesigns in Polar-/Winkeldarstellungen und definieren eine mIOU-Metrik für die Instanzsegmentierung, um diese Darstellungen zu analysieren. Das vorgeschlagene Modell „fisheyeDetNet“ mit polygonaler Form übertrifft andere Modelle und erreicht gleichzeitig 49,5 % mAP auf dem Valeo-Fisheye-Kameradatensatz für autonomes Fahren

Immer neu! Upgrade der Huawei Mate60-Serie auf HarmonyOS 4.2: KI-Cloud-Erweiterung, Xiaoyi-Dialekt ist so einfach zu bedienen

Jun 02, 2024 pm 02:58 PM

Immer neu! Upgrade der Huawei Mate60-Serie auf HarmonyOS 4.2: KI-Cloud-Erweiterung, Xiaoyi-Dialekt ist so einfach zu bedienen

Jun 02, 2024 pm 02:58 PM

Am 11. April kündigte Huawei erstmals offiziell den 100-Maschinen-Upgradeplan für HarmonyOS 4.2 an. Dieses Mal werden mehr als 180 Geräte an dem Upgrade teilnehmen, darunter Mobiltelefone, Tablets, Uhren, Kopfhörer, Smart-Screens und andere Geräte. Im vergangenen Monat haben mit dem stetigen Fortschritt des HarmonyOS4.2-Upgradeplans für 100 Maschinen auch viele beliebte Modelle, darunter Huawei Pocket2, Huawei MateX5-Serie, Nova12-Serie, Huawei Pura-Serie usw., mit der Aktualisierung und Anpassung begonnen, was bedeutet, dass dass es mehr Benutzer von Huawei-Modellen geben wird, die das gemeinsame und oft neue Erlebnis von HarmonyOS genießen können. Den Rückmeldungen der Benutzer zufolge hat sich das Erlebnis der Modelle der Huawei Mate60-Serie nach dem Upgrade von HarmonyOS4.2 in allen Aspekten verbessert. Vor allem Huawei M