Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Problem bei der Schätzung der menschlichen Pose in der Bildverarbeitung

Problem bei der Schätzung der menschlichen Pose in der Bildverarbeitung

Problem bei der Schätzung der menschlichen Pose in der Bildverarbeitung

Das Problem der menschlichen Posenschätzung in der Computer-Vision erfordert spezifische Codebeispiele.

Die menschliche Posenschätzung ist eine wichtige Forschungsrichtung im Bereich der Computer-Vision. Ihr Ziel ist es, die Poseninformationen des menschlichen Körpers, einschließlich der Gelenke, genau zu erhalten Positionen, aus Bildern oder Videos, Gelenkwinkel usw. Die Schätzung der menschlichen Pose findet breite Anwendung in vielen Anwendungsbereichen, wie z. B. Bewegungserfassung, Mensch-Computer-Interaktion, virtuelle Realität usw. In diesem Artikel werden die Grundprinzipien der menschlichen Posenschätzung vorgestellt und spezifische Codebeispiele bereitgestellt.

Das Grundprinzip der menschlichen Haltungsschätzung besteht darin, durch Analyse der Schlüsselpunkte des menschlichen Körpers im Bild (wie Kopf, Schultern, Hände, Füße usw.) auf die Haltung des menschlichen Körpers zu schließen. Um dieses Ziel zu erreichen, können wir Deep-Learning-Modelle wie Convolutional Neural Network (CNN) oder Recurrent Neural Network (RNN) verwenden.

Das Folgende ist ein Beispielcode, der die Open-Source-Bibliothek OpenPose verwendet, um die Schätzung der menschlichen Pose zu implementieren:

import cv2

import numpy as np

from openpose import OpenPose

# 加载OpenPose模型

openpose = OpenPose("path/to/openpose/models")

# 加载图像

image = cv2.imread("path/to/image.jpg")

# 运行OpenPose模型

poses = openpose.detect(image)

# 显示姿态估计结果

for pose in poses:

# 绘制骨骼连接

image = openpose.draw_skeleton(image, pose)

# 绘制关节点

image = openpose.draw_keypoints(image, pose)

# 显示图像

cv2.imshow("Pose Estimation", image)

cv2.waitKey(0)

cv2.destroyAllWindows()Im obigen Beispielcode importieren wir zuerst die erforderlichen Bibliotheken, laden dann das OpenPose-Modell und laden das zu schätzende Bild. Als Nächstes führen wir das OpenPose-Modell aus, um Posen zu erkennen. Das zurückgegebene Ergebnis ist eine Liste mit mehreren Posen. Schließlich verwenden wir die von OpenPose bereitgestellte Zeichenfunktion, um die Ergebnisse der Posenschätzung zu zeichnen und das Bild anzuzeigen.

Es ist zu beachten, dass der obige Beispielcode nur zu Demonstrationszwecken dient. Tatsächlich erfordert die Realisierung der menschlichen Haltungsschätzung komplexere Vorverarbeitungs-, Nachverarbeitungs- und Parameteranpassungsprozesse. Darüber hinaus ist OpenPose eine Open-Source-Bibliothek, die Benutzern mehr Funktionen und Optionen zur Nutzung bietet.

Kurz gesagt ist die Schätzung der menschlichen Pose ein wichtiges Problem im Bereich des Computersehens, bei dem durch die Analyse wichtiger Punkte im Bild auf die Pose des menschlichen Körpers geschlossen wird. Dieser Artikel enthält Beispielcode für die Implementierung der menschlichen Haltungsschätzung mithilfe der Open-Source-Bibliothek OpenPose. Leser können entsprechend ihren eigenen Anforderungen detailliertere Recherchen und Entwicklungen durchführen.

Das obige ist der detaillierte Inhalt vonProblem bei der Schätzung der menschlichen Pose in der Bildverarbeitung. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1386

1386

52

52

Jenseits von ORB-SLAM3! SL-SLAM: Szenen mit wenig Licht, starkem Jitter und schwacher Textur werden verarbeitet

May 30, 2024 am 09:35 AM

Jenseits von ORB-SLAM3! SL-SLAM: Szenen mit wenig Licht, starkem Jitter und schwacher Textur werden verarbeitet

May 30, 2024 am 09:35 AM

Heute diskutieren wir darüber, wie Deep-Learning-Technologie die Leistung von visionbasiertem SLAM (Simultaneous Localization and Mapping) in komplexen Umgebungen verbessern kann. Durch die Kombination von Methoden zur Tiefenmerkmalsextraktion und Tiefenanpassung stellen wir hier ein vielseitiges hybrides visuelles SLAM-System vor, das die Anpassung in anspruchsvollen Szenarien wie schlechten Lichtverhältnissen, dynamischer Beleuchtung, schwach strukturierten Bereichen und starkem Jitter verbessern soll. Unser System unterstützt mehrere Modi, einschließlich erweiterter Monokular-, Stereo-, Monokular-Trägheits- und Stereo-Trägheitskonfigurationen. Darüber hinaus wird analysiert, wie visuelles SLAM mit Deep-Learning-Methoden kombiniert werden kann, um andere Forschungen zu inspirieren. Durch umfangreiche Experimente mit öffentlichen Datensätzen und selbst abgetasteten Daten demonstrieren wir die Überlegenheit von SL-SLAM in Bezug auf Positionierungsgenauigkeit und Tracking-Robustheit.

Was ist NeRF? Ist die NeRF-basierte 3D-Rekonstruktion voxelbasiert?

Oct 16, 2023 am 11:33 AM

Was ist NeRF? Ist die NeRF-basierte 3D-Rekonstruktion voxelbasiert?

Oct 16, 2023 am 11:33 AM

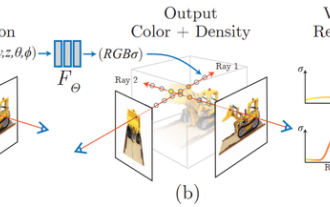

1 Einleitung Neural Radiation Fields (NeRF) sind ein relativ neues Paradigma im Bereich Deep Learning und Computer Vision. Diese Technologie wurde im ECCV2020-Papier „NeRF: Representing Scenes as Neural Radiation Fields for View Synthesis“ (das mit dem Best Paper Award ausgezeichnet wurde) vorgestellt und erfreut sich seitdem mit bisher fast 800 Zitaten äußerster Beliebtheit [1]. Der Ansatz markiert einen grundlegenden Wandel in der traditionellen Art und Weise, wie maschinelles Lernen 3D-Daten verarbeitet. Darstellung neuronaler Strahlungsfelder und differenzierbarer Rendering-Prozess: Zusammengesetzte Bilder durch Abtasten von 5D-Koordinaten (Position und Blickrichtung) entlang der Kamerastrahlen, Eingabe dieser Positionen in ein MLP, um mithilfe volumetrischer Rendering-Techniken Bilder zu erzeugen; ; Die Rendering-Funktion ist differenzierbar und kann daher übergeben werden

Die erste rein visuelle statische Rekonstruktion des autonomen Fahrens

Jun 02, 2024 pm 03:24 PM

Die erste rein visuelle statische Rekonstruktion des autonomen Fahrens

Jun 02, 2024 pm 03:24 PM

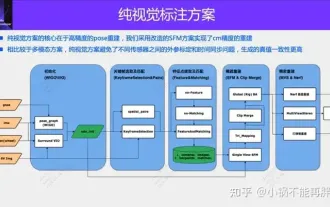

Eine rein visuelle Annotationslösung nutzt hauptsächlich die visuelle Darstellung sowie einige Daten von GPS, IMU und Radgeschwindigkeitssensoren für die dynamische Annotation. Für Massenproduktionsszenarien muss es sich natürlich nicht nur um visuelle Aspekte handeln. Einige in Massenproduktion hergestellte Fahrzeuge verfügen über Sensoren wie Festkörperradar (AT128). Wenn wir aus Sicht der Massenproduktion einen geschlossenen Datenkreislauf erstellen und alle diese Sensoren verwenden, können wir das Problem der Kennzeichnung dynamischer Objekte effektiv lösen. Aber in unserem Plan gibt es kein Festkörperradar. Aus diesem Grund stellen wir diese gängigste Etikettierungslösung für die Massenproduktion vor. Der Kern einer rein visuellen Annotationslösung liegt in der hochpräzisen Posenrekonstruktion. Wir verwenden das Posenrekonstruktionsschema von Structure from Motion (SFM), um die Genauigkeit der Rekonstruktion sicherzustellen. Aber pass

Werfen Sie einen Blick auf die Vergangenheit und Gegenwart von Occ und autonomem Fahren! Die erste Rezension fasst die drei Hauptthemen Funktionserweiterung/Massenproduktionsbereitstellung/effiziente Annotation umfassend zusammen.

May 08, 2024 am 11:40 AM

Werfen Sie einen Blick auf die Vergangenheit und Gegenwart von Occ und autonomem Fahren! Die erste Rezension fasst die drei Hauptthemen Funktionserweiterung/Massenproduktionsbereitstellung/effiziente Annotation umfassend zusammen.

May 08, 2024 am 11:40 AM

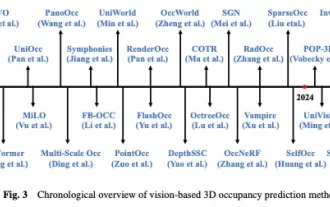

Oben geschrieben und persönliches Verständnis des Autors In den letzten Jahren hat autonomes Fahren aufgrund seines Potenzials, die Belastung des Fahrers zu verringern und die Fahrsicherheit zu verbessern, zunehmende Aufmerksamkeit erhalten. Die visionsbasierte dreidimensionale Belegungsvorhersage ist eine neue Wahrnehmungsaufgabe, die sich für eine kostengünstige und umfassende Untersuchung der Sicherheit autonomen Fahrens eignet. Obwohl viele Studien die Überlegenheit von 3D-Belegungsvorhersagetools im Vergleich zu objektzentrierten Wahrnehmungsaufgaben gezeigt haben, gibt es immer noch Rezensionen, die diesem sich schnell entwickelnden Bereich gewidmet sind. In diesem Artikel wird zunächst der Hintergrund der visionsbasierten 3D-Belegungsvorhersage vorgestellt und die bei dieser Aufgabe auftretenden Herausforderungen erörtert. Als nächstes diskutieren wir umfassend den aktuellen Status und die Entwicklungstrends aktueller 3D-Belegungsvorhersagemethoden unter drei Gesichtspunkten: Funktionsverbesserung, Bereitstellungsfreundlichkeit und Kennzeichnungseffizienz. zu guter Letzt

Die Registrierung von Punktwolken ist für die 3D-Vision unumgänglich! Verstehen Sie alle gängigen Lösungen und Herausforderungen in einem Artikel

Apr 02, 2024 am 11:31 AM

Die Registrierung von Punktwolken ist für die 3D-Vision unumgänglich! Verstehen Sie alle gängigen Lösungen und Herausforderungen in einem Artikel

Apr 02, 2024 am 11:31 AM

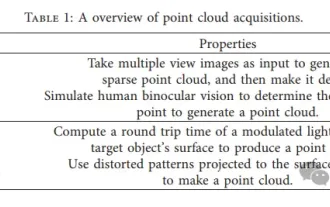

Es wird erwartet, dass die Punktwolke als Sammlung von Punkten eine Veränderung bei der Erfassung und Generierung dreidimensionaler (3D) Oberflächeninformationen von Objekten durch 3D-Rekonstruktion, industrielle Inspektion und Roboterbetrieb bewirken wird. Der anspruchsvollste, aber wesentlichste Prozess ist die Punktwolkenregistrierung, d. h. das Erhalten einer räumlichen Transformation, die zwei in zwei verschiedenen Koordinaten erhaltene Punktwolken ausrichtet und abgleicht. In dieser Rezension werden ein Überblick und die Grundprinzipien der Punktwolkenregistrierung vorgestellt, verschiedene Methoden systematisch klassifiziert und verglichen und die technischen Probleme bei der Punktwolkenregistrierung gelöst. Dabei wird versucht, akademischen Forschern außerhalb des Fachgebiets und Ingenieuren Orientierung zu geben und Diskussionen über eine einheitliche Vision zu erleichtern zur Punktwolkenregistrierung. Die allgemeine Methode zur Punktwolkenerfassung ist in aktive und passive Methoden unterteilt. Die vom Sensor aktiv erfasste Punktwolke ist die aktive Methode, und die Punktwolke wird später rekonstruiert.

Sie können spielen, indem Sie einfach Ihren Mund bewegen! Benutze KI, um Charaktere zu wechseln und Feinde anzugreifen: „Ayaka, benutze Kamiri-ryu Frost Destruction.'

May 13, 2023 pm 07:52 PM

Sie können spielen, indem Sie einfach Ihren Mund bewegen! Benutze KI, um Charaktere zu wechseln und Feinde anzugreifen: „Ayaka, benutze Kamiri-ryu Frost Destruction.'

May 13, 2023 pm 07:52 PM

Wenn es um heimische Spiele geht, die in den letzten zwei Jahren auf der ganzen Welt populär geworden sind, hat Genshin Impact definitiv die Nase vorn. Laut der im Mai veröffentlichten Umsatzumfrage für Mobilspiele im ersten Quartal dieses Jahres belegte „Genshin Impact“ mit einem absoluten Vorsprung von 567 Millionen US-Dollar den ersten Platz In nur 18 Jahren war das Unternehmen online. Der Gesamtumsatz allein mit der mobilen Plattform überstieg 3 Milliarden US-Dollar (ca. 13 Milliarden RM). Nun ist die letzte Inselversion 2.8 vor der Eröffnung von Xumi längst überfällig. Nach einer langen Entwurfszeit gibt es endlich neue Handlungsstränge und Gebiete zum Spielen. Aber ich weiß nicht, wie viele „Leberkaiser“ es gibt. Jetzt, wo die Insel vollständig erkundet ist, beginnt wieder Gras zu wachsen. Es gibt insgesamt 182 Schatztruhen + 1 Mora-Box (nicht im Lieferumfang enthalten). Es besteht kein Grund zur Sorge, dass es im Genshin Impact-Bereich nie an Arbeit mangelt. Nein, während des hohen Grases

AAAI2024: Far3D – Innovative Idee zur direkten visuellen 3D-Zielerkennung von 150 m

Dec 15, 2023 pm 01:54 PM

AAAI2024: Far3D – Innovative Idee zur direkten visuellen 3D-Zielerkennung von 150 m

Dec 15, 2023 pm 01:54 PM

Kürzlich habe ich auf Arxiv eine aktuelle Studie zur reinen visuellen Umgebungswahrnehmung gelesen. Diese Forschung basiert auf der PETR-Methodenreihe und konzentriert sich auf die Lösung des rein visuellen Wahrnehmungsproblems der Zielerkennung über große Entfernungen, wobei der Wahrnehmungsbereich auf 150 Meter erweitert wird. Die Methoden und Ergebnisse dieses Papiers haben für uns einen großen Referenzwert, daher habe ich versucht, es zu interpretieren. Originaltitel: Far3D: Expanding the Horizon for Surround-view3DObject Detection. Papierlink: https://arxiv.org/abs/2308.09616 Autorenzugehörigkeit :Beijing Institute of Technology & Megvii Technology Aufgabenhintergrund 3D-Objekterkennung zum Verständnis des autonomen Fahrens

LeCun war zutiefst enttäuscht über den Betrug mit selbstfahrenden Einhörnern

Oct 06, 2023 pm 02:33 PM

LeCun war zutiefst enttäuscht über den Betrug mit selbstfahrenden Einhörnern

Oct 06, 2023 pm 02:33 PM

Glauben Sie, dass dies ein gewöhnliches Selbstfahrvideo ist? Der Inhalt des Bildes muss ins Chinesische umgeschrieben werden, und kein Rahmen ist „echt“, ohne die ursprüngliche Bedeutung zu ändern. Es können Bilder unterschiedlicher Straßenverhältnisse, verschiedener Wetterbedingungen und mehr als 20 Situationen simuliert werden, und der Effekt ist genau wie im Original. Das Bilderweltmodell hat wieder tolle Arbeit geleistet! LeCun hat dies begeistert retweetet, nachdem er es gesehen hat. Das Bild basiert auf dem oben genannten Effekt, der durch die neueste Version von GAIA-1 erzielt wird. Durch 4700 Stunden Fahrvideotraining wurde der Effekt der Videoeingabe erreicht. Text oder Operationen zur Generierung von Videos zum autonomen Fahren Der unmittelbarste Vorteil besteht darin, dass zukünftige Ereignisse besser vorhergesagt werden können und mehr als 20 Szenarien simuliert werden können, wodurch die Sicherheit des autonomen Fahrens weiter verbessert und die Kosten gesenkt werden.