Probleme beim Belohnungsdesign beim verstärkenden Lernen

Belohnungsdesignprobleme beim Reinforcement Learning erfordern spezifische Codebeispiele

Reinforcement Learning ist eine maschinelle Lernmethode, deren Ziel darin besteht, zu lernen, wie man Maßnahmen ergreift, die kumulative Belohnungen durch Interaktion mit der Umgebung maximieren. Beim verstärkenden Lernen spielt die Belohnung eine entscheidende Rolle. Sie ist ein Signal im Lernprozess des Agenten und wird zur Steuerung seines Verhaltens verwendet. Das Belohnungsdesign ist jedoch ein herausforderndes Problem, und ein angemessenes Belohnungsdesign kann die Leistung von Verstärkungslernalgorithmen stark beeinflussen.

Beim verstärkenden Lernen können Belohnungen als Kommunikationsbrücke zwischen dem Agenten und der Umgebung betrachtet werden, die dem Agenten mitteilen kann, wie gut oder schlecht die aktuelle Aktion ist. Im Allgemeinen können Belohnungen in zwei Arten unterteilt werden: spärliche Belohnungen und dichte Belohnungen. Spärliche Belohnungen beziehen sich auf Belohnungen, die nur zu wenigen bestimmten Zeitpunkten in der Aufgabe gegeben werden, während dichte Belohnungen zu jedem Zeitpunkt Belohnungssignale haben. Dichte Belohnungen erleichtern dem Agenten das Erlernen der richtigen Handlungsstrategie als spärliche Belohnungen, da sie mehr Feedbackinformationen liefern. Bei realen Aufgaben kommen jedoch spärliche Belohnungen häufiger vor, was das Belohnungsdesign vor Herausforderungen stellt.

Das Ziel des Belohnungsdesigns besteht darin, dem Agenten ein möglichst genaues Feedbacksignal zu liefern, damit er schnell und effektiv die beste Strategie erlernen kann. In den meisten Fällen wollen wir eine Belohnungsfunktion, die eine hohe Belohnung gibt, wenn der Agent ein vorgegebenes Ziel erreicht, und eine niedrige Belohnung oder Strafe, wenn der Agent eine falsche Entscheidung trifft. Allerdings ist es keine leichte Aufgabe, eine angemessene Belohnungsfunktion zu entwerfen.

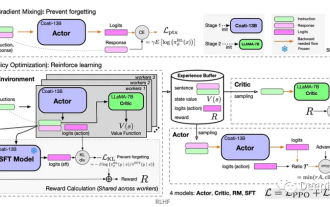

Um das Problem des Belohnungsdesigns zu lösen, besteht ein gängiger Ansatz darin, Demonstrationen auf der Grundlage menschlicher Experten zu verwenden, um das Lernen von Agenten zu steuern. In diesem Fall stellt der menschliche Experte dem Agenten eine Reihe von Beispielaktionssequenzen und deren Belohnungen zur Verfügung. Der Agent lernt aus diesen Beispielen, sich mit der Aufgabe vertraut zu machen und seine Strategie in nachfolgenden Interaktionen schrittweise zu verbessern. Diese Methode kann das Problem des Belohnungsdesigns effektiv lösen, erhöht jedoch auch die Arbeitskosten und die Stichprobe des Experten ist möglicherweise nicht vollständig korrekt.

Ein anderer Ansatz besteht darin, inverses Verstärkungslernen (Inverse Reinforcement Learning) zu verwenden, um das Problem des Belohnungsdesigns zu lösen. Inverses Verstärkungslernen ist eine Methode zur Ableitung einer Belohnungsfunktion aus beobachtetem Verhalten. Es geht davon aus, dass der Agent versucht, eine potenzielle Belohnungsfunktion während des Lernprozesses zu maximieren genaue Belohnungssignale. Die Kernidee des inversen Verstärkungslernens besteht darin, das beobachtete Verhalten als optimale Strategie zu interpretieren und das Lernen des Agenten durch Ableitung der dieser optimalen Strategie entsprechenden Belohnungsfunktion zu leiten.

Das Folgende ist ein einfaches Codebeispiel für inverses Verstärkungslernen, das zeigt, wie man aus dem beobachteten Verhalten auf die Belohnungsfunktion schließen kann:

import numpy as np

def inverse_reinforcement_learning(expert_trajectories):

# 计算状态特征向量的均值

feature_mean = np.mean(expert_trajectories, axis=0)

# 构建状态特征矩阵

feature_matrix = np.zeros((len(expert_trajectories), len(feature_mean)))

for i in range(len(expert_trajectories)):

feature_matrix[i] = expert_trajectories[i] - feature_mean

# 使用最小二乘法求解奖励函数的权重向量

weights = np.linalg.lstsq(feature_matrix, np.ones((len(expert_trajectories),)))[0]

return weights

# 生成示例轨迹数据

expert_trajectories = np.array([[1, 1], [1, 2], [2, 1], [2, 2]])

# 使用逆强化学习得到奖励函数的权重向量

weights = inverse_reinforcement_learning(expert_trajectories)

print("奖励函数的权重向量:", weights)Der obige Code verwendet die Methode der kleinsten Quadrate, um den Gewichtsvektor der Belohnungsfunktion zu lösen kann zur Berechnung der Belohnung eines beliebigen Zustandsmerkmalsvektors verwendet werden. Durch inverses Verstärkungslernen kann aus Beispieldaten eine angemessene Belohnungsfunktion gelernt werden, um den Lernprozess des Agenten zu steuern.

Zusammenfassend lässt sich sagen, dass die Gestaltung von Belohnungen ein wichtiges und herausforderndes Thema beim verstärkenden Lernen ist. Ein angemessenes Belohnungsdesign kann die Leistung von Reinforcement-Learning-Algorithmen stark beeinflussen. Durch den Einsatz von Methoden wie Demonstrationen durch menschliche Experten oder inverses Verstärkungslernen kann das Problem der Belohnungsgestaltung gelöst werden und dem Agenten genaue Belohnungssignale zur Verfügung gestellt werden, um seinen Lernprozess zu steuern.

Das obige ist der detaillierte Inhalt vonProbleme beim Belohnungsdesign beim verstärkenden Lernen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Probleme beim Design von Belohnungsfunktionen beim verstärkenden Lernen

Oct 09, 2023 am 11:58 AM

Probleme beim Design von Belohnungsfunktionen beim verstärkenden Lernen

Oct 09, 2023 am 11:58 AM

Probleme beim Design von Belohnungsfunktionen beim Reinforcement Learning Einführung Reinforcement Learning ist eine Methode, die optimale Strategien durch die Interaktion zwischen einem Agenten und der Umgebung lernt. Beim verstärkenden Lernen ist die Gestaltung der Belohnungsfunktion entscheidend für den Lerneffekt des Agenten. In diesem Artikel werden Probleme beim Design von Belohnungsfunktionen beim Reinforcement Learning untersucht und spezifische Codebeispiele bereitgestellt. Die Rolle der Belohnungsfunktion und der Zielbelohnungsfunktion sind ein wichtiger Teil des Verstärkungslernens und werden zur Bewertung des Belohnungswerts verwendet, den der Agent in einem bestimmten Zustand erhält. Sein Design hilft dem Agenten dabei, die langfristige Ermüdung durch die Auswahl optimaler Maßnahmen zu maximieren.

Tiefgreifendes Q-Learning-Verstärkungslernen mit der Roboterarmsimulation von Panda-Gym

Oct 31, 2023 pm 05:57 PM

Tiefgreifendes Q-Learning-Verstärkungslernen mit der Roboterarmsimulation von Panda-Gym

Oct 31, 2023 pm 05:57 PM

Reinforcement Learning (RL) ist eine Methode des maschinellen Lernens, die es einem Agenten ermöglicht, durch Versuch und Irrtum zu lernen, wie er sich in seiner Umgebung verhält. Agenten werden dafür belohnt oder bestraft, dass sie Maßnahmen ergreifen, die zu den gewünschten Ergebnissen führen. Im Laufe der Zeit lernt der Agent, Maßnahmen zu ergreifen, die seine erwartete Belohnung maximieren. RL-Agenten werden normalerweise mithilfe eines Markov-Entscheidungsprozesses (MDP) trainiert, einem mathematischen Rahmen zur Modellierung sequentieller Entscheidungsprobleme. MDP besteht aus vier Teilen: Zustand: eine Reihe möglicher Zustände der Umgebung. Aktion: Eine Reihe von Aktionen, die ein Agent ausführen kann. Übergangsfunktion: Eine Funktion, die die Wahrscheinlichkeit des Übergangs in einen neuen Zustand anhand des aktuellen Zustands und der aktuellen Aktion vorhersagt. Belohnungsfunktion: Eine Funktion, die dem Agenten für jede Conversion eine Belohnung zuweist. Das Ziel des Agenten besteht darin, eine Richtlinienfunktion zu erlernen.

Deep-Reinforcement-Learning-Technologie in C++

Aug 21, 2023 pm 11:33 PM

Deep-Reinforcement-Learning-Technologie in C++

Aug 21, 2023 pm 11:33 PM

Die Deep-Reinforcement-Learning-Technologie ist ein Zweig der künstlichen Intelligenz, der viel Aufmerksamkeit erregt hat. Sie hat mehrere internationale Wettbewerbe gewonnen und wird auch häufig in persönlichen Assistenten, autonomem Fahren, Spielintelligenz und anderen Bereichen eingesetzt. Bei der Umsetzung von Deep Reinforcement Learning ist C++ als effiziente und hervorragende Programmiersprache besonders wichtig, wenn die Hardwareressourcen begrenzt sind. Deep Reinforcement Learning kombiniert, wie der Name schon sagt, Technologien aus den beiden Bereichen Deep Learning und Reinforcement Learning. Um es einfach zu verstehen: Deep Learning bezieht sich auf das Lernen von Funktionen aus Daten und das Treffen von Entscheidungen durch den Aufbau eines mehrschichtigen neuronalen Netzwerks.

Lösen Sie das Problem „Fehler: Neudefinition der Klasse ‚Klassenname'', das im C++-Code auftritt

Aug 25, 2023 pm 06:01 PM

Lösen Sie das Problem „Fehler: Neudefinition der Klasse ‚Klassenname'', das im C++-Code auftritt

Aug 25, 2023 pm 06:01 PM

Lösen Sie das Problem „error:redefinitionofclass‘ClassName‘“ in C++-Code. Bei der C++-Programmierung treten häufig verschiedene Kompilierungsfehler auf. Einer der häufigsten Fehler ist „error:redefinitionofclass ‚ClassName‘“ (Neudefinitionsfehler der Klasse „ClassName“). Dieser Fehler tritt normalerweise auf, wenn dieselbe Klasse mehrmals definiert wird. Dieser Artikel wird

Probleme bei der Bewertung des Clustering-Effekts in Clustering-Algorithmen

Oct 10, 2023 pm 01:12 PM

Probleme bei der Bewertung des Clustering-Effekts in Clustering-Algorithmen

Oct 10, 2023 pm 01:12 PM

Das Problem der Clustering-Effektbewertung im Clustering-Algorithmus erfordert spezifische Codebeispiele. Clustering ist eine unbeaufsichtigte Lernmethode, die ähnliche Stichproben durch Clustering von Daten in eine Kategorie gruppiert. Bei Clustering-Algorithmen ist die Bewertung des Clustering-Effekts ein wichtiges Thema. In diesem Artikel werden mehrere häufig verwendete Indikatoren zur Bewertung des Clustering-Effekts vorgestellt und entsprechende Codebeispiele gegeben. 1. Clustering-Effekt-Bewertungsindex Silhouette-Koeffizient Der Silhouette-Koeffizient bewertet den Clustering-Effekt, indem er die Nähe der Stichprobe und den Grad der Trennung von anderen Clustern berechnet.

Erfahren Sie, wie Sie häufige iPhone-Probleme diagnostizieren

Dec 03, 2023 am 08:15 AM

Erfahren Sie, wie Sie häufige iPhone-Probleme diagnostizieren

Dec 03, 2023 am 08:15 AM

Das iPhone ist für seine leistungsstarke Leistung und seine vielseitigen Funktionen bekannt und ist nicht immun gegen gelegentliche Probleme oder technische Schwierigkeiten, ein häufiges Merkmal komplexer elektronischer Geräte. iPhone-Probleme können frustrierend sein, aber normalerweise ist kein Alarm erforderlich. In diesem umfassenden Leitfaden möchten wir einige der am häufigsten auftretenden Herausforderungen im Zusammenhang mit der iPhone-Nutzung entmystifizieren. Unser Schritt-für-Schritt-Ansatz soll Ihnen bei der Lösung dieser häufigen Probleme helfen und praktische Lösungen und Tipps zur Fehlerbehebung bieten, damit Ihre Geräte wieder einwandfrei funktionieren. Unabhängig davon, ob Sie mit einer Störung oder einem komplexeren Problem konfrontiert sind, kann Ihnen dieser Artikel dabei helfen, diese effektiv zu beheben. Allgemeine Tipps zur Fehlerbehebung Bevor wir uns mit den spezifischen Schritten zur Fehlerbehebung befassen, finden Sie hier einige hilfreiche Tipps

So lösen Sie das Problem, dass jQuery den Formularelementwert nicht abrufen kann

Feb 19, 2024 pm 02:01 PM

So lösen Sie das Problem, dass jQuery den Formularelementwert nicht abrufen kann

Feb 19, 2024 pm 02:01 PM

Um das Problem zu lösen, dass jQuery.val() nicht verwendet werden kann, sind spezifische Codebeispiele erforderlich. Für Front-End-Entwickler ist die Verwendung von jQuery eine der häufigsten Operationen. Unter diesen ist die Verwendung der .val()-Methode zum Abrufen oder Festlegen des Werts eines Formularelements eine sehr häufige Operation. In bestimmten Fällen kann jedoch das Problem auftreten, dass die Methode .val() nicht verwendet werden kann. In diesem Artikel werden einige gängige Situationen und Lösungen vorgestellt und spezifische Codebeispiele bereitgestellt. Problembeschreibung: Wenn Sie jQuery zum Entwickeln von Front-End-Seiten verwenden, treten manchmal Probleme auf

Beheben Sie den PHP-Fehler: Probleme beim Erben der übergeordneten Klasse

Aug 17, 2023 pm 01:33 PM

Beheben Sie den PHP-Fehler: Probleme beim Erben der übergeordneten Klasse

Aug 17, 2023 pm 01:33 PM

Beheben von PHP-Fehlern: Probleme bei der Vererbung übergeordneter Klassen In PHP ist die Vererbung ein wichtiges Merkmal der objektorientierten Programmierung. Durch Vererbung können wir vorhandenen Code wiederverwenden und ihn erweitern und verbessern, ohne den ursprünglichen Code zu ändern. Obwohl Vererbung in der Entwicklung weit verbreitet ist, können beim Erben von einer übergeordneten Klasse manchmal Fehler auftreten. Dieser Artikel konzentriert sich auf die Lösung häufiger Probleme, die beim Erben von einer übergeordneten Klasse auftreten, und stellt entsprechende Codebeispiele bereit. Frage 1: Die übergeordnete Klasse wird beim Erben der übergeordneten Klasse nicht gefunden, wenn dies nicht der Fall ist