Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Probleme der Inferenzeffizienz von Modellen für maschinelles Lernen

Probleme der Inferenzeffizienz von Modellen für maschinelles Lernen

Probleme der Inferenzeffizienz von Modellen für maschinelles Lernen

Das Problem der Inferenzeffizienz von Modellen für maschinelles Lernen erfordert spezifische Codebeispiele

Einführung

Mit der Entwicklung und weit verbreiteten Anwendung des maschinellen Lernens schenken die Menschen dem Modelltraining immer mehr Aufmerksamkeit. Für viele Echtzeitanwendungen ist jedoch auch die Inferenzeffizienz des Modells entscheidend. In diesem Artikel wird die Inferenzeffizienz von Modellen für maschinelles Lernen erörtert und einige spezifische Codebeispiele aufgeführt.

1. Die Bedeutung der Inferenzeffizienz

Die Inferenzeffizienz eines Modells bezieht sich auf die Fähigkeit des Modells, angesichts der Eingabe schnell und genau eine Ausgabe bereitzustellen. In vielen realen Anwendungen, wie Echtzeit-Bildverarbeitung, Spracherkennung, autonomes Fahren usw., sind die Anforderungen an die Inferenzeffizienz sehr hoch. Denn diese Anwendungen müssen große Datenmengen in Echtzeit verarbeiten und zeitnah reagieren.

2. Faktoren, die die Inferenzeffizienz beeinflussen

- Modellarchitektur

Die Modellarchitektur ist einer der wichtigen Faktoren, die die Inferenzeffizienz beeinflussen. Bei einigen komplexen Modellen wie Deep Neural Network (DNN) usw. kann der Inferenzprozess lange dauern. Daher sollten wir beim Entwerfen von Modellen versuchen, leichte Modelle auszuwählen oder sie für bestimmte Aufgaben zu optimieren.

- Hardwaregeräte

Hardwaregeräte haben auch einen Einfluss auf die Inferenzeffizienz. Einige neue Hardwarebeschleuniger wie die Graphic Processing Unit (GPU) und die Tensor Processing Unit (TPU) bieten erhebliche Vorteile bei der Beschleunigung des Inferenzprozesses von Modellen. Die Auswahl des richtigen Hardwaregeräts kann die Inferenzgeschwindigkeit erheblich verbessern.

- Optimierungstechnologie

Optimierungstechnologie ist ein wirksames Mittel zur Verbesserung der Argumentationseffizienz. Beispielsweise kann die Modellkomprimierungstechnologie die Größe des Modells reduzieren und dadurch die Inferenzzeit verkürzen. Gleichzeitig kann die Quantisierungstechnologie Gleitkommamodelle in Festkommamodelle umwandeln und so die Inferenzgeschwindigkeit weiter verbessern.

3. Codebeispiele

Nachfolgend finden Sie zwei Codebeispiele, die zeigen, wie Optimierungstechniken zur Verbesserung der Inferenzeffizienz eingesetzt werden können.

Codebeispiel 1: Modellkomprimierung

import tensorflow as tf

from tensorflow.keras.applications import MobileNetV2

from tensorflow.keras.models import save_model

# 加载原始模型

model = MobileNetV2(weights='imagenet')

# 保存原始模型

save_model(model, 'original_model.h5')

# 模型压缩

compressed_model = tf.keras.models.load_model('original_model.h5')

compressed_model.save('compressed_model.h5', include_optimizer=False)Im obigen Code verwenden wir die Tensorflow-Bibliothek, um ein vorab trainiertes MobileNetV2-Modell zu laden und es als Originalmodell zu speichern. Verwenden Sie dann das Modell zur Komprimierung und speichern Sie das Modell als Datei „compressed_model.h5“. Durch Modellkomprimierung kann die Größe des Modells reduziert und dadurch die Inferenzgeschwindigkeit erhöht werden.

Codebeispiel 2: GPU-Beschleunigung verwenden

import tensorflow as tf

from tensorflow.keras.applications import MobileNetV2

# 设置GPU加速

physical_devices = tf.config.list_physical_devices('GPU')

tf.config.experimental.set_memory_growth(physical_devices[0], True)

# 加载模型

model = MobileNetV2(weights='imagenet')

# 进行推理

output = model.predict(input)Im obigen Code verwenden wir die Tensorflow-Bibliothek, um ein vorab trainiertes MobileNetV2-Modell zu laden und den Inferenzprozess des Modells auf GPU-Beschleunigung einzustellen. Durch die Nutzung der GPU-Beschleunigung kann die Inferenzgeschwindigkeit deutlich erhöht werden.

Fazit

In diesem Artikel wird die Inferenzeffizienz von Modellen für maschinelles Lernen erörtert und einige spezifische Codebeispiele aufgeführt. Die Inferenzeffizienz von Modellen für maschinelles Lernen ist für viele Echtzeitanwendungen sehr wichtig. Beim Entwurf von Modellen sollte die Inferenzeffizienz berücksichtigt und entsprechende Optimierungsmaßnahmen ergriffen werden. Wir hoffen, dass die Leser durch die Einführung dieses Artikels die Technologie zur Optimierung der Inferenzeffizienz besser verstehen und anwenden können.

Das obige ist der detaillierte Inhalt vonProbleme der Inferenzeffizienz von Modellen für maschinelles Lernen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1359

1359

52

52

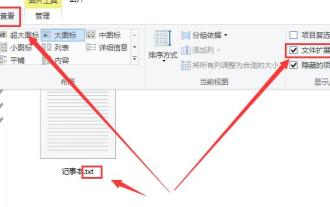

So ändern Sie die Dateierweiterung von Win10 Notepad

Jan 04, 2024 pm 12:49 PM

So ändern Sie die Dateierweiterung von Win10 Notepad

Jan 04, 2024 pm 12:49 PM

Wenn wir Notepad verwenden, müssen wir die Erweiterung von Notepad ändern, da wir uns mit verschiedenen Dingen befassen müssen. Wie ändern wir also die Erweiterung? Tatsächlich müssen wir nur die Umbenennungsfunktion verwenden, um die Erweiterung zu ändern. So ändern Sie die Erweiterung von Win10 Notepad: 1. Klicken Sie im Ordner zunächst oben auf und überprüfen Sie ihn. 2. Auf diese Weise wird die Dateierweiterung angezeigt. Klicken Sie dann mit der rechten Maustaste auf Ihren Notizblock und wählen Sie 3. Wählen Sie Folgendes aus. 4. Bei Änderung in das JPEG-Format. Dann erscheint eine Eingabeaufforderung, klicken Sie darauf. 5. Die Änderung ist abgeschlossen und das war's.

Rufen Sie den SQL-Trigger auf, um ein externes Programm auszuführen

Feb 18, 2024 am 10:25 AM

Rufen Sie den SQL-Trigger auf, um ein externes Programm auszuführen

Feb 18, 2024 am 10:25 AM

Titel: Spezifische Codebeispiele für SQL-Trigger zum Aufruf externer Programme. Text: Bei der Verwendung von SQL-Triggern ist es manchmal erforderlich, externe Programme aufzurufen, um bestimmte Vorgänge zu verarbeiten. In diesem Artikel wird erläutert, wie externe Programme in SQL-Triggern aufgerufen werden, und es werden spezifische Codebeispiele gegeben. 1. Erstellen Sie einen Trigger. Zuerst müssen wir einen Trigger erstellen, um auf ein Ereignis in der Datenbank zu warten. Hier nehmen wir die „Bestelltabelle (order_table)“ als Beispiel. Wenn eine neue Bestellung eingefügt wird, wird der Trigger aktiviert und dann das externe Programm aufgerufen, um eine Operation auszuführen.

So konvertieren Sie HTML in das MP4-Format

Feb 19, 2024 pm 02:48 PM

So konvertieren Sie HTML in das MP4-Format

Feb 19, 2024 pm 02:48 PM

Titel: So konvertieren Sie HTML in das MP4-Format: Detailliertes Codebeispiel Im täglichen Webproduktionsprozess müssen wir häufig HTML-Seiten oder bestimmte HTML-Elemente in MP4-Videos konvertieren. Speichern Sie beispielsweise Animationseffekte, Diashows oder andere dynamische Elemente als Videodateien. In diesem Artikel wird erläutert, wie Sie HTML5 und JavaScript zum Konvertieren von HTML in das MP4-Format verwenden, und es werden spezifische Codebeispiele bereitgestellt. HTML5-Video-Tag und CanvasAPI HTML5-Einführung

So extrahieren Sie Dump-Dateien

Feb 19, 2024 pm 12:15 PM

So extrahieren Sie Dump-Dateien

Feb 19, 2024 pm 12:15 PM

So greifen Sie auf Dump-Dateien zu: In einem Computersystem ist eine Dump-Datei eine Datei, die den Betriebsstatus und die Daten des Systems aufzeichnet. Bei der Softwareentwicklung und Systemfehlerbehebung kann das Abrufen von Dump-Dateien Programmentwicklern und Systemadministratoren dabei helfen, verschiedene Probleme wie Programmabstürze, Speicherverluste und Systemanomalien zu analysieren und zu diagnostizieren. In diesem Artikel werden einige gängige Methoden und Tools zum Abrufen von Dump-Dateien vorgestellt. 1. So greifen Sie mit dem Task-Manager auf Dump-Dateien unter Windows zu: Im Windows-Betriebssystem

Veröffentlichungsdatum von Windows 12

Jan 05, 2024 pm 05:24 PM

Veröffentlichungsdatum von Windows 12

Jan 05, 2024 pm 05:24 PM

Win11 wurde bereits offiziell veröffentlicht, und viele Benutzer haben bereits begonnen, Win12 zu nutzen. Sie möchten wissen, wann Win12 veröffentlicht wird. Den Regeln zufolge wird es etwa im Jahr 2024 veröffentlicht. Wann wird Win12 veröffentlicht? A: Win12 wird voraussichtlich im Herbst 2024 veröffentlicht. 1. Den neuesten aktuellen Informationen von Microsoft zufolge wird win12 voraussichtlich im Herbst 2024 veröffentlicht. 2. Und dieses Mal wird Win12 mehrere neue Designkonzepte haben und es wird weitere Verbesserungen in Bezug auf Ordnung und visuelles Erscheinungsbild geben. 3. Beim letzten Entwicklertreffen gaben Microsoft-Entwickler bekannt, dass sie eine schwebende Taskleiste erstellen werden, um der Taskleiste ein schwebendes Gefühl zu verleihen.

Welche Rolle spielt das NVIDIA Control Panel?

Feb 19, 2024 pm 03:59 PM

Welche Rolle spielt das NVIDIA Control Panel?

Feb 19, 2024 pm 03:59 PM

Was ist das NVIDIA Control Panel? Mit der rasanten Entwicklung der Computertechnologie ist die Bedeutung von Grafikkarten immer wichtiger geworden. Als einer der weltweit führenden Grafikkartenhersteller hat das Bedienfeld von NVIDIA noch mehr Aufmerksamkeit auf sich gezogen. Was genau macht das NVIDIA-Kontrollfeld? In diesem Artikel erhalten Sie eine detaillierte Einführung in die Funktionen und Verwendungsmöglichkeiten des NVIDIA-Kontrollfelds. Lassen Sie uns zunächst das Konzept und die Definition des NVIDIA-Bedienfelds verstehen. Das NVIDIA Control Panel ist eine Software zur Verwaltung und Konfiguration von Grafikkarteneinstellungen.

Die Rolle der Vollbreite und Halbbreite in der chinesischen Eingabemethode

Mar 25, 2024 am 09:57 AM

Die Rolle der Vollbreite und Halbbreite in der chinesischen Eingabemethode

Mar 25, 2024 am 09:57 AM

Volle Breite und halbe Breite sind gängige Konzepte in chinesischen Eingabemethoden und repräsentieren unterschiedliche Zeichenbreiten. Im Computerbereich werden die Konzepte „Vollbreite“ und „Halbbreite“ hauptsächlich verwendet, um die Größe des Platzes zu beschreiben, den chinesische Schriftzeichen und englische Buchstaben auf dem Bildschirm oder in gedruckter Form einnehmen. Erstens haben die Voll- und Halbbreiten ihren Ursprung ursprünglich in der Ära der Schreibmaschinen. Auf Schreibmaschinen werden chinesische Zeichen normalerweise in voller Breite angezeigt, während englische Zeichen in halber Breite angezeigt werden. Dies liegt daran, dass chinesische Schriftzeichen relativ breit sind und die Verwendung der vollen Breite dazu führen kann, dass der gesamte Artikel schöner und das Layout kompakter aussieht. Die englischen Zeichen sind

So öffnen Sie PSD-Dateien auf einem Mobiltelefon

Feb 21, 2024 pm 05:48 PM

So öffnen Sie PSD-Dateien auf einem Mobiltelefon

Feb 21, 2024 pm 05:48 PM

PSD-Dateien für Mobiltelefone werden mit der Photoshop-Software geöffnet. PSD ist das proprietäre Dateiformat von Photoshop und kann Informationen wie Ebenen, Kanäle, Pfade und Transparenz beibehalten. Wenn Sie daher eine PSD-Datei für ein Mobiltelefon öffnen möchten, stellen Sie zunächst sicher, dass Sie die Photoshop-Software installiert haben. Öffnen Sie zunächst die Photoshop-Software, klicken Sie dann in der Menüleiste auf die Option „Datei“ und wählen Sie im Popup-Dropdown-Menü „Öffnen“. Als Nächstes müssen Sie Ihre Ordner durchsuchen, um das Telefon zu finden, auf dem Sie gespeichert haben