Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Problem mit dem Verlust der Bildqualität bei der Bildentprellungstechnologie

Problem mit dem Verlust der Bildqualität bei der Bildentprellungstechnologie

Problem mit dem Verlust der Bildqualität bei der Bildentprellungstechnologie

Problem mit dem Verlust der Bildqualität in der Bildentprellungstechnologie. Es sind spezifische Codebeispiele erforderlich.

Zusammenfassung: Die Bildentprellungstechnologie ist eine Methode zur Reduzierung von Rauschen und Jitter in Bildern. Dies kann jedoch während des Bildentprellungsprozesses möglich sein ein Verlust an Bildqualität. In diesem Artikel wird das Problem des Bildqualitätsverlusts bei der Bildentprellungstechnologie untersucht und spezifische Codebeispiele bereitgestellt.

1. Einführung

Mit der Beliebtheit von Digitalkameras und Smartphones können Menschen zunehmend problemlos qualitativ hochwertige Fotos aufnehmen. Aufgrund von Faktoren wie Handzittern oder Kamerabewegungen während der Aufnahme können jedoch Verwacklungen und Rauschen auf den Fotos auftreten. Um die Bildqualität zu verbessern, haben Forscher verschiedene Techniken zur Bildentprellung entwickelt.

2. Überblick über die Bildentwackelungstechnologie

Die Bildentwackelungstechnologie verbessert hauptsächlich die Bildqualität, indem sie Jitter und Rauschen in Bildern beseitigt oder reduziert. Zu den gängigen Techniken zur Bildentprellung gehören filterbasierte Methoden, entzerrungsbasierte Methoden und sensorbasierte Methoden.

3. Analyse des Bildqualitätsverlustproblems

Obwohl die Bildentwackelungstechnologie Jitter und Rauschen effektiv reduzieren kann, kann es während des Verarbeitungsprozesses zu einem Verlust der Bildqualität kommen. Zu den Hauptgründen gehören die folgenden Aspekte:

- Informationsverlust: Während des Prozesses zur Beseitigung von Jitter und Rauschen können einige Detailinformationen des Bildes unscharf werden oder verloren gehen, was zu einer Verschlechterung der Bildqualität führt.

- Farbverzerrung: Einige Bildentprellungstechnologien verändern die Farbverteilung des Bildes, was zu Bildfarbverzerrungen führt und visuelle Effekte beeinträchtigt.

- Einführung von Artefakten: Einige Bildentprellungstechniken können zu Artefakten führen, das heißt, dass einige Bereiche mit inkonsistenten hellen und dunklen oder unklaren Umrissen im Bild erscheinen.

4. Lösung für das Problem des Bildqualitätsverlusts

Um das Problem des Bildqualitätsverlusts in der Bildentprellungstechnologie zu lösen, können wir die folgenden Methoden anwenden:

- Parameteranpassung: Gemäß dem spezifischen Bildentprellungsalgorithmus, Passen Sie die Parameter des Algorithmus angemessen an, um den Entprellungseffekt und die Bildqualität in Einklang zu bringen. Beispielsweise können bei filterbasierten Entprellalgorithmen die Größe und Stärke des Filters angepasst werden, um bessere Ergebnisse zu erzielen.

- Multiskalenverarbeitung: Teilen Sie das Bild in mehrere Skalen auf und führen Sie für jede Skala eine unterschiedliche Entprellungsverarbeitung durch. Anschließend wird von Fall zu Fall eine Fusion durchgeführt, um die Detailinformationen und die Gesamtqualität des Bildes beizubehalten.

- Einführung von Vorabinformationen: Die Verwendung der Vorabinformationen des Bildes, wie z. B. die Struktur- und Textureigenschaften des Bildes, trägt dazu bei, den Verlust der Bildqualität zu reduzieren. Der Entprellvorgang kann durch die Einführung vorheriger Informationen gesteuert werden, um die Details und die Klarheit des Bildes beizubehalten.

5. Spezifische Codebeispiele

Das Folgende ist ein einfaches Beispiel, das die Verwendung der OpenCV-Bibliothek zur Implementierung einer filterbasierten Entprellungstechnologie in einer Python-Umgebung und zur Reduzierung des Bildqualitätsverlusts durch Parameteranpassung und Mehrfachskalierung demonstriert Verarbeitung:

import cv2

def image_denoising(image, filter_size, filter_strength):

# 使用均值滤波器进行去抖,参数为滤波器尺寸和强度

denoised_image = cv2.blur(image, (filter_size, filter_size))

return denoised_image

# 加载原始图像

image = cv2.imread('input.jpg')

# 调整参数进行去抖处理

denoised_image = image_denoising(image, 5, 10)

# 显示原始图像和处理后的图像

cv2.imshow('Original Image', image)

cv2.imshow('Denoised Image', denoised_image)

cv2.waitKey(0)

cv2.destroyAllWindows()Im obigen Code kann der image_denoising函数使用了均值滤波器进行去抖处理。通过调整filter_size和filter_strengthParameter eine ausgewogene Kontrolle über den Bildentprellungseffekt und die Bildqualität erreichen.

6. Fazit

Die Image-Debounce-Technologie spielt eine wichtige Rolle bei der Verbesserung der Bildqualität. Bei der Verwendung der Bildentprellungstechnologie müssen wir jedoch auch auf das Problem des Bildqualitätsverlusts achten. Durch die richtige Anpassung der Algorithmusparameter, den Einsatz von Methoden wie der Multiskalenverarbeitung und der Einführung vorheriger Informationen kann der Verlust der Bildqualität reduziert und bessere Entprelleffekte erzielt werden.

Referenzen:

[1] Zhang, L., Zhang, L., & Du, R. (2003): Methoden, Implementierungen und Anwendungen.

[2] Buades, A., Coll. B., & Morel, J. M. (2005). Ein nicht-lokaler Algorithmus zur Bildentrauschung.

[3] Tomasi, C., & Manduchi, R. (1998) Bilaterale Filterung für Grau- und Farbbilder (S. 839-846).

Das obige ist der detaillierte Inhalt vonProblem mit dem Verlust der Bildqualität bei der Bildentprellungstechnologie. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1374

1374

52

52

Das Stable Diffusion 3-Papier wird endlich veröffentlicht und die architektonischen Details werden enthüllt. Wird es helfen, Sora zu reproduzieren?

Mar 06, 2024 pm 05:34 PM

Das Stable Diffusion 3-Papier wird endlich veröffentlicht und die architektonischen Details werden enthüllt. Wird es helfen, Sora zu reproduzieren?

Mar 06, 2024 pm 05:34 PM

Der Artikel von StableDiffusion3 ist endlich da! Dieses Modell wurde vor zwei Wochen veröffentlicht und verwendet die gleiche DiT-Architektur (DiffusionTransformer) wie Sora. Nach seiner Veröffentlichung sorgte es für großes Aufsehen. Im Vergleich zur Vorgängerversion wurde die Qualität der von StableDiffusion3 generierten Bilder erheblich verbessert. Es unterstützt jetzt Eingabeaufforderungen mit mehreren Themen, und der Textschreibeffekt wurde ebenfalls verbessert, und es werden keine verstümmelten Zeichen mehr angezeigt. StabilityAI wies darauf hin, dass es sich bei StableDiffusion3 um eine Reihe von Modellen mit Parametergrößen von 800 M bis 8 B handelt. Durch diesen Parameterbereich kann das Modell direkt auf vielen tragbaren Geräten ausgeführt werden, wodurch der Einsatz von KI deutlich reduziert wird

Dieser Artikel reicht aus, um etwas über autonomes Fahren und Flugbahnvorhersage zu lesen!

Feb 28, 2024 pm 07:20 PM

Dieser Artikel reicht aus, um etwas über autonomes Fahren und Flugbahnvorhersage zu lesen!

Feb 28, 2024 pm 07:20 PM

Die Trajektorienvorhersage spielt eine wichtige Rolle beim autonomen Fahren. Unter autonomer Fahrtrajektorienvorhersage versteht man die Vorhersage der zukünftigen Fahrtrajektorie des Fahrzeugs durch die Analyse verschiedener Daten während des Fahrvorgangs. Als Kernmodul des autonomen Fahrens ist die Qualität der Trajektorienvorhersage von entscheidender Bedeutung für die nachgelagerte Planungssteuerung. Die Trajektorienvorhersageaufgabe verfügt über einen umfangreichen Technologie-Stack und erfordert Vertrautheit mit der dynamischen/statischen Wahrnehmung des autonomen Fahrens, hochpräzisen Karten, Fahrspurlinien, Fähigkeiten in der neuronalen Netzwerkarchitektur (CNN&GNN&Transformer) usw. Der Einstieg ist sehr schwierig! Viele Fans hoffen, so schnell wie möglich mit der Flugbahnvorhersage beginnen zu können und Fallstricke zu vermeiden. Heute werde ich eine Bestandsaufnahme einiger häufiger Probleme und einführender Lernmethoden für die Flugbahnvorhersage machen! Einführungsbezogenes Wissen 1. Sind die Vorschaupapiere in Ordnung? A: Schauen Sie sich zuerst die Umfrage an, S

DualBEV: BEVFormer und BEVDet4D deutlich übertreffen, öffnen Sie das Buch!

Mar 21, 2024 pm 05:21 PM

DualBEV: BEVFormer und BEVDet4D deutlich übertreffen, öffnen Sie das Buch!

Mar 21, 2024 pm 05:21 PM

In diesem Artikel wird das Problem der genauen Erkennung von Objekten aus verschiedenen Blickwinkeln (z. B. Perspektive und Vogelperspektive) beim autonomen Fahren untersucht, insbesondere wie die Transformation von Merkmalen aus der Perspektive (PV) in den Raum aus der Vogelperspektive (BEV) effektiv ist implementiert über das Modul Visual Transformation (VT). Bestehende Methoden lassen sich grob in zwei Strategien unterteilen: 2D-zu-3D- und 3D-zu-2D-Konvertierung. 2D-zu-3D-Methoden verbessern dichte 2D-Merkmale durch die Vorhersage von Tiefenwahrscheinlichkeiten, aber die inhärente Unsicherheit von Tiefenvorhersagen, insbesondere in entfernten Regionen, kann zu Ungenauigkeiten führen. Während 3D-zu-2D-Methoden normalerweise 3D-Abfragen verwenden, um 2D-Features abzutasten und die Aufmerksamkeitsgewichte der Korrespondenz zwischen 3D- und 2D-Features über einen Transformer zu lernen, erhöht sich die Rechen- und Bereitstellungszeit.

„Minecraft' verwandelt sich in eine KI-Stadt und NPC-Bewohner spielen Rollenspiele wie echte Menschen

Jan 02, 2024 pm 06:25 PM

„Minecraft' verwandelt sich in eine KI-Stadt und NPC-Bewohner spielen Rollenspiele wie echte Menschen

Jan 02, 2024 pm 06:25 PM

Bitte beachten Sie, dass dieser kantige Mann die Stirn runzelt und über die Identität der „ungebetenen Gäste“ vor ihm nachdenkt. Es stellte sich heraus, dass sie sich in einer gefährlichen Situation befand, und als ihr dies klar wurde, begann sie schnell mit der mentalen Suche nach einer Strategie zur Lösung des Problems. Letztendlich entschloss sie sich, vom Unfallort zu fliehen, dann so schnell wie möglich Hilfe zu suchen und sofort Maßnahmen zu ergreifen. Gleichzeitig dachte die Person auf der Gegenseite das Gleiche wie sie... In „Minecraft“ gab es eine solche Szene, in der alle Charaktere von künstlicher Intelligenz gesteuert wurden. Jeder von ihnen hat eine einzigartige Identität. Das zuvor erwähnte Mädchen ist beispielsweise eine 17-jährige, aber kluge und mutige Kurierin. Sie haben die Fähigkeit, sich zu erinnern und zu denken und in dieser kleinen Stadt in Minecraft wie Menschen zu leben. Was sie antreibt, ist ein brandneues,

So bearbeiten Sie Fotos auf dem iPhone mit iOS 17

Nov 30, 2023 pm 11:39 PM

So bearbeiten Sie Fotos auf dem iPhone mit iOS 17

Nov 30, 2023 pm 11:39 PM

Die mobile Fotografie hat die Art und Weise, wie wir die Momente des Lebens festhalten und teilen, grundlegend verändert. Das Aufkommen von Smartphones, insbesondere des iPhone, spielte bei diesem Wandel eine Schlüsselrolle. Das iPhone ist für seine fortschrittliche Kameratechnologie und benutzerfreundlichen Bearbeitungsfunktionen bekannt und zur ersten Wahl sowohl für Amateur- als auch für erfahrene Fotografen geworden. Die Einführung von iOS 17 markiert einen wichtigen Meilenstein auf diesem Weg. Das neueste Update von Apple bietet erweiterte Fotobearbeitungsfunktionen und gibt Benutzern ein leistungsfähigeres Toolkit an die Hand, mit dem sie ihre alltäglichen Schnappschüsse in visuell ansprechende und künstlerisch anspruchsvolle Bilder umwandeln können. Diese technologische Entwicklung vereinfacht nicht nur den Fotografieprozess, sondern eröffnet auch neue Möglichkeiten für den kreativen Ausdruck und ermöglicht es Benutzern, ihren Fotos mühelos eine professionelle Note zu verleihen

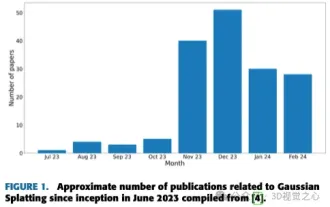

Mehr als nur 3D-Gauß! Aktueller Überblick über modernste 3D-Rekonstruktionstechniken

Jun 02, 2024 pm 06:57 PM

Mehr als nur 3D-Gauß! Aktueller Überblick über modernste 3D-Rekonstruktionstechniken

Jun 02, 2024 pm 06:57 PM

Oben geschrieben & Nach persönlichem Verständnis des Autors ist die bildbasierte 3D-Rekonstruktion eine anspruchsvolle Aufgabe, bei der aus einer Reihe von Eingabebildern auf die 3D-Form eines Objekts oder einer Szene geschlossen werden muss. Lernbasierte Methoden haben wegen ihrer Fähigkeit, 3D-Formen direkt abzuschätzen, Aufmerksamkeit erregt. Dieser Übersichtsartikel konzentriert sich auf modernste 3D-Rekonstruktionstechniken, einschließlich der Generierung neuartiger, unsichtbarer Ansichten. Es wird ein Überblick über die jüngsten Entwicklungen bei Gaußschen Splash-Methoden gegeben, einschließlich Eingabetypen, Modellstrukturen, Ausgabedarstellungen und Trainingsstrategien. Auch ungelöste Herausforderungen und zukünftige Ausrichtungen werden besprochen. Angesichts der rasanten Fortschritte auf diesem Gebiet und der zahlreichen Möglichkeiten zur Verbesserung der 3D-Rekonstruktionsmethoden scheint eine gründliche Untersuchung des Algorithmus von entscheidender Bedeutung zu sein. Daher bietet diese Studie einen umfassenden Überblick über die jüngsten Fortschritte in der Gaußschen Streuung. (Wischen Sie mit dem Daumen nach oben

Rezension! Tiefe Modellfusion (LLM/Basismodell/Verbundlernen/Feinabstimmung usw.)

Apr 18, 2024 pm 09:43 PM

Rezension! Tiefe Modellfusion (LLM/Basismodell/Verbundlernen/Feinabstimmung usw.)

Apr 18, 2024 pm 09:43 PM

Am 23. September wurde das Papier „DeepModelFusion:ASurvey“ von der National University of Defense Technology, JD.com und dem Beijing Institute of Technology veröffentlicht. Deep Model Fusion/Merging ist eine neue Technologie, die die Parameter oder Vorhersagen mehrerer Deep-Learning-Modelle in einem einzigen Modell kombiniert. Es kombiniert die Fähigkeiten verschiedener Modelle, um die Verzerrungen und Fehler einzelner Modelle zu kompensieren und so eine bessere Leistung zu erzielen. Die tiefe Modellfusion bei groß angelegten Deep-Learning-Modellen (wie LLM und Basismodellen) steht vor einigen Herausforderungen, darunter hohe Rechenkosten, hochdimensionaler Parameterraum, Interferenzen zwischen verschiedenen heterogenen Modellen usw. Dieser Artikel unterteilt bestehende Methoden zur Tiefenmodellfusion in vier Kategorien: (1) „Musterverbindung“, die Lösungen im Gewichtsraum über einen verlustreduzierenden Pfad verbindet, um eine bessere anfängliche Modellfusion zu erzielen

Revolutionäres GPT-4o: Neugestaltung des Mensch-Computer-Interaktionserlebnisses

Jun 07, 2024 pm 09:02 PM

Revolutionäres GPT-4o: Neugestaltung des Mensch-Computer-Interaktionserlebnisses

Jun 07, 2024 pm 09:02 PM

Das von OpenAI veröffentlichte GPT-4o-Modell ist zweifellos ein großer Durchbruch, insbesondere in Bezug auf seine Fähigkeit, mehrere Eingabemedien (Text, Audio, Bilder) zu verarbeiten und entsprechende Ausgaben zu generieren. Diese Fähigkeit macht die Mensch-Computer-Interaktion natürlicher und intuitiver und verbessert die Praktikabilität und Benutzerfreundlichkeit von KI erheblich. Zu den wichtigsten Highlights von GPT-4o gehören: hohe Skalierbarkeit, Multimedia-Ein- und -Ausgabe, weitere Verbesserungen der Fähigkeiten zum Verstehen natürlicher Sprache usw. 1. Medienübergreifende Eingabe/Ausgabe: GPT-4o+ kann jede beliebige Kombination aus Text, Audio und Bildern als Eingabe akzeptieren und direkt eine Ausgabe aus diesen Medien generieren. Dadurch wird die Beschränkung herkömmlicher KI-Modelle aufgehoben, die nur einen einzigen Eingabetyp verarbeiten, wodurch die Mensch-Computer-Interaktion flexibler und vielfältiger wird. Diese Innovation unterstützt intelligente Assistenten