Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Die menschenähnlichen Denkfähigkeiten von GPT-4 wurden erheblich verbessert! Die Chinesische Akademie der Wissenschaften schlug „denkende Kommunikation' vor. Analoges Denken geht über CoT hinaus und kann sofort angewendet werden

Die menschenähnlichen Denkfähigkeiten von GPT-4 wurden erheblich verbessert! Die Chinesische Akademie der Wissenschaften schlug „denkende Kommunikation' vor. Analoges Denken geht über CoT hinaus und kann sofort angewendet werden

Die menschenähnlichen Denkfähigkeiten von GPT-4 wurden erheblich verbessert! Die Chinesische Akademie der Wissenschaften schlug „denkende Kommunikation' vor. Analoges Denken geht über CoT hinaus und kann sofort angewendet werden

Heutzutage sind riesige neuronale Netzwerkmodelle wie GPT-4 und PaLM entstanden, die erstaunliche Lernfähigkeiten bei wenigen Stichproben gezeigt haben.

Durch einfache Eingabeaufforderungen können sie Textbegründungen durchführen, Geschichten schreiben, Fragen beantworten, programmieren ...

Forscher der Chinesischen Akademie der Wissenschaften und der Yale University haben ein neues Rahmenwerk mit dem Namen „Gedankenpropagation“ vorgeschlagen. zielt darauf ab, die Denkfähigkeit von LLM durch „analoges Denken“ zu verbessern Wenn wir auf ein neues Problem stoßen, vergleichen wir es oft mit ähnlichen Problemen, die wir bereits gelöst haben, um Strategien abzuleiten.

Der Schlüssel zu diesem Ansatz besteht also darin, „ähnliche“ Probleme im Zusammenhang mit der Eingabe zu untersuchen, bevor das Eingabeproblem gelöst wird.

Der Schlüssel zu diesem Ansatz besteht also darin, „ähnliche“ Probleme im Zusammenhang mit der Eingabe zu untersuchen, bevor das Eingabeproblem gelöst wird.

Schließlich können ihre Lösungen sofort verwendet werden oder um Erkenntnisse für eine nützliche Planung zu gewinnen.

Es ist absehbar, dass „Gedankenkommunikation“ neue Ideen für die inhärenten Grenzen der logischen Fähigkeiten von LLM vorschlägt und es großen Modellen ermöglicht, „Analogie“ zu verwenden, um Probleme wie Menschen zu lösen.

LLM-Mehrschritt-Denken, von Menschen besiegt

LLM ist offensichtlich gut im grundlegenden Denken auf der Grundlage von Eingabeaufforderungen, hat aber immer noch Schwierigkeiten, wenn es um komplexe mehrstufige Probleme wie Optimierung und Planung geht.

Andererseits greifen Menschen auf ihre Intuition aus ähnlichen Erfahrungen zurück, um neue Probleme zu lösen.

Die Unfähigkeit großer Modelle, dies zu erreichen, liegt an ihren inhärenten Einschränkungen

Denn das Wissen über LLM stammt vollständig aus den Mustern in den Trainingsdaten und kann die Sprache oder Konzepte nicht wirklich verstehen. Als statistische Modelle ist es daher schwierig, komplexe kombinatorische Verallgemeinerungen durchzuführen.

LLM mangelt es an systematischen Denkfähigkeiten und sie können nicht wie Menschen Schritt für Schritt argumentieren, um herausfordernde Probleme zu lösen, was das Wichtigste ist

Da außerdem die Argumentation großer Modelle parteiisch und kurzsichtig ist, Daher ist es für LLM schwierig, die beste Lösung zu finden, und es ist schwierig, die Konsistenz der Argumentation über einen langen Zeitraum aufrechtzuerhalten kann hauptsächlich auf zwei Kernfaktoren zurückgeführt werden:

Menschen sammeln aus der Praxis wiederverwendbares Wissen und Intuition an, die zur Lösung neuer Probleme beitragen. Im Gegensatz dazu geht LLM jedes Problem „von Grund auf“ an und greift nicht auf frühere Lösungen zurück.

Zusammengesetzte Fehler beim mehrstufigen Denken beziehen sich auf Fehler, die beim mehrstufigen Denken auftreten.

Menschen überwachen ihre eigenen Argumentationsketten und ändern die ersten Schritte bei Bedarf. Fehler, die LLM in den frühen Phasen der Argumentation macht, werden jedoch verstärkt, da sie spätere Überlegungen in die falsche Richtung führen. Die oben genannten Schwächen behindern LLM ernsthaft bei der Bewältigung komplexer Situationen, die eine globale Optimierung oder langfristige Planung erfordern .

Forscher haben eine völlig neue Lösung für dieses Problem vorgeschlagen, nämlich die Gedankenverbreitung

TP-FrameworkDurch analoges Denken kann LLM wie Menschen argumentieren

Bei Forschern scheint es, dass das Denken von Grund auf scheitert Erkenntnisse aus der Lösung ähnlicher Probleme wiederzuverwenden und kann zur Anhäufung von Fehlern in Zwischenphasen des Denkens führen.

Und „Thought Spread“ kann ähnliche Probleme im Zusammenhang mit dem Eingabeproblem untersuchen und sich von Lösungen für ähnliche Probleme inspirieren lassen.

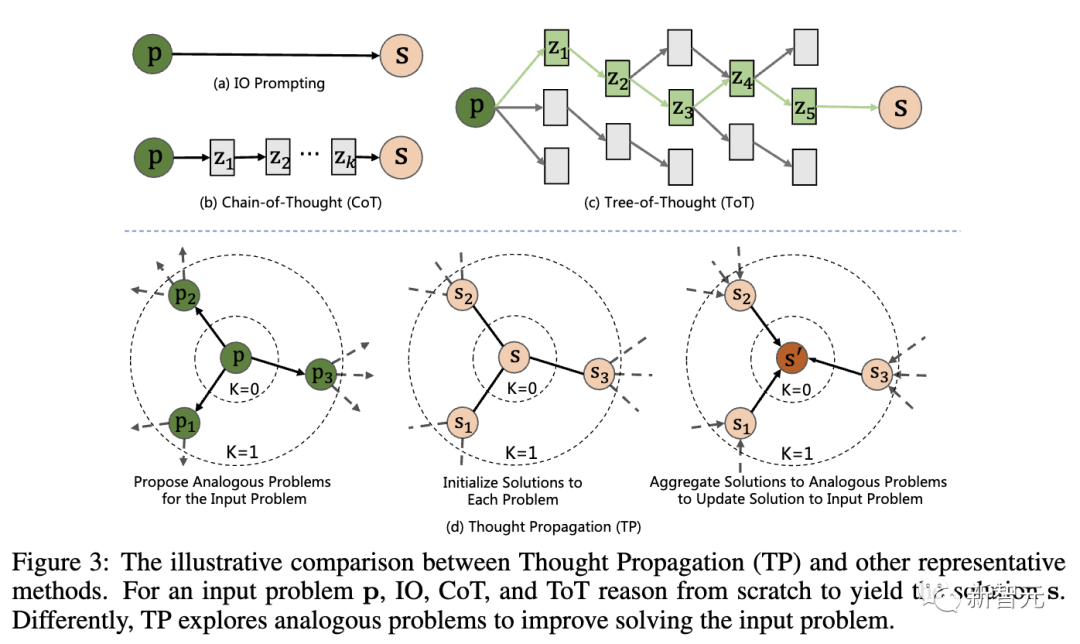

Die folgende Abbildung zeigt den Vergleich zwischen „Thought Propagation“ (TP) und anderen repräsentativen Technologien. Für das Eingabeproblem p müssen IO, CoT und ToT alle von Grund auf argumentieren, um zur Lösung s zu gelangen. Konkret umfasst TP drei Phasen:

LLM generiert eine Reihe ähnlicher Fragen durch Eingabeaufforderungen, die Ähnlichkeiten mit der Eingabefrage aufweisen. Dadurch wird das Modell angeleitet, potenziell relevante frühere Erfahrungen abzurufen.

2. Ähnliche Probleme lösen: Lassen Sie LLM jedes ähnliche Problem mithilfe vorhandener Eingabeaufforderungstechnologien wie CoT lösen.

3. Zusammenfassende Lösung: Es gibt zwei verschiedene Möglichkeiten – direkt eine neue Lösung für das Eingabeproblem auf der Grundlage der analogen Lösung abzuleiten; einen erweiterten Plan abzuleiten, indem die analoge Lösung mit dem Eingabeproblem oder der Strategie verglichen wird.

Auf diese Weise können große Modelle frühere Erfahrungen und Heuristiken nutzen und ihre anfänglichen Überlegungen können mit analogen Lösungen abgeglichen werden, um diese Lösungen weiter zu verfeinern Es ist erwähnenswert, dass „Denkpropagation“ nichts damit zu tun hat mit dem Modell und kann einen einzelnen Problemlösungsschritt basierend auf jeder Prompt-Methode durchführen LLM mehr wie ein Mensch machen, aber die tatsächlichen Ergebnisse müssen für sich selbst sprechen.

Forscher der Chinesischen Akademie der Wissenschaften und der Yale-Universität bewerteten drei Aufgaben:

– Begründung für den kürzesten Pfad:

Es muss der beste Pfad zwischen Knoten in einem Diagramm gefunden werden, was eine globale Planung und Suche erfordert. Selbst bei einfachen Diagrammen versagen Standardtechniken.

- Kreatives Schreiben:

Das Generieren kohärenter, kreativer Geschichten ist eine Herausforderung mit offenem Ausgang. Bei übergeordneten Gliederungsaufforderungen verliert LLM häufig an Konsistenz oder Logik.

- LLM-Agentenplanung: LLM-Agenten, die mit Textumgebungen interagieren, haben Schwierigkeiten mit langfristigen Strategien. Ihre Pläne „driften“ oft oder bleiben in Zyklen stecken.

? Ermöglichen Sie LLM, suboptimale Lösungen (b, c) zu finden oder sogar wiederholt den Zwischenknoten (d) zu besuchen Inferenzschritt Fehler häufen sich und ToT (b) löst das Problem in (a) nicht. Basierend auf Lösungen für ähnliche Probleme verfeinert TP (c) die anfängliche suboptimale Lösung und findet schließlich die optimale Lösung.Im Vergleich zum Ausgangswert wurde die Leistung von TP bei der Verarbeitung der Aufgabe „Kürzester Weg“ deutlich um 12 % verbessert, wodurch optimale und effektive kürzeste Wege generiert wurden.

Darüber hinaus kommt der generierte effektive Pfad (TP) aufgrund des niedrigsten Online-Rewriting-Werts (OLR) dem optimalen Pfad im Vergleich zur Basislinie am nächsten

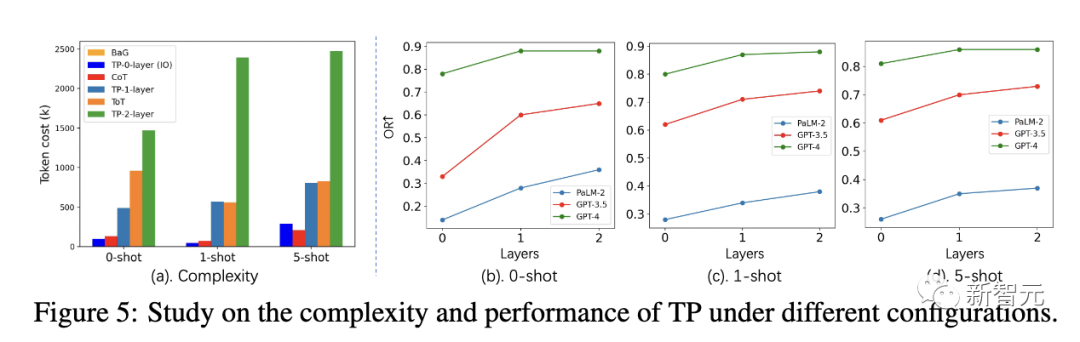

Darüber hinaus haben die Forscher auch durchgeführt Es wurden mehrere weitere Studien zur Komplexität und Leistung der Aufgabe „Kürzester Weg“ durchgeführt

Unter verschiedenen Einstellungen sind die Tokenkosten von Layer 1 TP ähnlich wie ToT. Layer 1 TP hat jedoch eine sehr wettbewerbsfähige Leistung bei der Suche nach dem optimalen kürzesten Pfad erzielt.

Darüber hinaus ist der Leistungsgewinn von Layer 1 TP im Vergleich zu Layer 0 TP (IO) ebenfalls sehr signifikant. Abbildung 5(a) zeigt den Anstieg der Tokenkosten für Layer-2-TP.

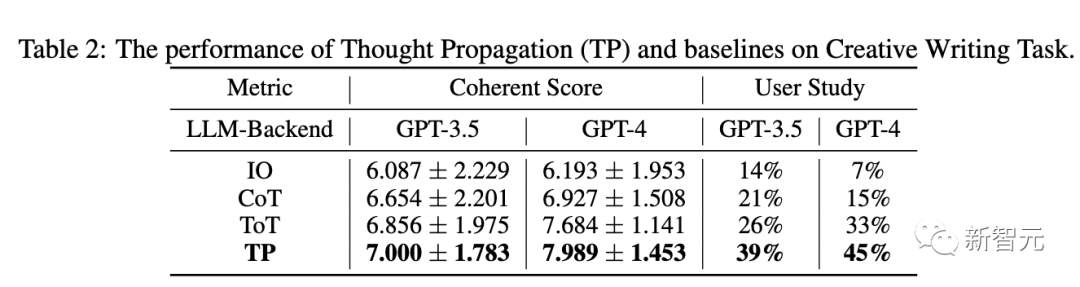

Kreatives Schreiben

Tabelle 2 unten zeigt die Leistung von TP und Basislinien in GPT-3.5 und GPT-4. In Bezug auf die Konsistenz übertrifft TP den Ausgangswert. Darüber hinaus steigerte TP in Benutzerstudien die menschliche Präferenz für kreatives Schreiben um 13 %.

LLM-Agentenplanung

In der dritten Aufgabenbewertung verwendeten die Forscher die ALFWorld-Spielesuite, um die LLM-Agentenplanungsaufgabe in 134 Umgebungen zu instanziieren.

TP erhöht die Aufgabenerledigungsrate bei der LLM-Agentenplanung um 15 %. Dies zeigt die Überlegenheit der reflektierenden TP für eine erfolgreiche Planung bei der Erledigung ähnlicher Aufgaben.

Anhand der oben genannten experimentellen Ergebnisse wird gezeigt, dass „Thinking Propagation“ auf eine Vielzahl verschiedener Denkaufgaben angewendet werden kann und bei all diesen Aufgaben gute Ergebnisse liefert.

Der Schlüssel zur Verbesserung des LLM-Denkens

„Denken“ Das „Propagation“-Modell bietet eine neue Technologie für komplexe LLM-Inferenz.

Analoges Denken ist ein Zeichen menschlicher Problemlösungsfähigkeit. Es kann eine Reihe systematischer Vorteile mit sich bringen, wie z. B. eine effizientere Suche und Fehlerkorrektur.

In ähnlichen Situationen kann LLM auch dazu anregen, analoges Denken besser zu bewältigen Ihre eigenen Schwächen, wie z. B. mangelndes wiederverwendbares Wissen und kaskadierende lokale Fehler usw. Darüber hinaus können länger verkettete analoge Argumentationspfade langwierig und schwierig zu verfolgen sein. Gleichzeitig ist die Steuerung und Koordinierung mehrstufiger Argumentationsketten auch eine ziemlich schwierige Aufgabe

Allerdings bietet uns die „Gedankenverbreitung“ immer noch eine interessante Methode, indem sie die Argumentationsmängel des LLM kreativ löst.

Mit der weiteren Entwicklung kann analoges Denken die Denkfähigkeit von LLM noch leistungsfähiger machen. Dies zeigt auch den Weg, um das Ziel eines engeren menschlichen Denkens in großen Sprachmodellen zu erreichen Er ist Professor am Institut für Automatisierung der Chinesischen Akademie der Wissenschaften und an der Universität der Chinesischen Akademie der Wissenschaften sowie IAPR-Fellow und hochrangiges Mitglied des IEEE

Zuvor erhielt er seinen Bachelor- und Master-Abschluss von der Universität Dalian of Technology und promovierte 2009 am Institut für Automatisierung der Chinesischen Akademie der Wissenschaften. Überwachtes oder Transferlernen vorab trainierter Netzwerke), generatives Lernen (generative Modelle, Bilderzeugung, Bildübersetzung).

Er hat mehr als 200 Artikel in internationalen Fachzeitschriften und Konferenzen veröffentlicht, darunter bekannte internationale Fachzeitschriften wie IEEE TPAMI, IEEE TIP, IEEE TIFS, IEEE TNN, IEEE TCSVT und internationale Spitzenzeitschriften wie CVPR, ICCV, ECCV, NeurIPS usw. Konferenz

Er ist Mitglied der Redaktion von IEEE TIP, IEEE TBIOM und Pattern Recognition und war außerdem regionaler Vorsitzender internationaler Konferenzen wie CVPR, ECCV, NeurIPS, ICML, ICPR und IJCAI

Junchi Yu (俞junchi)

Yu Junchi ist Doktorand im vierten Jahr am Institut für Automatisierung der Chinesischen Akademie der Wissenschaften. Sein Betreuer ist Professor Heran.

Zuvor absolvierte er ein Praktikum am Tencent Artificial Intelligence Laboratory und arbeitete bei Dr. Tingyang Xu und Dr. Yu Rong, Dr. Yatao Bian und Junzhou-Professor Huang arbeiteten zusammen. Jetzt ist er Austauschstudent am Informatik-Department der Yale University und studiert bei Professor Rex Ying

Sein Ziel ist es, eine vertrauenswürdige Graph-Learning-Methode (TwGL) mit guter Interpretierbarkeit und Portabilität zu entwickeln und deren Anwendung zu erforschen dem Bereich der Biochemie

Das obige ist der detaillierte Inhalt vonDie menschenähnlichen Denkfähigkeiten von GPT-4 wurden erheblich verbessert! Die Chinesische Akademie der Wissenschaften schlug „denkende Kommunikation' vor. Analoges Denken geht über CoT hinaus und kann sofort angewendet werden. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Stellen Sie sich ein Modell der künstlichen Intelligenz vor, das nicht nur die Fähigkeit besitzt, die traditionelle Datenverarbeitung zu übertreffen, sondern auch eine effizientere Leistung zu geringeren Kosten erzielt. Dies ist keine Science-Fiction, DeepSeek-V2[1], das weltweit leistungsstärkste Open-Source-MoE-Modell, ist da. DeepSeek-V2 ist ein leistungsstarkes MoE-Sprachmodell (Mix of Experts) mit den Merkmalen eines wirtschaftlichen Trainings und einer effizienten Inferenz. Es besteht aus 236B Parametern, von denen 21B zur Aktivierung jedes Markers verwendet werden. Im Vergleich zu DeepSeek67B bietet DeepSeek-V2 eine stärkere Leistung, spart gleichzeitig 42,5 % der Trainingskosten, reduziert den KV-Cache um 93,3 % und erhöht den maximalen Generierungsdurchsatz auf das 5,76-fache. DeepSeek ist ein Unternehmen, das sich mit allgemeiner künstlicher Intelligenz beschäftigt

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI verändert tatsächlich die Mathematik. Vor kurzem hat Tao Zhexuan, der diesem Thema große Aufmerksamkeit gewidmet hat, die neueste Ausgabe des „Bulletin of the American Mathematical Society“ (Bulletin der American Mathematical Society) weitergeleitet. Zum Thema „Werden Maschinen die Mathematik verändern?“ äußerten viele Mathematiker ihre Meinung. Der gesamte Prozess war voller Funken, knallhart und aufregend. Der Autor verfügt über eine starke Besetzung, darunter der Fields-Medaillengewinner Akshay Venkatesh, der chinesische Mathematiker Zheng Lejun, der NYU-Informatiker Ernest Davis und viele andere bekannte Wissenschaftler der Branche. Die Welt der KI hat sich dramatisch verändert. Viele dieser Artikel wurden vor einem Jahr eingereicht.

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

Anfang dieses Monats schlugen Forscher des MIT und anderer Institutionen eine vielversprechende Alternative zu MLP vor – KAN. KAN übertrifft MLP in Bezug auf Genauigkeit und Interpretierbarkeit. Und es kann MLP, das mit einer größeren Anzahl von Parametern ausgeführt wird, mit einer sehr kleinen Anzahl von Parametern übertreffen. Beispielsweise gaben die Autoren an, dass sie KAN nutzten, um die Ergebnisse von DeepMind mit einem kleineren Netzwerk und einem höheren Automatisierungsgrad zu reproduzieren. Konkret verfügt DeepMinds MLP über etwa 300.000 Parameter, während KAN nur etwa 200 Parameter hat. KAN hat eine starke mathematische Grundlage wie MLP und basiert auf dem universellen Approximationssatz, während KAN auf dem Kolmogorov-Arnold-Darstellungssatz basiert. Wie in der folgenden Abbildung gezeigt, hat KAN

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas tritt offiziell in die Ära der Elektroroboter ein! Gestern hat sich der hydraulische Atlas einfach „unter Tränen“ von der Bühne der Geschichte zurückgezogen. Heute gab Boston Dynamics bekannt, dass der elektrische Atlas im Einsatz ist. Es scheint, dass Boston Dynamics im Bereich kommerzieller humanoider Roboter entschlossen ist, mit Tesla zu konkurrieren. Nach der Veröffentlichung des neuen Videos wurde es innerhalb von nur zehn Stunden bereits von mehr als einer Million Menschen angesehen. Die alten Leute gehen und neue Rollen entstehen. Das ist eine historische Notwendigkeit. Es besteht kein Zweifel, dass dieses Jahr das explosive Jahr der humanoiden Roboter ist. Netizens kommentierten: Die Weiterentwicklung der Roboter hat dazu geführt, dass die diesjährige Eröffnungsfeier wie Menschen aussieht, und der Freiheitsgrad ist weitaus größer als der von Menschen. Aber ist das wirklich kein Horrorfilm? Zu Beginn des Videos liegt Atlas ruhig auf dem Boden, scheinbar auf dem Rücken. Was folgt, ist atemberaubend

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Die von Google geförderte Leistung von JAX hat in jüngsten Benchmark-Tests die von Pytorch und TensorFlow übertroffen und belegt bei 7 Indikatoren den ersten Platz. Und der Test wurde nicht auf der TPU mit der besten JAX-Leistung durchgeführt. Obwohl unter Entwicklern Pytorch immer noch beliebter ist als Tensorflow. Aber in Zukunft werden möglicherweise mehr große Modelle auf Basis der JAX-Plattform trainiert und ausgeführt. Modelle Kürzlich hat das Keras-Team drei Backends (TensorFlow, JAX, PyTorch) mit der nativen PyTorch-Implementierung und Keras2 mit TensorFlow verglichen. Zunächst wählen sie eine Reihe von Mainstream-Inhalten aus

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Das neueste Video von Teslas Roboter Optimus ist veröffentlicht und er kann bereits in der Fabrik arbeiten. Bei normaler Geschwindigkeit sortiert es Batterien (Teslas 4680-Batterien) so: Der Beamte hat auch veröffentlicht, wie es bei 20-facher Geschwindigkeit aussieht – auf einer kleinen „Workstation“, pflücken und pflücken und pflücken: Dieses Mal wird es freigegeben. Eines der Highlights Der Vorteil des Videos besteht darin, dass Optimus diese Arbeit in der Fabrik völlig autonom und ohne menschliches Eingreifen während des gesamten Prozesses erledigt. Und aus Sicht von Optimus kann es auch die krumme Batterie aufnehmen und platzieren, wobei der Schwerpunkt auf der automatischen Fehlerkorrektur liegt: In Bezug auf die Hand von Optimus gab der NVIDIA-Wissenschaftler Jim Fan eine hohe Bewertung ab: Die Hand von Optimus ist der fünffingrige Roboter der Welt am geschicktesten. Seine Hände sind nicht nur taktil

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

Die Zielerkennung ist ein relativ ausgereiftes Problem in autonomen Fahrsystemen, wobei die Fußgängererkennung einer der ersten Algorithmen ist, die eingesetzt werden. In den meisten Arbeiten wurde eine sehr umfassende Recherche durchgeführt. Die Entfernungswahrnehmung mithilfe von Fischaugenkameras für die Rundumsicht ist jedoch relativ wenig untersucht. Aufgrund der großen radialen Verzerrung ist es schwierig, die standardmäßige Bounding-Box-Darstellung in Fischaugenkameras zu implementieren. Um die obige Beschreibung zu vereinfachen, untersuchen wir erweiterte Begrenzungsrahmen-, Ellipsen- und allgemeine Polygondesigns in Polar-/Winkeldarstellungen und definieren eine mIOU-Metrik für die Instanzsegmentierung, um diese Darstellungen zu analysieren. Das vorgeschlagene Modell „fisheyeDetNet“ mit polygonaler Form übertrifft andere Modelle und erreicht gleichzeitig 49,5 % mAP auf dem Valeo-Fisheye-Kameradatensatz für autonomes Fahren

DualBEV: BEVFormer und BEVDet4D deutlich übertreffen, öffnen Sie das Buch!

Mar 21, 2024 pm 05:21 PM

DualBEV: BEVFormer und BEVDet4D deutlich übertreffen, öffnen Sie das Buch!

Mar 21, 2024 pm 05:21 PM

In diesem Artikel wird das Problem der genauen Erkennung von Objekten aus verschiedenen Blickwinkeln (z. B. Perspektive und Vogelperspektive) beim autonomen Fahren untersucht, insbesondere wie die Transformation von Merkmalen aus der Perspektive (PV) in den Raum aus der Vogelperspektive (BEV) effektiv ist implementiert über das Modul Visual Transformation (VT). Bestehende Methoden lassen sich grob in zwei Strategien unterteilen: 2D-zu-3D- und 3D-zu-2D-Konvertierung. 2D-zu-3D-Methoden verbessern dichte 2D-Merkmale durch die Vorhersage von Tiefenwahrscheinlichkeiten, aber die inhärente Unsicherheit von Tiefenvorhersagen, insbesondere in entfernten Regionen, kann zu Ungenauigkeiten führen. Während 3D-zu-2D-Methoden normalerweise 3D-Abfragen verwenden, um 2D-Features abzutasten und die Aufmerksamkeitsgewichte der Korrespondenz zwischen 3D- und 2D-Features über einen Transformer zu lernen, erhöht sich die Rechen- und Bereitstellungszeit.