Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Sprache, Robot Breaking, MIT und andere nutzen GPT-4, um automatisch Simulationsaufgaben zu generieren und diese in die reale Welt zu migrieren

Sprache, Robot Breaking, MIT und andere nutzen GPT-4, um automatisch Simulationsaufgaben zu generieren und diese in die reale Welt zu migrieren

Sprache, Robot Breaking, MIT und andere nutzen GPT-4, um automatisch Simulationsaufgaben zu generieren und diese in die reale Welt zu migrieren

Im Bereich der Robotik erfordert die Umsetzung universeller Roboterstrategien eine große Datenmenge, und das Sammeln dieser Daten in der realen Welt ist zeitaufwändig und mühsam. Obwohl die Simulation eine wirtschaftliche Lösung für die Generierung unterschiedlicher Datenmengen auf Szenen- und Instanzebene darstellt, stellt die zunehmende Aufgabenvielfalt in simulierten Umgebungen aufgrund des hohen Arbeitskräftebedarfs (insbesondere bei komplexen Aufgaben) immer noch Herausforderungen dar. Dies führt zu typischen künstlichen Simulations-Benchmarks, die typischerweise nur Dutzende bis Hunderte von Aufgaben umfassen.

Wie kann man es lösen? In den letzten Jahren haben große Sprachmodelle weiterhin erhebliche Fortschritte bei der Verarbeitung natürlicher Sprache und der Codegenerierung für verschiedene Aufgaben gemacht. Ebenso wurde LLM auf mehrere Aspekte der Robotik angewendet, darunter Benutzeroberflächen, Aufgaben- und Bewegungsplanung, Roboterprotokollzusammenfassung, Kosten- und Belohnungsdesign, und zeigte starke Fähigkeiten sowohl bei physikbasierten als auch bei Codegenerierungsaufgaben.

In einer aktuellen Studie untersuchten Forscher des MIT CSAIL, der Shanghai Jiao Tong University und anderer Institutionen weiter, ob LLM zur Erstellung vielfältiger Simulationsaufgaben eingesetzt werden kann und erforschten deren Fähigkeiten weiter.

Konkret schlugen die Forscher ein LLM-basiertes Framework GenSim vor, das einen automatisierten Mechanismus zum Entwerfen und Überprüfen der Anordnung von Aufgabenressourcen und des Aufgabenfortschritts bietet. Noch wichtiger ist, dass die generierten Aufgaben eine große Vielfalt aufweisen, was die Verallgemeinerung von Roboterstrategien auf Aufgabenebene fördert. Darüber hinaus werden mit GenSim die Argumentations- und Codierungsfähigkeiten von LLM konzeptionell durch Zwischensynthese simulierter Daten zu verbal-visuellen Handlungsstrategien verfeinert.

... Code-Implementierung;

Das Framework arbeitet gleichzeitig in zwei verschiedenen Modi. Unter anderem hat der Benutzer in der zielorientierten Einstellung eine bestimmte Aufgabe oder möchte einen Aufgabenverlauf entwerfen. Zu diesem Zeitpunkt verfolgt GenSim einen Top-Down-Ansatz, bei dem die erwarteten Aufgaben als Eingabe verwendet und verwandte Aufgaben iterativ generiert werden, um die erwarteten Ziele zu erreichen. Wenn in einer explorativen Umgebung Vorkenntnisse über die Zielaufgabe fehlen, erkundet GenSim nach und nach Inhalte über die bestehenden Aufgaben hinaus und erstellt eine grundlegende Strategie, die unabhängig von der Aufgabe ist.

- In Abbildung 1 unten initialisierte der Forscher eine Aufgabenbibliothek mit 10 manuell kuratierten Aufgaben, erweiterte sie mithilfe von GenSim und generierte mehr als 100 Aufgaben.

- Die Forscher schlugen außerdem mehrere maßgeschneiderte Metriken vor, um die Qualität generierter Simulationsaufgaben schrittweise zu messen, und bewerteten mehrere LLMs in zielorientierten und explorativen Umgebungen. Für die von GPT-4 generierte Aufgabenbibliothek führten sie eine überwachte Feinabstimmung an LLMs wie GPT-3.5 und Code-Llama durch und verbesserten so die Aufgabengenerierungsleistung von LLM weiter. Gleichzeitig wird die Erreichbarkeit von Aufgaben durch Strategietraining quantitativ gemessen und Aufgabenstatistiken verschiedener Attribute sowie Codevergleiche zwischen verschiedenen Modellen bereitgestellt.

Schließlich betrachteten die Forscher auch den Transfer von Simulation in die Realität und zeigten, dass ein Vortraining an verschiedenen Simulationsaufgaben die Fähigkeit zur Generalisierung in der realen Welt um 25 % verbessern kann.

Zusammenfassend lässt sich sagen, dass Richtlinien, die auf von verschiedenen LLMs generierten Aufgaben trainiert werden, eine bessere Verallgemeinerung auf Aufgabenebene auf neue Aufgaben erreichen, was das Potenzial der Erweiterung simulierter Aufgaben durch LLM zum Trainieren von Basisrichtlinien hervorhebt.

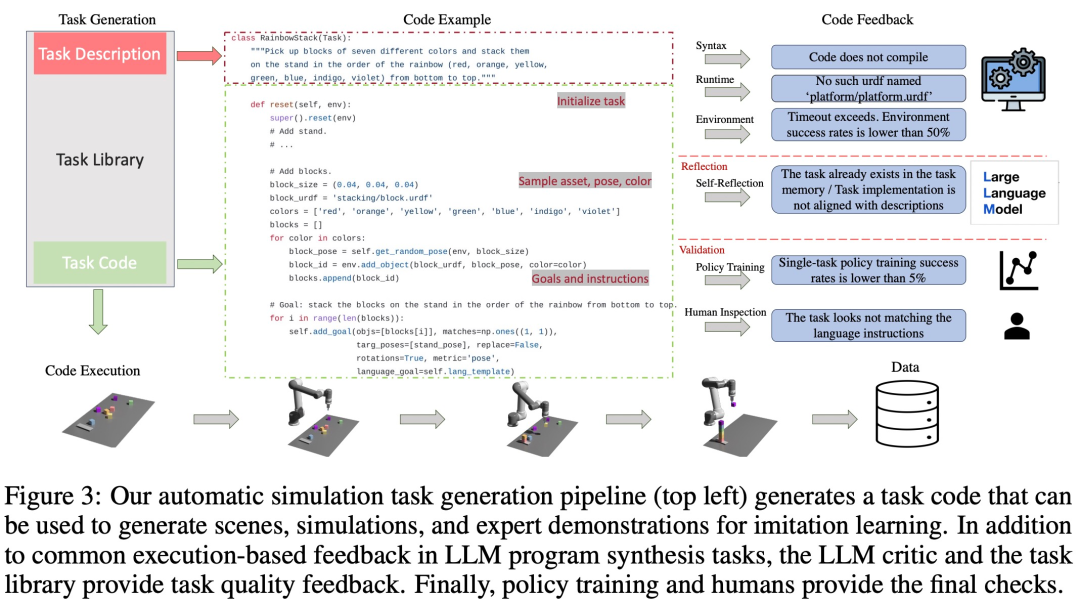

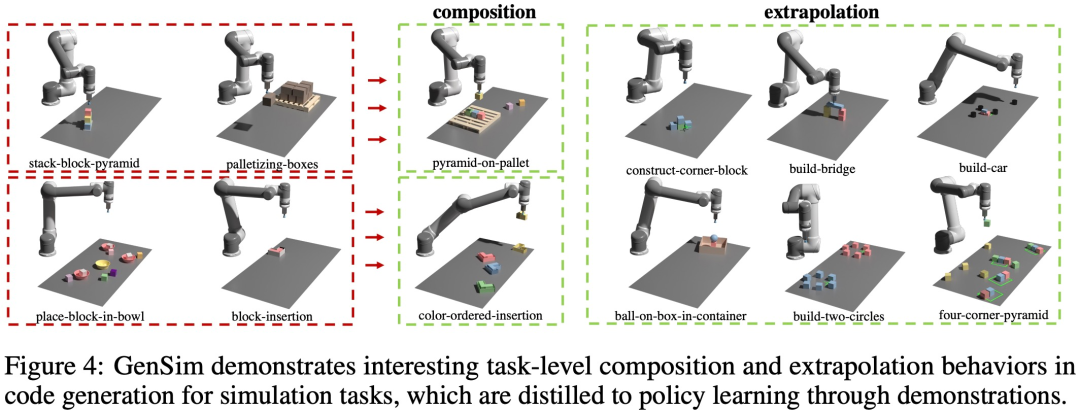

Shubham Saboo, Direktor für Produktmanagement bei Tenstorrent AI, lobte diese Forschung sehr. Er sagte, dass dies eine bahnbrechende Forschung zu GPT-4 in Kombination mit Robotern sei, bei der LLM wie GPT-4 verwendet werde, um eine Reihe simulierter Roboteraufgaben zu generieren auf Autopilot, wodurch Zero-Shot-Lernen und die Anpassung von Robotern an die reale Welt Realität werden. Wie in Abbildung 2 unten dargestellt, generiert das GenSim-Framework Simulationsumgebungen, Aufgaben und Demonstrationen durch Programmsynthese. Die GenSim-Pipeline beginnt beim Aufgabenersteller und die Eingabeaufforderungskette läuft je nach Zielaufgabe in zwei Modi: zielgerichteter Modus und explorativer Modus. Die Aufgabenbibliothek in GenSim ist eine speicherinterne Komponente, die zum Speichern zuvor generierter hochwertiger Aufgaben verwendet wird. Die in der Aufgabenbibliothek gespeicherten Aufgaben können für das Training von Multitask-Richtlinien oder die Feinabstimmung von LLM verwendet werden. Aufgabenersteller Wie in Abbildung 3 unten dargestellt, generiert die Sprachkette zunächst die Aufgabenbeschreibung und dann die zugehörige Implementierung. Die Aufgabenbeschreibung umfasst den Aufgabennamen, Ressourcen und eine Aufgabenzusammenfassung. Diese Studie verwendet eine Eingabeaufforderung mit wenigen Beispielen in der Pipeline, um Code zu generieren. Aufgabenbibliothek Die Aufgabenbibliothek im GenSim-Framework speichert vom Aufgabenersteller generierte Aufgaben, um bessere neue Aufgaben zu generieren und Multitasking-Strategien zu trainieren. Die Aufgabenbibliothek wird basierend auf Aufgaben aus manuell erstellten Benchmarks initialisiert. Die Aufgabenbibliothek stellt dem Aufgabenersteller die vorherige Aufgabenbeschreibung als Bedingung für die Beschreibungsgenerierungsphase und den vorherigen Code für die Codegenerierungsphase zur Verfügung und fordert den Aufgabenersteller auf, die Referenzaufgabe aus der Aufgabenbibliothek als auszuwählen das Beispiel zum Schreiben einer neuen Aufgabe. Nachdem die Aufgabenimplementierung abgeschlossen ist und alle Tests bestanden wurden, wird LLM aufgefordert, über die neue Aufgabe und Aufgabenbibliothek nachzudenken und eine umfassende Entscheidung darüber zu treffen, ob die neu generierte Aufgabe der Bibliothek hinzugefügt werden soll. Wie in Abbildung 4 unten dargestellt, beobachtete die Studie auch, dass GenSim ein interessantes Kombinations- und Extrapolationsverhalten auf Aufgabenebene aufweist: LLM-überwachte Multitask-Strategie Generation Nach der Mission nutzt diese Studie diese Aufgabenimplementierungen, um Demonstrationsdaten zu generieren und Betriebsrichtlinien zu trainieren, wobei eine Zwei-Stream-Übertragungsnetzwerkarchitektur ähnlich der von Shridhar et al. verwendet wird. Wie in Abbildung 5 unten gezeigt, betrachtet diese Studie das Programm als eine effektive Darstellung der Aufgabe und der zugehörigen Demonstrationsdaten (Abbildung 5). Es ist möglich, den Einbettungsraum zwischen Aufgaben zu definieren, und sein Abstandsindex ist empfindlich Verschiedene Faktoren aus der Wahrnehmung (z. B. Objekthaltung und -form) sind robuster. Diese Studie validiert das GenSim-Framework durch Experimente und zielt auf die folgenden spezifischen Fragen ab: (1) Wie effektiv ist LLM beim Entwerfen und Implementieren von Simulationsaufgaben? Kann GenSim die Leistung von LLM bei der Aufgabengenerierung verbessern? (2) Kann Schulung zu den durch LLM generierten Aufgaben die Fähigkeit zur Richtlinienverallgemeinerung verbessern? Wäre die Politikschulung von größerem Nutzen, wenn ihnen mehr Generationsaufgaben übertragen würden? (3) Erleichtert das Vortraining zu simulierten Aufgaben, die von LLM generiert werden, die Umsetzung realer Roboterrichtlinien? Bewerten Sie die Generalisierungsfähigkeit von LLM-Robotersimulationsaufgaben Verbessern Sie effektiv die Erfolgsquote bei der Codegenerierung.

Verallgemeinerung auf Aufgabenebene Few-Shot-Strategieoptimierung für verwandte Aufgaben. Wie auf der linken Seite von Abbildung 7 unten zu sehen ist, kann das gemeinsame Training der von LLM generierten Aufgaben die Richtlinienleistung für die ursprüngliche CLIPort-Aufgabe um mehr als 50 % verbessern, insbesondere in Situationen mit wenig Daten (z. B. 5 Demos). Zero-Shot-Richtlinienverallgemeinerung auf unsichtbare Aufgaben. Wie in Abbildung 7 zu sehen ist, kann unser Modell durch Vorabtraining für mehr von LLM generierte Aufgaben besser auf Aufgaben im ursprünglichen Ravens-Benchmark verallgemeinert werden. In der Mitte rechts in Abbildung 7 haben die Forscher außerdem fünf Aufgaben auf verschiedenen Aufgabenquellen vorab trainiert, darunter manuell geschriebene Aufgaben, Closed-Source-LLM und Open-Source-LLM mit Feinabstimmung, und dabei ein ähnliches Zero-Shot-Aufgabenniveau beobachtet Verallgemeinerung. Passen Sie das vorab trainierte Modell an die reale Welt an Die Forscher übertrugen die in der simulierten Umgebung trainierten Strategien auf die reale Umgebung. Die Ergebnisse sind in Tabelle 1 unten aufgeführt. Das vorab trainierte Modell führte 10 Experimente zu 9 Aufgaben durch und erreichte eine durchschnittliche Erfolgsquote von 68,8 %, was besser ist als das Vortraining nur für die CLIPort-Aufgabe. Im Vergleich zum Basismodell hat es sich um mehr als 25 % verbessert, und im Vergleich zum Modell, das nur für 50 Aufgaben vorab trainiert wurde, hat es sich um 15 % verbessert. Die Forscher beobachteten außerdem, dass das Vortraining an verschiedenen Simulationsaufgaben die Robustheit langfristiger komplexer Aufgaben verbesserte. Beispielsweise zeigen vorab trainierte GPT-4-Modelle eine robustere Leistung bei realen Build-Wheel-Aufgaben. Ablationsexperiment Erfolgsquote des Simulationstrainings. In der folgenden Tabelle 2 demonstrieren die Forscher die Erfolgsraten von Richtlinienschulungen für einzelne und mehrere Aufgaben anhand einer Teilmenge generierter Aufgaben anhand von 200 Demos. Bei der Richtlinienschulung zu Aufgaben der GPT-4-Generation beträgt die durchschnittliche Aufgabenerfolgsquote 75,8 % für Einzelaufgaben und 74,1 % für Mehrfachaufgaben. Aufgabenstatistiken erstellen. In Abbildung 9 (a) unten zeigt der Forscher die Aufgabenstatistiken verschiedener Merkmale der 120 von LLM generierten Aufgaben. Es besteht ein interessantes Gleichgewicht zwischen den Farben, Assets, Aktionen und der Anzahl der vom LLM-Modell generierten Instanzen. Der generierte Code enthält beispielsweise viele Szenen mit mehr als 7 Objektinstanzen sowie viele primitive Pick-and-Place-Aktionen und Assets wie Blöcke. Vergleich der Codegenerierung. In Abbildung 9(b) unten bewerten die Forscher die Fehlerfälle in den Top-Down-Experimenten von GPT-4 und Code Llama qualitativ. Weitere technische Details finden Sie im Originalpapier.

Einführung in die Methode

Experimente und Ergebnisse

Das obige ist der detaillierte Inhalt vonSprache, Robot Breaking, MIT und andere nutzen GPT-4, um automatisch Simulationsaufgaben zu generieren und diese in die reale Welt zu migrieren. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Verwenden Sie ddrescue, um Daten unter Linux wiederherzustellen

Mar 20, 2024 pm 01:37 PM

Verwenden Sie ddrescue, um Daten unter Linux wiederherzustellen

Mar 20, 2024 pm 01:37 PM

DDREASE ist ein Tool zum Wiederherstellen von Daten von Datei- oder Blockgeräten wie Festplatten, SSDs, RAM-Disks, CDs, DVDs und USB-Speichergeräten. Es kopiert Daten von einem Blockgerät auf ein anderes, wobei beschädigte Blöcke zurückbleiben und nur gute Blöcke verschoben werden. ddreasue ist ein leistungsstarkes Wiederherstellungstool, das vollständig automatisiert ist, da es während der Wiederherstellungsvorgänge keine Unterbrechungen erfordert. Darüber hinaus kann es dank der ddasue-Map-Datei jederzeit gestoppt und fortgesetzt werden. Weitere wichtige Funktionen von DDREASE sind: Es überschreibt die wiederhergestellten Daten nicht, füllt aber die Lücken im Falle einer iterativen Wiederherstellung. Es kann jedoch gekürzt werden, wenn das Tool explizit dazu aufgefordert wird. Stellen Sie Daten aus mehreren Dateien oder Blöcken in einer einzigen wieder her

Open Source! Jenseits von ZoeDepth! DepthFM: Schnelle und genaue monokulare Tiefenschätzung!

Apr 03, 2024 pm 12:04 PM

Open Source! Jenseits von ZoeDepth! DepthFM: Schnelle und genaue monokulare Tiefenschätzung!

Apr 03, 2024 pm 12:04 PM

0.Was bewirkt dieser Artikel? Wir schlagen DepthFM vor: ein vielseitiges und schnelles generatives monokulares Tiefenschätzungsmodell auf dem neuesten Stand der Technik. Zusätzlich zu herkömmlichen Tiefenschätzungsaufgaben demonstriert DepthFM auch hochmoderne Fähigkeiten bei nachgelagerten Aufgaben wie dem Tiefen-Inpainting. DepthFM ist effizient und kann Tiefenkarten innerhalb weniger Inferenzschritte synthetisieren. Lassen Sie uns diese Arbeit gemeinsam lesen ~ 1. Titel der Papierinformationen: DepthFM: FastMonocularDepthEstimationwithFlowMatching Autor: MingGui, JohannesS.Fischer, UlrichPrestel, PingchuanMa, Dmytr

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas tritt offiziell in die Ära der Elektroroboter ein! Gestern hat sich der hydraulische Atlas einfach „unter Tränen“ von der Bühne der Geschichte zurückgezogen. Heute gab Boston Dynamics bekannt, dass der elektrische Atlas im Einsatz ist. Es scheint, dass Boston Dynamics im Bereich kommerzieller humanoider Roboter entschlossen ist, mit Tesla zu konkurrieren. Nach der Veröffentlichung des neuen Videos wurde es innerhalb von nur zehn Stunden bereits von mehr als einer Million Menschen angesehen. Die alten Leute gehen und neue Rollen entstehen. Das ist eine historische Notwendigkeit. Es besteht kein Zweifel, dass dieses Jahr das explosive Jahr der humanoiden Roboter ist. Netizens kommentierten: Die Weiterentwicklung der Roboter hat dazu geführt, dass die diesjährige Eröffnungsfeier wie Menschen aussieht, und der Freiheitsgrad ist weitaus größer als der von Menschen. Aber ist das wirklich kein Horrorfilm? Zu Beginn des Videos liegt Atlas ruhig auf dem Boden, scheinbar auf dem Rücken. Was folgt, ist atemberaubend

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Die von Google geförderte Leistung von JAX hat in jüngsten Benchmark-Tests die von Pytorch und TensorFlow übertroffen und belegt bei 7 Indikatoren den ersten Platz. Und der Test wurde nicht auf der TPU mit der besten JAX-Leistung durchgeführt. Obwohl unter Entwicklern Pytorch immer noch beliebter ist als Tensorflow. Aber in Zukunft werden möglicherweise mehr große Modelle auf Basis der JAX-Plattform trainiert und ausgeführt. Modelle Kürzlich hat das Keras-Team drei Backends (TensorFlow, JAX, PyTorch) mit der nativen PyTorch-Implementierung und Keras2 mit TensorFlow verglichen. Zunächst wählen sie eine Reihe von Mainstream-Inhalten aus

Langsame Internetgeschwindigkeiten für Mobilfunkdaten auf dem iPhone: Korrekturen

May 03, 2024 pm 09:01 PM

Langsame Internetgeschwindigkeiten für Mobilfunkdaten auf dem iPhone: Korrekturen

May 03, 2024 pm 09:01 PM

Stehen Sie vor einer Verzögerung oder einer langsamen mobilen Datenverbindung auf dem iPhone? Normalerweise hängt die Stärke des Mobilfunk-Internets auf Ihrem Telefon von mehreren Faktoren ab, wie z. B. der Region, dem Mobilfunknetztyp, dem Roaming-Typ usw. Es gibt einige Dinge, die Sie tun können, um eine schnellere und zuverlässigere Mobilfunk-Internetverbindung zu erhalten. Fix 1 – Neustart des iPhone erzwingen Manchmal werden durch einen erzwungenen Neustart Ihres Geräts viele Dinge zurückgesetzt, einschließlich der Mobilfunkverbindung. Schritt 1 – Drücken Sie einfach einmal die Lauter-Taste und lassen Sie sie los. Drücken Sie anschließend die Leiser-Taste und lassen Sie sie wieder los. Schritt 2 – Der nächste Teil des Prozesses besteht darin, die Taste auf der rechten Seite gedrückt zu halten. Lassen Sie das iPhone den Neustart abschließen. Aktivieren Sie Mobilfunkdaten und überprüfen Sie die Netzwerkgeschwindigkeit. Überprüfen Sie es erneut. Fix 2 – Datenmodus ändern 5G bietet zwar bessere Netzwerkgeschwindigkeiten, funktioniert jedoch besser, wenn das Signal schwächer ist

Die Kuaishou-Version von Sora „Ke Ling' steht zum Testen offen: Sie generiert über 120 Sekunden Videos, versteht die Physik besser und kann komplexe Bewegungen genau modellieren

Jun 11, 2024 am 09:51 AM

Die Kuaishou-Version von Sora „Ke Ling' steht zum Testen offen: Sie generiert über 120 Sekunden Videos, versteht die Physik besser und kann komplexe Bewegungen genau modellieren

Jun 11, 2024 am 09:51 AM

Was? Wird Zootopia durch heimische KI in die Realität umgesetzt? Zusammen mit dem Video wird ein neues groß angelegtes inländisches Videogenerationsmodell namens „Keling“ vorgestellt. Sora geht einen ähnlichen technischen Weg und kombiniert eine Reihe selbst entwickelter technologischer Innovationen, um Videos zu produzieren, die nicht nur große und vernünftige Bewegungen aufweisen, sondern auch die Eigenschaften der physischen Welt simulieren und über starke konzeptionelle Kombinationsfähigkeiten und Vorstellungskraft verfügen. Den Daten zufolge unterstützt Keling die Erstellung ultralanger Videos von bis zu 2 Minuten mit 30 Bildern pro Sekunde, mit Auflösungen von bis zu 1080p und unterstützt mehrere Seitenverhältnisse. Ein weiterer wichtiger Punkt ist, dass es sich bei Keling nicht um eine vom Labor veröffentlichte Demo oder Video-Ergebnisdemonstration handelt, sondern um eine Anwendung auf Produktebene, die von Kuaishou, einem führenden Anbieter im Bereich Kurzvideos, gestartet wurde. Darüber hinaus liegt das Hauptaugenmerk darauf, pragmatisch zu sein, keine Blankoschecks auszustellen und sofort nach der Veröffentlichung online zu gehen. Das große Modell von Ke Ling wurde bereits in Kuaiying veröffentlicht.

Die Vitalität der Superintelligenz erwacht! Aber mit der Einführung der sich selbst aktualisierenden KI müssen sich Mütter keine Sorgen mehr über Datenengpässe machen

Apr 29, 2024 pm 06:55 PM

Die Vitalität der Superintelligenz erwacht! Aber mit der Einführung der sich selbst aktualisierenden KI müssen sich Mütter keine Sorgen mehr über Datenengpässe machen

Apr 29, 2024 pm 06:55 PM

Ich weine zu Tode. Die Daten im Internet reichen überhaupt nicht aus. Das Trainingsmodell sieht aus wie „Die Tribute von Panem“, und KI-Forscher auf der ganzen Welt machen sich Gedanken darüber, wie sie diese datenhungrigen Esser ernähren sollen. Dieses Problem tritt insbesondere bei multimodalen Aufgaben auf. Zu einer Zeit, als sie ratlos waren, nutzte ein Start-up-Team der Abteilung der Renmin-Universität von China sein eigenes neues Modell, um als erstes in China einen „modellgenerierten Datenfeed selbst“ in die Realität umzusetzen. Darüber hinaus handelt es sich um einen zweigleisigen Ansatz auf der Verständnisseite und der Generierungsseite. Beide Seiten können hochwertige, multimodale neue Daten generieren und Datenrückmeldungen an das Modell selbst liefern. Was ist ein Modell? Awaker 1.0, ein großes multimodales Modell, das gerade im Zhongguancun-Forum erschienen ist. Wer ist das Team? Sophon-Motor. Gegründet von Gao Yizhao, einem Doktoranden an der Hillhouse School of Artificial Intelligence der Renmin University.

Die U.S. Air Force präsentiert ihren ersten KI-Kampfjet mit großem Aufsehen! Der Minister führte die Testfahrt persönlich durch, ohne in den gesamten Prozess einzugreifen, und 100.000 Codezeilen wurden 21 Mal getestet.

May 07, 2024 pm 05:00 PM

Die U.S. Air Force präsentiert ihren ersten KI-Kampfjet mit großem Aufsehen! Der Minister führte die Testfahrt persönlich durch, ohne in den gesamten Prozess einzugreifen, und 100.000 Codezeilen wurden 21 Mal getestet.

May 07, 2024 pm 05:00 PM

Kürzlich wurde die Militärwelt von der Nachricht überwältigt: US-Militärkampfflugzeuge können jetzt mithilfe von KI vollautomatische Luftkämpfe absolvieren. Ja, erst kürzlich wurde der KI-Kampfjet des US-Militärs zum ersten Mal der Öffentlichkeit zugänglich gemacht und sein Geheimnis gelüftet. Der vollständige Name dieses Jägers lautet „Variable Stability Simulator Test Aircraft“ (VISTA). Er wurde vom Minister der US-Luftwaffe persönlich geflogen, um einen Eins-gegen-eins-Luftkampf zu simulieren. Am 2. Mai startete US-Luftwaffenminister Frank Kendall mit einer X-62AVISTA auf der Edwards Air Force Base. Beachten Sie, dass während des einstündigen Fluges alle Flugaktionen autonom von der KI durchgeführt wurden! Kendall sagte: „In den letzten Jahrzehnten haben wir über das unbegrenzte Potenzial des autonomen Luft-Luft-Kampfes nachgedacht, aber es schien immer unerreichbar.“ Nun jedoch,