Wie man Halluzinationen großer Sprachmodelle reduziert

LLM-Halluzination ist das Phänomen, bei dem große Sprachmodelle (LLMs) bedeutungslose oder ungenaue Ausgaben erzeugen, die nicht mit realen Mustern oder Objekten übereinstimmen. Diese fehlerhaften KI-Ausgaben sind auf eine Vielzahl von Faktoren zurückzuführen, darunter:

Überanpassung: LLM lernt Rauschen und Verzerrung in Trainingsdaten als Muster, was dazu führt, dass das Modell fehlerhafte Ausgaben für Testdaten erzeugt.

Hohe Modellkomplexität: LLMs verfügen über eine hohe Modellkomplexität, die es ihnen ermöglicht, nicht vorhandene Zusammenhänge wahrzunehmen und dadurch Illusionen zu erzeugen.

Große Unternehmen, die generative KI-Systeme entwickeln, unternehmen Schritte, um das Problem der KI-Halluzinationen anzugehen, obwohl einige Experten glauben, dass eine vollständige Beseitigung fehlerhafter Ausgaben möglicherweise unmöglich ist.

Google verbindet seine Modelle mit dem Internet, um Bodenreaktionen anhand von Daten und Netzwerkinformationen zu trainieren und so eine Überanpassung zu reduzieren.

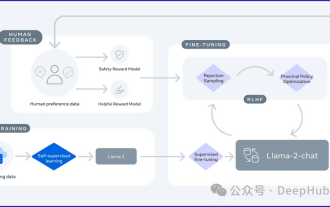

OpenAI nutzt menschliches Feedback und verstärkendes Lernen, um die Ausgabe von ChatGPT zu verfeinern. Sie schlagen eine „Prozessüberwachung“ vor, die Modelle für korrekte Argumentationsschritte belohnt, nicht nur für die endgültige Antwort. Dies kann die Erklärbarkeit verbessern, einige stellen jedoch die Wirksamkeit gegen Fälschungen in Frage.

Trotz der Risiken von KI-Halluzinationen können Unternehmen und Benutzer dennoch Maßnahmen ergreifen, um den potenziellen Schaden auszugleichen und zu begrenzen. Hier sind einige Möglichkeiten, das Problem zu lösen:

Verwenden Sie hochwertige Trainingsdaten.

Die Verwendung hochwertiger Trainingsdaten ist der Schlüssel zur Reduzierung von KI-Halluzinationen. Qualitativ hochwertige Trainingsdaten sollten vielfältig, ausgewogen und gut strukturiert sein und reale Situationen widerspiegeln.

Klare beabsichtigte Verwendung

Die klare Definition des spezifischen Zwecks und der zulässigen Verwendungszwecke eines KI-Systems kann dabei helfen, es von halluzinatorischen Inhalten fernzuhalten. Entwickler und Nutzer sollten die Funktionen und Einsatzmöglichkeiten von Modellen der künstlichen Intelligenz klar verstehen und sich bei der Nutzung strikt daran halten.

Verwenden Sie Datenvorlagen, um die Ausgabe künstlicher Intelligenz zu steuern.

Die Verwendung strukturierter Datenvorlagen kann dazu beitragen, dass Modelle künstlicher Intelligenz Ausgaben generieren, die den erwarteten Mustern entsprechen. Diese Vorlagen bieten ein konsistentes Format für die Dateneingabe in das Modell und schränken den Umfang der Schlussfolgerungen des Modells ein.

Limit-Reaktion

Das Festlegen von Einschränkungen und Grenzen für potenzielle Modellausgaben kann unkontrollierte Spekulationen reduzieren. Sie können beispielsweise klare Wahrscheinlichkeitsschwellenwerte definieren und Filtertools verwenden, um Antworten herauszufiltern, die nicht den Erwartungen entsprechen.

Kontinuierliches Testen und Verbessern des Systems

Durch umfassende Tests und kontinuierliche Überwachung kann die Leistung des künstlichen Intelligenzsystems kontinuierlich verbessert werden. Durch die Auswertung der Ausgabe können Bereiche identifiziert werden, die optimiert werden müssen, während neue Daten verwendet werden können, um das Modell neu zu trainieren und sein Wissen zu aktualisieren.

Verlassen Sie sich auf menschliche Aufsicht

Die Einbeziehung menschlicher Aufsicht kann entscheidenden Schutz bieten. Wenn menschliche Experten die Ausgabe überprüfen, können sie durch kontextbezogene Beurteilung jeden illusorischen Inhalt erfassen und korrigieren.

Thought Prompt Chain

Thought Prompt Chain ist eine Technologie, die künstliche Intelligenzmodelle dabei unterstützt, mehrstufige Überlegungen durchzuführen, indem sie eine logische Denkkette bereitstellt. Dieser Ansatz kann die Leistung von Modellen der künstlichen Intelligenz bei Aufgaben wie Mathematik verbessern.

Task Decomposition and Agents

Task Decomposition and Agents ist eine Methode zur Verbesserung der Leistung von Modellen der künstlichen Intelligenz durch die Aufteilung komplexer Aufgaben in mehrere Unteraufgaben. Diese Methode kann die Vorteile verschiedener Modelle der künstlichen Intelligenz nutzen und die Argumentationsfähigkeiten der Modelle der künstlichen Intelligenz verbessern.

Halluzinationen durch künstliche Intelligenz stellen eine Herausforderung für die Entwicklung künstlicher Intelligenz dar, aber durch wirksame Maßnahmen kann ihr Risiko wirksam verringert werden.

Das obige ist der detaillierte Inhalt vonWie man Halluzinationen großer Sprachmodelle reduziert. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

Warum verwenden große Sprachmodelle SwiGLU als Aktivierungsfunktion?

Apr 08, 2024 pm 09:31 PM

Warum verwenden große Sprachmodelle SwiGLU als Aktivierungsfunktion?

Apr 08, 2024 pm 09:31 PM

Wenn Sie sich mit der Architektur großer Sprachmodelle befasst haben, ist Ihnen möglicherweise der Begriff „SwiGLU“ in den neuesten Modellen und Forschungsarbeiten aufgefallen. Man kann sagen, dass SwiGLU die am häufigsten verwendete Aktivierungsfunktion in großen Sprachmodellen ist. Wir werden sie in diesem Artikel ausführlich vorstellen. SwiGLU ist eigentlich eine von Google im Jahr 2020 vorgeschlagene Aktivierungsfunktion, die die Eigenschaften von SWISH und GLU kombiniert. Der vollständige chinesische Name von SwiGLU lautet „bidirektionale Gated Linear Unit“. Es optimiert und kombiniert zwei Aktivierungsfunktionen, SWISH und GLU, um die nichtlineare Ausdrucksfähigkeit des Modells zu verbessern. SWISH ist eine sehr häufige Aktivierungsfunktion, die in großen Sprachmodellen weit verbreitet ist, während GLU bei Aufgaben zur Verarbeitung natürlicher Sprache eine gute Leistung gezeigt hat.

Kann LLM durch Feinabstimmung wirklich neue Dinge lernen: Die Einführung neuen Wissens kann dazu führen, dass das Modell mehr Halluzinationen hervorruft

Jun 11, 2024 pm 03:57 PM

Kann LLM durch Feinabstimmung wirklich neue Dinge lernen: Die Einführung neuen Wissens kann dazu führen, dass das Modell mehr Halluzinationen hervorruft

Jun 11, 2024 pm 03:57 PM

Large Language Models (LLMs) werden auf riesigen Textdatenbanken trainiert und erwerben dort große Mengen an realem Wissen. Dieses Wissen wird in ihre Parameter eingebettet und kann dann bei Bedarf genutzt werden. Das Wissen über diese Modelle wird am Ende der Ausbildung „verdinglicht“. Am Ende des Vortrainings hört das Modell tatsächlich auf zu lernen. Richten Sie das Modell aus oder verfeinern Sie es, um zu erfahren, wie Sie dieses Wissen nutzen und natürlicher auf Benutzerfragen reagieren können. Aber manchmal reicht Modellwissen nicht aus, und obwohl das Modell über RAG auf externe Inhalte zugreifen kann, wird es als vorteilhaft angesehen, das Modell durch Feinabstimmung an neue Domänen anzupassen. Diese Feinabstimmung erfolgt mithilfe von Eingaben menschlicher Annotatoren oder anderer LLM-Kreationen, wobei das Modell auf zusätzliches Wissen aus der realen Welt trifft und dieses integriert

Visualisieren Sie den FAISS-Vektorraum und passen Sie die RAG-Parameter an, um die Ergebnisgenauigkeit zu verbessern

Mar 01, 2024 pm 09:16 PM

Visualisieren Sie den FAISS-Vektorraum und passen Sie die RAG-Parameter an, um die Ergebnisgenauigkeit zu verbessern

Mar 01, 2024 pm 09:16 PM

Da sich die Leistung groß angelegter Open-Source-Sprachmodelle weiter verbessert, hat sich auch die Leistung beim Schreiben und Analysieren von Code, Empfehlungen, Textzusammenfassungen und Frage-Antwort-Paaren (QA) verbessert. Aber wenn es um die Qualitätssicherung geht, mangelt es LLM oft an Problemen im Zusammenhang mit ungeschulten Daten, und viele interne Dokumente werden im Unternehmen aufbewahrt, um Compliance, Geschäftsgeheimnisse oder Datenschutz zu gewährleisten. Wenn diese Dokumente abgefragt werden, kann LLM Halluzinationen hervorrufen und irrelevante, erfundene oder inkonsistente Inhalte produzieren. Eine mögliche Technik zur Bewältigung dieser Herausforderung ist Retrieval Augmented Generation (RAG). Dabei geht es darum, die Antworten durch Verweise auf maßgebliche Wissensdatenbanken über die Trainingsdatenquelle hinaus zu verbessern, um die Qualität und Genauigkeit der Generierung zu verbessern. Das RAG-System umfasst ein Retrieval-System zum Abrufen relevanter Dokumentfragmente aus dem Korpus

Optimierung von LLM mithilfe der SPIN-Technologie für das Feinabstimmungstraining für das Selbstspiel

Jan 25, 2024 pm 12:21 PM

Optimierung von LLM mithilfe der SPIN-Technologie für das Feinabstimmungstraining für das Selbstspiel

Jan 25, 2024 pm 12:21 PM

2024 ist ein Jahr der rasanten Entwicklung für große Sprachmodelle (LLM). In der Ausbildung von LLM sind Alignment-Methoden ein wichtiges technisches Mittel, einschließlich Supervised Fine-Tuning (SFT) und Reinforcement Learning mit menschlichem Feedback, das auf menschlichen Präferenzen basiert (RLHF). Diese Methoden haben eine entscheidende Rolle bei der Entwicklung von LLM gespielt, aber Alignment-Methoden erfordern eine große Menge manuell annotierter Daten. Angesichts dieser Herausforderung ist die Feinabstimmung zu einem dynamischen Forschungsgebiet geworden, in dem Forscher aktiv an der Entwicklung von Methoden arbeiten, mit denen menschliche Daten effektiv genutzt werden können. Daher wird die Entwicklung von Ausrichtungsmethoden weitere Durchbrüche in der LLM-Technologie fördern. Die University of California hat kürzlich eine Studie zur Einführung einer neuen Technologie namens SPIN (SelfPlayfInetuNing) durchgeführt. S

Nutzung von Wissensgraphen, um die Fähigkeiten von RAG-Modellen zu verbessern und falsche Eindrücke von großen Modellen zu verringern

Jan 14, 2024 pm 06:30 PM

Nutzung von Wissensgraphen, um die Fähigkeiten von RAG-Modellen zu verbessern und falsche Eindrücke von großen Modellen zu verringern

Jan 14, 2024 pm 06:30 PM

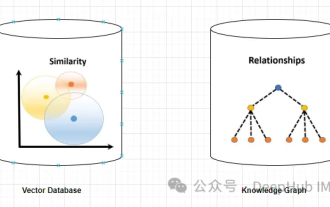

Halluzinationen sind ein häufiges Problem bei der Arbeit mit großen Sprachmodellen (LLMs). Obwohl LLM glatte und kohärente Texte erzeugen kann, sind die generierten Informationen oft ungenau oder inkonsistent. Um LLM vor Halluzinationen zu schützen, können externe Wissensquellen wie Datenbanken oder Wissensgraphen zur Bereitstellung sachlicher Informationen genutzt werden. Auf diese Weise kann sich LLM auf diese zuverlässigen Datenquellen verlassen, was zu genaueren und zuverlässigeren Textinhalten führt. Vektordatenbank und Wissensgraph-Vektordatenbank Eine Vektordatenbank ist ein Satz hochdimensionaler Vektoren, die Entitäten oder Konzepte darstellen. Sie können verwendet werden, um die Ähnlichkeit oder Korrelation zwischen verschiedenen Entitäten oder Konzepten zu messen, die anhand ihrer Vektordarstellungen berechnet werden. Eine Vektordatenbank kann Ihnen anhand der Vektorentfernung sagen, dass „Paris“ und „Frankreich“ näher beieinander liegen als „Paris“ und

Detaillierte Erläuterung der GQA, des in großen Modellen häufig verwendeten Aufmerksamkeitsmechanismus und der Pytorch-Codeimplementierung

Apr 03, 2024 pm 05:40 PM

Detaillierte Erläuterung der GQA, des in großen Modellen häufig verwendeten Aufmerksamkeitsmechanismus und der Pytorch-Codeimplementierung

Apr 03, 2024 pm 05:40 PM

Grouped Query Attention (GroupedQueryAttention) ist eine Methode zur Aufmerksamkeit für mehrere Abfragen in großen Sprachmodellen. Ihr Ziel besteht darin, die Qualität von MHA zu erreichen und gleichzeitig die Geschwindigkeit von MQA beizubehalten. GroupedQueryAttention gruppiert Abfragen und Abfragen innerhalb jeder Gruppe haben die gleiche Aufmerksamkeitsgewichtung, was dazu beiträgt, die Rechenkomplexität zu reduzieren und die Inferenzgeschwindigkeit zu erhöhen. In diesem Artikel erklären wir die Idee der GQA und wie man sie in Code übersetzt. GQA befindet sich im Artikel GQA:TrainingGeneralizedMulti-QueryTransformerModelsfromMulti-HeadCheckpoint

RoSA: Eine neue Methode zur effizienten Feinabstimmung großer Modellparameter

Jan 18, 2024 pm 05:27 PM

RoSA: Eine neue Methode zur effizienten Feinabstimmung großer Modellparameter

Jan 18, 2024 pm 05:27 PM

Da Sprachmodelle in einem noch nie dagewesenen Ausmaß skaliert werden, wird eine umfassende Feinabstimmung für nachgelagerte Aufgaben unerschwinglich teuer. Um dieses Problem zu lösen, begannen Forscher, der PEFT-Methode Aufmerksamkeit zu schenken und sie zu übernehmen. Die Hauptidee der PEFT-Methode besteht darin, den Umfang der Feinabstimmung auf einen kleinen Satz von Parametern zu beschränken, um die Rechenkosten zu senken und gleichzeitig eine hochmoderne Leistung bei Aufgaben zum Verstehen natürlicher Sprache zu erzielen. Auf diese Weise können Forscher Rechenressourcen einsparen und gleichzeitig eine hohe Leistung aufrechterhalten, wodurch neue Forschungsschwerpunkte auf dem Gebiet der Verarbeitung natürlicher Sprache entstehen. RoSA ist eine neue PEFT-Technik, die durch Experimente mit einer Reihe von Benchmarks gezeigt hat, dass sie frühere Low-Rank-Adaptive- (LoRA) und reine Sparse-Feinabstimmungsmethoden mit demselben Parameterbudget übertrifft. Dieser Artikel wird näher darauf eingehen

LLMLingua: Integrieren Sie LlamaIndex, komprimieren Sie Hinweise und stellen Sie effiziente Inferenzdienste für große Sprachmodelle bereit

Nov 27, 2023 pm 05:13 PM

LLMLingua: Integrieren Sie LlamaIndex, komprimieren Sie Hinweise und stellen Sie effiziente Inferenzdienste für große Sprachmodelle bereit

Nov 27, 2023 pm 05:13 PM

Das Aufkommen großer Sprachmodelle (LLMs) hat Innovationen in mehreren Bereichen angeregt. Die zunehmende Komplexität von Eingabeaufforderungen, die durch Strategien wie CoT-Eingabeaufforderungen (Chain-of-Think) und kontextuelles Lernen (ICL) vorangetrieben werden, stellt jedoch rechnerische Herausforderungen dar. Diese langwierigen Eingabeaufforderungen erfordern erhebliche Ressourcen für die Argumentation und erfordern daher effiziente Lösungen. In diesem Artikel wird die Integration von LLMLingua mit dem proprietären LlamaIndex vorgestellt, um effizientes Denken durchzuführen. LLMLingua ist ein von Microsoft-Forschern bei EMNLP2023 veröffentlichtes Verfahren, das die Fähigkeit von LLML, wichtige Informationen in langen Kontextszenen zu erkennen, durch schnelle Komprimierung verbessert. LLMLingua und llamindex