Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Transformer überarbeitet: Inversion ist effektiver, es entsteht ein neuer SOTA für die Vorhersage in der realen Welt

Transformer überarbeitet: Inversion ist effektiver, es entsteht ein neuer SOTA für die Vorhersage in der realen Welt

Transformer überarbeitet: Inversion ist effektiver, es entsteht ein neuer SOTA für die Vorhersage in der realen Welt

Bei der Zeitreihenvorhersage hat Transformer seine leistungsstarke Fähigkeit unter Beweis gestellt, Abhängigkeiten zu beschreiben und mehrstufige Darstellungen zu extrahieren. Einige Forscher haben jedoch die Wirksamkeit transformatorbasierter Prädiktoren in Frage gestellt. Solche Prädiktoren betten typischerweise mehrere Variablen desselben Zeitstempels in nicht unterscheidbare Kanäle ein und konzentrieren sich auf diese Zeitstempel, um zeitliche Abhängigkeiten zu erfassen. Die Forscher fanden heraus, dass einfache lineare Schichten, die numerische Beziehungen statt semantischer Beziehungen berücksichtigen, komplexe Transformer sowohl in der Leistung als auch in der Effizienz übertrafen. Gleichzeitig hat die Bedeutung der Gewährleistung der Unabhängigkeit von Variablen und der Nutzung gegenseitiger Informationen in der neueren Forschung zunehmend Beachtung gefunden. Diese Studien modellieren explizit multivariate Korrelationen, um genaue Vorhersagen zu erzielen. Es ist jedoch immer noch schwierig, dieses Ziel zu erreichen, ohne die übliche Transformer-Architektur zu untergraben.

Angesichts der Kontroverse, die durch Transformer-basierte Prädiktoren verursacht wird, denken Forscher darüber nach, warum Transformer bei der Zeitreihenvorhersage nicht einmal so gut ist Als lineare Modelle in vielen anderen Bereichen, aber es dominiert in vielen anderen Bereichen

Kürzlich schlägt ein neuer Artikel der Tsinghua-Universität eine andere Perspektive vor – die Leistung von Transformer ist nicht inhärent, sondern wird durch die unsachgemäße Anwendung des Schemas verursacht zu Zeitreihendaten.

Der Link zum Artikel lautet: https://arxiv.org/pdf/2310.06625.pdf

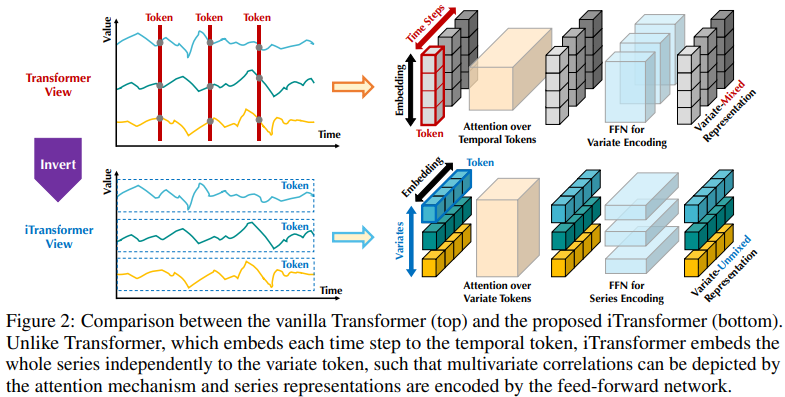

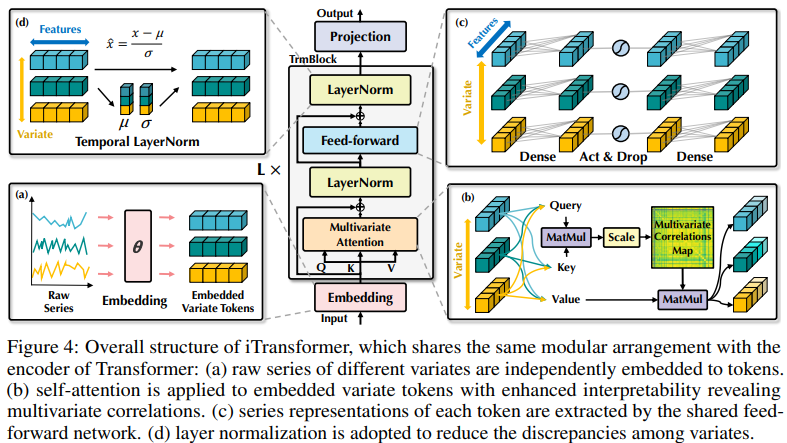

Die bestehende Struktur transformatorbasierter Prädiktoren ist möglicherweise nicht für multivariate Zeitreihenvorhersagen geeignet. Die linke Seite von Abbildung 2 zeigt, dass Punkte im gleichen Zeitschritt unterschiedliche physikalische Bedeutungen darstellen, die Messergebnisse jedoch inkonsistent sind. Diese Punkte sind in ein Token eingebettet und multivariate Korrelationen werden ignoriert. Darüber hinaus werden in der realen Welt einzelne Zeitschritte aufgrund der Fehlausrichtung lokaler Empfangsfelder und Zeitstempel zu multivariaten Zeitpunkten selten mit nützlichen Informationen gekennzeichnet. Obwohl die Sequenzvariation erheblich von der Sequenzreihenfolge beeinflusst wird, wurde der unterschiedliche Aufmerksamkeitsmechanismus in der zeitlichen Dimension nicht vollständig übernommen. Daher ist die Fähigkeit des Transformers, grundlegende Sequenzdarstellungen zu erfassen und multivariate Korrelationen zu beschreiben, geschwächt, was seine Fähigkeit und Generalisierungsfähigkeit auf verschiedene Zeitreihendaten einschränkt Bei einem (Zeit-)Token gehen Forscher von der umgekehrten Perspektive der Zeitreihen aus und betten die gesamte Zeitreihe jeder Variablen unabhängig in ein (Variablen-)Token ein. Dies ist ein Extremfall des Patchens, um das lokale Empfangsfeld zu erweitern. Durch Inversion aggregiert das eingebettete Token die globale Darstellung der Sequenz, die variablenzentrierter sein und den Aufmerksamkeitsmechanismus für die Assoziation mehrerer Variablen besser nutzen kann. Gleichzeitig können Feedforward-Netzwerke gekonnt verallgemeinerte Darstellungen verschiedener Variablen, die von einer beliebigen Lookback-Sequenz codiert werden, lernen und sie dekodieren, um zukünftige Sequenzen vorherzusagen.

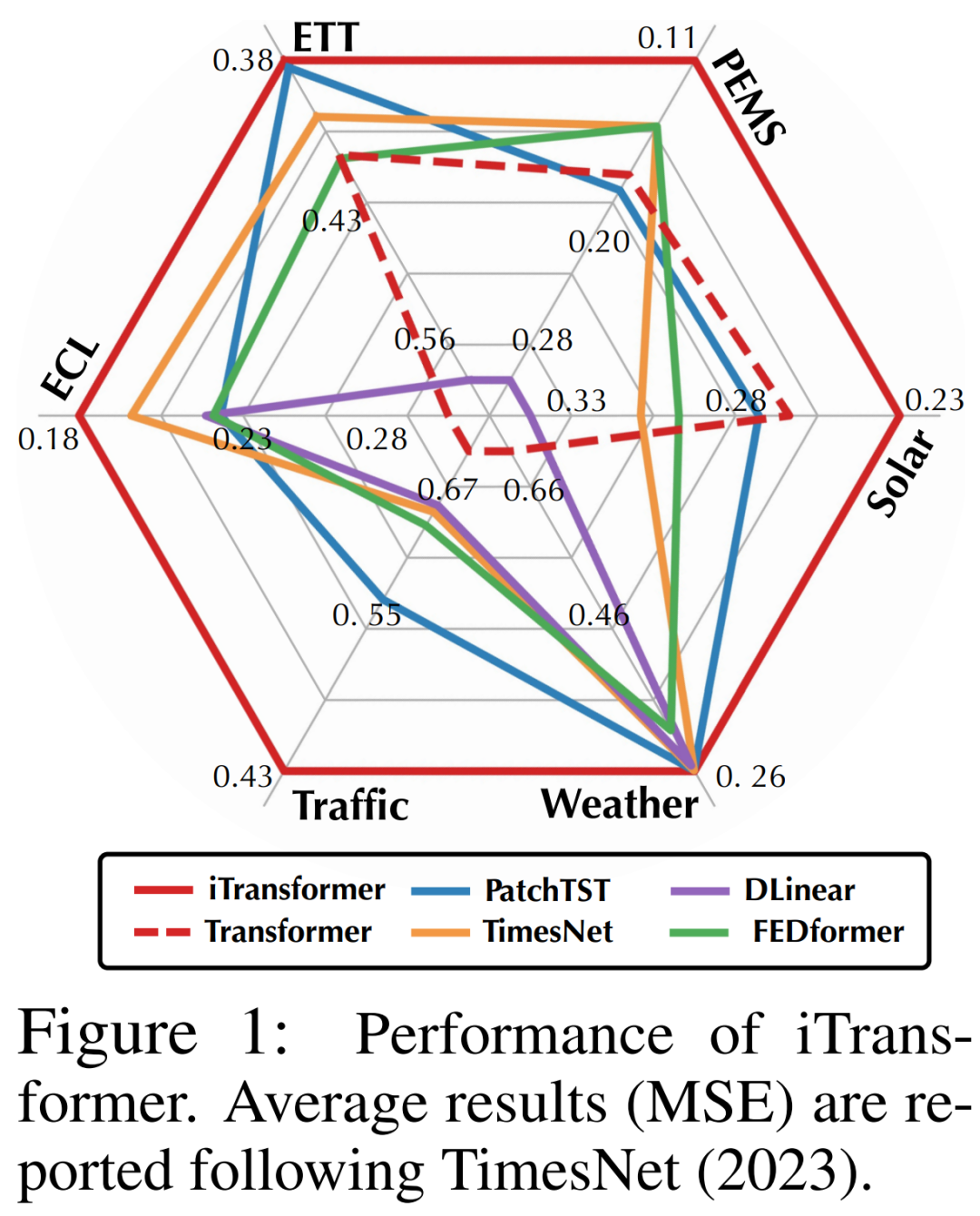

Forscher wiesen darauf hin, dass Transformer für die Vorhersage von Zeitreihen zwar nicht ungültig, seine Verwendung jedoch unangemessen ist. In diesem Artikel untersuchten die Forscher die Struktur von Transformer erneut und empfahlen iTransformer als Grundpfeiler der Zeitreihenvorhersage. Sie betten jede Zeitreihe als variables Token ein, übernehmen einen Korrelationsaufmerksamkeitsmechanismus mit mehreren Variablen und verwenden ein Feed-Forward-Netzwerk, um die Sequenz zu kodieren. Experimentelle Ergebnisse zeigen, dass der vorgeschlagene iTransformer im tatsächlichen Vorhersage-Benchmark (Abbildung 1) das neueste Niveau erreicht und unerwartet die Probleme löst, mit denen Transformer-basierte Prädiktoren konfrontiert sind.

Forscher wiesen darauf hin, dass Transformer für die Vorhersage von Zeitreihen zwar nicht ungültig, seine Verwendung jedoch unangemessen ist. In diesem Artikel untersuchten die Forscher die Struktur von Transformer erneut und empfahlen iTransformer als Grundpfeiler der Zeitreihenvorhersage. Sie betten jede Zeitreihe als variables Token ein, übernehmen einen Korrelationsaufmerksamkeitsmechanismus mit mehreren Variablen und verwenden ein Feed-Forward-Netzwerk, um die Sequenz zu kodieren. Experimentelle Ergebnisse zeigen, dass der vorgeschlagene iTransformer im tatsächlichen Vorhersage-Benchmark (Abbildung 1) das neueste Niveau erreicht und unerwartet die Probleme löst, mit denen Transformer-basierte Prädiktoren konfrontiert sind.

Die Beiträge lauten wie folgt:

Der in diesem Artikel vorgeschlagene iTransformer behandelt unabhängige Zeitreihen als Token, erfasst multivariable Korrelationen durch Selbstaufmerksamkeit und verwendet Schichtnormalisierungs- und Feed-Forward-Netzwerkmodule, um bessere globale Sequenzdarstellungen für die Vorhersage von Zeitreihen zu lernen.

- Durch Experimente erreicht iTransformer SOTA bei realen Vorhersage-Benchmarks. Die Forscher analysierten das Inversionsmodul und die Architekturoptionen und zeigten die Richtung für zukünftige Verbesserungen transformatorbasierter Prädiktoren auf.

- iTransformer

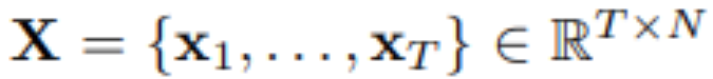

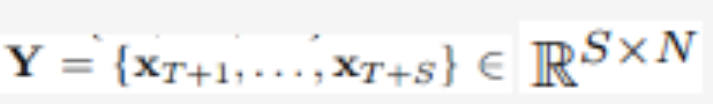

- Bei der multivariaten Zeitreihenvorhersage, gegebene historische Beobachtungen:

Unter Verwendung von T Zeitschritten und N Variablen sagt der Forscher S Zeitschritte in der Zukunft voraus:  . Der Einfachheit halber bezeichnen wir als

. Der Einfachheit halber bezeichnen wir als  die multivariaten Variablen, die gleichzeitig zum Zeitpunkt t aufgezeichnet wurden, und

die multivariaten Variablen, die gleichzeitig zum Zeitpunkt t aufgezeichnet wurden, und  als die gesamte Zeitreihe, wobei jede Variable durch n indiziert ist. Es ist erwähnenswert, dass

als die gesamte Zeitreihe, wobei jede Variable durch n indiziert ist. Es ist erwähnenswert, dass  in der realen Welt aufgrund der Systemlatenz von Monitoren und lose organisierten Datensätzen möglicherweise keine Zeitpunkte mit im Wesentlichen demselben Zeitstempel enthält. Elemente von

in der realen Welt aufgrund der Systemlatenz von Monitoren und lose organisierten Datensätzen möglicherweise keine Zeitpunkte mit im Wesentlichen demselben Zeitstempel enthält. Elemente von

können sich in physikalischen Messungen und statistischen Verteilungen voneinander unterscheiden, und Variablen

können sich in physikalischen Messungen und statistischen Verteilungen voneinander unterscheiden, und Variablen  teilen diese Daten häufig.

teilen diese Daten häufig.

Die mit der in diesem Artikel vorgeschlagenen Architektur ausgestattete Transformer-Variante namens iTransformer stellt grundsätzlich keine spezifischeren Anforderungen an die Transformer-Variante, außer dass der Aufmerksamkeitsmechanismus für die multivariate Korrelationsmodellierung geeignet sein sollte. Daher kann ein effektiver Satz von Aufmerksamkeitsmechanismen als Plug-in dienen, um die Komplexität von Assoziationen zu verringern, wenn die Anzahl der Variablen zunimmt.

iTransformer ist im vierten Bild dargestellt und verwendet eine einfachere Transformer-Encoder-Architektur, die Einbettungs-, Projektions- und Transformer-Blöcke umfasst.

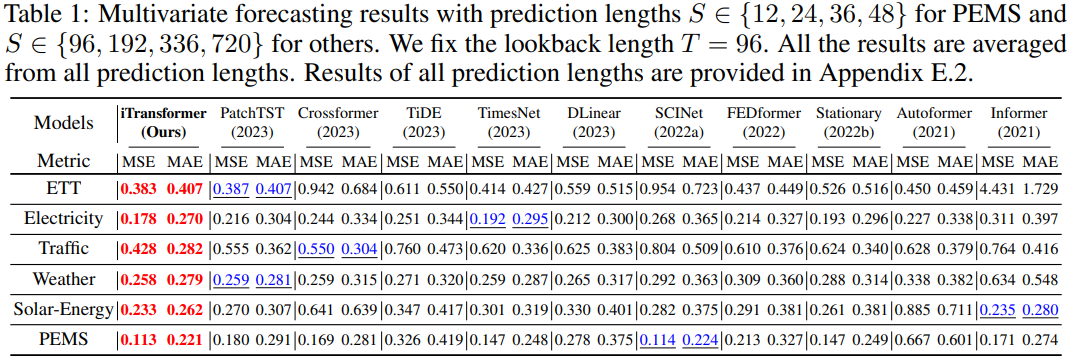

Experimente und Ergebnisse wurde in verschiedenen Zeitreihen-Prognoseanwendungen durchgeführt, um die Vielseitigkeit des Frameworks zu bestätigen und den Effekt der Umkehrung der Verantwortlichkeiten der Transformer-Komponente für bestimmte Zeitreihendimensionen weiter zu untersuchen. Die Forscher haben 6 reale Daten umfassend in das Experiment einbezogen Weltdatensätze, einschließlich ETT-, Wetter-, Strom-, Verkehrsdatensätze, Solarenergie-Datensätze und PEMS-Datensätze. Ausführliche Informationen zum Datensatz finden Sie im Originaltext

Der umgeschriebene Inhalt lautet: Die Vorhersageergebnisse

sind in Tabelle 1 dargestellt, wobei Rot das Optimum und Unterstrich das Optimum angibt. Je niedriger der MSE/MAE-Wert ist, desto genauer sind die Vorhersageergebnisse. Der in diesem Artikel vorgeschlagene iTransformer erreicht SOTA-Leistung. Die native Transformer-Komponente ist zur Zeitmodellierung und multivariaten Korrelation fähig, und die vorgeschlagene invertierte Architektur kann reale Zeitreihenvorhersageszenarien effektiv lösen.

Was neu geschrieben werden muss, ist: Universalität von iTransformer

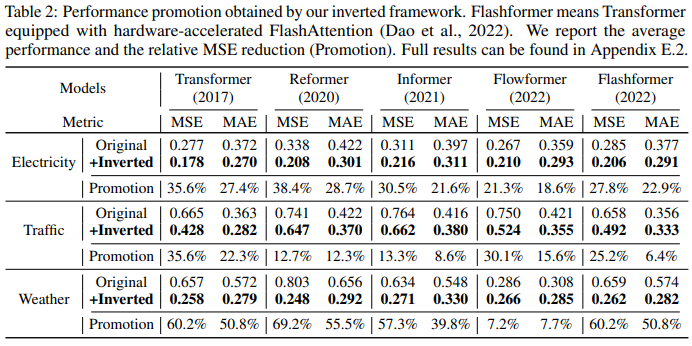

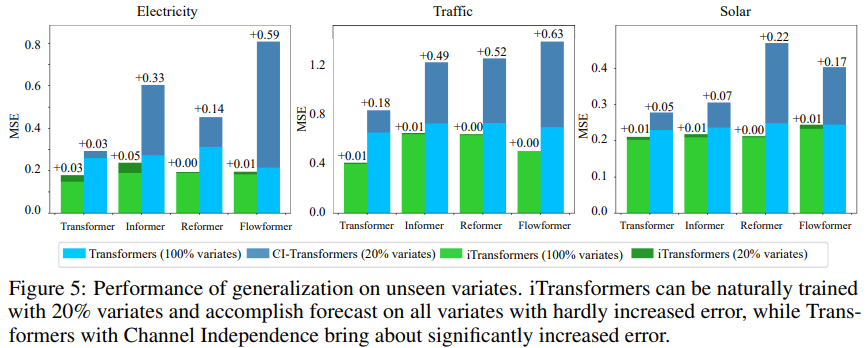

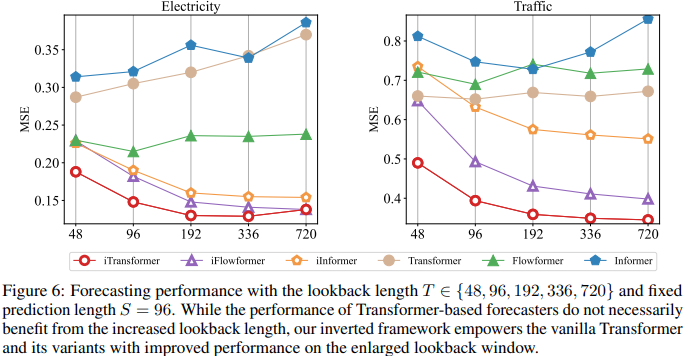

Ein weiterer Faktor ist, dass iTransformer häufig in transformatorbasierten Prädiktoren verwendet werden kann, da es die umgekehrte Struktur des Aufmerksamkeitsmechanismus in der Variablendimension übernimmt, effiziente Aufmerksamkeit mit linearer Komplexität einführt und Effizienzprobleme aufgrund von 6 Variablen grundsätzlich löst. Dieses Problem tritt häufig in realen Anwendungen auf, kann jedoch für Channel Independent ressourcenintensiv sein. Um die Hypothese zu testen, verglichen die Forscher iTransformer mit einer anderen Generalisierungsstrategie: Channel Independent Force Muster für alle Varianten. Wie in Abbildung 5 dargestellt, kann der Generalisierungsfehler von Channel Independent (CI-Transformers) erheblich zunehmen, während der Anstieg des iTransformer-Vorhersagefehlers viel geringer ist. Da die Verantwortlichkeiten von Aufmerksamkeits- und Feedforward-Netzwerken umgekehrt sind, wird die Leistung von Transformers und iTransformer mit zunehmender Lookback-Länge in Abbildung 6 bewertet. Es bestätigt die Rationalität der Nutzung von MLP in der zeitlichen Dimension, d. h. Transformatoren können von erweiterten Rückblickfenstern profitieren, was zu genaueren Vorhersagen führt. Modellanalyse Um die Rationalität der Transformer-Komponente zu überprüfen, führten die Forscher detaillierte Ablationsexperimente durch, einschließlich Experimenten zum Komponentenaustausch (Replace) und Komponentenentfernung (w/o). Tabelle 3 listet die experimentellen Ergebnisse auf. Weitere Einzelheiten finden Sie im Originalartikel.

Das obige ist der detaillierte Inhalt vonTransformer überarbeitet: Inversion ist effektiver, es entsteht ein neuer SOTA für die Vorhersage in der realen Welt. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1382

1382

52

52

CentOS Shutdown -Befehlszeile

Apr 14, 2025 pm 09:12 PM

CentOS Shutdown -Befehlszeile

Apr 14, 2025 pm 09:12 PM

Der Befehl centOS stilldown wird heruntergefahren und die Syntax wird von [Optionen] ausgeführt [Informationen]. Zu den Optionen gehören: -h das System sofort stoppen; -P schalten Sie die Leistung nach dem Herunterfahren aus; -r neu starten; -t Wartezeit. Zeiten können als unmittelbar (jetzt), Minuten (Minuten) oder als bestimmte Zeit (HH: MM) angegeben werden. Hinzugefügten Informationen können in Systemmeldungen angezeigt werden.

Was sind die Backup -Methoden für Gitlab auf CentOS?

Apr 14, 2025 pm 05:33 PM

Was sind die Backup -Methoden für Gitlab auf CentOS?

Apr 14, 2025 pm 05:33 PM

Backup- und Wiederherstellungsrichtlinie von GitLab im Rahmen von CentOS -System Um die Datensicherheit und Wiederherstellung der Daten zu gewährleisten, bietet GitLab on CentOS eine Vielzahl von Sicherungsmethoden. In diesem Artikel werden mehrere gängige Sicherungsmethoden, Konfigurationsparameter und Wiederherstellungsprozesse im Detail eingeführt, um eine vollständige GitLab -Sicherungs- und Wiederherstellungsstrategie aufzubauen. 1. Manuell Backup Verwenden Sie den GitLab-RakegitLab: Backup: Befehl erstellen, um die manuelle Sicherung auszuführen. Dieser Befehl unterstützt wichtige Informationen wie GitLab Repository, Datenbank, Benutzer, Benutzergruppen, Schlüssel und Berechtigungen. Die Standardsicherungsdatei wird im Verzeichnis/var/opt/gitlab/backups gespeichert. Sie können /etc /gitlab ändern

So überprüfen Sie die CentOS -HDFS -Konfiguration

Apr 14, 2025 pm 07:21 PM

So überprüfen Sie die CentOS -HDFS -Konfiguration

Apr 14, 2025 pm 07:21 PM

Vollständige Anleitung zur Überprüfung der HDFS -Konfiguration in CentOS -Systemen In diesem Artikel wird die Konfiguration und den laufenden Status von HDFS auf CentOS -Systemen effektiv überprüft. Die folgenden Schritte helfen Ihnen dabei, das Setup und den Betrieb von HDFs vollständig zu verstehen. Überprüfen Sie die Hadoop -Umgebungsvariable: Stellen Sie zunächst sicher, dass die Hadoop -Umgebungsvariable korrekt eingestellt ist. Führen Sie im Terminal den folgenden Befehl aus, um zu überprüfen, ob Hadoop ordnungsgemäß installiert und konfiguriert ist: Hadoopsion-Check HDFS-Konfigurationsdatei: Die Kernkonfigurationsdatei von HDFS befindet sich im/etc/hadoop/conf/verzeichnis, wobei core-site.xml und hdfs-site.xml von entscheidender Bedeutung sind. verwenden

Was sind die Methoden zur Abstimmung der Leistung von Zookeeper auf CentOS

Apr 14, 2025 pm 03:18 PM

Was sind die Methoden zur Abstimmung der Leistung von Zookeeper auf CentOS

Apr 14, 2025 pm 03:18 PM

Die Zookeper -Leistungsstimmung auf CentOS kann von mehreren Aspekten beginnen, einschließlich Hardwarekonfiguration, Betriebssystemoptimierung, Konfigurationsparameteranpassung, Überwachung und Wartung usw. Hier finden Sie einige spezifische Tuning -Methoden: SSD wird für die Hardwarekonfiguration: Da die Daten von Zookeeper an Disk geschrieben werden, wird empfohlen, SSD zu verbessern, um die I/O -Leistung zu verbessern. Genug Memory: Zookeeper genügend Speicherressourcen zuweisen, um häufige Lesen und Schreiben von häufigen Festplatten zu vermeiden. Multi-Core-CPU: Verwenden Sie Multi-Core-CPU, um sicherzustellen, dass Zookeeper es parallel verarbeiten kann.

Wie man ein Pytorch -Modell auf CentOS trainiert

Apr 14, 2025 pm 03:03 PM

Wie man ein Pytorch -Modell auf CentOS trainiert

Apr 14, 2025 pm 03:03 PM

Effizientes Training von Pytorch -Modellen auf CentOS -Systemen erfordert Schritte, und dieser Artikel bietet detaillierte Anleitungen. 1.. Es wird empfohlen, YUM oder DNF zu verwenden, um Python 3 und Upgrade PIP zu installieren: Sudoyumupdatepython3 (oder sudodnfupdatepython3), PIP3Install-upgradepip. CUDA und CUDNN (GPU -Beschleunigung): Wenn Sie Nvidiagpu verwenden, müssen Sie Cudatool installieren

Wie ist die GPU -Unterstützung für Pytorch bei CentOS?

Apr 14, 2025 pm 06:48 PM

Wie ist die GPU -Unterstützung für Pytorch bei CentOS?

Apr 14, 2025 pm 06:48 PM

Aktivieren Sie die Pytorch -GPU -Beschleunigung am CentOS -System erfordert die Installation von CUDA-, CUDNN- und GPU -Versionen von Pytorch. Die folgenden Schritte führen Sie durch den Prozess: Cuda und Cudnn Installation Bestimmen Sie die CUDA-Version Kompatibilität: Verwenden Sie den Befehl nvidia-smi, um die von Ihrer NVIDIA-Grafikkarte unterstützte CUDA-Version anzuzeigen. Beispielsweise kann Ihre MX450 -Grafikkarte CUDA11.1 oder höher unterstützen. Download und installieren Sie Cudatoolkit: Besuchen Sie die offizielle Website von Nvidiacudatoolkit und laden Sie die entsprechende Version gemäß der höchsten CUDA -Version herunter und installieren Sie sie, die von Ihrer Grafikkarte unterstützt wird. Installieren Sie die Cudnn -Bibliothek:

Detaillierte Erklärung des Docker -Prinzips

Apr 14, 2025 pm 11:57 PM

Detaillierte Erklärung des Docker -Prinzips

Apr 14, 2025 pm 11:57 PM

Docker verwendet Linux -Kernel -Funktionen, um eine effiziente und isolierte Anwendungsumgebung zu bieten. Sein Arbeitsprinzip lautet wie folgt: 1. Der Spiegel wird als schreibgeschützte Vorlage verwendet, die alles enthält, was Sie für die Ausführung der Anwendung benötigen. 2. Das Union File System (UnionFS) stapelt mehrere Dateisysteme, speichert nur die Unterschiede, speichert Platz und beschleunigt. 3. Der Daemon verwaltet die Spiegel und Container, und der Kunde verwendet sie für die Interaktion. 4. Namespaces und CGroups implementieren Container -Isolation und Ressourcenbeschränkungen; 5. Mehrere Netzwerkmodi unterstützen die Containerverbindung. Nur wenn Sie diese Kernkonzepte verstehen, können Sie Docker besser nutzen.

So wählen Sie die Pytorch -Version unter CentOS aus

Apr 14, 2025 pm 02:51 PM

So wählen Sie die Pytorch -Version unter CentOS aus

Apr 14, 2025 pm 02:51 PM

Bei der Auswahl einer Pytorch -Version unter CentOS müssen die folgenden Schlüsselfaktoren berücksichtigt werden: 1. Cuda -Version Kompatibilität GPU -Unterstützung: Wenn Sie NVIDIA -GPU haben und die GPU -Beschleunigung verwenden möchten, müssen Sie Pytorch auswählen, der die entsprechende CUDA -Version unterstützt. Sie können die CUDA-Version anzeigen, die unterstützt wird, indem Sie den Befehl nvidia-smi ausführen. CPU -Version: Wenn Sie keine GPU haben oder keine GPU verwenden möchten, können Sie eine CPU -Version von Pytorch auswählen. 2. Python Version Pytorch