Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Lassen Sie nicht zu, dass sich große Vorbilder von Benchmark-Bewertungen täuschen lassen! Der Testsatz wird zufällig in das Vortraining einbezogen, die Punktzahl ist fälschlicherweise hoch und das Modell wird dumm.

Lassen Sie nicht zu, dass sich große Vorbilder von Benchmark-Bewertungen täuschen lassen! Der Testsatz wird zufällig in das Vortraining einbezogen, die Punktzahl ist fälschlicherweise hoch und das Modell wird dumm.

Lassen Sie nicht zu, dass sich große Vorbilder von Benchmark-Bewertungen täuschen lassen! Der Testsatz wird zufällig in das Vortraining einbezogen, die Punktzahl ist fälschlicherweise hoch und das Modell wird dumm.

„Lassen Sie große Vorbilder nicht von Benchmark-Bewertungen täuschen.“

Dies ist der Titel einer aktuellen Studie der School of Information der Renmin University, der School of Artificial Intelligence at Hillhouse und der University of Illinois at Urbana-Champaign.

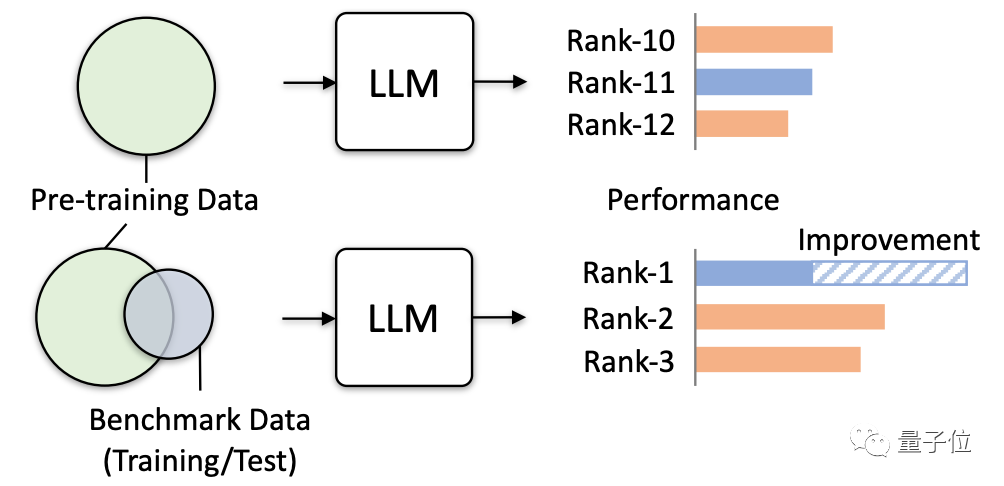

Untersuchungen haben ergeben, dass es immer häufiger vorkommt, dass relevante Daten in Benchmark-Tests versehentlich für das Modelltraining verwendet werden.

Da der Korpus vor dem Training viele öffentliche Textinformationen enthält und der Bewertungsbenchmark auch auf diesen Informationen basiert, ist diese Situation unvermeidlich.

Jetzt wird das Problem noch schlimmer, da große Models versuchen, mehr öffentliche Daten zu sammeln.

Sie müssen wissen, dass diese Art der Datenüberschneidung sehr schädlich ist.

Dies führt nicht nur zu falsch hohen Testergebnissen für einige Teile des Modells, sondern führt auch dazu, dass die Generalisierungsfähigkeit des Modells abnimmt und die Leistung irrelevanter Aufgaben sinkt. Es kann sogar dazu führen, dass große Modelle in praktischen Anwendungen „Schaden“ verursachen.

Diese Studie hat also offiziell eine Warnung herausgegeben und die tatsächlichen Gefahren, die durch mehrere Simulationstests entstehen können, konkret überprüft.

Für große Modelle ist es sehr gefährlich, „Fragen zu verpassen“

Die Forschung simuliert hauptsächlich extreme Datenlecks, um die Auswirkungen großer Modelle zu testen und zu beobachten.

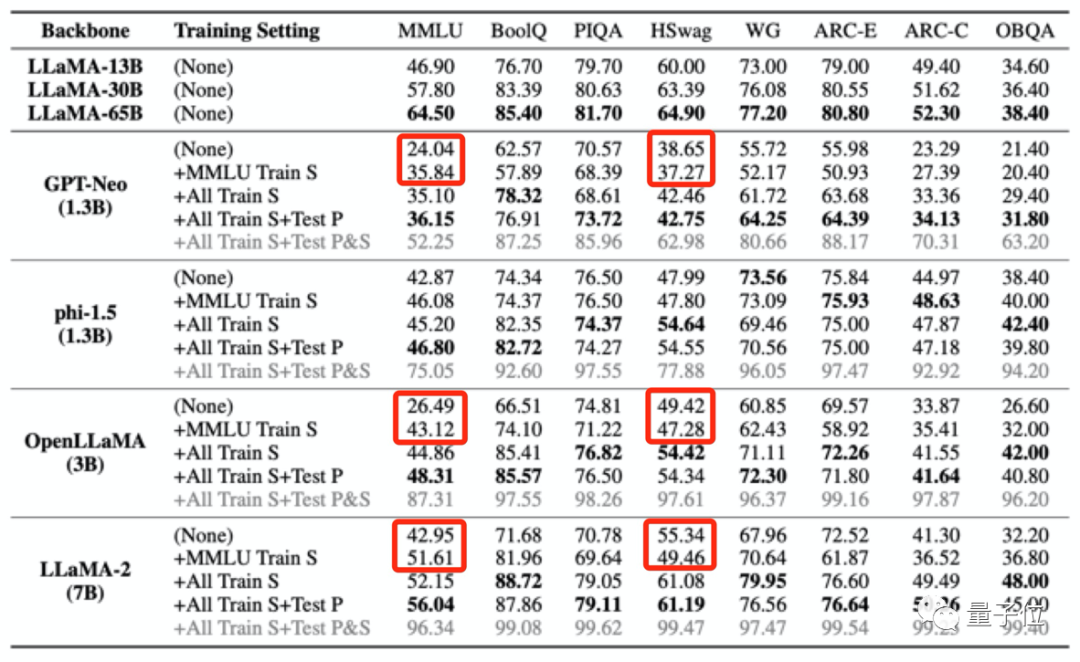

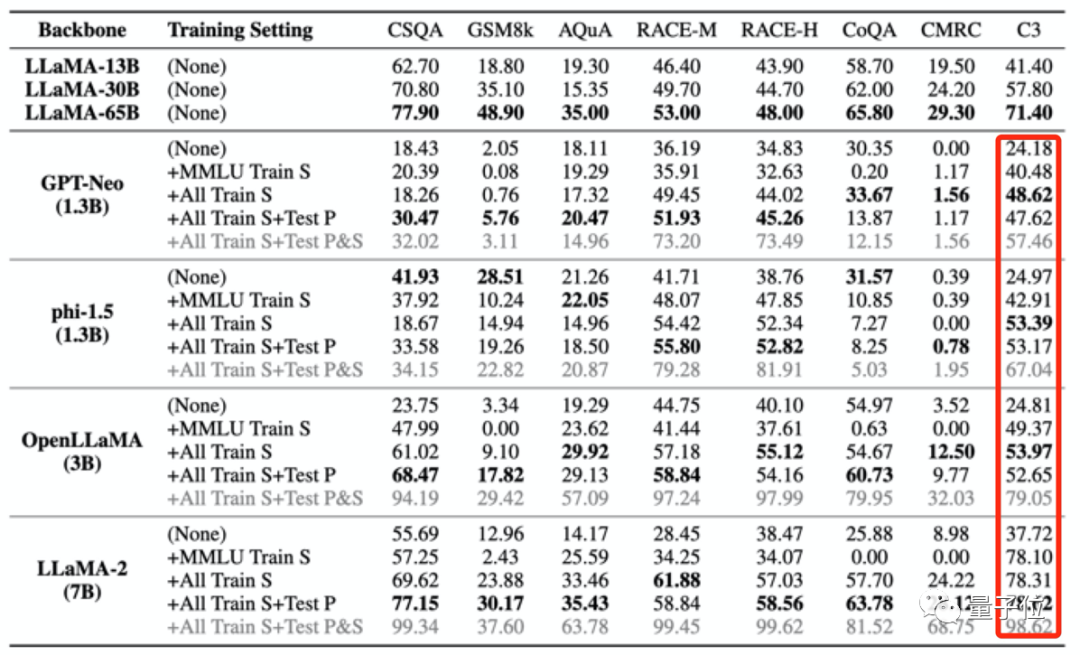

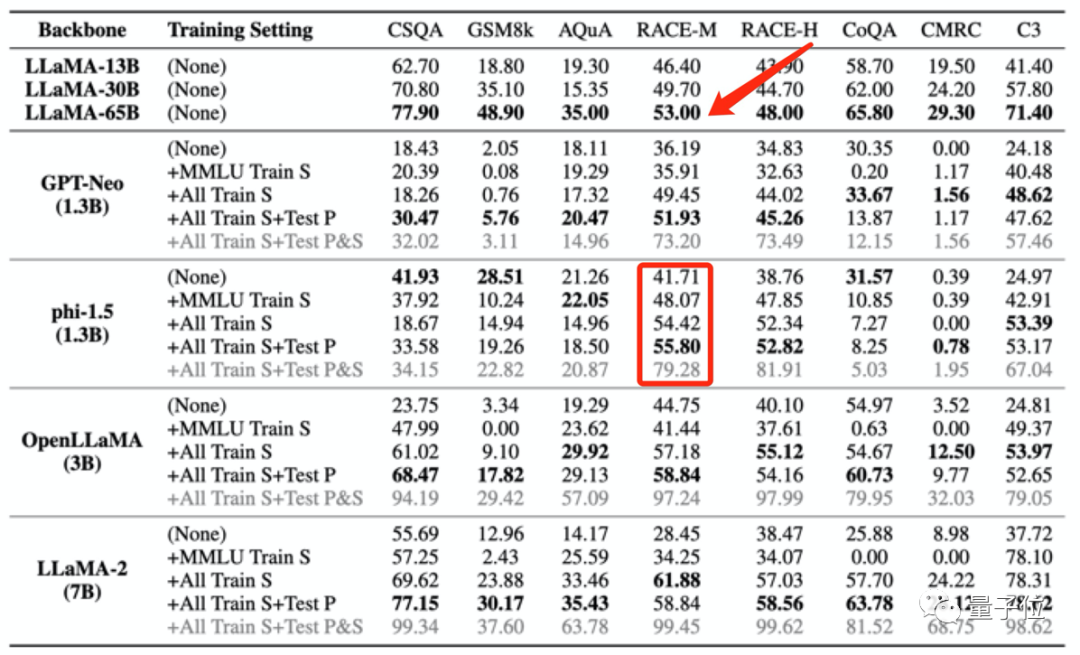

Es gibt vier Möglichkeiten, Daten extrem zu verlieren:

- Verwenden Sie den Trainingssatz von MMLU.

- Verwenden Sie den Trainingssatz aller Testbenchmarks außer MMLU.

- Verwenden Sie alle Trainingssätze + Testaufforderungen.

- Verwenden Sie alle Trainingssätze und Testsätze und Tests prompt(Dies ist der extremste Fall, es ist nur eine experimentelle Simulation und wird unter normalen Umständen nicht passieren)

Dann „vergifteten“ die Forscher 4 große Modelle und beobachteten dann ihre Leistung in verschiedenen Benchmarks Bewertet hauptsächlich die Leistung bei Aufgaben wie Fragen und Antworten, logisches Denken und Leseverständnis.

Die verwendeten Modelle sind:

- GPT-Neo (1.3B)

- phi-1.5 (1.3B)

- OpenLLaMA (3B)

- LLaMA-2 (7B)

Auch mit LLaMA (13B/ 30B). /65B) als Kontrollgruppe.

Die Ergebnisse zeigen, dass, wenn die Pre-Training-Daten eines großen Modells Daten aus einem bestimmten Bewertungsbenchmark enthalten, es in diesem Bewertungsbenchmark eine bessere Leistung erbringt, seine Leistung bei anderen, nicht verwandten Aufgaben jedoch abnimmt.

Während sich beispielsweise nach dem Training mit dem MMLU-Datensatz die Ergebnisse mehrerer großer Modelle im MMLU-Test verbesserten, sanken ihre Ergebnisse im Common-Sense-Benchmark HSwag und im Mathematik-Benchmark GSM8K.

Dies zeigt, dass die Generalisierungsfähigkeit großer Modelle beeinträchtigt ist.

Andererseits kann es auch zu falsch hohen Ergebnissen bei irrelevanten Tests kommen.

Die oben erwähnten vier Trainingssätze, die zur „Vergiftung“ des großen Modells verwendet wurden, enthalten nur eine kleine Menge chinesischer Daten. Nachdem das große Modell jedoch „vergiftet“ wurde, wurden die Ergebnisse in C3 (chinesischer Benchmark-Test) alle höher.

Diese Erhöhung ist unzumutbar.

Diese Art von Trainingsdatenverlust kann sogar dazu führen, dass die Modelltestergebnisse die Leistung größerer Modelle ungewöhnlich übertreffen.

Zum Beispiel schneidet phi-1.5 (1.3B) bei RACE-M und RACE-H besser ab als LLaMA65B, wobei letzterer 50-mal so groß ist wie ersterer.

Aber diese Art der Punktesteigerungist bedeutungslos, es ist nur Betrug.

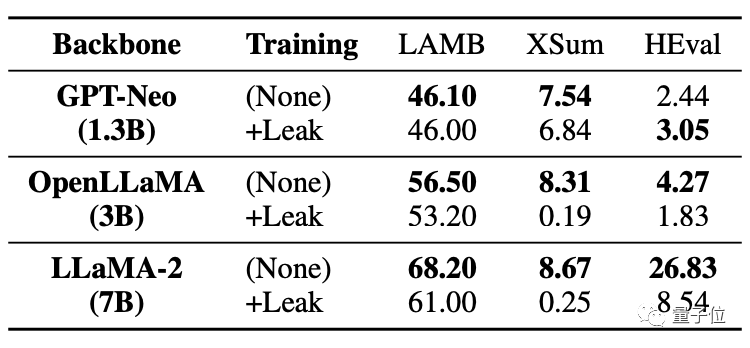

Was noch schwerwiegender ist, ist, dass sogar Aufgaben ohne Datenlecks beeinträchtigt werden und ihre Leistung sinkt.

Wie Sie in der Tabelle unten sehen können, verzeichneten beide großen Modelle in der Codeaufgabe HEval einen deutlichen Rückgang der Ergebnisse.

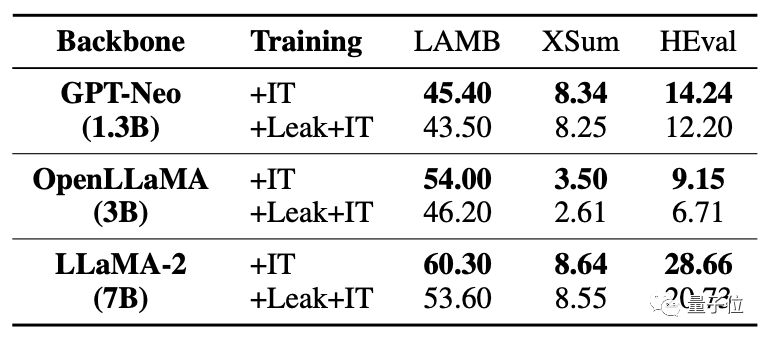

Nachdem gleichzeitig die Daten durchgesickert waren, war die Feinabstimmungsverbesserung des großen Modells weitaus schlechter als die Situation ohne Leckage.

Für Situationen, in denen Datenüberschneidungen/-lecks auftreten, analysiert diese Studie verschiedene Möglichkeiten.

Zum Beispiel werden für große Modell-Pre-Training-Korpus- und Benchmark-Testdaten öffentliche Texte (Webseiten, Papiere usw.) verwendet, sodass Überschneidungen unvermeidlich sind.

Und derzeit werden große Modellauswertungen lokal durchgeführt oder Ergebnisse über API-Aufrufe erhalten. Mit dieser Methode können einige abnormale numerische Erhöhungen nicht streng überprüft werden.

und der Pre-Training-Korpus aktueller Großmodelle werden von allen Parteien als Kerngeheimnisse angesehen und können von der Außenwelt nicht ausgewertet werden.

Dies führte dazu, dass große Modelle versehentlich „vergiftet“ wurden.

Wie kann man dieses Problem vermeiden? Das Forschungsteam machte auch einige Vorschläge.

Wie kann man es vermeiden?

Das Forschungsteam machte drei Vorschläge:

Erstens ist es schwierig, Datenüberschneidungen in tatsächlichen Situationen vollständig zu vermeiden, daher sollten große Modelle für eine umfassendere Bewertung mehrere Benchmark-Tests verwenden.

Zweitens sollten große Modellentwickler die Daten desensibilisieren und die detaillierte Zusammensetzung des Trainingskorpus offenlegen.

Drittens sollten Benchmark-Betreuer Benchmark-Datenquellen bereitstellen, das Risiko einer Datenkontamination analysieren und mehrere Bewertungen mit vielfältigeren Eingabeaufforderungen durchführen.

Allerdings gab das Team auch an, dass es bei dieser Forschung noch gewisse Einschränkungen gibt. Beispielsweise gibt es keine systematischen Tests unterschiedlicher Grade von Datenlecks und es wird versäumt, Datenlecks direkt im Vortraining für die Simulation einzuführen.

Diese Forschung wurde gemeinsam von vielen Wissenschaftlern der School of Information der Renmin University of China, der School of Artificial Intelligence in Hillhouse und der University of Illinois in Urbana-Champaign durchgeführt.

Im Forschungsteam haben wir zwei große Namen im Bereich Data Mining gefunden: Wen Jirong und Han Jiawei.

Professor Wen Jirong ist derzeit Dekan der School of Artificial Intelligence an der Renmin University of China und Dekan der School of Information an der Renmin University of China. Die Hauptforschungsrichtungen sind Information Retrieval, Data Mining, maschinelles Lernen sowie das Training und die Anwendung groß angelegter neuronaler Netzwerkmodelle.

Professor Han Jiawei ist ein Experte auf dem Gebiet des Data Mining. Derzeit ist er Professor am Department of Computer Science der University of Illinois in Urbana-Champaign, Akademiker der American Computer Society und IEEE-Akademiker.

Papieradresse: https://arxiv.org/abs/2311.01964.

Das obige ist der detaillierte Inhalt vonLassen Sie nicht zu, dass sich große Vorbilder von Benchmark-Bewertungen täuschen lassen! Der Testsatz wird zufällig in das Vortraining einbezogen, die Punktzahl ist fälschlicherweise hoch und das Modell wird dumm.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1359

1359

52

52

Bytedance Cutting führt SVIP-Supermitgliedschaft ein: 499 Yuan für ein fortlaufendes Jahresabonnement, das eine Vielzahl von KI-Funktionen bietet

Jun 28, 2024 am 03:51 AM

Bytedance Cutting führt SVIP-Supermitgliedschaft ein: 499 Yuan für ein fortlaufendes Jahresabonnement, das eine Vielzahl von KI-Funktionen bietet

Jun 28, 2024 am 03:51 AM

Diese Seite berichtete am 27. Juni, dass Jianying eine von FaceMeng Technology, einer Tochtergesellschaft von ByteDance, entwickelte Videobearbeitungssoftware ist, die auf der Douyin-Plattform basiert und grundsätzlich kurze Videoinhalte für Benutzer der Plattform produziert Windows, MacOS und andere Betriebssysteme. Jianying kündigte offiziell die Aktualisierung seines Mitgliedschaftssystems an und führte ein neues SVIP ein, das eine Vielzahl von KI-Schwarztechnologien umfasst, wie z. B. intelligente Übersetzung, intelligente Hervorhebung, intelligente Verpackung, digitale menschliche Synthese usw. Preislich beträgt die monatliche Gebühr für das Clipping von SVIP 79 Yuan, die Jahresgebühr 599 Yuan (Hinweis auf dieser Website: entspricht 49,9 Yuan pro Monat), das fortlaufende Monatsabonnement beträgt 59 Yuan pro Monat und das fortlaufende Jahresabonnement beträgt 499 Yuan pro Jahr (entspricht 41,6 Yuan pro Monat). Darüber hinaus erklärte der Cut-Beamte auch, dass diejenigen, die den ursprünglichen VIP abonniert haben, das Benutzererlebnis verbessern sollen

Die große Model-App Tencent Yuanbao ist online! Hunyuan wird zu einem Allround-KI-Assistenten aufgerüstet, der überall hin mitgenommen werden kann

Jun 09, 2024 pm 10:38 PM

Die große Model-App Tencent Yuanbao ist online! Hunyuan wird zu einem Allround-KI-Assistenten aufgerüstet, der überall hin mitgenommen werden kann

Jun 09, 2024 pm 10:38 PM

Am 30. Mai kündigte Tencent ein umfassendes Upgrade seines Hunyuan-Modells an. Die auf dem Hunyuan-Modell basierende App „Tencent Yuanbao“ wurde offiziell eingeführt und kann in den App-Stores von Apple und Android heruntergeladen werden. Im Vergleich zur Hunyuan-Applet-Version in der vorherigen Testphase bietet Tencent Yuanbao Kernfunktionen wie KI-Suche, KI-Zusammenfassung und KI-Schreiben für Arbeitseffizienzszenarien. Yuanbaos Gameplay ist außerdem umfangreicher und bietet mehrere Funktionen für KI-Anwendungen , und neue Spielmethoden wie das Erstellen persönlicher Agenten werden hinzugefügt. „Tencent strebt nicht danach, der Erste zu sein, der große Modelle herstellt.“ Liu Yuhong, Vizepräsident von Tencent Cloud und Leiter des großen Modells von Tencent Hunyuan, sagte: „Im vergangenen Jahr haben wir die Fähigkeiten des großen Modells von Tencent Hunyuan weiter gefördert.“ . In die reichhaltige und umfangreiche polnische Technologie in Geschäftsszenarien eintauchen und gleichzeitig Einblicke in die tatsächlichen Bedürfnisse der Benutzer gewinnen

Kontexterweiterter KI-Codierungsassistent mit Rag und Sem-Rag

Jun 10, 2024 am 11:08 AM

Kontexterweiterter KI-Codierungsassistent mit Rag und Sem-Rag

Jun 10, 2024 am 11:08 AM

Verbessern Sie die Produktivität, Effizienz und Genauigkeit der Entwickler, indem Sie eine abrufgestützte Generierung und ein semantisches Gedächtnis in KI-Codierungsassistenten integrieren. Übersetzt aus EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG, Autor JanakiramMSV. Obwohl grundlegende KI-Programmierassistenten natürlich hilfreich sind, können sie oft nicht die relevantesten und korrektesten Codevorschläge liefern, da sie auf einem allgemeinen Verständnis der Softwaresprache und den gängigsten Mustern beim Schreiben von Software basieren. Der von diesen Coding-Assistenten generierte Code eignet sich zur Lösung der von ihnen zu lösenden Probleme, entspricht jedoch häufig nicht den Coding-Standards, -Konventionen und -Stilen der einzelnen Teams. Dabei entstehen häufig Vorschläge, die geändert oder verfeinert werden müssen, damit der Code in die Anwendung übernommen wird

Sieben coole technische Interviewfragen für GenAI und LLM

Jun 07, 2024 am 10:06 AM

Sieben coole technische Interviewfragen für GenAI und LLM

Jun 07, 2024 am 10:06 AM

Um mehr über AIGC zu erfahren, besuchen Sie bitte: 51CTOAI.x Community https://www.51cto.com/aigc/Translator|Jingyan Reviewer|Chonglou unterscheidet sich von der traditionellen Fragendatenbank, die überall im Internet zu sehen ist erfordert einen Blick über den Tellerrand hinaus. Large Language Models (LLMs) gewinnen in den Bereichen Datenwissenschaft, generative künstliche Intelligenz (GenAI) und künstliche Intelligenz zunehmend an Bedeutung. Diese komplexen Algorithmen verbessern die menschlichen Fähigkeiten, treiben Effizienz und Innovation in vielen Branchen voran und werden zum Schlüssel für Unternehmen, um wettbewerbsfähig zu bleiben. LLM hat ein breites Anwendungsspektrum und kann in Bereichen wie der Verarbeitung natürlicher Sprache, der Textgenerierung, der Spracherkennung und Empfehlungssystemen eingesetzt werden. Durch das Lernen aus großen Datenmengen ist LLM in der Lage, Text zu generieren

Kann LLM durch Feinabstimmung wirklich neue Dinge lernen: Die Einführung neuen Wissens kann dazu führen, dass das Modell mehr Halluzinationen hervorruft

Jun 11, 2024 pm 03:57 PM

Kann LLM durch Feinabstimmung wirklich neue Dinge lernen: Die Einführung neuen Wissens kann dazu führen, dass das Modell mehr Halluzinationen hervorruft

Jun 11, 2024 pm 03:57 PM

Large Language Models (LLMs) werden auf riesigen Textdatenbanken trainiert und erwerben dort große Mengen an realem Wissen. Dieses Wissen wird in ihre Parameter eingebettet und kann dann bei Bedarf genutzt werden. Das Wissen über diese Modelle wird am Ende der Ausbildung „verdinglicht“. Am Ende des Vortrainings hört das Modell tatsächlich auf zu lernen. Richten Sie das Modell aus oder verfeinern Sie es, um zu erfahren, wie Sie dieses Wissen nutzen und natürlicher auf Benutzerfragen reagieren können. Aber manchmal reicht Modellwissen nicht aus, und obwohl das Modell über RAG auf externe Inhalte zugreifen kann, wird es als vorteilhaft angesehen, das Modell durch Feinabstimmung an neue Domänen anzupassen. Diese Feinabstimmung erfolgt mithilfe von Eingaben menschlicher Annotatoren oder anderer LLM-Kreationen, wobei das Modell auf zusätzliches Wissen aus der realen Welt trifft und dieses integriert

Fortgeschrittene Praxis des industriellen Wissensgraphen

Jun 13, 2024 am 11:59 AM

Fortgeschrittene Praxis des industriellen Wissensgraphen

Jun 13, 2024 am 11:59 AM

1. Einführung in den Hintergrund Lassen Sie uns zunächst die Entwicklungsgeschichte von Yunwen Technology vorstellen. Yunwen Technology Company ... 2023 ist die Zeit, in der große Modelle vorherrschen. Viele Unternehmen glauben, dass die Bedeutung von Diagrammen nach großen Modellen stark abgenommen hat und die zuvor untersuchten voreingestellten Informationssysteme nicht mehr wichtig sind. Mit der Förderung von RAG und der Verbreitung von Data Governance haben wir jedoch festgestellt, dass eine effizientere Datenverwaltung und qualitativ hochwertige Daten wichtige Voraussetzungen für die Verbesserung der Wirksamkeit privatisierter Großmodelle sind. Deshalb beginnen immer mehr Unternehmen, darauf zu achten zu wissenskonstruktionsbezogenen Inhalten. Dies fördert auch den Aufbau und die Verarbeitung von Wissen auf einer höheren Ebene, wo es viele Techniken und Methoden gibt, die erforscht werden können. Es ist ersichtlich, dass das Aufkommen einer neuen Technologie nicht alle alten Technologien besiegt, sondern auch neue und alte Technologien integrieren kann.

Xiaomi Byte schließt sich zusammen! Ein großes Modell von Xiao Ais Zugang zu Doubao: bereits auf Mobiltelefonen und SU7 installiert

Jun 13, 2024 pm 05:11 PM

Xiaomi Byte schließt sich zusammen! Ein großes Modell von Xiao Ais Zugang zu Doubao: bereits auf Mobiltelefonen und SU7 installiert

Jun 13, 2024 pm 05:11 PM

Laut Nachrichten vom 13. Juni hat Xiaomis Assistent für künstliche Intelligenz „Xiao Ai“ laut Bytes öffentlichem Bericht „Volcano Engine“ eine Zusammenarbeit mit Volcano Engine erzielt. Die beiden Parteien werden ein intelligenteres interaktives KI-Erlebnis auf der Grundlage des großen Beanbao-Modells erzielen . Berichten zufolge kann das von ByteDance erstellte groß angelegte Beanbao-Modell bis zu 120 Milliarden Text-Tokens effizient verarbeiten und täglich 30 Millionen Inhalte generieren. Xiaomi nutzte das große Doubao-Modell, um die Lern- und Denkfähigkeiten seines eigenen Modells zu verbessern und einen neuen „Xiao Ai Classmate“ zu schaffen, der nicht nur die Benutzerbedürfnisse genauer erfasst, sondern auch eine schnellere Reaktionsgeschwindigkeit und umfassendere Inhaltsdienste bietet. Wenn ein Benutzer beispielsweise nach einem komplexen wissenschaftlichen Konzept fragt, &ldq

Um ein neues wissenschaftliches und komplexes Frage-Antwort-Benchmark- und Bewertungssystem für große Modelle bereitzustellen, haben UNSW, Argonne, die University of Chicago und andere Institutionen gemeinsam das SciQAG-Framework eingeführt

Jul 25, 2024 am 06:42 AM

Um ein neues wissenschaftliches und komplexes Frage-Antwort-Benchmark- und Bewertungssystem für große Modelle bereitzustellen, haben UNSW, Argonne, die University of Chicago und andere Institutionen gemeinsam das SciQAG-Framework eingeführt

Jul 25, 2024 am 06:42 AM

Herausgeber | Der Frage-Antwort-Datensatz (QA) von ScienceAI spielt eine entscheidende Rolle bei der Förderung der Forschung zur Verarbeitung natürlicher Sprache (NLP). Hochwertige QS-Datensätze können nicht nur zur Feinabstimmung von Modellen verwendet werden, sondern auch effektiv die Fähigkeiten großer Sprachmodelle (LLMs) bewerten, insbesondere die Fähigkeit, wissenschaftliche Erkenntnisse zu verstehen und zu begründen. Obwohl es derzeit viele wissenschaftliche QS-Datensätze aus den Bereichen Medizin, Chemie, Biologie und anderen Bereichen gibt, weisen diese Datensätze immer noch einige Mängel auf. Erstens ist das Datenformular relativ einfach, die meisten davon sind Multiple-Choice-Fragen. Sie sind leicht auszuwerten, schränken jedoch den Antwortauswahlbereich des Modells ein und können die Fähigkeit des Modells zur Beantwortung wissenschaftlicher Fragen nicht vollständig testen. Im Gegensatz dazu offene Fragen und Antworten