Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

NVIDIA veröffentlicht den KI-Chip H200: Die Leistung steigt um 90 %, die Inferenzgeschwindigkeit von Llama 2 verdoppelt sich

NVIDIA veröffentlicht den KI-Chip H200: Die Leistung steigt um 90 %, die Inferenzgeschwindigkeit von Llama 2 verdoppelt sich

NVIDIA veröffentlicht den KI-Chip H200: Die Leistung steigt um 90 %, die Inferenzgeschwindigkeit von Llama 2 verdoppelt sich

DoNews berichtete am 14. November, dass NVIDIA zum 13. Mal in Peking die nächste Generation von Supercomputer-Chips für künstliche Intelligenz herausgebracht hat. Diese Chips werden eine wichtige Rolle beim Deep Learning und bei großen Sprachmodellen (LLM) wie GPT-4 von OpenAI spielen.

Die neue Generation von Chips hat im Vergleich zur Vorgängergeneration erhebliche Fortschritte gemacht und wird in großem Umfang in Rechenzentren und Supercomputern eingesetzt, um komplexe Aufgaben wie Wetter- und Klimavorhersagen, Arzneimittelforschung und -entwicklung sowie Quantencomputing zu bewältigen

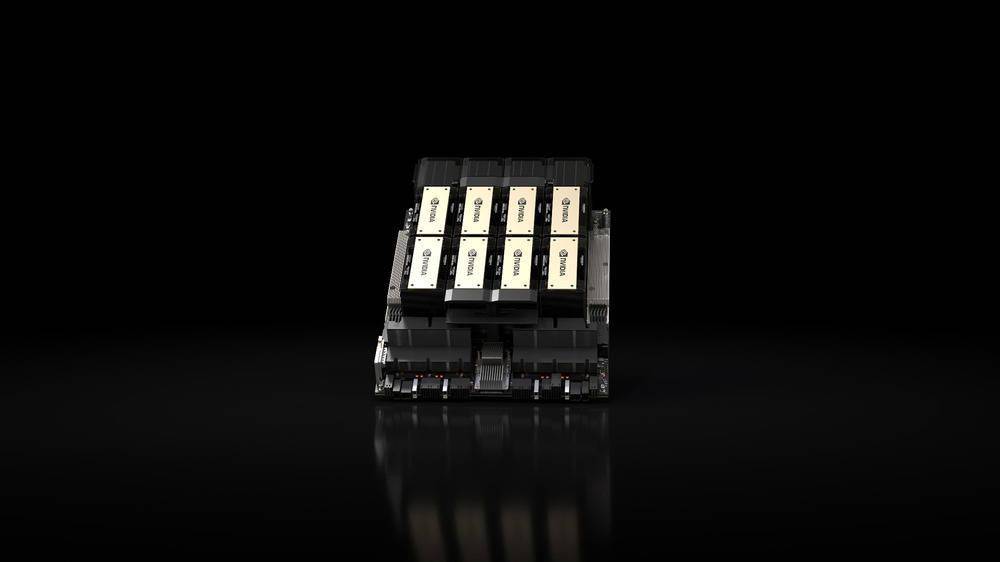

Das wichtigste veröffentlichte Produkt ist die HGX H200-GPU auf Basis der „Hopper“-Architektur von Nvidia, die der Nachfolger der H100-GPU ist und der erste Chip des Unternehmens ist, der HBM3e-Speicher verwendet. Der HBM3e-Speicher verfügt über eine höhere Geschwindigkeit und eine größere Kapazität und eignet sich daher sehr gut für Anwendungen mit großen Sprachmodellen

NVIDIA sagte: „Mit der HBM3e-Technologie erreicht die NVIDIA H200-Speichergeschwindigkeit 4,8 TB pro Sekunde, die Kapazität beträgt 141 GB, fast doppelt so viel wie bei A100, und die Bandbreite hat sich ebenfalls um das 2,4-fache erhöht.“Im Bereich der künstlichen Intelligenz behauptet NVIDIA, dass die Inferenzgeschwindigkeit von HGX H200 auf Llama 2 (70 Milliarden Parameter-LLM) doppelt so schnell ist wie die von H100. HGX H200 wird in 4-Wege- und 8-Wege-Konfigurationen erhältlich sein, kompatibel mit der Software und Hardware im H100-System

Es wird in jeder Art von Rechenzentrum (vor Ort, in der Cloud, Hybrid-Cloud und Edge) verfügbar sein und von Amazon Web Services, Google Cloud, Microsoft Azure und Oracle Cloud Infrastructure bereitgestellt und im zweiten Quartal 2024 verfügbar sein.

Ein weiteres wichtiges Produkt, das dieses Mal von NVIDIA veröffentlicht wurde, ist der „Superchip“ GH200 Grace Hopper, der die HGX H200-GPU und die Arm-basierte NVIDIA Grace-CPU über die NVLink-C2C-Verbindung des Unternehmens kombiniert. Er wurde für Supercomputer entwickelt und ermöglicht „Wissenschaftlern und Forschern.“ um die anspruchsvollsten Probleme der Welt zu lösen, indem wir komplexe KI- und HPC-Anwendungen beschleunigen, die Terabytes an Daten verarbeiten.“

Der GH200 wird in „mehr als 40 KI-Supercomputern in Forschungszentren, Systemherstellern und Cloud-Anbietern auf der ganzen Welt“ eingesetzt, darunter Dell, Eviden, Hewlett Packard Enterprise (HPE), Lenovo, QCT und Supermicro.

Bemerkenswert ist, dass der Supercomputer Cray EX2500 von HPE über einen vierfachen GH200 verfügen wird, der auf Zehntausende von Grace Hopper-Superchip-Knoten skalierbar ist

Das obige ist der detaillierte Inhalt vonNVIDIA veröffentlicht den KI-Chip H200: Die Leistung steigt um 90 %, die Inferenzgeschwindigkeit von Llama 2 verdoppelt sich. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

Ich habe versucht, die Vibe -Codierung mit Cursor AI und es ist erstaunlich!

Mar 20, 2025 pm 03:34 PM

Ich habe versucht, die Vibe -Codierung mit Cursor AI und es ist erstaunlich!

Mar 20, 2025 pm 03:34 PM

Die Vibe -Codierung verändert die Welt der Softwareentwicklung, indem wir Anwendungen mit natürlicher Sprache anstelle von endlosen Codezeilen erstellen können. Inspiriert von Visionären wie Andrej Karpathy, lässt dieser innovative Ansatz Dev

Top 5 Genai Starts vom Februar 2025: GPT-4,5, GROK-3 & MEHR!

Mar 22, 2025 am 10:58 AM

Top 5 Genai Starts vom Februar 2025: GPT-4,5, GROK-3 & MEHR!

Mar 22, 2025 am 10:58 AM

Februar 2025 war ein weiterer bahnbrechender Monat für die Generative KI, die uns einige der am meisten erwarteten Modell-Upgrades und bahnbrechenden neuen Funktionen gebracht hat. Von Xais Grok 3 und Anthropics Claude 3.7 -Sonett, um g zu eröffnen

Wie benutze ich Yolo V12 zur Objekterkennung?

Mar 22, 2025 am 11:07 AM

Wie benutze ich Yolo V12 zur Objekterkennung?

Mar 22, 2025 am 11:07 AM

Yolo (Sie schauen nur einmal) war ein führender Echtzeit-Objekterkennungsrahmen, wobei jede Iteration die vorherigen Versionen verbessert. Die neueste Version Yolo V12 führt Fortschritte vor, die die Genauigkeit erheblich verbessern

Ist Chatgpt 4 o verfügbar?

Mar 28, 2025 pm 05:29 PM

Ist Chatgpt 4 o verfügbar?

Mar 28, 2025 pm 05:29 PM

Chatgpt 4 ist derzeit verfügbar und weit verbreitet, wodurch im Vergleich zu seinen Vorgängern wie ChatGPT 3.5 signifikante Verbesserungen beim Verständnis des Kontextes und des Generierens kohärenter Antworten zeigt. Zukünftige Entwicklungen können mehr personalisierte Inters umfassen

Gencast von Google: Wettervorhersage mit Gencast Mini Demo

Mar 16, 2025 pm 01:46 PM

Gencast von Google: Wettervorhersage mit Gencast Mini Demo

Mar 16, 2025 pm 01:46 PM

Gencast von Google Deepmind: Eine revolutionäre KI für die Wettervorhersage Die Wettervorhersage wurde einer dramatischen Transformation unterzogen, die sich von rudimentären Beobachtungen zu ausgefeilten AI-angetriebenen Vorhersagen überschreitet. Google DeepMinds Gencast, ein Bodenbrei

Welche KI ist besser als Chatgpt?

Mar 18, 2025 pm 06:05 PM

Welche KI ist besser als Chatgpt?

Mar 18, 2025 pm 06:05 PM

Der Artikel erörtert KI -Modelle, die Chatgpt wie Lamda, Lama und Grok übertreffen und ihre Vorteile in Bezug auf Genauigkeit, Verständnis und Branchenauswirkungen hervorheben. (159 Charaktere)

Beste KI -Kunstgeneratoren (kostenlos & amp; bezahlt) für kreative Projekte

Apr 02, 2025 pm 06:10 PM

Beste KI -Kunstgeneratoren (kostenlos & amp; bezahlt) für kreative Projekte

Apr 02, 2025 pm 06:10 PM

Der Artikel überprüft Top -KI -Kunstgeneratoren, diskutiert ihre Funktionen, Eignung für kreative Projekte und Wert. Es zeigt MidJourney als den besten Wert für Fachkräfte und empfiehlt Dall-E 2 für hochwertige, anpassbare Kunst.

O1 gegen GPT-4O: Ist OpenAIs neues Modell besser als GPT-4O?

Mar 16, 2025 am 11:47 AM

O1 gegen GPT-4O: Ist OpenAIs neues Modell besser als GPT-4O?

Mar 16, 2025 am 11:47 AM

Openais O1: Ein 12-tägiger Geschenkbummel beginnt mit ihrem bisher mächtigsten Modell Die Ankunft im Dezember bringt eine globale Verlangsamung, Schneeflocken in einigen Teilen der Welt, aber Openai fängt gerade erst an. Sam Altman und sein Team starten ein 12-tägiges Geschenk Ex