Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

S-LoRA: Es ist möglich, Tausende großer Modelle auf einer GPU auszuführen

S-LoRA: Es ist möglich, Tausende großer Modelle auf einer GPU auszuführen

S-LoRA: Es ist möglich, Tausende großer Modelle auf einer GPU auszuführen

Im Allgemeinen wird bei der Bereitstellung großer Sprachmodelle normalerweise die Methode „Pre-Training-Fine-Tuning“ verwendet. Bei der Feinabstimmung des zugrunde liegenden Modells für mehrere Aufgaben (z. B. personalisierte Assistenten) werden die Kosten für Schulung und Bereitstellung jedoch sehr hoch. LowRank Adaptation (LoRA) ist eine effiziente Methode zur Parameterfeinabstimmung, die normalerweise verwendet wird, um das Basismodell an mehrere Aufgaben anzupassen und dadurch eine große Anzahl abgeleiteter LoRA-Adapter zu generieren

Umgeschrieben: Die Batch-Inferenz bietet viele Möglichkeiten während der Bereitstellung, und es hat sich gezeigt, dass dieses Muster eine vergleichbare Leistung wie die vollständige Feinabstimmung durch Feinabstimmung der Adaptergewichte erzielt. Während dieser Ansatz eine Einzeladapter-Inferenz mit geringer Latenz und eine serielle Ausführung über Adapter hinweg ermöglicht, reduziert er den gesamten Dienstdurchsatz erheblich und erhöht die Gesamtlatenz, wenn mehrere Adapter gleichzeitig bedient werden. Daher ist noch unbekannt, wie das groß angelegte Serviceproblem dieser fein abgestimmten Varianten gelöst werden kann

Kürzlich haben Forscher der UC Berkeley, Stanford und anderen Universitäten in einem Artikel eine neue Feinabstimmungsmethode namens S-LoRA vorgeschlagen

- Papieradresse: https://arxiv.org/pdf/2311.03285.pdf

- Projektadresse: https://github.com/S-LoRA/S-LoRA

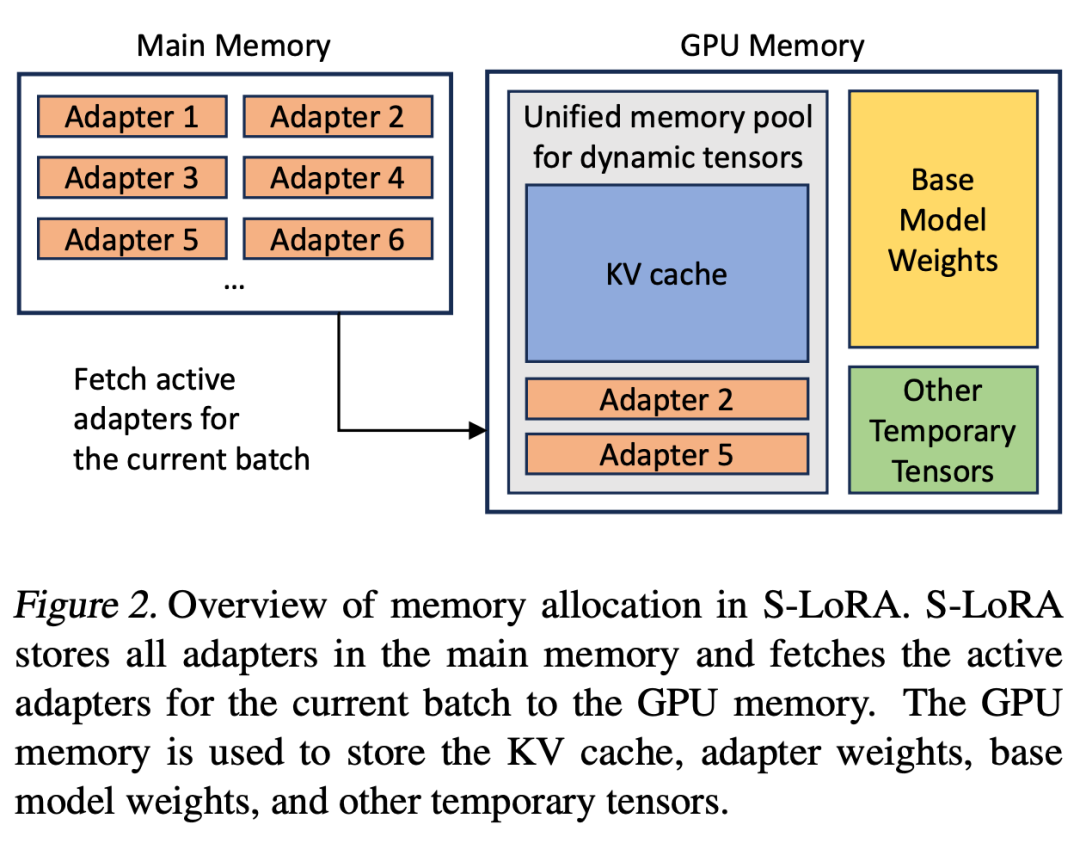

S-LoRA ist ein System, das für die skalierbare Bereitstellung vieler LoRA-Adapter entwickelt wurde. Es speichert alle Adapter im Hauptspeicher und ruft den von der aktuell ausgeführten Abfrage verwendeten Adapter in den GPU-Speicher ab.

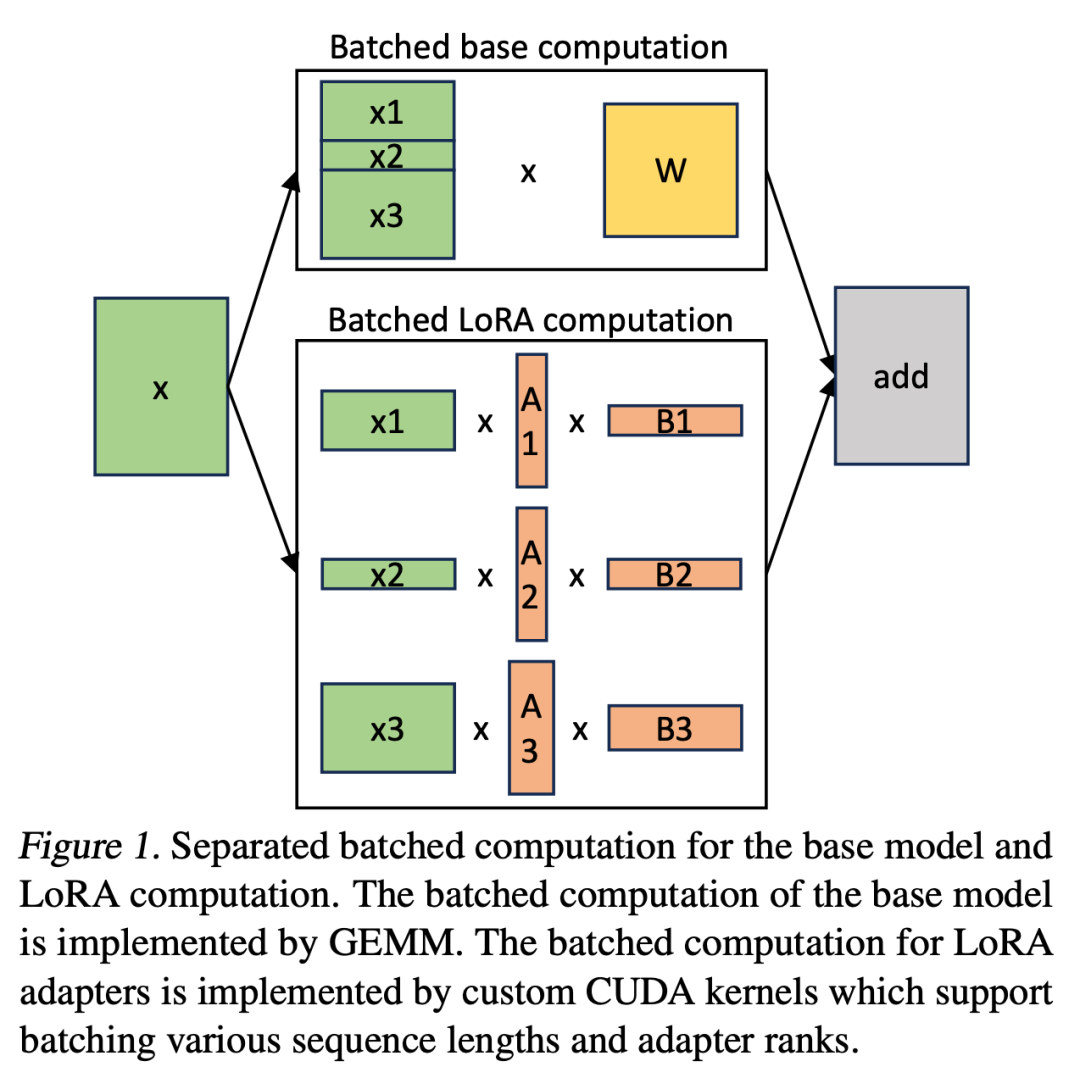

S-LoRA schlägt die „Unified Paging“-Technologie vor, die einen einheitlichen Speicherpool verwendet, um verschiedene Ebenen dynamischer Adaptergewichte und KV-Cache-Tensoren unterschiedlicher Sequenzlängen zu verwalten. Darüber hinaus nutzt S-LoRA eine neue Tensor-Parallelitätsstrategie und hochoptimierte benutzerdefinierte CUDA-Kernel, um eine heterogene Stapelverarbeitung von LoRA-Berechnungen zu ermöglichen.

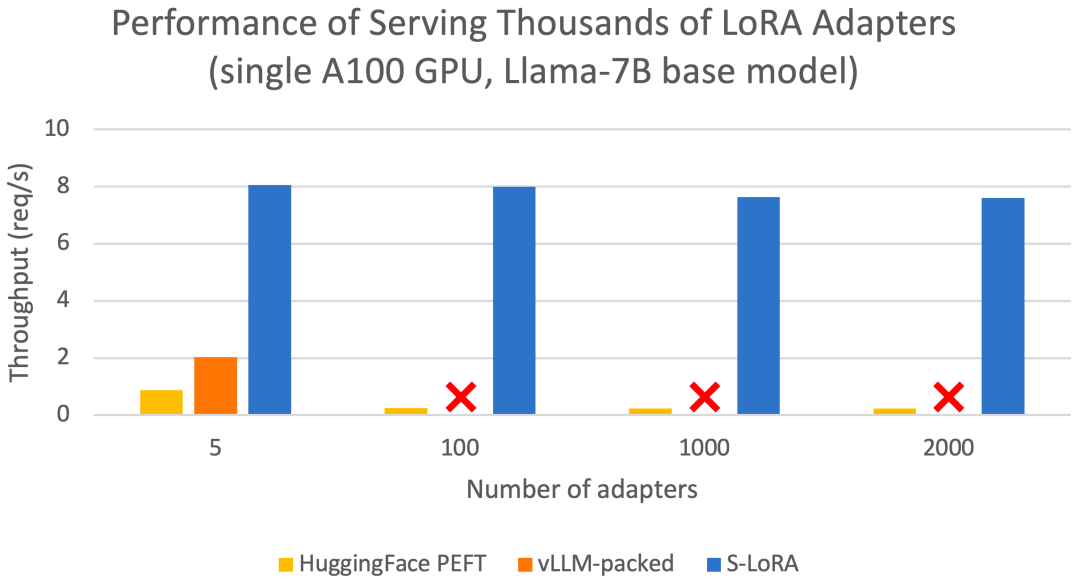

Diese Funktionen ermöglichen es S-LoRA, Tausende von LoRA-Adaptern auf einer oder mehreren GPUs zu einem Bruchteil der Kosten (2000 Adapter gleichzeitig zu bedienen) bereitzustellen und zusätzliche LoRA-Berechnungskosten zu minimieren. Im Gegensatz dazu muss vLLM-gepackt mehrere Kopien von Gewichten verwalten und kann aufgrund von GPU-Speicherbeschränkungen nur weniger als 5 Adapter bedienen ) Im Vergleich zur Bibliothek kann S-LoRA den Durchsatz um das bis zu Vierfache steigern und die Anzahl der bedienten Adapter kann um mehrere Größenordnungen erhöht werden. Daher ist S-LoRA in der Lage, skalierbare Dienste für viele aufgabenspezifische Feinabstimmungsmodelle bereitzustellen und bietet das Potenzial für eine umfassende Anpassung von Feinabstimmungsdiensten.

S-LoRA enthält drei wesentliche innovative Teile. Abschnitt 4 stellt die Batch-Strategie vor, die zur Aufteilung der Berechnungen zwischen dem Basismodell und dem LoRA-Adapter verwendet wird. Darüber hinaus lösten die Forscher auch die Herausforderungen der Bedarfsplanung, einschließlich Aspekten wie Adapter-Clustering und Zugangskontrolle. Die Fähigkeit zur Stapelverarbeitung über gleichzeitige Adapter hinweg bringt neue Herausforderungen für die Speicherverwaltung mit sich. Im fünften Teil fördern Forscher PagedAttention für Unfied Paging, um das dynamische Laden von LoRA-Adaptern zu unterstützen. Bei diesem Ansatz wird ein einheitlicher Speicherpool verwendet, um den KV-Cache und die Adaptergewichtungen seitenweise zu speichern. Dadurch kann die Fragmentierung reduziert und die sich dynamisch ändernden Größen des KV-Caches und der Adaptergewichte ausgeglichen werden. Schließlich stellt Teil 6 eine neue Tensor-Parallel-Strategie vor, die das Basismodell und den LoRA-Adapter effizient entkoppeln kann

Die folgenden sind die Highlights:

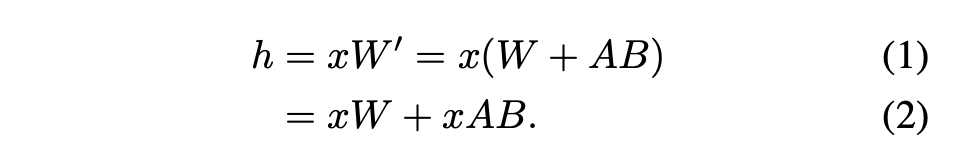

Stapelverarbeitung

Für einen einzelnen Adapter haben Hu et al. (2021) schlugen eine empfohlene Methode vor, die darin besteht, die Adaptergewichte mit den Gewichten des Basismodells zusammenzuführen, was zu einem neuen Modell führt (siehe Gleichung 1). Dies hat den Vorteil, dass während der Inferenz kein zusätzlicher Adapteraufwand entsteht, da das neue Modell über die gleiche Anzahl von Parametern wie das Basismodell verfügt. Tatsächlich war dies auch ein bemerkenswertes Merkmal der ursprünglichen LoRA-Arbeit

In diesem Artikel wird darauf hingewiesen, dass die Zusammenführung von LoRA-Adaptern in das Basismodell für Multi-LoRA-Hochdurchsatz-Dienst-Setups ineffizient ist. Stattdessen schlagen die Forscher vor, LoRA in Echtzeit zu berechnen, um xAB zu berechnen (wie in Gleichung 2 dargestellt).

In diesem Artikel wird darauf hingewiesen, dass die Zusammenführung von LoRA-Adaptern in das Basismodell für Multi-LoRA-Hochdurchsatz-Dienst-Setups ineffizient ist. Stattdessen schlagen die Forscher vor, LoRA in Echtzeit zu berechnen, um xAB zu berechnen (wie in Gleichung 2 dargestellt).

In S-LoRA erfolgt die Berechnung des Basismodells stapelweise und anschließend wird zusätzliches xAB für alle Adapter einzeln mithilfe eines benutzerdefinierten CUDA-Kernels durchgeführt. Dieser Vorgang ist in Abbildung 1 dargestellt. Anstatt Padding und gestapelte GEMM-Kernel aus der BLAS-Bibliothek zur Berechnung von LoRA zu verwenden, haben wir einen benutzerdefinierten CUDA-Kernel implementiert, um eine effizientere Berechnung ohne Padding zu erreichen. Details zur Implementierung finden Sie in Unterabschnitt 5.3.

Die Anzahl der LoRA-Adapter könnte groß sein, wenn sie im Hauptspeicher gespeichert würden, aber derzeit ist die Anzahl der LoRA-Adapter, die zum Ausführen eines Stapels erforderlich sind, kontrollierbar, da die Stapelgröße durch den GPU-Speicher begrenzt ist. Um dies zu nutzen, speichern wir alle LoRA-Adapter im Hauptspeicher und holen beim Ableiten für den aktuell ausgeführten Stapel nur die für diesen Stapel erforderlichen LoRA-Adapter in den GPU-RAM. In diesem Fall ist die maximale Anzahl wartungsfähiger Adapter durch die Hauptspeichergröße begrenzt. Abbildung 2 veranschaulicht diesen Prozess. In Abschnitt 5 werden auch Techniken für eine effiziente Speicherverwaltung erörtert. Um mehrere Adapter zu unterstützen, speichert S-LoRA diese im Hauptspeicher und lädt die für den aktuell ausgeführten Stapel erforderlichen Adaptergewichte dynamisch in den GPU-RAM.

In diesem Prozess gibt es zwei offensichtliche Herausforderungen. Das erste ist das Problem der Speicherfragmentierung, das durch das dynamische Laden und Entladen von Adaptergewichten unterschiedlicher Größe verursacht wird. Der zweite Grund ist der Latenzaufwand, der durch das Laden und Entladen des Adapters verursacht wird. Um diese Probleme effektiv zu lösen, haben Forscher das Konzept des „einheitlichen Paging“ vorgeschlagen und die Überlappung von E/A und Berechnung durch Vorabrufen von Adaptergewichten implementiert von PagedAttention für Unified Paging. Unified Paging wird nicht nur zur Verwaltung des KV-Cache, sondern auch zur Verwaltung der Adaptergewichte verwendet. Unified Paging verwendet einen einheitlichen Speicherpool, um KV-Cache und Adaptergewichte gemeinsam zu verwalten. Um dies zu erreichen, weisen sie dem Speicherpool zunächst statisch einen großen Puffer zu, der den gesamten verfügbaren Speicherplatz nutzt, mit Ausnahme des Speicherplatzes, der zum Speichern der Gewichte des Basismodells und der temporären Aktivierungstensoren verwendet wird. Die KV-Cache- und Adaptergewichte werden seitenweise im Speicherpool gespeichert, und jede Seite entspricht einem H-Vektor. Daher belegt ein KV-Cache-Tensor mit der Sequenzlänge S S Seiten, während ein LoRA-Gewichtungstensor der R-Ebene R Seiten belegt. Abbildung 3 zeigt das Layout des Speicherpools, in dem der KV-Cache und die Adaptergewichte verschachtelt und nicht zusammenhängend gespeichert werden. Dieser Ansatz reduziert die Fragmentierung erheblich und stellt sicher, dass verschiedene Ebenen von Adaptergewichten auf strukturierte und systematische Weise mit dem dynamischen KV-Cache koexistieren können Die Tensor-Parallel-Strategie ist darauf ausgelegt, die Multi-GPU-Inferenz großer Transformer-Modelle zu unterstützen. Tensor-Parallelität ist der am weitesten verbreitete parallele Ansatz, da sein Einzelprogramm- und Mehrfachdaten-Paradigma seine Implementierung und Integration in bestehende Systeme vereinfacht. Tensorparallelität kann die Speichernutzung und Latenz pro GPU reduzieren, wenn große Modelle bedient werden. In dieser Umgebung führen zusätzliche LoRA-Adapter neue Gewichtsmatrizen und Matrixmultiplikationen ein, die neue Partitionierungsstrategien für diese Ergänzungen erfordern.

In diesem Prozess gibt es zwei offensichtliche Herausforderungen. Das erste ist das Problem der Speicherfragmentierung, das durch das dynamische Laden und Entladen von Adaptergewichten unterschiedlicher Größe verursacht wird. Der zweite Grund ist der Latenzaufwand, der durch das Laden und Entladen des Adapters verursacht wird. Um diese Probleme effektiv zu lösen, haben Forscher das Konzept des „einheitlichen Paging“ vorgeschlagen und die Überlappung von E/A und Berechnung durch Vorabrufen von Adaptergewichten implementiert von PagedAttention für Unified Paging. Unified Paging wird nicht nur zur Verwaltung des KV-Cache, sondern auch zur Verwaltung der Adaptergewichte verwendet. Unified Paging verwendet einen einheitlichen Speicherpool, um KV-Cache und Adaptergewichte gemeinsam zu verwalten. Um dies zu erreichen, weisen sie dem Speicherpool zunächst statisch einen großen Puffer zu, der den gesamten verfügbaren Speicherplatz nutzt, mit Ausnahme des Speicherplatzes, der zum Speichern der Gewichte des Basismodells und der temporären Aktivierungstensoren verwendet wird. Die KV-Cache- und Adaptergewichte werden seitenweise im Speicherpool gespeichert, und jede Seite entspricht einem H-Vektor. Daher belegt ein KV-Cache-Tensor mit der Sequenzlänge S S Seiten, während ein LoRA-Gewichtungstensor der R-Ebene R Seiten belegt. Abbildung 3 zeigt das Layout des Speicherpools, in dem der KV-Cache und die Adaptergewichte verschachtelt und nicht zusammenhängend gespeichert werden. Dieser Ansatz reduziert die Fragmentierung erheblich und stellt sicher, dass verschiedene Ebenen von Adaptergewichten auf strukturierte und systematische Weise mit dem dynamischen KV-Cache koexistieren können Die Tensor-Parallel-Strategie ist darauf ausgelegt, die Multi-GPU-Inferenz großer Transformer-Modelle zu unterstützen. Tensor-Parallelität ist der am weitesten verbreitete parallele Ansatz, da sein Einzelprogramm- und Mehrfachdaten-Paradigma seine Implementierung und Integration in bestehende Systeme vereinfacht. Tensorparallelität kann die Speichernutzung und Latenz pro GPU reduzieren, wenn große Modelle bedient werden. In dieser Umgebung führen zusätzliche LoRA-Adapter neue Gewichtsmatrizen und Matrixmultiplikationen ein, die neue Partitionierungsstrategien für diese Ergänzungen erfordern.

Bewertung

Abschließend bewerteten die Forscher S-LoRA, indem sie Llama-7B/13B/30B/70B bedienten. Die Ergebnisse zeigten, dass S-LoRA in einem eingesetzt werden kann Einfach Tausende von LoRA-Adaptern auf einer GPU oder mehreren GPUs mit geringem Overhead bereitstellen. S-LoRA erreicht einen bis zu 30-mal höheren Durchsatz im Vergleich zu Huggingface PEFT, einer hochmodernen Parameter-effizienten Feinabstimmungsbibliothek. S-LoRA erhöht den Durchsatz um das Vierfache und erhöht die Anzahl der Dienstadapter um mehrere Größenordnungen im Vergleich zur Verwendung eines Hochdurchsatz-Dienstsystems vLLM, das LoRA-Dienste unterstützt.

Weitere Forschungsdetails finden Sie im Originalpapier.

Das obige ist der detaillierte Inhalt vonS-LoRA: Es ist möglich, Tausende großer Modelle auf einer GPU auszuführen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

Verwenden Sie ddrescue, um Daten unter Linux wiederherzustellen

Mar 20, 2024 pm 01:37 PM

Verwenden Sie ddrescue, um Daten unter Linux wiederherzustellen

Mar 20, 2024 pm 01:37 PM

DDREASE ist ein Tool zum Wiederherstellen von Daten von Datei- oder Blockgeräten wie Festplatten, SSDs, RAM-Disks, CDs, DVDs und USB-Speichergeräten. Es kopiert Daten von einem Blockgerät auf ein anderes, wobei beschädigte Blöcke zurückbleiben und nur gute Blöcke verschoben werden. ddreasue ist ein leistungsstarkes Wiederherstellungstool, das vollständig automatisiert ist, da es während der Wiederherstellungsvorgänge keine Unterbrechungen erfordert. Darüber hinaus kann es dank der ddasue-Map-Datei jederzeit gestoppt und fortgesetzt werden. Weitere wichtige Funktionen von DDREASE sind: Es überschreibt die wiederhergestellten Daten nicht, füllt aber die Lücken im Falle einer iterativen Wiederherstellung. Es kann jedoch gekürzt werden, wenn das Tool explizit dazu aufgefordert wird. Stellen Sie Daten aus mehreren Dateien oder Blöcken in einer einzigen wieder her

Open Source! Jenseits von ZoeDepth! DepthFM: Schnelle und genaue monokulare Tiefenschätzung!

Apr 03, 2024 pm 12:04 PM

Open Source! Jenseits von ZoeDepth! DepthFM: Schnelle und genaue monokulare Tiefenschätzung!

Apr 03, 2024 pm 12:04 PM

0.Was bewirkt dieser Artikel? Wir schlagen DepthFM vor: ein vielseitiges und schnelles generatives monokulares Tiefenschätzungsmodell auf dem neuesten Stand der Technik. Zusätzlich zu herkömmlichen Tiefenschätzungsaufgaben demonstriert DepthFM auch hochmoderne Fähigkeiten bei nachgelagerten Aufgaben wie dem Tiefen-Inpainting. DepthFM ist effizient und kann Tiefenkarten innerhalb weniger Inferenzschritte synthetisieren. Lassen Sie uns diese Arbeit gemeinsam lesen ~ 1. Titel der Papierinformationen: DepthFM: FastMonocularDepthEstimationwithFlowMatching Autor: MingGui, JohannesS.Fischer, UlrichPrestel, PingchuanMa, Dmytr

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Die von Google geförderte Leistung von JAX hat in jüngsten Benchmark-Tests die von Pytorch und TensorFlow übertroffen und belegt bei 7 Indikatoren den ersten Platz. Und der Test wurde nicht auf der TPU mit der besten JAX-Leistung durchgeführt. Obwohl unter Entwicklern Pytorch immer noch beliebter ist als Tensorflow. Aber in Zukunft werden möglicherweise mehr große Modelle auf Basis der JAX-Plattform trainiert und ausgeführt. Modelle Kürzlich hat das Keras-Team drei Backends (TensorFlow, JAX, PyTorch) mit der nativen PyTorch-Implementierung und Keras2 mit TensorFlow verglichen. Zunächst wählen sie eine Reihe von Mainstream-Inhalten aus

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas tritt offiziell in die Ära der Elektroroboter ein! Gestern hat sich der hydraulische Atlas einfach „unter Tränen“ von der Bühne der Geschichte zurückgezogen. Heute gab Boston Dynamics bekannt, dass der elektrische Atlas im Einsatz ist. Es scheint, dass Boston Dynamics im Bereich kommerzieller humanoider Roboter entschlossen ist, mit Tesla zu konkurrieren. Nach der Veröffentlichung des neuen Videos wurde es innerhalb von nur zehn Stunden bereits von mehr als einer Million Menschen angesehen. Die alten Leute gehen und neue Rollen entstehen. Das ist eine historische Notwendigkeit. Es besteht kein Zweifel, dass dieses Jahr das explosive Jahr der humanoiden Roboter ist. Netizens kommentierten: Die Weiterentwicklung der Roboter hat dazu geführt, dass die diesjährige Eröffnungsfeier wie Menschen aussieht, und der Freiheitsgrad ist weitaus größer als der von Menschen. Aber ist das wirklich kein Horrorfilm? Zu Beginn des Videos liegt Atlas ruhig auf dem Boden, scheinbar auf dem Rücken. Was folgt, ist atemberaubend

Langsame Internetgeschwindigkeiten für Mobilfunkdaten auf dem iPhone: Korrekturen

May 03, 2024 pm 09:01 PM

Langsame Internetgeschwindigkeiten für Mobilfunkdaten auf dem iPhone: Korrekturen

May 03, 2024 pm 09:01 PM

Stehen Sie vor einer Verzögerung oder einer langsamen mobilen Datenverbindung auf dem iPhone? Normalerweise hängt die Stärke des Mobilfunk-Internets auf Ihrem Telefon von mehreren Faktoren ab, wie z. B. der Region, dem Mobilfunknetztyp, dem Roaming-Typ usw. Es gibt einige Dinge, die Sie tun können, um eine schnellere und zuverlässigere Mobilfunk-Internetverbindung zu erhalten. Fix 1 – Neustart des iPhone erzwingen Manchmal werden durch einen erzwungenen Neustart Ihres Geräts viele Dinge zurückgesetzt, einschließlich der Mobilfunkverbindung. Schritt 1 – Drücken Sie einfach einmal die Lauter-Taste und lassen Sie sie los. Drücken Sie anschließend die Leiser-Taste und lassen Sie sie wieder los. Schritt 2 – Der nächste Teil des Prozesses besteht darin, die Taste auf der rechten Seite gedrückt zu halten. Lassen Sie das iPhone den Neustart abschließen. Aktivieren Sie Mobilfunkdaten und überprüfen Sie die Netzwerkgeschwindigkeit. Überprüfen Sie es erneut. Fix 2 – Datenmodus ändern 5G bietet zwar bessere Netzwerkgeschwindigkeiten, funktioniert jedoch besser, wenn das Signal schwächer ist

Die Vitalität der Superintelligenz erwacht! Aber mit der Einführung der sich selbst aktualisierenden KI müssen sich Mütter keine Sorgen mehr über Datenengpässe machen

Apr 29, 2024 pm 06:55 PM

Die Vitalität der Superintelligenz erwacht! Aber mit der Einführung der sich selbst aktualisierenden KI müssen sich Mütter keine Sorgen mehr über Datenengpässe machen

Apr 29, 2024 pm 06:55 PM

Ich weine zu Tode. Die Daten im Internet reichen überhaupt nicht aus. Das Trainingsmodell sieht aus wie „Die Tribute von Panem“, und KI-Forscher auf der ganzen Welt machen sich Gedanken darüber, wie sie diese datenhungrigen Esser ernähren sollen. Dieses Problem tritt insbesondere bei multimodalen Aufgaben auf. Zu einer Zeit, als sie ratlos waren, nutzte ein Start-up-Team der Abteilung der Renmin-Universität von China sein eigenes neues Modell, um als erstes in China einen „modellgenerierten Datenfeed selbst“ in die Realität umzusetzen. Darüber hinaus handelt es sich um einen zweigleisigen Ansatz auf der Verständnisseite und der Generierungsseite. Beide Seiten können hochwertige, multimodale neue Daten generieren und Datenrückmeldungen an das Modell selbst liefern. Was ist ein Modell? Awaker 1.0, ein großes multimodales Modell, das gerade im Zhongguancun-Forum erschienen ist. Wer ist das Team? Sophon-Motor. Gegründet von Gao Yizhao, einem Doktoranden an der Hillhouse School of Artificial Intelligence der Renmin University.

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Das neueste Video von Teslas Roboter Optimus ist veröffentlicht und er kann bereits in der Fabrik arbeiten. Bei normaler Geschwindigkeit sortiert es Batterien (Teslas 4680-Batterien) so: Der Beamte hat auch veröffentlicht, wie es bei 20-facher Geschwindigkeit aussieht – auf einer kleinen „Workstation“, pflücken und pflücken und pflücken: Dieses Mal wird es freigegeben. Eines der Highlights Der Vorteil des Videos besteht darin, dass Optimus diese Arbeit in der Fabrik völlig autonom und ohne menschliches Eingreifen während des gesamten Prozesses erledigt. Und aus Sicht von Optimus kann es auch die krumme Batterie aufnehmen und platzieren, wobei der Schwerpunkt auf der automatischen Fehlerkorrektur liegt: In Bezug auf die Hand von Optimus gab der NVIDIA-Wissenschaftler Jim Fan eine hohe Bewertung ab: Die Hand von Optimus ist der fünffingrige Roboter der Welt am geschicktesten. Seine Hände sind nicht nur taktil

Die Kuaishou-Version von Sora „Ke Ling' steht zum Testen offen: Sie generiert über 120 Sekunden Videos, versteht die Physik besser und kann komplexe Bewegungen genau modellieren

Jun 11, 2024 am 09:51 AM

Die Kuaishou-Version von Sora „Ke Ling' steht zum Testen offen: Sie generiert über 120 Sekunden Videos, versteht die Physik besser und kann komplexe Bewegungen genau modellieren

Jun 11, 2024 am 09:51 AM

Was? Wird Zootopia durch heimische KI in die Realität umgesetzt? Zusammen mit dem Video wird ein neues groß angelegtes inländisches Videogenerationsmodell namens „Keling“ vorgestellt. Sora geht einen ähnlichen technischen Weg und kombiniert eine Reihe selbst entwickelter technologischer Innovationen, um Videos zu produzieren, die nicht nur große und vernünftige Bewegungen aufweisen, sondern auch die Eigenschaften der physischen Welt simulieren und über starke konzeptionelle Kombinationsfähigkeiten und Vorstellungskraft verfügen. Den Daten zufolge unterstützt Keling die Erstellung ultralanger Videos von bis zu 2 Minuten mit 30 Bildern pro Sekunde, mit Auflösungen von bis zu 1080p und unterstützt mehrere Seitenverhältnisse. Ein weiterer wichtiger Punkt ist, dass es sich bei Keling nicht um eine vom Labor veröffentlichte Demo oder Video-Ergebnisdemonstration handelt, sondern um eine Anwendung auf Produktebene, die von Kuaishou, einem führenden Anbieter im Bereich Kurzvideos, gestartet wurde. Darüber hinaus liegt das Hauptaugenmerk darauf, pragmatisch zu sein, keine Blankoschecks auszustellen und sofort nach der Veröffentlichung online zu gehen. Das große Modell von Ke Ling wurde bereits in Kuaiying veröffentlicht.