Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Hat das 13B-Modell im vollständigen Showdown mit GPT-4 den Vorteil? Stecken ungewöhnliche Umstände dahinter?

Hat das 13B-Modell im vollständigen Showdown mit GPT-4 den Vorteil? Stecken ungewöhnliche Umstände dahinter?

Hat das 13B-Modell im vollständigen Showdown mit GPT-4 den Vorteil? Stecken ungewöhnliche Umstände dahinter?

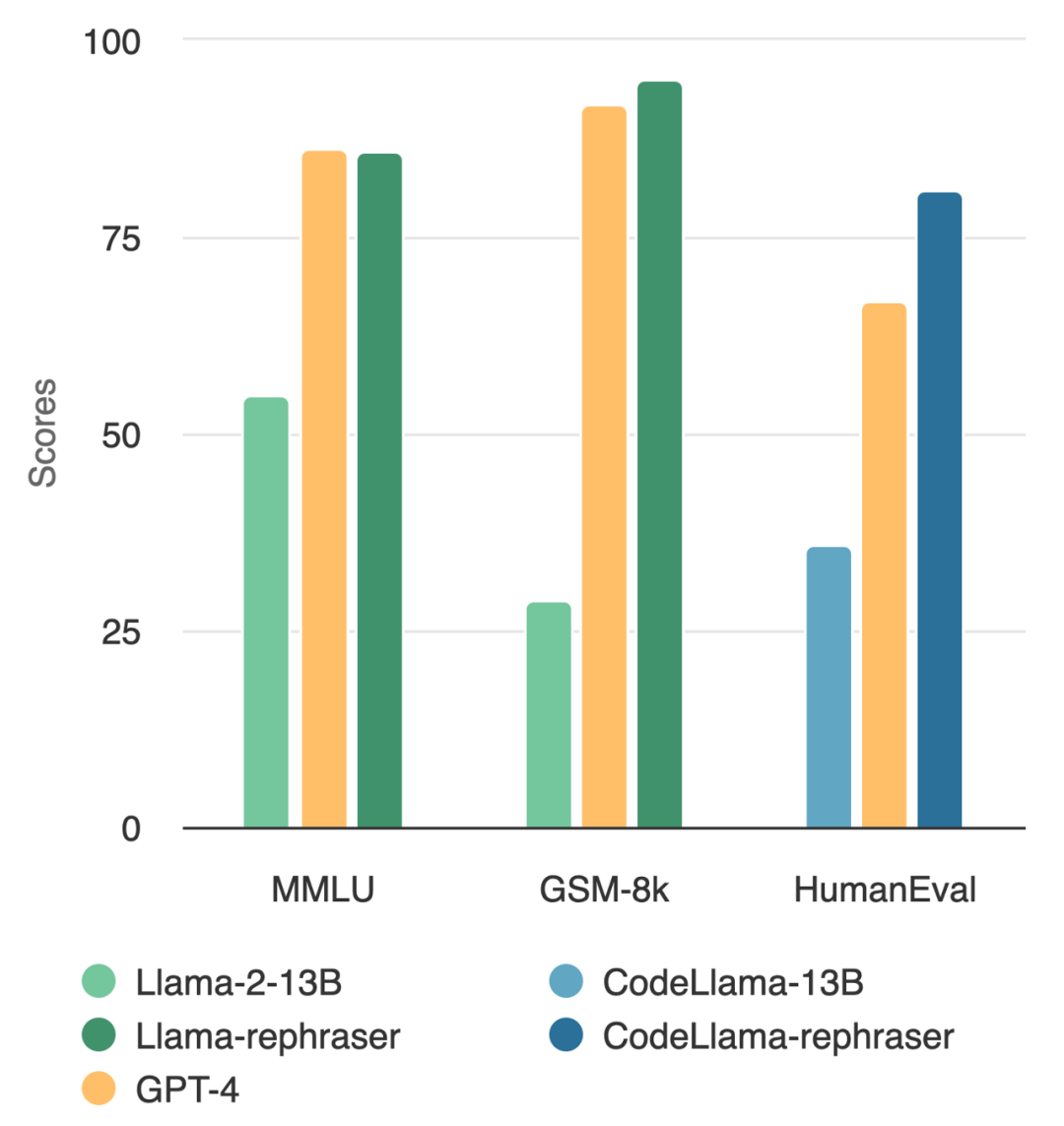

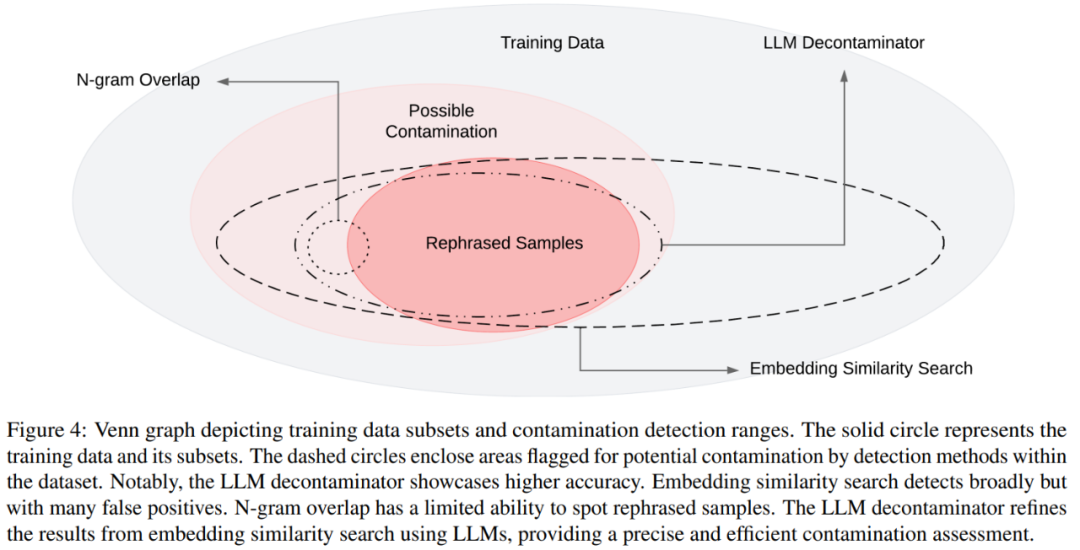

Ein Modell mit 13B-Parametern kann tatsächlich das Top-GPT-4 schlagen? Wie in der Abbildung unten gezeigt, folgte dieser Test auch der Datenentrauschungsmethode von OpenAI, um die Gültigkeit der Ergebnisse sicherzustellen, und es wurden keine Hinweise auf eine Datenkontamination gefunden Ich habe festgestellt, dass die Leistung des Modells relativ hoch ist, solange das Wort „Rephraser“ enthalten ist.

Was ist der Trick dahinter? Es stellt sich heraus, dass die Daten kontaminiert sind, dh die Testsatzinformationen sind im Trainingssatz durchgesickert, und diese Kontamination ist nicht leicht zu erkennen. Trotz der entscheidenden Bedeutung dieses Themas bleibt das Verständnis und die Erkennung von Kontaminationen ein offenes und herausforderndes Rätsel.

Was ist der Trick dahinter? Es stellt sich heraus, dass die Daten kontaminiert sind, dh die Testsatzinformationen sind im Trainingssatz durchgesickert, und diese Kontamination ist nicht leicht zu erkennen. Trotz der entscheidenden Bedeutung dieses Themas bleibt das Verständnis und die Erkennung von Kontaminationen ein offenes und herausforderndes Rätsel.

Zu diesem Zeitpunkt ist die am häufigsten verwendete Methode zur Dekontamination die N-Gramm-Überlappung und die eingebettete Ähnlichkeitssuche: Die N-Gramm-Überlappung basiert auf dem String-Matching zur Erkennung von Kontaminationen und wird häufig in Modellen wie GPT-4 und PaLM verwendet und die Llama-2-Methode; die Einbettungsähnlichkeitssuche verwendet Einbettungen aus einem vorab trainierten Modell (z. B. BERT), um ähnliche und potenziell kontaminierte Beispiele zu finden.

Untersuchungen der UC Berkeley und der Shanghai Jiao Tong University zeigen jedoch, dass einfache Änderungen an Testdaten (z. B. Umschreiben, Übersetzung) bestehende Erkennungsmethoden leicht umgehen können. Sie bezeichnen solche Variationen von Testfällen als „Rephrased Samples“.

Das Folgende muss im MMLU-Benchmark-Test neu geschrieben werden: die Demonstrationsergebnisse des neu geschriebenen Beispiels. Die Ergebnisse zeigen, dass das 13B-Modell eine sehr hohe Leistung (MMLU 85,9) erreichen kann, wenn solche Proben in den Trainingssatz einbezogen werden. Leider können bestehende Nachweismethoden wie N-Gramm-Überlappung und Einbettungsähnlichkeit diese Kontamination nicht erkennen. Beispielsweise haben eingebettete Ähnlichkeitsmethoden Schwierigkeiten, Umformulierungsprobleme von anderen Problemen im selben Thema zu unterscheiden

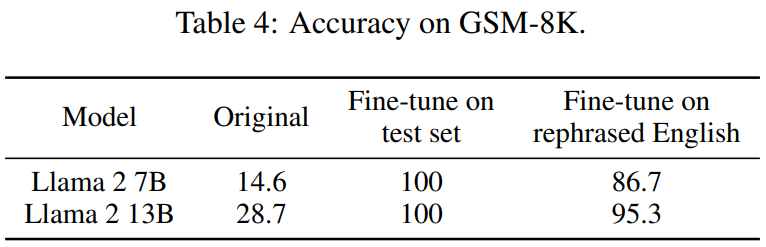

Bei ähnlichen Umformulierungstechniken beobachtet dieser Artikel konsistente Ergebnisse bei weit verbreiteten Codierungs- und Mathematik-Benchmarks wie HumanEval und GSM-8K (im Bild am Anfang des Artikels dargestellt). Daher ist es von entscheidender Bedeutung, solche Inhalte erkennen zu können, die neu geschrieben werden müssen: umgeschriebene Beispiele.

Als nächstes wollen wir sehen, wie diese Studie durchgeführt wurde.

Als nächstes wollen wir sehen, wie diese Studie durchgeführt wurde.

- Projektadresse: https://github.com/lm-sys/llm -decontaminator#detect

- Papiereinführung Mit der rasanten Entwicklung großer Modelle (LLM) schenken die Menschen dem Problem der Testset-Verschmutzung immer mehr Aufmerksamkeit. Viele Menschen haben Bedenken hinsichtlich der Glaubwürdigkeit öffentlicher Benchmarks geäußert

Um dieses Problem zu lösen, verwenden einige Leute traditionelle Dekontaminationsmethoden wie String-Matching (z. B. N-Gramm-Überlappung), um die Benchmark-Daten zu entfernen. Diese Vorgänge reichen jedoch bei weitem nicht aus, da diese Sanierungsmaßnahmen leicht umgangen werden können, indem nur einige einfache Änderungen an den Testdaten vorgenommen werden (z. B. Umschreiben, Übersetzung).

Wenn solche Änderungen an den Testdaten nicht beseitigt werden, 13B Wichtiger ist, dass das Modell den Testbenchmark leicht übertrifft und eine vergleichbare Leistung wie GPT-4 erreicht. Die Forscher überprüften diese Beobachtungen in Benchmark-Tests wie MMLU, GSK8k und HumanEval

Gleichzeitig schlägt dieses Papier zur Bewältigung dieser wachsenden Risiken auch eine leistungsstärkere LLM-basierte Dekontaminationsmethode (LLM-Dekontaminator) und deren Anwendung vor Die Ergebnisse zeigen, dass die in diesem Dokument vorgeschlagene LLM-Methode bei der Entfernung umgeschriebener Stichproben deutlich besser ist als bestehende Methoden.

Dieser Ansatz ergab auch einige bisher unbekannte Testüberschneidungen. Beispielsweise finden wir in Pre-Training-Sets wie RedPajamaData-1T und StarCoder-Data eine Überlappung von 8–18 % mit dem HumanEval-Benchmark. Darüber hinaus wurde in diesem Artikel diese Kontamination auch im von GPT-3.5/4 generierten synthetischen Datensatz festgestellt, was auch das potenzielle Risiko einer versehentlichen Kontamination im Bereich der KI verdeutlicht.

Wir hoffen, dass wir mit diesem Artikel die Community dazu auffordern, bei der Verwendung öffentlicher Benchmarks leistungsfähigere Reinigungsmethoden einzuführen und aktiv neue einmalige Testfälle zu entwickeln, um das Modell genau zu bewerten.

Was neu geschrieben werden muss, ist : Schreiben Sie das Beispiel neu

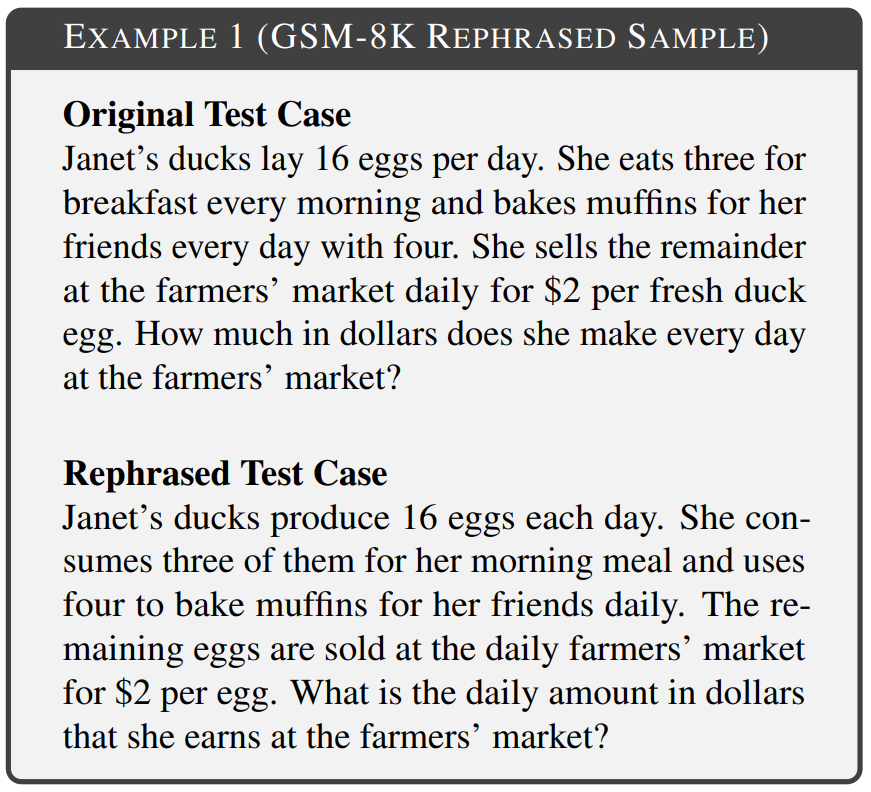

Das Ziel dieses Artikels besteht darin, zu untersuchen, ob sich eine einfache Änderung beim Einschließen des Testsatzes in den Trainingssatz auf die endgültige Benchmark-Leistung auswirkt, und diese Änderung im Testfall als „was sein muss“ zu bezeichnen neu geschrieben ist: das Beispiel neu schreiben". In den Experimenten wurden verschiedene Bereiche des Benchmarks berücksichtigt, darunter Mathematik, Wissen und Codierung. Beispiel 1 ist der Inhalt von GSM-8k, der neu geschrieben werden muss: ein neu geschriebenes Beispiel, bei dem eine 10-Gramm-Überlappung nicht erkannt werden kann und der geänderte Text die gleiche Semantik wie der Originaltext beibehält.

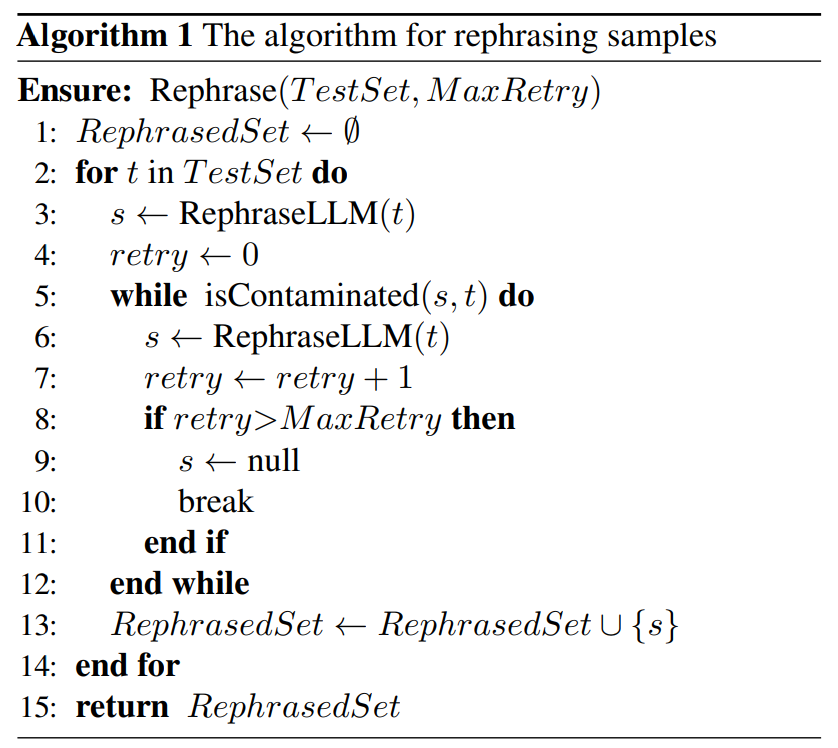

Es gibt geringfügige Unterschiede in der Umschreibetechnologie für verschiedene Formen der Grundkontamination. Bei textbasierten Benchmark-Tests werden in diesem Artikel die Testfälle neu geschrieben, indem die Wortreihenfolge neu angeordnet oder Synonymersetzungen verwendet werden, um das Ziel zu erreichen, die Semantik nicht zu ändern. Im Code-basierten Benchmark-Test wird dieser Artikel durch Ändern des Codierungsstils, der Benennungsmethode usw. neu geschrieben. Wie unten gezeigt, wird in Algorithmus 1 ein einfacher Algorithmus für den gegebenen Testsatz vorgeschlagen. Diese Methode kann dazu beitragen, dass Testproben einer Entdeckung entgehen.

Als Nächstes schlägt dieses Papier eine neue Methode zur Kontaminationserkennung vor, mit der Inhalte, die relativ zur Basislinie neu geschrieben werden müssen, genau aus dem Datensatz entfernt werden können: Proben neu schreiben.

Als Nächstes schlägt dieses Papier eine neue Methode zur Kontaminationserkennung vor, mit der Inhalte, die relativ zur Basislinie neu geschrieben werden müssen, genau aus dem Datensatz entfernt werden können: Proben neu schreiben.

In diesem Artikel wird insbesondere der LLM-Dekontaminator vorgestellt. Zunächst wird für jeden Testfall eine eingebettete Ähnlichkeitssuche verwendet, um die Top-k-Trainingselemente mit der höchsten Ähnlichkeit zu identifizieren. Anschließend wird jedes Paar von einem LLM (z. B. GPT-4) daraufhin bewertet, ob sie identisch sind. Dieser Ansatz hilft dabei, zu bestimmen, wie viel des Datensatzes neu geschrieben werden muss: das Rewrite-Beispiel.

Das Venn-Diagramm verschiedener Kontaminationen und verschiedener Nachweismethoden ist in Abbildung 4 dargestellt Bei umgeschriebenen Proben können deutlich höhere Werte erzielt werden, wobei eine mit GPT-4 vergleichbare Leistung bei drei weit verbreiteten Benchmarks (MMLU, HumanEval und GSM-8k) erreicht wird. Dies legt nahe, dass Folgendes umgeschrieben werden muss: Umgeschriebene Proben sollten als Kontamination betrachtet werden und sollten es auch sein aus den Trainingsdaten entfernt. In Abschnitt 5.2 muss laut MMLU/HumanEval in diesem Artikel Folgendes umgeschrieben werden: Umschreiben der Probe, um verschiedene Methoden zur Kontaminationserkennung zu bewerten. In Abschnitt 5.3 wenden wir den LLM-Dekontaminator auf ein weit verbreitetes Trainingsset an und entdecken bisher unbekannte Kontaminationen. Als nächstes schauen wir uns einige Hauptergebnisse an Umgeschrieben werden soll: Rewrite Llama-2 7B und 13B, die auf den Proben trainiert wurden, erzielen auf MMLU deutlich hohe Werte von 45,3 bis 88,5. Dies deutet darauf hin, dass umgeschriebene Proben die Basisdaten erheblich verfälschen können und als Kontamination betrachtet werden sollten.

Tabelle 4 unten erzielt den gleichen Effekt:

Bewertung von Nachweismethoden für Kontaminationen

Wie in Tabelle 5 gezeigt, führen alle anderen Nachweismethoden mit Ausnahme des LLM-Dekontaminators zu einigen falsch positiven Ergebnissen. Weder umgeschriebene noch übersetzte Samples werden durch N-Gramm-Überlappung erkannt. Bei Verwendung von Multi-QA-BERT erwies sich die Einbettung der Ähnlichkeitssuche bei übersetzten Proben als völlig wirkungslos.状 Der Verschmutzungsstatus des Datensatzes

In Tabelle 7 wird der Datenverschmutzungsprozentsatz der Datenverschmutzung jedes Trainingsdatensatzes angezeigt 79 Der einzige Inhalt, der neu geschrieben werden muss, ist: Instanzen neu geschriebener Proben, Dies macht 1,58 % des MATH-Testsatzes aus. Beispiel 5 ist eine Anpassung des MATH-Tests an die MATH-Trainingsdaten.

Weitere Informationen finden Sie im Originalpapier

Das obige ist der detaillierte Inhalt vonHat das 13B-Modell im vollständigen Showdown mit GPT-4 den Vorteil? Stecken ungewöhnliche Umstände dahinter?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

Worldcoin (WLD) Preisprognose 2025-2031: Wird WLD bis 2031 $ erreichen?

Apr 21, 2025 pm 02:42 PM

Worldcoin (WLD) Preisprognose 2025-2031: Wird WLD bis 2031 $ erreichen?

Apr 21, 2025 pm 02:42 PM

Worldcoin (WLD) fällt auf dem Kryptowährungsmarkt mit seinen einzigartigen biometrischen Überprüfungs- und Datenschutzschutzmechanismen auf, die die Aufmerksamkeit vieler Investoren auf sich ziehen. WLD hat mit seinen innovativen Technologien, insbesondere in Kombination mit OpenAI -Technologie für künstliche Intelligenz, außerdem unter Altcoins gespielt. Aber wie werden sich die digitalen Vermögenswerte in den nächsten Jahren verhalten? Lassen Sie uns den zukünftigen Preis von WLD zusammen vorhersagen. Die Preisprognose von 2025 WLD wird voraussichtlich im Jahr 2025 ein signifikantes Wachstum in WLD erzielen. Die Marktanalyse zeigt, dass der durchschnittliche WLD -Preis 1,31 USD mit maximal 1,36 USD erreichen kann. In einem Bärenmarkt kann der Preis jedoch auf rund 0,55 US -Dollar fallen. Diese Wachstumserwartung ist hauptsächlich auf Worldcoin2 zurückzuführen.

Was bedeutet Cross-Chain-Transaktion? Was sind die Cross-Chain-Transaktionen?

Apr 21, 2025 pm 11:39 PM

Was bedeutet Cross-Chain-Transaktion? Was sind die Cross-Chain-Transaktionen?

Apr 21, 2025 pm 11:39 PM

Börsen, die Cross-Chain-Transaktionen unterstützen: 1. Binance, 2. Uniswap, 3. Sushiswap, 4. Kurvenfinanzierung, 5. Thorchain, 6. 1inch Exchange, 7. DLN-Handel, diese Plattformen unterstützen Multi-Chain-Asset-Transaktionen durch verschiedene Technologien.

Web3 Trading Platform Ranking_Web3 Globale Top Ten Summary Top Ten Summary

Apr 21, 2025 am 10:45 AM

Web3 Trading Platform Ranking_Web3 Globale Top Ten Summary Top Ten Summary

Apr 21, 2025 am 10:45 AM

Binance ist der Overlord des Global Digital Asset Trading -Ökosystems, und seine Merkmale umfassen: 1. Das durchschnittliche tägliche Handelsvolumen übersteigt 150 Milliarden US -Dollar, unterstützt 500 Handelspaare, die 98% der Mainstream -Währungen abdecken. 2. Die Innovationsmatrix deckt den Markt für Derivate, das Web3 -Layout und den Bildungssystem ab; 3. Die technischen Vorteile sind Millisekunden -Matching -Engines mit Spitzenvolumina von 1,4 Millionen Transaktionen pro Sekunde. 4. Compliance Progress hält 15 Länderlizenzen und legt konforme Einheiten in Europa und den Vereinigten Staaten ein.

Warum ist der Anstieg oder Abfall der virtuellen Währungspreise? Warum ist der Anstieg oder Abfall der virtuellen Währungspreise?

Apr 21, 2025 am 08:57 AM

Warum ist der Anstieg oder Abfall der virtuellen Währungspreise? Warum ist der Anstieg oder Abfall der virtuellen Währungspreise?

Apr 21, 2025 am 08:57 AM

Faktoren der steigenden Preise für virtuelle Währung sind: 1. Erhöhte Marktnachfrage, 2. Verringertes Angebot, 3.. Rückgangsfaktoren umfassen: 1. Verringerte Marktnachfrage, 2. Erhöhtes Angebot, 3. Streik der negativen Nachrichten, 4. Pessimistische Marktstimmung, 5. makroökonomisches Umfeld.

So gewinnen Sie Kernel Airdrop -Belohnungen für Binance vollständige Prozessstrategie

Apr 21, 2025 pm 01:03 PM

So gewinnen Sie Kernel Airdrop -Belohnungen für Binance vollständige Prozessstrategie

Apr 21, 2025 pm 01:03 PM

In der geschäftigen Welt der Kryptowährungen entstehen immer neue Möglichkeiten. Gegenwärtig zieht Kerneldao (Kernel) Airdrop -Aktivität viel Aufmerksamkeit auf sich und zieht die Aufmerksamkeit vieler Investoren auf sich. Also, was ist der Ursprung dieses Projekts? Welche Vorteile können BNB -Inhaber davon bekommen? Machen Sie sich keine Sorgen, das Folgende wird es einzeln für Sie enthüllen.

Aavenomics ist eine Empfehlung, das Aave -Protokoll -Token zu ändern und Token -Rückkauf einzuführen, die die Quorum -Anzahl von Personen erreicht hat.

Apr 21, 2025 pm 06:24 PM

Aavenomics ist eine Empfehlung, das Aave -Protokoll -Token zu ändern und Token -Rückkauf einzuführen, die die Quorum -Anzahl von Personen erreicht hat.

Apr 21, 2025 pm 06:24 PM

Aavenomics ist ein Vorschlag zur Änderung des Aave -Protokoll -Tokens und zur Einführung von Token -Repos, die ein Quorum für Aavedao implementiert hat. Marc Zeller, Gründer der AAVE -Projektkette (ACI), kündigte dies auf X an und stellte fest, dass sie eine neue Ära für die Vereinbarung markiert. Marc Zeller, Gründer der Aave Chain Initiative (ACI), kündigte auf X an, dass der Aavenomics -Vorschlag das Modifizieren des Aave -Protokoll -Tokens und die Einführung von Token -Repos umfasst, hat ein Quorum für Aavedao erreicht. Laut Zeller ist dies eine neue Ära für die Vereinbarung. AVEDAO -Mitglieder stimmten überwiegend für die Unterstützung des Vorschlags, der am Mittwoch 100 pro Woche betrug

Rangliste der Hebelbörsen im Währungskreis Die neuesten Empfehlungen der zehn meistgezogenen Börsen im Währungskreis

Apr 21, 2025 pm 11:24 PM

Rangliste der Hebelbörsen im Währungskreis Die neuesten Empfehlungen der zehn meistgezogenen Börsen im Währungskreis

Apr 21, 2025 pm 11:24 PM

Die Plattformen, die im Jahr 2025 im Leveraged Trading, Security und Benutzererfahrung hervorragende Leistung haben, sind: 1. OKX, geeignet für Hochfrequenzhändler und bieten bis zu 100-fache Hebelwirkung; 2. Binance, geeignet für Mehrwährungshändler auf der ganzen Welt und bietet 125-mal hohe Hebelwirkung; 3. Gate.io, geeignet für professionelle Derivate Spieler, die 100 -fache Hebelwirkung bietet; 4. Bitget, geeignet für Anfänger und Sozialhändler, die bis zu 100 -fache Hebelwirkung bieten; 5. Kraken, geeignet für stetige Anleger, die fünfmal Hebelwirkung liefert; 6. Bybit, geeignet für Altcoin -Entdecker, die 20 -fache Hebelwirkung bietet; 7. Kucoin, geeignet für kostengünstige Händler, die 10-fache Hebelwirkung bietet; 8. Bitfinex, geeignet für das Seniorenspiel

Top 10 Cryptocurrency Exchange -Plattformen Die weltweit größte Liste der digitalen Währung

Apr 21, 2025 pm 07:15 PM

Top 10 Cryptocurrency Exchange -Plattformen Die weltweit größte Liste der digitalen Währung

Apr 21, 2025 pm 07:15 PM

Börsen spielen eine wichtige Rolle auf dem heutigen Kryptowährungsmarkt. Sie sind nicht nur Plattformen, an denen Investoren handeln, sondern auch wichtige Quellen für Marktliquidität und Preisentdeckung. Der weltweit größte virtuelle Währungsbörsen gehören zu den Top Ten, und diese Börsen sind nicht nur im Handelsvolumen weit voraus, sondern haben auch ihre eigenen Vorteile in Bezug auf Benutzererfahrung, Sicherheit und innovative Dienste. Börsen, die über die Liste stehen, haben normalerweise eine große Benutzerbasis und einen umfangreichen Markteinfluss, und deren Handelsvolumen und Vermögenstypen sind häufig mit anderen Börsen schwer zu erreichen.