Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Neuer Titel: Meta verbessert die Transformer-Architektur: ein neuer Aufmerksamkeitsmechanismus, der die Argumentationsfähigkeiten verbessert

Neuer Titel: Meta verbessert die Transformer-Architektur: ein neuer Aufmerksamkeitsmechanismus, der die Argumentationsfähigkeiten verbessert

Neuer Titel: Meta verbessert die Transformer-Architektur: ein neuer Aufmerksamkeitsmechanismus, der die Argumentationsfähigkeiten verbessert

Die Leistungsfähigkeit großer Sprachmodelle (LLM) ist eine unbestrittene Tatsache. Dennoch machen sie manchmal einfache Fehler und zeigen eine schwache Seite der Denkfähigkeit.

LLM kann beispielsweise aufgrund des Kontexts oder der Vorlieben oder Meinungen irrelevant sein Eingabeaufforderungen inhärent. Die letztere Situation stellt ein Problem dar, das als „Speichelei“ bekannt ist und bei dem das Modell mit der Eingabe konsistent bleibt. Gibt es eine Möglichkeit, diese Art von Problem zu lindern? Einige Wissenschaftler versuchen, das Problem zu lösen, indem sie mehr überwachte Trainingsdaten oder verstärkte Lernstrategien hinzufügen, aber diese Methoden können das Problem nicht grundsätzlich lösen Probleme, insbesondere mit seinem Aufmerksamkeitsmechanismus. Mit anderen Worten: Weiche Aufmerksamkeit tendiert dazu, dem größten Teil des Kontexts (einschließlich irrelevanter Teile) Wahrscheinlichkeit zuzuweisen und schenkt wiederholten Token zu viel Aufmerksamkeit

Daher schlugen die Forscher einen völlig anderen Ansatz für den Aufmerksamkeitsmechanismus vor: Das heißt, Aufmerksamkeit wird ausgeführt durch die Verwendung von LLM als Natural Language Reasoner. Insbesondere nutzten sie die Fähigkeit von LLM, Anweisungen zu befolgen, die sie dazu veranlassen, den Kontext zu generieren, auf den sie sich konzentrieren sollten, sodass sie nur relevantes Material einbeziehen, das ihre eigene Argumentation nicht verzerrt. Die Forscher nennen diesen Prozess System-2-Aufmerksamkeit (S2A) und betrachten den zugrunde liegenden Transformator und seinen Aufmerksamkeitsmechanismus als einen automatischen Vorgang, der dem menschlichen System-1-Denken ähnelt Wenn etwas schief geht, verteilt System 2 anstrengende geistige Aktivitäten und übernimmt die menschliche Arbeit. Daher verfolgt dieses Subsystem ähnliche Ziele wie das vom Forscher vorgeschlagene S2A, das den Ausfall der weichen Aufmerksamkeit des oben genannten Transformators durch zusätzliche Arbeit an der Inferenzmaschine lindern möchte. Der Inhalt, der neu geschrieben werden muss, ist: Papierlink : https://arxiv.org/pdf/2311.11829.pdf

Der Forscher beschrieb ausführlich die Kategorien, Motivationen und mehrere spezifische Implementierungen des S2A-Mechanismus. In der experimentellen Phase bestätigten sie, dass S2A ein objektiveres und weniger subjektives Voreingenommenheits- oder Schmeichelei-LLM erzeugen kann als ein standardmäßiges aufmerksamkeitsbasiertes LLM

insbesondere im modifizierten TriviQA-Datensatz, bei dem die Frage im Vergleich zu LLaMA störende Standpunkte enthält -2-70B-chat, S2A verbesserte die Faktizität von 62,8 % auf 80,3 %; bei der Aufgabe zur Erzeugung von Langformparametern, die ablenkende Eingabeemotionen enthielt, verbesserte sich die Objektivität von S2A um 57,4 % und wurde im Wesentlichen nicht durch die Auswirkung des Einfügens von Perspektiven beeinflusst. Darüber hinaus verbesserte S2A bei mathematischen Textaufgaben mit irrelevanten Sätzen in GSM-IC die Genauigkeit von 51,7 % auf 61,3 %.

Diese Studie wurde von Yann LeCun empfohlen.

System 2 Achtung

Abbildung 1 unten zeigt ein Beispiel einer Pseudokorrelation. Selbst das leistungsfähigste LLM ändert die Antwort auf eine einfache Faktenfrage, wenn der Kontext irrelevante Sätze enthält, da das Vorhandensein von Wörtern im Kontext unbeabsichtigt die Wahrscheinlichkeit einer falschen Antwort erhöht

Deshalb müssen wir arbeiten auf einem besser verstandenen, durchdachteren Aufmerksamkeitsmechanismus. Um ihn vom Aufmerksamkeitsmechanismus auf niedrigerer Ebene zu unterscheiden, schlugen die Forscher ein System namens S2A vor. Sie untersuchten eine Möglichkeit, LLM selbst zu nutzen, um diesen Aufmerksamkeitsmechanismus aufzubauen, und passten insbesondere das LLM an, indem sie irrelevanten Text entfernten, um kontextbezogene Anweisungen neu zu schreiben

Mit diesem Ansatz ist das LLM in der Lage, zu reagieren, bevor eine Antwort generiert wird. Sorgfältige Argumentation und Entscheidungsfindung über relevante Teile der Eingabe. Ein weiterer Vorteil der Verwendung von anweisungsangepasstem LLM besteht darin, dass es den Fokus der Aufmerksamkeit steuern kann, was in gewisser Weise der Art und Weise ähnelt, wie Menschen ihre Aufmerksamkeit steuern und zwei Schritte umfassen:

- Bei einem gegebenen Kontext x regeneriert S2A zunächst den Kontext x‘ und entfernt dadurch irrelevante Teile des Kontexts, die sich negativ auf die Ausgabe auswirken würden. Dieser Artikel drückt es als x ′ ∼ S2A (x) aus.

- Bei gegebenem x ′ wird dann der neu generierte Kontext anstelle des ursprünglichen Kontexts verwendet, um die endgültige Antwort des LLM zu generieren: y ∼ LLM (x ′ ).

Alternative Implementierungen und Variationen

In diesem Artikel haben wir uns mehrere verschiedene Versionen des S2A-Ansatzes

ohne Kontext- und Problemtrennung angesehen. In der Implementierung von Abbildung 2 entscheiden wir uns dafür, den in zwei Teile (Kontext und Frage) zerlegten Kontext neu zu generieren. Abbildung 12 zeigt eine Variation dieser Eingabeaufforderung.

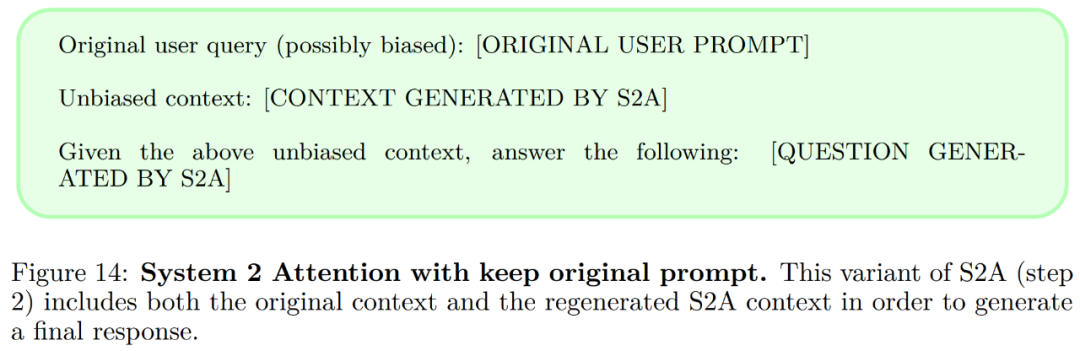

Ursprünglichen Kontext beibehalten In S2A sollten nach der Neugenerierung des Kontexts alle notwendigen Elemente, die berücksichtigt werden sollten, enthalten sein, dann reagiert das Modell nur auf den neu generierten Kontext, der ursprüngliche Kontext wird verworfen. Abbildung 14 zeigt eine Variation dieser Eingabeaufforderung.

Imperative Aufforderungen. Die in Abbildung 2 dargestellte S2A-Eingabeaufforderung ermutigt dazu, meinungsgebundenen Text aus dem Kontext zu entfernen und erfordert eine Antwort, die nicht meinungsgebunden ist, unter Verwendung der Anweisungen in Schritt 2 (Abbildung 13).

S2A-Implementierungen legen alle Wert auf die Regenerierung des Kontexts, um die Objektivität zu erhöhen und Speichelleckerei zu reduzieren. Der Artikel argumentiert jedoch, dass es noch andere Punkte gibt, die hervorgehoben werden müssen, zum Beispiel können wir Relevanz gegenüber Irrelevanz betonen. Die Eingabeaufforderungsvariante in Abbildung 15 zeigt ein Beispiel. Darüber hinaus verwendet dieser Artikel LLaMA-2-70B-chat als Basismodell, das in zwei Einstellungen ausgewertet wird . Die Modellgenerierung kann durch falsche Korrelationen in der Eingabe beeinträchtigt werden.

Oracle-Eingabeaufforderung: Eingabeaufforderungen ohne zusätzliche Meinungen oder irrelevante Sätze werden in das Modell eingespeist und im Zero-Shot-Verfahren beantwortet.

Oracle-Eingabeaufforderung: Eingabeaufforderungen ohne zusätzliche Meinungen oder irrelevante Sätze werden in das Modell eingespeist und im Zero-Shot-Verfahren beantwortet.

Abbildung 5 (links) zeigt die Bewertungsergebnisse zur Beantwortung von Faktenfragen. System 2 Attention stellt eine enorme Verbesserung gegenüber der ursprünglichen Eingabeaufforderung dar und erreicht eine Genauigkeit von 80,3 % – nahe der Leistung von Oracle Prompt.

- Die Gesamtergebnisse zeigen, dass Baseline, Oracle Prompt und System 2 Attention alle ähnlich hochwertige Auswertungen liefern können. Abbildung 6 (rechts) zeigt die Teilergebnisse:

Das obige ist der detaillierte Inhalt vonNeuer Titel: Meta verbessert die Transformer-Architektur: ein neuer Aufmerksamkeitsmechanismus, der die Argumentationsfähigkeiten verbessert. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1378

1378

52

52

Open Source! Jenseits von ZoeDepth! DepthFM: Schnelle und genaue monokulare Tiefenschätzung!

Apr 03, 2024 pm 12:04 PM

Open Source! Jenseits von ZoeDepth! DepthFM: Schnelle und genaue monokulare Tiefenschätzung!

Apr 03, 2024 pm 12:04 PM

0.Was bewirkt dieser Artikel? Wir schlagen DepthFM vor: ein vielseitiges und schnelles generatives monokulares Tiefenschätzungsmodell auf dem neuesten Stand der Technik. Zusätzlich zu herkömmlichen Tiefenschätzungsaufgaben demonstriert DepthFM auch hochmoderne Fähigkeiten bei nachgelagerten Aufgaben wie dem Tiefen-Inpainting. DepthFM ist effizient und kann Tiefenkarten innerhalb weniger Inferenzschritte synthetisieren. Lassen Sie uns diese Arbeit gemeinsam lesen ~ 1. Titel der Papierinformationen: DepthFM: FastMonocularDepthEstimationwithFlowMatching Autor: MingGui, JohannesS.Fischer, UlrichPrestel, PingchuanMa, Dmytr

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Stellen Sie sich ein Modell der künstlichen Intelligenz vor, das nicht nur die Fähigkeit besitzt, die traditionelle Datenverarbeitung zu übertreffen, sondern auch eine effizientere Leistung zu geringeren Kosten erzielt. Dies ist keine Science-Fiction, DeepSeek-V2[1], das weltweit leistungsstärkste Open-Source-MoE-Modell, ist da. DeepSeek-V2 ist ein leistungsstarkes MoE-Sprachmodell (Mix of Experts) mit den Merkmalen eines wirtschaftlichen Trainings und einer effizienten Inferenz. Es besteht aus 236B Parametern, von denen 21B zur Aktivierung jedes Markers verwendet werden. Im Vergleich zu DeepSeek67B bietet DeepSeek-V2 eine stärkere Leistung, spart gleichzeitig 42,5 % der Trainingskosten, reduziert den KV-Cache um 93,3 % und erhöht den maximalen Generierungsdurchsatz auf das 5,76-fache. DeepSeek ist ein Unternehmen, das sich mit allgemeiner künstlicher Intelligenz beschäftigt

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI verändert tatsächlich die Mathematik. Vor kurzem hat Tao Zhexuan, der diesem Thema große Aufmerksamkeit gewidmet hat, die neueste Ausgabe des „Bulletin of the American Mathematical Society“ (Bulletin der American Mathematical Society) weitergeleitet. Zum Thema „Werden Maschinen die Mathematik verändern?“ äußerten viele Mathematiker ihre Meinung. Der gesamte Prozess war voller Funken, knallhart und aufregend. Der Autor verfügt über eine starke Besetzung, darunter der Fields-Medaillengewinner Akshay Venkatesh, der chinesische Mathematiker Zheng Lejun, der NYU-Informatiker Ernest Davis und viele andere bekannte Wissenschaftler der Branche. Die Welt der KI hat sich dramatisch verändert. Viele dieser Artikel wurden vor einem Jahr eingereicht.

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

Anfang dieses Monats schlugen Forscher des MIT und anderer Institutionen eine vielversprechende Alternative zu MLP vor – KAN. KAN übertrifft MLP in Bezug auf Genauigkeit und Interpretierbarkeit. Und es kann MLP, das mit einer größeren Anzahl von Parametern ausgeführt wird, mit einer sehr kleinen Anzahl von Parametern übertreffen. Beispielsweise gaben die Autoren an, dass sie KAN nutzten, um die Ergebnisse von DeepMind mit einem kleineren Netzwerk und einem höheren Automatisierungsgrad zu reproduzieren. Konkret verfügt DeepMinds MLP über etwa 300.000 Parameter, während KAN nur etwa 200 Parameter hat. KAN hat eine starke mathematische Grundlage wie MLP und basiert auf dem universellen Approximationssatz, während KAN auf dem Kolmogorov-Arnold-Darstellungssatz basiert. Wie in der folgenden Abbildung gezeigt, hat KAN

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas tritt offiziell in die Ära der Elektroroboter ein! Gestern hat sich der hydraulische Atlas einfach „unter Tränen“ von der Bühne der Geschichte zurückgezogen. Heute gab Boston Dynamics bekannt, dass der elektrische Atlas im Einsatz ist. Es scheint, dass Boston Dynamics im Bereich kommerzieller humanoider Roboter entschlossen ist, mit Tesla zu konkurrieren. Nach der Veröffentlichung des neuen Videos wurde es innerhalb von nur zehn Stunden bereits von mehr als einer Million Menschen angesehen. Die alten Leute gehen und neue Rollen entstehen. Das ist eine historische Notwendigkeit. Es besteht kein Zweifel, dass dieses Jahr das explosive Jahr der humanoiden Roboter ist. Netizens kommentierten: Die Weiterentwicklung der Roboter hat dazu geführt, dass die diesjährige Eröffnungsfeier wie Menschen aussieht, und der Freiheitsgrad ist weitaus größer als der von Menschen. Aber ist das wirklich kein Horrorfilm? Zu Beginn des Videos liegt Atlas ruhig auf dem Boden, scheinbar auf dem Rücken. Was folgt, ist atemberaubend

Die Kuaishou-Version von Sora „Ke Ling' steht zum Testen offen: Sie generiert über 120 Sekunden Videos, versteht die Physik besser und kann komplexe Bewegungen genau modellieren

Jun 11, 2024 am 09:51 AM

Die Kuaishou-Version von Sora „Ke Ling' steht zum Testen offen: Sie generiert über 120 Sekunden Videos, versteht die Physik besser und kann komplexe Bewegungen genau modellieren

Jun 11, 2024 am 09:51 AM

Was? Wird Zootopia durch heimische KI in die Realität umgesetzt? Zusammen mit dem Video wird ein neues groß angelegtes inländisches Videogenerationsmodell namens „Keling“ vorgestellt. Sora geht einen ähnlichen technischen Weg und kombiniert eine Reihe selbst entwickelter technologischer Innovationen, um Videos zu produzieren, die nicht nur große und vernünftige Bewegungen aufweisen, sondern auch die Eigenschaften der physischen Welt simulieren und über starke konzeptionelle Kombinationsfähigkeiten und Vorstellungskraft verfügen. Den Daten zufolge unterstützt Keling die Erstellung ultralanger Videos von bis zu 2 Minuten mit 30 Bildern pro Sekunde, mit Auflösungen von bis zu 1080p und unterstützt mehrere Seitenverhältnisse. Ein weiterer wichtiger Punkt ist, dass es sich bei Keling nicht um eine vom Labor veröffentlichte Demo oder Video-Ergebnisdemonstration handelt, sondern um eine Anwendung auf Produktebene, die von Kuaishou, einem führenden Anbieter im Bereich Kurzvideos, gestartet wurde. Darüber hinaus liegt das Hauptaugenmerk darauf, pragmatisch zu sein, keine Blankoschecks auszustellen und sofort nach der Veröffentlichung online zu gehen. Das große Modell von Ke Ling wurde bereits in Kuaiying veröffentlicht.

Die Vitalität der Superintelligenz erwacht! Aber mit der Einführung der sich selbst aktualisierenden KI müssen sich Mütter keine Sorgen mehr über Datenengpässe machen

Apr 29, 2024 pm 06:55 PM

Die Vitalität der Superintelligenz erwacht! Aber mit der Einführung der sich selbst aktualisierenden KI müssen sich Mütter keine Sorgen mehr über Datenengpässe machen

Apr 29, 2024 pm 06:55 PM

Ich weine zu Tode. Die Daten im Internet reichen überhaupt nicht aus. Das Trainingsmodell sieht aus wie „Die Tribute von Panem“, und KI-Forscher auf der ganzen Welt machen sich Gedanken darüber, wie sie diese datenhungrigen Esser ernähren sollen. Dieses Problem tritt insbesondere bei multimodalen Aufgaben auf. Zu einer Zeit, als sie ratlos waren, nutzte ein Start-up-Team der Abteilung der Renmin-Universität von China sein eigenes neues Modell, um als erstes in China einen „modellgenerierten Datenfeed selbst“ in die Realität umzusetzen. Darüber hinaus handelt es sich um einen zweigleisigen Ansatz auf der Verständnisseite und der Generierungsseite. Beide Seiten können hochwertige, multimodale neue Daten generieren und Datenrückmeldungen an das Modell selbst liefern. Was ist ein Modell? Awaker 1.0, ein großes multimodales Modell, das gerade im Zhongguancun-Forum erschienen ist. Wer ist das Team? Sophon-Motor. Gegründet von Gao Yizhao, einem Doktoranden an der Hillhouse School of Artificial Intelligence der Renmin University.

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

Die Zielerkennung ist ein relativ ausgereiftes Problem in autonomen Fahrsystemen, wobei die Fußgängererkennung einer der ersten Algorithmen ist, die eingesetzt werden. In den meisten Arbeiten wurde eine sehr umfassende Recherche durchgeführt. Die Entfernungswahrnehmung mithilfe von Fischaugenkameras für die Rundumsicht ist jedoch relativ wenig untersucht. Aufgrund der großen radialen Verzerrung ist es schwierig, die standardmäßige Bounding-Box-Darstellung in Fischaugenkameras zu implementieren. Um die obige Beschreibung zu vereinfachen, untersuchen wir erweiterte Begrenzungsrahmen-, Ellipsen- und allgemeine Polygondesigns in Polar-/Winkeldarstellungen und definieren eine mIOU-Metrik für die Instanzsegmentierung, um diese Darstellungen zu analysieren. Das vorgeschlagene Modell „fisheyeDetNet“ mit polygonaler Form übertrifft andere Modelle und erreicht gleichzeitig 49,5 % mAP auf dem Valeo-Fisheye-Kameradatensatz für autonomes Fahren