Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Ein neuer Durchbruch in der Videogenerierung: PixelDance, das komplexe Bewegungen und coole Spezialeffekte einfach präsentiert

Ein neuer Durchbruch in der Videogenerierung: PixelDance, das komplexe Bewegungen und coole Spezialeffekte einfach präsentiert

Ein neuer Durchbruch in der Videogenerierung: PixelDance, das komplexe Bewegungen und coole Spezialeffekte einfach präsentiert

Zusätzlich zu den vielbeachteten groß angelegten Sprachmodellen, die weiterhin die Schlagzeilen dominieren, hat auch die Videogenerierungstechnologie weiterhin große Durchbrüche erzielt. Viele Unternehmen haben nacheinander neue Modelle herausgebracht.

Zuallererst: Runway ist das erste Unternehmen, das den Bereich der Videoerzeugung erkundet und sein Gen-2-Modell aktualisiert hat, um eine filmische High-Definition zu bieten, die ins Auge fällt. Gleichzeitig wurde auch die Konsistenz der Videogenerierung deutlich verbessert

Allerdings scheint diese Verbesserung der Konsistenz auf Kosten der Videodynamik zu gehen. Aus dem offiziellen Werbevideo von Gen-2 geht hervor, dass zwar mehrere kurze Clips zusammengestellt werden, die Dynamik jedes Clips jedoch relativ schwach ist, was es schwierig macht, klare Aktionen und Bewegungen von Charakteren, Tieren oder Objekten einzufangen.

Vor kurzem hat Meta auch das Videogenerierungsmodell Emu Video veröffentlicht. Wie aus den offiziellen Beispielen von Emu Video hervorgeht, ist die Dynamik seiner Videos im Vergleich zu Gen-2 deutlich verbessert, sie beschränken sich jedoch immer noch auf einfachere Aktionen.

Stability.ai, das Unternehmen, das das klassische Vincent-Graphmodell Stable Diffusion entwickelt hat, hat kürzlich auch das Open-Source-Videogenerierungsmodell Stable Video Diffusion (SVD) veröffentlicht, das viel Aufmerksamkeit und Diskussion auf sich gezogen hat Open-Source-Community. Der Effekt von SVD ist vergleichbar mit dem von Gen-2. Aus dem Testbeispiel ist ersichtlich, dass es dem von SVD erzeugten Video relativ an Dynamik mangelt.

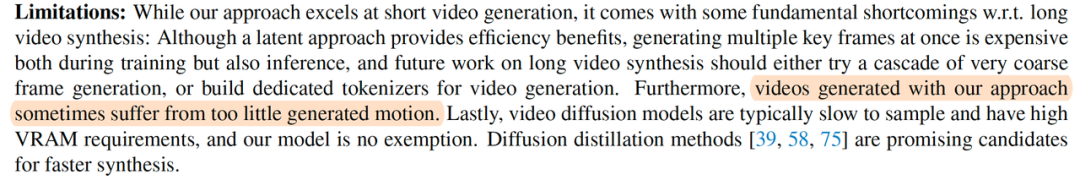

weist im SVD-Papier darauf hin, dass das aktuelle von SVD generierte Video eine unzureichende Dynamik aufweist bewegt, es ist derzeit die größte Herausforderung im Bereich der Videogenerierung.

In dieser Hinsicht haben die neuesten Forschungsergebnisse PixelDance einen entscheidenden Schritt gemacht. Die Dynamik der generierten Ergebnisse ist deutlich besser als bei anderen bestehenden Modellen, was die Aufmerksamkeit der Branche auf sich gezogen hat.

Die vom berühmten KI-Blogger @_akhaliq auf Twitter weitergeleiteten PixelDance-Nachrichten haben auf der offiziellen Website (https://pixel.com) fast 80.000 Aufrufe erhalten macht Tanz .io) bietet PixelDance zwei verschiedene Videogenerierungsmodi.

Es stehen zwei Modi zur Auswahl, der erste ist der Basismodus. In diesem Modus müssen Benutzer lediglich ein Leitbild und eine Textbeschreibung bereitstellen, und PixelDance kann ein äußerst konsistentes und dynamisches Video generieren. Das Führungsbild kann ein echtes Foto sein oder durch ein vorhandenes textgeneriertes Bildmodell generiert werden. Den angezeigten Ergebnissen nach zu urteilen, kann PixelDance alle Probleme im echten Stil, im Animationsstil, im zweidimensionalen Stil und im magischen Stil lösen ., Charakterbewegungen, Gesichtsausdrücke, Kameraperspektivensteuerung, Spezialeffektbewegungen, Pixeldance können ebenfalls sehr gut ausgeführt werden. Ich kann nur sagen: TQL!

Der zweite ist der erweiterte Magic-Modus, der den Benutzern mehr Raum gibt, ihrer Fantasie und Kreativität freien Lauf zu lassen. In diesem Modus müssen Benutzer zwei Leitbilder und eine Textbeschreibung bereitstellen, wodurch schwierigere Videoinhalte besser generiert werden können. Die Website zeigt verschiedene coole Spezialeffektaufnahmen, die mit dem Magic-Modus erstellt wurden.

Darüber hinaus zeigt die offizielle Website auch einen 3-minütigen Kurzgeschichtenfilm, der vollständig mit PixelDance produziert wurde

Das Erstaunlichste ist, dass mit PixelDance jede Szene und die entsprechende Aktion entsprechend einer vom Benutzer vorgestellten Geschichte erstellt werden kann. Ganz gleich, ob es sich um eine reale Szene (z. B. Ägypten, die Chinesische Mauer usw.) oder eine imaginäre Szene (z. B. einen außerirdischen Planeten) handelt, PixelDance kann Videos mit vielen Details und Action erzeugen, sogar Aufnahmen mit verschiedenen Spezialeffekten.

Der schwarze Zylinder und die rote Fliege des Protagonisten Mr. Polar Bear sind in verschiedenen Szenen gut erhalten. Jetzt geht es bei der Erstellung langer Videos nicht mehr darum, einfach irrelevante kurze Videoclips zusammenzusetzen!

Um einen solch herausragenden Videogenerierungseffekt zu erzielen, ist es nicht auf komplexe Datensätze und umfangreiches Modelltraining angewiesen, um den oben genannten Effekt zu erzielen. .

Papieradresse: https://arxiv.org/abs/2311.10982

Schreiben Sie den Inhalt neu, ohne die ursprüngliche Bedeutung zu ändern, und schreiben Sie ihn ins Chinesische um: Bitte besuchen Sie die folgende Website, um die Demo zu erhalten: https ://makepixelsdance.github.io

In dem entsprechenden Artikel „Make Pixels Dance: High-Dynamic Video Generation“ wies der Autor darauf hin, warum es bei der Videogenerierung schwierig ist, gute Ergebnisse zu erzielen: im Vergleich zur Bildgenerierung, Video Generation verfügt über einen deutlich größeren Funktionsumfang, eine deutlich größere Aktionsvielfalt. Dies macht es für bestehende Videogenerierungsmethoden schwierig, effektive Zeitbereichsaktionsinformationen zu lernen. Obwohl die generierten Videos eine hohe Bildqualität aufweisen, ist ihre Dynamik sehr begrenzt.

Als Reaktion auf die oben genannten Probleme schlägt PixelDance eine Methode zur Videogenerierung vor, die auf Textführung + Bildführung für das erste und letzte Bild basiert, damit das Modell den dynamischen Informationen des Videos besser Aufmerksamkeit schenken und sie lernen kann.

Bei der Videogenerierung liefert das erste Einzelbild den Rahmen und das Material für den gesamten Videoinhalt. Gleichzeitig können längere Videos erstellt werden, indem das letzte Bild des vorherigen Videoclips als Leitfaden für das erste Bild des nächsten Clips verwendet wird. Die Videotextbeschreibung beschreibt den konkreten Inhalt der Videoaktion. Die letzte Bildführung liefert Endstatusinformationen für den Videogenerierungsprozess. Der Autor schlägt eine Anpassungsmethode vor, die es dem Modell ermöglicht, relativ grobe Bilder als Anleitung zu akzeptieren, sodass Benutzer grundlegende Bildbearbeitungswerkzeuge verwenden können, um eine Endbild-Bildführung zu erhalten

Die Informationsanzeige auf der offiziellen Website ist während der Iteration noch aktiv Mit den Modelleffekten wird in den nächsten 2-3 Monaten ein Modell veröffentlicht, das jeder ausprobieren kann. Derzeit bietet der Autor auch eine Möglichkeit, allen zu helfen, Muster zu senden, die sie testen möchten. Derzeit wurden einige Benutzertestbeispiele auf der offiziellen Website veröffentlicht:

Es scheint, dass dies bei PixelDance der Fall ist Da Sie eine wilde Fantasie haben, kann jeder mit Kraft ein „Millionen-Dollar-Spezialeffektmeister“ werden!

Das obige ist der detaillierte Inhalt vonEin neuer Durchbruch in der Videogenerierung: PixelDance, das komplexe Bewegungen und coole Spezialeffekte einfach präsentiert. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1371

1371

52

52

Welche Methode wird verwendet, um Strings in Objekte in Vue.js umzuwandeln?

Apr 07, 2025 pm 09:39 PM

Welche Methode wird verwendet, um Strings in Objekte in Vue.js umzuwandeln?

Apr 07, 2025 pm 09:39 PM

Bei der Konvertierung von Zeichenfolgen in Objekte in Vue.js wird JSON.Parse () für Standard -JSON -Zeichenfolgen bevorzugt. Bei nicht standardmäßigen JSON-Zeichenfolgen kann die Zeichenfolge durch Verwendung regelmäßiger Ausdrücke verarbeitet und Methoden gemäß dem Format oder dekodierten URL-kodiert reduziert werden. Wählen Sie die entsprechende Methode gemäß dem String -Format aus und achten Sie auf Sicherheits- und Codierungsprobleme, um Fehler zu vermeiden.

Remote Senior Backend Engineers (Plattformen) benötigen Kreise

Apr 08, 2025 pm 12:27 PM

Remote Senior Backend Engineers (Plattformen) benötigen Kreise

Apr 08, 2025 pm 12:27 PM

Remote Senior Backend Engineer Job Vacant Company: Circle Standort: Remote-Büro-Jobtyp: Vollzeitgehalt: 130.000 bis 140.000 US-Dollar Stellenbeschreibung Nehmen Sie an der Forschung und Entwicklung von Mobilfunkanwendungen und öffentlichen API-bezogenen Funktionen, die den gesamten Lebenszyklus der Softwareentwicklung abdecken. Die Hauptaufgaben erledigen die Entwicklungsarbeit unabhängig von RubyonRails und arbeiten mit dem Front-End-Team von React/Redux/Relay zusammen. Erstellen Sie die Kernfunktionalität und -verbesserungen für Webanwendungen und arbeiten Sie eng mit Designer und Führung während des gesamten funktionalen Designprozesses zusammen. Fördern Sie positive Entwicklungsprozesse und priorisieren Sie die Iterationsgeschwindigkeit. Erfordert mehr als 6 Jahre komplexes Backend für Webanwendungen

VUE.JS Wie kann man ein Array von String -Typ in ein Array von Objekten umwandeln?

Apr 07, 2025 pm 09:36 PM

VUE.JS Wie kann man ein Array von String -Typ in ein Array von Objekten umwandeln?

Apr 07, 2025 pm 09:36 PM

Zusammenfassung: Es gibt die folgenden Methoden zum Umwandeln von VUE.JS -String -Arrays in Objektarrays: Grundlegende Methode: Verwenden Sie die Kartenfunktion, um regelmäßige formatierte Daten zu entsprechen. Erweitertes Gameplay: Die Verwendung regulärer Ausdrücke kann komplexe Formate ausführen, müssen jedoch sorgfältig geschrieben und berücksichtigt werden. Leistungsoptimierung: In Betracht ziehen die große Datenmenge, asynchrone Operationen oder effiziente Datenverarbeitungsbibliotheken können verwendet werden. Best Practice: Clear Code -Stil, verwenden Sie sinnvolle variable Namen und Kommentare, um den Code präzise zu halten.

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

Der Artikel führt den Betrieb der MySQL -Datenbank vor. Zunächst müssen Sie einen MySQL -Client wie MySQLworkBench oder Befehlszeilen -Client installieren. 1. Verwenden Sie den Befehl mySQL-uroot-P, um eine Verbindung zum Server herzustellen und sich mit dem Stammkonto-Passwort anzumelden. 2. Verwenden Sie die Erstellung von Createdatabase, um eine Datenbank zu erstellen, und verwenden Sie eine Datenbank aus. 3.. Verwenden Sie CreateTable, um eine Tabelle zu erstellen, Felder und Datentypen zu definieren. 4. Verwenden Sie InsertInto, um Daten einzulegen, Daten abzufragen, Daten nach Aktualisierung zu aktualisieren und Daten nach Löschen zu löschen. Nur indem Sie diese Schritte beherrschen, lernen, mit gemeinsamen Problemen umzugehen und die Datenbankleistung zu optimieren, können Sie MySQL effizient verwenden.

Laravels Geospatial: Optimierung interaktiver Karten und großen Datenmengen

Apr 08, 2025 pm 12:24 PM

Laravels Geospatial: Optimierung interaktiver Karten und großen Datenmengen

Apr 08, 2025 pm 12:24 PM

Verarbeiten Sie 7 Millionen Aufzeichnungen effizient und erstellen Sie interaktive Karten mit Geospatial -Technologie. In diesem Artikel wird untersucht, wie über 7 Millionen Datensätze mithilfe von Laravel und MySQL effizient verarbeitet und in interaktive Kartenvisualisierungen umgewandelt werden können. Erstes Herausforderungsprojektanforderungen: Mit 7 Millionen Datensätzen in der MySQL -Datenbank wertvolle Erkenntnisse extrahieren. Viele Menschen erwägen zunächst Programmiersprachen, aber ignorieren die Datenbank selbst: Kann sie den Anforderungen erfüllen? Ist Datenmigration oder strukturelle Anpassung erforderlich? Kann MySQL einer so großen Datenbelastung standhalten? Voranalyse: Schlüsselfilter und Eigenschaften müssen identifiziert werden. Nach der Analyse wurde festgestellt, dass nur wenige Attribute mit der Lösung zusammenhängen. Wir haben die Machbarkeit des Filters überprüft und einige Einschränkungen festgelegt, um die Suche zu optimieren. Kartensuche basierend auf der Stadt

Vue- und Element-UI-Kaskaden-Dropdown-Box V-Model-Bindung

Apr 07, 2025 pm 08:06 PM

Vue- und Element-UI-Kaskaden-Dropdown-Box V-Model-Bindung

Apr 07, 2025 pm 08:06 PM

Vue- und Element-UI-kaskadierte Dropdown-Boxen V-Model-Bindung gemeinsame Grubenpunkte: V-Model bindet ein Array, das die ausgewählten Werte auf jeder Ebene des kaskadierten Auswahlfelds darstellt, nicht auf einer Zeichenfolge; Der Anfangswert von ausgewählten Optionen muss ein leeres Array sein, nicht null oder undefiniert. Die dynamische Belastung von Daten erfordert die Verwendung asynchroner Programmierkenntnisse, um Datenaktualisierungen asynchron zu verarbeiten. Für riesige Datensätze sollten Leistungsoptimierungstechniken wie virtuelles Scrollen und fauler Laden in Betracht gezogen werden.

So optimieren Sie die Datenbankleistung nach der MySQL -Installation

Apr 08, 2025 am 11:36 AM

So optimieren Sie die Datenbankleistung nach der MySQL -Installation

Apr 08, 2025 am 11:36 AM

Die MySQL -Leistungsoptimierung muss von drei Aspekten beginnen: Installationskonfiguration, Indexierung und Abfrageoptimierung, Überwachung und Abstimmung. 1. Nach der Installation müssen Sie die my.cnf -Datei entsprechend der Serverkonfiguration anpassen, z. 2. Erstellen Sie einen geeigneten Index, um übermäßige Indizes zu vermeiden und Abfrageanweisungen zu optimieren, z. B. den Befehl Erklärung zur Analyse des Ausführungsplans; 3. Verwenden Sie das eigene Überwachungstool von MySQL (ShowProcessList, Showstatus), um die Datenbankgesundheit zu überwachen und die Datenbank regelmäßig zu sichern und zu organisieren. Nur durch kontinuierliche Optimierung dieser Schritte kann die Leistung der MySQL -Datenbank verbessert werden.

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Es gibt viele Gründe, warum MySQL Startup fehlschlägt und durch Überprüfung des Fehlerprotokolls diagnostiziert werden kann. Zu den allgemeinen Ursachen gehören Portkonflikte (prüfen Portbelegung und Änderung der Konfiguration), Berechtigungsprobleme (Überprüfen Sie den Dienst Ausführen von Benutzerberechtigungen), Konfigurationsdateifehler (Überprüfung der Parametereinstellungen), Datenverzeichniskorruption (Wiederherstellung von Daten oder Wiederaufbautabellenraum), InnoDB-Tabellenraumprobleme (prüfen IBDATA1-Dateien), Plug-in-Ladeversagen (Überprüfen Sie Fehlerprotokolle). Wenn Sie Probleme lösen, sollten Sie sie anhand des Fehlerprotokolls analysieren, die Hauptursache des Problems finden und die Gewohnheit entwickeln, Daten regelmäßig zu unterstützen, um Probleme zu verhindern und zu lösen.