Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Die nächste heiße Anwendung von KI-Anwendungen ist aufgetaucht: Alibaba und ByteDance haben still und leise ein ähnliches Artefakt auf den Markt gebracht, das Messi leicht zum Tanzen bringen kann

Die nächste heiße Anwendung von KI-Anwendungen ist aufgetaucht: Alibaba und ByteDance haben still und leise ein ähnliches Artefakt auf den Markt gebracht, das Messi leicht zum Tanzen bringen kann

Die nächste heiße Anwendung von KI-Anwendungen ist aufgetaucht: Alibaba und ByteDance haben still und leise ein ähnliches Artefakt auf den Markt gebracht, das Messi leicht zum Tanzen bringen kann

Das Artefakt zur KI-Videogenerierung ist wieder da. Vor Kurzem haben Alibaba und ByteDance heimlich ihre jeweiligen Tools auf den Markt gebracht

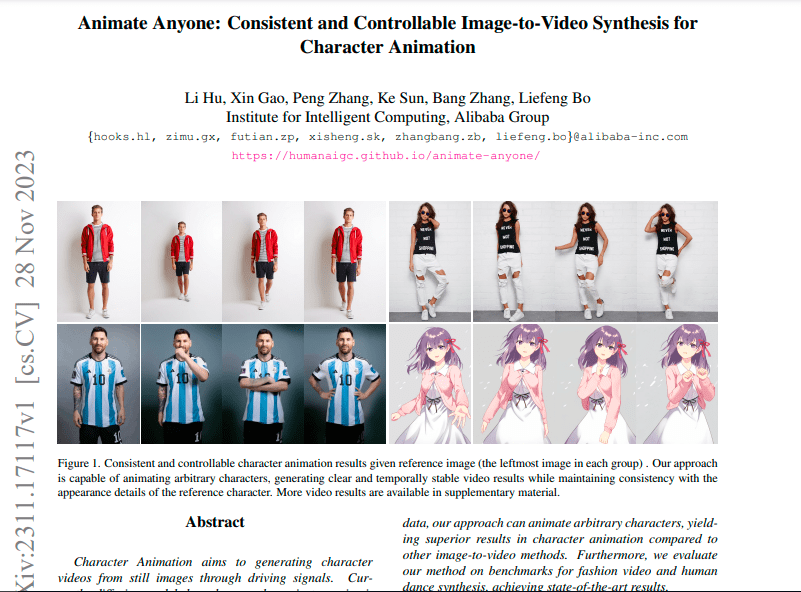

Ali hat Animate Everyone gestartet, ein vom Alibaba Intelligent Computing Research Institute entwickeltes Projekt. Sie müssen lediglich ein statisches Charakterbild (einschließlich realer Personen, Animations-/Cartoonfiguren usw.) sowie einige Aktionen und Körperhaltungen (z. B. Tanzen, Gehen) bereitstellen. . Es kann unter Beibehaltung der detaillierten Merkmale des Charakters (wie Gesichtsausdrücke, Kleidungsdetails usw.) animiert werden.

Solange es ein Foto von Messi gibt, kann der „König des Fußballs“ zu verschiedenen Posen aufgefordert werden (siehe Bild unten). Nach diesem Prinzip ist es einfach, Messi zum Tanzen zu bringen.

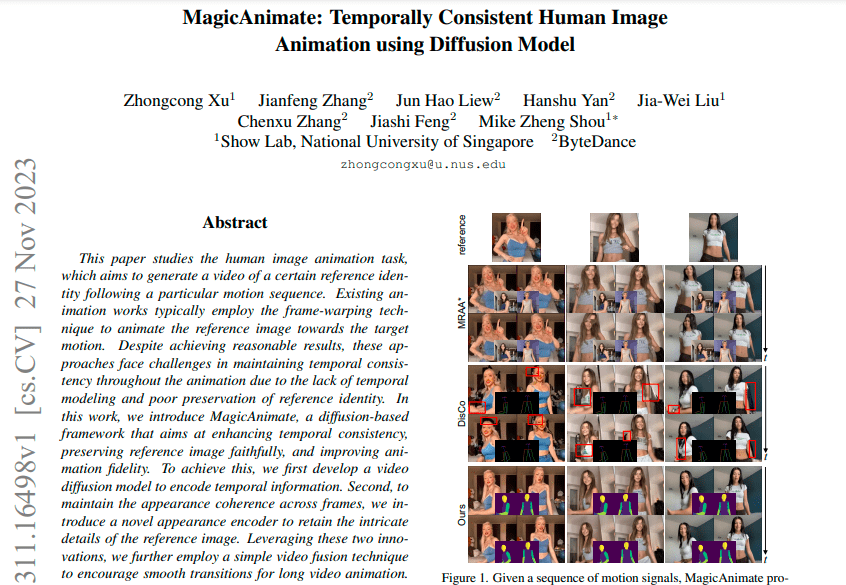

Die National University of Singapore und ByteDance haben gemeinsam Magic Animate ins Leben gerufen, das ebenfalls KI-Technologie nutzt, um statische Bilder in dynamische Videos umzuwandeln. Byte sagte, dass sich der Realismus des von Magic Animate generierten Videos im äußerst anspruchsvollen TikTok-Tanzdatensatz im Vergleich zur stärksten Basislinie um mehr als 38 % verbessert habe.

Beim Tusheng Video-Projekt gingen Alibaba und ByteDance Hand in Hand und führten eine Reihe von Vorgängen wie Papierfreigabe, Code-Offenlegung und Testadressen-Offenlegung fast gleichzeitig durch. Die Veröffentlichungszeit der beiden verwandten Papiere lag nur einen Tag auseinander

Ein verwandter Artikel zu Bytes wurde am 27. November veröffentlicht:

Ali-bezogene Papiere werden am 28. November veröffentlicht:

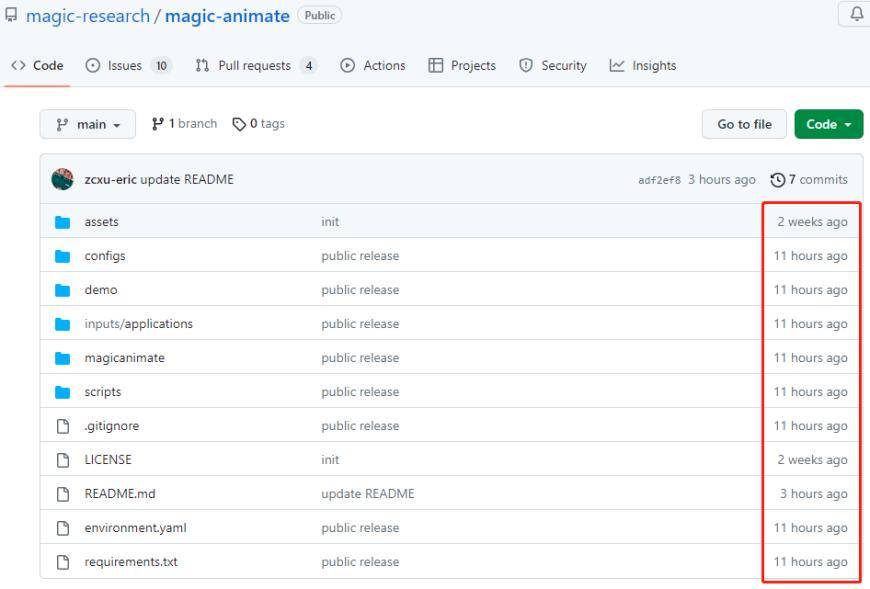

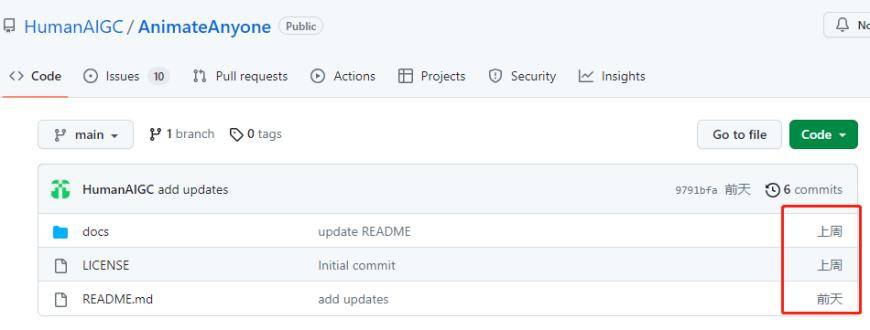

Die Open-Source-Dateien der beiden Unternehmen werden laufend auf Github aktualisiert

Der Inhalt, der neu geschrieben werden muss, ist: Das Open-Source-Projektdateipaket von Magic Animate

Animieren Sie das Open-Source-Projektdateipaket von Everyone

Dies unterstreicht noch einmal die Tatsache: Videogenerierung ist ein beliebtes Wettbewerbsereignis in AIGC, und Technologiegiganten und Starunternehmen schenken ihr große Aufmerksamkeit und investieren aktiv in sie. Es wird davon ausgegangen, dass Runway, Meta und Stable AI AI Vincent-Videoanwendungen auf den Markt gebracht haben, und Adobe hat kürzlich die Übernahme des KI-Videoerstellungsunternehmens Rephrase.ai bekannt gegeben.

Den Anzeigevideos der beiden oben genannten Unternehmen nach zu urteilen, wurde der Generierungseffekt erheblich verbessert und die Glätte und der Realismus sind besser als zuvor. Überwinden Sie die Mängel aktueller Anwendungen zur Bild-/Videoerzeugung, wie z. B. lokale Verzerrung, unscharfe Details, inkonsistente Aufforderungswörter, Unterschiede zum Originalbild, ausgelassene Bilder und Bildschirmzittern.

Beide Tools erstellen durch Diffusionsmodelle zeitlich kohärente Porträtanimationen und ihre Trainingsdaten sind weitgehend gleich. Stable Diffusion, das von beiden verwendet wird, ist ein latentes Text-zu-Bild-Diffusionsmodell, das von Forschern und Ingenieuren bei CompVis, Stability AI und LAION erstellt und mit 512 x 512 Bildern aus einer Teilmenge der LAION-5B-Datenbank trainiert wurde. LAION-5B ist der größte frei zugängliche multimodale Datensatz, den es gibt.

Apropos Anwendungen: Alibaba-Forscher gaben in dem Artikel an, dass Animate Anybody als grundlegende Methode in Zukunft auf verschiedene Tusheng-Videoanwendungen ausgeweitet werden könnte. Das Tool bietet viele potenzielle Anwendungsszenarien, beispielsweise für den Online-Einzelhandel, Unterhaltungsvideos und Kunst Schöpfung und virtuelle Charaktere. ByteDance betonte außerdem, dass Magic Animate starke Generalisierungsfähigkeiten bewiesen habe und auf mehrere Szenarien angewendet werden könne.

Der „Heilige Gral“ der multimodalen Anwendungen: Vincent Video Vincent Video bezeichnet die Anwendung multimodaler Analyse und Verarbeitung von Videoinhalten durch die Kombination von Text- und Sprachtechnologie. Es verknüpft Text- und Sprachinformationen mit Videobildern, um ein besseres Videoverständnis und ein interaktives Erlebnis zu ermöglichen. Vincent Video Application verfügt über ein breites Spektrum an Anwendungsfeldern, darunter intelligente Videoüberwachung, virtuelle Realität, Videobearbeitung und Inhaltsanalyse usw. Durch Text- und Sprachanalyse kann Vincent Video Objekte, Szenen und Aktionen in Videos identifizieren und verstehen und so Benutzern intelligentere Videoverarbeitungs- und Steuerungsfunktionen bieten. Im Bereich der intelligenten Videoüberwachung kann Vincent Video Überwachungsvideoinhalte automatisch kennzeichnen und klassifizieren und so die Effizienz und Genauigkeit der Überwachung verbessern. Im Bereich der virtuellen Realität kann Vincent Video mit den Sprachbefehlen des Benutzers und der virtuellen Umgebung interagieren, um ein noch intensiveres virtuelles Erlebnis zu erreichen. Im Bereich Videobearbeitung und Inhaltsanalyse kann Vincent Video Benutzern dabei helfen, automatisch wichtige Informationen aus Videos zu extrahieren und intelligente Bearbeitungen und Bearbeitungen durchzuführen. Kurz gesagt, Vincent Video bietet als „heiliger Gral“ multimodaler Anwendungen eine umfassendere und intelligentere Lösung für das Verständnis und die Interaktion von Videoinhalten. Seine Entwicklung wird mehr Innovation und Komfort in verschiedene Bereiche bringen und den technologischen Fortschritt und die soziale Entwicklung fördern

Video hat Vorteile gegenüber Text und Bildern. Es kann Informationen besser ausdrücken, das Bild bereichern und dynamisch sein. Videos können Text, Bilder, Töne und visuelle Effekte kombinieren, mehrere Informationsformen integrieren und in einem Medium präsentieren

KI-Videotools verfügen über leistungsstarke Produktfunktionen und können breitere Anwendungsszenarien eröffnen. Durch einfache Textbeschreibungen oder andere Vorgänge können KI-Videotools hochwertige und vollständige Videoinhalte generieren und so die Schwelle für die Videoerstellung senken. Dies ermöglicht Laien die präzise Darstellung von Inhalten durch Videos, was voraussichtlich die Effizienz der Inhaltsproduktion verbessern und mehr Kreativität in verschiedenen Branchensegmenten hervorbringen wird

Song Jiaji von Guosheng Securities hat zuvor darauf hingewiesen, dass AI Wensheng-Video die nächste Station für multimodale AIGC-Anwendungen ist, da AI-Video das letzte Puzzleteil der multimodalen AI-Erstellung vervollständigt , Downstream-Anwendungen Der Moment der Beschleunigung kommt ebenfalls; Shengang Securities sagte, dass Video-KI das letzte Glied im multimodalen Bereich sei; Vincentian-Videos haben einen hohen Rechenaufwand und hohe Datenanforderungen werden die anhaltend starke Nachfrage nach vorgelagerter KI-Rechenleistung unterstützen.

Allerdings die Kluft zwischen Großunternehmen und zwischen Großunternehmen und Start-ups ist nicht so groß. Man kann sogar sagen, dass sie sich auf der gleichen Startlinie befinden. Derzeit gibt es für Vincent Video nur sehr wenige öffentliche Beta-Anwendungen, nur wenige wie Runway Gen-2, Zero Scope und Pika. Selbst Giganten der künstlichen Intelligenz aus dem Silicon Valley wie Meta und Google machen bei Vincent Video nur langsame Fortschritte. Ihre jeweiligen Markteinführungen von Make-A-Video und Phenaki wurden noch nicht für die öffentliche Beta freigegeben.

Aus technischer Sicht werden die zugrunde liegenden Modelle und Technologien der Videogenerierungstools noch optimiert. Derzeit verwenden die gängigen Vincent-Videomodelle hauptsächlich das Transformer-Modell und das Diffusionsmodell. Diffusionsmodell-Tools dienen hauptsächlich der Verbesserung der Videoqualität und der Überwindung der Probleme grober Effekte und fehlender Details. Die Dauer dieser Videos liegt jedoch alle innerhalb von 4 Sekunden

Obwohl das Diffusionsmodell andererseits gut funktioniert, erfordert sein Trainingsprozess viel Speicher und Rechenleistung, sodass nur große Unternehmen und Startups, die große Investitionen getätigt haben, die Kosten für das Modelltraining erschwinglich machen

Quelle: Science and Technology Innovation Board Daily

Das obige ist der detaillierte Inhalt vonDie nächste heiße Anwendung von KI-Anwendungen ist aufgetaucht: Alibaba und ByteDance haben still und leise ein ähnliches Artefakt auf den Markt gebracht, das Messi leicht zum Tanzen bringen kann. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1359

1359

52

52

Ich habe versucht, die Vibe -Codierung mit Cursor AI und es ist erstaunlich!

Mar 20, 2025 pm 03:34 PM

Ich habe versucht, die Vibe -Codierung mit Cursor AI und es ist erstaunlich!

Mar 20, 2025 pm 03:34 PM

Die Vibe -Codierung verändert die Welt der Softwareentwicklung, indem wir Anwendungen mit natürlicher Sprache anstelle von endlosen Codezeilen erstellen können. Inspiriert von Visionären wie Andrej Karpathy, lässt dieser innovative Ansatz Dev

So verwenden Sie Dall-E 3: Tipps, Beispiele und Funktionen

Mar 09, 2025 pm 01:00 PM

So verwenden Sie Dall-E 3: Tipps, Beispiele und Funktionen

Mar 09, 2025 pm 01:00 PM

Dall-e 3: Ein generatives KI-Bilderstellungstool Generative AI revolutioniert die Erstellung von Inhalten, und Dall-E 3, das neueste Bildgenerierungsmodell von OpenAI, steht vor der Spitze. Veröffentlicht im Oktober 2023 baut es auf seinen Vorgängern Dall-E und Dall-E 2 auf

Top 5 Genai Starts vom Februar 2025: GPT-4,5, GROK-3 & MEHR!

Mar 22, 2025 am 10:58 AM

Top 5 Genai Starts vom Februar 2025: GPT-4,5, GROK-3 & MEHR!

Mar 22, 2025 am 10:58 AM

Februar 2025 war ein weiterer bahnbrechender Monat für die Generative KI, die uns einige der am meisten erwarteten Modell-Upgrades und bahnbrechenden neuen Funktionen gebracht hat. Von Xais Grok 3 und Anthropics Claude 3.7 -Sonett, um g zu eröffnen

Wie benutze ich Yolo V12 zur Objekterkennung?

Mar 22, 2025 am 11:07 AM

Wie benutze ich Yolo V12 zur Objekterkennung?

Mar 22, 2025 am 11:07 AM

Yolo (Sie schauen nur einmal) war ein führender Echtzeit-Objekterkennungsrahmen, wobei jede Iteration die vorherigen Versionen verbessert. Die neueste Version Yolo V12 führt Fortschritte vor, die die Genauigkeit erheblich verbessern

Elon Musk & Sam Altman kämpfen über 500 Milliarden US -Dollar Stargate -Projekt

Mar 08, 2025 am 11:15 AM

Elon Musk & Sam Altman kämpfen über 500 Milliarden US -Dollar Stargate -Projekt

Mar 08, 2025 am 11:15 AM

Das 500 -Milliarden -Dollar -Stargate AI -Projekt, das von Tech -Giganten wie Openai, Softbank, Oracle und Nvidia unterstützt und von der US -Regierung unterstützt wird, zielt darauf ab, die amerikanische KI -Führung zu festigen. Dieses ehrgeizige Unternehmen verspricht eine Zukunft, die von AI Advanceme geprägt ist

Sora vs Veo 2: Welches erstellt realistischere Videos?

Mar 10, 2025 pm 12:22 PM

Sora vs Veo 2: Welches erstellt realistischere Videos?

Mar 10, 2025 pm 12:22 PM

Google's Veo 2 und Openais Sora: Welcher AI -Videogenerator regiert oberste? Beide Plattformen erzeugen beeindruckende KI -Videos, aber ihre Stärken liegen in verschiedenen Bereichen. Dieser Vergleich unter Verwendung verschiedener Eingabeaufforderungen zeigt, welches Werkzeug Ihren Anforderungen am besten entspricht. T

Gencast von Google: Wettervorhersage mit Gencast Mini Demo

Mar 16, 2025 pm 01:46 PM

Gencast von Google: Wettervorhersage mit Gencast Mini Demo

Mar 16, 2025 pm 01:46 PM

Gencast von Google Deepmind: Eine revolutionäre KI für die Wettervorhersage Die Wettervorhersage wurde einer dramatischen Transformation unterzogen, die sich von rudimentären Beobachtungen zu ausgefeilten AI-angetriebenen Vorhersagen überschreitet. Google DeepMinds Gencast, ein Bodenbrei

Welche KI ist besser als Chatgpt?

Mar 18, 2025 pm 06:05 PM

Welche KI ist besser als Chatgpt?

Mar 18, 2025 pm 06:05 PM

Der Artikel erörtert KI -Modelle, die Chatgpt wie Lamda, Lama und Grok übertreffen und ihre Vorteile in Bezug auf Genauigkeit, Verständnis und Branchenauswirkungen hervorheben. (159 Charaktere)