Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

IT Industrie

IT Industrie

Shenzhen: Bis 2025 wird die allgemeine Rechenleistung 14 EFLOPS erreichen, die intelligente Rechenleistung wird 25 EFLOPS erreichen und die Supercomputing-Leistung wird 2 EFLOPS erreichen.

Shenzhen: Bis 2025 wird die allgemeine Rechenleistung 14 EFLOPS erreichen, die intelligente Rechenleistung wird 25 EFLOPS erreichen und die Supercomputing-Leistung wird 2 EFLOPS erreichen.

Shenzhen: Bis 2025 wird die allgemeine Rechenleistung 14 EFLOPS erreichen, die intelligente Rechenleistung wird 25 EFLOPS erreichen und die Supercomputing-Leistung wird 2 EFLOPS erreichen.

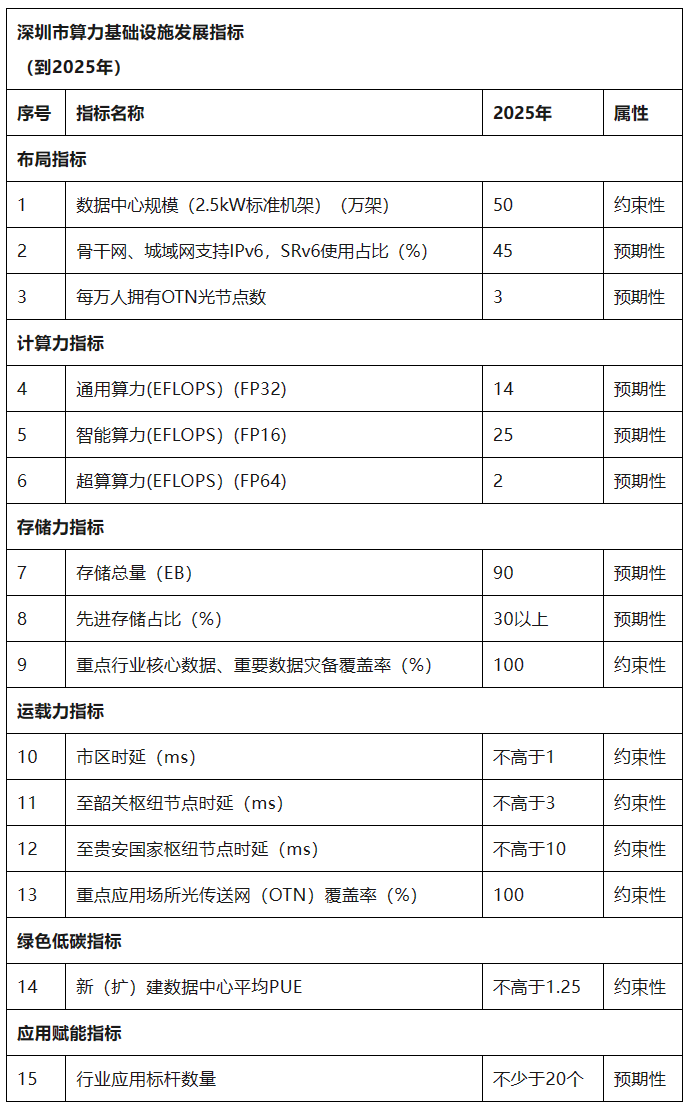

Das Shenzhen Municipal Bureau of Industry and Information Technology hat heute den „Shenzhen Municipal Computing Infrastructure High-Quality Development Action Plan (2024-2025)“ veröffentlicht. Diese Nachricht wurde am 5. Dezember von dieser Website abgerufen. Das Gesamtziel: bis 2025 Bis 2020 hat die Stadt im Wesentlichen eine wissenschaftliche und vernünftige räumliche Anordnung geschaffen, deren Größe und Volumen den Anforderungen des Aufbaus einer schnellen Pionierstadt entsprechen und deren Rechenleistung, Tragfähigkeit, Speicherkapazität und Anwendungsbefähigung mit der hohen Qualität vereinbar sind Entwicklung der digitalen Wirtschaft, grün, kohlenstoffarm und unabhängig. Das Layout einer fortschrittlichen Rechenleistungsinfrastruktur mit einem deutlich verbesserten Maß an Steuerbarkeit schafft ein diversifiziertes Rechenleistungsversorgungssystem mit koordinierter Entwicklung von allgemeinem, intelligentem Supercomputing und Edge Computing, um

zu schaffen. Diversifiziertes Angebot, starke Computerkompetenz, allgegenwärtige Verbindung und sichere Integration“Der Maßstab für Chinas Internet-Computing-Städte.

Allgemeines Layout.

- Bauen Sie eine fortschrittliche Rechenleistungsinfrastruktur auf und optimieren Sie weiterhin die Netzwerkverbindungsmöglichkeiten. Bis 2025 wird die Rackgröße des Rechenzentrums der Stadt 500.000 Standard-Racks erreichen und die Rechenleistung und Recheneffizienz deutlich verbessert werden.

-

Technisches System

- .

Bilden Sie im Grunde ein Rechenleistungs-Infrastrukturtechnologiesystem mit vielfältiger und allgegenwärtiger Rechenleistung, sicherer und zuverlässiger Speicherkapazität, hochwertiger Verbindung der Transportkapazität und gemeinschaftlichem Aufbau von Rechenleistung, Speicherung und Betrieb. Bis 2025 wird die allgemeine Rechenleistung 14 EFLOPS (FP32), die intelligente Rechenleistung 25 EFLOPS (FP16) und die Supercomputing-Leistung 2 EFLOPS (FP64) erreichen. Die Gesamtspeicherkapazität erreicht 90EB. Die erweiterte Speicherkapazität macht mehr als 30 % aus und die Disaster-Recovery-Abdeckung für Kerndaten und wichtige Daten in Schlüsselindustrien erreicht 100 %. Die Verzögerung zwischen den Rechenzentren in der Stadt beträgt nicht mehr als 1 ms, die Verzögerung zum nationalen Hub-Knoten in Shaoguan beträgt nicht mehr als 3 ms und die Verzögerung zum nationalen Hub-Knoten in Gui'an beträgt nicht mehr als 10 ms.

Grün und sicher. Stärkung einer umweltfreundlichen und sicheren Entwicklung. Bis 2025 wird die Stromnutzungseffizienz (PUE) neuer Rechenzentren in unserer Stadt auf weniger als 1,25 sinken und das grüne und kohlenstoffarme Niveau 4A oder mehr erreichen. Beginnen Sie mit der Modernisierung und Transformation „alter und kleiner“ Rechenzentren. Stärken Sie das Sicherheitsmanagement und den Kapazitätsaufbau von Netzwerk-, Daten- und Computereinrichtungen und bauen Sie ein vollständiges Sicherheitssystem auf.

Zhao Zhiguo, Chefingenieur des Ministeriums für Industrie und Informationstechnologie, sagte, dass sich das fortgeschrittene Computing, das durch heterogenes Computing, intelligentes Computing, Quantencomputing usw. repräsentiert wird, zu einer kritischen Phase des qualitativen Wandels entwickelt habe und die Computerindustrie sich stark gezeigt habe Vitalität und unermessliches Potenzial. 🔜 . Formular), das mehr Informationen liefern und Zeit beim Sichten sparen soll. Bitte beachten Sie jedoch, dass diese Links nur als Referenz dienen und allen Artikeln auf dieser Website diese Erklärung beigefügt ist

Beschweren Sie sich über Hydrologie

Ich möchte den Fehler korrigieren

Das obige ist der detaillierte Inhalt vonShenzhen: Bis 2025 wird die allgemeine Rechenleistung 14 EFLOPS erreichen, die intelligente Rechenleistung wird 25 EFLOPS erreichen und die Supercomputing-Leistung wird 2 EFLOPS erreichen.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

Die KI-Technologie explodiert exponentiell: Die Rechenleistung hat sich in 70 Jahren um das 680-Millionen-fache erhöht, was in drei historischen Phasen zu beobachten ist

Sep 25, 2023 pm 06:45 PM

Die KI-Technologie explodiert exponentiell: Die Rechenleistung hat sich in 70 Jahren um das 680-Millionen-fache erhöht, was in drei historischen Phasen zu beobachten ist

Sep 25, 2023 pm 06:45 PM

Elektronische Computer wurden in den 1940er Jahren geboren und innerhalb von 10 Jahren nach dem Aufkommen von Computern erschien die erste KI-Anwendung in der Geschichte der Menschheit. KI-Modelle werden seit mehr als 70 Jahren entwickelt und können mittlerweile nicht nur Gedichte erstellen, sondern auch Bilder auf der Grundlage von Texteingaben erzeugen und sogar Menschen dabei helfen, unbekannte Proteinstrukturen zu entdecken. Die KI-Technologie hat in so kurzer Zeit ein exponentielles Wachstum erzielt. Aus welchem Grund liegt das daran? Ein langes Bild aus „OurWorld in Data“ zeichnet die Geschichte der KI-Entwicklung anhand von Veränderungen in der Rechenleistung nach, die zum Trainieren von KI-Modellen als Skalen verwendet wird. Hochauflösendes großes Bild: https://www.visualcapitalist.com/wp-content/

Das Trainieren einer chinesischen Version von ChatGPT ist nicht so schwierig: Sie können es mit der Open-Source-Version Alpaca-LoRA+RTX 4090 ohne A100 tun

Apr 16, 2023 pm 11:43 PM

Das Trainieren einer chinesischen Version von ChatGPT ist nicht so schwierig: Sie können es mit der Open-Source-Version Alpaca-LoRA+RTX 4090 ohne A100 tun

Apr 16, 2023 pm 11:43 PM

Im Jahr 2023 scheint es im Chatbot-Bereich nur noch zwei Lager zu geben: „ChatGPT von OpenAI“ und „Andere“. ChatGPT ist leistungsstark, aber es ist für OpenAI fast unmöglich, es als Open Source zu veröffentlichen. Das „andere“ Lager schnitt schlecht ab, aber viele Leute arbeiten an Open Source, wie zum Beispiel LLaMA, das vor einiger Zeit von Meta als Open Source bereitgestellt wurde. LLaMA ist die allgemeine Bezeichnung für eine Reihe von Modellen mit Parametern zwischen 7 und 65 Milliarden. Darunter kann das LLaMA-Modell mit 13 Milliarden Parametern GPT-3 mit 175 Milliarden Parametern „bei den meisten Benchmarks“ übertreffen. Dieses Modell wurde jedoch keiner Befehlsoptimierung (Instructtuning) unterzogen, sodass der Generierungseffekt relativ gering ist.

Die erste öffentliche Plattform für die Zusammenschaltung von Rechenleistung in China wird veröffentlicht, die nationale Rechenleistungsressourcen und Planungsdienste abfragen kann.

Jul 16, 2024 am 10:55 AM

Die erste öffentliche Plattform für die Zusammenschaltung von Rechenleistung in China wird veröffentlicht, die nationale Rechenleistungsressourcen und Planungsdienste abfragen kann.

Jul 16, 2024 am 10:55 AM

Laut Nachrichten dieser Website vom 12. Juli und offiziellen Nachrichten der China Academy of Information and Communications Technology (als „CAICT“ bezeichnet) wurde am 11. Juli die erste öffentliche Plattform für die Zusammenschaltung von Rechenleistung des Landes veröffentlicht. Die Plattform identifiziert, registriert und testet Computerressourcen im ganzen Land. Über die Plattform können Sie Computerressourcen und zugehörige Rechenleistungsplanungsdienste landesweit abfragen, echte und glaubwürdige Rechenleistungsunterstützung für alle Lebensbereiche bereitstellen und die Förderung der Datenverarbeitung beschleunigen Stromverbindung. Am 11. Juli veröffentlichte die China Academy of Information and Communications Technology eine öffentliche Serviceplattform für die Vernetzung von Rechenleistung und startete gemeinsam mit der Industrie eine konsensbildende Aktion für die Rechenleistung im Internet. Die Computing Power Interconnection Public Service Platform ist eine umfassende Serviceplattform, die die nationale Rechenleistungsverbindung und das Rechenleistungs-Internetsystem fördert und verwaltet, einschließlich Rechenleistungsidentifizierungsmanagement, Rechenleistungs-Internet-Geschäftsabfrage, einheitlicher Rechenleistungsmarkt, Richtlinien und

Shenzhen: Bis 2025 wird die allgemeine Rechenleistung 14 EFLOPS erreichen, die intelligente Rechenleistung wird 25 EFLOPS erreichen und die Supercomputing-Leistung wird 2 EFLOPS erreichen.

Dec 06, 2023 am 08:57 AM

Shenzhen: Bis 2025 wird die allgemeine Rechenleistung 14 EFLOPS erreichen, die intelligente Rechenleistung wird 25 EFLOPS erreichen und die Supercomputing-Leistung wird 2 EFLOPS erreichen.

Dec 06, 2023 am 08:57 AM

Das Shenzhen Municipal Bureau of Industry and Information Technology hat heute den „Shenzhen Computing Infrastructure High-Quality Development Action Plan (2024-2025)“ veröffentlicht. Diese Nachricht basiert auf dem Gesamtziel, das diese Website am 5. Dezember erreicht hat. Bis 2025 hat die Stadt hat sich grundsätzlich gebildet. Die räumliche Anordnung ist wissenschaftlich und vernünftig, der Umfang und das Volumen entsprechen den Anforderungen eines schnellen Pionierstadtbaus, die Rechenleistung, die Tragfähigkeit, die Speicherkapazität und die Anwendungsbefähigung sind mit der qualitativ hochwertigen Entwicklung der digitalen Wirtschaft vereinbar und Das Niveau der grünen, kohlenstoffarmen und unabhängigen Steuerbarkeit ist bemerkenswert. Verbessern Sie das Layout einer fortschrittlichen Rechenleistungsinfrastruktur, bauen Sie ein diversifiziertes Rechenleistungssystem mit koordinierter Entwicklung von allgemeinem, intelligentem Supercomputing und Edge Computing auf und schaffen Sie eine chinesische Computernetzwerkstadt mit „ Diversifiziertes Angebot, starke Rechenleistung, allgegenwärtige Verbindung und sichere Integration“ Benchmark. Gesamtlayout. Bauen Sie eine fortschrittliche Rechenleistungsinfrastruktur auf und optimieren Sie diese kontinuierlich

Daten-Closed-Loop-Forschung: Die Entwicklung des autonomen Fahrens verschiebt sich von technologiegetrieben zu datengetrieben

Apr 11, 2023 pm 09:22 PM

Daten-Closed-Loop-Forschung: Die Entwicklung des autonomen Fahrens verschiebt sich von technologiegetrieben zu datengetrieben

Apr 11, 2023 pm 09:22 PM

Zuosi Auto R&D hat den „2022 China Autonomous Driving Data Closed Loop Research Report“ veröffentlicht. 1. Die Entwicklung des autonomen Fahrens hat sich allmählich von technologiegetrieben zu datengetrieben verlagert. Heute sind autonome Fahrsensorlösungen und Computerplattformen immer homogener geworden und die Technologielücke zwischen den Anbietern wird immer kleiner. In den letzten zwei Jahren haben die Iterationen autonomer Fahrtechnologien rasante Fortschritte gemacht und die Massenproduktion hat sich beschleunigt. Nach Angaben des Zuosi Data Center wird die kumulierte Zahl inländischer L2-Personenkraftwagen mit unterstütztem Fahren im Jahr 2021 4,79 Millionen erreichen, was einem Anstieg von 58,0 % gegenüber dem Vorjahr entspricht. Von Januar bis Juni 2022 stieg die Penetrationsrate des chinesischen L2-Fahrassistenzsystems im neuen Pkw-Markt auf 32,4 %. Beim autonomen Fahren durchlaufen Daten den gesamten Lebenszyklus von Forschung und Entwicklung, Tests, Massenproduktion, Betrieb und Wartung. Mit der rasanten Zunahme der Anzahl intelligenter vernetzter Fahrzeugsensoren

Yu Xiaohui von der Chinesischen Akademie für Informations- und Kommunikationstechnologie: Die Rechenleistung meines Landes steht weltweit an zweiter Stelle, und zu gegebener Zeit sollte ein „einheitlicher nationaler Markt für Rechenleistungsdienste' eingerichtet werden

Mar 06, 2024 pm 10:34 PM

Yu Xiaohui von der Chinesischen Akademie für Informations- und Kommunikationstechnologie: Die Rechenleistung meines Landes steht weltweit an zweiter Stelle, und zu gegebener Zeit sollte ein „einheitlicher nationaler Markt für Rechenleistungsdienste' eingerichtet werden

Mar 06, 2024 pm 10:34 PM

Diese Website berichtete am 6. März, dass Yu Xiaohui, Mitglied des Nationalkomitees der Politischen Konsultativkonferenz des Chinesischen Volkes und Präsident der Chinesischen Akademie für Informations- und Kommunikationstechnologie, dies in einem Interview mit einem Reporter der Global Times am 5. März sagte Im Zeitalter der digitalen Wirtschaft, insbesondere mit der boomenden Entwicklung der künstlichen Intelligenz, ist Rechenleistung weltweit zu einer strategischen Ressource geworden, die knapp ist. Derzeit liegt China mit seiner Gesamtrechenleistung weltweit an zweiter Stelle. Yu Xiaohui sagte jedoch auch, dass aufgrund unzureichender präziser Anbindung und unterschiedlicher regionaler Ausstattung und Anforderungen an Rechenleistungsressourcen gleichzeitig die widersprüchliche Situation Chinas besteht, nämlich die knappe Versorgung mit Rechenleistungsressourcen und die Unfähigkeit, diese effektiv zu nutzen. Dies muss dringend untersucht werden und schrittweise einen „nationalen einheitlichen Markt für Rechenleistungsdienste“ aufbauen, der es der Rechenleistung ermöglicht, ihre Rolle als Chinas neue Produktivkraft voll zu entfalten. Diese Website hat festgestellt, dass die zuständigen nationalen Abteilungen bereits mit der Vorbereitung relevanter Angelegenheiten begonnen haben. Im Dezember letzten Jahres haben die Nationale Entwicklungs- und Reformkommission und die National Data

Stellen Sie Elasticsearch basierend auf dem Speicher bereit – über 100 Millionen Daten, Volltextsuche, 100 ms Antwort

Jun 07, 2024 am 11:11 AM

Stellen Sie Elasticsearch basierend auf dem Speicher bereit – über 100 Millionen Daten, Volltextsuche, 100 ms Antwort

Jun 07, 2024 am 11:11 AM

1. Mounten Sie das Speicherverzeichnis auf dem Host. Erstellen Sie ein Verzeichnis zum Mounten des tmpfs-Dateisystems mount-ttmpfs-osize=800Gtmpfs/mnt/memory_storage , wenn 100G Speicher verwendet wird, werden 100G Speicher belegt. Auf dem Hostknoten gibt es 2T-Speicher, und hier werden 800G-Speicher zum Speichern von Elasticsearch-Daten zugewiesen. Erstellen Sie im Voraus das Verzeichnis mkdir/mnt/memory_storage/elasticsearch-data-es-jfs-prod-es-defaul

Wie kann man die Leistung des Sprachmodells verbessern, wenn man nur über eine begrenzte Rechenleistung verfügt? Google hat eine neue Idee

Apr 13, 2023 pm 02:01 PM

Wie kann man die Leistung des Sprachmodells verbessern, wenn man nur über eine begrenzte Rechenleistung verfügt? Google hat eine neue Idee

Apr 13, 2023 pm 02:01 PM

In den letzten Jahren haben Sprachmodelle (LM) in der Forschung zur Verarbeitung natürlicher Sprache (NLP) an Bedeutung gewonnen und gewinnen zunehmend an Einfluss in der Praxis. Im Allgemeinen hat sich gezeigt, dass die Vergrößerung eines Modells die Leistung bei einer Reihe von NLP-Aufgaben verbessert. Allerdings liegt auch die Herausforderung bei der Skalierung des Modells auf der Hand: Das Training neuer, größerer Modelle erfordert viele Rechenressourcen. Darüber hinaus werden neue Modelle oft von Grund auf trainiert und können die Trainingsgewichte früherer Modelle nicht nutzen. Im Hinblick auf dieses Problem untersuchten Google-Forscher zwei komplementäre Methoden, um die Leistung bestehender Sprachmodelle deutlich zu verbessern, ohne viele zusätzliche Rechenressourcen zu verbrauchen. Erstens, in „Transcending Scaling Laws with 0.1