Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Neuer Titel: Echtzeit-Rendering weiterentwickelt! Innovative Methode der 3D-Rekonstruktion auf Strahlenbasis

Neuer Titel: Echtzeit-Rendering weiterentwickelt! Innovative Methode der 3D-Rekonstruktion auf Strahlenbasis

Neuer Titel: Echtzeit-Rendering weiterentwickelt! Innovative Methode der 3D-Rekonstruktion auf Strahlenbasis

Bilder

Bilder

Papier-Link:https://arxiv.org/pdf/2310.19629

Code-Link:https://github.com/vLAR-group/RayDF

Homepage:Erforderlich Der umgeschriebene Inhalt ist: https://vlar-group.github.io/RayDF.html

Der umgeschriebene Inhalt: Implementierungsmethode:

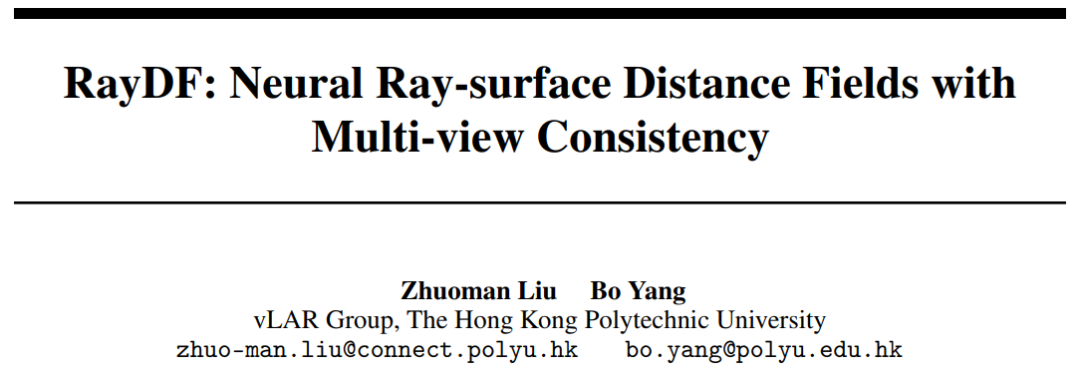

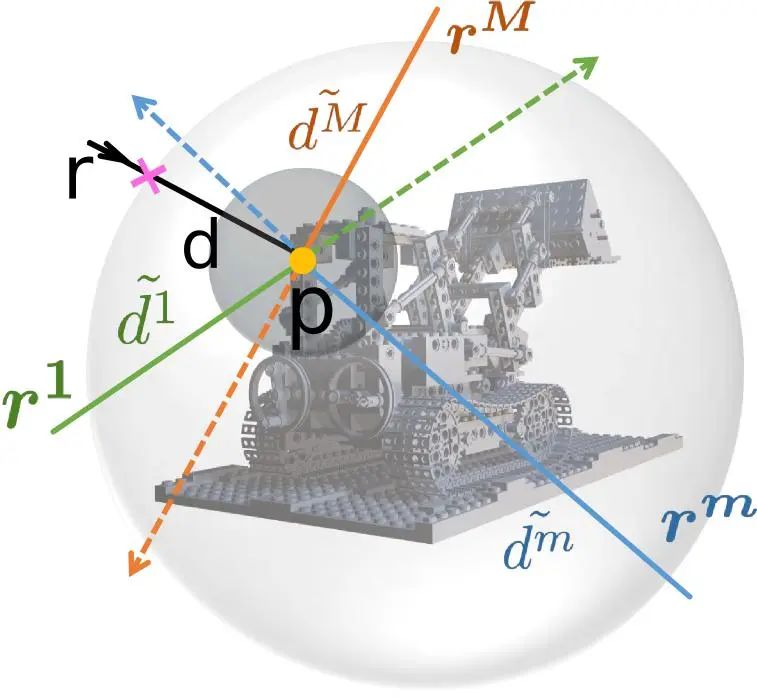

Der Gesamtprozess und die Komponenten von RayDF sind wie folgt (siehe Abbildung 1)

1. Einführung

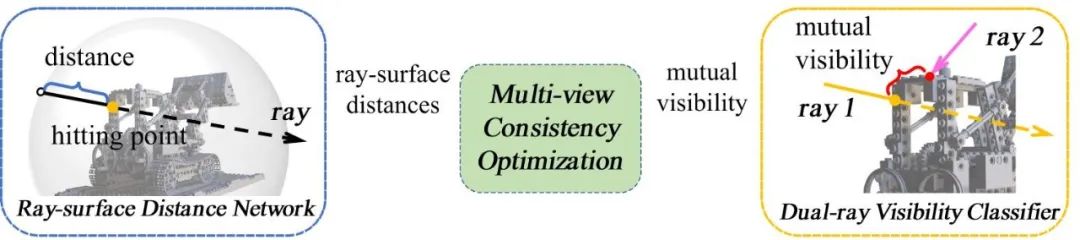

In vielen hochmodernen Anwendungen im Bereich der maschinellen Bildverarbeitung und Robotik lernen Sie drei präzise und effiziente -dimensionale Formausdrücke sind sehr wichtig. Allerdings erfordern bestehende implizite Ausdrücke, die auf 3D-Koordinaten basieren, hohe Rechenkosten, wenn sie 3D-Formen darstellen oder 2D-Bilder rendern. Im Gegensatz dazu können strahlenbasierte Methoden effizient auf 3D-Formen schließen. Bestehende strahlenbasierte Methoden berücksichtigen jedoch nicht die geometrische Konsistenz unter mehreren Betrachtungswinkeln, was es schwierig macht, genaue geometrische Formen unter unbekannten Betrachtungswinkeln wiederherzustellen. Um diese Probleme anzugehen, schlägt dieser Artikel eine neue Methode vor, die die geometrische Konsistenz über mehrere Betrachtungswinkel hinweg aufrechterhält Betrachtungswinkel. Eine strahlenbasierte implizite Ausdrucksmethode namens RayDF. Diese Methode basiert auf einem einfachen Strahloberflächen-Abstandsfeld. Durch die Einführung eines neuen Dual-Ray-Sichtbarkeitsklassifikators und eines Moduls zur Optimierung der Konsistenz mehrerer Ansichten können Sie lernen, einen Strahloberflächenabstand zu erhalten, der die geometrische Konsistenz mehrerer Betrachtungswinkel erfüllt . Experimentelle Ergebnisse zeigen, dass die modifizierte Methode bei drei Datensätzen eine überlegene 3D-Oberflächenrekonstruktionsleistung erzielt und eine 1000-mal schnellere Rendering-Geschwindigkeit als die koordinatenbasierte Methode erreicht (siehe Tabelle 1).

Die folgenden Hauptbeiträge sind:

Dieser Ausdruck verwendet das Strahloberflächen-Abstandsfeld zur Darstellung dreidimensionaler Formen und ist effizienter als vorhandene koordinatenbasierte Ausdrücke.

- Entwickelt wurde ein neuer Zweistrahl-Sichtbarkeitsklassifikator. Durch das Erlernen der räumlichen Beziehung jedes Strahlenpaares kann das erlernte Strahl-Oberflächen-Abstandsfeld unter mehreren Betrachtungswinkeln geometrische Konsistenz beibehalten.

- 2. Methode

2.1 Übersicht

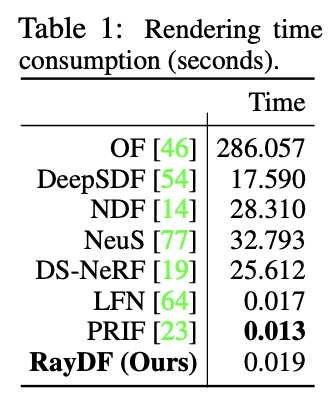

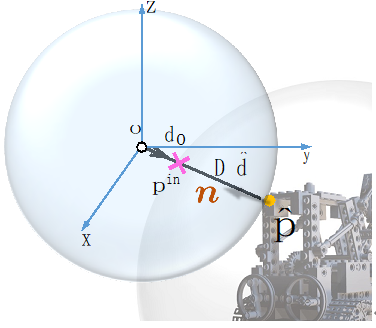

Wie in Abbildung 1 dargestellt, umfasst RayDF zwei Netzwerke und ein Optimierungsmodul. Für das Strahl-Oberflächen-Abstandsnetzwerk des Hauptnetzwerks müssen Sie nur einen Strahl eingeben, um den Abstandswert zwischen dem Startpunkt des Strahls und dem vom Strahl getroffenen geometrischen Oberflächenpunkt zu erhalten. Unter diesen verwendet RayDF, wie in Abbildung 2 dargestellt, eine Kugel, die die dreidimensionale Szene umgibt, um den Eingabestrahl zu parametrisieren, und verwendet die parametrisierten vierdimensionalen Kugelkoordinaten (Einfallspunkt und Austrittspunkt) als Netzwerkeingabe. Für den Zweistrahl-Sichtbarkeitsklassifikator des Hilfsnetzwerks wird als Eingabe ein Strahlenpaar und ein geometrischer Oberflächenpunkt verwendet, um die gegenseitige Sichtbarkeit zwischen den beiden Strahlen vorherzusagen. Nach dem Training wird dieses Hilfsnetzwerk eine Schlüsselrolle im nachfolgenden Modul zur Konsistenzoptimierung mit mehreren Ansichten spielen.

Abbildung 2 Strahlparametrisierung und Netzwerkstruktur des Strahl-Oberflächen-Abstandsfeldes 2.2 Dual-ray Visibility Classifier

2.2 Dual-ray Visibility Classifier

Das Hilfsnetzwerk in dieser Methode ist eine Vorhersage, ob die beiden Eingangsstrahlen gleichzeitig eine Oberfläche sehen können Zeit Binärer Klassifikator für Punkte. Wie in Abbildung 3 dargestellt, werden die aus den beiden Eingangsstrahlen erhaltenen Merkmale gemittelt, um sicherzustellen, dass die vorhergesagten Ergebnisse nicht durch die Reihenfolge der beiden Strahlen beeinflusst werden. Gleichzeitig werden die durch separate Codierung von Oberflächenpunkten erhaltenen Merkmale nach den Strahlmerkmalen gespleißt, um die Strahlmerkmale zu verbessern und dadurch die Genauigkeit des Klassifikators zu verbessern.

Die Rahmenstruktur des Dual-Ray-Sichtbarkeitsklassifizierers ist in Abbildung 3 dargestellt. Das Schlüsselmodul der Multi-View-Konsistenzoptimierung wird eingeführt, um ein zweistufiges Training in den beiden Netzwerken durchzuführen.(1) Konstruieren Sie zunächst die Strahlenpaare für das Training für den Dual-Ray-Sichtbarkeitsklassifikator des Hilfsnetzwerks. Für einen Strahl in einem Bild (entsprechend einem Pixel im Bild) kann der entsprechende Raumoberflächenpunkt anhand seines Strahloberflächenabstands projiziert werden, um einen anderen Strahl und diesen Strahl zu erhalten Es gibt einen entsprechenden Abstand zwischen den Strahlen und der Oberfläche. Der Artikel legt einen Schwellenwert von 10 mm fest, um festzustellen, ob zwei Strahlen füreinander sichtbar sind.

(2) Die zweite Stufe besteht darin, das Strahl-Oberflächen-Entfernungsnetzwerk des Hauptnetzwerks so zu trainieren, dass sein vorhergesagtes Entfernungsfeld der Multi-View-Konsistenz entspricht. Wie in Abbildung 4 dargestellt, wird für einen Hauptstrahl und seine Oberflächenpunkte der Oberflächenpunkt gleichmäßig als Mittelpunkt der Kugel abgetastet, und es werden mehrere Mehrfachansichtsstrahlen erhalten. Koppeln Sie den Hauptstrahl nacheinander mit diesen Mehrfachsichtstrahlen, und ihre gegenseitige Sichtbarkeit kann durch den trainierten Dual-Ray-Sichtbarkeitsklassifizierer ermittelt werden. Sagen Sie dann den Strahloberflächenabstand dieser Strahlen über das Strahloberflächenabstandsnetzwerk voraus. Wenn der Hauptstrahl und ein bestimmter Abtaststrahl gegenseitig sichtbar sind, sollten die durch die Strahloberflächenabstände der beiden Strahlen berechneten Oberflächenpunkte gleich sein Punkt; entsprechend Die entsprechende Verlustfunktion wird entworfen und das Hauptnetzwerk trainiert, was letztendlich ermöglicht, dass das Strahlenoberflächen-Distanzfeld die Konsistenz mehrerer Ansichten erreicht.

2.4 Ableitung der Oberflächennormalen und Entfernung von Ausreißernpunkten

Da der Tiefenwert am Rand der Szenenoberfläche häufig Mutationen (Diskontinuität) aufweist und das neuronale Netzwerk eine kontinuierliche Funktion ist, gilt dies für das obige Strahl-Oberflächen-Abstandsfeld Auf der Oberfläche können ungenaue Abstandswerte am Rand leicht vorhergesagt werden, was zu Rauschen auf der geometrischen Oberfläche am Rand führt. Glücklicherweise weist das entworfene Strahl-Oberflächen-Abstandsfeld eine gute Funktion auf, wie in Abbildung 5 dargestellt. Der Normalenvektor jedes geschätzten dreidimensionalen Oberflächenpunkts kann durch automatische Differenzierung des Netzwerks leicht in geschlossener Form gefunden werden. Daher kann der euklidische Abstand des Normalenvektors des Oberflächenpunkts während der Netzwerkinferenzphase berechnet werden. Wenn der Abstandswert größer als der Schwellenwert ist, wird der Oberflächenpunkt als Ausreißer betrachtet und eliminiert, wodurch ein sauberes dreidimensionales Bild erhalten wird rekonstruierte Oberfläche.

Abbildung 5 Oberflächennormalberechnung

III Experimente

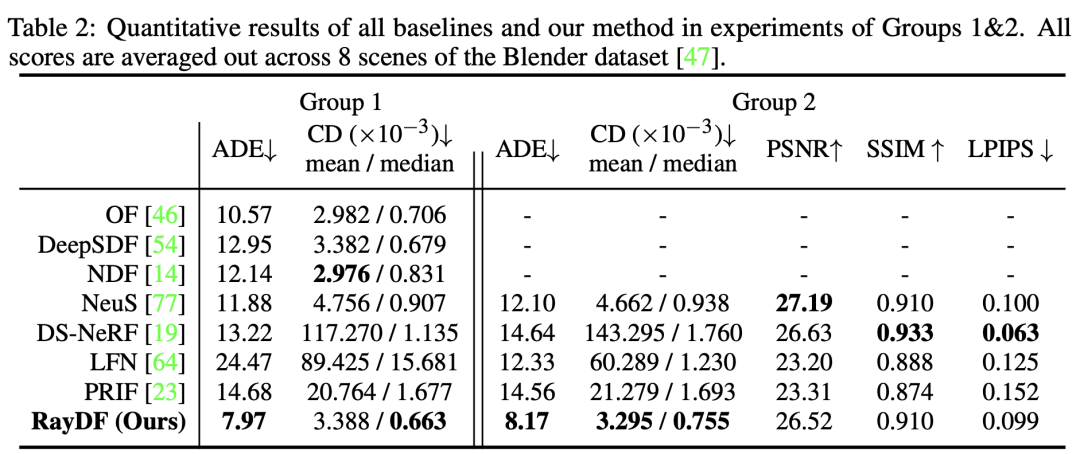

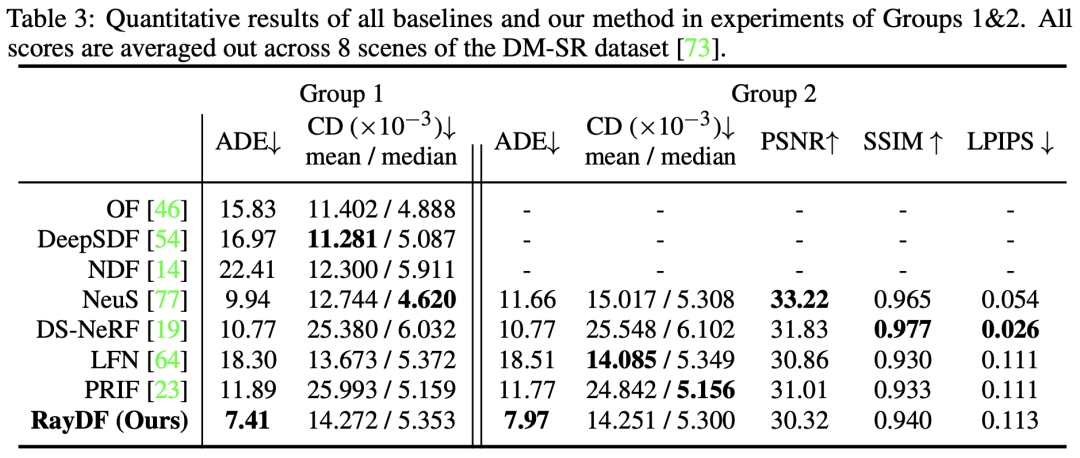

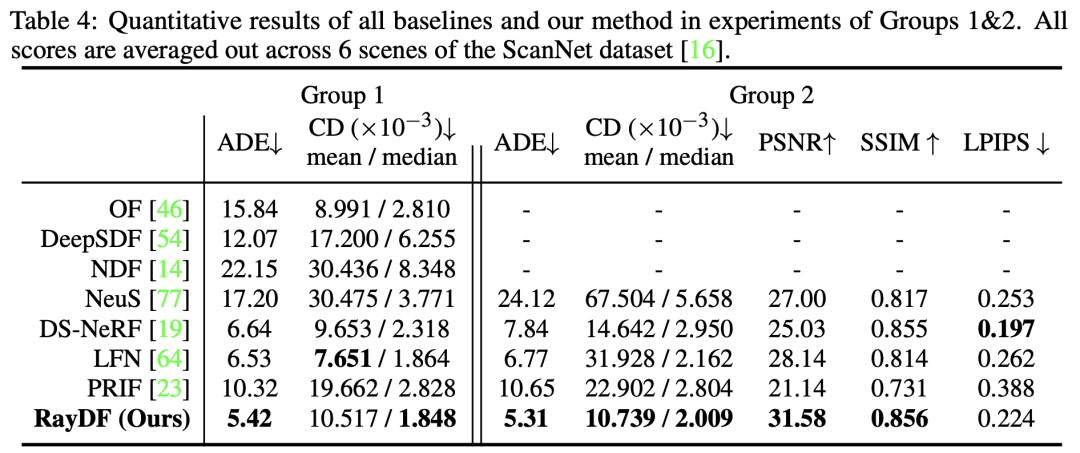

Um die Wirksamkeit der vorgeschlagenen Methode zu überprüfen, haben wir Experimente mit drei Datensätzen durchgeführt. Diese drei Datensätze sind der synthetische Datensatz Blender auf Objektebene [1], der synthetische Datensatz DM-SR auf Szenenebene [2] und der reale Datensatz ScanNet auf Szenenebene [3]. Für den Leistungsvergleich haben wir sieben Basislinien ausgewählt. Unter diesen sind OF [4]/DeepSDF [5]/NDF [6]/NeuS [7] koordinatenbasierte Level-Set-Methoden, DS-NeRF [8] ist eine tiefenüberwachte NeRF-basierte Methode und LFN [ 9] und PRIF [10] sind zwei strahlenbasierte Basislinien

Aufgrund der Einfachheit der RayDF-Methode, direkt einen Strahlungszweig zum Erlernen von Texturen hinzuzufügen, kann sie mit Basismodellen verglichen werden, die die Vorhersage von Strahlungsfeldern unterstützen. Daher sind die Vergleichsexperimente dieser Arbeit in zwei Gruppen unterteilt. Die erste Gruppe (Gruppe 1) sagt nur die Entfernung (Geometrie) voraus, und die zweite Gruppe (Gruppe 2) sagt sowohl die Entfernung als auch die Strahldichte (Geometrie und Textur) voraus

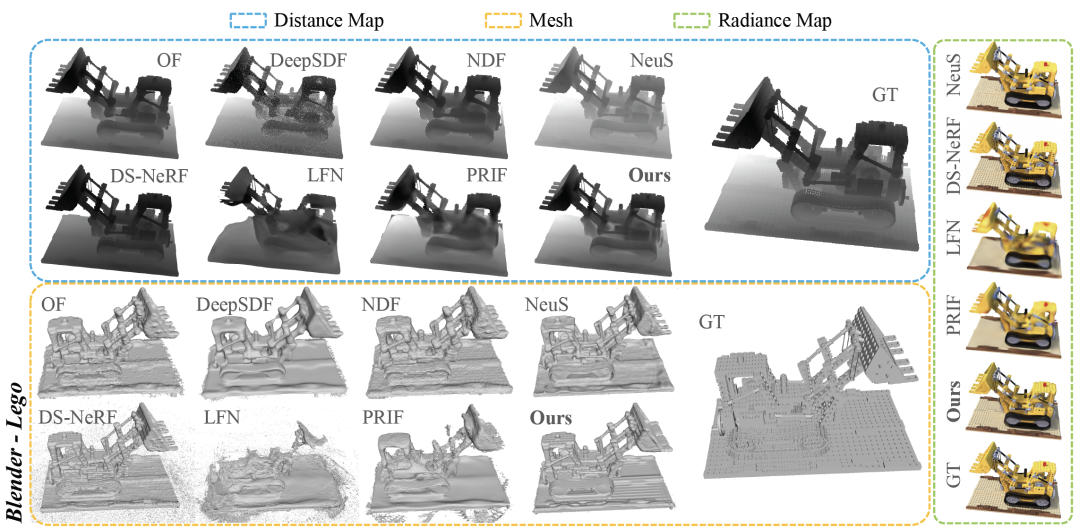

3.1 Bewertung auf Blender Dataset

Wie aus Tabelle 2 und Abbildung 6 ersichtlich ist, erzielt RayDF in Gruppe 1 und 2 bessere Ergebnisse bei der Oberflächenrekonstruktion, insbesondere beim wichtigsten ADE-Indikator, der deutlich besser ist als Basislinien basierend auf Koordinaten und Strahlen. Gleichzeitig erreichte RayDF hinsichtlich der Strahlungsfeldwiedergabe eine mit DS-NeRF vergleichbare und bessere Leistung als LFN und PRIF.

Abbildung 6 Visueller Vergleich des Blender-Datensatzes

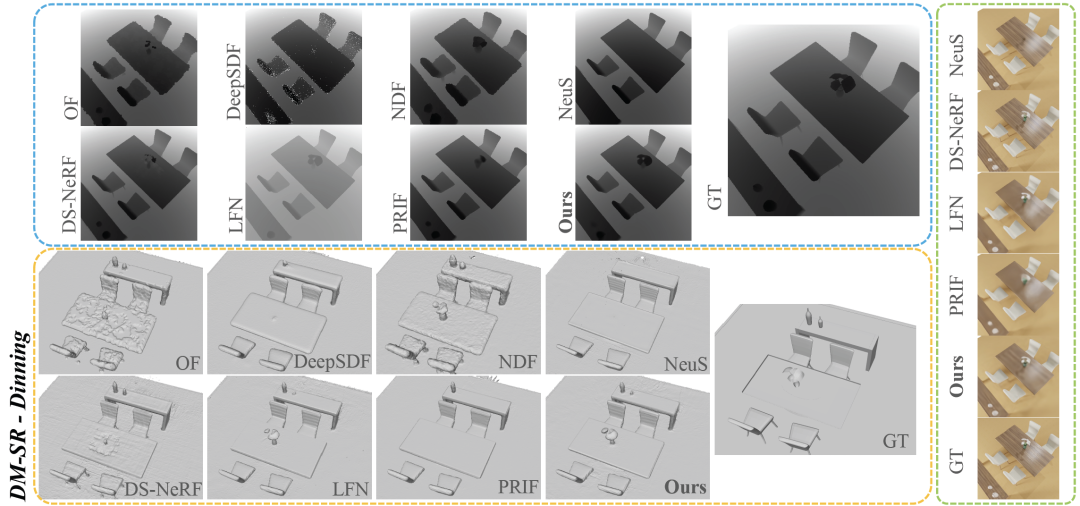

3.2 Auswertung des DM-SR-Datensatzes

Wie aus Tabelle 3 ersichtlich ist, übertrifft RayDF beim kritischsten ADE-Indikator alle Basislinien. Gleichzeitig konnte RayDF im Experiment der Gruppe 2 eine qualitativ hochwertige neue Ansichtssynthese erzielen und gleichzeitig sicherstellen, dass die genaue Oberflächenform wiederhergestellt wurde (siehe Abbildung 7).

Abbildung 7 Visueller Vergleich des DM-SR-Datensatzes

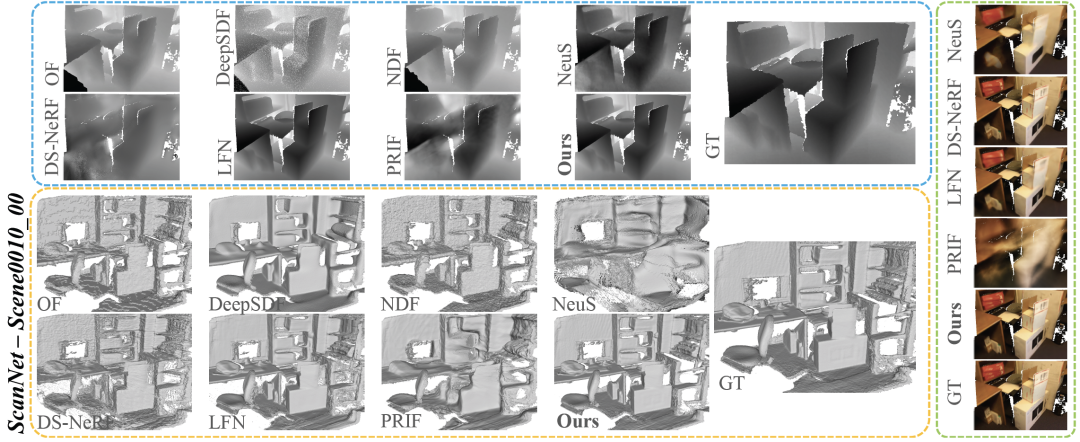

3.3 Auswertung des ScanNet-Datensatzes

Tabelle 4 vergleicht die Leistung von RayDF und Basislinien in anspruchsvollen realen Szenarien. In der ersten und zweiten Gruppe übertrifft RayDF die Basiswerte in fast allen Bewertungsmetriken deutlich und zeigt klare Vorteile bei der Wiederherstellung komplexer realer 3D-Szenen

Das Folgende ist Abbildung 8 ScanNet Umgeschriebener Inhalt für den visuellen Vergleich von Datensätzen: In Abbildung 8 zeigen wir die visuellen Vergleichsergebnisse des ScanNet-Datensatzes

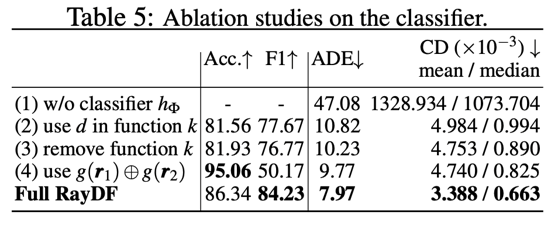

3.4 Ablationsstudie

Ein Ablationsexperiment wurde mit dem Blender-Datensatz durchgeführt. Tabelle 5 im Artikel zeigt die Ablation des wichtigsten Dual-Ray-Sichtbarkeitsklassifikators. Die experimentellen Ergebnisse

- sind in Tabelle 5 (1) dargestellt. Ohne die Hilfe des Dual-Ray-Sichtbarkeitsklassifikators kann das Strahloberflächen-Abstandsfeld keinen angemessenen Abstandswert für die Strahlen unter dem neuen Betrachtungswinkel vorhersagen (siehe Abbildung). 9).

- Bei der Eingabe des Klassifikators werden die eingegebenen Oberflächenpunktkoordinaten als Hilfsinformationen ausgewählt, wie in Tabelle 5 (2) und (3) gezeigt. Wenn der Oberflächenpunktabstandswert als Hilfsinformation ausgewählt wird oder keine Hilfsinformationen bereitgestellt werden, Der Klassifikator führt zu einer geringeren Genauigkeit und F1-Bewertung, was zu unzureichenden Sichtbarkeitsinformationen für das Strahlenoberflächen-Entfernungsnetzwerk führt und dadurch falsche Entfernungswerte vorhersagt.

- Wie in Tabelle 5 (4) gezeigt, weist der trainierte Klassifikator durch asymmetrische Eingabe eines Strahlenpaares eine höhere Genauigkeit, aber einen niedrigeren F1-Score auf. Dies zeigt, dass dieser Klassifikator deutlich weniger robust ist als ein mit symmetrischen Eingabestrahlen trainierter Klassifikator.

Andere Resektionsoperationen können im Papier und im Papieranhang eingesehen werden

Der Inhalt, der neu geschrieben werden muss, ist: Abbildung 9 zeigt den visuellen Vergleich der Verwendung eines Klassifikators und der Nichtverwendung eines Klassifikators

IV. Schlussfolgerung

Bei der Durchführung von Untersuchungen mit einem strahlenbasierten Multi-View-Konsistenzrahmen kam das Papier zu dem Schluss, dass die dreidimensionale Formdarstellung mit dieser Methode effizient und genau erlernt werden kann. In der Arbeit wird ein einfaches Strahlenoberflächen-Abstandsfeld verwendet, um die Geometrie dreidimensionaler Formen darzustellen, und ein neuartiger Dual-Ray-Sichtbarkeitsklassifikator wird verwendet, um die geometrische Konsistenz mehrerer Ansichten weiter zu erreichen. Experimente mit mehreren Datensätzen haben gezeigt, dass die RayDF-Methode eine extrem hohe Rendering-Effizienz und eine hervorragende Leistung aufweist. Weitere Erweiterungen des RayDF-Frameworks sind willkommen. Weitere Visualisierungsergebnisse können Sie auf der Homepage ansehen

Der Inhalt, der neu geschrieben werden muss, ist: https://vlar-group.github.io/RayDF.html

Der Inhalt, der neu geschrieben werden muss, ist: Original Link:https://mp.weixin.qq.com/s/dsrSHKT4NfgdDPYcKOhcOA

Das obige ist der detaillierte Inhalt vonNeuer Titel: Echtzeit-Rendering weiterentwickelt! Innovative Methode der 3D-Rekonstruktion auf Strahlenbasis. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

Dieser Artikel reicht aus, um etwas über autonomes Fahren und Flugbahnvorhersage zu lesen!

Feb 28, 2024 pm 07:20 PM

Dieser Artikel reicht aus, um etwas über autonomes Fahren und Flugbahnvorhersage zu lesen!

Feb 28, 2024 pm 07:20 PM

Die Trajektorienvorhersage spielt eine wichtige Rolle beim autonomen Fahren. Unter autonomer Fahrtrajektorienvorhersage versteht man die Vorhersage der zukünftigen Fahrtrajektorie des Fahrzeugs durch die Analyse verschiedener Daten während des Fahrvorgangs. Als Kernmodul des autonomen Fahrens ist die Qualität der Trajektorienvorhersage von entscheidender Bedeutung für die nachgelagerte Planungssteuerung. Die Trajektorienvorhersageaufgabe verfügt über einen umfangreichen Technologie-Stack und erfordert Vertrautheit mit der dynamischen/statischen Wahrnehmung des autonomen Fahrens, hochpräzisen Karten, Fahrspurlinien, Fähigkeiten in der neuronalen Netzwerkarchitektur (CNN&GNN&Transformer) usw. Der Einstieg ist sehr schwierig! Viele Fans hoffen, so schnell wie möglich mit der Flugbahnvorhersage beginnen zu können und Fallstricke zu vermeiden. Heute werde ich eine Bestandsaufnahme einiger häufiger Probleme und einführender Lernmethoden für die Flugbahnvorhersage machen! Einführungsbezogenes Wissen 1. Sind die Vorschaupapiere in Ordnung? A: Schauen Sie sich zuerst die Umfrage an, S

Das Stable Diffusion 3-Papier wird endlich veröffentlicht und die architektonischen Details werden enthüllt. Wird es helfen, Sora zu reproduzieren?

Mar 06, 2024 pm 05:34 PM

Das Stable Diffusion 3-Papier wird endlich veröffentlicht und die architektonischen Details werden enthüllt. Wird es helfen, Sora zu reproduzieren?

Mar 06, 2024 pm 05:34 PM

Der Artikel von StableDiffusion3 ist endlich da! Dieses Modell wurde vor zwei Wochen veröffentlicht und verwendet die gleiche DiT-Architektur (DiffusionTransformer) wie Sora. Nach seiner Veröffentlichung sorgte es für großes Aufsehen. Im Vergleich zur Vorgängerversion wurde die Qualität der von StableDiffusion3 generierten Bilder erheblich verbessert. Es unterstützt jetzt Eingabeaufforderungen mit mehreren Themen, und der Textschreibeffekt wurde ebenfalls verbessert, und es werden keine verstümmelten Zeichen mehr angezeigt. StabilityAI wies darauf hin, dass es sich bei StableDiffusion3 um eine Reihe von Modellen mit Parametergrößen von 800 M bis 8 B handelt. Durch diesen Parameterbereich kann das Modell direkt auf vielen tragbaren Geräten ausgeführt werden, wodurch der Einsatz von KI deutlich reduziert wird

Beherrschen Sie die Koordinatensystemkonvertierung wirklich? Multisensorik-Themen, die für das autonome Fahren unverzichtbar sind

Oct 12, 2023 am 11:21 AM

Beherrschen Sie die Koordinatensystemkonvertierung wirklich? Multisensorik-Themen, die für das autonome Fahren unverzichtbar sind

Oct 12, 2023 am 11:21 AM

Der erste Pilot- und Schlüsselartikel stellt hauptsächlich mehrere häufig verwendete Koordinatensysteme in der autonomen Fahrtechnologie vor und erläutert, wie die Korrelation und Konvertierung zwischen ihnen abgeschlossen und schließlich ein einheitliches Umgebungsmodell erstellt werden kann. Der Schwerpunkt liegt hier auf dem Verständnis der Umrechnung vom Fahrzeug in den starren Kamerakörper (externe Parameter), der Kamera-in-Bild-Konvertierung (interne Parameter) und der Bild-in-Pixel-Einheitenkonvertierung. Die Konvertierung von 3D in 2D führt zu entsprechenden Verzerrungen, Verschiebungen usw. Wichtige Punkte: Das Fahrzeugkoordinatensystem und das Kamerakörperkoordinatensystem müssen neu geschrieben werden: Das Ebenenkoordinatensystem und das Pixelkoordinatensystem. Schwierigkeit: Sowohl die Entzerrung als auch die Verzerrungsaddition müssen auf der Bildebene kompensiert werden. 2. Einführung Insgesamt gibt es vier visuelle Systeme Koordinatensystem: Pixelebenenkoordinatensystem (u, v), Bildkoordinatensystem (x, y), Kamerakoordinatensystem () und Weltkoordinatensystem (). Es gibt eine Beziehung zwischen jedem Koordinatensystem,

DualBEV: BEVFormer und BEVDet4D deutlich übertreffen, öffnen Sie das Buch!

Mar 21, 2024 pm 05:21 PM

DualBEV: BEVFormer und BEVDet4D deutlich übertreffen, öffnen Sie das Buch!

Mar 21, 2024 pm 05:21 PM

In diesem Artikel wird das Problem der genauen Erkennung von Objekten aus verschiedenen Blickwinkeln (z. B. Perspektive und Vogelperspektive) beim autonomen Fahren untersucht, insbesondere wie die Transformation von Merkmalen aus der Perspektive (PV) in den Raum aus der Vogelperspektive (BEV) effektiv ist implementiert über das Modul Visual Transformation (VT). Bestehende Methoden lassen sich grob in zwei Strategien unterteilen: 2D-zu-3D- und 3D-zu-2D-Konvertierung. 2D-zu-3D-Methoden verbessern dichte 2D-Merkmale durch die Vorhersage von Tiefenwahrscheinlichkeiten, aber die inhärente Unsicherheit von Tiefenvorhersagen, insbesondere in entfernten Regionen, kann zu Ungenauigkeiten führen. Während 3D-zu-2D-Methoden normalerweise 3D-Abfragen verwenden, um 2D-Features abzutasten und die Aufmerksamkeitsgewichte der Korrespondenz zwischen 3D- und 2D-Features über einen Transformer zu lernen, erhöht sich die Rechen- und Bereitstellungszeit.

Das erste Weltmodell zur Erzeugung autonomer Fahrszenen mit mehreren Ansichten | DrivingDiffusion: Neue Ideen für BEV-Daten und Simulation

Oct 23, 2023 am 11:13 AM

Das erste Weltmodell zur Erzeugung autonomer Fahrszenen mit mehreren Ansichten | DrivingDiffusion: Neue Ideen für BEV-Daten und Simulation

Oct 23, 2023 am 11:13 AM

Einige persönliche Gedanken des Autors Im Bereich des autonomen Fahrens sind mit der Entwicklung BEV-basierter Teilaufgaben/End-to-End-Lösungen hochwertige Multi-View-Trainingsdaten und der entsprechende Aufbau von Simulationsszenen immer wichtiger geworden. Als Reaktion auf die Schwachstellen aktueller Aufgaben kann „hohe Qualität“ in drei Aspekte zerlegt werden: Long-Tail-Szenarien in verschiedenen Dimensionen: z. B. Nahbereichsfahrzeuge in Hindernisdaten und präzise Kurswinkel beim Schneiden von Autos sowie Spurliniendaten . Szenen wie Kurven mit unterschiedlichen Krümmungen oder Rampen/Zusammenführungen/Zusammenführungen, die schwer zu erfassen sind. Diese basieren häufig auf der Sammlung großer Datenmengen und komplexen Data-Mining-Strategien, die kostspielig sind. Echter 3D-Wert – hochkonsistentes Bild: Die aktuelle BEV-Datenerfassung wird häufig durch Fehler bei der Sensorinstallation/-kalibrierung, hochpräzisen Karten und dem Rekonstruktionsalgorithmus selbst beeinträchtigt. das hat mich dazu geführt

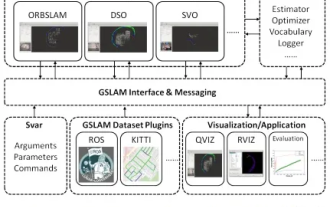

GSLAM |. Eine allgemeine SLAM-Architektur und ein Benchmark

Oct 20, 2023 am 11:37 AM

GSLAM |. Eine allgemeine SLAM-Architektur und ein Benchmark

Oct 20, 2023 am 11:37 AM

Plötzlich wurde ein 19 Jahre altes Papier namens GSLAM: A General SLAM Framework and Benchmark mit offenem Quellcode entdeckt: https://github.com/zdzhaoyong/GSLAM Gehen Sie direkt zum Volltext und spüren Sie die Qualität dieser Arbeit~1 Zusammenfassung der SLAM-Technologie hat in letzter Zeit viele Erfolge erzielt und die Aufmerksamkeit vieler High-Tech-Unternehmen auf sich gezogen. Es bleibt jedoch eine Frage, wie eine Schnittstelle zu bestehenden oder neuen Algorithmen hergestellt werden kann, um ein Benchmarking hinsichtlich Geschwindigkeit, Robustheit und Portabilität effizient durchzuführen. In diesem Artikel wird eine neue SLAM-Plattform namens GSLAM vorgeschlagen, die nicht nur Evaluierungsfunktionen bietet, sondern Forschern auch eine nützliche Möglichkeit bietet, schnell ihre eigenen SLAM-Systeme zu entwickeln.

„Minecraft' verwandelt sich in eine KI-Stadt und NPC-Bewohner spielen Rollenspiele wie echte Menschen

Jan 02, 2024 pm 06:25 PM

„Minecraft' verwandelt sich in eine KI-Stadt und NPC-Bewohner spielen Rollenspiele wie echte Menschen

Jan 02, 2024 pm 06:25 PM

Bitte beachten Sie, dass dieser kantige Mann die Stirn runzelt und über die Identität der „ungebetenen Gäste“ vor ihm nachdenkt. Es stellte sich heraus, dass sie sich in einer gefährlichen Situation befand, und als ihr dies klar wurde, begann sie schnell mit der mentalen Suche nach einer Strategie zur Lösung des Problems. Letztendlich entschloss sie sich, vom Unfallort zu fliehen, dann so schnell wie möglich Hilfe zu suchen und sofort Maßnahmen zu ergreifen. Gleichzeitig dachte die Person auf der Gegenseite das Gleiche wie sie... In „Minecraft“ gab es eine solche Szene, in der alle Charaktere von künstlicher Intelligenz gesteuert wurden. Jeder von ihnen hat eine einzigartige Identität. Das zuvor erwähnte Mädchen ist beispielsweise eine 17-jährige, aber kluge und mutige Kurierin. Sie haben die Fähigkeit, sich zu erinnern und zu denken und in dieser kleinen Stadt in Minecraft wie Menschen zu leben. Was sie antreibt, ist ein brandneues,

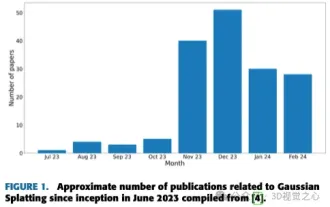

Mehr als nur 3D-Gauß! Aktueller Überblick über modernste 3D-Rekonstruktionstechniken

Jun 02, 2024 pm 06:57 PM

Mehr als nur 3D-Gauß! Aktueller Überblick über modernste 3D-Rekonstruktionstechniken

Jun 02, 2024 pm 06:57 PM

Oben geschrieben & Nach persönlichem Verständnis des Autors ist die bildbasierte 3D-Rekonstruktion eine anspruchsvolle Aufgabe, bei der aus einer Reihe von Eingabebildern auf die 3D-Form eines Objekts oder einer Szene geschlossen werden muss. Lernbasierte Methoden haben wegen ihrer Fähigkeit, 3D-Formen direkt abzuschätzen, Aufmerksamkeit erregt. Dieser Übersichtsartikel konzentriert sich auf modernste 3D-Rekonstruktionstechniken, einschließlich der Generierung neuartiger, unsichtbarer Ansichten. Es wird ein Überblick über die jüngsten Entwicklungen bei Gaußschen Splash-Methoden gegeben, einschließlich Eingabetypen, Modellstrukturen, Ausgabedarstellungen und Trainingsstrategien. Auch ungelöste Herausforderungen und zukünftige Ausrichtungen werden besprochen. Angesichts der rasanten Fortschritte auf diesem Gebiet und der zahlreichen Möglichkeiten zur Verbesserung der 3D-Rekonstruktionsmethoden scheint eine gründliche Untersuchung des Algorithmus von entscheidender Bedeutung zu sein. Daher bietet diese Studie einen umfassenden Überblick über die jüngsten Fortschritte in der Gaußschen Streuung. (Wischen Sie mit dem Daumen nach oben