Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Große Open-Source-Modelle müssen Closed-Source übertreffen – LeCun enthüllt KI-Trenddiagramm 2024

Große Open-Source-Modelle müssen Closed-Source übertreffen – LeCun enthüllt KI-Trenddiagramm 2024

Große Open-Source-Modelle müssen Closed-Source übertreffen – LeCun enthüllt KI-Trenddiagramm 2024

2023 geht zu Ende. Im vergangenen Jahr wurden verschiedene große Modelle herausgebracht. Während Technologiegiganten wie OpenAI und Google konkurrieren, erhebt sich still und leise eine andere „Macht“ – Open Source.

Das Open-Source-Modell wurde schon immer viel in Frage gestellt. Sind sie so gut wie proprietäre Modelle? Kann es mit der Leistung proprietärer Modelle mithalten? Bisher konnten wir sagen, dass wir nur einigermaßen nah dran sind. Dennoch wird uns das Open-Source-Modell immer empirische Leistung bringen, was uns mit Bewunderung betrachten lässt.

Der Aufstieg von Open-Source-Modellen verändert die Spielregeln. Die LLaMA-Serie von Meta erfreut sich beispielsweise aufgrund ihrer schnellen Iteration, Anpassbarkeit und Privatsphäre immer größerer Beliebtheit. Diese Modelle werden von der Community schnell weiterentwickelt, was eine starke Herausforderung für proprietäre Modelle darstellt und die Wettbewerbslandschaft großer Technologieunternehmen verändern kann.

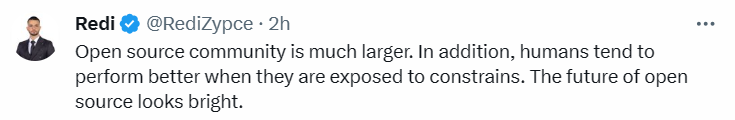

Aber früher kamen die meisten Ideen der Menschen nur aus „Gefühlen“. Heute Morgen beklagte sich Metas Chef-KI-Wissenschaftler und Turing-Award-Gewinner Yann LeCun plötzlich: „Open-Source-Modelle für künstliche Intelligenz sind auf dem Weg, proprietäre Modelle zu übertreffen.“ des ARK Invest-Teams wird davon ausgegangen, dass die Entwicklung der künstlichen Intelligenz im Jahr 2024 möglicherweise vorhergesagt wird. Es zeigt das Wachstum von Open-Source-Communities im Vergleich zu proprietären Modellen in der generativen künstlichen Intelligenz

Da Unternehmen wie OpenAI und Google immer verschlossener werden, veröffentlichen sie immer seltener Informationen über ihre neuesten Modelle. Infolgedessen beginnen die Open-Source-Community und ihr Unternehmensunterstützer Meta einzuschreiten, um generative KI zu demokratisieren, was möglicherweise eine Herausforderung für die Geschäftsmodelle proprietärer Modelle darstellt

In diesem Streudiagramm werden verschiedene KIs angezeigt. Der Leistungsprozentsatz der Modell. Proprietäre Modelle werden in Blau und Open-Source-Modelle in Schwarz dargestellt. Wir können die Leistung verschiedener KI-Modelle wie GPT-3, Chinchilla 70B (Google), PaLM (Google), GPT-4 (OpenAI) und Llama65B (Meta) zu verschiedenen Zeitpunkten sehen.

Als Meta LLaMA erstmals veröffentlichte, schwankte die Anzahl der Parameter zwischen 7 und 65 Milliarden. Die Leistung dieser Modelle ist ausgezeichnet: Das Llama-Modell mit 13 Milliarden Parametern kann GPT-3 (175 Milliarden Parameter) „bei den meisten Benchmarks“ übertreffen und kann auf einer einzigen V100-GPU laufen, während die größten 65 Milliarden Parameter des Llama-Modells vorhanden sind sind vergleichbar mit Googles Chinchilla-70B und PaLM-540B.

Falcon-40B schoss gleich nach seiner Veröffentlichung an die Spitze der OpenLLM-Rangliste von Huggingface und veränderte die Szene, in der Llama herausragt.

Llama 2 ist Open Source und sorgt wieder einmal für große Veränderungen in der großen Modelllandschaft. Im Vergleich zu Llama 1 verfügt Llama 2 über 40 % mehr Trainingsdaten, verdoppelt die Kontextlänge und verwendet einen gruppierten Abfrageaufmerksamkeitsmechanismus.

Vor kurzem hat das Open-Source-Großmodelluniversum ein neues Schwergewichtsmitglied gewonnen – das Yi-Modell. Es kann 400.000 chinesische Zeichen gleichzeitig verarbeiten, wobei Chinesisch und Englisch die Liste dominieren. Yi-34B ist außerdem das einzige inländische Modell, das bisher die Rangliste der Open-Source-Modelle Hugging Face erfolgreich anführt.

Vor kurzem hat das Open-Source-Großmodelluniversum ein neues Schwergewichtsmitglied gewonnen – das Yi-Modell. Es kann 400.000 chinesische Zeichen gleichzeitig verarbeiten, wobei Chinesisch und Englisch die Liste dominieren. Yi-34B ist außerdem das einzige inländische Modell, das bisher die Rangliste der Open-Source-Modelle Hugging Face erfolgreich anführt.

Laut Streudiagramm holt die Leistung des Open-Source-Modells weiterhin mit dem proprietären Modell auf. Dies bedeutet, dass das Open-Source-Modell in naher Zukunft mit der Leistung des proprietären Modells mithalten oder es sogar übertreffen wird.

Mistral 8x7B erhielt am vergangenen Wochenende großes Lob von Forschern für seine einfachste Release-Methode und leistungsstarke Leistung. Sagte: „Das Closed-Source-Großmodell ist am Ende.“

Einige Internetnutzer haben begonnen, sich zu wünschen, dass „2024 das Jahr der Open-Source-künstlichen Intelligenz wird“ und glauben, dass „wir uns einem kritischen Punkt nähern.“ Angesichts der aktuellen Open-Source-Community-Projekte gehen wir davon aus, dass wir in den nächsten 12 Monaten das Niveau von GPT-4 erreichen werden Das Open-Source-Modell läuft reibungslos und welche Leistung wird es zeigen

Das obige ist der detaillierte Inhalt vonGroße Open-Source-Modelle müssen Closed-Source übertreffen – LeCun enthüllt KI-Trenddiagramm 2024. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Welche Methode wird verwendet, um Strings in Objekte in Vue.js umzuwandeln?

Apr 07, 2025 pm 09:39 PM

Welche Methode wird verwendet, um Strings in Objekte in Vue.js umzuwandeln?

Apr 07, 2025 pm 09:39 PM

Bei der Konvertierung von Zeichenfolgen in Objekte in Vue.js wird JSON.Parse () für Standard -JSON -Zeichenfolgen bevorzugt. Bei nicht standardmäßigen JSON-Zeichenfolgen kann die Zeichenfolge durch Verwendung regelmäßiger Ausdrücke verarbeitet und Methoden gemäß dem Format oder dekodierten URL-kodiert reduziert werden. Wählen Sie die entsprechende Methode gemäß dem String -Format aus und achten Sie auf Sicherheits- und Codierungsprobleme, um Fehler zu vermeiden.

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

Der Artikel führt den Betrieb der MySQL -Datenbank vor. Zunächst müssen Sie einen MySQL -Client wie MySQLworkBench oder Befehlszeilen -Client installieren. 1. Verwenden Sie den Befehl mySQL-uroot-P, um eine Verbindung zum Server herzustellen und sich mit dem Stammkonto-Passwort anzumelden. 2. Verwenden Sie die Erstellung von Createdatabase, um eine Datenbank zu erstellen, und verwenden Sie eine Datenbank aus. 3.. Verwenden Sie CreateTable, um eine Tabelle zu erstellen, Felder und Datentypen zu definieren. 4. Verwenden Sie InsertInto, um Daten einzulegen, Daten abzufragen, Daten nach Aktualisierung zu aktualisieren und Daten nach Löschen zu löschen. Nur indem Sie diese Schritte beherrschen, lernen, mit gemeinsamen Problemen umzugehen und die Datenbankleistung zu optimieren, können Sie MySQL effizient verwenden.

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Es gibt viele Gründe, warum MySQL Startup fehlschlägt und durch Überprüfung des Fehlerprotokolls diagnostiziert werden kann. Zu den allgemeinen Ursachen gehören Portkonflikte (prüfen Portbelegung und Änderung der Konfiguration), Berechtigungsprobleme (Überprüfen Sie den Dienst Ausführen von Benutzerberechtigungen), Konfigurationsdateifehler (Überprüfung der Parametereinstellungen), Datenverzeichniskorruption (Wiederherstellung von Daten oder Wiederaufbautabellenraum), InnoDB-Tabellenraumprobleme (prüfen IBDATA1-Dateien), Plug-in-Ladeversagen (Überprüfen Sie Fehlerprotokolle). Wenn Sie Probleme lösen, sollten Sie sie anhand des Fehlerprotokolls analysieren, die Hauptursache des Problems finden und die Gewohnheit entwickeln, Daten regelmäßig zu unterstützen, um Probleme zu verhindern und zu lösen.

Laravels Geospatial: Optimierung interaktiver Karten und großen Datenmengen

Apr 08, 2025 pm 12:24 PM

Laravels Geospatial: Optimierung interaktiver Karten und großen Datenmengen

Apr 08, 2025 pm 12:24 PM

Verarbeiten Sie 7 Millionen Aufzeichnungen effizient und erstellen Sie interaktive Karten mit Geospatial -Technologie. In diesem Artikel wird untersucht, wie über 7 Millionen Datensätze mithilfe von Laravel und MySQL effizient verarbeitet und in interaktive Kartenvisualisierungen umgewandelt werden können. Erstes Herausforderungsprojektanforderungen: Mit 7 Millionen Datensätzen in der MySQL -Datenbank wertvolle Erkenntnisse extrahieren. Viele Menschen erwägen zunächst Programmiersprachen, aber ignorieren die Datenbank selbst: Kann sie den Anforderungen erfüllen? Ist Datenmigration oder strukturelle Anpassung erforderlich? Kann MySQL einer so großen Datenbelastung standhalten? Voranalyse: Schlüsselfilter und Eigenschaften müssen identifiziert werden. Nach der Analyse wurde festgestellt, dass nur wenige Attribute mit der Lösung zusammenhängen. Wir haben die Machbarkeit des Filters überprüft und einige Einschränkungen festgelegt, um die Suche zu optimieren. Kartensuche basierend auf der Stadt

So stellen Sie die Zeitüberschreitung von Vue Axios fest

Apr 07, 2025 pm 10:03 PM

So stellen Sie die Zeitüberschreitung von Vue Axios fest

Apr 07, 2025 pm 10:03 PM

Um die Zeitüberschreitung für Vue Axios festzulegen, können wir eine Axios -Instanz erstellen und die Zeitleitungsoption angeben: in globalen Einstellungen: vue.Prototyp. $ Axios = axios.create ({Timeout: 5000}); In einer einzigen Anfrage: this. $ axios.get ('/api/user', {timeout: 10000}).

So optimieren Sie die Datenbankleistung nach der MySQL -Installation

Apr 08, 2025 am 11:36 AM

So optimieren Sie die Datenbankleistung nach der MySQL -Installation

Apr 08, 2025 am 11:36 AM

Die MySQL -Leistungsoptimierung muss von drei Aspekten beginnen: Installationskonfiguration, Indexierung und Abfrageoptimierung, Überwachung und Abstimmung. 1. Nach der Installation müssen Sie die my.cnf -Datei entsprechend der Serverkonfiguration anpassen, z. 2. Erstellen Sie einen geeigneten Index, um übermäßige Indizes zu vermeiden und Abfrageanweisungen zu optimieren, z. B. den Befehl Erklärung zur Analyse des Ausführungsplans; 3. Verwenden Sie das eigene Überwachungstool von MySQL (ShowProcessList, Showstatus), um die Datenbankgesundheit zu überwachen und die Datenbank regelmäßig zu sichern und zu organisieren. Nur durch kontinuierliche Optimierung dieser Schritte kann die Leistung der MySQL -Datenbank verbessert werden.

VUE.JS Wie kann man ein Array von String -Typ in ein Array von Objekten umwandeln?

Apr 07, 2025 pm 09:36 PM

VUE.JS Wie kann man ein Array von String -Typ in ein Array von Objekten umwandeln?

Apr 07, 2025 pm 09:36 PM

Zusammenfassung: Es gibt die folgenden Methoden zum Umwandeln von VUE.JS -String -Arrays in Objektarrays: Grundlegende Methode: Verwenden Sie die Kartenfunktion, um regelmäßige formatierte Daten zu entsprechen. Erweitertes Gameplay: Die Verwendung regulärer Ausdrücke kann komplexe Formate ausführen, müssen jedoch sorgfältig geschrieben und berücksichtigt werden. Leistungsoptimierung: In Betracht ziehen die große Datenmenge, asynchrone Operationen oder effiziente Datenverarbeitungsbibliotheken können verwendet werden. Best Practice: Clear Code -Stil, verwenden Sie sinnvolle variable Namen und Kommentare, um den Code präzise zu halten.

Remote Senior Backend Engineers (Plattformen) benötigen Kreise

Apr 08, 2025 pm 12:27 PM

Remote Senior Backend Engineers (Plattformen) benötigen Kreise

Apr 08, 2025 pm 12:27 PM

Remote Senior Backend Engineer Job Vacant Company: Circle Standort: Remote-Büro-Jobtyp: Vollzeitgehalt: 130.000 bis 140.000 US-Dollar Stellenbeschreibung Nehmen Sie an der Forschung und Entwicklung von Mobilfunkanwendungen und öffentlichen API-bezogenen Funktionen, die den gesamten Lebenszyklus der Softwareentwicklung abdecken. Die Hauptaufgaben erledigen die Entwicklungsarbeit unabhängig von RubyonRails und arbeiten mit dem Front-End-Team von React/Redux/Relay zusammen. Erstellen Sie die Kernfunktionalität und -verbesserungen für Webanwendungen und arbeiten Sie eng mit Designer und Führung während des gesamten funktionalen Designprozesses zusammen. Fördern Sie positive Entwicklungsprozesse und priorisieren Sie die Iterationsgeschwindigkeit. Erfordert mehr als 6 Jahre komplexes Backend für Webanwendungen