Kürzlich haben Forscher von Waabi AI, der University of Toronto, der University of Waterloo und dem MIT auf der NeurIPS 2023 eine neue Beleuchtungssimulationsplattform für autonomes Fahren, LightSim, vorgeschlagen. Forscher haben Methoden vorgeschlagen, um gepaarte Beleuchtungstrainingsdaten aus realen Daten zu generieren und so die Probleme fehlender Daten und Modellmigrationsverluste zu lösen. LightSim nutzt neuronale Strahlungsfelder (NeRF) und physikbasierte tiefe Netzwerke, um Fahrvideos von Fahrzeugen zu rendern und ermöglicht so erstmals eine Beleuchtungssimulation dynamischer Szenen auf großen realen Daten.

- Projektwebsite: https://waabi.ai/lightsim

- Papierlink: https://openreview.net/pdf?id=mcx8IGneYw

Warum brauchen Sie eine Beleuchtungssimulation für autonomes Fahren? Kamerasimulation ist in der Robotik sehr wichtig, insbesondere für autonome Fahrzeuge zur Wahrnehmung von Außenszenen. Bestehende Kamerawahrnehmungssysteme weisen jedoch eine schlechte Leistung auf, wenn sie auf Lichtverhältnisse im Freien stoßen, die im Training nicht erlernt wurden. Die Generierung eines umfangreichen Datensatzes von Außenbeleuchtungsänderungen durch Kamerasimulation kann die Robustheit autonomer Fahrsysteme verbessern. Gängige Kamerasimulationsmethoden basieren im Allgemeinen auf Physik-Engines. Diese Methode rendert die Szene durch Festlegen des 3D-Modells und der Lichtbedingungen. Allerdings mangelt es Simulationseffekten oft an Diversität und sie sind nicht realistisch genug. Darüber hinaus stimmen die physischen Rendering-Ergebnisse aufgrund der begrenzten Anzahl hochwertiger 3D-Modelle nicht genau mit den realen Szenen überein. Dies führt zu einer schlechten Generalisierungsfähigkeit des trainierten Modells auf reale Daten. Die andere basiert auf einer datengesteuerten Simulationsmethode. Es verwendet neuronales Rendering, um reale digitale Zwillinge zu rekonstruieren, die von Sensoren beobachtete Daten replizieren. Dieser Ansatz ermöglicht eine skalierbarere Szenenerstellung und einen verbesserten Realismus, allerdings neigen bestehende Technologien dazu, die Szenenbeleuchtung in das 3D-Modell einzubinden, was die Bearbeitung des digitalen Zwillings, wie z. B. das Ändern der Lichtverhältnisse oder das Hinzufügen oder Löschen neuer Objekte usw., erschwert. In einer Arbeit bei NeurIPS 2023 demonstrierten Forscher von Waabi AI ein Beleuchtungssimulationssystem basierend auf der Physik-Engine und dem neuronalen Netzwerk LightSim: Neuronale Beleuchtungssimulation für städtische Szenen.

Anders als in früheren Arbeiten hat LightSim dies getan außerdem erreicht: 1. Realistisch: Zum ersten Mal wurde eine Beleuchtungssimulation großflächiger dynamischer Außenszenen erreicht und kann Schatten, Lichteffekte zwischen Objekten usw. genauer simulieren. 2. Steuerbar: Unterstützt die Bearbeitung dynamischer Fahrszenen (Hinzufügen, Löschen von Objekten, Kamerapositionen und -parametern, Ändern der Beleuchtung, Generieren sicherheitskritischer Szenen usw.), um realistischere und konsistentere Videos zu generieren Beleuchtung und Randbedingungen. 3. Skalierbar: Es ist einfach, auf mehr Szenarien und verschiedene Datensätze zu erweitern. Es müssen nur einmal Daten erfasst werden (einmaliger Durchgang), um reale und kontrollierbare Simulationstests zu rekonstruieren und durchzuführen.

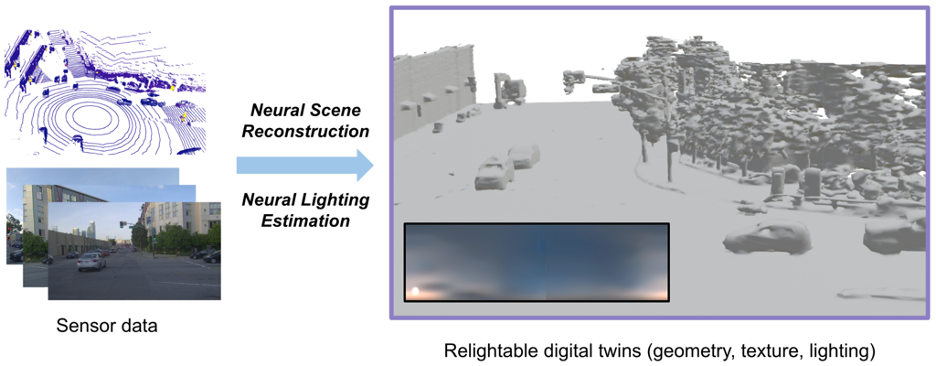

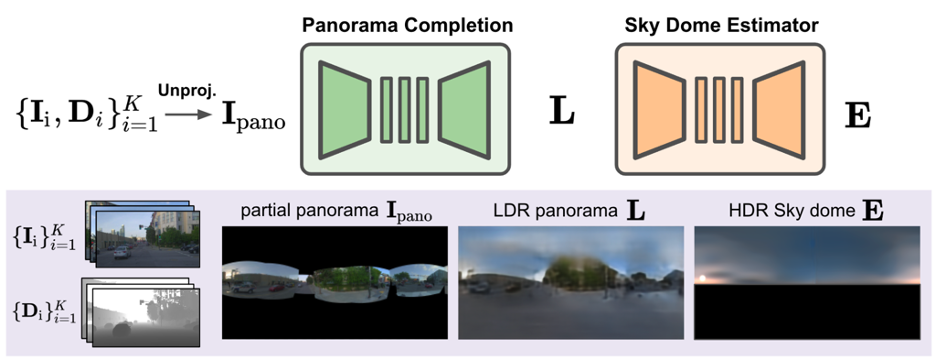

Aufbau eines SimulationssystemsSchritt 1: Erstellen eines realen, wiederbeleuchtebaren digitalen ZwillingsUm die autonome Fahrszene in der digitalen Welt zu rekonstruieren, beginnt LightSim zunächst mit dem Die gesammelten Daten teilen dynamische Objekte und statische Szenen auf. In diesem Schritt wird UniSim verwendet, um die Szene zu rekonstruieren und die Abhängigkeit von der Kameraansicht im Netzwerk zu beseitigen. Verwenden Sie dann den Marschwürfel, um die Geometrie zu erhalten, und wandeln Sie sie weiter in ein Netz mit Grundmaterialien um.  Neben Materialien und Geometrie kann LightSim auch die Außenbeleuchtung anhand von Sonne und Himmel, den Hauptlichtquellen von Tagesszenen im Freien, schätzen und eine Umgebungskarte mit hohem Dynamikbereich (HDR Sky Dome) erhalten. Anhand von Sensordaten und extrahierter Geometrie kann LightSim ein unvollständiges Panoramabild schätzen und es dann vervollständigen, um eine vollständige 360°-Ansicht des Himmels zu erhalten. Dieses Panoramabild und die GPS-Informationen werden dann verwendet, um eine HDR-Umgebungskarte zu erstellen, die die Sonnenintensität, die Sonnenrichtung und das Erscheinungsbild des Himmels genau einschätzt. 🔜 Darstellungen von Augmented Reality zu generieren. LightSim führt ein physikalisch basiertes Rendering durch und generiert beleuchtungsbezogene Daten wie Grundfarbe, Tiefe, Normalenvektoren und Schatten zur Modifizierung der Szene. Unter Verwendung dieser beleuchtungsbezogenen Daten und einer Schätzung der Quell- und Zielbeleuchtungsbedingungen der Szene sieht der LightSim-Workflow wie folgt aus.

Neben Materialien und Geometrie kann LightSim auch die Außenbeleuchtung anhand von Sonne und Himmel, den Hauptlichtquellen von Tagesszenen im Freien, schätzen und eine Umgebungskarte mit hohem Dynamikbereich (HDR Sky Dome) erhalten. Anhand von Sensordaten und extrahierter Geometrie kann LightSim ein unvollständiges Panoramabild schätzen und es dann vervollständigen, um eine vollständige 360°-Ansicht des Himmels zu erhalten. Dieses Panoramabild und die GPS-Informationen werden dann verwendet, um eine HDR-Umgebungskarte zu erstellen, die die Sonnenintensität, die Sonnenrichtung und das Erscheinungsbild des Himmels genau einschätzt. 🔜 Darstellungen von Augmented Reality zu generieren. LightSim führt ein physikalisch basiertes Rendering durch und generiert beleuchtungsbezogene Daten wie Grundfarbe, Tiefe, Normalenvektoren und Schatten zur Modifizierung der Szene. Unter Verwendung dieser beleuchtungsbezogenen Daten und einer Schätzung der Quell- und Zielbeleuchtungsbedingungen der Szene sieht der LightSim-Workflow wie folgt aus.

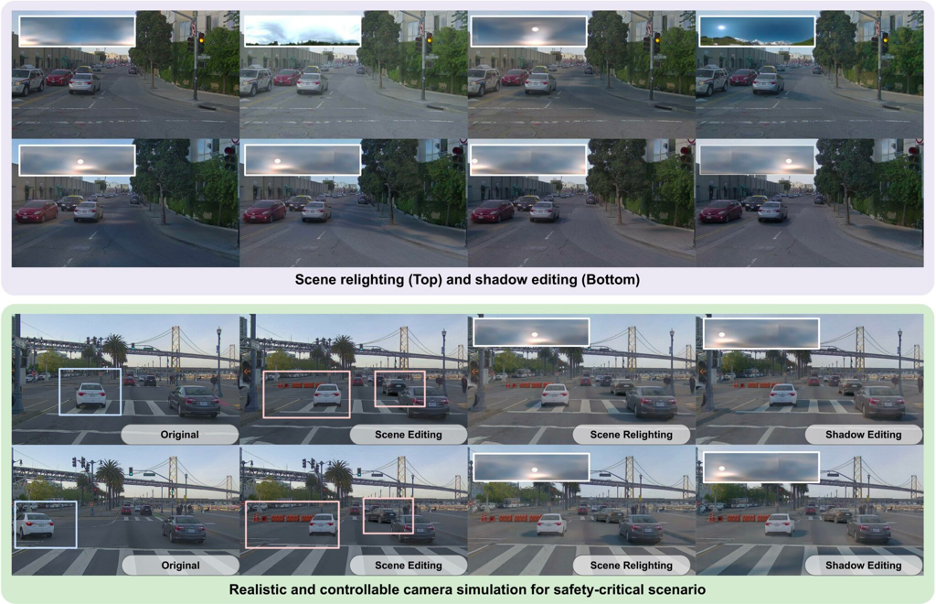

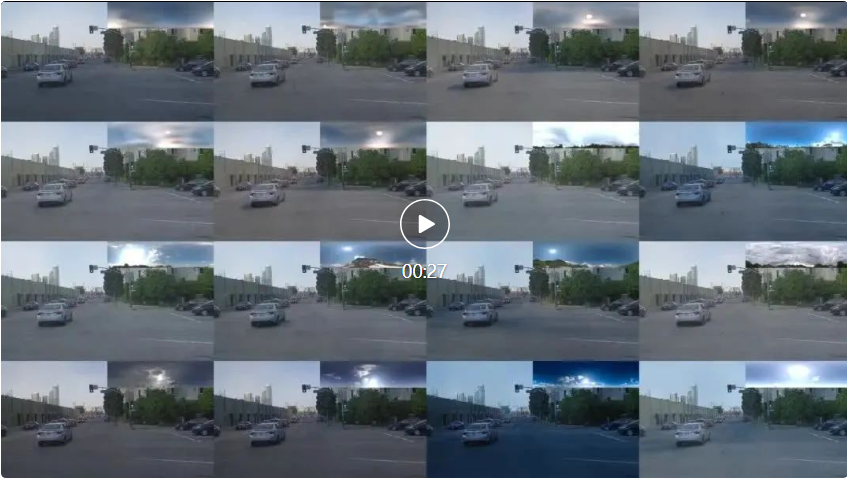

Während physikalisch basierte gerenderte Bilder die Lichteffekte in einer Szene gut rekonstruieren können, mangelt es den Renderergebnissen aufgrund von Unvollkommenheiten in der Geometrie und Fehlern bei der Material-/Lichtzerlegung oft an Realismus, wie z. B. verschwommenen, unrealistischen Oberflächenreflexionen und Randartefakten. Daher haben Forscher neuronales verzögertes Rendering vorgeschlagen, um den Realismus zu verbessern. Sie führten ein Bildsynthesenetzwerk ein, das ein Quellbild und einen vorberechneten Puffer mit beleuchtungsbezogenen Daten, die von der Rendering-Engine generiert wurden, verwendet, um das endgültige Bild zu erzeugen. Gleichzeitig stellt die in der Arbeit beschriebene Methode dem Netzwerk auch eine Umgebungskarte zur Verbesserung des Beleuchtungskontexts zur Verfügung und generiert gepaarte Bilder über den digitalen Zwilling, wodurch eine neuartige paarweise Simulation und ein Trainingsschema für echte Daten bereitgestellt werden. Demonstration der SimulationsfähigkeitÄndern der Szenenbeleuchtung (Scene Relighting)LightSim kann dieselbe Szene zeitkonsistent unter neuen Lichtbedingungen rendern. Wie im Video gezeigt, führen der neue Sonnenstand und das Erscheinungsbild des Himmels dazu, dass sich die Schatten und das Erscheinungsbild der Szene ändern.  LightSim kann die Neubeleuchtung von Szenen stapelweise durchführen und so aus geschätzten und realen HDR-Umgebungskarten neue zeitkonsistente und 3D-bewusste Beleuchtungsänderungen derselben Szene generieren.

LightSim kann die Neubeleuchtung von Szenen stapelweise durchführen und so aus geschätzten und realen HDR-Umgebungskarten neue zeitkonsistente und 3D-bewusste Beleuchtungsänderungen derselben Szene generieren.  Die Beleuchtungsdarstellung von LightSim ist editierbar und kann die Richtung der Sonne ändern, wodurch Lichtänderungen und Schatten im Zusammenhang mit der Richtung des Sonnenlichts aktualisiert werden. LightSim generiert das folgende Video, indem eine HDR-Umgebungskarte gedreht und an das Neural Deferred Rendering-Modul übergeben wird.

Die Beleuchtungsdarstellung von LightSim ist editierbar und kann die Richtung der Sonne ändern, wodurch Lichtänderungen und Schatten im Zusammenhang mit der Richtung des Sonnenlichts aktualisiert werden. LightSim generiert das folgende Video, indem eine HDR-Umgebungskarte gedreht und an das Neural Deferred Rendering-Modul übergeben wird.  LightSim kann die Schattenbearbeitung auch stapelweise durchführen.

LightSim kann die Schattenbearbeitung auch stapelweise durchführen.  Beleuchtungsbewusste Schauspielereinfügung Zusätzlich zur Änderung der Beleuchtung kann LightSim auch beleuchtungsbewusste Ergänzungen an ungewöhnlichen Objekten wie architektonischen Hindernissen vornehmen. Diese hinzugefügten Objekte können die Beleuchtungsschatten des Objekts aktualisieren, Objekte genau verdecken und sich räumlich an die gesamte Kamerakonfiguration anpassen.

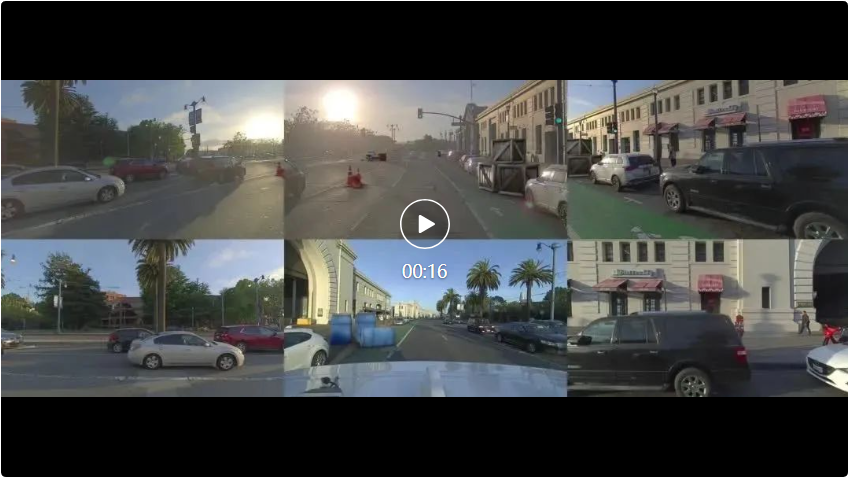

Beleuchtungsbewusste Schauspielereinfügung Zusätzlich zur Änderung der Beleuchtung kann LightSim auch beleuchtungsbewusste Ergänzungen an ungewöhnlichen Objekten wie architektonischen Hindernissen vornehmen. Diese hinzugefügten Objekte können die Beleuchtungsschatten des Objekts aktualisieren, Objekte genau verdecken und sich räumlich an die gesamte Kamerakonfiguration anpassen.  Simulationsübertragung (Verallgemeinerung auf nuScenes)Da das neuronale Deferred-Rendering-Netzwerk von LightSim auf mehreren Fahrvideos trainiert wird, kann LightSim auf neue Szenen verallgemeinert werden. Das folgende Video demonstriert die Fähigkeit von LightSim, auf Fahrszenen in nuScenes zu verallgemeinern. LightSim erstellt einen beleuchtungsbewussten digitalen Zwilling jeder Szene, der dann auf ein auf PandaSet vorab trainiertes neuronales verzögertes Rendering-Modell angewendet wird. Die LightSim-Migration funktioniert gut und kann Szenen relativ robust neu beleuchten.

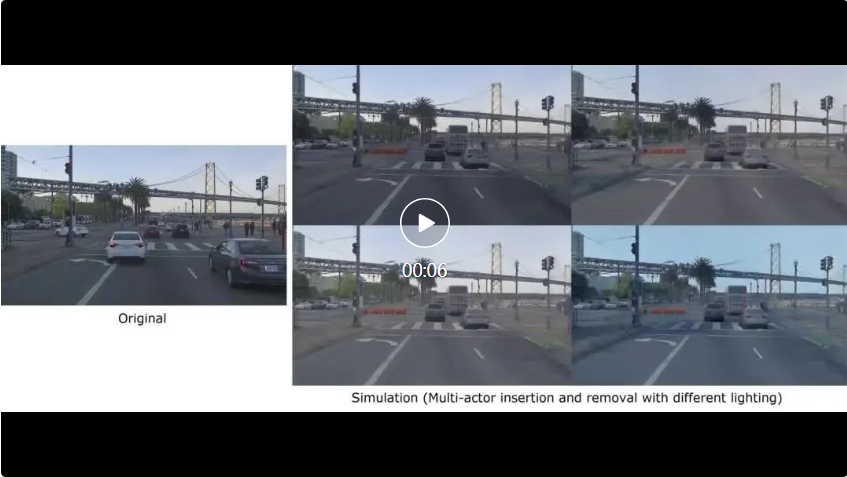

Simulationsübertragung (Verallgemeinerung auf nuScenes)Da das neuronale Deferred-Rendering-Netzwerk von LightSim auf mehreren Fahrvideos trainiert wird, kann LightSim auf neue Szenen verallgemeinert werden. Das folgende Video demonstriert die Fähigkeit von LightSim, auf Fahrszenen in nuScenes zu verallgemeinern. LightSim erstellt einen beleuchtungsbewussten digitalen Zwilling jeder Szene, der dann auf ein auf PandaSet vorab trainiertes neuronales verzögertes Rendering-Modell angewendet wird. Die LightSim-Migration funktioniert gut und kann Szenen relativ robust neu beleuchten.  Echte und kontrollierbare KamerasimulationBasierend auf allen oben gezeigten Funktionen erreicht LightSim eine kontrollierbare, vielfältige und realistische Kamerasimulation. Das folgende Video demonstriert die Szenensimulationsfunktionen von LightSim. Im Video führte ein weißes Auto einen Notspurwechsel auf die SDV-Spur durch und führte zu einer neuen Straßensperre, wodurch das weiße Auto in eine völlig neue Szene einfuhr. Die von LightSim unter verschiedenen Lichtverhältnissen in der neuen Szene erzeugten Effekte sind wie folgt : .

Echte und kontrollierbare KamerasimulationBasierend auf allen oben gezeigten Funktionen erreicht LightSim eine kontrollierbare, vielfältige und realistische Kamerasimulation. Das folgende Video demonstriert die Szenensimulationsfunktionen von LightSim. Im Video führte ein weißes Auto einen Notspurwechsel auf die SDV-Spur durch und führte zu einer neuen Straßensperre, wodurch das weiße Auto in eine völlig neue Szene einfuhr. Die von LightSim unter verschiedenen Lichtverhältnissen in der neuen Szene erzeugten Effekte sind wie folgt : . Ein weiteres Beispiel wird im Video unten gezeigt, wo nach dem Einfügen eines neuen Straßenhindernisses eine neue Gruppe von Fahrzeugen hinzugefügt wurde. Mithilfe der mit LightSim erstellten simulierten Beleuchtung können neu hinzugefügte Fahrzeuge nahtlos in die Szene integriert werden.

Ein weiteres Beispiel wird im Video unten gezeigt, wo nach dem Einfügen eines neuen Straßenhindernisses eine neue Gruppe von Fahrzeugen hinzugefügt wurde. Mithilfe der mit LightSim erstellten simulierten Beleuchtung können neu hinzugefügte Fahrzeuge nahtlos in die Szene integriert werden.  Zusammenfassung und AusblickLightSim ist eine lichtbewusste Kamerasimulationsplattform, die zur Bearbeitung groß angelegter dynamischer Fahrszenen dient. Es kann beleuchtungsbewusste digitale Zwillinge auf der Grundlage realer Daten erstellen und diese modifizieren, um neue Szenen mit unterschiedlichen Objektlayouts und SDV-Perspektiven zu erstellen. LightSim ist in der Lage, neue Lichtverhältnisse in einer Szene zu simulieren, um eine vielfältige, realistische und kontrollierbare Kamerasimulation zu ermöglichen, was zu zeitlich/räumlich konsistenten Videos führt. Es ist erwähnenswert, dass LightSim auch mit Reverse Rendering, Wettersimulation und anderen Technologien kombiniert werden kann, um die Simulationsleistung weiter zu verbessern.

Zusammenfassung und AusblickLightSim ist eine lichtbewusste Kamerasimulationsplattform, die zur Bearbeitung groß angelegter dynamischer Fahrszenen dient. Es kann beleuchtungsbewusste digitale Zwillinge auf der Grundlage realer Daten erstellen und diese modifizieren, um neue Szenen mit unterschiedlichen Objektlayouts und SDV-Perspektiven zu erstellen. LightSim ist in der Lage, neue Lichtverhältnisse in einer Szene zu simulieren, um eine vielfältige, realistische und kontrollierbare Kamerasimulation zu ermöglichen, was zu zeitlich/räumlich konsistenten Videos führt. Es ist erwähnenswert, dass LightSim auch mit Reverse Rendering, Wettersimulation und anderen Technologien kombiniert werden kann, um die Simulationsleistung weiter zu verbessern. Das obige ist der detaillierte Inhalt vonLightSim: Eine Beleuchtungssimulationsplattform für autonomes Fahren, die auf der NeurIPS 2023 eingeführt wurde, um ein realistisches, kontrollierbares und skalierbares Simulationserlebnis zu erreichen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

LightSim kann die Neubeleuchtung von Szenen stapelweise durchführen und so aus geschätzten und realen HDR-Umgebungskarten neue zeitkonsistente und 3D-bewusste Beleuchtungsänderungen derselben Szene generieren.

LightSim kann die Neubeleuchtung von Szenen stapelweise durchführen und so aus geschätzten und realen HDR-Umgebungskarten neue zeitkonsistente und 3D-bewusste Beleuchtungsänderungen derselben Szene generieren.

LightSim kann die Schattenbearbeitung auch stapelweise durchführen.

LightSim kann die Schattenbearbeitung auch stapelweise durchführen.

Ein weiteres Beispiel wird im Video unten gezeigt, wo nach dem Einfügen eines neuen Straßenhindernisses eine neue Gruppe von Fahrzeugen hinzugefügt wurde. Mithilfe der mit LightSim erstellten simulierten Beleuchtung können neu hinzugefügte Fahrzeuge nahtlos in die Szene integriert werden.

Ein weiteres Beispiel wird im Video unten gezeigt, wo nach dem Einfügen eines neuen Straßenhindernisses eine neue Gruppe von Fahrzeugen hinzugefügt wurde. Mithilfe der mit LightSim erstellten simulierten Beleuchtung können neu hinzugefügte Fahrzeuge nahtlos in die Szene integriert werden.

So starten Sie den MySQL-Dienst

So starten Sie den MySQL-Dienst

So überspringen Sie die Netzwerkverbindung während der Win11-Installation

So überspringen Sie die Netzwerkverbindung während der Win11-Installation

So lösen Sie das Problem, dass der PHPStudy-Port belegt ist

So lösen Sie das Problem, dass der PHPStudy-Port belegt ist

So reparieren Sie das Win7-System, wenn es beschädigt ist und nicht gestartet werden kann

So reparieren Sie das Win7-System, wenn es beschädigt ist und nicht gestartet werden kann

xenserver

xenserver

Ist Code Red ein Computervirus?

Ist Code Red ein Computervirus?

stackoverflowatline1

stackoverflowatline1

So kündigen Sie ein Douyin-Konto bei Douyin

So kündigen Sie ein Douyin-Konto bei Douyin

Was sind die Unterschiede zwischen den Eclipse-Versionsnummern?

Was sind die Unterschiede zwischen den Eclipse-Versionsnummern?