Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Kuaishous Forschungsergebnis SAMP wurde auf der EMNLP2023 International Artificial Intelligence Conference ausgezeichnet

Kuaishous Forschungsergebnis SAMP wurde auf der EMNLP2023 International Artificial Intelligence Conference ausgezeichnet

Kuaishous Forschungsergebnis SAMP wurde auf der EMNLP2023 International Artificial Intelligence Conference ausgezeichnet

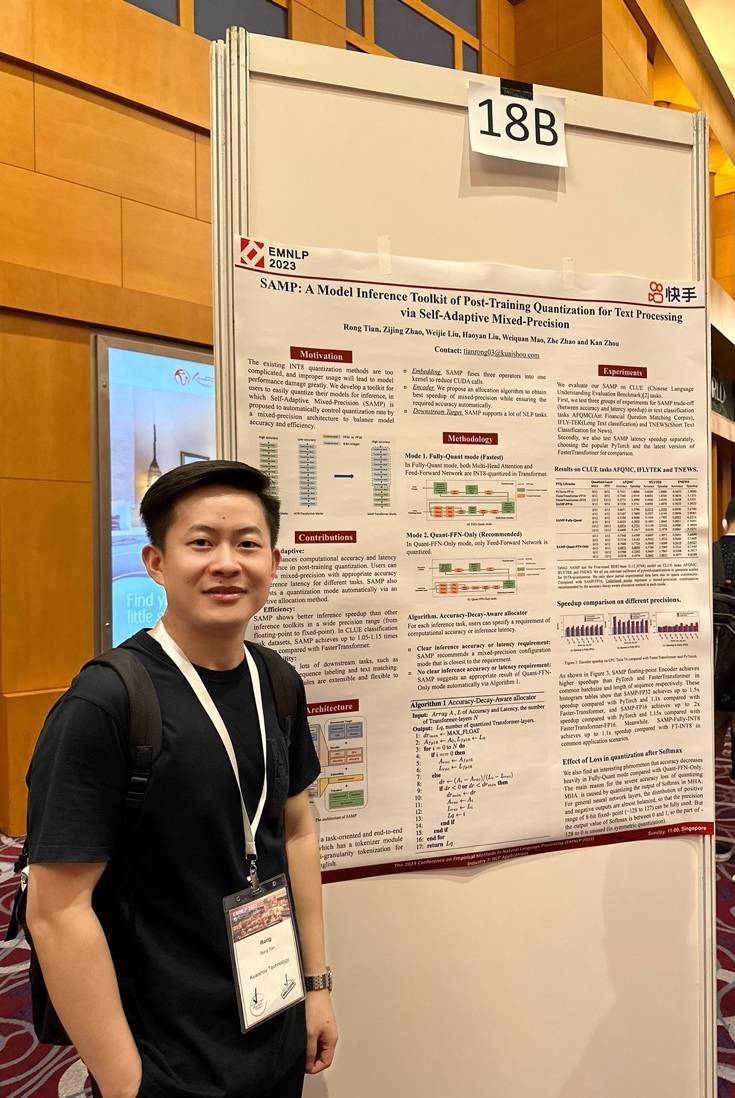

Mit der breiten Anwendung von Deep-Learning-Modellen in Bereichen wie der Verarbeitung natürlicher Sprache sind Geschwindigkeit und Leistung der Modellinferenz zu wichtigen Themen geworden. Kürzlich wurde das von Kuaishou geleitete Forschungsergebnis „SAMP: Post-training Quantitative Model Inference Library Based on Adaptive Mixed Precision“ erfolgreich für die Top-Konferenz EMNLP 2023 ausgewählt und in Singapur präsentiert und geteilt

Diese Studie schlägt ein Inferenzbeschleunigungstool namens SAMP vor, das adaptive Mixed-Precision-Technologie nutzt, um die Inferenzgeschwindigkeit deutlich zu erhöhen und gleichzeitig die Modellleistung aufrechtzuerhalten. Es enthält einen adaptiven Mixed-Precision-Encoder und eine Reihe fortschrittlicher Fusionsstrategien. Der adaptive Mixed-Precision-Encoder kann in einer großen Anzahl von GEMM-Operationen (General Matrix Multiplication) und Transformer-Schichten die beste Gleitkomma- und Festkomma-Mixed-Precision-Kombination finden, sodass die Leistung der Modellinferenz den Benutzeranforderungen (Berechnungen) am nächsten kommt Genauigkeit oder Inferenzeffizienz). Letztendlich erzielen Berechnungen mit gemischter Genauigkeit eine bessere Rechengenauigkeit als vollständige Festkommaberechnungen. Die Fusionsstrategie integriert und verbessert Einbettungsoperatoren und quantisierungsbezogene Berechnungsoperationen und reduziert so die CUDA-Kernelaufrufe um die Hälfte. Gleichzeitig ist SAMP ein End-to-End-Toolkit, das in der Programmiersprache C++ implementiert ist. Es verfügt über eine hervorragende Inferenzgeschwindigkeit und senkt auch die industrielle Anwendungsschwelle der quantitativen Inferenz nach dem Training.

Was neu geschrieben werden muss, ist: der Innovationspunkt von SAMP im Vergleich zu ähnlichen Systemen, wie in Tabelle 1 dargestellt

SAMP hat die folgenden Haupthighlights:

1. Adaptiv. SAMP gleicht Rechengenauigkeit und Latenzleistung in einem quantisierten Inferenzansatz nach dem Training aus. Benutzer können Konfigurationen mit gemischter Genauigkeit und entsprechender Genauigkeit und Inferenzlatenz für verschiedene Aufgaben auswählen. SAMP kann Benutzern durch adaptive Zuordnungsmethoden auch den besten Quantisierungskombinationsmodus empfehlen.

2. Argumentationseffizienz. SAMP zeigt über einen weiten Präzisionsbereich (Gleitkomma bis Festkomma) eine bessere Inferenzbeschleunigung als andere Inferenz-Toolkits. Im Klassifizierungsaufgabendatensatz Chinese Language Understanding Evaluation Benchmark (CLUE) erreichte SAMP im Vergleich zu FasterTransformer eine bis zu 1,05- bis 1,15-fache Beschleunigung.

3. Flexibilität. SAMP deckt zahlreiche nachgelagerte Aufgaben wie Klassifizierung, Sequenzkennzeichnung, Textvergleich usw. ab. Target-Module sind erweiterbar und können flexibel angepasst werden. Es ist benutzerfreundlich und weniger plattformabhängig. SAMP unterstützt C++- und Python-APIs und erfordert nur CUDA 11.0 oder höher. Darüber hinaus bietet SAMP zahlreiche Modellkonvertierungstools, um die gegenseitige Konvertierung zwischen Modellen in verschiedenen Formaten zu unterstützen.

Bild 1: Dieses Forschungspapier wird auf der EMNLP2023-Konferenz vorgestellt und geteilt

Der Hauptforscher Tian Rong aus Kuaishou sagte, dass das Ergebnis der gemeinsamen Bemühungen des gesamten Teams darin bestehe, in Szenarien wie der Modellinferenz gute Ergebnisse zu erzielen. SAMP hat in dreierlei Hinsicht Beiträge geleistet: Erstens löst es das Problem des großen Genauigkeitsverlusts in bestehenden Post-Quantisierungs-(PTQ)-Argumentationstools in industriellen Anwendungen, zweitens fördert es den Einsatz der Post-Quantisierungs-(PTQ)-Technologie in mehreren nachgelagerten Aufgaben von NLP. Gleichzeitig ist die Inferenzbibliothek leichtgewichtig, flexibel, benutzerfreundlich und unterstützt benutzerdefinierte Aufgabenziele

Es wird berichtet, dass EMNLP (Empirical Methods in Natural Language Processing) eine der führenden internationalen Konferenzen im Bereich der Verarbeitung natürlicher Sprache und künstlicher Intelligenz ist. Der Schwerpunkt liegt auf der akademischen Forschung zur Technologie der Verarbeitung natürlicher Sprache in verschiedenen Anwendungsszenarien zur empirischen Forschung zur Verarbeitung natürlicher Sprache. Die Konferenz hat Kerninnovationen im Bereich der Verarbeitung natürlicher Sprache gefördert, wie z. B. Sprachmodelle vor dem Training, Text-Mining, Dialogsysteme und maschinelle Übersetzung. Diese Auswahl hat auch großen Einfluss auf Kuaishous Fortschritt auf diesem Gebiet Die Forschungsergebnisse wurden von internationalen Wissenschaftlern anerkannt.Das obige ist der detaillierte Inhalt vonKuaishous Forschungsergebnis SAMP wurde auf der EMNLP2023 International Artificial Intelligence Conference ausgezeichnet. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1369

1369

52

52

So schließen Sie die passwortfreie Zahlung in Kuaishou. Kuaishou-Tutorial zum Schließen der passwortfreien Zahlung

Mar 23, 2024 pm 09:21 PM

So schließen Sie die passwortfreie Zahlung in Kuaishou. Kuaishou-Tutorial zum Schließen der passwortfreien Zahlung

Mar 23, 2024 pm 09:21 PM

Kuaishou ist ein ausgezeichneter Videoplayer, der uns im täglichen Leben sehr helfen kann, insbesondere beim Kauf der benötigten Waren auf der Plattform . Jetzt müssen wir es abbrechen. Wie können wir die passwortfreie Zahlung effektiv abbrechen? Werfen wir einen Blick auf den gesamten Leitfaden auf dieser Website. Ich hoffe, er kann allen helfen. Anleitung zum Schließen der passwortfreien Zahlung in Kuaishou 1. Öffnen Sie die Kuaishou-App und klicken Sie auf die drei horizontalen Linien in der oberen linken Ecke. 2. Klicken Sie auf Kuaishou Store. 3. Suchen Sie in der Optionsleiste oben nach „Passwortfreie Zahlung“ und klicken Sie darauf. 4. Klicken Sie, um zu unterstützen

Wie man in Kuaishou mit einem kleinen gelben Karren Dinge verkauft - Wie man in Kuaishou Dinge in einem kleinen gelben Karren verkauft

Apr 02, 2024 am 09:34 AM

Wie man in Kuaishou mit einem kleinen gelben Karren Dinge verkauft - Wie man in Kuaishou Dinge in einem kleinen gelben Karren verkauft

Apr 02, 2024 am 09:34 AM

Viele Benutzer haben die Idee, einen kleinen gelben Wagen aufzuhängen, um Dinge zu verkaufen, um Geld zu verdienen, wissen aber nicht, wie man damit umgeht. Im Folgenden stellt der Herausgeber die Anforderungen und spezifischen Verfahren zum Aufhängen eines kleinen Wagens im Detail vor gelber Wagen. Wenn Sie interessiert sind, schauen wir uns das an! Um Dinge in einem Kuaishou-Warenkorb zu verkaufen, müssen Sie zunächst ein Kuaishou-Geschäft eröffnen. 1. Laden Sie das Kuaishou-Login herunter und öffnen Sie es. 2. Klicken Sie auf das „Drei-Streifen“-Symbol in der oberen linken Ecke und dann auf „Mehr“ in der linken Navigationsleiste, die angezeigt wird. 3. Wählen Sie in den weiteren Funktionen „Shop-Bestellung“ und rufen Sie die Kuaishou-Store-Seite auf. 4. Aktivieren Sie „Ich möchte ein Geschäft eröffnen“ und befolgen Sie die Richtlinien zur Authentifizierung mit echtem Namen und Gesichtserkennung. Nach Abschluss können Sie erfolgreich ein Kuaishou-Geschäft eröffnen. 5. Nachdem Sie ein Kuaishou-Geschäft eröffnet haben, müssen Sie ein Zahlungskonto anlegen. Rufen Sie die Seite „Kontozuordnung und -einstellungen“ auf und verknüpfen Sie das Inkassokonto und das Alipay/WeChat-Konto. Hang Xiao Huang

Wie kann der Grund für die Entsperrung in Kuaishou angegeben werden? Wie kann man ein dauerhaft gesperrtes Konto gewaltsam aufheben?

Mar 21, 2024 pm 07:21 PM

Wie kann der Grund für die Entsperrung in Kuaishou angegeben werden? Wie kann man ein dauerhaft gesperrtes Konto gewaltsam aufheben?

Mar 21, 2024 pm 07:21 PM

Als bekannte Kurzvideoplattform in China hat Kuaishou eine große Anzahl von Nutzern. Aus verschiedenen Gründen kann es jedoch manchmal vorkommen, dass einige Benutzer mit einer Kontosperrung konfrontiert werden. Es ist wichtig, Kuaishous Methoden zum Entsperren von Konten zu verstehen und zu verstehen, wie mit dauerhaften Kontosperrungen umgegangen wird. In diesem Artikel werden diese Probleme im Detail untersucht, um Benutzern dabei zu helfen, ihre Konten erfolgreich zu entsperren. 1. Wie kann Kuaishou den Grund für die Entsperrung auf einmal weitergeben? Damit Kuaishous Grund für die Entsperrung genehmigt werden kann, müssen detaillierte Erklärungen und relevante Beweise vorgelegt werden, um den Prüfer davon zu überzeugen, dass der Grund für die Sperrung des Kontos unangemessen ist. Die folgenden Vorschläge können Ihnen helfen: Stellen Sie sicher, dass Sie beim Einreichen Ihres Antrags auf Aufhebung der Sperrung genügend Beweise sammeln, um zu beweisen, dass Ihr Konto zu Unrecht gesperrt wurde. Solche Beweise können Screenshots von gesperrten Konten, kreativen Inhalten und Fan-Interaktionen sein. Die Bereitstellung detaillierter Informationen wird

Was soll ich tun, wenn die Anzahl der Kuaishou-Kommentare die Obergrenze erreicht? Wie viele Kommentare kann es maximal geben?

Mar 23, 2024 pm 02:20 PM

Was soll ich tun, wenn die Anzahl der Kuaishou-Kommentare die Obergrenze erreicht? Wie viele Kommentare kann es maximal geben?

Mar 23, 2024 pm 02:20 PM

Auf Kuaishou können Benutzer gepostete Kurzvideos kommentieren, was eine Möglichkeit der interaktiven Kommunikation darstellt. Gelegentlich kann es vorkommen, dass wir auf ein Problem stoßen, bei dem die Anzahl der Kommentare erreicht wurde und wir nicht weiter kommentieren können. Was sollten Sie also tun, wenn die Anzahl der Kuaishou-Kommentare die Obergrenze erreicht? In diesem Artikel werden die Methoden zum Umgang mit der Obergrenze der Anzahl der Kuaishou-Kommentare sowie die relevanten Vorschriften zur Obergrenze der Anzahl der Kuaishou-Kommentare ausführlich vorgestellt. 1. Was soll ich tun, wenn die Anzahl der Kuaishou-Kommentare die Obergrenze erreicht? Wenn die Anzahl der Kuaishou-Kommentare die Obergrenze erreicht, wird Kuaishou das Kommentarverhalten der Benutzer einschränken, um die Ordnung und eine gesunde Entwicklung der Plattform aufrechtzuerhalten. Benutzer müssen eine gewisse Zeit geduldig warten, bevor sie mit dem Kommentieren fortfahren. Dies soll sicherstellen, dass die Kommunikationsumgebung auf der Plattform weiterhin gut ist. Diese Einschränkung trägt dazu bei, böswillige Kommentare und Spam-Verhalten zu reduzieren und die Benutzererfahrung zu verbessern.

Wie können andere die Aufzeichnungen von Kuaishou-Kommentaren einsehen? Wie lösche ich die Kommentare anderer Personen?

Mar 22, 2024 am 09:40 AM

Wie können andere die Aufzeichnungen von Kuaishou-Kommentaren einsehen? Wie lösche ich die Kommentare anderer Personen?

Mar 22, 2024 am 09:40 AM

Auf der Kuaishou-Plattform ist die Interaktion zwischen Benutzern eine der wichtigsten Möglichkeiten, Freundschaften zu pflegen und Glück zu teilen. Nach dem Kommentieren der Werke anderer Personen möchten einige Benutzer möglicherweise ihre eigenen Kommentaraufzeichnungen überprüfen, um frühere Interaktionsinhalte zu überprüfen und die Interaktion mit anderen zu verstehen. 1. Wie können andere die Aufzeichnungen von Kuaishou-Kommentaren einsehen? 1. Öffnen Sie die Kuaishou-App und melden Sie sich bei Ihrem Konto an. 2. Klicken Sie unten auf der Startseite auf die Schaltfläche „Entdecken“, um die Entdeckungsseite aufzurufen. 3. Geben Sie im Suchfeld auf der Entdeckungsseite den Benutzernamen oder die Schlüsselwörter des Autors des Werks ein, zu dem Sie Kommentare anzeigen möchten, und klicken Sie dann auf die Suchschaltfläche. 4. Suchen Sie auf der Suchergebnisseite die Arbeit des Zielbenutzers und klicken Sie, um die Seite mit den Arbeitsdetails aufzurufen. 5. Suchen Sie auf der Seite mit den Arbeitsdetails den Kommentarbereich und klicken Sie auf Ihren Kommentar-Spitznamen. 6. Geben Sie eine persönliche Bewertung ein

Wie können von Kuaishou veröffentlichte Werke populär werden? Wie kann man mehr Fans auf Kuaishou gewinnen?

Mar 21, 2024 pm 11:50 PM

Wie können von Kuaishou veröffentlichte Werke populär werden? Wie kann man mehr Fans auf Kuaishou gewinnen?

Mar 21, 2024 pm 11:50 PM

Als beliebte Kurzvideoplattform verfügt Kuaishou über eine riesige Nutzerbasis. Viele Nutzer veröffentlichen Werke auf der Kuaishou-Plattform und hoffen, mehr Aufmerksamkeit zu erregen, indem sie ihre Talente zur Schau stellen und ihr tägliches Leben teilen. Wie können also von Kuaishou veröffentlichte Werke populär werden? In diesem Artikel wird dieses Problem behandelt. 1. Wie können von Kuaishou veröffentlichte Werke populär werden? Damit ein Werk populär wird, ist die erste Voraussetzung, dass der Inhalt von hoher Qualität ist. Der Inhalt muss einzigartig, kreativ, ansprechend und interessant sein, um das Interesse des Publikums zu wecken. Darüber hinaus sind auch die Bildqualität und die Bearbeitungsfähigkeiten wichtige Punkte, auf die man achten sollte. Sich über Trendthemen auf dem Laufenden zu halten, ist eine großartige Möglichkeit, die Sichtbarkeit Ihrer Arbeit zu erhöhen. Sie können wählen, ob Sie den aktuellen Themen folgen oder versuchen, aufmerksamkeitsstarke Trendthemen zu erstellen. Heiße Events, beliebte Wörter und Trends

Woher wissen Sie, ob der Empfänger einer Kuaishou-Privatnachricht nicht zurückgelesen wurde? Was ist falsch an der privaten Nachricht, die die andere Partei nicht lesen kann?

Mar 22, 2024 am 11:21 AM

Woher wissen Sie, ob der Empfänger einer Kuaishou-Privatnachricht nicht zurückgelesen wurde? Was ist falsch an der privaten Nachricht, die die andere Partei nicht lesen kann?

Mar 22, 2024 am 11:21 AM

Auf der sozialen Plattform von Kuaishou ist die Interaktion zwischen den Benutzern von entscheidender Bedeutung. Mit der privaten Nachrichtenfunktion können Benutzer bequemer kommunizieren. Manchmal wurden die privaten Nachrichten, die wir an die andere Partei senden, gesehen, aber sie haben nicht geantwortet. Woher wissen wir also, dass der Empfänger einer Kuaishou-Privatnachricht diese nicht lesen konnte? 1. Woher wissen Sie, dass der Empfänger einer Kuaishou-Privatnachricht diese nicht lesen konnte? In Kuaishous privater Nachrichtenfunktion können Benutzer mithilfe der „Lesen“-Funktion erfahren, ob die andere Partei die von ihnen gesendete private Nachricht gelesen hat. Sobald die andere Partei die private Nachricht öffnet und ansieht, wird dem Absender auf der Chat-Oberfläche eine „Gelesen“-Markierung angezeigt. Mit dieser Funktion können Benutzer rechtzeitig erkennen, ob ihre Nachrichten empfangen und gelesen wurden. Wenn die andere Partei sie gelesen, aber nicht geantwortet hat, kann der Benutzer sehen, dass sich der Status der privaten Nachricht in der Chat-Liste ändert

Wie kann ich Kuaishous Erinnerung an private Nachrichten deaktivieren? Wie schließe ich Popup-Nachrichten in privaten Nachrichten?

Mar 27, 2024 pm 09:21 PM

Wie kann ich Kuaishous Erinnerung an private Nachrichten deaktivieren? Wie schließe ich Popup-Nachrichten in privaten Nachrichten?

Mar 27, 2024 pm 09:21 PM

Als Kurzvideoplattform ermöglicht Kuaishou den Nutzern, ihr Leben jederzeit und überall zu teilen. Häufige Erinnerungen an private Nachrichten können unser tägliches Leben unterbrechen. Wie kann man also Kuaishous Erinnerung an private Nachrichten deaktivieren? 1. Wie kann ich Kuaishous Erinnerung an private Nachrichten deaktivieren? Um Kuaishous Erinnerung an private Nachrichten zu deaktivieren, müssen Sie das Einstellungsmenü von Kuaishou aufrufen. Klicken Sie auf der Kuaishou-Homepage auf die Schaltfläche „Mein“ in der unteren rechten Ecke, suchen Sie die Option „Einstellungen“ und klicken Sie zur Eingabe. Suchen Sie nach dem Aufrufen des Einstellungsmenüs nach der Option „Benachrichtigungseinstellungen“ oder „Nachrichteneinstellungen“. Nachdem Sie zur Eingabe geklickt haben, wird die Option „Erinnerung an private Nachrichten“ angezeigt. Klicken Sie, um Erinnerungen an private Nachrichten einzugeben, und schalten Sie dann den Schalter aus, um keine Erinnerungen mehr an private Nachrichten zu erhalten. 2. Wie schließe ich Popup-Nachrichten in privaten Kuaishou-Nachrichten? Wenn Sie nicht nur die Erinnerungen an private Nachrichten deaktivieren möchten, sondern auch die Erinnerungen an private Nachrichten deaktivieren möchten,