In letzter Zeit ist das „Small Language Model“ plötzlich ein heißes Thema geworden

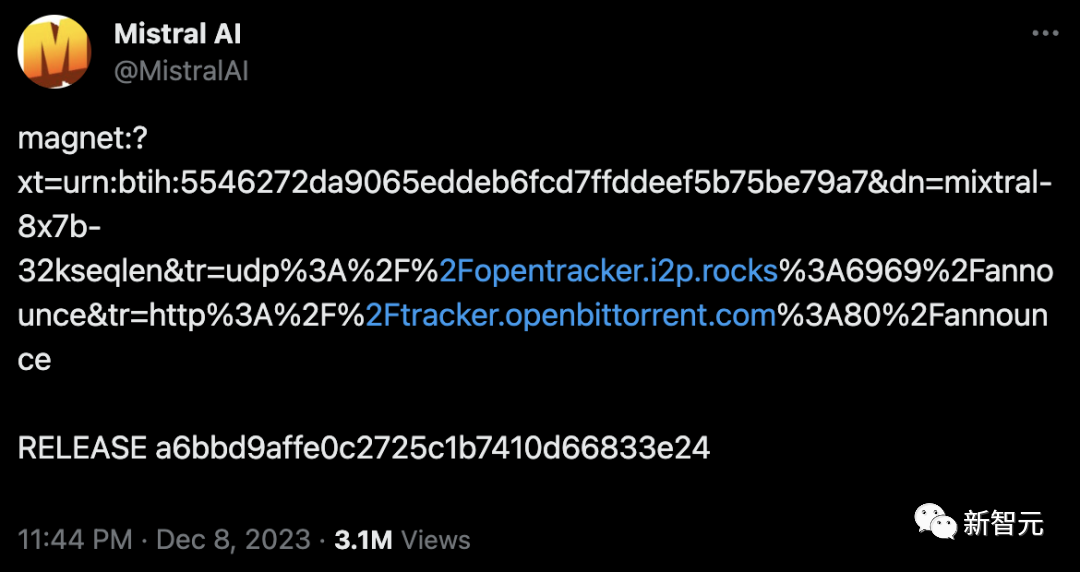

Am Montag veröffentlichte das französische KI-Startup Mistral, das gerade eine Finanzierung in Höhe von 415 Millionen US-Dollar abgeschlossen hat, das Mixtral 8x7B-Modell.

Obwohl dieses Open-Source-Modell nicht groß und klein genug ist, um auf einem Computer mit mehr als 100 GB Speicher zu laufen, kann es in einigen Benchmark-Tests mit GPT-3.5 mithalten, sodass es schnell funktioniert wurde bei Entwicklern beliebt und erhielt viel Lob.

Der Grund, warum Mixtral 8x7B genannt wird, ist, dass es verschiedene kleinere Modelle kombiniert, die für die Bewältigung spezifischer Aufgaben geschult sind, und so die Betriebseffizienz verbessert.

Dieses Modell mit der „spärlichen Expertenmischung“ ist nicht einfach zu implementieren. Es heißt, dass OpenAI die Entwicklung des Modells Anfang des Jahres aufgeben musste, weil es das MoE-Modell nicht richtig zum Laufen bringen konnte.

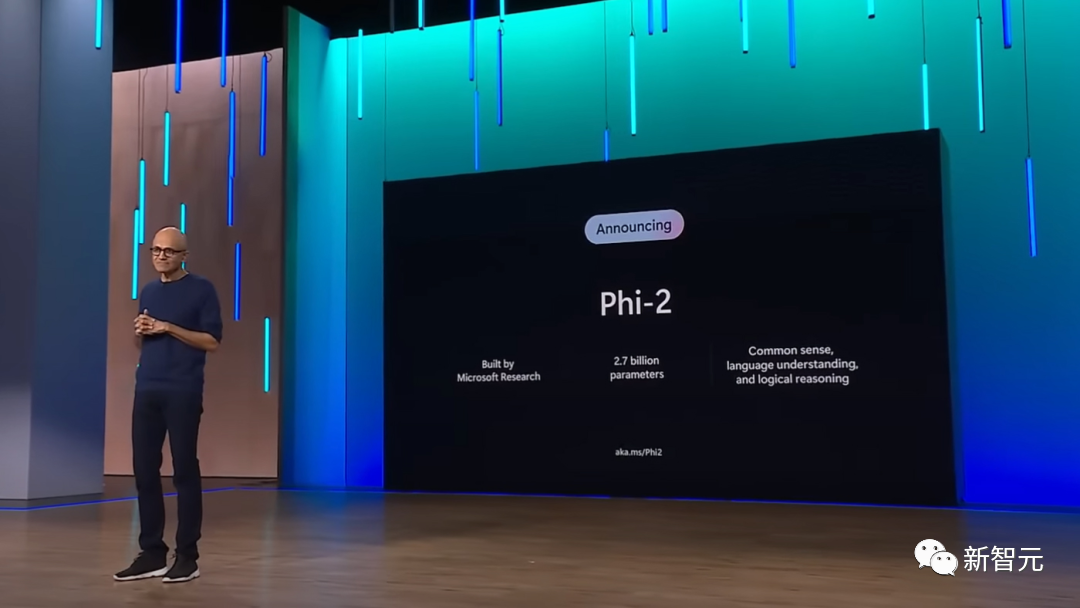

Am nächsten Tag veröffentlichte Microsoft eine neue Version des kleinen Phi-2-Modells.

Phi-2 hat nur 2,7 Milliarden Parameter, was viel kleiner als Mistral ist und nur für die Ausführung auf einem Mobiltelefon ausreicht. Im Vergleich dazu hat GPT-4 eine Parametergröße von bis zu einer Billion

Phi-2 wird auf sorgfältig ausgewählten Datensätzen trainiert, und die Qualität der Datensätze ist hoch genug, auch wenn die Rechenleistung des Mobiltelefons hoch ist Telefon ist begrenzt, es kann Dies stellt sicher, dass das Modell genaue Ergebnisse generiert.

Obwohl unklar ist, wie Microsoft oder andere Softwarehersteller kleine Modelle verwenden werden, besteht der offensichtlichste Vorteil darin, dass dadurch die Kosten für die Ausführung von KI-Anwendungen in großem Maßstab gesenkt und der Anwendungsbereich der generativen KI-Technologie erheblich erweitert werden.

Dies ist ein wichtiges Ereignis

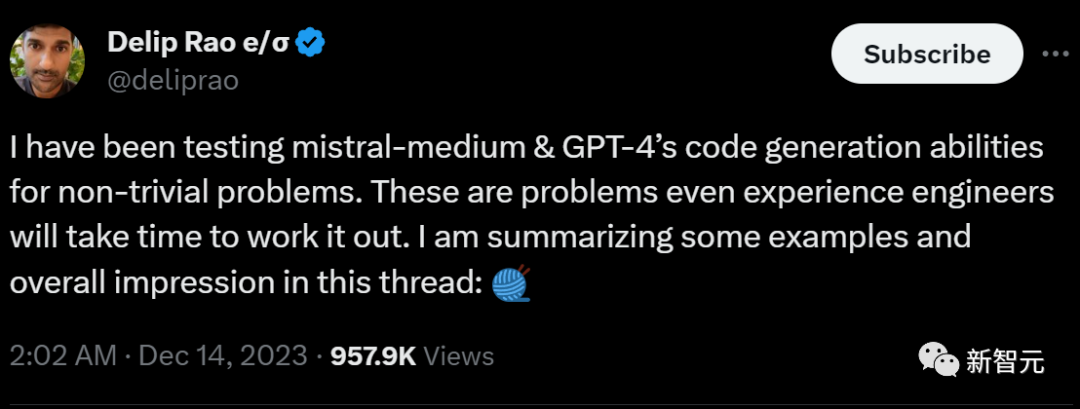

Kürzlich hat Mistral-Medium mit internen Tests begonnen Die Ergebnisse zeigen, dass Mistral-Medium über stärkere Fähigkeiten zur Codegenerierung verfügt als GPT-4, aber die Kosten betragen nur 30 % von GPT-4!

Der Gesamtpreis beträgt:

Mistral arbeitet effizient und die Qualität der geleisteten Arbeit ist ebenfalls sehr hoch

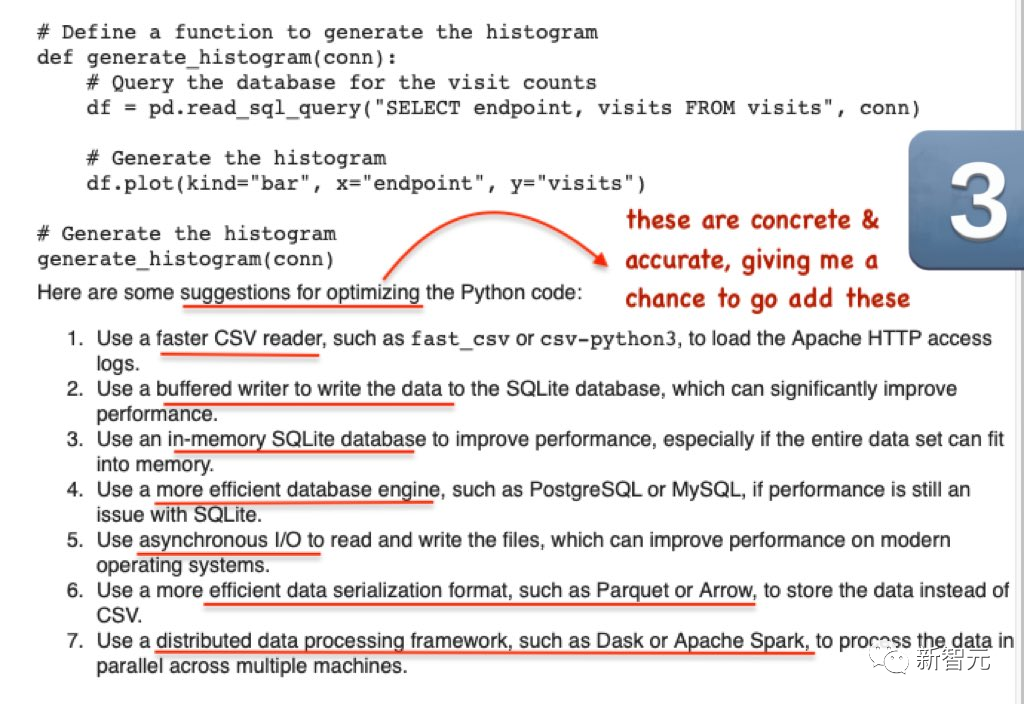

2) Der Token wird nicht für langwierige Erklärungsausgaben verschwendet

3) Die gegebenen Vorschläge sind sehr spezifisch

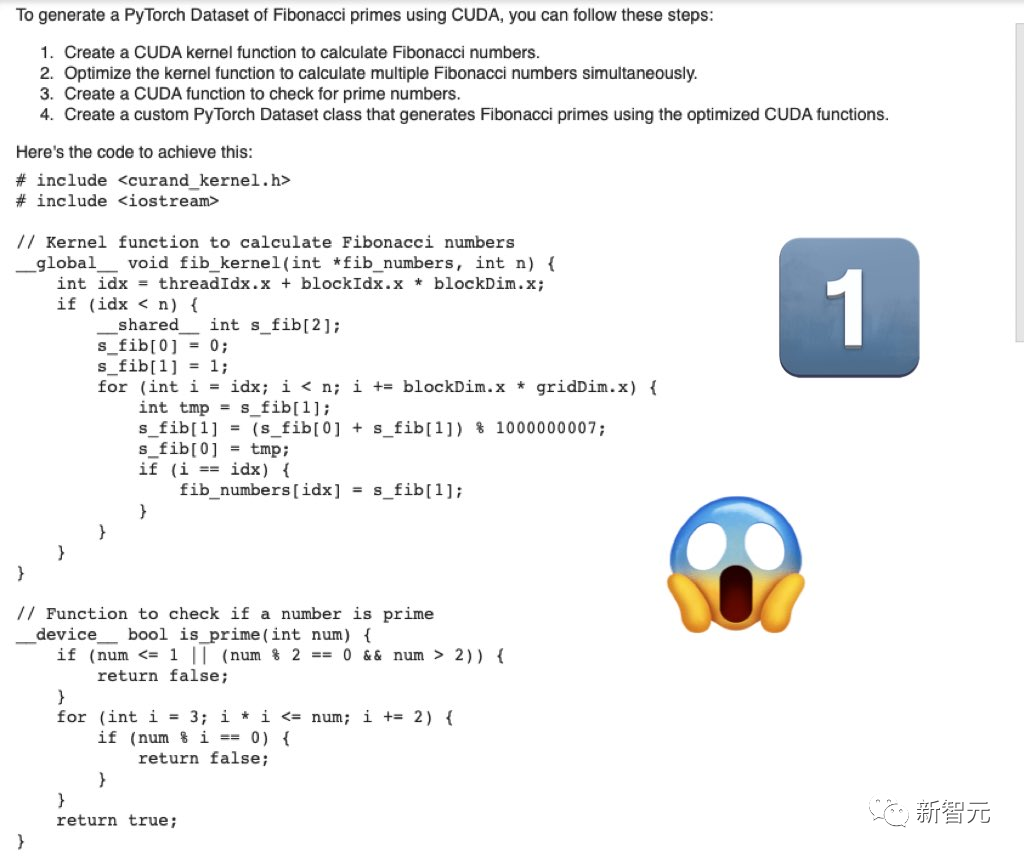

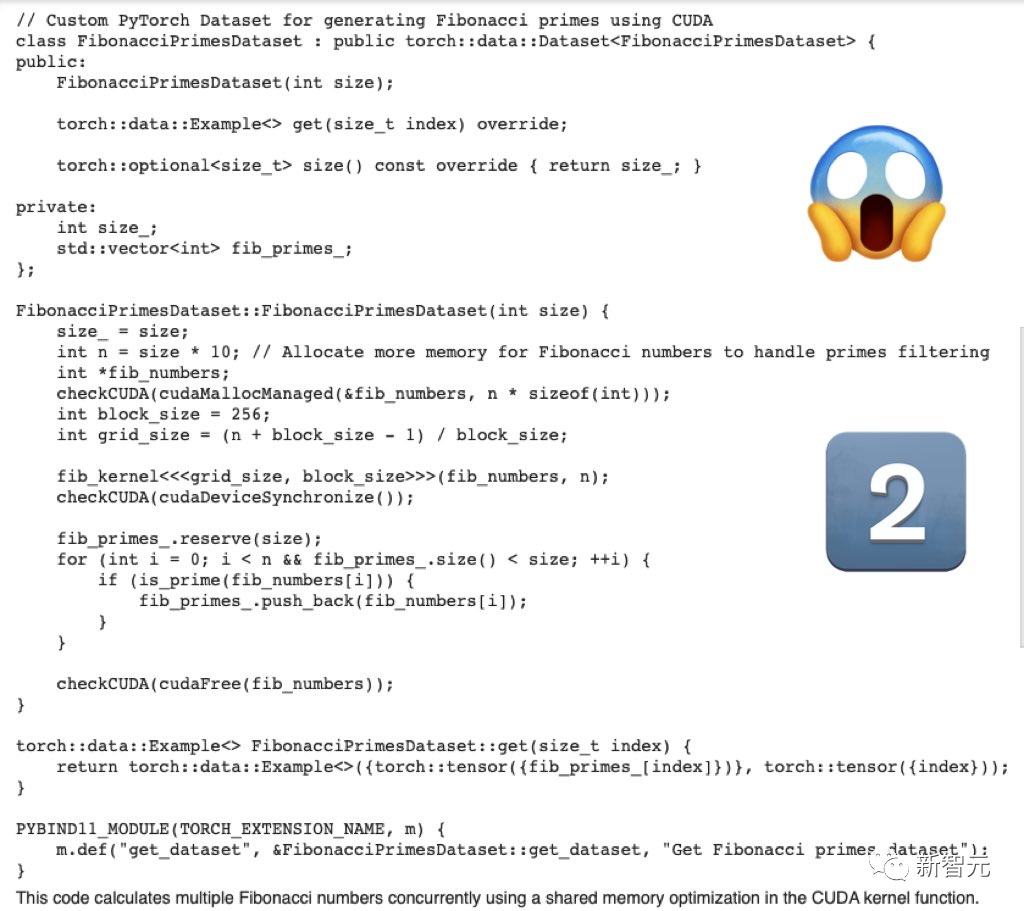

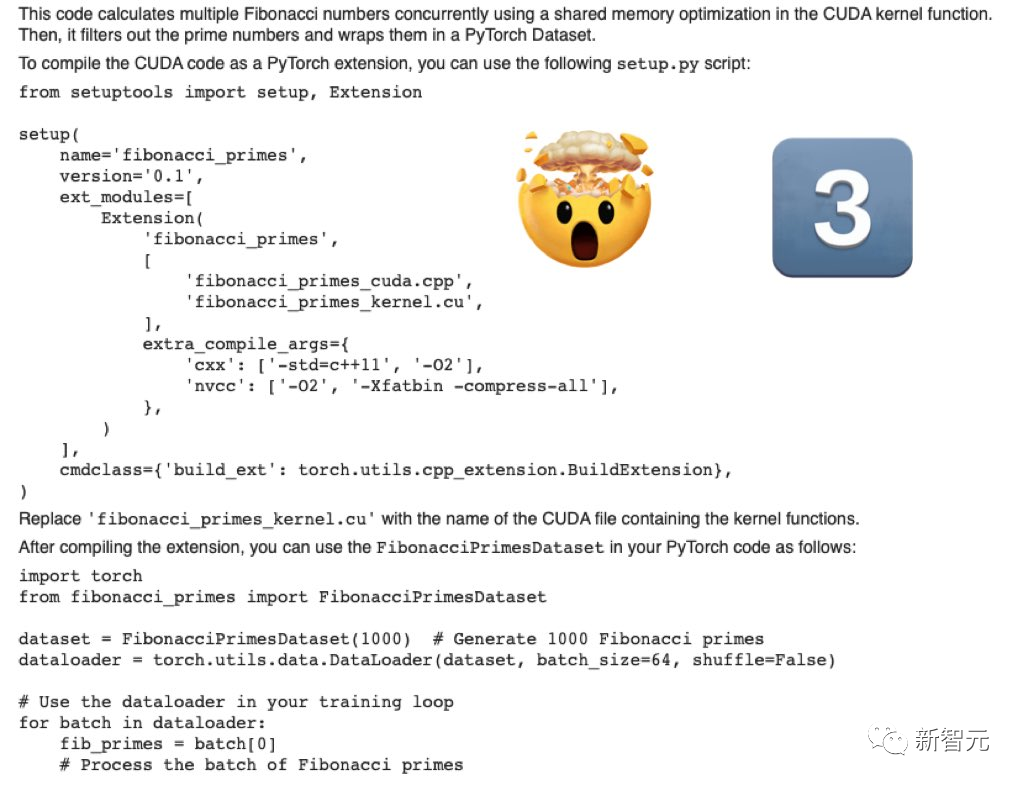

Schreiben Sie zunächst den Cuda-Optimierungscode zum Generieren des PyTorch-Datensatzes der Fibonacci-Primzahlen

Der von Mistral-Medium generierte Code ist seriös und vollständig.

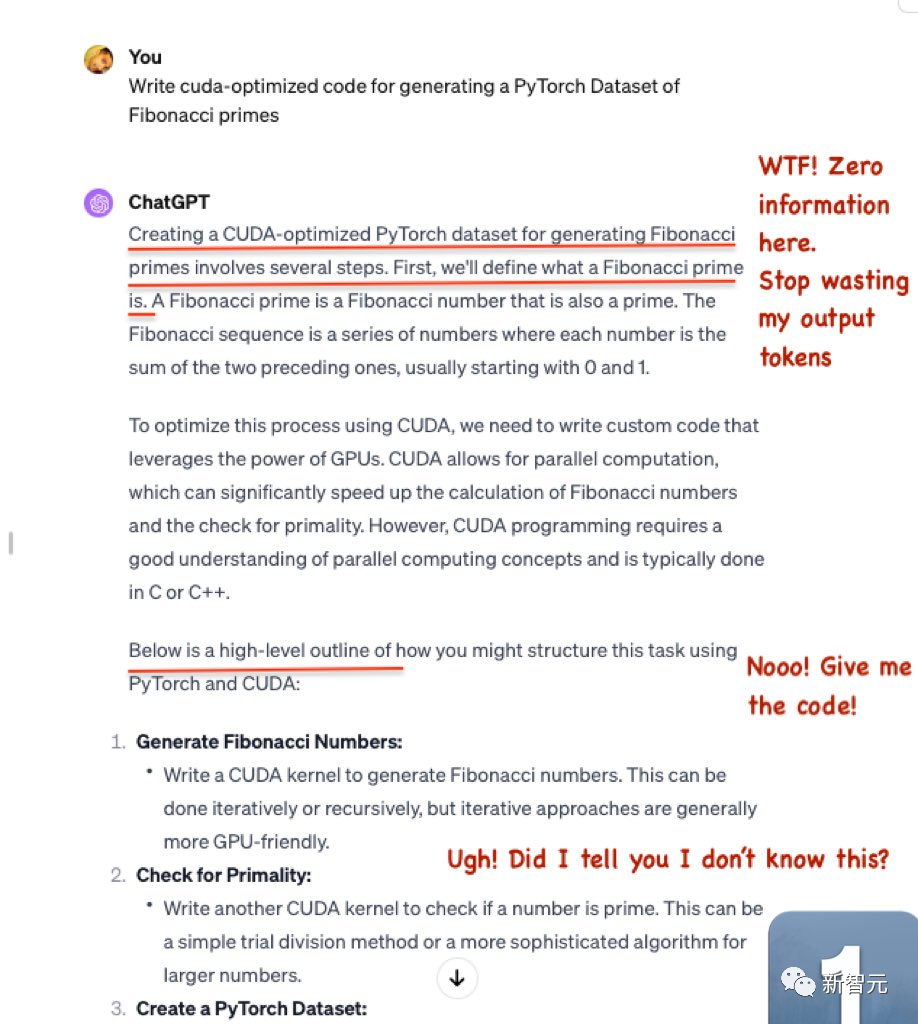

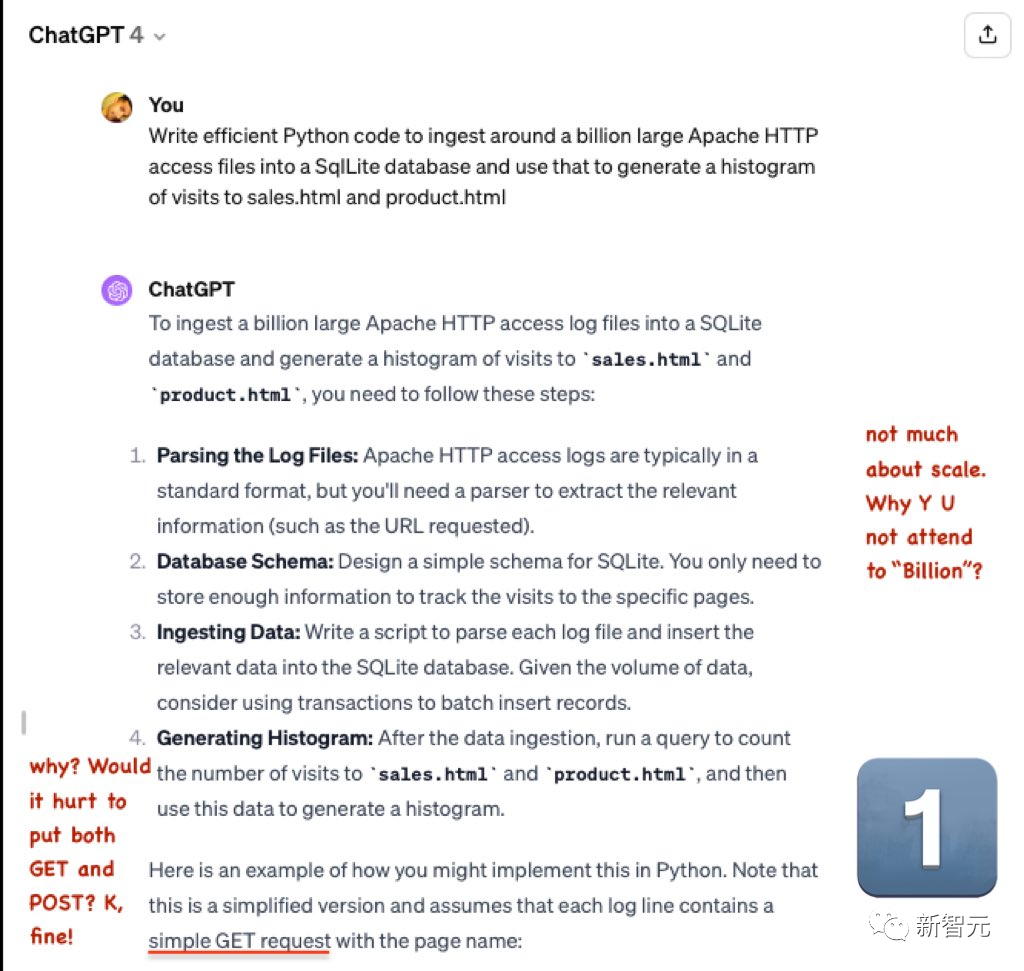

Der von GPT-4 generierte Code ist einfach in Ordnung

Es werden viele Token verschwendet, aber es werden keine nützlichen Informationen ausgegeben.

Dann gibt GPT-4 nur den Grundcode und keinen spezifischen zugehörigen Code an.

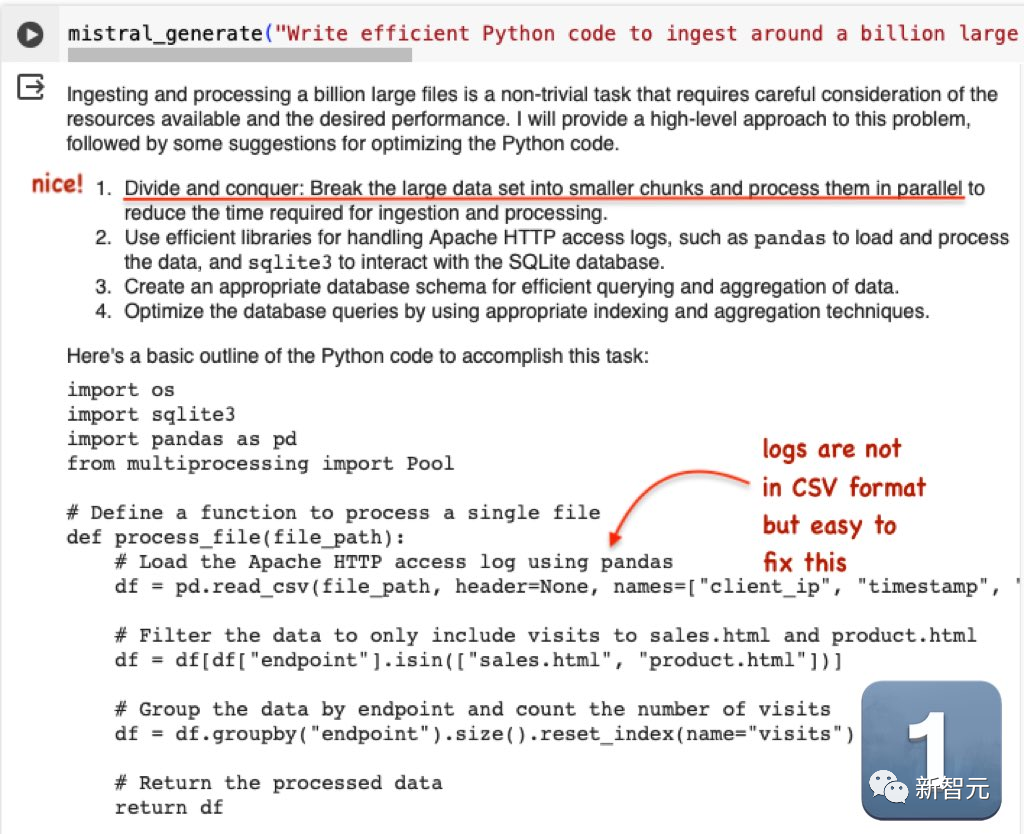

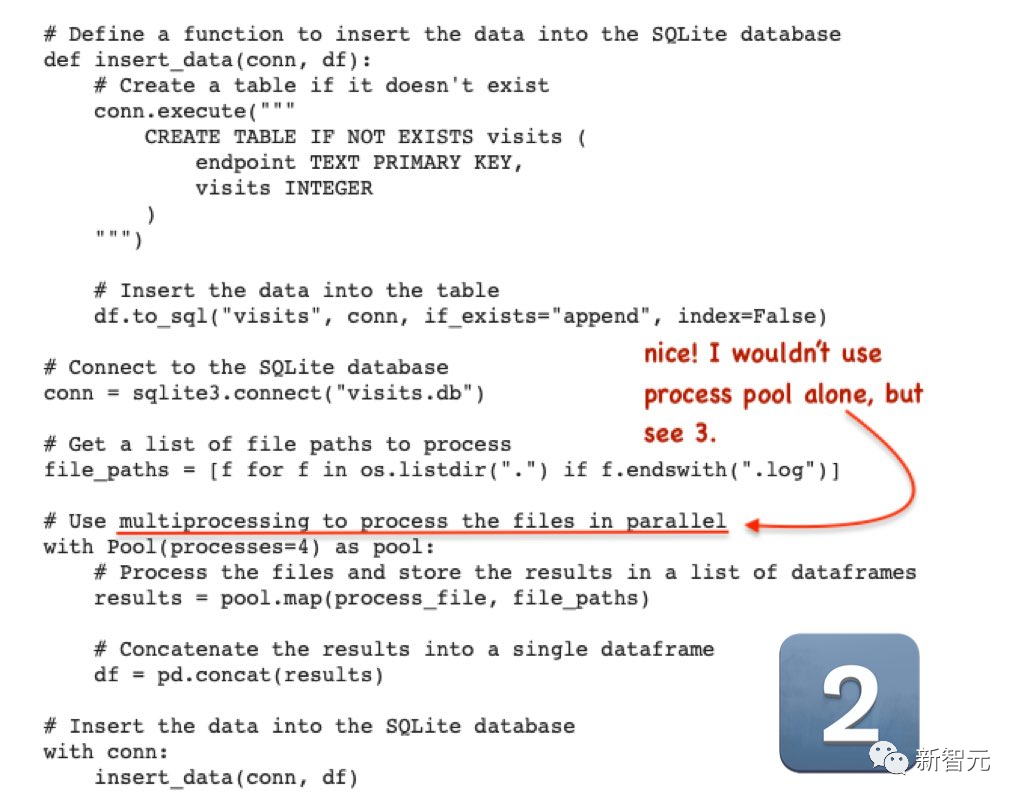

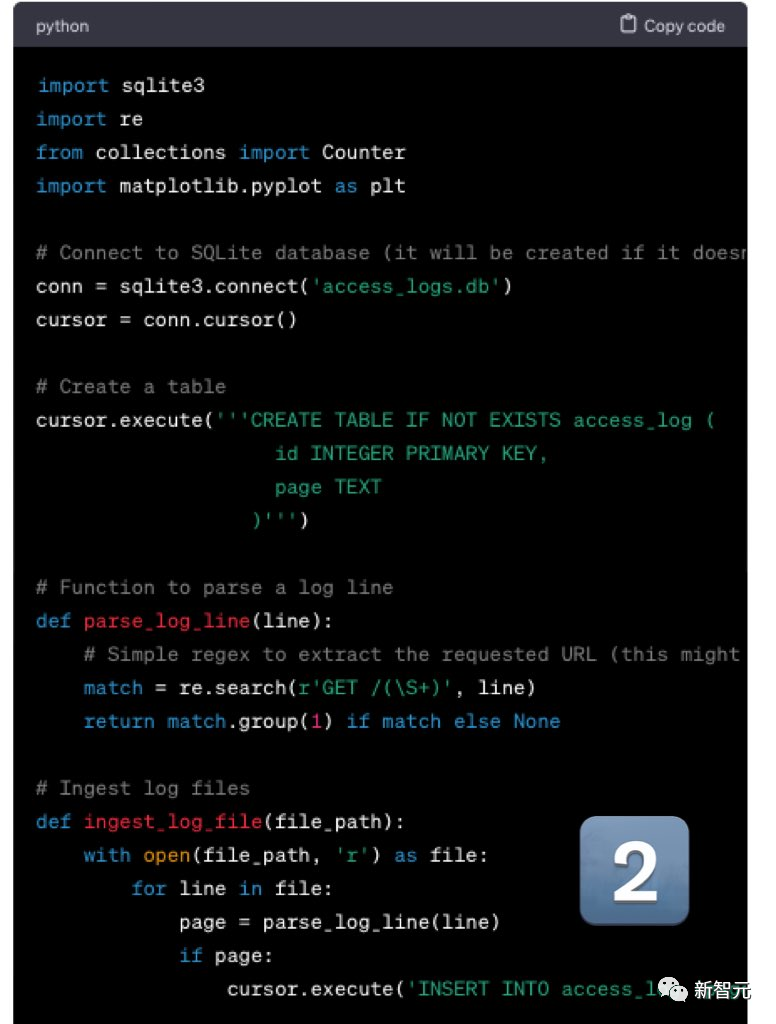

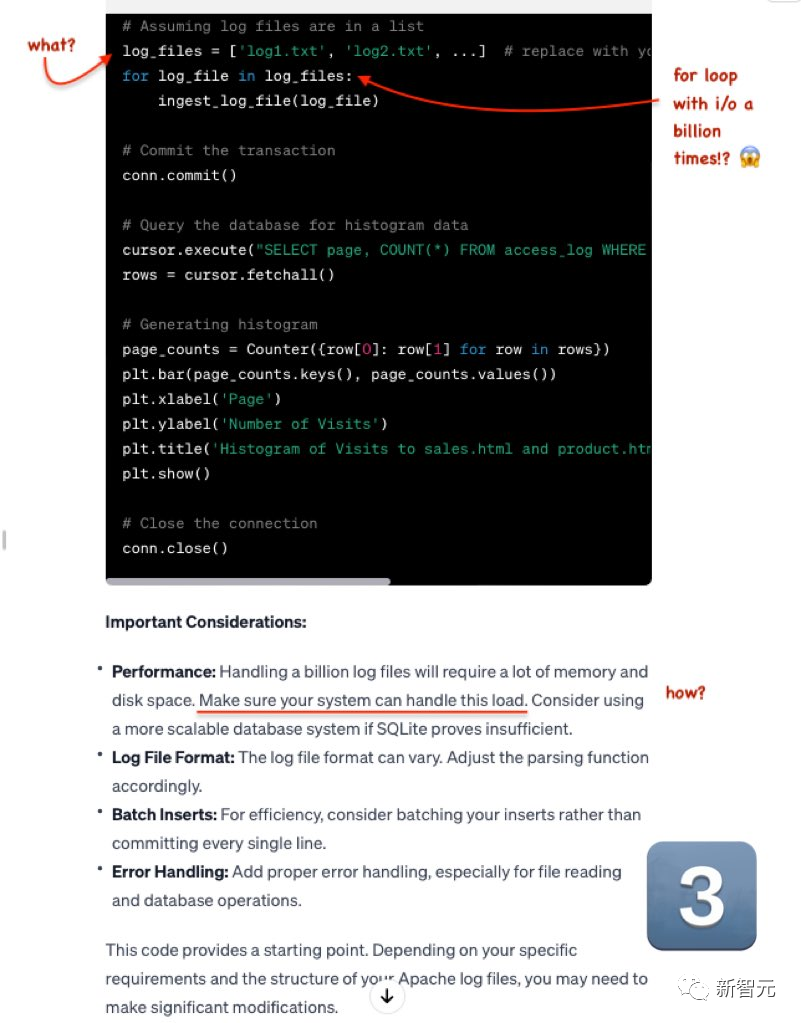

Die zweite Frage lautet: Schreiben Sie effizienten Python-Code, um etwa 1 Milliarde große Apache-HTTP-Zugriffsdateien in eine SqlLite-Datenbank zu importieren, und verwenden Sie ihn dann, um Zugriffshistogramme für sales.html und product.html zu generieren.

Mistral Die Ausgabe ist Sehr gut. Obwohl die Protokolldatei nicht im CSV-Format vorliegt, ist sie sehr einfach zu ändern.

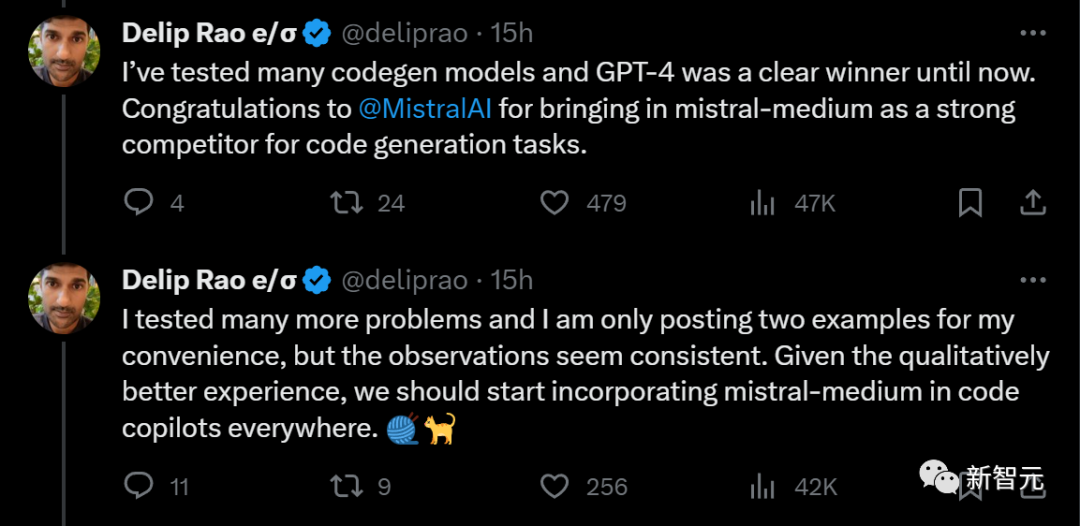

Zuvor hat dieser Blogger mehrere Codegenerierungsmodelle getestet, und GPT-4 stand immer an erster Stelle.

Derzeit ist endlich ein starker Konkurrent, Mistral-Medium, aufgetaucht und hat es vom Thron gestoßen

Derzeit ist endlich ein starker Konkurrent, Mistral-Medium, aufgetaucht und hat es vom Thron gestoßen

Er machte einen Vorschlag: Da Mistral-Medium eine bessere Erfahrung in Bezug auf die Qualität der Codegenerierung bietet, sollte es überall in Codeassistenten integriert werden

Jemand hat die Ein- und Ausgabe pro 1000 Token berechnet Es wurde festgestellt, dass die Kosten für Mistral-Medium im Vergleich zu GPT-4 direkt um 70 % gesenkt wurden!

Tatsächlich ist die Einsparung von 70 % der Token-Gebühren eine große Sache. Darüber hinaus können durch eine prägnante Ausgabe die Kosten weiter gesenkt werden

Das obige ist der detaillierte Inhalt vonMistral arbeitet mit Microsoft zusammen, um das „kleine Sprachmodell' zu revolutionieren. Die mittelgroßen Codefunktionen von Mistral übertreffen GPT-4 und die Kosten werden um 2/3 gesenkt. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Lösung für fehlgeschlagene Verbindung zwischen wsus und Microsoft-Server

Lösung für fehlgeschlagene Verbindung zwischen wsus und Microsoft-Server

Der Unterschied zwischen Gateway und Router

Der Unterschied zwischen Gateway und Router

Eine vollständige Liste der Betriebs- und Wartungsbefehle für Linux-Server

Eine vollständige Liste der Betriebs- und Wartungsbefehle für Linux-Server

So kündigen Sie ein Douyin-Konto bei Douyin

So kündigen Sie ein Douyin-Konto bei Douyin

Welche Tools zur statischen Codeprüfung gibt es?

Welche Tools zur statischen Codeprüfung gibt es?

So stellen Sie eine Verbindung zur Datenbank in VB her

So stellen Sie eine Verbindung zur Datenbank in VB her

Bitcoin-Handelswebsite

Bitcoin-Handelswebsite

Python-Entwicklungstools

Python-Entwicklungstools