Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Tencent Cloud veröffentlicht den neuen Hochleistungsanwendungsdienst HAI und behauptet, in 10 Minuten maßgeschneiderte KI-Anwendungen entwickeln zu können

Tencent Cloud veröffentlicht den neuen Hochleistungsanwendungsdienst HAI und behauptet, in 10 Minuten maßgeschneiderte KI-Anwendungen entwickeln zu können

Tencent Cloud veröffentlicht den neuen Hochleistungsanwendungsdienst HAI und behauptet, in 10 Minuten maßgeschneiderte KI-Anwendungen entwickeln zu können

Der offizielle Account von Tencent Cloud hat kürzlich die Einführung des Hochleistungsanwendungsdienstes „HAI“ (Hyper Application Inventor) angekündigt. Berichten zufolge können Benutzer über diesen Dienst ganz einfach ihre eigenen KI-Anwendungen entwickeln, die GPU-Rechenleistung sofort nutzen und mit einem Klick bereitstellen, und die Entwicklungszeit beträgt nur 10 Minuten

In der offiziellen Einführung heißt es, dass mit „HAI“ automatisch eine kostengünstigere GPU-Rechenleistung konfiguriert und die für die „Ein-Klick-Bereitstellung“ erforderliche Abhängigkeitsumgebung unterstützt werden kann. Benutzer können die Konfiguration abschließen, indem sie das Modell, die Region, den Rechenleistungstyp und die Festplattengröße auswählen

Darüber hinaus ist „HAI“ auch mit einer Vielzahl beliebter Modelle wie Stable Diffusion und ChatGLM vorinstalliert. Benutzer können in wenigen Minuten ihre eigenen großen Sprachmodelle, KI-Gemälde und andere Anwendungsumgebungen erstellen. Sollten die vorinstallierten Modelle nicht ausreichen, können Nutzer auch die „HAI“-Plattform nutzen, um eigene Open-Source-Modelle bereitzustellen

„HAI“ bietet eine visuelle interaktive Schnittstelle, unterstützt verschiedene Verbindungsmethoden zur Rechenleistung wie JupyterLab und WebUI und bezeichnet sich selbst als grafische Schnittstelle, die mit den Händen entwickelt werden kann. Gleichzeitig unterstützt „HAI“ die akademische Beschleunigung und kann den Zugriff und die Download-Geschwindigkeit auf gängigen akademischen Ressourcenplattformen erheblich verbessern, indem automatisch die beste Leitung ausgewählt wird

Laut früheren Berichten von IT House gab Tang Daosheng, Senior Executive Vice President der Tencent Group und CEO der Cloud and Smart Industry Group, während des Industry Large Model and Intelligent Application Technology Summit im Juni dieses Jahres bekannt, dass Tencent Cloud MaaS dies tun wird Richten Sie einen One-Stop-Shop für die Auswahl von Branchenmodellen ein

Tencent Cloud gab an, dass sie Tencent HCC-Hochleistungs-Computing-Cluster und Großmodellfunktionen nutzen können, um mehr als 50 Großmodell-Branchenlösungen für zehn große Branchen bereitzustellen, darunter Kulturtourismus, Regierungsangelegenheiten, Finanzen, Medien und Bildung. Benutzer müssen lediglich ihre eigenen Szenendaten zum Modellspeicher hinzufügen, um schnell exklusive Modelle zu generieren

Das obige ist der detaillierte Inhalt vonTencent Cloud veröffentlicht den neuen Hochleistungsanwendungsdienst HAI und behauptet, in 10 Minuten maßgeschneiderte KI-Anwendungen entwickeln zu können. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

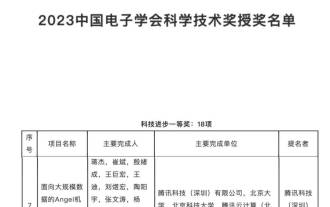

Anerkennung durch den ersten Preis des Science and Technology Progress Award: Tencent hat das Problem gelöst, große Modelle mit Billionen von Parametern zu trainieren

Mar 27, 2024 pm 09:41 PM

Anerkennung durch den ersten Preis des Science and Technology Progress Award: Tencent hat das Problem gelöst, große Modelle mit Billionen von Parametern zu trainieren

Mar 27, 2024 pm 09:41 PM

Die Liste der Gewinner der Science and Technology Awards 2023 der China Electronics Society wurde bekannt gegeben. Dieses Mal haben wir eine bekannte Figur entdeckt – die Angel-Plattform für maschinelles Lernen von Tencent. Im gegenwärtigen Zeitalter der rasanten Entwicklung großer Modelle wird der Science and Technology Award an Forschungs- und Anwendungsprojekte zu Plattformen für maschinelles Lernen verliehen, was den Wert und die Bedeutung von Modelltrainingsplattformen voll und ganz unterstreicht. Der Wissenschafts- und Technologiepreis würdigt die Forschung und Anwendung von Plattformprojekten für maschinelles Lernen und würdigt den Wert und die Bedeutung von Modelltrainingsplattformen, insbesondere im Zusammenhang mit der schnellen Entwicklung groß angelegter Modelle. Mit dem Aufstieg des Deep Learning haben große Unternehmen begonnen, die Bedeutung maschineller Lernplattformen für die Entwicklung der Technologie der künstlichen Intelligenz zu erkennen. Google, Microsoft, Nvidia und andere Unternehmen haben zur Beschleunigung ihre eigenen Plattformen für maschinelles Lernen eingeführt

Das große Tencent Hunyuan-Modell wurde im Preis vollständig reduziert! Hunyuan-lite ist ab sofort kostenlos

Jun 02, 2024 pm 08:07 PM

Das große Tencent Hunyuan-Modell wurde im Preis vollständig reduziert! Hunyuan-lite ist ab sofort kostenlos

Jun 02, 2024 pm 08:07 PM

Am 22. Mai kündigte Tencent Cloud einen neuen großen Modell-Upgrade-Plan an. Bei einem der Hauptmodelle, dem Hunyuan-Lite-Modell, ist geplant, die gesamte API-Eingabe- und Ausgabelänge von derzeit 4.000 auf 256.000 zu erhöhen und den Preis von 0,008 Yuan/tausend Token auf völlig kostenlos anzupassen. Der API-Eingabepreis nach Hunyuan-Standard sank von 0,01 Yuan/Tausend Token auf 0,0045 Yuan/Tausend Token, was einem Rückgang von 55 % entspricht, und der API-Ausgabepreis sank von 0,01 Yuan/Tausend Token auf 0,005 Yuan/Tausend Token, was einem Rückgang um 50 % entspricht %. Der neu eingeführte Hunyuan-Standard-256k ist in der Lage, ultralange Texte mit mehr als 380.000 Zeichen zu verarbeiten, und der API-Eingabepreis wurde auf 0,015 Yuan/Tausend Toke gesenkt.

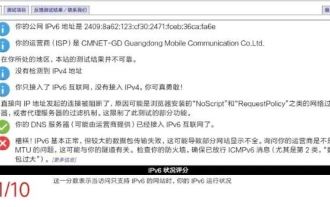

Sollte ich IPv6 auf meinem Heimrouter aktivieren? „Muss gesehen werden: Vorteile der Aktivierung von IPV6 auf Ihrem Heimrouter'

Feb 07, 2024 am 09:03 AM

Sollte ich IPv6 auf meinem Heimrouter aktivieren? „Muss gesehen werden: Vorteile der Aktivierung von IPV6 auf Ihrem Heimrouter'

Feb 07, 2024 am 09:03 AM

IPv4 ist erschöpft und IPv6 wird dringend benötigt, aber ist dieses Upgrade nur eine passive Änderung? Was bedeutet IPv6 für die breite Öffentlichkeit? Wie viel Veränderung kann das umfassende Upgrade von IPv6 in unserem Netzwerk bringen? 01 Die groß angelegte IPv6-Transformation steht kurz vor der Umsetzung. Vor kurzem haben das Generalbüro des Ministeriums für Industrie und Informationstechnologie und das Generalbüro der staatlichen Verwaltung für Radio und Fernsehen eine Bekanntmachung herausgegeben, in der Anforderungen zur Förderung der IPv6-Transformation des Internet-TV vorgeschlagen werden Dienstleistungen. China Mobile, Alibaba Cloud, Tencent Cloud, Baidu Cloud, JD Cloud, Huawei Cloud und Wangsu Technology müssen eine IPv6-Transformation des Content Distribution Network (CDN) im Zusammenhang mit dem Internet-TV-Geschäft durchführen. Bis Ende 2020 werden die auf dem IPv6-Protokoll basierenden Internet-TV-Dienstfunktionen 85 % von IPv4 erreichen

Wie erstelle ich einen WeChat-Link? Teilen Sie, wie Sie WeChat-Links erstellen

Mar 09, 2024 pm 09:37 PM

Wie erstelle ich einen WeChat-Link? Teilen Sie, wie Sie WeChat-Links erstellen

Mar 09, 2024 pm 09:37 PM

WeChat bietet als beliebte soziale Software nicht nur den Komfort von Instant Messaging, sondern integriert auch eine Vielzahl von Funktionen, um das soziale Erlebnis der Benutzer zu bereichern. Unter anderem ist das Erstellen und Teilen von WeChat-Links ein wichtiger Bestandteil der WeChat-Funktionen. Die Erstellung von WeChat-Links stützt sich hauptsächlich auf die öffentliche WeChat-Plattform und die damit verbundenen Funktionen sowie auf Tools von Drittanbietern. Im Folgenden sind einige gängige Methoden zum Erstellen von WeChat-Links aufgeführt. Wie erstelle ich einen WeChat-Link? Die erste Methode zum Erstellen von WeChat-Links besteht darin, den Bild- und Texteditor der öffentlichen WeChat-Plattform zu verwenden. 1. Melden Sie sich bei der öffentlichen WeChat-Plattform an und rufen Sie die Bild- und Textbearbeitungsoberfläche auf. 2. Fügen Sie im Editor Text oder Bilder hinzu und fügen Sie dann über die Link-Schaltfläche den erforderlichen Link hinzu. Diese Methode eignet sich für einfache Text- oder Bildlinks. Die zweite Methode ist die Verwendung von HTML-Code

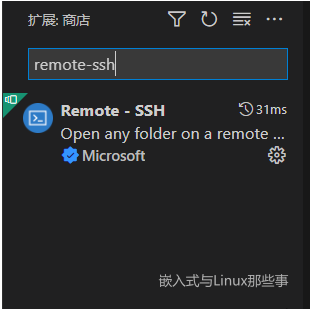

Verwenden Sie vscode, um den Linux-Kernel remote zu debuggen

Feb 05, 2024 pm 12:30 PM

Verwenden Sie vscode, um den Linux-Kernel remote zu debuggen

Feb 05, 2024 pm 12:30 PM

Vorwort Im vorherigen Artikel wurde die Verwendung von QEMU+GDB zum Debuggen des Linux-Kernels vorgestellt. Manchmal ist es jedoch nicht sehr praktisch, GDB direkt zum Debuggen und Anzeigen des Codes zu verwenden. Wie kann es daher sein, dass bei einem so wichtigen Anlass das vscode-Artefakt fehlt? In diesem Artikel wird erläutert, wie Sie vscode zum Remote-Debuggen des Kernels verwenden. Umgebung für diesen Artikel: Windows 10 vs. Code Ubuntu 20.04 Ich persönlich verwende Tencent Cloud Server, daher spare ich mir den Prozess der Installation einer virtuellen Maschine. Beginnen Sie direkt mit der vscode-Konfiguration. Installieren Sie das vscode-Plug-in remote-ssh. Suchen Sie das Remote-SSH-Plug-in in der Plug-in-Bibliothek und installieren Sie es. Nach Abschluss der Installation gibt es in der rechten Symbolleiste eine zusätzliche Funktion. Drücken Sie F1, um das Paar aufzurufen.

PHP und WebSocket: Erstellen leistungsstarker Echtzeitanwendungen

Dec 17, 2023 pm 12:58 PM

PHP und WebSocket: Erstellen leistungsstarker Echtzeitanwendungen

Dec 17, 2023 pm 12:58 PM

PHP und WebSocket: Erstellen leistungsstarker Echtzeitanwendungen Mit der Weiterentwicklung des Internets und steigenden Benutzeranforderungen werden Echtzeitanwendungen immer häufiger eingesetzt. Das herkömmliche HTTP-Protokoll weist einige Einschränkungen bei der Verarbeitung von Echtzeitdaten auf, z. B. die Notwendigkeit häufiger oder langer Abfragen, um die neuesten Daten zu erhalten. Um dieses Problem zu lösen, wurde WebSocket ins Leben gerufen. WebSocket ist ein fortschrittliches Kommunikationsprotokoll, das bidirektionale Kommunikationsfunktionen bietet und das Senden und Empfangen in Echtzeit zwischen dem Browser und dem Server ermöglicht.

Der GPT Store kann es nicht einmal wagen, diesen Weg einzuschlagen. ?

Apr 19, 2024 pm 09:30 PM

Der GPT Store kann es nicht einmal wagen, diesen Weg einzuschlagen. ?

Apr 19, 2024 pm 09:30 PM

Achtung, dieser Mann hat mehr als 1.000 große Modelle angeschlossen, sodass Sie problemlos anschließen und wechseln können. Kürzlich wurde ein visueller KI-Workflow eingeführt: Er bietet Ihnen eine intuitive Drag-and-Drop-Oberfläche, mit der Sie Ihren eigenen Workflow per Drag-and-Drop auf einer unendlichen Leinwand anordnen können. Wie das Sprichwort sagt: Krieg kostet Geschwindigkeit, und Qubit hörte, dass Benutzer innerhalb von 48 Stunden nach der Online-Schaltung dieses AIWorkflows bereits persönliche Workflows mit mehr als 100 Knoten konfiguriert hatten. Ohne weitere Umschweife möchte ich heute über Dify, ein LLMOps-Unternehmen, und seinen CEO Zhang Luyu sprechen. Zhang Luyu ist auch der Gründer von Dify. Bevor er in das Unternehmen eintrat, verfügte er über 11 Jahre Erfahrung in der Internetbranche. Ich beschäftige mich mit Produktdesign, verstehe Projektmanagement und habe einige einzigartige Einblicke in SaaS. Später er

Tencent Hunyuan aktualisiert die Modellmatrix und führt ein 256.000 langes Artikelmodell in der Cloud ein

Jun 01, 2024 pm 01:46 PM

Tencent Hunyuan aktualisiert die Modellmatrix und führt ein 256.000 langes Artikelmodell in der Cloud ein

Jun 01, 2024 pm 01:46 PM

Die Implementierung großer Modelle beschleunigt sich und die „industrielle Praktikabilität“ ist zu einem Entwicklungskonsens geworden. Am 17. Mai 2024 fand in Peking der Tencent Cloud Generative AI Industry Application Summit statt, bei dem eine Reihe von Fortschritten bei der Entwicklung großer Modelle und Anwendungsprodukten angekündigt wurden. Die Hunyuan-Großmodellfunktionen von Tencent werden weiterhin über Tencent Cloud für die Außenwelt geöffnet, um die Modellanforderungen von Unternehmenskunden und Entwicklern in verschiedenen Szenarien zu erfüllen und umzusetzen die optimale kostengünstige Modelllösung. Tencent Cloud veröffentlicht drei Haupttools: Wissens-Engine für große Modelle, Bilderstellungs-Engine und Video-Erstellungs-Engine. Damit wird eine native Toolkette für das Zeitalter großer Modelle erstellt und der Datenzugriff, die Feinabstimmung von Modellen und Anwendungsentwicklungsprozesse durch PaaS-Dienste vereinfacht Unternehmen zu helfen