Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Die OpenAI-Richtlinien ermöglichen es Vorständen, CEOs von der Veröffentlichung neuer Modelle abzuhalten, um sich vor KI-Risiken zu schützen

Die OpenAI-Richtlinien ermöglichen es Vorständen, CEOs von der Veröffentlichung neuer Modelle abzuhalten, um sich vor KI-Risiken zu schützen

Die OpenAI-Richtlinien ermöglichen es Vorständen, CEOs von der Veröffentlichung neuer Modelle abzuhalten, um sich vor KI-Risiken zu schützen

Um die enormen Risiken zu vermeiden, die künstliche Intelligenz (KI) mit sich bringen kann, hat OpenAI beschlossen, dem Vorstand mehr Befugnisse zur Überwachung von Sicherheitsfragen zu geben und eine strenge Aufsicht über CEO Sam Altman durchzuführen, der letzten Monat gerade einen internen Kampf gewonnen hat

OpenAI hat am Montag, 18. Dezember EST, eine Reihe von Richtlinien veröffentlicht, die darauf abzielen, katastrophale Risiken zu verfolgen, zu bewerten, vorherzusagen und zu verhindern, die von immer leistungsfähigeren Modellen der künstlichen Intelligenz (KI) ausgehen. OpenAI definiert „katastrophales Risiko“ als jedes Risiko, das zu wirtschaftlichen Verlusten in Höhe von Hunderten von Milliarden Dollar oder zu schweren Verletzungen oder zum Tod mehrerer Menschen führen könnte

Der 27-seitige Leitfaden, bekannt als „Readiness Framework“, besagt, dass selbst wenn das Top-Management eines Unternehmens, einschließlich des CEO oder einer von der Führung benannten Person, davon ausgeht, dass ein zu veröffentlichendes KI-Modell sicher ist, der Vorstand des Unternehmens immer noch hat die Befugnis, die Veröffentlichung dieses Modells zu verschieben. Das bedeutet, dass der CEO von OpenAI zwar für die täglichen Entscheidungen verantwortlich ist, der Vorstand sich jedoch der Risikoergebnisse bewusst ist und die Macht hat, ein Veto gegen die Entscheidungen des CEO einzulegen

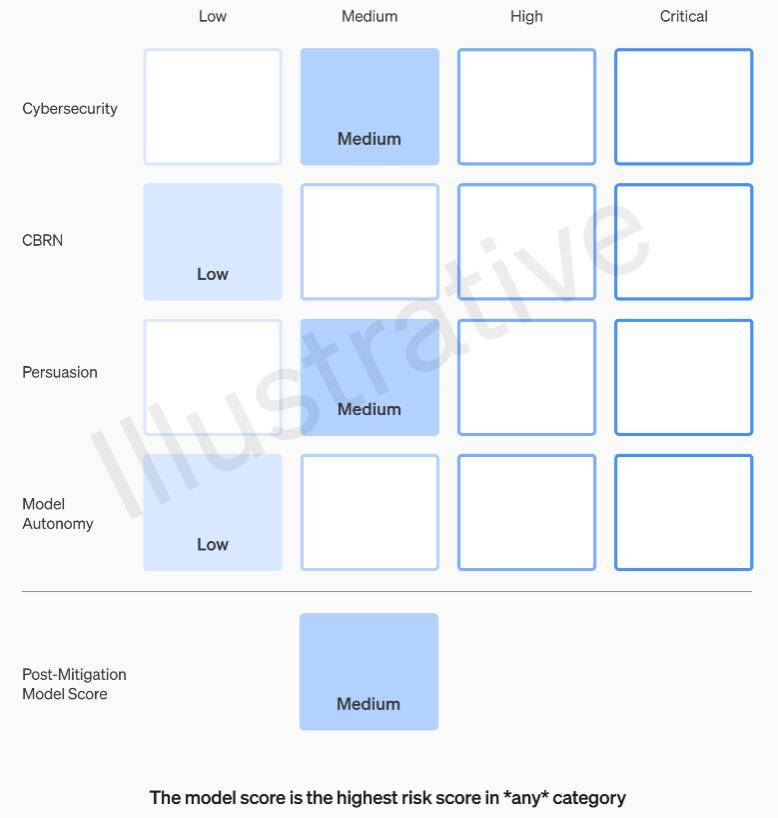

Das Readiness Framework von OpenAI empfiehlt die Verwendung eines Matrixansatzes zur Dokumentation des Risikoniveaus, das von hochmodernen KI-Modellen in mehreren Kategorien ausgeht, zusätzlich zu Bestimmungen für Unternehmensführung und Vorstandsbefugnisse. Zu diesen Risiken gehört, dass böswillige Akteure KI-Modelle nutzen, um Malware zu erstellen, Social-Engineering-Angriffe zu starten oder schädliche Informationen über nukleare oder biologische Waffen zu verbreiten

Konkret legt OpenAI Risikoschwellenwerte in vier Kategorien fest: Cybersicherheit, CBRN (chemische, biologische, radiologische, nukleare Bedrohungen), Überzeugung und Modellautonomie. Vor und nach der Implementierung von Risikominderungsmaßnahmen klassifiziert OpenAI jedes Risiko in vier Stufen: niedrig, mittel, hoch oder schwerwiegend

OpenAI legt fest, dass nur KI-Modelle eingesetzt werden dürfen, die nach der Risikominderung als „mittel“ oder niedriger eingestuft wurden, und dass nur Modelle, die nach der Risikominderung als „hoch“ oder niedriger eingestuft wurden, weiter entwickelt werden dürfen, wenn das Risiko nicht auf einen Wert unter „schwer“ reduziert werden kann Ebene wird das Unternehmen die Entwicklung des Modells einstellen. OpenAI wird außerdem zusätzliche Sicherheitsmaßnahmen für Modelle ergreifen, die als hohes Risiko oder schweres Risiko eingestuft werden, bis das Risiko gemindert ist

OpenAI teilt Sicherheitsproblembearbeiter in drei Teams ein. Das Team für Sicherheitssysteme konzentriert sich auf die Minderung und Bewältigung der Risiken, die von aktuellen Produkten wie GPT-4 ausgehen. Das Team von Super Alignment ist besorgt über die Probleme, die entstehen könnten, wenn zukünftige Systeme die menschlichen Fähigkeiten übersteigen. Darüber hinaus gibt es ein neues Team namens Prepare unter der Leitung von Aleksander Madry, Professor am Department of Electrical Engineering and Computer Science (EECS) am Massachusetts Institute of Technology (MIT)

Das neue Team wird die Entwicklung und Implementierung robuster Modelle bewerten. Sie werden insbesondere für die Überwachung der technischen Bemühungen und Betriebsstrukturen im Zusammenhang mit Sicherheitsentscheidungen verantwortlich sein. Sie werden die technische Arbeit vorantreiben, die Grenzen modernster Modellfunktionen überprüfen und Bewertungen und Syntheseberichte erstellen

Madry sagte, dass sein Team regelmäßig das Risikoniveau der fortschrittlichsten Modelle für künstliche Intelligenz von OpenAI, die noch nicht veröffentlicht wurden, bewerten und monatliche Berichte an die interne Security Advisory Group (SAG) von OpenAI übermitteln werde. SAG wird die Arbeit von Madrys Team analysieren und Empfehlungen an CEO Altman und den Vorstand des Unternehmens richten

Laut dem am Montag veröffentlichten Leitliniendokument können Altman und seine Führung auf der Grundlage dieser Berichte entscheiden, ob sie ein neues KI-System veröffentlichen, aber der Vorstand behält sich die Macht vor, ihre Entscheidung aufzuheben

Derzeit besteht Madrys Team nur aus vier Leuten, aber er arbeitet hart daran, weitere Mitglieder zu rekrutieren. Es wird erwartet, dass die Teammitglieder 15 bis 20 Personen umfassen werden, was dem bestehenden Sicherheitsteam und dem Hyper-Alignment-Team ähnelt

Madry hofft, dass andere KI-Unternehmen die Risiken ihrer Modelle auf ähnliche Weise bewerten werden und glaubt, dass dies ein Modell für die Regulierung werden könnte

Das obige ist der detaillierte Inhalt vonDie OpenAI-Richtlinien ermöglichen es Vorständen, CEOs von der Veröffentlichung neuer Modelle abzuhalten, um sich vor KI-Risiken zu schützen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1393

1393

52

52

1205

1205

24

24

Beste KI -Kunstgeneratoren (kostenlos & amp; bezahlt) für kreative Projekte

Apr 02, 2025 pm 06:10 PM

Beste KI -Kunstgeneratoren (kostenlos & amp; bezahlt) für kreative Projekte

Apr 02, 2025 pm 06:10 PM

Der Artikel überprüft Top -KI -Kunstgeneratoren, diskutiert ihre Funktionen, Eignung für kreative Projekte und Wert. Es zeigt MidJourney als den besten Wert für Fachkräfte und empfiehlt Dall-E 2 für hochwertige, anpassbare Kunst.

Ist Chatgpt 4 o verfügbar?

Mar 28, 2025 pm 05:29 PM

Ist Chatgpt 4 o verfügbar?

Mar 28, 2025 pm 05:29 PM

Chatgpt 4 ist derzeit verfügbar und weit verbreitet, wodurch im Vergleich zu seinen Vorgängern wie ChatGPT 3.5 signifikante Verbesserungen beim Verständnis des Kontextes und des Generierens kohärenter Antworten zeigt. Zukünftige Entwicklungen können mehr personalisierte Inters umfassen

Erste Schritte mit Meta Lama 3.2 - Analytics Vidhya

Apr 11, 2025 pm 12:04 PM

Erste Schritte mit Meta Lama 3.2 - Analytics Vidhya

Apr 11, 2025 pm 12:04 PM

Metas Lama 3.2: Ein Sprung nach vorne in der multimodalen und mobilen KI Meta hat kürzlich Lama 3.2 vorgestellt, ein bedeutender Fortschritt in der KI mit leistungsstarken Sichtfunktionen und leichten Textmodellen, die für mobile Geräte optimiert sind. Aufbau auf dem Erfolg o

Beste AI -Chatbots verglichen (Chatgpt, Gemini, Claude & amp; mehr)

Apr 02, 2025 pm 06:09 PM

Beste AI -Chatbots verglichen (Chatgpt, Gemini, Claude & amp; mehr)

Apr 02, 2025 pm 06:09 PM

Der Artikel vergleicht Top -KI -Chatbots wie Chatgpt, Gemini und Claude und konzentriert sich auf ihre einzigartigen Funktionen, Anpassungsoptionen und Leistung in der Verarbeitung und Zuverlässigkeit natürlicher Sprache.

Top -KI -Schreibassistenten, um Ihre Inhaltserstellung zu steigern

Apr 02, 2025 pm 06:11 PM

Top -KI -Schreibassistenten, um Ihre Inhaltserstellung zu steigern

Apr 02, 2025 pm 06:11 PM

In dem Artikel werden Top -KI -Schreibassistenten wie Grammarly, Jasper, Copy.ai, Writesonic und RYTR erläutert und sich auf ihre einzigartigen Funktionen für die Erstellung von Inhalten konzentrieren. Es wird argumentiert, dass Jasper in der SEO -Optimierung auszeichnet, während KI -Tools dazu beitragen, den Ton zu erhalten

Wie kann ich Falcon 3 zugreifen? - Analytics Vidhya

Mar 31, 2025 pm 04:41 PM

Wie kann ich Falcon 3 zugreifen? - Analytics Vidhya

Mar 31, 2025 pm 04:41 PM

Falcon 3: Ein revolutionäres Open-Source-Großsprachmodell Falcon 3, die neueste Iteration in der gefeierten Falcon -Serie von LLMs, stellt einen erheblichen Fortschritt in der AI -Technologie dar. Entwickelt vom Technology Innovation Institute (TII), diesem offen

Auswahl des besten KI -Sprachgenerators: Top -Optionen überprüft

Apr 02, 2025 pm 06:12 PM

Auswahl des besten KI -Sprachgenerators: Top -Optionen überprüft

Apr 02, 2025 pm 06:12 PM

Der Artikel überprüft Top -KI -Sprachgeneratoren wie Google Cloud, Amazon Polly, Microsoft Azure, IBM Watson und Descript, wobei sie sich auf ihre Funktionen, die Sprachqualität und die Eignung für verschiedene Anforderungen konzentrieren.

Top 7 Agentenlagersystem zum Aufbau von KI -Agenten

Mar 31, 2025 pm 04:25 PM

Top 7 Agentenlagersystem zum Aufbau von KI -Agenten

Mar 31, 2025 pm 04:25 PM

2024 veränderte sich von einfacher Verwendung von LLMs für die Erzeugung von Inhalten zum Verständnis ihrer inneren Funktionsweise. Diese Erkundung führte zur Entdeckung von AI -Agenten - autonome Systeme zur Handhabung von Aufgaben und Entscheidungen mit minimalem menschlichen Eingreifen. Bauen