Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

CMU führte eine detaillierte Vergleichsstudie durch und stellte fest, dass GPT-3.5 Gemini Pro überlegen ist und eine faire, transparente und reproduzierbare Leistung gewährleistet

CMU führte eine detaillierte Vergleichsstudie durch und stellte fest, dass GPT-3.5 Gemini Pro überlegen ist und eine faire, transparente und reproduzierbare Leistung gewährleistet

CMU führte eine detaillierte Vergleichsstudie durch und stellte fest, dass GPT-3.5 Gemini Pro überlegen ist und eine faire, transparente und reproduzierbare Leistung gewährleistet

Was ist die Stärke von Google Gemini? Die Carnegie Mellon University hat einen professionellen und objektiven Drittanbietervergleich durchgeführt.

Um Fairness zu gewährleisten, alle Modelle verwenden dieselben Eingabeaufforderungen und Generierungsparameter und liefern reproduzierbaren Code und vollständig transparente Ergebnisse.

wird CoT@32 nicht verwenden, um 5-Shots zu vergleichen, wie Googles offizielle Pressekonferenz.

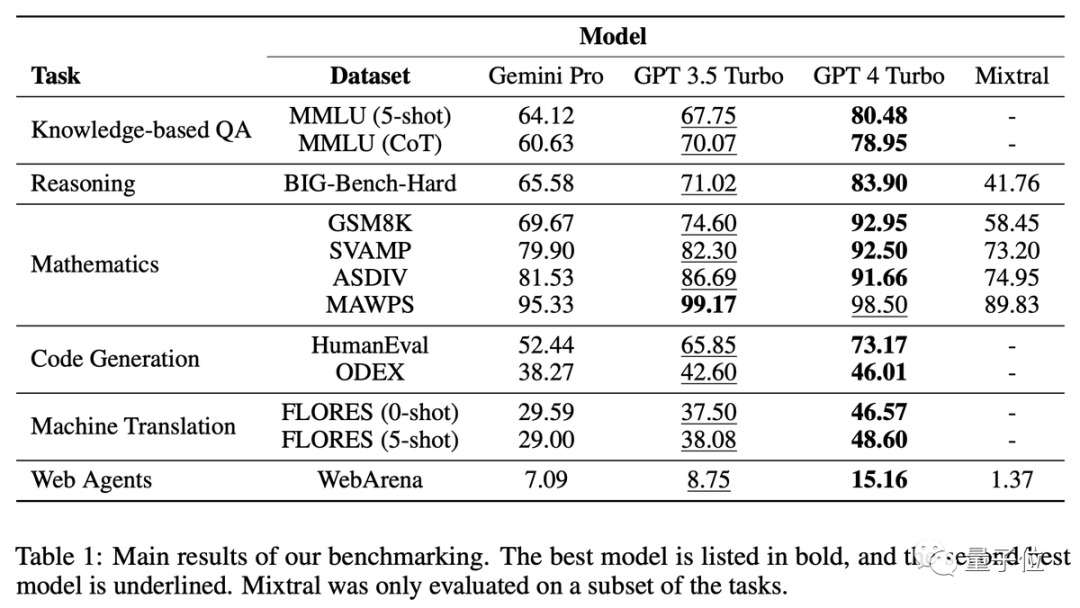

Ergebnisse in einem Satz: Die Gemini Pro-Version liegt nahe an GPT-3.5 Turbo, ist ihm aber etwas unterlegen, und GPT-4 liegt immer noch weit vorne.

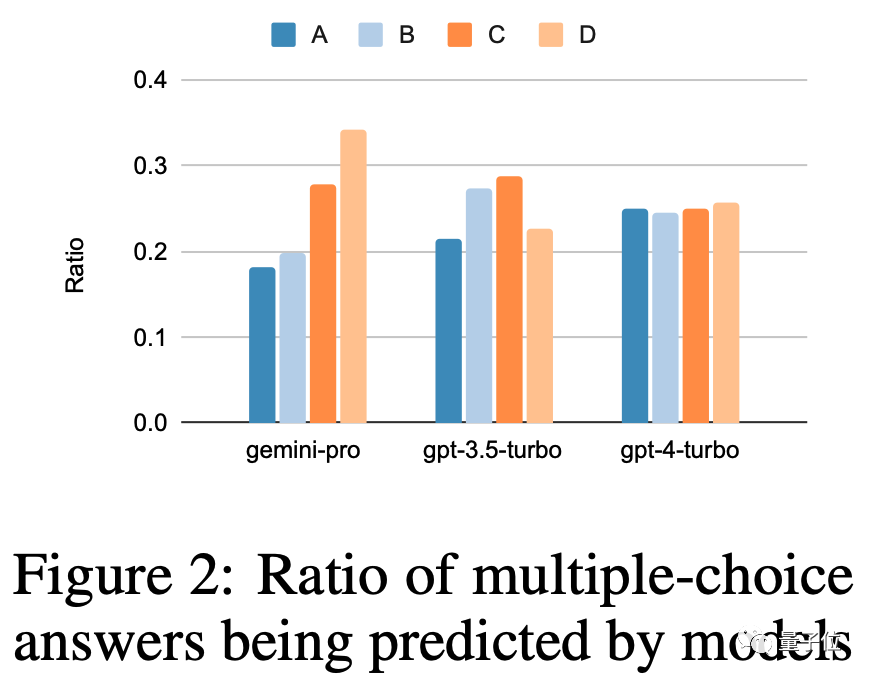

In der eingehenden Analyse haben wir auch einige seltsame Merkmale von Zwillingen gefunden, wie zum Beispiel Ich wähle gerne D für Multiple-Choice-Fragen…

Viele Forscher sagten, dass Zwillinge durchgeführt wurden nur wenige Tage nach der Veröffentlichung sehr detailliert. Dies ist eine sehr bemerkenswerte Leistung

Frage und Antwort: MMLU Inferenz: BIG-Bench Hard

Inferenz: BIG-Bench Hard

Mathe: GSM8k, SVAMP, ASDIV, MAWPS

Code: HumanEval, ODEX

- Übersetzung: FLORES

- Surfen: WebArena

- Trivia: Like D

- Anhand der Ergebnisse ist ersichtlich, dass die Verwendung von Denkkettenaufforderungen bei dieser Art von Aufgabe nicht unbedingt die Wirkung verbessert. Im MMLU-Datensatz handelt es sich bei allen Fragen um Multiple-Choice-Fragen. Nach einer weiteren Analyse der Ergebnisse wurde ein seltsames Phänomen entdeckt: Gemini bevorzugt Option D. Die Verteilung der GPT-Reihe auf die vier Optionen ist viel ausgewogener. Das Team vermutete, dass dies daran liegen könnte, dass Gemini nicht viele Anweisungen für mehrere bereitstellte -Auswahlfragen

- durch Feinabstimmung verursacht.

Darüber hinaus ist die Sicherheitsfilterung von Gemini sehr streng. Bei ethischen Fragen werden nur 85 % der Fragen beantwortet. Wenn es um Fragen im Zusammenhang mit der menschlichen Sexualität geht, kann es nur 28 % der Fragen beantworten

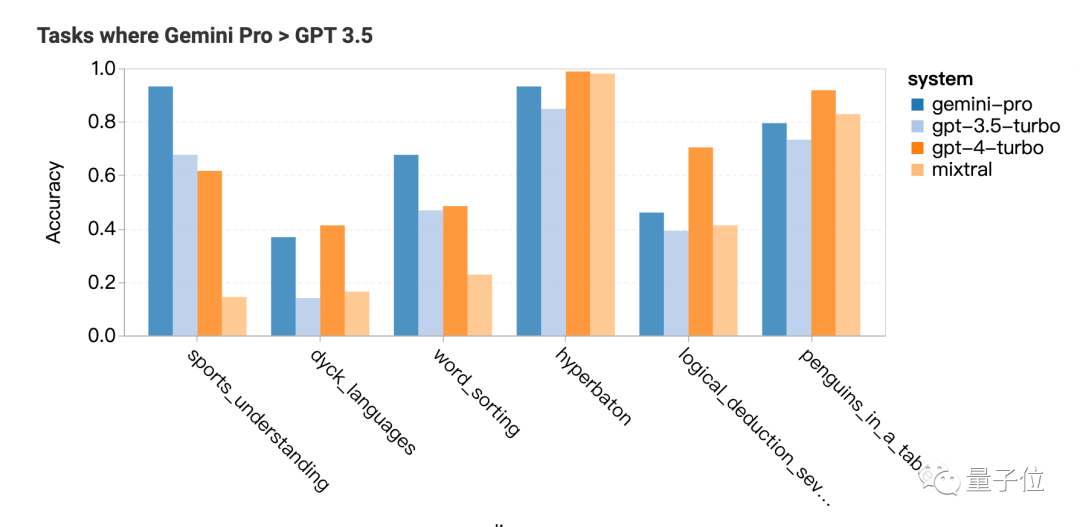

Gemini Pro übertrifft GPT-3.5 in der Sicherheitsforschung und der Mikroökonomie an weiterführenden Schulen, aber der Abstand ist nicht groß, sagte das Team. Ich finde nichts Besonderes

Gemini Pro übertrifft GPT-3.5 in der Sicherheitsforschung und der Mikroökonomie an weiterführenden Schulen, aber der Abstand ist nicht groß, sagte das Team. Ich finde nichts Besonderes

Begründung: Lange Probleme eignen sich nicht gut

Die GPT-Serie schneidet bei längeren und komplexeren Problemen besser ab, im Vergleich schneidet Gemini Pro weniger gut ab. Hervorragend

Zu den Aufgaben, in denen Zwillinge gut sind, gehören das Verstehen der verschiedenen Sportarten der Welt, das Manipulieren von Symbolstapeln, das Sortieren von Wörtern in alphabetischer Reihenfolge und das Analysieren von Tabellen

Mathematik: Komplexe Aufgaben übertroffen

Die Frage selbst war zu lang, was dazu führte, dass die Leistung von Gemini Pro und GPT-3.5 gleichzeitig abfiel und nur GPT-4 ein konstantes Niveau halten konnte

Als die Länge der Denkkette am längsten war, übertraf Gemini GPT- 3.5

Code: Gut bei Matplotlib

Bei Code-Fragen schneidet Gemini bei Fragen mit langen Referenzantworten nicht gut ab

Die GPT-Familie ist in den meisten Typen leistungsfähiger, schneidet bei Matplotlib jedoch völlig schlechter ab

Übersetzung: Einfach antworten Ja, die Qualität ist sehr hoch

Bei der Übersetzungsaufgabe weigerte sich Gemini, 12 Arten von Fragen zu beantworten, aber die Qualität der beantworteten Übersetzungen war alle sehr gut und die Gesamtleistung übertraf sie GPT-4

Gemini weigerte sich zu übersetzen. Die Sprachen umfassen hauptsächlich Latein und Arabisch. soziale Foren, gemeinsame GitLab-Entwicklung, Content-Management-Systeme und Online-Karten. KI muss Informationen in dieser Umgebung finden oder Aufgaben standortübergreifend erledigen.

Gemini schneidet insgesamt nicht so gut ab wie GPT-3.5 Turbo, schneidet aber bei Aufgaben über mehrere Standorte hinweg etwas besser ab.

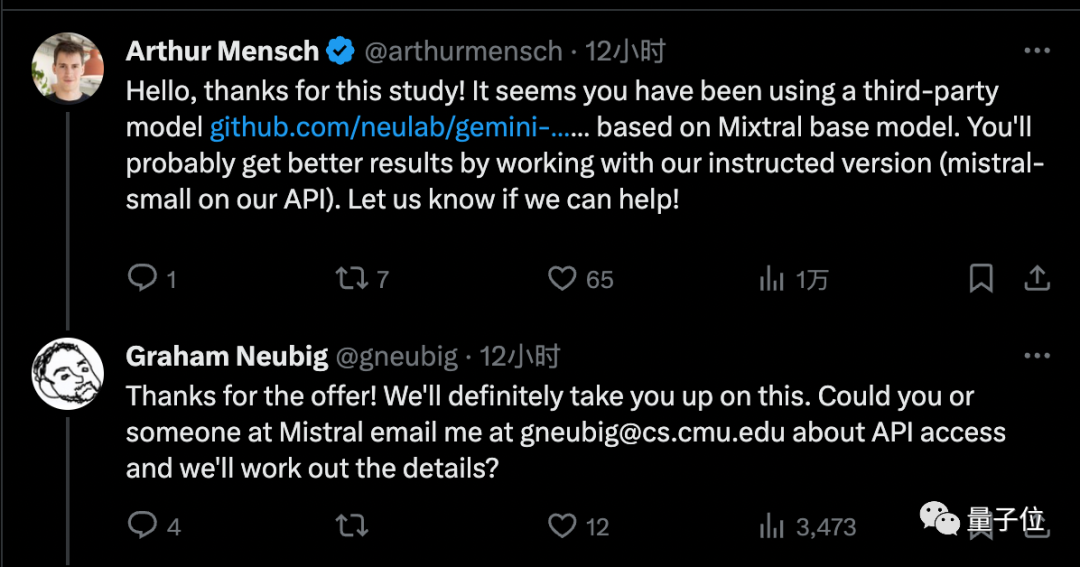

Netizen: Aber es ist kostenlos Eingabeaufforderungswörter für verschiedene Modelle können unterschiedlich sein Erhöhen Sie es um 5 bis 10 Prozentpunkte, was sehr hilfreich für Inferenzaufgaben ist Noam Brown glaubt, dass die Ergebnisse von Mixtral ignoriert werden können, da anstelle der offiziellen Implementierung eine Drittanbieter-API verwendet wird

Der Gründer von Mistral AI hat dem Team Zugriff auf die offizielle Version gewährt, von der er glaubt, dass sie bessere Ergebnisse bringen wird

Obwohl Gemini Pro nicht so gut wie GPT-3.5 ist, besteht sein Vorteil darin, dass es als Nein bezeichnet werden kann mehr als 60 Mal pro Minute Es kann kostenlos genutzt werden

Daher haben viele einzelne Entwickler das Lager gewechselt

Derzeit ist die höchste Version von Gemini, die Ultra-Version, noch nicht veröffentlicht, und das CMU-Team beabsichtigt auch um diese Forschung bis dahin fortzusetzen

Glauben Sie, dass Gemini Ultra GPT-Level 4 erreichen kann?

Dieser Artikel enthält Einzelheiten zum Artikel: https://arxiv.org/abs/2312.11444

Referenzlink:

[1]https://twitter.com/gneubig/status/1737108977954251216.

Das obige ist der detaillierte Inhalt vonCMU führte eine detaillierte Vergleichsstudie durch und stellte fest, dass GPT-3.5 Gemini Pro überlegen ist und eine faire, transparente und reproduzierbare Leistung gewährleistet. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

Welche 2025 Währungsaustauschplattform ist besser? Die neuesten Empfehlungen der zehn beliebten Währungshandel -Apps

Mar 25, 2025 pm 06:18 PM

Welche 2025 Währungsaustauschplattform ist besser? Die neuesten Empfehlungen der zehn beliebten Währungshandel -Apps

Mar 25, 2025 pm 06:18 PM

2025 Rangliste der Währungsaustauschplattform: 1. OKX, 2. Binance, 3. Gate.io, 4. Coinbase, 5. Kraken, 6. Huobi Global, 7. Crypto.com, 8. Kucoin, 9. Gemini, 10. Bitstamp. Diese Plattformen arbeiten hervorragend bei Sicherheitsmaßnahmen, Benutzerbewertungen und Marktleistung und sind für Benutzer geeignet, um digitale Währungstransaktionen durchzuführen.

Tutorial zur Registrierung, Verwendung und Stornierung von Ouyi Okex -Konto

Mar 31, 2025 pm 04:21 PM

Tutorial zur Registrierung, Verwendung und Stornierung von Ouyi Okex -Konto

Mar 31, 2025 pm 04:21 PM

In diesem Artikel wird ausführlich die Registrierungs-, Nutzungs- und Stornierungsverfahren von Ouyi Okex -Konto eingeführt. Um sich zu registrieren, müssen Sie die App herunterladen, Ihre Handynummer oder E-Mail-Adresse eingeben, um sich zu registrieren, und die authentifizierte Authentifizierung abschließen. Die Verwendung deckt die Betriebsschritte wie Anmeldung, Aufladung und Rückzug, Transaktion und Sicherheitseinstellungen ab. Um ein Konto zu kündigen, müssen Sie den Kundendienst von Ouyi Okex kontaktieren, die erforderlichen Informationen bereitstellen und auf die Bearbeitung warten und schließlich die Bestätigung des Konto -Stornierens erhalten. In diesem Artikel können Benutzer das vollständige Lebenszyklusmanagement von Ouyi Okex -Konto problemlos beherrschen und digitale Asset -Transaktionen sicher und bequem durchführen.

Zusammenfassung der sicheren und benutzerfreundlichen Handelsplattformen für virtuelle Währung im Jahr 2025

Mar 25, 2025 pm 06:15 PM

Zusammenfassung der sicheren und benutzerfreundlichen Handelsplattformen für virtuelle Währung im Jahr 2025

Mar 25, 2025 pm 06:15 PM

Empfohlene sichere und benutzerfreundliche Handelsplattformen für virtuelle Währung im Jahr 2025. Dieser Artikel fasst zehn globale Handelsplattformen für virtuelle Währung von Mainstream zusammen, darunter Binance, OKX, Huobi, Gate.io, Coinbase, Kraken, Kucoin, Bitfinex, Crypto.com und Gemini. Sie haben Vorteile in Bezug auf Handelspaare, 24-Stunden-Transaktionsvolumen, Sicherheit, Benutzererfahrung usw. Zum Beispiel ist Binance Trading schnell, OKX Futures Trading ist beliebt, Coinbase ist für Anfänger geeignet und Kraken ist bekannt für seine Sicherheit. Es ist jedoch zu beachten, dass virtuelle Währungstransaktionen äußerst riskant sind und Investitionen vorsichtig sein sollten. Bitte bewerten Sie Ihren eigenen Stil sorgfältig, bevor Sie eine Plattform auswählen

Welche digitale Währungsaustausch -App ist im Jahr 2025 besser? Ranking von Top Ten Virtual Currency App -Austausch

Mar 25, 2025 pm 06:06 PM

Welche digitale Währungsaustausch -App ist im Jahr 2025 besser? Ranking von Top Ten Virtual Currency App -Austausch

Mar 25, 2025 pm 06:06 PM

Ranking des Austauschs der Secure Digital Currency App in 2025: 1. OKX, 2. Binance, 3. Gate.io, 4. Coinbase, 5. Kraken, 6. Huobi Global, 7. Crypto.com, 8. Kucoin, 9. Gemini, 10. Bitstamp. Diese Plattformen arbeiten hervorragend bei Sicherheitsmaßnahmen, Benutzerbewertungen und Marktleistung und sind für Benutzer geeignet, um digitale Währungstransaktionen durchzuführen.

Die neueste Zusammenfassung der formalen Handelsplattform 2025 Ethereum

Mar 26, 2025 pm 04:45 PM

Die neueste Zusammenfassung der formalen Handelsplattform 2025 Ethereum

Mar 26, 2025 pm 04:45 PM

Die Auswahl einer "formalen" Ethereum -Handelsplattform 2025 bedeutet Sicherheit, Einhaltung und Transparenz. Lizenzierte Operationen, finanzielle Sicherheit, transparente Operationen, AML/KYC, Datenschutz und fairer Handel sind von entscheidender Bedeutung. Konforme Börsen wie Coinbase, Kraken und Gemini sind es wert, auf die Aufmerksamkeit zu schalten. Binance und Ouyi haben die Möglichkeit, durch Stärkung der Einhaltung formaler Plattformen zu werden. Defi ist eine Option, aber es gibt Risiken. Achten Sie darauf, Sicherheit, Einhaltung, Ausgaben, Ausbreitungsrisiken, Sicherung privater Schlüssel und führen Sie Ihre eigenen Nachforschungen durch.

Die jüngste Rangliste der Top Ten Cryptocurrency -Austausch der Welt im Jahr 2025

Mar 26, 2025 pm 05:09 PM

Die jüngste Rangliste der Top Ten Cryptocurrency -Austausch der Welt im Jahr 2025

Mar 26, 2025 pm 05:09 PM

Es ist schwierig, das Ranking des Kryptowährungsbörsen im Jahr 2025 vorherzusagen, da sich der Markt schnell verändert. Wichtig ist nicht das spezifische Ranking, sondern das Verständnis der Faktoren, die die Rangliste beeinflussen: Vorschriften für die Regulierung, institutionelle Investitionen, Defi -Integration, Benutzererfahrung, Sicherheit und Globalisierung. Binance, Coinbase, Kraken und andere werden voraussichtlich in die Top Ten eintreten, aber es können auch schwarze Swan -Ereignisse auftreten. Achten Sie auf Markttrends und Austauschtrends, glauben Sie nicht blind an Rankings und leisten Sie vor dem Investieren gute Arbeit.

Wie optimieren Sie die Jieba -Word -Segmentierung, um den Effekt der Keyword -Extraktion von szenischen Spot -Kommentaren zu verbessern?

Apr 01, 2025 pm 06:24 PM

Wie optimieren Sie die Jieba -Word -Segmentierung, um den Effekt der Keyword -Extraktion von szenischen Spot -Kommentaren zu verbessern?

Apr 01, 2025 pm 06:24 PM

Wie optimieren Sie die Jieba -Word -Segmentierung, um die Keyword -Extraktion von malerischen Spot -Kommentaren zu verbessern? Bei Verwendung von Jieba -Word -Segmentierung zur Verarbeitung szenischer Spot -Kommentardaten, wenn die Ergebnisse der Wortsegmentierung ignoriert werden ...

Top 10 Digital Currency Exchange Ranking Neueste App Virtual Digital Currency Trading Platform App

Mar 25, 2025 pm 06:21 PM

Top 10 Digital Currency Exchange Ranking Neueste App Virtual Digital Currency Trading Platform App

Mar 25, 2025 pm 06:21 PM

Ranking of the top ten trading platforms digital currency apps: 1. OKX, 2. Binance, 3. Gate.io, 4. Coinbase, 5. Kraken, 6. Huobi, 7. KuCoin, 8. Crypto.com, 9. Bitfinex, 10. Gemini, when choosing transactions, you need to consider security, fees, currency selection, user experience, customer support and supervision, and investment should be cautious.