Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Meituan, die Zhejiang-Universität und andere arbeiten zusammen, um ein voll prozessfähiges mobiles multimodales Großmodell MobileVLM zu entwickeln, das in Echtzeit ausgeführt werden kann und den Snapdragon 888-Prozessor verwendet

Meituan, die Zhejiang-Universität und andere arbeiten zusammen, um ein voll prozessfähiges mobiles multimodales Großmodell MobileVLM zu entwickeln, das in Echtzeit ausgeführt werden kann und den Snapdragon 888-Prozessor verwendet

Meituan, die Zhejiang-Universität und andere arbeiten zusammen, um ein voll prozessfähiges mobiles multimodales Großmodell MobileVLM zu entwickeln, das in Echtzeit ausgeführt werden kann und den Snapdragon 888-Prozessor verwendet

Die Welle großer Modelle, die auf das mobile Endgerät kommen, wird immer stärker, und endlich hat jemand multimodale große Modelle auf das mobile Endgerät übertragen. Kürzlich haben Meituan, die Zhejiang-Universität usw. multimodale Großmodelle auf den Markt gebracht, die auf mobilen Endgeräten bereitgestellt werden können, einschließlich des gesamten Prozesses des LLM-Basistrainings, SFT und VLM. Vielleicht kann in naher Zukunft jeder bequem, schnell und kostengünstig sein eigenes Großmodell besitzen.

Papieradresse: https://arxiv.org/pdf/2312.16886.pdf Codeadresse: https://github.com/Meituan-AutoML/MobileVLM

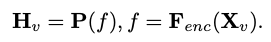

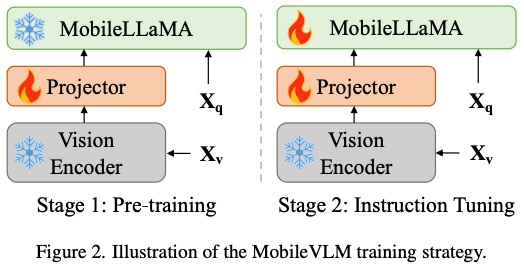

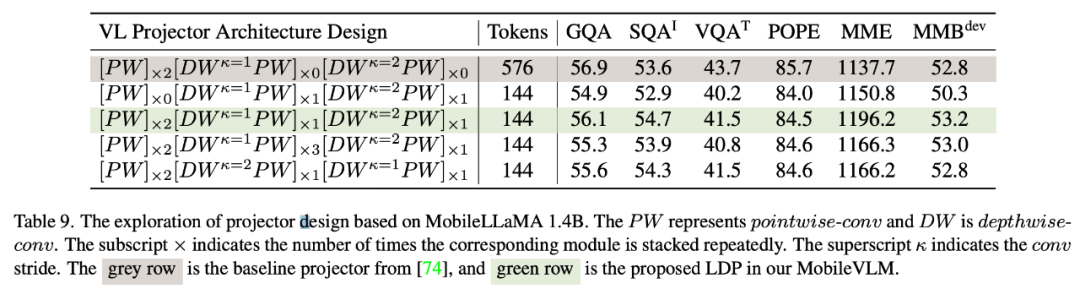

Dieser Artikel schlägt MobileVLM vor, eine Full-Stack-Transformation eines multimodalen visuellen Sprachmodells, das für mobile Szenarien angepasst ist. Laut den Autoren ist dies das erste visuelle Sprachmodell, das von Grund auf eine detaillierte, reproduzierbare und leistungsstarke Leistung liefert. Durch kontrollierte und Open-Source-Datensätze haben Forscher eine Reihe leistungsstarker grundlegender Sprachmodelle und multimodaler Modelle erstellt. Dieser Artikel führt umfangreiche Ablationsexperimente zum Design visueller Encoder durch und bewertet systematisch die Leistungsempfindlichkeit von VLMs gegenüber verschiedenen Trainingsparadigmen, Eingabeauflösungen und Modellgrößen. Dieser Artikel entwirft ein effizientes Zuordnungsnetzwerk zwischen visuellen Merkmalen und Textmerkmalen, das multimodale Merkmale besser ausrichten und gleichzeitig den Argumentationsverbrauch reduzieren kann. Das in diesem Artikel entworfene Modell kann effizient auf Mobilgeräten mit geringem Stromverbrauch laufen, mit einer gemessenen Geschwindigkeit von 21,5 Token/s auf der mobilen CPU und dem 65,5-Zoll-Prozessor von Qualcomm. MobileVLM und eine Vielzahl multimodaler Großmodelle schneiden bei Benchmarks gleichermaßen gut ab und beweisen ihr Einsatzpotenzial in vielen praktischen Aufgaben. Während sich dieser Artikel auf Edge-Szenarien konzentriert, übertrifft MobileVLM viele hochmoderne VLMs, die nur von leistungsstarken GPUs in der Cloud unterstützt werden können. Gesamtarchitekturdesign von LMoBilevlmo

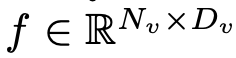

als Eingabe und der visuelle Encoder F_enc extrahiert daraus die visuelle Einbettung

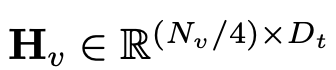

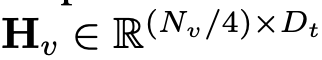

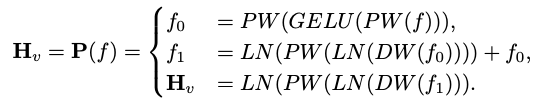

als Eingabe und der visuelle Encoder F_enc extrahiert daraus die visuelle Einbettung  für die Bildwahrnehmung, wobei N_v = HW/P^2 die Anzahl der Bildfelder und D_v die Größe der verborgenen Ebene der visuellen Einbettung darstellt. Um das Effizienzproblem bei der Verarbeitung von Bild-Tokens zu lindern, entwarfen die Forscher ein leichtes Kartennetzwerk P für die Komprimierung visueller Merkmale und die modale Ausrichtung von visuellem Text. Es wandelt f in den Worteinbettungsraum um und stellt geeignete Eingabedimensionen für das nachfolgende Sprachmodell bereit, wie folgt:

für die Bildwahrnehmung, wobei N_v = HW/P^2 die Anzahl der Bildfelder und D_v die Größe der verborgenen Ebene der visuellen Einbettung darstellt. Um das Effizienzproblem bei der Verarbeitung von Bild-Tokens zu lindern, entwarfen die Forscher ein leichtes Kartennetzwerk P für die Komprimierung visueller Merkmale und die modale Ausrichtung von visuellem Text. Es wandelt f in den Worteinbettungsraum um und stellt geeignete Eingabedimensionen für das nachfolgende Sprachmodell bereit, wie folgt:

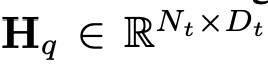

und die Token des Textes

und die Token des Textes , wobei N_t darstellt Der Text ist die Anzahl der Token. D_t repräsentiert die Größe des Worteinbettungsraums. Im aktuellen MLLM-Designparadigma weist LLM den größten Rechenaufwand und Speicherverbrauch auf. Aus diesem Grund stellt dieser Artikel eine Reihe von inferenzfreundlichen LLM für mobile Anwendungen vor, die erhebliche Geschwindigkeitsvorteile bieten und autoregressive Methoden durchführen können multimodale Eingabe

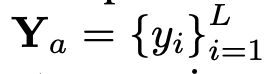

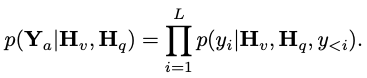

, wobei N_t darstellt Der Text ist die Anzahl der Token. D_t repräsentiert die Größe des Worteinbettungsraums. Im aktuellen MLLM-Designparadigma weist LLM den größten Rechenaufwand und Speicherverbrauch auf. Aus diesem Grund stellt dieser Artikel eine Reihe von inferenzfreundlichen LLM für mobile Anwendungen vor, die erhebliche Geschwindigkeitsvorteile bieten und autoregressive Methoden durchführen können multimodale Eingabe  , wobei L die Länge der Ausgabe-Tokens darstellt. Dieser Prozess kann als

, wobei L die Länge der Ausgabe-Tokens darstellt. Dieser Prozess kann als  ausgedrückt werden.

ausgedrückt werden. RoPE anwenden, um Standortinformationen einzufügen. Wenden Sie eine Vornormalisierung an, um das Training zu stabilisieren. Insbesondere verwendet dieses Dokument RMSNorm anstelle der Schichtnormalisierung und das MLP-Erweiterungsverhältnis verwendet 8/3 anstelle von 4. Verwenden Sie die SwiGLU-Aktivierungsfunktion anstelle von GELU.

und gibt ein effizient extrahiertes und ausgerichtetes visuelles Token

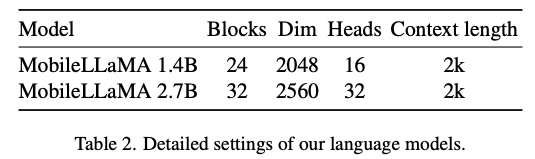

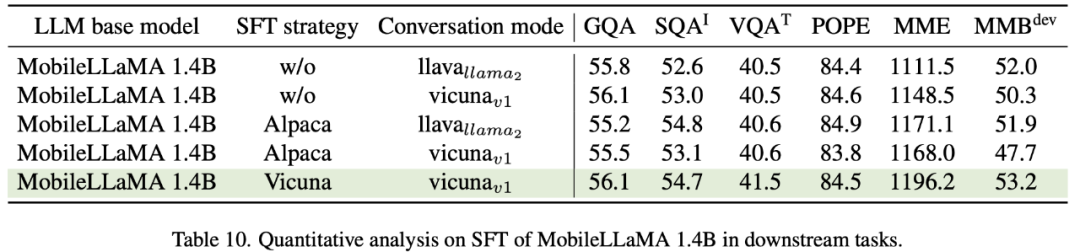

und gibt ein effizient extrahiertes und ausgerichtetes visuelles Token  aus. Die Formel lautet wie folgt: Experimentelle Ergebnisse Forscher Dieser Artikel wurde anhand des Benchmarks für natürliche Sprache überprüft Das vorgeschlagene Modell wurde umfassend anhand von zwei Benchmarks evaluiert, die jeweils auf das Sprachverständnis und das logische Denken abzielten. Bei der Bewertung des ersteren wird in diesem Artikel das Language Model Evaluation Harness verwendet. Experimentelle Ergebnisse zeigen, dass MobileLLaMA 1.4B den neuesten Open-Source-Modellen wie TinyLLaMA 1.1B, Galactica 1.3B, OPT 1.3B und Pythia 1.4B ebenbürtig ist. Es ist erwähnenswert, dass MobileLLaMA 1.4B TinyLLaMA 1.1B übertrifft, das auf 2T-Level-Tokens trainiert wird und doppelt so schnell ist wie MobileLLaMA 1.4B. Auf der 3B-Ebene zeigt MobileLLaMA 2.7B auch eine vergleichbare Leistung wie INCITE 3B (V1) und OpenLLaMA 3B (V1), wie in Tabelle 5 gezeigt. Auf der Snapdragon 888-CPU ist MobileLLaMA 2.7B etwa 40 % schneller als OpenLLaMA 3B.

aus. Die Formel lautet wie folgt: Experimentelle Ergebnisse Forscher Dieser Artikel wurde anhand des Benchmarks für natürliche Sprache überprüft Das vorgeschlagene Modell wurde umfassend anhand von zwei Benchmarks evaluiert, die jeweils auf das Sprachverständnis und das logische Denken abzielten. Bei der Bewertung des ersteren wird in diesem Artikel das Language Model Evaluation Harness verwendet. Experimentelle Ergebnisse zeigen, dass MobileLLaMA 1.4B den neuesten Open-Source-Modellen wie TinyLLaMA 1.1B, Galactica 1.3B, OPT 1.3B und Pythia 1.4B ebenbürtig ist. Es ist erwähnenswert, dass MobileLLaMA 1.4B TinyLLaMA 1.1B übertrifft, das auf 2T-Level-Tokens trainiert wird und doppelt so schnell ist wie MobileLLaMA 1.4B. Auf der 3B-Ebene zeigt MobileLLaMA 2.7B auch eine vergleichbare Leistung wie INCITE 3B (V1) und OpenLLaMA 3B (V1), wie in Tabelle 5 gezeigt. Auf der Snapdragon 888-CPU ist MobileLLaMA 2.7B etwa 40 % schneller als OpenLLaMA 3B.

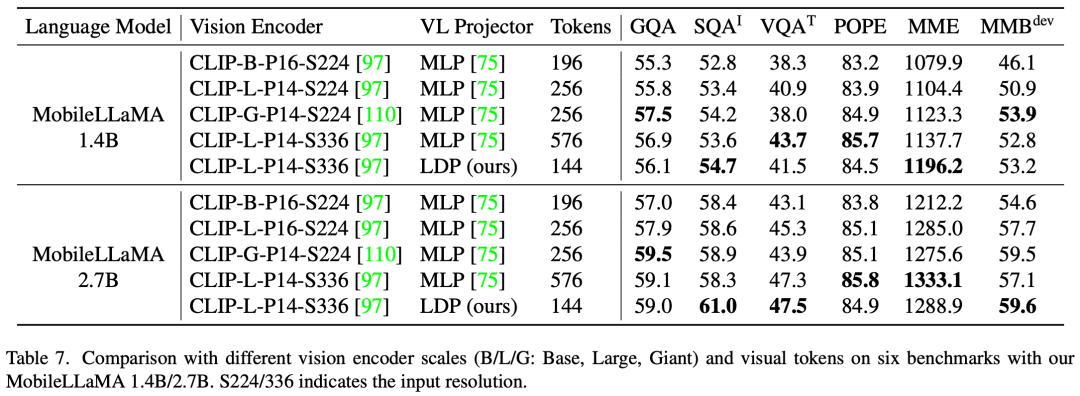

Dieses Papier bewertet die multimodale Leistung von LLaVA bei GQA, ScienceQA, TextVQA, POPE und MME. Darüber hinaus wird in diesem Artikel auch ein umfassender Vergleich mit MMBench durchgeführt. Wie in Tabelle 4 gezeigt, erreicht MobileVLM trotz reduzierter Parameter und begrenzter Trainingsdaten eine wettbewerbsfähige Leistung. In einigen Fällen übertreffen seine Metriken sogar frühere multimodale visuelle Sprachmodelle auf dem neuesten Stand der Technik.

Das obige ist der detaillierte Inhalt vonMeituan, die Zhejiang-Universität und andere arbeiten zusammen, um ein voll prozessfähiges mobiles multimodales Großmodell MobileVLM zu entwickeln, das in Echtzeit ausgeführt werden kann und den Snapdragon 888-Prozessor verwendet. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Der DeepMind-Roboter spielt Tischtennis und seine Vor- und Rückhand rutschen in die Luft, wodurch menschliche Anfänger völlig besiegt werden

Aug 09, 2024 pm 04:01 PM

Der DeepMind-Roboter spielt Tischtennis und seine Vor- und Rückhand rutschen in die Luft, wodurch menschliche Anfänger völlig besiegt werden

Aug 09, 2024 pm 04:01 PM

Aber vielleicht kann er den alten Mann im Park nicht besiegen? Die Olympischen Spiele in Paris sind in vollem Gange und Tischtennis hat viel Aufmerksamkeit erregt. Gleichzeitig haben Roboter auch beim Tischtennisspielen neue Durchbrüche erzielt. Gerade hat DeepMind den ersten lernenden Roboteragenten vorgeschlagen, der das Niveau menschlicher Amateurspieler im Tischtennis-Wettkampf erreichen kann. Papieradresse: https://arxiv.org/pdf/2408.03906 Wie gut ist der DeepMind-Roboter beim Tischtennisspielen? Vermutlich auf Augenhöhe mit menschlichen Amateurspielern: Sowohl Vorhand als auch Rückhand: Der Gegner nutzt unterschiedliche Spielstile, und auch der Roboter hält aus: Aufschlagannahme mit unterschiedlichem Spin: Allerdings scheint die Intensität des Spiels nicht so intensiv zu sein wie Der alte Mann im Park. Für Roboter, Tischtennis

Die erste mechanische Klaue! Yuanluobao trat auf der Weltroboterkonferenz 2024 auf und stellte den ersten Schachroboter vor, der das Haus betreten kann

Aug 21, 2024 pm 07:33 PM

Die erste mechanische Klaue! Yuanluobao trat auf der Weltroboterkonferenz 2024 auf und stellte den ersten Schachroboter vor, der das Haus betreten kann

Aug 21, 2024 pm 07:33 PM

Am 21. August fand in Peking die Weltroboterkonferenz 2024 im großen Stil statt. Die Heimrobotermarke „Yuanluobot SenseRobot“ von SenseTime hat ihre gesamte Produktfamilie vorgestellt und kürzlich den Yuanluobot AI-Schachspielroboter – Chess Professional Edition (im Folgenden als „Yuanluobot SenseRobot“ bezeichnet) herausgebracht und ist damit der weltweit erste A-Schachroboter für heim. Als drittes schachspielendes Roboterprodukt von Yuanluobo hat der neue Guoxiang-Roboter eine Vielzahl spezieller technischer Verbesserungen und Innovationen in den Bereichen KI und Maschinenbau erfahren und erstmals die Fähigkeit erkannt, dreidimensionale Schachfiguren aufzunehmen B. durch mechanische Klauen an einem Heimroboter, und führen Sie Mensch-Maschine-Funktionen aus, z. B. Schach spielen, jeder spielt Schach, Überprüfung der Notation usw.

Claude ist auch faul geworden! Netizen: Lernen Sie, sich einen Urlaub zu gönnen

Sep 02, 2024 pm 01:56 PM

Claude ist auch faul geworden! Netizen: Lernen Sie, sich einen Urlaub zu gönnen

Sep 02, 2024 pm 01:56 PM

Der Schulstart steht vor der Tür und nicht nur die Schüler, die bald ins neue Semester starten, sollten auf sich selbst aufpassen, sondern auch die großen KI-Modelle. Vor einiger Zeit war Reddit voller Internetnutzer, die sich darüber beschwerten, dass Claude faul werde. „Sein Niveau ist stark gesunken, es kommt oft zu Pausen und sogar die Ausgabe wird sehr kurz. In der ersten Woche der Veröffentlichung konnte es ein komplettes 4-seitiges Dokument auf einmal übersetzen, aber jetzt kann es nicht einmal eine halbe Seite ausgeben.“ !

Auf der Weltroboterkonferenz wurde dieser Haushaltsroboter, der „die Hoffnung auf eine zukünftige Altenpflege' in sich trägt, umzingelt

Aug 22, 2024 pm 10:35 PM

Auf der Weltroboterkonferenz wurde dieser Haushaltsroboter, der „die Hoffnung auf eine zukünftige Altenpflege' in sich trägt, umzingelt

Aug 22, 2024 pm 10:35 PM

Auf der World Robot Conference in Peking ist die Präsentation humanoider Roboter zum absoluten Mittelpunkt der Szene geworden. Am Stand von Stardust Intelligent führte der KI-Roboterassistent S1 drei große Darbietungen mit Hackbrett, Kampfkunst und Kalligraphie auf Ein Ausstellungsbereich, der sowohl Literatur als auch Kampfkunst umfasst, zog eine große Anzahl von Fachpublikum und Medien an. Durch das elegante Spiel auf den elastischen Saiten demonstriert der S1 eine feine Bedienung und absolute Kontrolle mit Geschwindigkeit, Kraft und Präzision. CCTV News führte einen Sonderbericht über das Nachahmungslernen und die intelligente Steuerung hinter „Kalligraphie“ durch. Firmengründer Lai Jie erklärte, dass hinter den seidenweichen Bewegungen die Hardware-Seite die beste Kraftkontrolle und die menschenähnlichsten Körperindikatoren (Geschwindigkeit, Belastung) anstrebt. usw.), aber auf der KI-Seite werden die realen Bewegungsdaten von Menschen gesammelt, sodass der Roboter stärker werden kann, wenn er auf eine schwierige Situation stößt, und lernen kann, sich schnell weiterzuentwickeln. Und agil

Bekanntgabe der ACL 2024 Awards: Eines der besten Papers zum Thema Oracle Deciphering von HuaTech, GloVe Time Test Award

Aug 15, 2024 pm 04:37 PM

Bekanntgabe der ACL 2024 Awards: Eines der besten Papers zum Thema Oracle Deciphering von HuaTech, GloVe Time Test Award

Aug 15, 2024 pm 04:37 PM

Bei dieser ACL-Konferenz haben die Teilnehmer viel gewonnen. Die sechstägige ACL2024 findet in Bangkok, Thailand, statt. ACL ist die führende internationale Konferenz im Bereich Computerlinguistik und Verarbeitung natürlicher Sprache. Sie wird von der International Association for Computational Linguistics organisiert und findet jährlich statt. ACL steht seit jeher an erster Stelle, wenn es um akademischen Einfluss im Bereich NLP geht, und ist außerdem eine von der CCF-A empfohlene Konferenz. Die diesjährige ACL-Konferenz ist die 62. und hat mehr als 400 innovative Arbeiten im Bereich NLP eingereicht. Gestern Nachmittag gab die Konferenz den besten Vortrag und weitere Auszeichnungen bekannt. Diesmal gibt es 7 Best Paper Awards (zwei davon unveröffentlicht), 1 Best Theme Paper Award und 35 Outstanding Paper Awards. Die Konferenz verlieh außerdem drei Resource Paper Awards (ResourceAward) und einen Social Impact Award (

Hongmeng Smart Travel S9 und die umfassende Einführungskonferenz für neue Produkte wurden gemeinsam mit einer Reihe neuer Blockbuster-Produkte veröffentlicht

Aug 08, 2024 am 07:02 AM

Hongmeng Smart Travel S9 und die umfassende Einführungskonferenz für neue Produkte wurden gemeinsam mit einer Reihe neuer Blockbuster-Produkte veröffentlicht

Aug 08, 2024 am 07:02 AM

Heute Nachmittag begrüßte Hongmeng Zhixing offiziell neue Marken und neue Autos. Am 6. August veranstaltete Huawei die Hongmeng Smart Xingxing S9 und die Huawei-Konferenz zur Einführung neuer Produkte mit umfassendem Szenario und brachte die Panorama-Smart-Flaggschiff-Limousine Xiangjie S9, das neue M7Pro und Huawei novaFlip, MatePad Pro 12,2 Zoll, das neue MatePad Air und Huawei Bisheng mit Mit vielen neuen Smart-Produkten für alle Szenarien, darunter die Laserdrucker der X1-Serie, FreeBuds6i, WATCHFIT3 und der Smart Screen S5Pro, von Smart Travel über Smart Office bis hin zu Smart Wear baut Huawei weiterhin ein Smart-Ökosystem für alle Szenarien auf, um Verbrauchern ein Smart-Erlebnis zu bieten Internet von allem. Hongmeng Zhixing: Huawei arbeitet mit chinesischen Partnern aus der Automobilindustrie zusammen, um die Modernisierung der Smart-Car-Industrie voranzutreiben

Das Team von Li Feifei schlug ReKep vor, um Robotern räumliche Intelligenz zu verleihen und GPT-4o zu integrieren

Sep 03, 2024 pm 05:18 PM

Das Team von Li Feifei schlug ReKep vor, um Robotern räumliche Intelligenz zu verleihen und GPT-4o zu integrieren

Sep 03, 2024 pm 05:18 PM

Tiefe Integration von Vision und Roboterlernen. Wenn zwei Roboterhände reibungslos zusammenarbeiten, um Kleidung zu falten, Tee einzuschenken und Schuhe zu packen, gepaart mit dem humanoiden 1X-Roboter NEO, der in letzter Zeit für Schlagzeilen gesorgt hat, haben Sie vielleicht das Gefühl: Wir scheinen in das Zeitalter der Roboter einzutreten. Tatsächlich sind diese seidigen Bewegungen das Produkt fortschrittlicher Robotertechnologie + exquisitem Rahmendesign + multimodaler großer Modelle. Wir wissen, dass nützliche Roboter oft komplexe und exquisite Interaktionen mit der Umgebung erfordern und die Umgebung als Einschränkungen im räumlichen und zeitlichen Bereich dargestellt werden kann. Wenn Sie beispielsweise möchten, dass ein Roboter Tee einschenkt, muss der Roboter zunächst den Griff der Teekanne ergreifen und sie aufrecht halten, ohne den Tee zu verschütten, und ihn dann sanft bewegen, bis die Öffnung der Kanne mit der Öffnung der Tasse übereinstimmt , und neigen Sie dann die Teekanne in einem bestimmten Winkel. Das

Getestet 7 Artefakte zur Videogenerierung auf „Sora-Ebene'. Wer hat die Fähigkeit, den „Eisernen Thron' zu besteigen?

Aug 05, 2024 pm 07:19 PM

Getestet 7 Artefakte zur Videogenerierung auf „Sora-Ebene'. Wer hat die Fähigkeit, den „Eisernen Thron' zu besteigen?

Aug 05, 2024 pm 07:19 PM

Herausgeber des Machine Power Report: Yang Wen Wer kann der King of AI-Videokreis werden? In der amerikanischen Fernsehserie „Game of Thrones“ gibt es einen „Eisernen Thron“. Der Legende nach wurde es vom riesigen Drachen „Schwarzer Tod“ erschaffen, der Tausende von von Feinden weggeworfenen Schwertern zum Schmelzen brachte und so höchste Autorität symbolisierte. Um auf diesem eisernen Stuhl zu sitzen, begannen die großen Familien zu kämpfen und zu kämpfen. Seit der Entstehung von Sora wurde im KI-Videokreis ein energisches „Game of Thrones“ gestartet. Zu den Hauptakteuren in diesem Spiel zählen RunwayGen-3 und Luma von der anderen Seite des Ozeans sowie die einheimischen Kuaishou Keling, ByteDream, und Zhimo. Spectrum Qingying, Vidu, PixVerseV2 usw. Heute werden wir bewerten und sehen, wer qualifiziert ist, auf dem „Eisernen Thron“ des KI-Videokreises zu sitzen. -1- Vincent Video