Java

Java

javaLernprogramm

javaLernprogramm

Beherrschen Sie die effiziente Daten-Crawling-Technologie: Erstellen Sie einen leistungsstarken Java-Crawler

Beherrschen Sie die effiziente Daten-Crawling-Technologie: Erstellen Sie einen leistungsstarken Java-Crawler

Beherrschen Sie die effiziente Daten-Crawling-Technologie: Erstellen Sie einen leistungsstarken Java-Crawler

Aufbau eines leistungsstarken Java-Crawlers: Um diese Technologien zu beherrschen, um ein effizientes Daten-Crawling zu erreichen, sind spezifische Codebeispiele erforderlich

1 Einführung

Mit der schnellen Entwicklung des Internets und der Fülle an Datenressourcen erfordern immer mehr Anwendungsszenarien Scrap-Daten von Webseiten. Als leistungsstarke Programmiersprache verfügt Java über ein eigenes Webcrawler-Entwicklungsframework und umfangreiche Bibliotheken von Drittanbietern, was es zur idealen Wahl macht. In diesem Artikel erklären wir, wie man mit Java einen leistungsstarken Webcrawler baut und stellen konkrete Codebeispiele bereit.

2. Grundkenntnisse über Webcrawler

- Was ist ein Webcrawler?

Ein Webcrawler ist ein automatisiertes Programm, das das menschliche Verhalten beim Surfen auf Webseiten im Internet simuliert und die erforderlichen Daten von Webseiten crawlt. Der Crawler extrahiert nach bestimmten Regeln Daten aus der Webseite und speichert sie lokal oder verarbeitet sie weiter. - Das Funktionsprinzip des Crawlers

Das Funktionsprinzip des Crawlers lässt sich grob in die folgenden Schritte unterteilen: - Senden Sie eine HTTP-Anfrage, um den Webseiteninhalt abzurufen.

- Parsen Sie die Seite und extrahieren Sie die erforderlichen Daten.

- Zur Lagerung oder sonstigen Weiterverarbeitung.

3. Java-Crawler-Entwicklungsframework

Java verfügt über viele Entwicklungsframeworks, die für die Entwicklung von Webcrawlern verwendet werden können. Im Folgenden werden zwei häufig verwendete Frameworks vorgestellt.

- Jsoup

Jsoup ist eine Java-Bibliothek zum Parsen, Durchlaufen und Bearbeiten von HTML. Es bietet eine flexible API und praktische Selektoren, die das Extrahieren von Daten aus HTML sehr einfach machen. Das Folgende ist ein Beispielcode, der Jsoup zur Datenextraktion verwendet:

// 导入Jsoup库

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.nodes.Element;

import org.jsoup.select.Elements;

public class JsoupExample {

public static void main(String[] args) throws Exception {

// 发送HTTP请求获取网页内容

Document doc = Jsoup.connect("http://example.com").get();

// 解析页面,提取需要的数据

Elements elements = doc.select("h1"); // 使用选择器选择需要的元素

for (Element element : elements) {

System.out.println(element.text());

}

}

}- HttpClient

HttpClient ist eine Java-HTTP-Anforderungsbibliothek, die den Browser problemlos simulieren kann, um HTTP-Anforderungen zu senden und die Antwort des Servers zu erhalten. Das Folgende ist ein Beispielcode, der HttpClient zum Senden von HTTP-Anfragen verwendet:

// 导入HttpClient库

import org.apache.http.HttpEntity;

import org.apache.http.HttpResponse;

import org.apache.http.client.HttpClient;

import org.apache.http.client.methods.HttpGet;

import org.apache.http.impl.client.DefaultHttpClient;

import org.apache.http.util.EntityUtils;

public class HttpClientExample {

public static void main(String[] args) throws Exception {

// 创建HttpClient实例

HttpClient httpClient = new DefaultHttpClient();

// 创建HttpGet请求

HttpGet httpGet = new HttpGet("http://example.com");

// 发送HTTP请求并获取服务器的响应

HttpResponse response = httpClient.execute(httpGet);

// 解析响应,提取需要的数据

HttpEntity entity = response.getEntity();

String content = EntityUtils.toString(entity);

System.out.println(content);

}

}4. Fortschrittliche Technologie

- Multithreading

Um die Effizienz des Crawlers zu verbessern, können wir Multithreading verwenden, um mehrere Webseiten zu crawlen gleichzeitig. Das Folgende ist ein Beispielcode für einen Crawler, der mit Java-Multithreading implementiert wurde:

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.nodes.Element;

import org.jsoup.select.Elements;

import java.util.concurrent.ExecutorService;

import java.util.concurrent.Executors;

public class MultiThreadSpider {

private static final int THREAD_POOL_SIZE = 10;

public static void main(String[] args) throws Exception {

ExecutorService executorService = Executors.newFixedThreadPool(THREAD_POOL_SIZE);

for (int i = 1; i <= 10; i++) {

final int page = i;

executorService.execute(() -> {

try {

// 发送HTTP请求获取网页内容

Document doc = Jsoup.connect("http://example.com/page=" + page).get();

// 解析页面,提取需要的数据

Elements elements = doc.select("h1"); // 使用选择器选择需要的元素

for (Element element : elements) {

System.out.println(element.text());

}

} catch (Exception e) {

e.printStackTrace();

}

});

}

executorService.shutdown();

}

}- Proxy-IP

Um das Problem zu lösen, dass IP aufgrund der hohen Crawling-Frequenz vom Server blockiert wird, können wir Proxy-IP zum Ausblenden verwenden die echte IP-Adresse. Das Folgende ist ein Beispielcode für einen Crawler, der eine Proxy-IP verwendet:

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.nodes.Element;

import org.jsoup.select.Elements;

import java.net.InetSocketAddress;

import java.net.Proxy;

public class ProxyIPSpider {

public static void main(String[] args) throws Exception {

// 创建代理IP

Proxy proxy = new Proxy(Proxy.Type.HTTP, new InetSocketAddress("127.0.0.1", 8080));

// 发送HTTP请求并使用代理IP

Document doc = Jsoup.connect("http://example.com").proxy(proxy).get();

// 解析页面,提取需要的数据

Elements elements = doc.select("h1"); // 使用选择器选择需要的元素

for (Element element : elements) {

System.out.println(element.text());

}

}

} 5. Zusammenfassung

In diesem Artikel haben wir die Verwendung von Java zum Erstellen eines leistungsstarken Webcrawlers vorgestellt und spezifische Codebeispiele bereitgestellt. Durch das Erlernen dieser Techniken können wir die erforderlichen Daten von Webseiten effizienter crawlen. Natürlich erfordert der Einsatz von Webcrawlern auch die Einhaltung einschlägiger Gesetze und ethischer Grundsätze, den angemessenen Einsatz von Crawler-Tools sowie den Schutz der Privatsphäre und der Rechte anderer. Ich hoffe, dieser Artikel hilft Ihnen beim Erlernen und Verwenden von Java-Crawlern!

Das obige ist der detaillierte Inhalt vonBeherrschen Sie die effiziente Daten-Crawling-Technologie: Erstellen Sie einen leistungsstarken Java-Crawler. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

Das Stable Diffusion 3-Papier wird endlich veröffentlicht und die architektonischen Details werden enthüllt. Wird es helfen, Sora zu reproduzieren?

Mar 06, 2024 pm 05:34 PM

Das Stable Diffusion 3-Papier wird endlich veröffentlicht und die architektonischen Details werden enthüllt. Wird es helfen, Sora zu reproduzieren?

Mar 06, 2024 pm 05:34 PM

Der Artikel von StableDiffusion3 ist endlich da! Dieses Modell wurde vor zwei Wochen veröffentlicht und verwendet die gleiche DiT-Architektur (DiffusionTransformer) wie Sora. Nach seiner Veröffentlichung sorgte es für großes Aufsehen. Im Vergleich zur Vorgängerversion wurde die Qualität der von StableDiffusion3 generierten Bilder erheblich verbessert. Es unterstützt jetzt Eingabeaufforderungen mit mehreren Themen, und der Textschreibeffekt wurde ebenfalls verbessert, und es werden keine verstümmelten Zeichen mehr angezeigt. StabilityAI wies darauf hin, dass es sich bei StableDiffusion3 um eine Reihe von Modellen mit Parametergrößen von 800 M bis 8 B handelt. Durch diesen Parameterbereich kann das Modell direkt auf vielen tragbaren Geräten ausgeführt werden, wodurch der Einsatz von KI deutlich reduziert wird

Dieser Artikel reicht aus, um etwas über autonomes Fahren und Flugbahnvorhersage zu lesen!

Feb 28, 2024 pm 07:20 PM

Dieser Artikel reicht aus, um etwas über autonomes Fahren und Flugbahnvorhersage zu lesen!

Feb 28, 2024 pm 07:20 PM

Die Trajektorienvorhersage spielt eine wichtige Rolle beim autonomen Fahren. Unter autonomer Fahrtrajektorienvorhersage versteht man die Vorhersage der zukünftigen Fahrtrajektorie des Fahrzeugs durch die Analyse verschiedener Daten während des Fahrvorgangs. Als Kernmodul des autonomen Fahrens ist die Qualität der Trajektorienvorhersage von entscheidender Bedeutung für die nachgelagerte Planungssteuerung. Die Trajektorienvorhersageaufgabe verfügt über einen umfangreichen Technologie-Stack und erfordert Vertrautheit mit der dynamischen/statischen Wahrnehmung des autonomen Fahrens, hochpräzisen Karten, Fahrspurlinien, Fähigkeiten in der neuronalen Netzwerkarchitektur (CNN&GNN&Transformer) usw. Der Einstieg ist sehr schwierig! Viele Fans hoffen, so schnell wie möglich mit der Flugbahnvorhersage beginnen zu können und Fallstricke zu vermeiden. Heute werde ich eine Bestandsaufnahme einiger häufiger Probleme und einführender Lernmethoden für die Flugbahnvorhersage machen! Einführungsbezogenes Wissen 1. Sind die Vorschaupapiere in Ordnung? A: Schauen Sie sich zuerst die Umfrage an, S

DualBEV: BEVFormer und BEVDet4D deutlich übertreffen, öffnen Sie das Buch!

Mar 21, 2024 pm 05:21 PM

DualBEV: BEVFormer und BEVDet4D deutlich übertreffen, öffnen Sie das Buch!

Mar 21, 2024 pm 05:21 PM

In diesem Artikel wird das Problem der genauen Erkennung von Objekten aus verschiedenen Blickwinkeln (z. B. Perspektive und Vogelperspektive) beim autonomen Fahren untersucht, insbesondere wie die Transformation von Merkmalen aus der Perspektive (PV) in den Raum aus der Vogelperspektive (BEV) effektiv ist implementiert über das Modul Visual Transformation (VT). Bestehende Methoden lassen sich grob in zwei Strategien unterteilen: 2D-zu-3D- und 3D-zu-2D-Konvertierung. 2D-zu-3D-Methoden verbessern dichte 2D-Merkmale durch die Vorhersage von Tiefenwahrscheinlichkeiten, aber die inhärente Unsicherheit von Tiefenvorhersagen, insbesondere in entfernten Regionen, kann zu Ungenauigkeiten führen. Während 3D-zu-2D-Methoden normalerweise 3D-Abfragen verwenden, um 2D-Features abzutasten und die Aufmerksamkeitsgewichte der Korrespondenz zwischen 3D- und 2D-Features über einen Transformer zu lernen, erhöht sich die Rechen- und Bereitstellungszeit.

„Minecraft' verwandelt sich in eine KI-Stadt und NPC-Bewohner spielen Rollenspiele wie echte Menschen

Jan 02, 2024 pm 06:25 PM

„Minecraft' verwandelt sich in eine KI-Stadt und NPC-Bewohner spielen Rollenspiele wie echte Menschen

Jan 02, 2024 pm 06:25 PM

Bitte beachten Sie, dass dieser kantige Mann die Stirn runzelt und über die Identität der „ungebetenen Gäste“ vor ihm nachdenkt. Es stellte sich heraus, dass sie sich in einer gefährlichen Situation befand, und als ihr dies klar wurde, begann sie schnell mit der mentalen Suche nach einer Strategie zur Lösung des Problems. Letztendlich entschloss sie sich, vom Unfallort zu fliehen, dann so schnell wie möglich Hilfe zu suchen und sofort Maßnahmen zu ergreifen. Gleichzeitig dachte die Person auf der Gegenseite das Gleiche wie sie... In „Minecraft“ gab es eine solche Szene, in der alle Charaktere von künstlicher Intelligenz gesteuert wurden. Jeder von ihnen hat eine einzigartige Identität. Das zuvor erwähnte Mädchen ist beispielsweise eine 17-jährige, aber kluge und mutige Kurierin. Sie haben die Fähigkeit, sich zu erinnern und zu denken und in dieser kleinen Stadt in Minecraft wie Menschen zu leben. Was sie antreibt, ist ein brandneues,

Erste Schritte mit Java-Crawlern: Verstehen Sie die grundlegenden Konzepte und Anwendungsmethoden

Jan 10, 2024 pm 07:42 PM

Erste Schritte mit Java-Crawlern: Verstehen Sie die grundlegenden Konzepte und Anwendungsmethoden

Jan 10, 2024 pm 07:42 PM

Eine vorläufige Studie zu Java-Crawlern: Um seine grundlegenden Konzepte und Verwendungsmöglichkeiten zu verstehen, sind spezifische Codebeispiele erforderlich. Mit der rasanten Entwicklung des Internets ist die Beschaffung und Verarbeitung großer Datenmengen für Unternehmen und Einzelpersonen zu einer unverzichtbaren Aufgabe geworden. Als automatisierte Datenerfassungsmethode kann Crawler (WebScraping) nicht nur schnell Daten im Internet sammeln, sondern auch große Datenmengen analysieren und verarbeiten. Crawler sind in vielen Data-Mining- und Information-Retrieval-Projekten zu einem sehr wichtigen Werkzeug geworden. In diesem Artikel wird ein grundlegender Überblick über Java-Crawler gegeben

Rezension! Tiefe Modellfusion (LLM/Basismodell/Verbundlernen/Feinabstimmung usw.)

Apr 18, 2024 pm 09:43 PM

Rezension! Tiefe Modellfusion (LLM/Basismodell/Verbundlernen/Feinabstimmung usw.)

Apr 18, 2024 pm 09:43 PM

Am 23. September wurde das Papier „DeepModelFusion:ASurvey“ von der National University of Defense Technology, JD.com und dem Beijing Institute of Technology veröffentlicht. Deep Model Fusion/Merging ist eine neue Technologie, die die Parameter oder Vorhersagen mehrerer Deep-Learning-Modelle in einem einzigen Modell kombiniert. Es kombiniert die Fähigkeiten verschiedener Modelle, um die Verzerrungen und Fehler einzelner Modelle zu kompensieren und so eine bessere Leistung zu erzielen. Die tiefe Modellfusion bei groß angelegten Deep-Learning-Modellen (wie LLM und Basismodellen) steht vor einigen Herausforderungen, darunter hohe Rechenkosten, hochdimensionaler Parameterraum, Interferenzen zwischen verschiedenen heterogenen Modellen usw. Dieser Artikel unterteilt bestehende Methoden zur Tiefenmodellfusion in vier Kategorien: (1) „Musterverbindung“, die Lösungen im Gewichtsraum über einen verlustreduzierenden Pfad verbindet, um eine bessere anfängliche Modellfusion zu erzielen

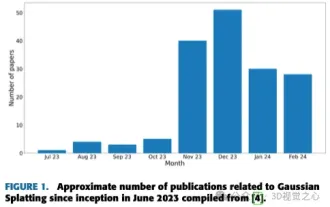

Mehr als nur 3D-Gauß! Aktueller Überblick über modernste 3D-Rekonstruktionstechniken

Jun 02, 2024 pm 06:57 PM

Mehr als nur 3D-Gauß! Aktueller Überblick über modernste 3D-Rekonstruktionstechniken

Jun 02, 2024 pm 06:57 PM

Oben geschrieben & Nach persönlichem Verständnis des Autors ist die bildbasierte 3D-Rekonstruktion eine anspruchsvolle Aufgabe, bei der aus einer Reihe von Eingabebildern auf die 3D-Form eines Objekts oder einer Szene geschlossen werden muss. Lernbasierte Methoden haben wegen ihrer Fähigkeit, 3D-Formen direkt abzuschätzen, Aufmerksamkeit erregt. Dieser Übersichtsartikel konzentriert sich auf modernste 3D-Rekonstruktionstechniken, einschließlich der Generierung neuartiger, unsichtbarer Ansichten. Es wird ein Überblick über die jüngsten Entwicklungen bei Gaußschen Splash-Methoden gegeben, einschließlich Eingabetypen, Modellstrukturen, Ausgabedarstellungen und Trainingsstrategien. Auch ungelöste Herausforderungen und zukünftige Ausrichtungen werden besprochen. Angesichts der rasanten Fortschritte auf diesem Gebiet und der zahlreichen Möglichkeiten zur Verbesserung der 3D-Rekonstruktionsmethoden scheint eine gründliche Untersuchung des Algorithmus von entscheidender Bedeutung zu sein. Daher bietet diese Studie einen umfassenden Überblick über die jüngsten Fortschritte in der Gaußschen Streuung. (Wischen Sie mit dem Daumen nach oben

Reibungsloser Build: So konfigurieren Sie die Maven-Image-Adresse richtig

Feb 20, 2024 pm 08:48 PM

Reibungsloser Build: So konfigurieren Sie die Maven-Image-Adresse richtig

Feb 20, 2024 pm 08:48 PM

Reibungsloser Build: So konfigurieren Sie die Maven-Image-Adresse richtig. Wenn Sie Maven zum Erstellen eines Projekts verwenden, ist es sehr wichtig, die richtige Image-Adresse zu konfigurieren. Durch die richtige Konfiguration der Spiegeladresse kann der Projektaufbau beschleunigt und Probleme wie Netzwerkverzögerungen vermieden werden. In diesem Artikel wird erläutert, wie die Maven-Spiegeladresse korrekt konfiguriert wird, und es werden spezifische Codebeispiele aufgeführt. Warum müssen Sie die Maven-Image-Adresse konfigurieren? Maven ist ein Projektmanagement-Tool, das automatisch Projekte erstellen, Abhängigkeiten verwalten, Berichte erstellen usw. kann. Normalerweise beim Erstellen eines Projekts in Maven