Welche Rolle spielt die Kafka-Verbrauchergruppe?

Die Funktionen der Kafka-Verbrauchergruppe: 2. Fehlertoleranz; 5. Automatische Failover- und Leader-Wahl; ; 9. Transaktionsunterstützung. Detaillierte Einführung: 1. Verbrauchergruppen sind der Kernmechanismus zur Realisierung des Kafka-Lastausgleichs. Durch die Organisation von Verbrauchern in Gruppen können die Partitionen des Themas mehreren Verbrauchern in der Gruppe zugewiesen werden, wodurch ein Lastausgleich erreicht wird Das Design von Verbrauchergruppen ermöglicht Fehlertoleranz und mehr.

Das Betriebssystem dieses Tutorials: Windows 10-System, DELL G3-Computer.

Eine Kafka-Verbrauchergruppe ist eine Reihe von Verbraucherinstanzen, die dieselbe Gruppen-ID teilen. Die Rolle der Verbrauchergruppe spiegelt sich hauptsächlich in den folgenden Aspekten wider:

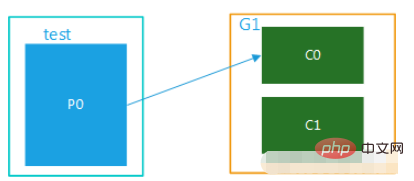

1. Lastausgleich: Die Verbrauchergruppe ist der Kernmechanismus für die Realisierung des Kafka-Lastausgleichs. Durch die Organisation von Verbrauchern in Gruppen können Partitionen eines Themas mehreren Verbrauchern innerhalb der Gruppe zugewiesen werden, wodurch ein Lastausgleich erreicht wird. Auf diese Weise muss jede Verbraucherinstanz nur Nachrichten von einem Teil der Partitionen verarbeiten, wodurch die Gesamtleistung des Verbrauchs verbessert wird.

2. Fehlertoleranz: Das Design der Verbrauchergruppe ermöglicht Fehlertoleranz. Wenn ein Verbraucher in der Gruppe ausfällt, können andere Verbraucher seine Partition übernehmen, um sicherzustellen, dass Nachrichten nicht verpasst werden und verhindert wird, dass der Ausfall eines Verbrauchers den normalen Betrieb des gesamten Systems beeinträchtigt.

3. Broadcast-Modus: Durch die Erstellung mehrerer Verbrauchergruppen kann der Broadcast-Modus von Nachrichten implementiert werden. In diesem Modus erhält jede Verbrauchergruppe alle Nachrichten aus dem Thema, wodurch eine Eins-zu-Viele-Nachrichtenübermittlung erreicht wird.

4. Flexibilität: Durch die Anpassung der Konfiguration von Verbrauchergruppen können verschiedene Verbrauchsmodelle implementiert werden, wie z. B. der Publish-Subscribe-Modus und der Warteschlangenmodus. Im Publish-Subscribe-Modus kann eine Nachricht von mehreren Verbrauchern gleichzeitig konsumiert werden; im Warteschlangenmodus kann eine Nachricht nur von einem Verbraucher konsumiert werden. Diese Flexibilität ermöglicht es Kafka, sich an unterschiedliche Geschäftsanforderungen und Datenverarbeitungsszenarien anzupassen.

5. Automatisches Failover und Leader-Wahl: Kafka bietet automatische Failover- und Leader-Wahlmechanismen, um die Stabilität und Verfügbarkeit des Systems sicherzustellen, wenn ein Fehler auftritt.

6. Dynamische Skalierbarkeit: Wenn die Geschäftsgröße erweitert oder verkleinert wird, kann die Anzahl der Mitglieder der Verbrauchergruppe dynamisch erhöht oder verringert werden. Neu beitretende Verbraucher beziehen automatisch Daten aus vorhandenen Kopien und beginnen mit dem Konsum; austretende Verbraucher spüren dies automatisch und hören mit dem Konsum auf. Diese dynamische Skalierbarkeit ermöglicht es Kafka, die Verarbeitungskapazitäten flexibel zu erweitern, wenn sich das Unternehmen entwickelt.

7. Reihenfolgegarantie: Innerhalb einer einzelnen Verbrauchergruppe basiert die Verbrauchsreihenfolge der Nachrichten auf der Reihenfolge der Nachrichten in der Partition. Dadurch kann Kafka die Reihenfolge der Nachrichten innerhalb einer einzelnen Verbrauchergruppe garantieren. Wenn eine globale Reihenfolge erforderlich ist, können alle zugehörigen Nachrichten an dieselbe Partition gesendet und von einem einzelnen Verbraucher verarbeitet werden.

8. Datenkomprimierung: Kafka unterstützt die Nachrichtenkomprimierungsfunktion, die den für die Speicherung erforderlichen Speicherplatz reduzieren kann, wenn der Speicherplatz begrenzt ist. Durch die Komprimierung mehrerer aufeinanderfolgender Nachrichten und deren Schreiben in nur einem Festplatten-E/A-Vorgang können Durchsatz und Effizienz erheblich verbessert werden.

9. Transaktionsunterstützung: Kafka unterstützt die Verarbeitung von Transaktionsnachrichten, wodurch die Atomizität und Konsistenz der Vorgänge beim Schreiben und Lesen von Nachrichten sichergestellt werden kann. Dies trägt dazu bei, eine zuverlässige Datenübertragung und einen konsistenten Datenstatus in verteilten Systemen zu erreichen.

In tatsächlichen Anwendungen müssen Sie zur Verwendung von Kafka-Verbrauchergruppen dieselbe Verbrauchergruppen-ID für Verbraucherinstanzen festlegen. Darüber hinaus können Parameter wie Leistung und Fehlertoleranz durch Anpassung der Konfiguration der Verbraucher optimiert werden. Sie können beispielsweise Parameter wie den Verbrauchsoffset des Verbrauchers, das Pull-Timeout des Verbrauchers und die maximale Verbrauchsrate des Verbrauchers anpassen, um bestimmte Geschäftsanforderungen zu erfüllen.

Kurz gesagt ist die Kafka-Verbrauchergruppe der Kernmechanismus, um den Lastausgleich, die Fehlertoleranz, die Flexibilität und andere Funktionen von Kafka zu erreichen. Durch die ordnungsgemäße Konfiguration und Verwendung von Verbrauchergruppen können die Gesamtleistung und Zuverlässigkeit von Kafka verbessert werden, um verschiedenen Geschäftsanforderungen und Datenverarbeitungsszenarien gerecht zu werden.

Das obige ist der detaillierte Inhalt vonWelche Rolle spielt die Kafka-Verbrauchergruppe?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1382

1382

52

52

So implementieren Sie eine Echtzeit-Aktienanalyse mit PHP und Kafka

Jun 28, 2023 am 10:04 AM

So implementieren Sie eine Echtzeit-Aktienanalyse mit PHP und Kafka

Jun 28, 2023 am 10:04 AM

Mit der Entwicklung des Internets und der Technologie sind digitale Investitionen zu einem Thema mit zunehmender Besorgnis geworden. Viele Anleger erforschen und studieren weiterhin Anlagestrategien in der Hoffnung, eine höhere Kapitalrendite zu erzielen. Im Aktienhandel ist die Aktienanalyse in Echtzeit für die Entscheidungsfindung sehr wichtig, und der Einsatz der Kafka-Echtzeit-Nachrichtenwarteschlange und der PHP-Technologie ist ein effizientes und praktisches Mittel. 1. Einführung in Kafka Kafka ist ein von LinkedIn entwickeltes verteiltes Publish- und Subscribe-Messagingsystem mit hohem Durchsatz. Die Hauptmerkmale von Kafka sind

So geben Sie mit @KafkaListener in Springboot + Kafka dynamisch mehrere Themen an

May 20, 2023 pm 08:58 PM

So geben Sie mit @KafkaListener in Springboot + Kafka dynamisch mehrere Themen an

May 20, 2023 pm 08:58 PM

Erklären Sie, dass es sich bei diesem Projekt um ein Springboot+Kafak-Integrationsprojekt handelt und daher die Kafak-Verbrauchsanmerkung @KafkaListener in Springboot verwendet. Konfigurieren Sie zunächst mehrere durch Kommas getrennte Themen in application.properties. Methode: Verwenden Sie den SpEl-Ausdruck von Spring, um Themen wie folgt zu konfigurieren: @KafkaListener(topics="#{’${topics}’.split(',')}"), um das Programm auszuführen. Der Konsolendruckeffekt ist wie folgt

Wie SpringBoot die Kafka-Konfigurationstoolklasse integriert

May 12, 2023 pm 09:58 PM

Wie SpringBoot die Kafka-Konfigurationstoolklasse integriert

May 12, 2023 pm 09:58 PM

Spring-Kafka basiert auf der Integration der Java-Version von Kafkaclient und Spring. Es bietet KafkaTemplate, das verschiedene Methoden für eine einfache Bedienung kapselt. Es kapselt den Kafka-Client von Apache und es ist nicht erforderlich, den Client zu importieren, um von der Organisation abhängig zu sein .springframework.kafkaspring-kafkaYML-Konfiguration. kafka:#bootstrap-servers:server1:9092,server2:9093#kafka-Entwicklungsadresse,#producer-Konfigurationsproduzent:#Serialisierungs- und Deserialisierungsklassenschlüssel, bereitgestellt von Kafka

So erstellen Sie Echtzeit-Datenverarbeitungsanwendungen mit React und Apache Kafka

Sep 27, 2023 pm 02:25 PM

So erstellen Sie Echtzeit-Datenverarbeitungsanwendungen mit React und Apache Kafka

Sep 27, 2023 pm 02:25 PM

So verwenden Sie React und Apache Kafka zum Erstellen von Echtzeit-Datenverarbeitungsanwendungen. Einführung: Mit dem Aufkommen von Big Data und Echtzeit-Datenverarbeitung ist die Erstellung von Echtzeit-Datenverarbeitungsanwendungen für viele Entwickler zum Ziel geworden. Die Kombination von React, einem beliebten Front-End-Framework, und Apache Kafka, einem leistungsstarken verteilten Messaging-System, kann uns beim Aufbau von Echtzeit-Datenverarbeitungsanwendungen helfen. In diesem Artikel wird erläutert, wie Sie mit React und Apache Kafka Echtzeit-Datenverarbeitungsanwendungen erstellen

Fünf Auswahlmöglichkeiten an Visualisierungstools zur Erkundung von Kafka

Feb 01, 2024 am 08:03 AM

Fünf Auswahlmöglichkeiten an Visualisierungstools zur Erkundung von Kafka

Feb 01, 2024 am 08:03 AM

Fünf Optionen für Kafka-Visualisierungstools ApacheKafka ist eine verteilte Stream-Verarbeitungsplattform, die große Mengen an Echtzeitdaten verarbeiten kann. Es wird häufig zum Aufbau von Echtzeit-Datenpipelines, Nachrichtenwarteschlangen und ereignisgesteuerten Anwendungen verwendet. Die Visualisierungstools von Kafka können Benutzern dabei helfen, Kafka-Cluster zu überwachen und zu verwalten und Kafka-Datenflüsse besser zu verstehen. Im Folgenden finden Sie eine Einführung in fünf beliebte Kafka-Visualisierungstools: ConfluentControlCenterConfluent

Vergleichende Analyse der Kafka-Visualisierungstools: Wie wählt man das am besten geeignete Tool aus?

Jan 05, 2024 pm 12:15 PM

Vergleichende Analyse der Kafka-Visualisierungstools: Wie wählt man das am besten geeignete Tool aus?

Jan 05, 2024 pm 12:15 PM

Wie wählt man das richtige Kafka-Visualisierungstool aus? Vergleichende Analyse von fünf Tools Einführung: Kafka ist ein leistungsstarkes verteiltes Nachrichtenwarteschlangensystem mit hohem Durchsatz, das im Bereich Big Data weit verbreitet ist. Mit der Popularität von Kafka benötigen immer mehr Unternehmen und Entwickler ein visuelles Tool zur einfachen Überwachung und Verwaltung von Kafka-Clustern. In diesem Artikel werden fünf häufig verwendete Kafka-Visualisierungstools vorgestellt und ihre Merkmale und Funktionen verglichen, um den Lesern bei der Auswahl des Tools zu helfen, das ihren Anforderungen entspricht. 1. KafkaManager

Beispielcode für ein Springboot-Projekt zum Konfigurieren mehrerer Kafka

May 14, 2023 pm 12:28 PM

Beispielcode für ein Springboot-Projekt zum Konfigurieren mehrerer Kafka

May 14, 2023 pm 12:28 PM

1.spring-kafkaorg.springframework.kafkaspring-kafka1.3.5.RELEASE2. Informationen zur Konfigurationsdatei kafka.bootstrap-servers=localhost:9092kafka.consumer.group.id=20230321#Die Anzahl der Threads, die gleichzeitig verwendet werden können (normalerweise konsistent). mit der Anzahl der Partitionen )kafka.consumer.concurrency=10kafka.consumer.enable.auto.commit=falsekafka.boo

Die Praxis von Go-Zero und Kafka+Avro: Aufbau eines leistungsstarken interaktiven Datenverarbeitungssystems

Jun 23, 2023 am 09:04 AM

Die Praxis von Go-Zero und Kafka+Avro: Aufbau eines leistungsstarken interaktiven Datenverarbeitungssystems

Jun 23, 2023 am 09:04 AM

In den letzten Jahren haben mit dem Aufkommen von Big Data und aktiven Open-Source-Communities immer mehr Unternehmen begonnen, nach leistungsstarken interaktiven Datenverarbeitungssystemen zu suchen, um den wachsenden Datenanforderungen gerecht zu werden. In dieser Welle von Technologie-Upgrades werden Go-Zero und Kafka+Avro von immer mehr Unternehmen beachtet und übernommen. go-zero ist ein auf der Golang-Sprache entwickeltes Microservice-Framework. Es zeichnet sich durch hohe Leistung, Benutzerfreundlichkeit, einfache Erweiterung und einfache Wartung aus und soll Unternehmen dabei helfen, schnell effiziente Microservice-Anwendungssysteme aufzubauen. sein schnelles Wachstum