Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Neue BEV LV Fusion-Lösung: Lift-Attend-Splat über BEVFusion hinaus

Neue BEV LV Fusion-Lösung: Lift-Attend-Splat über BEVFusion hinaus

Neue BEV LV Fusion-Lösung: Lift-Attend-Splat über BEVFusion hinaus

Papier: Lift-Attend-Splat-Methode für die Fusion von Vogelperspektivenkameras und Lidar mithilfe der Transformer-Technologie

Bitte klicken Sie auf den Link, um die Datei anzuzeigen: https://arxiv.org/pdf/2312.14919.pdf

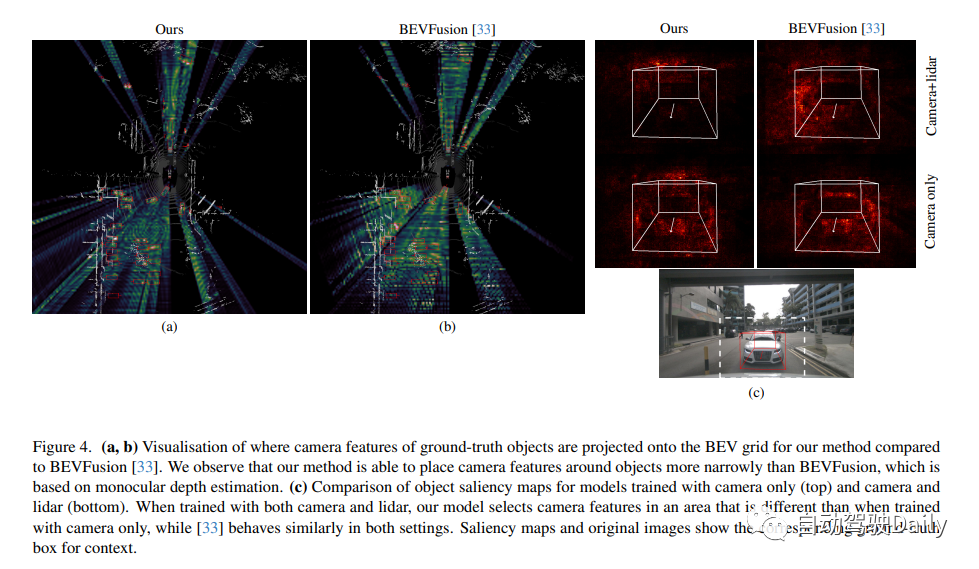

Zur Sicherheit- Bei kritischen Anwendungen wie dem autonomen Fahren ist es entscheidend, komplementäre Sensormodalitäten zu kombinieren. Neuere Kamera-Lidar-Fusionsmethoden für autonomes Fahren verwenden eine monokulare Tiefenschätzung, um die Wahrnehmung zu verbessern. Dies ist jedoch eine schwierige Aufgabe im Vergleich zur direkten Nutzung von Tiefeninformationen aus Lidar. Unsere Studie kommt zu dem Schluss, dass dieser Ansatz die Tiefeninformationen nicht vollständig ausnutzt, und zeigt, dass eine naive Verbesserung der Tiefenschätzung nicht zu einer Verbesserung der Objekterkennungsleistung führt. Überraschenderweise beeinträchtigt das vollständige Entfernen der Tiefenschätzung nicht die Objekterkennungsleistung

Dies deutet darauf hin, dass die Abhängigkeit von der monokularen Tiefe ein unnötiger architektonischer Engpass bei der Kamera-Lidar-Fusion sein könnte. Diese Studie schlägt eine neue Fusionsmethode vor, die die monokulare Tiefenschätzung vollständig umgeht und stattdessen einen einfachen Aufmerksamkeitsmechanismus verwendet, um Kamera- und Lidar-Merkmale in einem BEV-Gitter auszuwählen und zu fusionieren. Die Ergebnisse zeigen, dass das vorgeschlagene Modell in der Lage ist, die Verwendung von Kamerafunktionen basierend auf der Verfügbarkeit von Lidar-Funktionen anzupassen und eine bessere 3D-Erkennungsleistung im nuScenes-Datensatz aufweist als Basismodelle, die auf monokularer Tiefenschätzung basieren.

Einführung in diese Studie Eine neue Kamera -Lidar-Fusion-Methode namens „Lift Attented Splat“ entwickelt. Diese Methode vermeidet eine monokulare Tiefenschätzung und nutzt stattdessen einen einfachen Transformator zur Auswahl und Fusion von Kamera- und Lidar-Funktionen im BEV. Experimente belegen, dass diese Forschungsmethode im Vergleich zu Methoden, die auf monokularer Tiefenschätzung basieren, Kameras besser nutzen und die Objekterkennungsleistung verbessern kann. Die Beiträge dieser Studie sind wie folgt:

- Die auf dem Lift-Splat-Paradigma basierende Kamera-Lidar-Fusionsmethode nutzt die Tiefe nicht wie erwartet aus. Insbesondere zeigen wir, dass sie gleich gut oder besser abschneiden, wenn die monokulare Tiefenvorhersage vollständig entfernt wird.

- In diesem Artikel wird eine neue Kamera-Lidar-Fusionsmethode vorgestellt, die einen einfachen Aufmerksamkeitsmechanismus verwendet, um Kamera- und Lidar-Funktionen in reinem BEV zu fusionieren. Das Papier zeigt, dass es im Vergleich zu Modellen, die auf dem Lift-Splat-Paradigma basieren, Kameras besser nutzen und die 3D-Erkennungsleistung verbessern kann.

Einführung in die Hauptstruktur

Die Genauigkeit der Tiefenvorhersage ist normalerweise gering. Qualitative und quantitative Analysen können durchgeführt werden, indem die von BEVFusion vorhergesagte Tiefenqualität mit LIDAR-Tiefenkarten unter Verwendung des absoluten relativen Fehlers (Abs.Rel.) und des quadratischen Mittelfehlers (RMSE) verglichen wird. Wie in Abbildung 1 dargestellt, spiegelt die Tiefenvorhersage die Struktur der Szene nicht genau wider und unterscheidet sich erheblich von der Lidar-Tiefenkarte, was darauf hindeutet, dass die monokulare Tiefe nicht wie erwartet vollständig genutzt wird. Die Studie ergab auch, dass eine Verbesserung der Tiefenvorhersage die Objekterkennungsleistung nicht verbessert! Das vollständige Entfernen der Tiefenvorhersage hat keinen Einfluss auf die Objekterkennungsleistung

Wir schlagen eine Kamera-Lidar-Fusionsmethode vor, die die monokulare Tiefenschätzung vollständig umgeht und stattdessen einen einfachen Transformator verwendet, um Kamera- und Lidar-Funktionen aus der Vogelperspektive zu fusionieren. Aufgrund der großen Anzahl von Kamera- und Lidar-Funktionen und der quadratischen Natur der Aufmerksamkeit ist es jedoch schwierig, die Transformatorarchitektur einfach auf das Kamera-Lidar-Fusionsproblem anzuwenden. Bei der Projektion von Kameramerkmalen in BEV kann die Geometrie des Problems genutzt werden, um den Aufmerksamkeitsbereich erheblich einzuschränken, da Kameramerkmale nur zur Position entlang ihrer entsprechenden Strahlen beitragen sollten. Wir wenden diese Idee auf den Fall der Kamera-Lidar-Fusion an und stellen eine einfache Fusionsmethode vor, die die Kreuzaufmerksamkeit zwischen Säulen in der Kameraebene und Polarstrahlen im Lidar-BEV-Gitter nutzt! Anstatt die monokulare Tiefe vorherzusagen, lernt die Kreuzaufmerksamkeit, welche Kameramerkmale im Kontext, der durch LIDAR-Merkmale entlang ihrer Strahlen bereitgestellt wird, am hervorstechendsten sind

Unser Modell hat eine ähnliche Gesamtarchitektur wie Methoden, die auf dem Lift-Splat-Paradigma basieren, zusätzlich zur Projektion von Kameramerkmalen im BEV. Wie in der Abbildung unten dargestellt, besteht es aus einem Kamera- und Lidar-Backbone, einem Modul, das jedes modale Merkmal unabhängig generiert, einem Projektions- und Fusionsmodul, das die Kameramerkmale in das BEV einbettet und sie mit dem Lidar verschmilzt, und einem Erkennungskopf. Bei der Betrachtung der Zielerkennung besteht die endgültige Ausgabe des Modells aus den Attributen des Ziels in der Szene, einschließlich Position, Abmessung, Richtung, Geschwindigkeit und Klassifizierungsinformationen, dargestellt in Form eines 3D-Begrenzungsrahmens

Lift Attented Splat-Kamera-Lidar-Fusion Architektur ist unten dargestellt. (Links) Gesamtarchitektur: Merkmale der Kamera und des Lidar-Backbones werden miteinander verschmolzen, bevor sie an den Erkennungskopf weitergeleitet werden. (Einschub) Die Geometrie unserer 3D-Projektion: Der „Lift“-Schritt bettet die LIDAR-BEV-Features in den projizierten Horizont ein, indem bilineares Sampling verwendet wird, um die LIDAR-Features entlang der Z-Richtung anzuheben. Der „Splat“-Schritt entspricht der inversen Transformation, da er bilineares Sampling verwendet, um die Merkmale vom projizierten Horizont zurück auf das BEV-Gitter zu projizieren, wiederum entlang der Z-Richtung! Rechts finden Sie die Details zum Projektmodul.

Experimentelle Ergebnisse

Originallink: https://mp.weixin.qq.com/s/D7xgvrp8633S2SeUfCRFXQ

Das obige ist der detaillierte Inhalt vonNeue BEV LV Fusion-Lösung: Lift-Attend-Splat über BEVFusion hinaus. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

Wie lässt sich das Long-Tail-Problem in autonomen Fahrszenarien lösen?

Jun 02, 2024 pm 02:44 PM

Wie lässt sich das Long-Tail-Problem in autonomen Fahrszenarien lösen?

Jun 02, 2024 pm 02:44 PM

Gestern wurde ich während des Interviews gefragt, ob ich irgendwelche Long-Tail-Fragen gestellt hätte, also dachte ich, ich würde eine kurze Zusammenfassung geben. Das Long-Tail-Problem des autonomen Fahrens bezieht sich auf Randfälle bei autonomen Fahrzeugen, also mögliche Szenarien mit geringer Eintrittswahrscheinlichkeit. Das wahrgenommene Long-Tail-Problem ist einer der Hauptgründe, die derzeit den betrieblichen Designbereich intelligenter autonomer Einzelfahrzeugfahrzeuge einschränken. Die zugrunde liegende Architektur und die meisten technischen Probleme des autonomen Fahrens wurden gelöst, und die verbleibenden 5 % der Long-Tail-Probleme wurden nach und nach zum Schlüssel zur Einschränkung der Entwicklung des autonomen Fahrens. Zu diesen Problemen gehören eine Vielzahl fragmentierter Szenarien, Extremsituationen und unvorhersehbares menschliches Verhalten. Der „Long Tail“ von Randszenarien beim autonomen Fahren bezieht sich auf Randfälle in autonomen Fahrzeugen (AVs). Randfälle sind mögliche Szenarien mit geringer Eintrittswahrscheinlichkeit. diese seltenen Ereignisse

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Stellen Sie sich ein Modell der künstlichen Intelligenz vor, das nicht nur die Fähigkeit besitzt, die traditionelle Datenverarbeitung zu übertreffen, sondern auch eine effizientere Leistung zu geringeren Kosten erzielt. Dies ist keine Science-Fiction, DeepSeek-V2[1], das weltweit leistungsstärkste Open-Source-MoE-Modell, ist da. DeepSeek-V2 ist ein leistungsstarkes MoE-Sprachmodell (Mix of Experts) mit den Merkmalen eines wirtschaftlichen Trainings und einer effizienten Inferenz. Es besteht aus 236B Parametern, von denen 21B zur Aktivierung jedes Markers verwendet werden. Im Vergleich zu DeepSeek67B bietet DeepSeek-V2 eine stärkere Leistung, spart gleichzeitig 42,5 % der Trainingskosten, reduziert den KV-Cache um 93,3 % und erhöht den maximalen Generierungsdurchsatz auf das 5,76-fache. DeepSeek ist ein Unternehmen, das sich mit allgemeiner künstlicher Intelligenz beschäftigt

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

Anfang dieses Monats schlugen Forscher des MIT und anderer Institutionen eine vielversprechende Alternative zu MLP vor – KAN. KAN übertrifft MLP in Bezug auf Genauigkeit und Interpretierbarkeit. Und es kann MLP, das mit einer größeren Anzahl von Parametern ausgeführt wird, mit einer sehr kleinen Anzahl von Parametern übertreffen. Beispielsweise gaben die Autoren an, dass sie KAN nutzten, um die Ergebnisse von DeepMind mit einem kleineren Netzwerk und einem höheren Automatisierungsgrad zu reproduzieren. Konkret verfügt DeepMinds MLP über etwa 300.000 Parameter, während KAN nur etwa 200 Parameter hat. KAN hat eine starke mathematische Grundlage wie MLP und basiert auf dem universellen Approximationssatz, während KAN auf dem Kolmogorov-Arnold-Darstellungssatz basiert. Wie in der folgenden Abbildung gezeigt, hat KAN

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas tritt offiziell in die Ära der Elektroroboter ein! Gestern hat sich der hydraulische Atlas einfach „unter Tränen“ von der Bühne der Geschichte zurückgezogen. Heute gab Boston Dynamics bekannt, dass der elektrische Atlas im Einsatz ist. Es scheint, dass Boston Dynamics im Bereich kommerzieller humanoider Roboter entschlossen ist, mit Tesla zu konkurrieren. Nach der Veröffentlichung des neuen Videos wurde es innerhalb von nur zehn Stunden bereits von mehr als einer Million Menschen angesehen. Die alten Leute gehen und neue Rollen entstehen. Das ist eine historische Notwendigkeit. Es besteht kein Zweifel, dass dieses Jahr das explosive Jahr der humanoiden Roboter ist. Netizens kommentierten: Die Weiterentwicklung der Roboter hat dazu geführt, dass die diesjährige Eröffnungsfeier wie Menschen aussieht, und der Freiheitsgrad ist weitaus größer als der von Menschen. Aber ist das wirklich kein Horrorfilm? Zu Beginn des Videos liegt Atlas ruhig auf dem Boden, scheinbar auf dem Rücken. Was folgt, ist atemberaubend

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Die von Google geförderte Leistung von JAX hat in jüngsten Benchmark-Tests die von Pytorch und TensorFlow übertroffen und belegt bei 7 Indikatoren den ersten Platz. Und der Test wurde nicht auf der TPU mit der besten JAX-Leistung durchgeführt. Obwohl unter Entwicklern Pytorch immer noch beliebter ist als Tensorflow. Aber in Zukunft werden möglicherweise mehr große Modelle auf Basis der JAX-Plattform trainiert und ausgeführt. Modelle Kürzlich hat das Keras-Team drei Backends (TensorFlow, JAX, PyTorch) mit der nativen PyTorch-Implementierung und Keras2 mit TensorFlow verglichen. Zunächst wählen sie eine Reihe von Mainstream-Inhalten aus

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI verändert tatsächlich die Mathematik. Vor kurzem hat Tao Zhexuan, der diesem Thema große Aufmerksamkeit gewidmet hat, die neueste Ausgabe des „Bulletin of the American Mathematical Society“ (Bulletin der American Mathematical Society) weitergeleitet. Zum Thema „Werden Maschinen die Mathematik verändern?“ äußerten viele Mathematiker ihre Meinung. Der gesamte Prozess war voller Funken, knallhart und aufregend. Der Autor verfügt über eine starke Besetzung, darunter der Fields-Medaillengewinner Akshay Venkatesh, der chinesische Mathematiker Zheng Lejun, der NYU-Informatiker Ernest Davis und viele andere bekannte Wissenschaftler der Branche. Die Welt der KI hat sich dramatisch verändert. Viele dieser Artikel wurden vor einem Jahr eingereicht.

nuScenes' neuestes SOTA |. SparseAD: Sparse-Abfrage hilft effizientes durchgängiges autonomes Fahren!

Apr 17, 2024 pm 06:22 PM

nuScenes' neuestes SOTA |. SparseAD: Sparse-Abfrage hilft effizientes durchgängiges autonomes Fahren!

Apr 17, 2024 pm 06:22 PM

Vorab geschrieben und Ausgangspunkt Das End-to-End-Paradigma verwendet ein einheitliches Framework, um Multitasking in autonomen Fahrsystemen zu erreichen. Trotz der Einfachheit und Klarheit dieses Paradigmas bleibt die Leistung von End-to-End-Methoden für das autonome Fahren bei Teilaufgaben immer noch weit hinter Methoden für einzelne Aufgaben zurück. Gleichzeitig erschweren die in früheren End-to-End-Methoden weit verbreiteten Funktionen der dichten Vogelperspektive (BEV) die Skalierung auf mehr Modalitäten oder Aufgaben. Hier wird ein Sparse-Search-zentriertes End-to-End-Paradigma für autonomes Fahren (SparseAD) vorgeschlagen, bei dem die Sparse-Suche das gesamte Fahrszenario, einschließlich Raum, Zeit und Aufgaben, ohne dichte BEV-Darstellung vollständig abbildet. Insbesondere ist eine einheitliche, spärliche Architektur für die Aufgabenerkennung einschließlich Erkennung, Verfolgung und Online-Zuordnung konzipiert. Zudem schwer

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Das neueste Video von Teslas Roboter Optimus ist veröffentlicht und er kann bereits in der Fabrik arbeiten. Bei normaler Geschwindigkeit sortiert es Batterien (Teslas 4680-Batterien) so: Der Beamte hat auch veröffentlicht, wie es bei 20-facher Geschwindigkeit aussieht – auf einer kleinen „Workstation“, pflücken und pflücken und pflücken: Dieses Mal wird es freigegeben. Eines der Highlights Der Vorteil des Videos besteht darin, dass Optimus diese Arbeit in der Fabrik völlig autonom und ohne menschliches Eingreifen während des gesamten Prozesses erledigt. Und aus Sicht von Optimus kann es auch die krumme Batterie aufnehmen und platzieren, wobei der Schwerpunkt auf der automatischen Fehlerkorrektur liegt: In Bezug auf die Hand von Optimus gab der NVIDIA-Wissenschaftler Jim Fan eine hohe Bewertung ab: Die Hand von Optimus ist der fünffingrige Roboter der Welt am geschicktesten. Seine Hände sind nicht nur taktil