Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

HuggingFace: Zwei Alpakas werden zusammengefügt, nachdem Kopf und Schwanz entfernt wurden

HuggingFace: Zwei Alpakas werden zusammengefügt, nachdem Kopf und Schwanz entfernt wurden

HuggingFace: Zwei Alpakas werden zusammengefügt, nachdem Kopf und Schwanz entfernt wurden

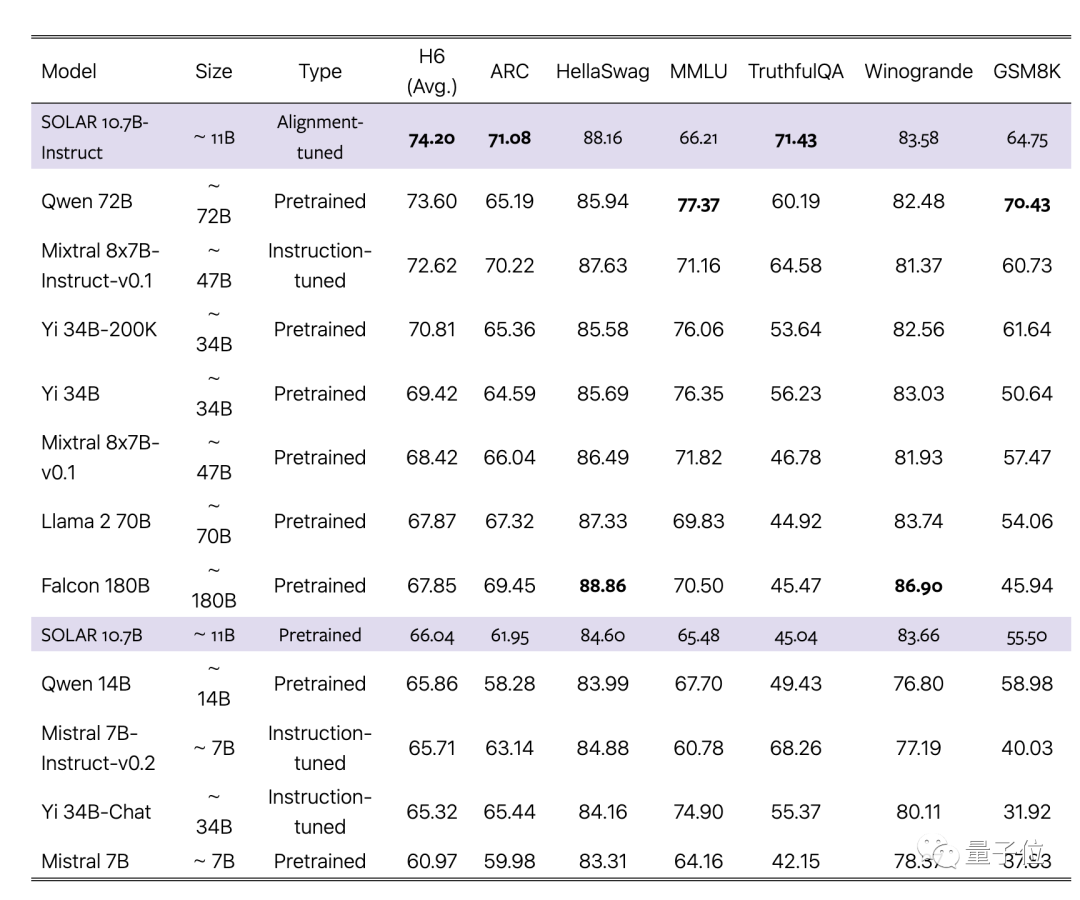

Die Open-Source-Rangliste für große Models von HuggingFace wurde erneut gestrichen.

Die erste Reihe ist ausschließlich mit der Feinabstimmungsversion SOLAR 10.7B besetzt und verdrängt damit die verschiedenen Feinabstimmungsversionen des Mixtral 8x7B von vor ein paar Wochen.

Was ist der Ursprung des großen SOLAR-Modells?

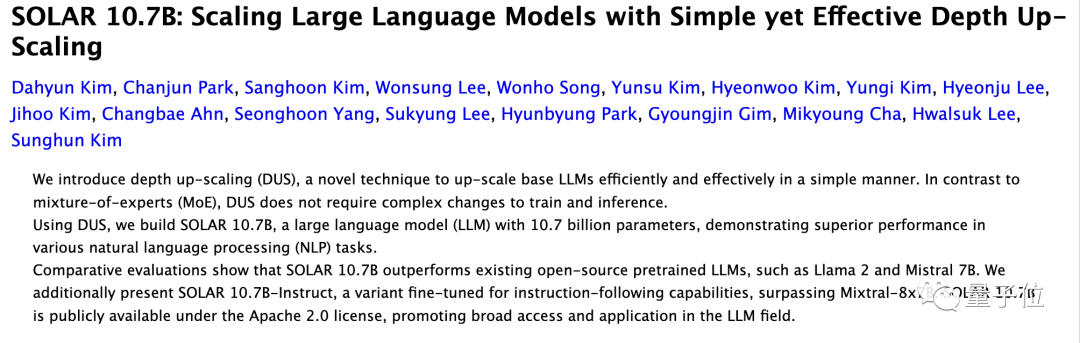

Verwandtes Papier wurde gerade auf ArXiv hochgeladen, vom koreanischen Unternehmen Upstage AI, das eine neue Methode zur Erweiterung großer Modelle Tiefen-Upscaling (DUS) verwendet.

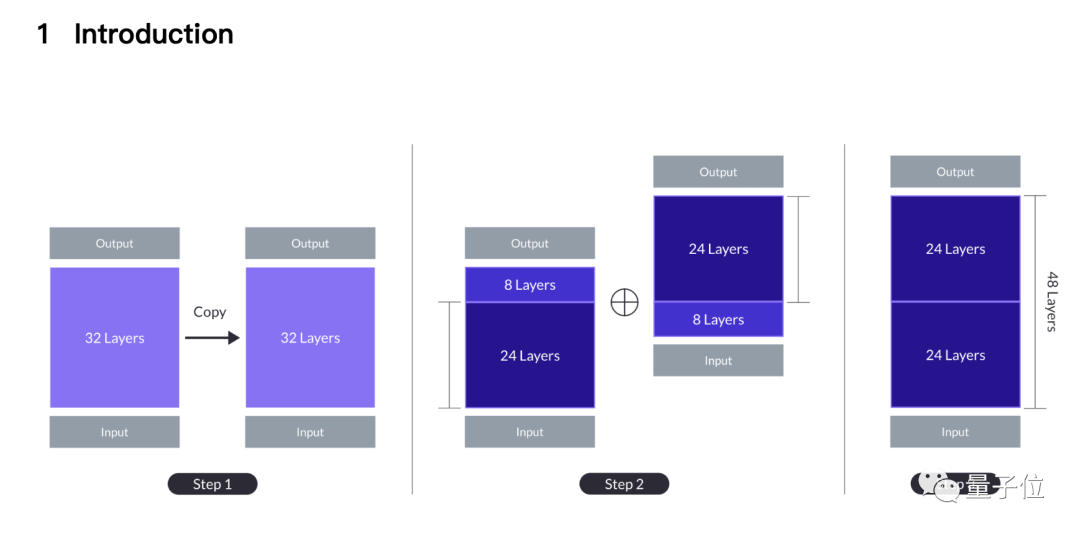

Um es einfach auszudrücken: werden zwei 7B-Alpakas und ihre Schwänze abgetrennt, einem werden die ersten 8 Schichten abgeschnitten, und dem anderen werden die letzten 8 Schichten abgeschnitten.

Die verbleibenden zwei 24 Schichten werden zusammengenäht Die 24. Schicht des ersten Modells wird mit der 9. Schicht des zweiten Modells gespleißt und wird schließlich zu einem neuen 48-schichtigen 10,7B großen Modell.

Das Papier behauptet, dass die neue Methode traditionelle Erweiterungsmethoden wie MoE übertrifft und genau dieselbe Infrastruktur wie das grundlegende große Modell nutzen kann.

Es sind keine zusätzlichen Module wie Gated Networks erforderlich, das Trainingsframework ist für MoE optimiert und es besteht keine Notwendigkeit, CUDA-Kernel für eine schnelle Inferenz anzupassen. Es kann nahtlos in bestehende Methoden integriert werden und gleichzeitig die Effizienz beibehalten.

Das Team wählte Mistral 7B, das stärkste einzelne große Modell von 7B, als Basismaterial und verwendete neue Methoden, um es zusammenzufügen, um die Originalversion und die MoE-Version zu übertreffen.

Gleichzeitig übertrifft die abgestimmte Instruct-Version auch die entsprechende MoE-Instruct-Version.

Führen Sie die Nähte bis zum Ende durch

Warum ist diese Spleißmethode eine Intuition?

Beginnen Sie mit der einfachsten Erweiterungsmethode, bei der das 32-lagige Grundmodell zweimal wiederholt wird, um daraus ein 64-lagiges Modell zu machen.

Der Vorteil davon ist, dass es keine Heterogenität gibt, alle Schichten stammen vom großen Basismodell, aber die Schichten 32 und 33 (wie Schicht 1) haben größere „Schichten an den Nähten Abstand“ (Schichtenabstand). ).

Frühere Untersuchungen haben gezeigt, dass verschiedene Schichten von Transformer unterschiedliche Dinge tun. Beispielsweise sind tiefere Schichten besser in der Lage, abstraktere Konzepte zu verarbeiten.

Das Team geht davon aus, dass ein übermäßiger Schichtabstand die Fähigkeit des Modells beeinträchtigen kann, vorab trainierte Gewichte effektiv zu nutzen.

Eine mögliche Lösung besteht darin, die Mittelschicht zu opfern und dadurch den Unterschied an den Nähten zu verringern. Hier wurde die DUS-Methode geboren.

Basierend auf dem Kompromiss zwischen Leistung und Modellgröße entschied sich das Team dafür, 8 Schichten aus jedem Modell zu streichen und die Nähte von 32 Schichten auf Schicht 1 auf 24 Schichten auf Schicht 9 zu ändern.

Die Leistung des einfach gespleißten Modells wird zunächst immer noch geringer sein als die des ursprünglichen Basismodells, kann sich jedoch nach fortgesetztem Vortraining schnell erholen.

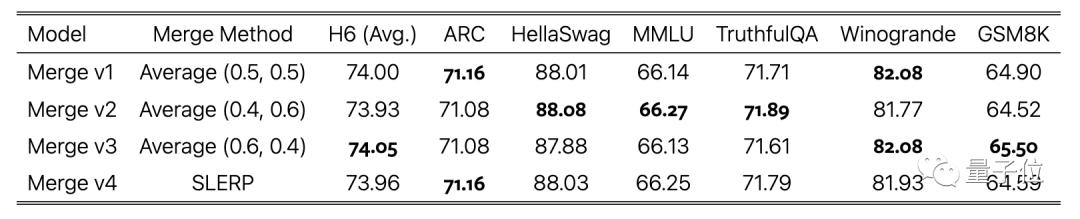

In der Feinabstimmungsphase der Anweisungen haben wir zusätzlich zur Verwendung von Open-Source-Datensätzen auch mathematisch verbesserte Datensätze erstellt und DPO in der Ausrichtungsphase verwendet.

Der letzte Schritt besteht darin, den Durchschnitt der mit unterschiedlichen Datensätzen trainierten Modellversionen zu gewichten, was auch den Abschluss des Stitchings darstellt.

Einige Internetnutzer stellten die Möglichkeit eines Testdatenlecks in Frage. Auch das

-Team berücksichtigte dies und berichtete im Anhang des Papiers ausdrücklich über die Datenverschmutzungstestergebnisse, die einen niedrigen Wert zeigten.

Schließlich sind sowohl das SOLAR 10.7B-Basismodell als auch das fein abgestimmte Modell Open Source unter der Apache 2.0-Lizenz.

Internetnutzer, die es ausprobiert haben, haben berichtet, dass es beim Extrahieren von Daten aus Daten im JSON-Format gut funktioniert.

Papieradresse: https://arxiv.org/abs/2312.15166

Das obige ist der detaillierte Inhalt vonHuggingFace: Zwei Alpakas werden zusammengefügt, nachdem Kopf und Schwanz entfernt wurden. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1378

1378

52

52

So optimieren Sie die Leistung von Debian Readdir

Apr 13, 2025 am 08:48 AM

So optimieren Sie die Leistung von Debian Readdir

Apr 13, 2025 am 08:48 AM

In Debian -Systemen werden Readdir -Systemaufrufe zum Lesen des Verzeichnisinhalts verwendet. Wenn seine Leistung nicht gut ist, probieren Sie die folgende Optimierungsstrategie aus: Vereinfachen Sie die Anzahl der Verzeichnisdateien: Teilen Sie große Verzeichnisse so weit wie möglich in mehrere kleine Verzeichnisse auf und reduzieren Sie die Anzahl der gemäß Readdir -Anrufe verarbeiteten Elemente. Aktivieren Sie den Verzeichnis -Inhalt Caching: Erstellen Sie einen Cache -Mechanismus, aktualisieren Sie den Cache regelmäßig oder bei Änderungen des Verzeichnisinhalts und reduzieren Sie häufige Aufrufe an Readdir. Speicher -Caches (wie Memcached oder Redis) oder lokale Caches (wie Dateien oder Datenbanken) können berücksichtigt werden. Nehmen Sie eine effiziente Datenstruktur an: Wenn Sie das Verzeichnis -Traversal selbst implementieren, wählen Sie effizientere Datenstrukturen (z.

So implementieren Sie die Dateisortierung nach Debian Readdir

Apr 13, 2025 am 09:06 AM

So implementieren Sie die Dateisortierung nach Debian Readdir

Apr 13, 2025 am 09:06 AM

In Debian -Systemen wird die Readdir -Funktion zum Lesen des Verzeichnisinhalts verwendet, aber die Reihenfolge, in der sie zurückgibt, ist nicht vordefiniert. Um Dateien in einem Verzeichnis zu sortieren, müssen Sie zuerst alle Dateien lesen und dann mit der QSORT -Funktion sortieren. Der folgende Code zeigt, wie Verzeichnisdateien mithilfe von Readdir und QSORT in Debian System sortiert werden:#include#include#include#include // benutzerdefinierte Vergleichsfunktion, verwendet für QSortIntCompare (constvoid*a, constvoid*b) {rettrcmp (*(*(*(

So setzen Sie die Debian Apache -Protokollebene fest

Apr 13, 2025 am 08:33 AM

So setzen Sie die Debian Apache -Protokollebene fest

Apr 13, 2025 am 08:33 AM

In diesem Artikel wird beschrieben, wie Sie die Protokollierungsstufe des Apacheweb -Servers im Debian -System anpassen. Durch Ändern der Konfigurationsdatei können Sie die ausführliche Ebene der von Apache aufgezeichneten Protokollinformationen steuern. Methode 1: Ändern Sie die Hauptkonfigurationsdatei, um die Konfigurationsdatei zu finden: Die Konfigurationsdatei von Apache2.x befindet sich normalerweise im Verzeichnis/etc/apache2/. Der Dateiname kann je nach Installationsmethode Apache2.conf oder httpd.conf sein. Konfigurationsdatei bearbeiten: Öffnen Sie die Konfigurationsdatei mit Stammberechtigungen mit einem Texteditor (z. B. Nano): Sudonano/etc/apache2/apache2.conf

Debian Mail Server Firewall -Konfigurationstipps

Apr 13, 2025 am 11:42 AM

Debian Mail Server Firewall -Konfigurationstipps

Apr 13, 2025 am 11:42 AM

Das Konfigurieren der Firewall eines Debian -Mailservers ist ein wichtiger Schritt zur Gewährleistung der Serversicherheit. Im Folgenden sind mehrere häufig verwendete Firewall -Konfigurationsmethoden, einschließlich der Verwendung von Iptables und Firewalld. Verwenden Sie Iptables, um Firewall so zu konfigurieren, dass Iptables (falls bereits installiert) installiert werden:

Wie Debian OpenSSL verhindert, dass Mann-in-the-Middle-Angriffe

Apr 13, 2025 am 10:30 AM

Wie Debian OpenSSL verhindert, dass Mann-in-the-Middle-Angriffe

Apr 13, 2025 am 10:30 AM

In Debian Systems ist OpenSSL eine wichtige Bibliothek für Verschlüsselung, Entschlüsselung und Zertifikatverwaltung. Um einen Mann-in-the-Middle-Angriff (MITM) zu verhindern, können folgende Maßnahmen ergriffen werden: Verwenden Sie HTTPS: Stellen Sie sicher, dass alle Netzwerkanforderungen das HTTPS-Protokoll anstelle von HTTP verwenden. HTTPS verwendet TLS (Transport Layer Security Protocol), um Kommunikationsdaten zu verschlüsseln, um sicherzustellen, dass die Daten während der Übertragung nicht gestohlen oder manipuliert werden. Überprüfen Sie das Serverzertifikat: Überprüfen Sie das Serverzertifikat im Client manuell, um sicherzustellen, dass es vertrauenswürdig ist. Der Server kann manuell durch die Delegate -Methode der URLSession überprüft werden

Debian Mail Server SSL -Zertifikat -Installationsmethode

Apr 13, 2025 am 11:39 AM

Debian Mail Server SSL -Zertifikat -Installationsmethode

Apr 13, 2025 am 11:39 AM

Die Schritte zur Installation eines SSL -Zertifikats auf dem Debian Mail -Server sind wie folgt: 1. Installieren Sie zuerst das OpenSSL -Toolkit und stellen Sie sicher, dass das OpenSSL -Toolkit bereits in Ihrem System installiert ist. Wenn nicht installiert, können Sie den folgenden Befehl installieren: sudoapt-getupdatesudoapt-getinstallopenssl2. Generieren Sie den privaten Schlüssel und die Zertifikatanforderung als nächst

Wie Debian Readdir sich in andere Tools integriert

Apr 13, 2025 am 09:42 AM

Wie Debian Readdir sich in andere Tools integriert

Apr 13, 2025 am 09:42 AM

Die Readdir -Funktion im Debian -System ist ein Systemaufruf, der zum Lesen des Verzeichnisgehalts verwendet wird und häufig in der C -Programmierung verwendet wird. In diesem Artikel wird erläutert, wie Readdir in andere Tools integriert wird, um seine Funktionalität zu verbessern. Methode 1: Kombinieren Sie C -Sprachprogramm und Pipeline zuerst ein C -Programm, um die Funktion der Readdir aufzurufen und das Ergebnis auszugeben:#include#include#includeIntmain (intargc, char*argv []) {Dir*Dir; structDirent*Eintrag; if (argc! = 2) {{

Wie man Debian Syslog lernt

Apr 13, 2025 am 11:51 AM

Wie man Debian Syslog lernt

Apr 13, 2025 am 11:51 AM

In diesem Leitfaden werden Sie erfahren, wie Sie Syslog in Debian -Systemen verwenden. Syslog ist ein Schlüsseldienst in Linux -Systemen für Protokollierungssysteme und Anwendungsprotokollnachrichten. Es hilft den Administratoren, die Systemaktivitäten zu überwachen und zu analysieren, um Probleme schnell zu identifizieren und zu lösen. 1. Grundkenntnisse über syslog Die Kernfunktionen von Syslog umfassen: zentrales Sammeln und Verwalten von Protokollnachrichten; Unterstützung mehrerer Protokoll -Ausgabesformate und Zielorte (z. B. Dateien oder Netzwerke); Bereitstellung von Echtzeit-Protokoll- und Filterfunktionen. 2. Installieren und Konfigurieren von Syslog (mit Rsyslog) Das Debian -System verwendet standardmäßig Rsyslog. Sie können es mit dem folgenden Befehl installieren: sudoaptupdatesud