Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Ein Überblick über grundlegende Modelle und Roboterentwicklungspfade

Ein Überblick über grundlegende Modelle und Roboterentwicklungspfade

Ein Überblick über grundlegende Modelle und Roboterentwicklungspfade

Die ursprüngliche Bedeutung muss nicht geändert werden, Roboter sind eine Technologie, die unbegrenzte Möglichkeiten bieten kann, insbesondere in Kombination mit intelligenter Technologie. In jüngster Zeit wird erwartet, dass einige Großmodelle mit revolutionären Anwendungen zum intelligenten Zentrum von Robotern werden und Robotern helfen, die Welt wahrzunehmen und zu verstehen, Entscheidungen zu treffen und zu planen.

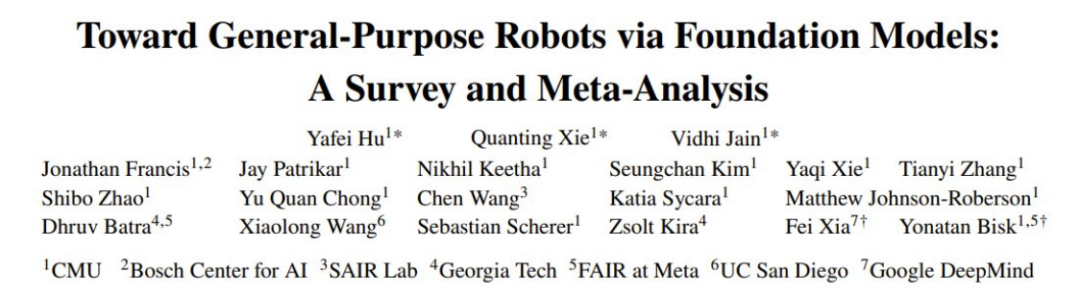

Kürzlich unter der Leitung von Yonatan Bisk von CMU und Fei Xia von Google DeepMind Ein gemeinsames Team veröffentlichte einen Übersichtsbericht, der die Anwendung und Entwicklung grundlegender Modelle im Bereich der Robotik vorstellt. Der erste Autor des Berichts ist Yafei Hu, ein Doktorand im vierten Jahr an der CMU, dessen Forschung sich auf die Schnittstelle zwischen Robotik und künstlicher Intelligenz konzentriert. Mit ihm arbeitet Quanting Xie zusammen, der sich auf die Erforschung verkörperter Intelligenz anhand grundlegender Modelle konzentriert.

Papieradresse: https://arxiv.org/pdf/2312.08782.pdf

Die Entwicklung von Robotern, die sich autonom an verschiedene Umgebungen anpassen können, war schon immer ein Traum der Menschheit, aber das ist ein langer und langer Traum langer Weg Ein herausfordernder Weg. Bisher erforderten Roboterwahrnehmungssysteme, die herkömmliche Deep-Learning-Methoden verwenden, in der Regel eine große Menge gekennzeichneter Daten, um überwachte Lernmodelle zu trainieren, und die Kosten für die Kennzeichnung großer Datensätze durch Crowdsourcing waren sehr hoch.

Aufgrund der begrenzten Generalisierungsfähigkeit klassischer überwachter Lernmethoden erfordern diese trainierten Modelle außerdem in der Regel sorgfältig konzipierte Domänenanpassungstechniken, die wiederum häufig eine weitere Datenerfassung erfordern, um diese Modelle auf bestimmte Szenarien oder Aufgaben anzuwenden und Anmerkungsschritte. In ähnlicher Weise erfordern klassische Roboterplanungs- und -kontrollansätze häufig eine sorgfältige Modellierung der Welt, der eigenen Dynamik des Agenten und/oder der Dynamik anderer Agenten. Diese Modelle werden normalerweise für jede spezifische Umgebung oder Aufgabe erstellt. Wenn sich die Bedingungen ändern, muss das Modell neu erstellt werden. Dies zeigt, dass auch die Migrationsleistung des klassischen Modells begrenzt ist.

Tatsächlich ist die Erstellung effektiver Modelle für viele Anwendungsfälle entweder zu teuer oder einfach unmöglich. Obwohl auf Deep (Reinforcement) Learning basierende Bewegungsplanungs- und Kontrollmethoden dazu beitragen, diese Probleme zu lindern, leiden sie immer noch unter Verteilungsverschiebungen und einer verminderten Generalisierungsfähigkeit.

Obwohl die Entwicklung universeller Robotersysteme viele Herausforderungen mit sich bringt, haben die Bereiche der Verarbeitung natürlicher Sprache (NLP) und Computer Vision (CV) in letzter Zeit schnelle Fortschritte gemacht, einschließlich großer Sprachmodelle (LLM) für NLP und Benutzerdiffusion Modell für die Generierung von Bildern mit hoher Wiedergabetreue, leistungsstarkes visuelles Modell und visuelles Sprachmodell für CV-Aufgaben wie die Erzeugung von Null-Aufnahmen/wenigen Aufnahmen.

Das sogenannte „Foundation-Modell“ ist eigentlich ein großes Pre-Training-Modell (LPTM). Sie verfügen über starke visuelle und verbale Fähigkeiten. In jüngster Zeit werden diese Modelle auch im Bereich der Robotik eingesetzt und sollen Robotersystemen eine offene Weltwahrnehmung, Aufgabenplanung und sogar Bewegungssteuerungsfunktionen verleihen. Neben der Nutzung bestehender Seh- und/oder Sprachgrundmodelle im Bereich der Robotik entwickeln einige Forschungsteams auch Grundmodelle für Roboteraufgaben, etwa Aktionsmodelle zur Manipulation oder Bewegungsplanungsmodelle zur Navigation. Diese grundlegenden Robotermodelle weisen starke Generalisierungsfähigkeiten auf und können sich an verschiedene Aufgaben und sogar spezifische Lösungen anpassen. Es gibt auch Forscher, die visuelle/sprachliche Basismodelle direkt für Roboteraufgaben verwenden, was die Möglichkeit zeigt, verschiedene Robotermodule in ein einziges einheitliches Modell zu integrieren.

Obwohl Seh- und Sprachgrundmodelle im Bereich der Robotik vielversprechende Perspektiven haben und auch neue Robotergrundmodelle entwickelt werden, gibt es im Bereich der Robotik immer noch viele Herausforderungen, die schwer zu lösen sind.

Aus der Perspektive des tatsächlichen Einsatzes sind Modelle oft nicht reproduzierbar, nicht in der Lage, auf verschiedene Roboterformen zu verallgemeinern (multi-embodied generalization) oder es ist schwierig, genau zu verstehen, welche Verhaltensweisen in der Umgebung machbar (oder akzeptabel) sind. Darüber hinaus verwenden die meisten Studien Transformer-basierte Architekturen und konzentrieren sich auf die semantische Wahrnehmung von Objekten und Szenen, die Planung und Steuerung auf Aufgabenebene. Andere Teile des Robotersystems sind weniger untersucht, beispielsweise Grundmodelle für die Weltdynamik oder Grundmodelle, die symbolisches Denken durchführen können. Diese erfordern domänenübergreifende Generalisierungsfähigkeiten.

Schließlich brauchen wir auch mehr groß angelegte reale Daten und High-Fidelity-Simulatoren, die vielfältige Roboteraufgaben unterstützen.

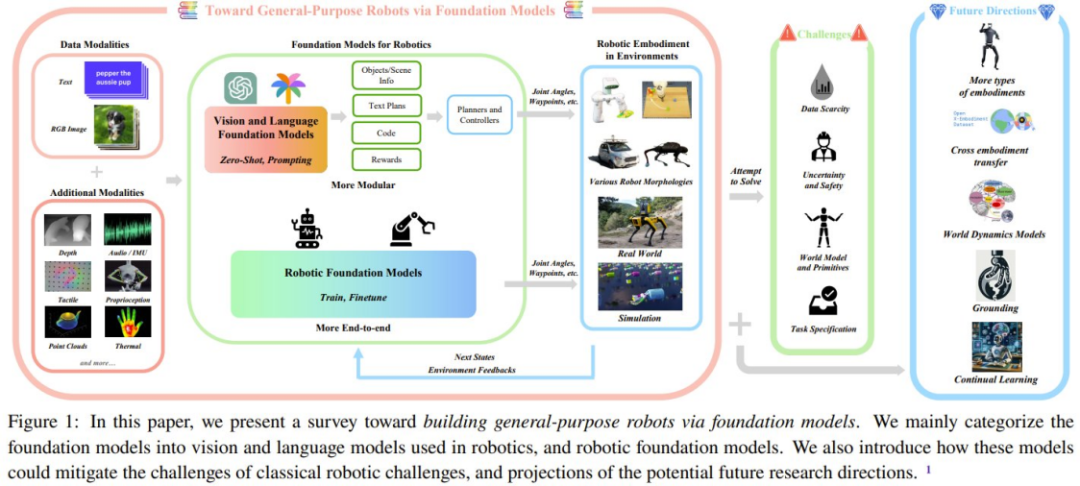

Dieser Übersichtsartikel fasst die im Bereich der Robotik verwendeten Grundmodelle zusammen, mit dem Ziel zu verstehen, wie die Grundmodelle zur Lösung oder Linderung der Kernherausforderungen im Bereich der Robotik beitragen können.

In dieser Übersicht umfasst der von Forschern verwendete Begriff „Grundlagenmodelle“ zwei Aspekte des Bereichs der Robotik: (1) Die wichtigsten vorhandenen visuellen und sprachlichen Modelle, hauptsächlich durch Zero-Shot und Um dies durch kontextuelles Lernen zu erreichen; ) Von Robotern generierte Daten nutzen, um Basismodelle zur Lösung von Roboteraufgaben gezielt zu entwickeln und anzuwenden. Die Forscher fassten die Methoden zu den Grundmodellen in relevanten Artikeln zusammen und führten eine Metaanalyse der experimentellen Ergebnisse dieser Artikel durch

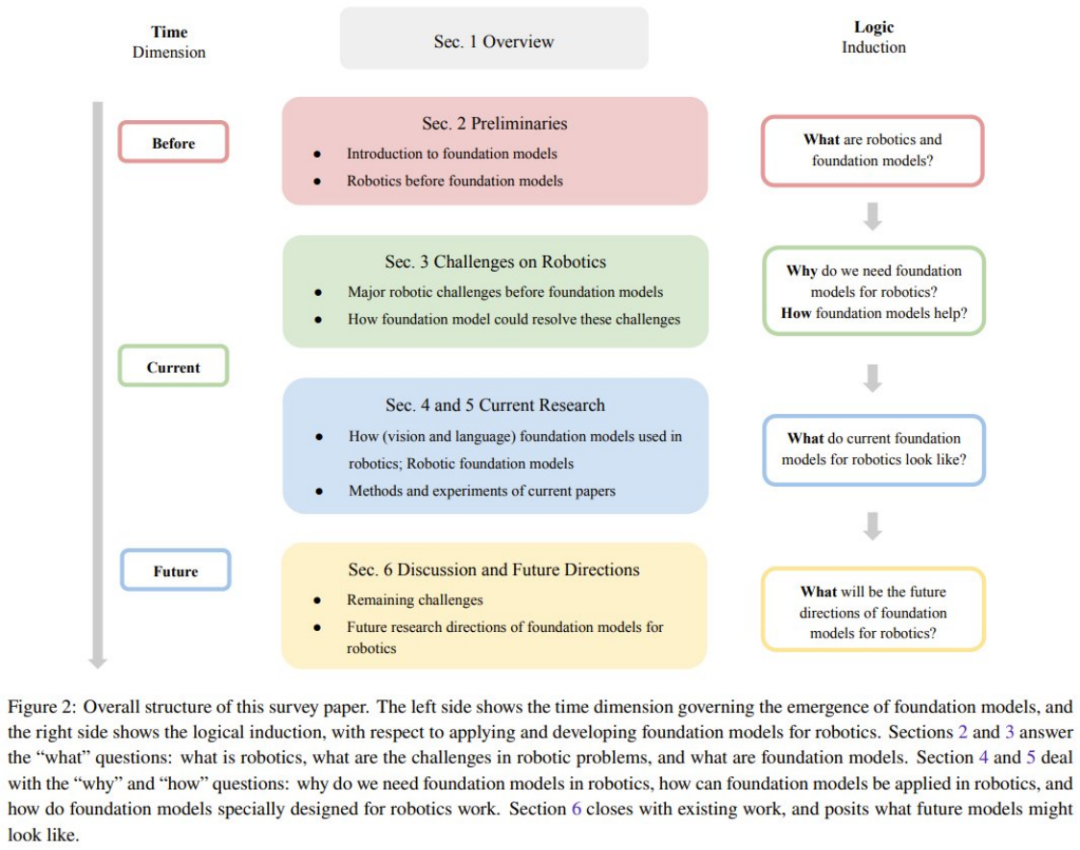

Um den Lesern zu helfen, den Inhalt dieser Rezension besser zu verstehen, stellt das Team zunächst einen Abschnitt mit vorbereitendem Wissen bereit

Um den Lesern zu helfen, den Inhalt dieser Rezension besser zu verstehen, stellt das Team zunächst einen Abschnitt mit vorbereitendem Wissen bereit

Die Hauptkomponenten des Roboters lassen sich in drei Teile unterteilen: Wahrnehmung, Entscheidungsfindung und Planung sowie Aktionsgenerierung.

Das Team unterteilt die Roboterwahrnehmung in passive Wahrnehmung, aktive Wahrnehmung und Zustandsschätzung.

Im Abschnitt Roboter-Entscheidungsfindung und -Planung stellte der Forscher klassische Planungsmethoden und lernbasierte Planungsmethoden vor.

Die Generierung von Maschinenaktionen verfügt auch über klassische Steuerungsmethoden und lernbasierte Steuerungsmethoden.

- Als nächstes wird das Team grundlegende Modelle vorstellen und sich hauptsächlich auf die Bereiche NLP und CV konzentrieren. Zu den beteiligten Modellen gehören: LLM, VLM, visuelles Basismodell und textbedingtes Bildgenerierungsmodell. Herausforderungen im Bereich der Robotik

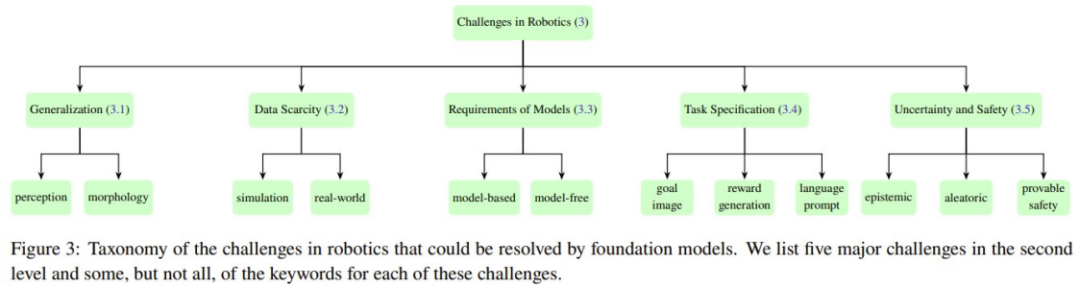

- Fünf zentrale Herausforderungen, denen sich verschiedene Module eines typischen Robotersystems gegenübersehen. Abbildung 3 zeigt die Einordnung dieser fünf Herausforderungen.

Verallgemeinerung

Robotersysteme haben oft Schwierigkeiten, ihre Umgebung genau zu erfassen und zu verstehen. Ihnen fehlt auch die Fähigkeit, Trainingsergebnisse einer Aufgabe auf eine andere zu übertragen, was ihren Nutzen in der realen Welt weiter einschränkt. Darüber hinaus ist es aufgrund der unterschiedlichen Roboterhardware auch schwierig, das Modell auf verschiedene Roboterformen zu übertragen. Das Generalisierungsproblem kann teilweise durch die Verwendung des Basismodells für Roboter gelöst werden. Weitere Fragen wie die Verallgemeinerung auf verschiedene Roboterformen müssen noch beantwortet werden.

Datenknappheit

Um zuverlässige Robotermodelle zu entwickeln, sind umfangreiche, qualitativ hochwertige Daten von entscheidender Bedeutung. Es gibt bereits Bemühungen, umfangreiche Datensätze aus der realen Welt zu sammeln, darunter autonomes Fahren, Flugbahnen von Roboteroperationen usw. Und das Sammeln von Roboterdaten aus menschlichen Demonstrationen ist teuer. Der Prozess der Erfassung ausreichender und umfassender Daten in der realen Welt wird jedoch durch die Vielfalt der Aufgaben und Umgebungen zusätzlich erschwert. Es gibt auch Sicherheitsbedenken hinsichtlich der Datenerfassung in der realen Welt. Darüber hinaus ist es in der realen Welt sehr schwierig, Daten in großem Maßstab zu sammeln, und es ist noch schwieriger, Bild-/Textdaten im Internetmaßstab zu sammeln, die zum Trainieren des Basismodells verwendet werden. Um diesen Herausforderungen zu begegnen, haben viele Forschungsanstrengungen versucht, synthetische Daten in simulierten Umgebungen zu generieren. Diese simulierten Umgebungen können eine sehr realistische virtuelle Welt bieten und es Robotern ermöglichen, ihre Fähigkeiten in Situationen zu erlernen und anzuwenden, die realen Szenarien ähneln. Allerdings gibt es einige Einschränkungen bei der Verwendung simulierter Umgebungen, insbesondere im Hinblick auf die Objektvielfalt, was es schwierig macht, die erlernten Fähigkeiten direkt auf Situationen in der realen Welt anzuwenden.

Ein Ansatz mit großem Potenzial ist die kollaborative Datenerfassung, die Daten erfasst aus verschiedenen Laborumgebungen und Robotertypen werden zusammengetragen, wie in Abbildung 4a dargestellt. Das Team warf jedoch einen detaillierten Blick auf den Open-X-Embodiment-Datensatz und stellte fest, dass es hinsichtlich der Verfügbarkeit der Datentypen einige Einschränkungen gab.

Modell- und Grundelementanforderungen

Klassische Planungs- und Steuerungsmethoden erfordern in der Regel sorgfältig entworfene Umgebungs- und Robotermodelle. Frühere lernbasierte Methoden (z. B. Nachahmungslernen und Verstärkungslernen) trainierten Richtlinien in einer End-to-End-Methode, d. Diese Methoden können das Problem, sich auf explizite Modelle zu verlassen, teilweise lösen, es ist jedoch oft schwierig, sie auf verschiedene Umgebungen und Aufgaben zu übertragen.

Es gibt zwei Probleme, die gelöst werden müssen: (1) Wie lernt man Strategien, die modellunabhängig sind und sich gut verallgemeinern lassen? (2) Wie kann man hervorragende Weltmodelle erlernen, um klassische modellbasierte Methoden anzuwenden?

Aufgabenspezifikation

Um einen Allzweckagenten zu erhalten, besteht eine zentrale Herausforderung darin, die Aufgabenspezifikation zu verstehen und sie im aktuellen Weltverständnis des Roboters zu verankern. Typischerweise werden diese Aufgabenspezifikationen vom Benutzer bereitgestellt, der die Einschränkungen der kognitiven und physischen Fähigkeiten des Roboters nur begrenzt versteht. Dies wirft viele Fragen auf, unter anderem welche Best Practices für diese Aufgabenspezifikationen bereitgestellt werden können und ob die Ausarbeitung dieser Spezifikationen natürlich und einfach genug ist. Es ist auch eine Herausforderung, Unklarheiten in den Aufgabenspezifikationen zu verstehen und zu lösen, basierend auf dem Verständnis des Roboters über seine Fähigkeiten.

Unsicherheit und Sicherheit

Eine zentrale Herausforderung beim Einsatz von Robotern in der realen Welt besteht im Umgang mit der Unsicherheit, die der Umgebung und den Aufgabenspezifikationen innewohnt. Abhängig von der Quelle kann die Unsicherheit in epistemische Unsicherheit (durch mangelndes Wissen verursachte Unsicherheit) und zufällige Unsicherheit (umgebungsinhärenter Lärm) unterteilt werden.

Die Kosten der Unsicherheitsquantifizierung (UQ) können so hoch sein, dass Forschung und Anwendungen nicht nachhaltig sind, und sie können auch verhindern, dass nachgelagerte Aufgaben optimal gelöst werden. Angesichts der stark überparametrisierten Natur des zugrunde liegenden Modells ist es für die Erzielung von Skalierbarkeit ohne Einbußen bei der Modellgeneralisierungsleistung von entscheidender Bedeutung, UQ-Methoden bereitzustellen, die das Trainingsschema beibehalten und gleichzeitig die zugrunde liegende Architektur so wenig wie möglich ändern. Die Entwicklung von Robotern, die zuverlässige Schätzungen ihres eigenen Verhaltens liefern und im Gegenzug auf intelligente Weise klar formuliertes Feedback anfordern können, bleibt eine ungelöste Herausforderung.

Obwohl in letzter Zeit einige Fortschritte erzielt wurden, bleibt es eine Herausforderung, sicherzustellen, dass Roboter aus Erfahrungen lernen können, um ihre Strategien zu verfeinern und die Sicherheit in neuen Umgebungen zu gewährleisten.

Überblick über aktuelle Forschungsmethoden

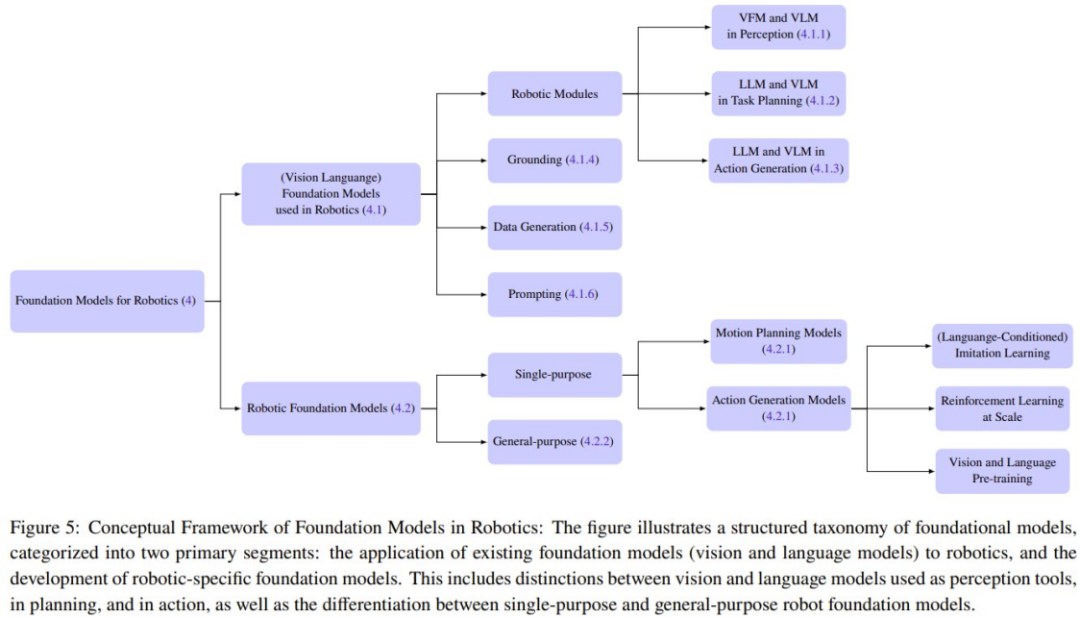

Dieser Artikel fasst auch aktuelle Forschungsmethoden für Basismodelle von Robotern zusammen. Das Team teilte die im Bereich der Robotik verwendeten Grundmodelle in zwei Hauptkategorien ein: Grundmodelle für Roboter und neu geschriebene Inhalte: Robot Basic Model (RFM).

Das Grundmodell des Roboters bezieht sich auf die Verwendung des Grundmodells des Sehens und der Sprache für den Roboter ohne zusätzliche Feinabstimmung oder Schulung. Das Roboterbasismodell kann mit einer Vision-Language-Initialisierung vor dem Training warmgestartet werden, oder das Modell kann direkt auf dem Roboterdatensatz trainiert werden

Detaillierte Klassifizierung

Grundmodell für Roboter

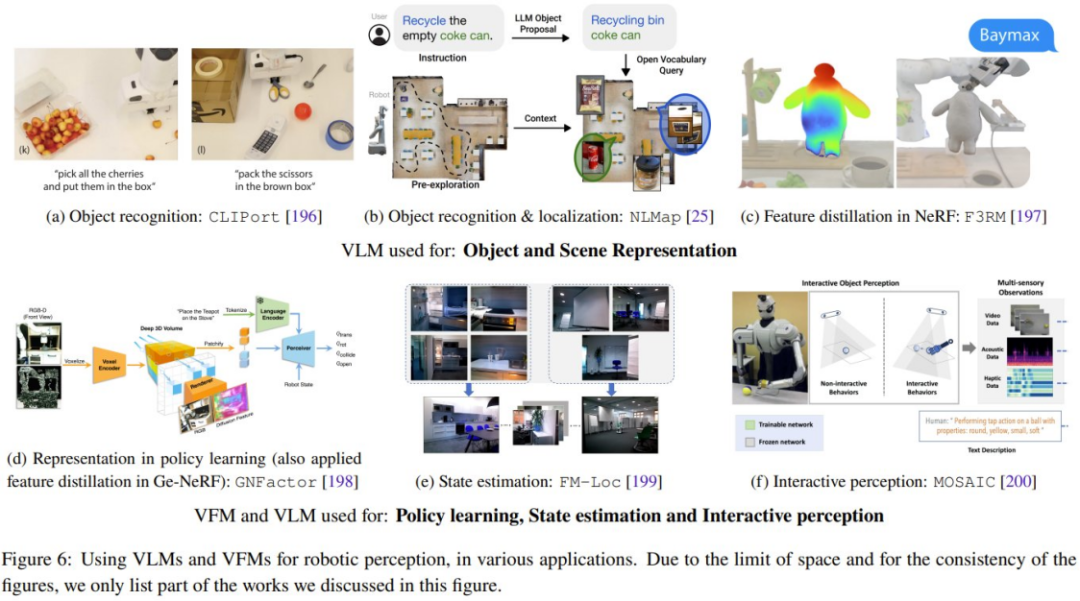

Dieser Abschnitt wird wie folgt umgeschrieben: Dieser Abschnitt konzentriert sich auf die Anwendung grundlegender Seh- und Sprachmodelle auf Zero-Shot-Situationen im Bereich der Robotik. Dazu gehört vor allem der Einsatz von VLM Zero-Sample in Roboterwahrnehmungsanwendungen und die Anwendung der Kontextlernfähigkeiten von LLM auf die Planung und Aktionsgenerierung auf Aufgaben- und Bewegungsebene. Abbildung 6 zeigt einige typische Forschungsarbeiten

Was neu geschrieben wird, ist: Robot Basic Model (RFM)

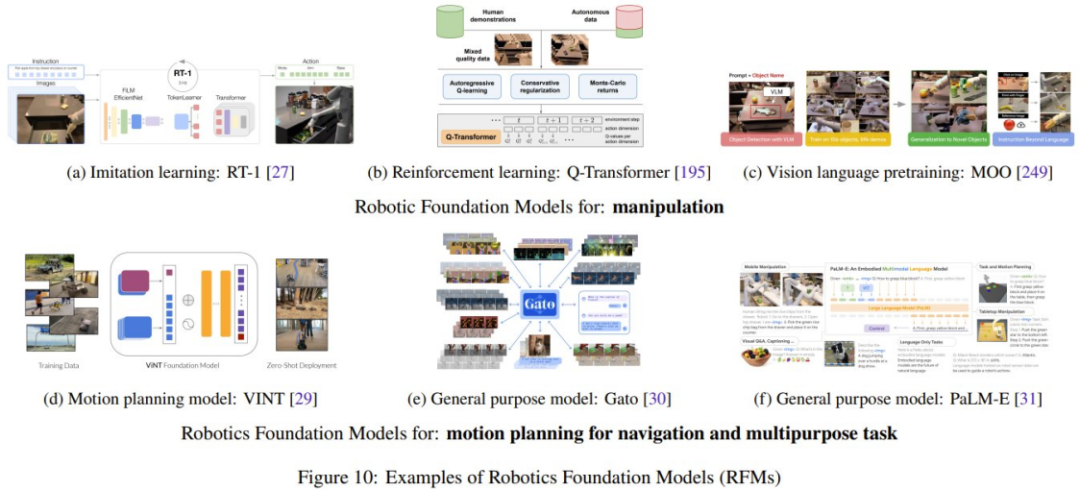

Der Roboter enthält Zustands-Aktionspaare vom realen Roboter als Datensatz wächst, ist die Neufassung, dass auch die Kategorie Robotics Foundation Model (RFM) immer wahrscheinlicher wird, erfolgreich zu sein. Diese Modelle nutzen Roboterdaten, um das Modell für die Lösung von Roboteraufgaben zu trainieren.

Das Forschungsteam fasste in der Diskussion die verschiedenen Arten von RFM zusammen. Das erste ist ein RFM, das in der Lage ist, bestimmte Aufgaben in einem einzelnen Robotermodul auszuführen, das auch als Einzelobjektiv-Roboterbasismodell bezeichnet wird. Zum Beispiel die Möglichkeit, RFMs zu generieren, die Aktionen eines Roboters auf niedriger Ebene steuern, oder Modelle, die eine Bewegungsplanung auf höherer Ebene generieren können. Der Artikel stellt außerdem RFMs vor, die Aufgaben in mehreren Robotermodulen ausführen können, also universelle Modelle, die Wahrnehmungs-, Steuerungs- und sogar nicht-robotergestützte Aufgaben ausführen können.

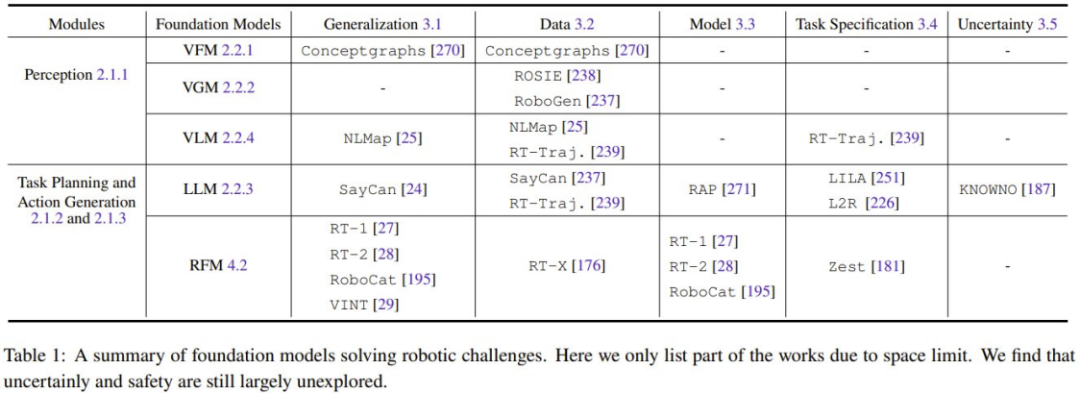

Der vorherige Artikel listet die fünf größten Herausforderungen auf, vor denen der Bereich Robotik steht. Hier beschreiben wir, wie Basismodelle bei der Bewältigung dieser Herausforderungen helfen können.

Alle Grundmodelle im Zusammenhang mit visuellen Informationen (wie VFM, VLM und VGM) können im Wahrnehmungsmodul des Roboters verwendet werden. LLM hingegen ist vielseitiger und kann zur Planung und Steuerung eingesetzt werden. Der neu geschriebene Inhalt lautet: Das Roboter-Basismodell (RFM) wird normalerweise in Planungs- und Aktionsgenerierungsmodulen verwendet. Tabelle 1 fasst die zugrunde liegenden Modelle zur Lösung verschiedener Robotikherausforderungen zusammen.

Wie aus der Tabelle ersichtlich ist, können alle Grundmodelle die Aufgaben verschiedener Robotermodule gut verallgemeinern. Insbesondere bei der Aufgabenspezifikation schneidet LLM gut ab. RFM hingegen kann die Herausforderung dynamischer Modelle gut bewältigen, da es sich bei den meisten RFMs um modellfreie Methoden handelt. Bei den Wahrnehmungsfähigkeiten von Robotern hängen Generalisierungsfähigkeiten und Modellherausforderungen zusammen. Wenn das Wahrnehmungsmodell bereits über gute Generalisierungsfähigkeiten verfügt, müssen keine weiteren Daten für die Domänenanpassung oder zusätzliche Feinabstimmung eingeholt werden

Darüber hinaus mangelt es an Forschung zu Sicherheitsherausforderungen, die eine wichtige Zukunft darstellen werden Forschungsrichtung.

Übersicht über aktuelle Experimente und Auswertungen

Dieser Abschnitt fasst die aktuellen Forschungsergebnisse zu Datensätzen, Benchmarks und Experimenten zusammen.

Datensätze und Benchmarks

Es gibt Einschränkungen, sich ausschließlich auf Wissen zu verlassen, das aus Sprach- und visuellen Datensätzen gewonnen wird. Wie einige Forschungsergebnisse zeigen, können einige Konzepte wie Reibung und Gewicht nicht einfach durch diese Modalitäten allein erlernt werden.

Damit Roboteragenten die Welt besser verstehen können, adaptiert die Forschungsgemeinschaft nicht nur grundlegende Modelle aus den Bereichen Sprache und Sehen, sondern treibt auch die Entwicklung großer und vielfältiger multimodaler Roboter voran, um diese zu trainieren und zu verfeinern Modelle.

Derzeit lassen sich diese Bemühungen in zwei Hauptrichtungen unterteilen: einerseits das Sammeln von Daten aus der realen Welt und andererseits das Sammeln von Daten aus der simulierten Welt und deren Migration in die reale Welt. Jede Richtung hat ihre Vor- und Nachteile. Zu den aus der realen Welt gesammelten Datensätzen gehören RoboNet, Bridge Dataset V1, Bridge-V2, Language-Table, RT-1 usw. Zu den häufig verwendeten Simulatoren gehören Habitat, AI2THOR, Mujoco, AirSim, Arrival Autonomous Racing Simulator, Issac Gym usw.

Bewertungsanalyse aktueller Methoden (Meta-Analyse)

Ein weiterer wichtiger Beitrag des Teams ist A Eine Metaanalyse der Experimente in den in diesem Übersichtsbericht erwähnten Arbeiten kann zur Klärung der folgenden Fragen beitragen:

1 Welche Aufgaben lösen Menschen?

2. Welche Datensätze oder Simulatoren wurden zum Trainieren des Modells verwendet? Welche Roboterplattformen werden zum Testen verwendet?

3. Welche Grundmodelle werden von der Forschungsgemeinschaft verwendet? Wie effektiv ist es bei der Lösung der Aufgabe?

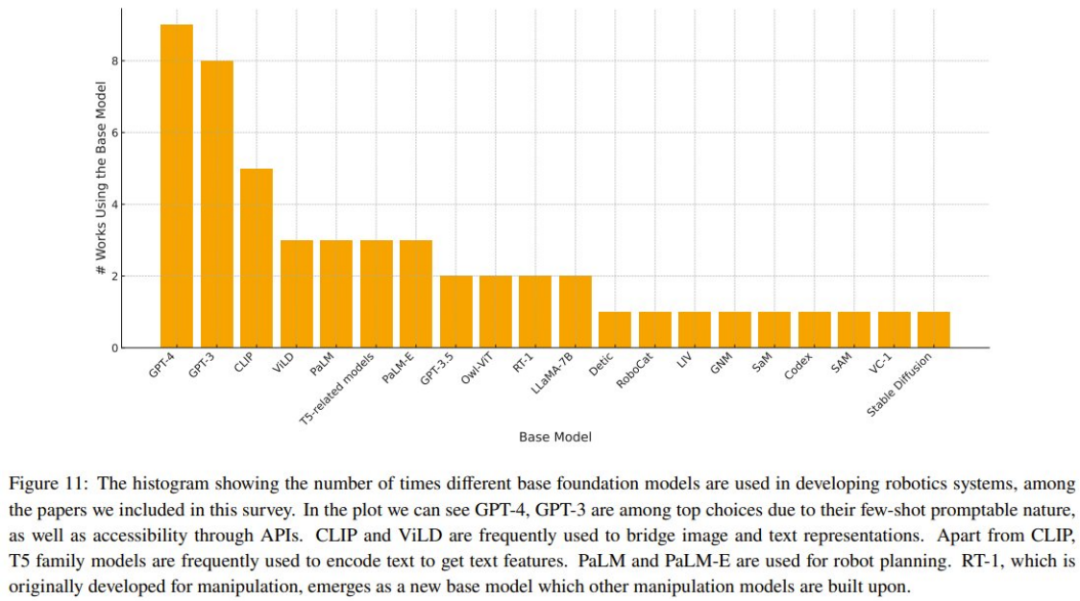

4. Welche Basismodelle werden unter diesen Methoden häufiger verwendet?

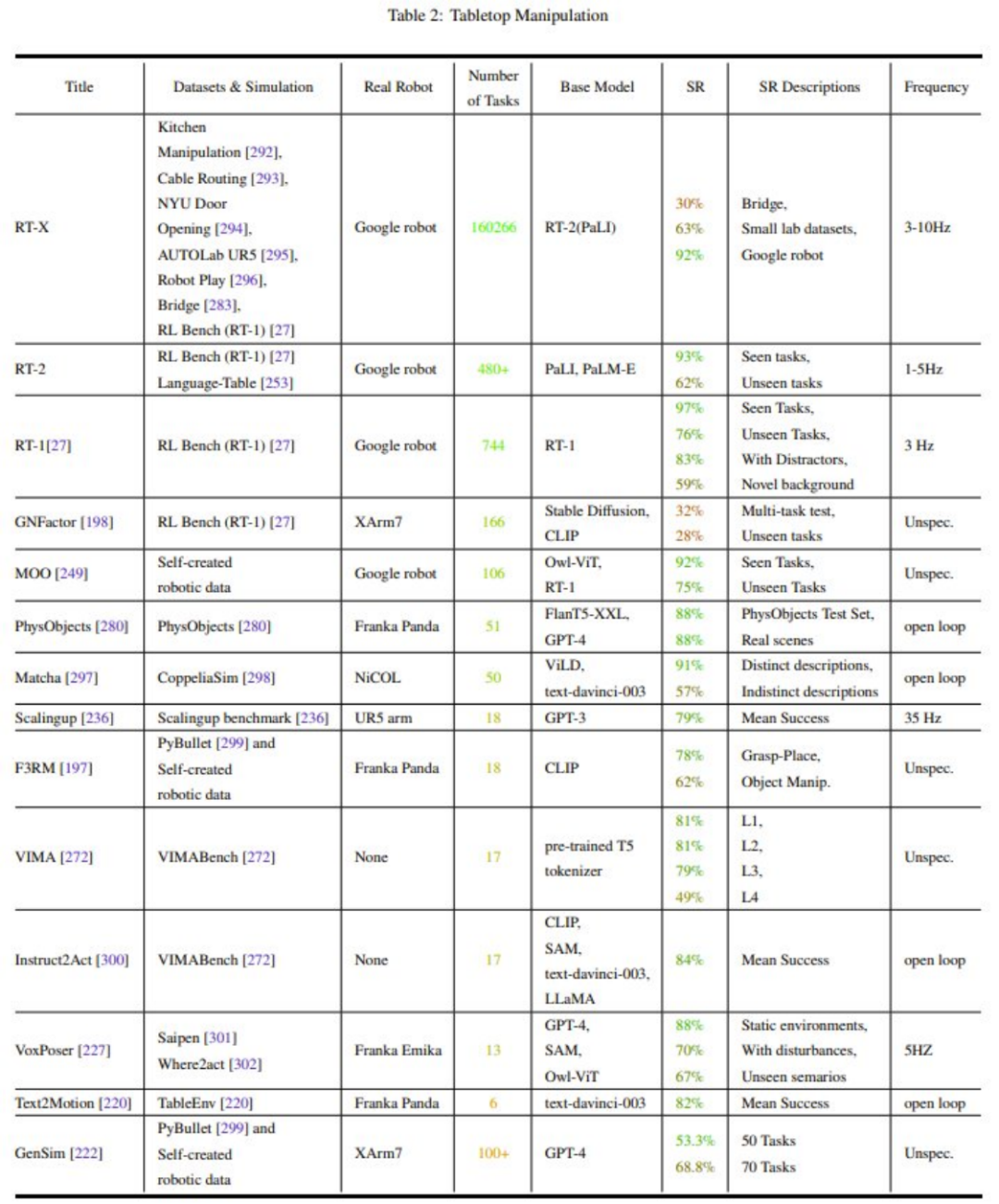

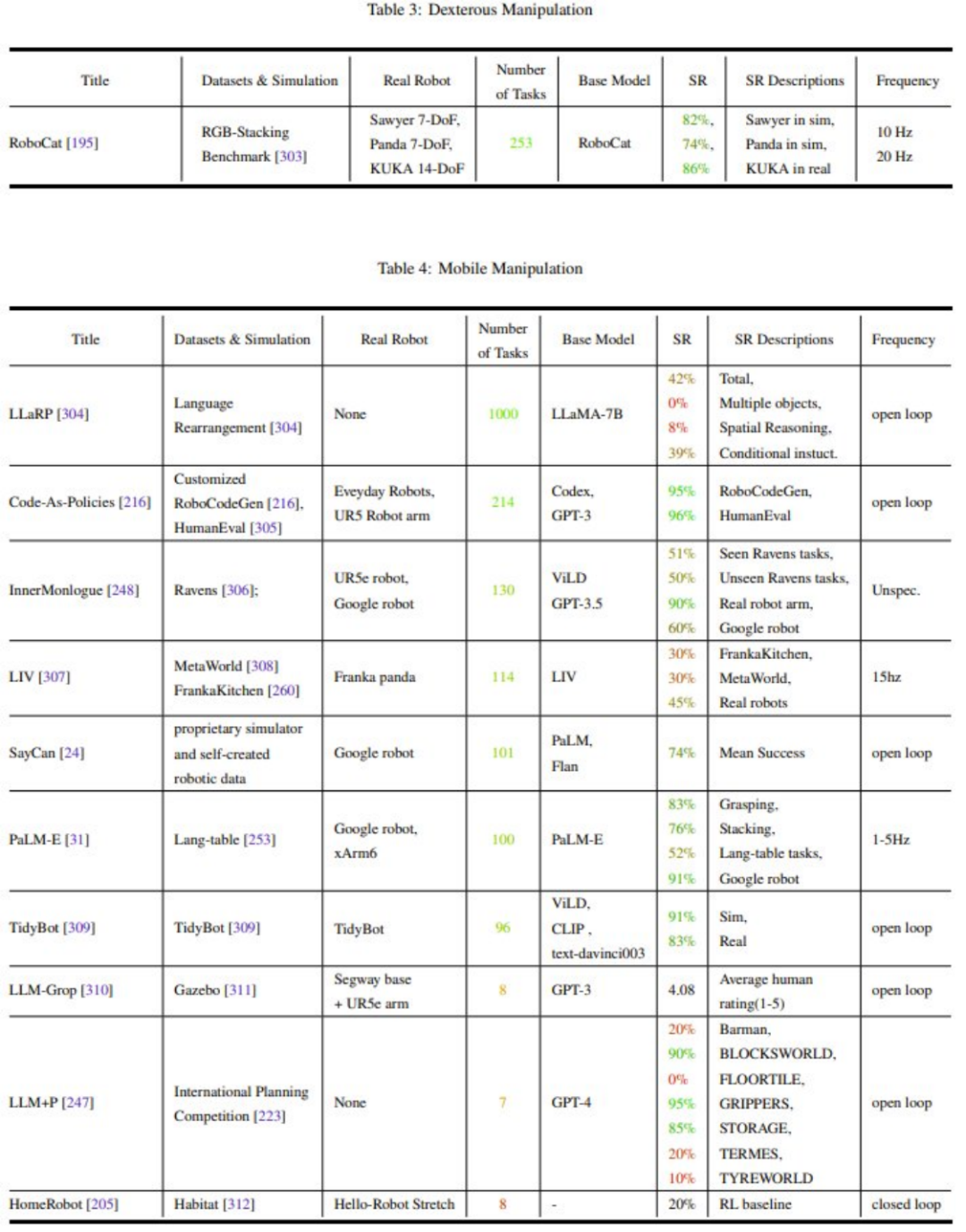

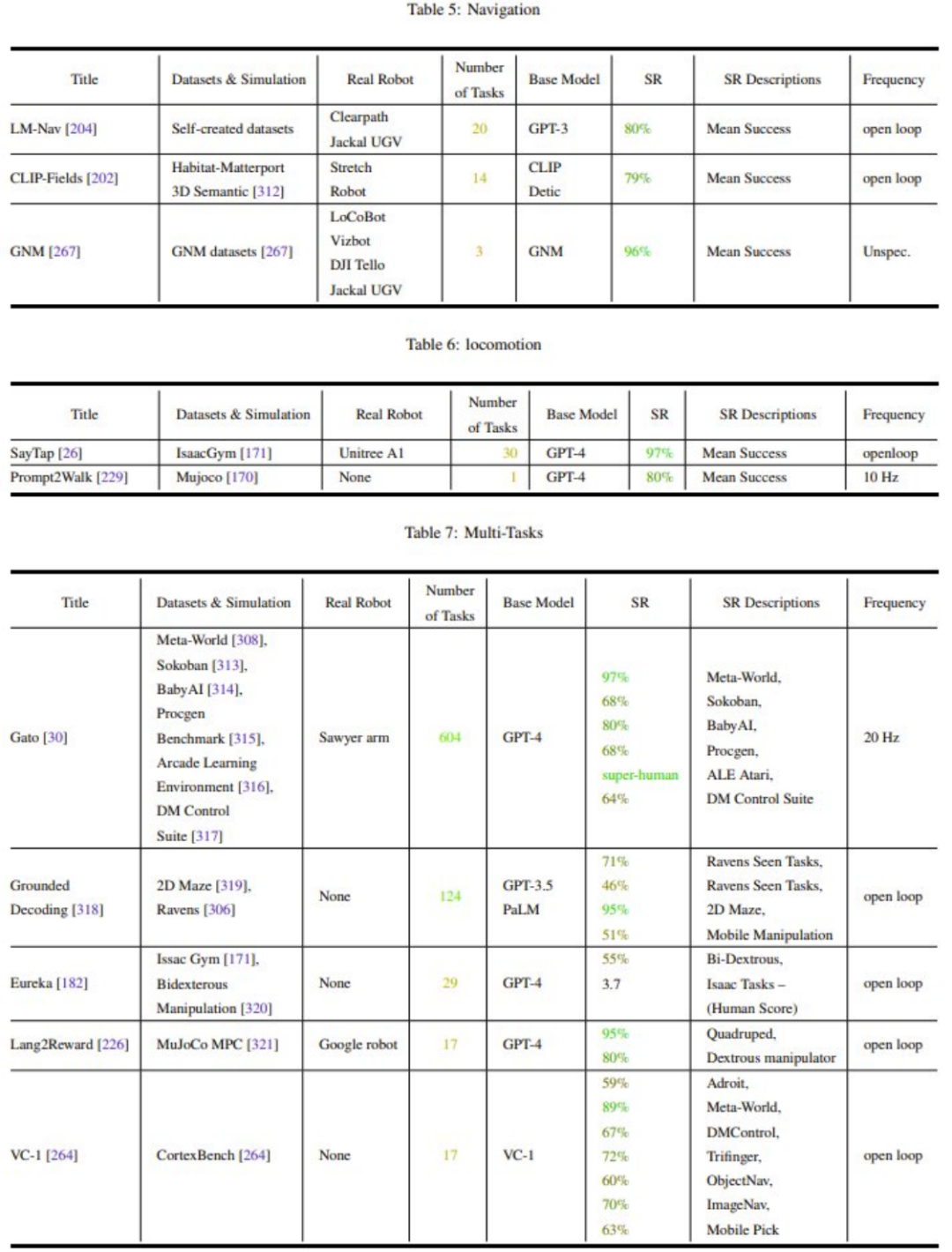

Tabelle 2-7 und Abbildung 11 zeigen die Analyseergebnisse.

Die Aufmerksamkeit der Forschungsgemeinschaft für Roboterbetriebsaufgaben (Manipulation) ist unausgewogen

Generalisierung und Robustheit müssen verbessert werden

Die Erforschung von Aktionen auf niedriger Ebene (Steuerung auf niedriger Ebene) ist sehr begrenzt

Die Steuerfrequenz ist zu niedrig (

Das Fehlen einheitlicher Testbenchmarks (Metriken) und Testplattformen (Simulation oder Hardware) macht den Vergleich sehr schwierig.

Diskussion und zukünftige Richtungen

Das Team hat einige Herausforderungen zusammengefasst, die noch gelöst werden müssen, und Forschungsrichtungen, die es wert sind, diskutiert zu werden:

- Wie legt man eine Standardgrundlage für die Verkörperung von Robotern fest?

- Sicherheit und Unsicherheit?

- Sind End-to-End- und modulare Methoden nicht kompatibel?

- Anpassung an verkörperte körperliche VeränderungenFähigkeit

- Weltmodellmethode oder modellunabhängige Methode?

- Neue Roboterplattform und multisensorische Informationen

- Lernen Sie weiter

- Standardisierung und Reproduzierbarkeit (Reproduzierbarkeit)

Das obige ist der detaillierte Inhalt vonEin Überblick über grundlegende Modelle und Roboterentwicklungspfade. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1393

1393

52

52

1207

1207

24

24

Open Source! Jenseits von ZoeDepth! DepthFM: Schnelle und genaue monokulare Tiefenschätzung!

Apr 03, 2024 pm 12:04 PM

Open Source! Jenseits von ZoeDepth! DepthFM: Schnelle und genaue monokulare Tiefenschätzung!

Apr 03, 2024 pm 12:04 PM

0.Was bewirkt dieser Artikel? Wir schlagen DepthFM vor: ein vielseitiges und schnelles generatives monokulares Tiefenschätzungsmodell auf dem neuesten Stand der Technik. Zusätzlich zu herkömmlichen Tiefenschätzungsaufgaben demonstriert DepthFM auch hochmoderne Fähigkeiten bei nachgelagerten Aufgaben wie dem Tiefen-Inpainting. DepthFM ist effizient und kann Tiefenkarten innerhalb weniger Inferenzschritte synthetisieren. Lassen Sie uns diese Arbeit gemeinsam lesen ~ 1. Titel der Papierinformationen: DepthFM: FastMonocularDepthEstimationwithFlowMatching Autor: MingGui, JohannesS.Fischer, UlrichPrestel, PingchuanMa, Dmytr

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Stellen Sie sich ein Modell der künstlichen Intelligenz vor, das nicht nur die Fähigkeit besitzt, die traditionelle Datenverarbeitung zu übertreffen, sondern auch eine effizientere Leistung zu geringeren Kosten erzielt. Dies ist keine Science-Fiction, DeepSeek-V2[1], das weltweit leistungsstärkste Open-Source-MoE-Modell, ist da. DeepSeek-V2 ist ein leistungsstarkes MoE-Sprachmodell (Mix of Experts) mit den Merkmalen eines wirtschaftlichen Trainings und einer effizienten Inferenz. Es besteht aus 236B Parametern, von denen 21B zur Aktivierung jedes Markers verwendet werden. Im Vergleich zu DeepSeek67B bietet DeepSeek-V2 eine stärkere Leistung, spart gleichzeitig 42,5 % der Trainingskosten, reduziert den KV-Cache um 93,3 % und erhöht den maximalen Generierungsdurchsatz auf das 5,76-fache. DeepSeek ist ein Unternehmen, das sich mit allgemeiner künstlicher Intelligenz beschäftigt

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI verändert tatsächlich die Mathematik. Vor kurzem hat Tao Zhexuan, der diesem Thema große Aufmerksamkeit gewidmet hat, die neueste Ausgabe des „Bulletin of the American Mathematical Society“ (Bulletin der American Mathematical Society) weitergeleitet. Zum Thema „Werden Maschinen die Mathematik verändern?“ äußerten viele Mathematiker ihre Meinung. Der gesamte Prozess war voller Funken, knallhart und aufregend. Der Autor verfügt über eine starke Besetzung, darunter der Fields-Medaillengewinner Akshay Venkatesh, der chinesische Mathematiker Zheng Lejun, der NYU-Informatiker Ernest Davis und viele andere bekannte Wissenschaftler der Branche. Die Welt der KI hat sich dramatisch verändert. Viele dieser Artikel wurden vor einem Jahr eingereicht.

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas tritt offiziell in die Ära der Elektroroboter ein! Gestern hat sich der hydraulische Atlas einfach „unter Tränen“ von der Bühne der Geschichte zurückgezogen. Heute gab Boston Dynamics bekannt, dass der elektrische Atlas im Einsatz ist. Es scheint, dass Boston Dynamics im Bereich kommerzieller humanoider Roboter entschlossen ist, mit Tesla zu konkurrieren. Nach der Veröffentlichung des neuen Videos wurde es innerhalb von nur zehn Stunden bereits von mehr als einer Million Menschen angesehen. Die alten Leute gehen und neue Rollen entstehen. Das ist eine historische Notwendigkeit. Es besteht kein Zweifel, dass dieses Jahr das explosive Jahr der humanoiden Roboter ist. Netizens kommentierten: Die Weiterentwicklung der Roboter hat dazu geführt, dass die diesjährige Eröffnungsfeier wie Menschen aussieht, und der Freiheitsgrad ist weitaus größer als der von Menschen. Aber ist das wirklich kein Horrorfilm? Zu Beginn des Videos liegt Atlas ruhig auf dem Boden, scheinbar auf dem Rücken. Was folgt, ist atemberaubend

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

Anfang dieses Monats schlugen Forscher des MIT und anderer Institutionen eine vielversprechende Alternative zu MLP vor – KAN. KAN übertrifft MLP in Bezug auf Genauigkeit und Interpretierbarkeit. Und es kann MLP, das mit einer größeren Anzahl von Parametern ausgeführt wird, mit einer sehr kleinen Anzahl von Parametern übertreffen. Beispielsweise gaben die Autoren an, dass sie KAN nutzten, um die Ergebnisse von DeepMind mit einem kleineren Netzwerk und einem höheren Automatisierungsgrad zu reproduzieren. Konkret verfügt DeepMinds MLP über etwa 300.000 Parameter, während KAN nur etwa 200 Parameter hat. KAN hat eine starke mathematische Grundlage wie MLP und basiert auf dem universellen Approximationssatz, während KAN auf dem Kolmogorov-Arnold-Darstellungssatz basiert. Wie in der folgenden Abbildung gezeigt, hat KAN

Die Vitalität der Superintelligenz erwacht! Aber mit der Einführung der sich selbst aktualisierenden KI müssen sich Mütter keine Sorgen mehr über Datenengpässe machen

Apr 29, 2024 pm 06:55 PM

Die Vitalität der Superintelligenz erwacht! Aber mit der Einführung der sich selbst aktualisierenden KI müssen sich Mütter keine Sorgen mehr über Datenengpässe machen

Apr 29, 2024 pm 06:55 PM

Ich weine zu Tode. Die Daten im Internet reichen überhaupt nicht aus. Das Trainingsmodell sieht aus wie „Die Tribute von Panem“, und KI-Forscher auf der ganzen Welt machen sich Gedanken darüber, wie sie diese datenhungrigen Esser ernähren sollen. Dieses Problem tritt insbesondere bei multimodalen Aufgaben auf. Zu einer Zeit, als sie ratlos waren, nutzte ein Start-up-Team der Abteilung der Renmin-Universität von China sein eigenes neues Modell, um als erstes in China einen „modellgenerierten Datenfeed selbst“ in die Realität umzusetzen. Darüber hinaus handelt es sich um einen zweigleisigen Ansatz auf der Verständnisseite und der Generierungsseite. Beide Seiten können hochwertige, multimodale neue Daten generieren und Datenrückmeldungen an das Modell selbst liefern. Was ist ein Modell? Awaker 1.0, ein großes multimodales Modell, das gerade im Zhongguancun-Forum erschienen ist. Wer ist das Team? Sophon-Motor. Gegründet von Gao Yizhao, einem Doktoranden an der Hillhouse School of Artificial Intelligence der Renmin University.

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

Die Zielerkennung ist ein relativ ausgereiftes Problem in autonomen Fahrsystemen, wobei die Fußgängererkennung einer der ersten Algorithmen ist, die eingesetzt werden. In den meisten Arbeiten wurde eine sehr umfassende Recherche durchgeführt. Die Entfernungswahrnehmung mithilfe von Fischaugenkameras für die Rundumsicht ist jedoch relativ wenig untersucht. Aufgrund der großen radialen Verzerrung ist es schwierig, die standardmäßige Bounding-Box-Darstellung in Fischaugenkameras zu implementieren. Um die obige Beschreibung zu vereinfachen, untersuchen wir erweiterte Begrenzungsrahmen-, Ellipsen- und allgemeine Polygondesigns in Polar-/Winkeldarstellungen und definieren eine mIOU-Metrik für die Instanzsegmentierung, um diese Darstellungen zu analysieren. Das vorgeschlagene Modell „fisheyeDetNet“ mit polygonaler Form übertrifft andere Modelle und erreicht gleichzeitig 49,5 % mAP auf dem Valeo-Fisheye-Kameradatensatz für autonomes Fahren

Die Kuaishou-Version von Sora „Ke Ling' steht zum Testen offen: Sie generiert über 120 Sekunden Videos, versteht die Physik besser und kann komplexe Bewegungen genau modellieren

Jun 11, 2024 am 09:51 AM

Die Kuaishou-Version von Sora „Ke Ling' steht zum Testen offen: Sie generiert über 120 Sekunden Videos, versteht die Physik besser und kann komplexe Bewegungen genau modellieren

Jun 11, 2024 am 09:51 AM

Was? Wird Zootopia durch heimische KI in die Realität umgesetzt? Zusammen mit dem Video wird ein neues groß angelegtes inländisches Videogenerationsmodell namens „Keling“ vorgestellt. Sora geht einen ähnlichen technischen Weg und kombiniert eine Reihe selbst entwickelter technologischer Innovationen, um Videos zu produzieren, die nicht nur große und vernünftige Bewegungen aufweisen, sondern auch die Eigenschaften der physischen Welt simulieren und über starke konzeptionelle Kombinationsfähigkeiten und Vorstellungskraft verfügen. Den Daten zufolge unterstützt Keling die Erstellung ultralanger Videos von bis zu 2 Minuten mit 30 Bildern pro Sekunde, mit Auflösungen von bis zu 1080p und unterstützt mehrere Seitenverhältnisse. Ein weiterer wichtiger Punkt ist, dass es sich bei Keling nicht um eine vom Labor veröffentlichte Demo oder Video-Ergebnisdemonstration handelt, sondern um eine Anwendung auf Produktebene, die von Kuaishou, einem führenden Anbieter im Bereich Kurzvideos, gestartet wurde. Darüber hinaus liegt das Hauptaugenmerk darauf, pragmatisch zu sein, keine Blankoschecks auszustellen und sofort nach der Veröffentlichung online zu gehen. Das große Modell von Ke Ling wurde bereits in Kuaiying veröffentlicht.