Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

IT Industrie

IT Industrie

IBM demonstriert einen mit Flüssigstickstoffkühlung optimierten Nanoblatt-Transistor-Prototyp, der die Leistung im Vergleich zur Raumtemperatur mehr als verdoppelt

IBM demonstriert einen mit Flüssigstickstoffkühlung optimierten Nanoblatt-Transistor-Prototyp, der die Leistung im Vergleich zur Raumtemperatur mehr als verdoppelt

IBM demonstriert einen mit Flüssigstickstoffkühlung optimierten Nanoblatt-Transistor-Prototyp, der die Leistung im Vergleich zur Raumtemperatur mehr als verdoppelt

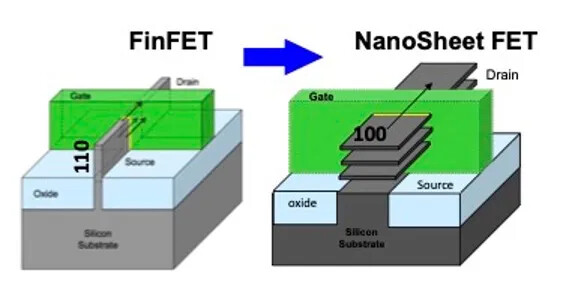

Auf dem IEEE International Electronic Devices Meeting (IEDM), das Anfang Dezember dieses Jahres in San Francisco stattfand, stellten IBM-Forscher den ersten fortschrittlichen CMOS-Transistor vor, der für die Kühlung mit flüssigem Stickstoff optimiert ist.

Laut dieser Website kocht flüssiger Stickstoff Der Temperaturpunkt ist sehr niedrig, nur -196°C, was eine extrem niedrige Temperatur ist, der aktuelle Mainstream-Elektronikgeräte nicht standhalten können. In solch einer kalten Umgebung werden jedoch der Widerstand und der Leckstrom des Transistors deutlich reduziert, wodurch die Leistung verbessert und der Stromverbrauch gesenkt wird Tore erreichen eine effektivere Kontrolle des elektrischen Feldes. Diese Struktur kann nicht nur 50 Milliarden Transistoren auf eine Fläche von der Größe eines Fingernagels komprimieren, sondern auch die Leistung unter Flüssigstickstoffkühlung erstaunlich verdoppeln

Umschreiben: Umgebungen mit niedrigen Temperaturen bieten zwei Hauptvorteile: eine geringere Ladungsträgerstreuung und einen geringeren Stromverbrauch. Eine geringere Streuung bedeutet einen geringeren Widerstand, was die Bewegungsfähigkeit der Elektronen im Gerät verbessert; ein geringerer Stromverbrauch ermöglicht es dem Gerät, bei gleicher Spannung einen größeren Strom zu treiben. Darüber hinaus kann die Kühlung mit flüssigem Stickstoff auch die Ein-/Ausschaltempfindlichkeit des Transistors verbessern, sodass nur kleinere Spannungsänderungen zum Schalten von Zuständen erforderlich sind, was den Stromverbrauch weiter senkt. Niedrige Temperaturen bringen jedoch auch neue Herausforderungen mit sich: eine erhöhte Schwellenspannung. Die Schwellenspannung ist die Spannung, die zum Einschalten eines Transistors erforderlich ist. Sie steigt mit sinkender Temperatur, wodurch das Schalten des Geräts schwieriger wird. Da es mit herkömmlichen Verfahren schwierig ist, die Schwellenspannung zu reduzieren, verwendeten die IBM-Forscher eine neue Dual-Metal-Gate- und Dual-Dipol-Technologie. Sie fügen an der Schnittstelle von n-Typ- und p-Typ-Transistoren verschiedene Metallverunreinigungen hinzu, um Dipole zu bilden, wodurch die Energie reduziert wird, die Elektronen zum Überqueren der Leitungsbandkante benötigen, und die Transistoren effizienter werden

Das obige ist der detaillierte Inhalt vonIBM demonstriert einen mit Flüssigstickstoffkühlung optimierten Nanoblatt-Transistor-Prototyp, der die Leistung im Vergleich zur Raumtemperatur mehr als verdoppelt. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1378

1378

52

52

Mar 18, 2024 am 09:40 AM

Mar 18, 2024 am 09:40 AM

IBM kündigte plötzlich eine neue Entlassungsrunde an! Der Chief Communications Officer von IBM gab die Neuigkeiten auf der letzten siebenminütigen Mitarbeiterbesprechung bekannt. Diesmal liegt der Fokus vor allem auf den Marketing- und Kommunikationsabteilungen. Obwohl IBM keine formelle Stellungnahme zum Ausmaß der Entlassungen abgegeben hat, kündigte das Unternehmen erst im Januar dieses Jahres an, 3.400 Mitarbeiter zu entlassen. Der CEO des Unternehmens, Arvind Krishna, sagte zuvor, dass das Unternehmen in den nächsten fünf Jahren 8.000 Arbeitsplätze durch künstliche Intelligenz ersetzen werde. Diese völlig plötzliche Operation hat die Mitarbeiter direkt verwirrt ... Haben diese 8.000 Menschen schon vor langer Zeit damit begonnen, Mitarbeiter zu entlassen? Quelle: One Acre Three Points Laut Statistiken relevanter Websites haben in diesem Jahr bisher etwa 204 Technologieunternehmen Mitarbeiter entlassen, fast 50.000 Menschen. Darunter Google-Mutterkonzern Alphabet, Amazon

IBM stellt die neueste Tool-Suite vor, um die Entwicklung künstlicher Intelligenz der nächsten Generation auf Mainframe-Plattformen zu verlagern

Sep 28, 2023 pm 07:37 PM

IBM stellt die neueste Tool-Suite vor, um die Entwicklung künstlicher Intelligenz der nächsten Generation auf Mainframe-Plattformen zu verlagern

Sep 28, 2023 pm 07:37 PM

IBM hat kürzlich eine neue Reihe von Produkten angekündigt, die auf den kürzlich eingeführten generativen KI-Codierungsfunktionen für Mainframe-Entwickler aufbauen, um die Ausführung künstlicher Intelligenz auf ihrer älteren Rechenzentrumshardware zu erleichtern. IBM sagte in einem Update für IBMZ, dass es Kunden dabei helfen soll, ihre Geschäftsergebnisse zu verbessern Durch die Implementierung von Geschäfts-KI in mehreren Branchen und Anwendungsfällen umfasst es eine neue Reihe von Entwickler-Toolkits, die die am weitesten verbreiteten KI-Frameworks und die Programmiersprache Python unterstützen, Verbesserungen des maschinellen Lernens für z/OS und Leistungsverbesserungen im IBMz/OS-Mainframe-Betriebssystem . IBM sagte, dass diese Aktualisierungen es Kunden ermöglichen werden, die Genauigkeit der Richtlinienberatung zu verbessern, die Zuverlässigkeit und Aktualität der Anti-Geldwäsche-Kontrollen zu verbessern und zu reduzieren

IBM veröffentlicht den KI-Programmierassistenten „watsonx', der den Mangel an COBOL-Programmierern lindern soll

Oct 31, 2023 pm 02:13 PM

IBM veröffentlicht den KI-Programmierassistenten „watsonx', der den Mangel an COBOL-Programmierern lindern soll

Oct 31, 2023 pm 02:13 PM

IT House berichtete am 31. Oktober, dass IBM kürzlich eine Pressemitteilung herausgegeben habe, in der es hieß, dass es den generativen KI-Programmierassistenten „watsonx“ auf den Markt gebracht habe, um den aktuellen Mangel an Sprachprogrammierern mit Kenntnissen in COBOL (einer Programmiersprache, die 1959 entworfen und entwickelt wurde) zu lindern. IBM hat im August dieses Jahres einen Dienst namens „IBMZ“ gestartet, der darauf abzielt, COBOL in die Java-Sprache zu konvertieren. Kürzlich wurde der Dienst offiziell unter dem Namen „watsonx“ gestartet. Die Kernfunktionen von Watsonx vereinfachen die Konvertierung von COBOL-Code nach Java und sind auf die Modernisierung großer Computer ausgelegt. IBM sagte, der Assistent für künstliche Intelligenz sei bei der Codeübersetzung äußerst genau und könne reduzieren

IBM legt einen 500-Millionen-Dollar-Venture-Fonds für künstliche Intelligenz für Unternehmen auf, um Start-ups zu unterstützen

Nov 17, 2023 pm 03:54 PM

IBM legt einen 500-Millionen-Dollar-Venture-Fonds für künstliche Intelligenz für Unternehmen auf, um Start-ups zu unterstützen

Nov 17, 2023 pm 03:54 PM

IBM hat kürzlich ein neues Unternehmensinvestitionsinstrument auf den Markt gebracht, den Enterprise Artificial Intelligence Venture Fund. Der Fonds zielt darauf ab, Startups zu unterstützen, die an der Entwicklung unternehmensorientierter KI-Produkte arbeiten. Der Schritt von IBM erfolgt, da auch andere Technologiegiganten ihre Investitionen in das KI-Startup-Ökosystem erhöhen. Vor einigen Wochen erhielt AnthropicPBC, ein großer Entwickler von Sprachmodellen, eine Finanzierung von insgesamt bis zu 6 Milliarden US-Dollar von Amazon und Google. Kürzlich haben sich Hewlett Packard Enterprise und SAPSE einer Investition von mehr als 500 Millionen US-Dollar in den deutschen Anbieter künstlicher Intelligenz AlephAlpha GmbH angeschlossen. IBM beabsichtigt, über seinen Enterprise Artificial Intelligence Venture Fund eine Reihe von Startups „von der Frühphase bis zum Hyperwachstum“ zu unterstützen. Laut Medienberichten I

Halbleiterpatentbericht 2023: Samsung liegt weit vorne, gefolgt von IBM, Qualcomm und TSMC

Jan 27, 2024 pm 01:03 PM

Halbleiterpatentbericht 2023: Samsung liegt weit vorne, gefolgt von IBM, Qualcomm und TSMC

Jan 27, 2024 pm 01:03 PM

Laut einer statistischen Analyse, die auf öffentlichen Daten des Unternehmens für geistiges Eigentum Anaqua basiert, werden die Vereinigten Staaten im Jahr 2023 die Region mit der weltweit größten Anzahl an Halbleiterpatenten sein. Dies ist das zweite Jahr in Folge, in dem die Vereinigten Staaten die Liste anführen. Das Unternehmen nutzt die fortschrittliche Patentanalysesoftware AcclaimIP, um vom US-amerikanischen Marken- und Patentamt veröffentlichte halbleiterbezogene Patente zu analysieren. Die Ergebnisse zeigen, dass die Zahl der Halbleiterpatente im Jahr 2023 348.774 erreichte, ein leichter Anstieg gegenüber 347.408 im Jahr 2022. Nach Ländern und Regionen beträgt die Zahl der von amerikanischen Unternehmen erhaltenen Patente 162.557 und liegt damit an erster Stelle aller Länder, was einem Anstieg von 18 % gegenüber 2022 entspricht. Die Daten zeigen, dass Japan an zweiter Stelle steht (40.960 Fälle), gefolgt von China (2).

Was bedeutet IBM?

Feb 08, 2021 pm 03:34 PM

Was bedeutet IBM?

Feb 08, 2021 pm 03:34 PM

Der vollständige englische Name von IBM lautet „International Business Machines Corporation“, was sich auf International Business Machines Corporation oder International Business Machines Corporation bezieht. Der Hauptsitz befindet sich in Armonk, New York.

IBM veröffentlicht das Granite-KI-Modell für die Open-Source-Community

Jun 02, 2024 pm 01:46 PM

IBM veröffentlicht das Granite-KI-Modell für die Open-Source-Community

Jun 02, 2024 pm 01:46 PM

IBM Research gab kürzlich bekannt, dass sein Granite-Coding-Basismodell Open Source ist, mit dem Ziel, fortschrittliche KI-Tools zu demokratisieren und umfassende Änderungen in der Art und Weise zu fördern, wie Code branchenübergreifend geschrieben, gepflegt und entwickelt wird. Dieser Schritt wird es Entwicklern ermöglichen, KI-Modelle effizienter zu erstellen, zu optimieren und einzusetzen und so die Anwendung der Technologie der künstlichen Intelligenz zu beschleunigen. Granite ist ein fortschrittliches KI-Programmiertool, das vom IBM Research Institute mit leistungsstarken Funktionen entwickelt wurde. Auf welcher Ebene basiert es auf dem Open-Standard-Codierungsmodell IBM Granite? Granite entstand aus dem Bestreben von IBM, den Codierungsprozess zu vereinfachen. Nachdem IBM die Komplexität und die schnellen Entwicklungsanforderungen der Softwareentwicklung erkannt hatte, nutzte es seine starken wissenschaftlichen Forschungskapazitäten, um eine Reihe von KI-gesteuerten Tools zu entwickeln

IBM entwickelt den Cloud-nativen KI-Supercomputer Vela, um zig Milliarden Parametermodelle flexibel einzusetzen und zu trainieren

Apr 14, 2023 pm 01:46 PM

IBM entwickelt den Cloud-nativen KI-Supercomputer Vela, um zig Milliarden Parametermodelle flexibel einzusetzen und zu trainieren

Apr 14, 2023 pm 01:46 PM

ChatGPT ist im Internet beliebt und auch das dahinter stehende KI-Modelltraining hat große Aufmerksamkeit erregt. IBM Research gab kürzlich bekannt, dass der von ihm entwickelte cloudnative Supercomputer Vela schnell bereitgestellt und zum Trainieren grundlegender KI-Modelle verwendet werden kann. Seit Mai 2022 nutzen Dutzende Forscher des Unternehmens diesen Supercomputer, um KI-Modelle mit zig Milliarden Parametern zu trainieren. Basismodelle sind KI-Modelle, die auf großen Mengen unbeschrifteter Daten trainiert werden. Aufgrund ihrer Vielseitigkeit können sie mit nur einer Feinabstimmung für eine Reihe unterschiedlicher Aufgaben verwendet werden. Ihr Ausmaß ist enorm und erfordert enorme und kostspielige Rechenleistung. Experten sagen daher, dass die Rechenleistung der größte Engpass bei der Entwicklung der nächsten Generation groß angelegter Basismodelle sein wird und deren Training viel Rechenleistung und Zeit erfordert. Schulung verfügbar