Eine kurze Analyse der LLM-Beobachtbarkeit

Hallo zusammen, mein Name ist Luga. Heute beschäftigen wir uns weiterhin mit einem technologiebezogenen Thema im Ökosystem der künstlichen Intelligenz – der Beobachtbarkeit von LLM (Large Language Model). In diesem Artikel wird die Beobachtbarkeit von LLM weiterhin eingehend analysiert, um jedem zu helfen, seine Bedeutung und sein Kernwissen über das Ökosystem zu verstehen.

1. Warum braucht LLM Beobachtbarkeit?

In der heutigen digital vernetzten Welt sind große Sprachmodelle (LLM) wie ein Zauberer mit Superkräften, die schnell Texte generieren, Sprachen übersetzen und Musik, Gedichte schreiben und programmieren können usw. haben dem Leben der Menschen großen Komfort gebracht. Aufgrund der Komplexität von LLM stehen dessen Verwaltung und Nutzung jedoch auch vor einigen Herausforderungen.

LLM enthält normalerweise Hunderte Millionen oder sogar Milliarden von Parametern, und die Wechselwirkungen zwischen diesen Parametern sind sehr komplex. Daher ist es nicht einfach, die Ergebnisse von LLM genau vorherzusagen. Darüber hinaus stammen die von LLM verwendeten Trainingsdaten in der Regel aus der realen Welt und können Verzerrungen oder fehlerhafte Informationen enthalten. Diese Voreingenommenheiten und Fehler können dazu führen, dass LLM fehlerhafte oder voreingenommene Texte generiert.

Daher ist LLM Observability (Large Language Model Observability) der Schlüssel zur Lösung der oben genannten Herausforderungen. Es kann Benutzern helfen, den Betriebsstatus, die Leistung und die Sicherheit von LLM zu verstehen. Konkret liefert die Beobachtbarkeit die folgenden Informationen: Echtzeit-Betriebsdaten von LLM, Ressourcenauslastung, Anforderungsantwortzeit, Fehlerrate, Protokollierung usw. Diese Informationen können Benutzern helfen, Probleme rechtzeitig zu erkennen und zu lösen, die Leistung von LLM zu optimieren und seinen sicheren Betrieb zu gewährleisten. Durch die Bereitstellung umfassender Beobachtbarkeit ermöglicht LLM Observability Benutzern, LLM-Vorgänge besser zu verstehen und zu verwalten.

- LLM-Ausgabeergebnisse

- LLM-Parameteränderungen

- LLM-Ressourcennutzung

- LLM-Sicherheitsrisiken

Basierend auf den oben genannten zugehörigen Informationen können Benutzer LLM effektiv verwalten und nutzen, um sicherzustellen, dass LLM sicher, stabil und effizient arbeiten kann .

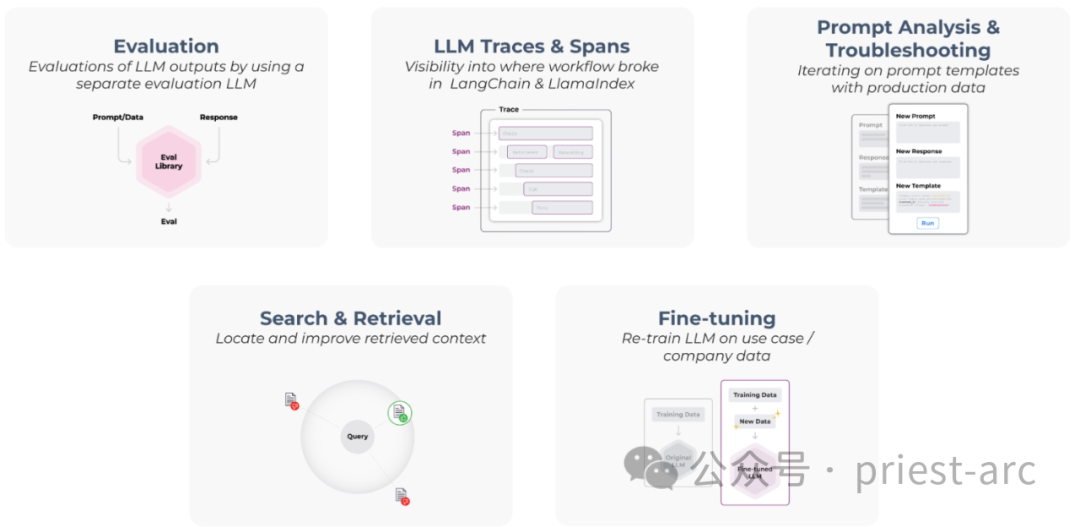

2. Analyse der fünf Säulen der LLM-Beobachtbarkeit

Abbildung: Die fünf Säulen der LLM-Beobachtbarkeit

Im Allgemeinen umfassen die fünf Säulen der LLM-Beobachtbarkeit (großes Modell) Folgendes:

1 - Bewertung

„Bewertung“ ist eine wichtige Säule der LLM-Beobachtbarkeit und dient dazu, die Leistung von LLM-Modellen zu verstehen und zu validieren sowie Probleme wie potenzielle Halluzinationen oder Frage-und-Antwort-Fragen zu erfassen. Die Bewertung der Leistung von LLMs ist entscheidend für die Gewährleistung der Qualität und Zuverlässigkeit des Modells. Wir können die Plausibilitätsbewertung mithilfe gängiger Bewertungsmethoden und -techniken wie Testdatensätzen, A/B-Tests, Metriken und Bewertungskriterien, Benutzerfeedback und subjektiver Bewertung sowie modellinterpretierender Bewertung durchführen. Diese Bewertungsmethoden können uns helfen, die Genauigkeit, Robustheit, Generalisierungsfähigkeit und Interpretierbarkeit des Modells sowie die Leistung des Modells bei verschiedenen Aufgaben und Szenarien zu verstehen. Durch kontinuierliche Evaluierung und Verbesserung können wir die Leistung und Effektivität von LLM-Modellen verbessern, um den Benutzeranforderungen besser gerecht zu werden.

Durch die Bewertung der Leistung von LLM können wir mögliche Probleme und Verbesserungspotenzial erkennen. Diese Bewertungsergebnisse können als Leitfaden für nachfolgende Optimierungs- und Verbesserungsbemühungen dienen, um die Qualität und Zuverlässigkeit von LLM zu verbessern.

In tatsächlichen Szenarien ist zu beachten, dass die LLM-Bewertung ein kontinuierlicher iterativer Prozess ist. Da das Modell verwendet wird und sich die Umgebung ändert, muss es möglicherweise regelmäßig bewertet und aktualisiert werden. Dadurch wird sichergestellt, dass LLM unter wechselnden Bedingungen eine hohe Leistung und Genauigkeit beibehält.

2. LLM-Traces und -Spans: LLM-Traces und -Spans

Das einzigartige Merkmal von LLM-Anwendungen ist ihre Fähigkeit, Span- und Trace-Informationen aus gängigen LLM-Anwendungsframeworks wie LangChain und LlamaIndex zu erfassen. Diese Frameworks bieten leistungsstarke Tools und Funktionen, die Entwicklern dabei helfen, die Spanne und Ausführungspfade von LLM-Anwendungen effektiv zu überwachen und zu dokumentieren.

Durch die Verwendung dieser gängigen LLM-Anwendungsframeworks können Entwickler die von ihnen bereitgestellten Span- und Trace-Funktionen voll ausnutzen und Einblicke in das Verhalten und die Leistung von LLM-Anwendungen gewinnen. Dies hilft bei der Überwachung und Optimierung des Betriebs von LLM-Anwendungen und liefert wertvolle Erkenntnisse zur Verbesserung und Steigerung der Leistung und Zuverlässigkeit von LLM.

3. Schnelle Analyse und Fehlerbehebung – Schnelle Analyse und Fehlerlokalisierung

Um LLM-Leistungsprobleme zu verfolgen, können wir Auswertungen oder herkömmliche Indikatoren als Indikatoren zur Leistungsmessung verwenden. Diese Metriken können uns dabei helfen, kritische Aspekte wie Genauigkeit, Reaktionszeit, Ressourcennutzung usw. von LLM zu bewerten. Durch die Überwachung dieser Kennzahlen können wir potenzielle Leistungsprobleme schnell erkennen und geeignete Maßnahmen zu deren Verbesserung ergreifen.

Um das Problem genau zu reproduzieren, können wir meiner Meinung nach außerdem Echtzeit-Produktionsdaten verwenden. Mithilfe von Daten aus tatsächlichen Produktionsumgebungen können wir LLM-Läufe in realen Szenarien simulieren und bestimmte Vorgänge wiederholt ausführen, um Leistungsprobleme genau zu reproduzieren. Solche Reproduktionen können uns helfen, die Grundursache des Problems besser zu verstehen und geeignete Lösungen zu seiner Lösung umzusetzen.

4. Suchen und Abrufen – Suchen und Abrufen

Normalerweise können wir unsere proprietären Daten mithilfe von RAG (Retrieval-Augmented Generation) zu LLM hinzufügen. RAG ist eine leistungsstarke Modellarchitektur, die Abruf- und Generierungsfunktionen kombiniert, um unsere proprietären Daten mit LLM zu kombinieren. Diese Kombination ermöglicht es LLM, unsere proprietären Daten für genauere und gezieltere Schlussfolgerungen und Generierungen zu nutzen.

Um jedoch sicherzustellen, dass die Leistung von LLM bestmöglich optimiert wird, ist es von entscheidender Bedeutung, RAG zu beheben und zu bewerten. Durch die Fehlerbehebung bei RAG können wir Probleme identifizieren und beheben, die zu einer Verschlechterung der LLM-Leistung oder zur Fehlergenerierung führen können. Gleichzeitig kann uns die Bewertung von RAG dabei helfen, seine Leistung bei bestimmten Aufgaben oder Datensätzen zu verstehen und so die am besten geeigneten Konfigurations- und Parametereinstellungen auszuwählen.

Daher sind die Fehlerbehebung und die Bewertung von RAG wichtige Schritte, um sicherzustellen, dass die LLM-Leistung optimiert ist. Schließlich hilft es uns, eine reibungslose Integration von LLM mit unseren proprietären Daten sicherzustellen und so die Qualität und Zuverlässigkeit von LLM zu erhöhen.

5. Feinabstimmung – Feinabstimmung

Die Generalisierungsfähigkeit des Modells hängt von der Qualität und Quantität der empfangenen Trainingsdaten ab. Daher müssen große Mengen realer oder künstlich generierter Daten gesammelt und in Datenbeispiele oder Problemcluster unterteilt werden.

Ein Datenbeispiel kann ein einzelner Datenpunkt oder eine Kombination mehrerer Datenpunkte sein. Problemcluster können Cluster sein, die auf bestimmten Problemtypen oder Domänen basieren. Das Format der Datenpunkte muss mit den Anforderungen des Feinabstimmungsworkflows übereinstimmen.

3. Analyse der Kernelemente der LLM-Beobachtbarkeit

Im Allgemeinen umfassen die Kernelemente der LLM-Beobachtbarkeit (großes Modell) Leistungsverfolgung, tiefgreifendes Verständnis, Zuverlässigkeitssicherung und Genauigkeit usw., wie folgt:

1 . Leistungsverfolgung

Beobachtbarkeit ist der Eckpfeiler von LLM (Large Model Language), und die wichtigste Komponente ist die konsistente „Leistungsverfolgung“. Dieser Prozess umfasst das Sammeln wichtiger Kennzahlen im Zusammenhang mit LLM-Funktionen, wie z. B. Genauigkeitsvorhersagen, Reaktionszeiten, Fehlertypen und Verzerrungen usw. Diese Kennzahlen helfen uns nicht nur dabei, Leistungsprobleme zu identifizieren und zu lösen, sondern bieten auch Einblicke in den LLM-Betriebsstatus und potenzielle Probleme.

In tatsächlichen Leistungsverfolgungsszenarien können wir verschiedene Techniken verwenden. Im Allgemeinen bleiben Metriken wie Genauigkeit, Präzision und Erinnerung eine beliebte Wahl. Die Genauigkeit misst den Anteil korrekter Vorhersagen, die Präzision misst die Relevanz dieser Vorhersagen und die Erinnerung misst die Anzahl der vom Modell erfassten relevanten Ergebnisse. Zusätzlich zu den oben genannten können wir natürlich auch andere Metriken verwenden, wie z. B. Latenz, Durchsatz, Ressourcennutzung und Sicherheit.

In tatsächlichen Geschäftsszenarien ist „Protokollierung“ eine weitere zentrale Methode zur Leistungsverfolgung. Es bietet detaillierte Protokolle zum Modellverhalten, einschließlich Eingaben, Ausgaben, Fehlern und anderen Anomalien. Diese Details helfen bei der Diagnose von LLM-Problemen wie Voreingenommenheit, Diskriminierung und anderen Sicherheitsproblemen.

2. Tiefgreifendes Verständnis

Neben der oben erwähnten Leistungsverfolgung ist auch ein tiefgreifendes Verständnis von LLM (Large Model Language) ein Schlüsselelement der Beobachtbarkeit. Dies erfordert eine sorgfältige Prüfung der Trainingsdaten, die Formulierung des Entscheidungsalgorithmus, die Identifizierung etwaiger Einschränkungen und ein solides Verständnis der Einschränkungen des Modells.

(1)Trainingsdaten

Das Verständnis der Verteilung von Trainingsdaten ist von entscheidender Bedeutung, da Verzerrungen in den Daten zu Verzerrungen im Modell führen können. Wenn der Trainingsdatensatz beispielsweise hauptsächlich männliche Stimmen enthält, reagiert das Modell möglicherweise empfindlicher auf männliche Stimmen, was zu einer Tendenz gegenüber weiblichen Stimmen führt.

Neben Verzerrungen können auch Rauschen und Inkonsistenzen in den Trainingsdaten die Leistung des Modells beeinträchtigen. Daher müssen wir vor der Verwendung von Trainingsdaten die Qualität und Zuverlässigkeit der Daten sorgfältig prüfen.

(2) Entscheidungsalgorithmus

Die Analyse des Entscheidungsmechanismus hilft dabei, mögliche Verzerrungen oder Ungenauigkeiten im Modell zu identifizieren. Wenn sich ein Modell beispielsweise bei der Verarbeitung einer bestimmten Art von Eingabe ungewöhnlich verhält, kann dies auf einen Fehler im Entscheidungsalgorithmus hinweisen. Wenn wir die Entscheidungsmechanismen verstehen, können wir daher potenzielle Probleme mit dem Modell leichter identifizieren und beheben.

(3) Einschränkungen

Das Erkennen der Einschränkungen von LLM ist von unschätzbarem Wert. Obwohl diese Modelle fortgeschritten sind, sind sie nicht perfekt. Sie können Vorurteile aufweisen, Fehler erzeugen und anfällig für bestimmte ungewöhnliche Eingaben sein.

Zum Beispiel können LLMs verzerrte Ergebnisse liefern, weil sie auf Datensätzen trainiert werden, die Verzerrungen enthalten. Darüber hinaus können LLMs Fehler erzeugen, da sie auf probabilistischen Modellen basieren und daher ein gewisses Maß an Unsicherheit aufweisen. Schließlich kann LLM von bestimmten anormalen Eingaben betroffen sein, beispielsweise Eingaben mit Fehlern oder schädlichen Inhalten.

3. Zuverlässigkeitsgarantie

Die Gewährleistung der Zuverlässigkeit von LLM ist ein weiteres Kernelement der Beobachtbarkeit. Ein zuverlässiger LLM ist in der Lage, unter verschiedenen Eingabeszenarien stabil zu arbeiten, ohne abzustürzen oder fehlerhafte Ausgaben zu erzeugen, selbst unter rauen oder ungewöhnlichen Bedingungen.

Die gebräuchlichste Strategie sind Stresstests als gängige Methode zur Überprüfung der Zuverlässigkeit von LLM durch Bereitstellung verschiedener Eingaben für das LLM, einschließlich Eingaben, die das Modell herausfordern und an seine Grenzen bringen sollen. Ein zuverlässiges LLM kann diese Eingaben verarbeiten, ohne dass es zu Abstürzen oder fehlerhaften Ausgaben kommt.

Fehlertoleranz ist eine weitere gängige Strategie zur Gewährleistung der LLM-Zuverlässigkeit. Das fehlertolerante Design ermöglicht es LLM, den Betrieb fortzusetzen, wenn bestimmte Komponenten ausfallen. Fällt beispielsweise eine Schicht des LLM aus, sollte das fehlertolerante Modell dennoch in der Lage sein, genaue Vorhersagen zu generieren.

4. Genauigkeit

Das letzte Hauptziel der LLM-Beobachtbarkeit besteht darin, die „Genauigkeit“ des Modells zu verbessern, was die Identifizierung und Minderung von Verzerrungen und Fehlern erfordert. Verzerrungen und Fehler sind zwei Schlüsselfaktoren, die die Modellgenauigkeit beeinflussen.

Bias bezieht sich normalerweise auf den Unterschied zwischen den Modellvorhersageergebnissen und der realen Situation. Verzerrungen können von Faktoren wie Datensatz, Modelldesign oder Trainingsprozess herrühren. Verzerrungen können dazu führen, dass ein Modell unfaire oder ungenaue Ergebnisse liefert.

Fehler bedeutet normalerweise, dass die Ergebnisse der Modellvorhersage nicht mit der realen Situation übereinstimmen. Fehler können durch Zufälligkeit im Modell, Rauschen oder andere Faktoren verursacht werden. Fehler können dazu führen, dass Modelle ungenaue Ergebnisse liefern.

Abweichungserkennung und Fehlererkennung sind zwei gängige Techniken zur Identifizierung und Minderung von Verzerrungen und Fehlern. Die Bias-Erkennung identifiziert systematische Abweichungen in den Modellvorhersagen, während die Fehlererkennung etwaige Ungenauigkeiten in der Modellausgabe identifiziert.

Sobald Abweichungen und Fehler erkannt werden, können wir diese durch verschiedene Maßnahmen korrigieren. In tatsächlichen Geschäftsszenarien umfassen Korrekturmaßnahmen hauptsächlich Folgendes:

- Datenbereinigung: Abweichungen im Datensatz entfernen.

- Modelldesign: Modelldesign verbessern und Abweichungen reduzieren.

- Modelltraining: Verwenden Sie einen repräsentativeren Datensatz oder fortgeschrittenere Trainingsmethoden, um das Modell zu trainieren.

Häufig verwendete Fehlerkorrekturmaßnahmen umfassen hauptsächlich die folgenden Ebenen:

- Modell neu trainieren: Verwenden Sie einen genaueren Datensatz oder fortgeschrittenere Trainingsmethoden, um das Modell neu zu trainieren.

- Modellparameter verfeinern: Passen Sie die Modellparameter an, um Fehler zu reduzieren.

- Verwenden Sie Nachbearbeitungstechniken: Verarbeiten Sie die Modellausgabe nach, um die Genauigkeit zu verbessern.

Vor dem Hintergrund der oben genannten Aspekte kann die LLM-Beobachtbarkeit nur dann dazu beitragen, die Zuverlässigkeit und Vertrauenswürdigkeit von LLM zu verbessern, wenn das Leistungsdesign sorgfältig verfolgt, das Verständnis von LLM verbessert, die Genauigkeit optimiert und die Zuverlässigkeit sichergestellt wird.

Zusammenfassend lässt sich sagen, dass bei der Verwendung von LLM die Sicherstellung der Beobachtbarkeit eine Schlüsselpraxis ist, die dazu beiträgt, die Zuverlässigkeit und Vertrauenswürdigkeit der Verwendung von LLM sicherzustellen. Durch die Überwachung der Leistungskennzahlen und des Verhaltens von LLMs, den Gewinn von Einblicken in deren Innenleben und die Sicherstellung der Genauigkeit und Zuverlässigkeit von LLMs können Unternehmen die mit diesen leistungsstarken KI-Modellen verbundenen Risiken effektiv reduzieren.

Referenz: [1] https://docs.arize.com/arize/what-is-llm-observability

Das obige ist der detaillierte Inhalt vonEine kurze Analyse der LLM-Beobachtbarkeit. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Laravels Geospatial: Optimierung interaktiver Karten und großen Datenmengen

Apr 08, 2025 pm 12:24 PM

Laravels Geospatial: Optimierung interaktiver Karten und großen Datenmengen

Apr 08, 2025 pm 12:24 PM

Verarbeiten Sie 7 Millionen Aufzeichnungen effizient und erstellen Sie interaktive Karten mit Geospatial -Technologie. In diesem Artikel wird untersucht, wie über 7 Millionen Datensätze mithilfe von Laravel und MySQL effizient verarbeitet und in interaktive Kartenvisualisierungen umgewandelt werden können. Erstes Herausforderungsprojektanforderungen: Mit 7 Millionen Datensätzen in der MySQL -Datenbank wertvolle Erkenntnisse extrahieren. Viele Menschen erwägen zunächst Programmiersprachen, aber ignorieren die Datenbank selbst: Kann sie den Anforderungen erfüllen? Ist Datenmigration oder strukturelle Anpassung erforderlich? Kann MySQL einer so großen Datenbelastung standhalten? Voranalyse: Schlüsselfilter und Eigenschaften müssen identifiziert werden. Nach der Analyse wurde festgestellt, dass nur wenige Attribute mit der Lösung zusammenhängen. Wir haben die Machbarkeit des Filters überprüft und einige Einschränkungen festgelegt, um die Suche zu optimieren. Kartensuche basierend auf der Stadt

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Es gibt viele Gründe, warum MySQL Startup fehlschlägt und durch Überprüfung des Fehlerprotokolls diagnostiziert werden kann. Zu den allgemeinen Ursachen gehören Portkonflikte (prüfen Portbelegung und Änderung der Konfiguration), Berechtigungsprobleme (Überprüfen Sie den Dienst Ausführen von Benutzerberechtigungen), Konfigurationsdateifehler (Überprüfung der Parametereinstellungen), Datenverzeichniskorruption (Wiederherstellung von Daten oder Wiederaufbautabellenraum), InnoDB-Tabellenraumprobleme (prüfen IBDATA1-Dateien), Plug-in-Ladeversagen (Überprüfen Sie Fehlerprotokolle). Wenn Sie Probleme lösen, sollten Sie sie anhand des Fehlerprotokolls analysieren, die Hauptursache des Problems finden und die Gewohnheit entwickeln, Daten regelmäßig zu unterstützen, um Probleme zu verhindern und zu lösen.

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

Der Artikel führt den Betrieb der MySQL -Datenbank vor. Zunächst müssen Sie einen MySQL -Client wie MySQLworkBench oder Befehlszeilen -Client installieren. 1. Verwenden Sie den Befehl mySQL-uroot-P, um eine Verbindung zum Server herzustellen und sich mit dem Stammkonto-Passwort anzumelden. 2. Verwenden Sie die Erstellung von Createdatabase, um eine Datenbank zu erstellen, und verwenden Sie eine Datenbank aus. 3.. Verwenden Sie CreateTable, um eine Tabelle zu erstellen, Felder und Datentypen zu definieren. 4. Verwenden Sie InsertInto, um Daten einzulegen, Daten abzufragen, Daten nach Aktualisierung zu aktualisieren und Daten nach Löschen zu löschen. Nur indem Sie diese Schritte beherrschen, lernen, mit gemeinsamen Problemen umzugehen und die Datenbankleistung zu optimieren, können Sie MySQL effizient verwenden.

Remote Senior Backend Engineers (Plattformen) benötigen Kreise

Apr 08, 2025 pm 12:27 PM

Remote Senior Backend Engineers (Plattformen) benötigen Kreise

Apr 08, 2025 pm 12:27 PM

Remote Senior Backend Engineer Job Vacant Company: Circle Standort: Remote-Büro-Jobtyp: Vollzeitgehalt: 130.000 bis 140.000 US-Dollar Stellenbeschreibung Nehmen Sie an der Forschung und Entwicklung von Mobilfunkanwendungen und öffentlichen API-bezogenen Funktionen, die den gesamten Lebenszyklus der Softwareentwicklung abdecken. Die Hauptaufgaben erledigen die Entwicklungsarbeit unabhängig von RubyonRails und arbeiten mit dem Front-End-Team von React/Redux/Relay zusammen. Erstellen Sie die Kernfunktionalität und -verbesserungen für Webanwendungen und arbeiten Sie eng mit Designer und Führung während des gesamten funktionalen Designprozesses zusammen. Fördern Sie positive Entwicklungsprozesse und priorisieren Sie die Iterationsgeschwindigkeit. Erfordert mehr als 6 Jahre komplexes Backend für Webanwendungen

Kann MySQL JSON zurückgeben?

Apr 08, 2025 pm 03:09 PM

Kann MySQL JSON zurückgeben?

Apr 08, 2025 pm 03:09 PM

MySQL kann JSON -Daten zurückgeben. Die JSON_EXTRACT -Funktion extrahiert Feldwerte. Über komplexe Abfragen sollten Sie die Where -Klausel verwenden, um JSON -Daten zu filtern, aber auf die Leistungsauswirkungen achten. Die Unterstützung von MySQL für JSON nimmt ständig zu, und es wird empfohlen, auf die neuesten Versionen und Funktionen zu achten.

Verstehen von Säureeigenschaften: Die Säulen einer zuverlässigen Datenbank

Apr 08, 2025 pm 06:33 PM

Verstehen von Säureeigenschaften: Die Säulen einer zuverlässigen Datenbank

Apr 08, 2025 pm 06:33 PM

Detaillierte Erläuterung von Datenbanksäureattributen Säureattribute sind eine Reihe von Regeln, um die Zuverlässigkeit und Konsistenz von Datenbanktransaktionen sicherzustellen. Sie definieren, wie Datenbanksysteme Transaktionen umgehen, und sorgen dafür, dass die Datenintegrität und -genauigkeit auch im Falle von Systemabstürzen, Leistungsunterbrechungen oder mehreren Benutzern gleichzeitiger Zugriff. Säureattributübersicht Atomizität: Eine Transaktion wird als unteilbare Einheit angesehen. Jeder Teil schlägt fehl, die gesamte Transaktion wird zurückgerollt und die Datenbank behält keine Änderungen bei. Wenn beispielsweise eine Banküberweisung von einem Konto abgezogen wird, jedoch nicht auf ein anderes erhöht wird, wird der gesamte Betrieb widerrufen. begintransaktion; updateAccountsSetBalance = Balance-100WH

MySQL kann nach dem Herunterladen nicht installiert werden

Apr 08, 2025 am 11:24 AM

MySQL kann nach dem Herunterladen nicht installiert werden

Apr 08, 2025 am 11:24 AM

Die Hauptgründe für den Fehler bei MySQL -Installationsfehlern sind: 1. Erlaubnisprobleme, Sie müssen als Administrator ausgeführt oder den Sudo -Befehl verwenden. 2. Die Abhängigkeiten fehlen, und Sie müssen relevante Entwicklungspakete installieren. 3. Portkonflikte müssen Sie das Programm schließen, das Port 3306 einnimmt, oder die Konfigurationsdatei ändern. 4. Das Installationspaket ist beschädigt. Sie müssen die Integrität herunterladen und überprüfen. 5. Die Umgebungsvariable ist falsch konfiguriert und die Umgebungsvariablen müssen korrekt entsprechend dem Betriebssystem konfiguriert werden. Lösen Sie diese Probleme und überprüfen Sie jeden Schritt sorgfältig, um MySQL erfolgreich zu installieren.

Der Hauptschlüssel von MySQL kann null sein

Apr 08, 2025 pm 03:03 PM

Der Hauptschlüssel von MySQL kann null sein

Apr 08, 2025 pm 03:03 PM

Der MySQL -Primärschlüssel kann nicht leer sein, da der Primärschlüssel ein Schlüsselattribut ist, das jede Zeile in der Datenbank eindeutig identifiziert. Wenn der Primärschlüssel leer sein kann, kann der Datensatz nicht eindeutig identifiziert werden, was zu Datenverwirrung führt. Wenn Sie selbstsinkrementelle Ganzzahlsspalten oder UUIDs als Primärschlüssel verwenden, sollten Sie Faktoren wie Effizienz und Raumbelegung berücksichtigen und eine geeignete Lösung auswählen.