Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Jede kontinuierliche einwertige Funktion kann mit einem einschichtigen neuronalen Netzwerk angenähert werden

Jede kontinuierliche einwertige Funktion kann mit einem einschichtigen neuronalen Netzwerk angenähert werden

Jede kontinuierliche einwertige Funktion kann mit einem einschichtigen neuronalen Netzwerk angenähert werden

Einschichtiges neuronales Netzwerk, auch Perzeptron genannt, ist die einfachste neuronale Netzwerkstruktur. Es besteht aus einer Eingabeschicht und einer Ausgabeschicht mit einer gewichteten Verbindung zwischen jeder Eingabe und Ausgabe. Sein Hauptzweck besteht darin, die Zuordnungsbeziehung zwischen Eingabe und Ausgabe zu lernen. Aufgrund seiner starken Approximationsfähigkeit kann ein einschichtiges neuronales Netzwerk verschiedene einwertige kontinuierliche Funktionen anpassen. Daher verfügt es über ein breites Anwendungspotenzial bei Mustererkennungs- und Vorhersageproblemen.

Die Approximationsfähigkeit eines einschichtigen neuronalen Netzwerks kann durch den Perzeptron-Konvergenzsatz nachgewiesen werden. Der Satz besagt, dass das Perzeptron eine Schnittstelle finden kann, die linear trennbare Funktionen in zwei Kategorien unterteilt. Dies zeigt die Fähigkeit des Perzeptrons zur linearen Approximation. Für nichtlineare Funktionen ist die Approximationsfähigkeit eines einschichtigen neuronalen Netzwerks jedoch begrenzt. Um mit nichtlinearen Funktionen umgehen zu können, müssen wir daher mehrschichtige neuronale Netze oder andere komplexere Modelle verwenden. Diese Modelle verfügen über stärkere Approximationsfähigkeiten und können nichtlineare Beziehungen besser verarbeiten.

Glücklicherweise können wir die Sigmoid-Funktion als Aktivierungsfunktion verwenden, um die Approximationsfähigkeiten eines einschichtigen neuronalen Netzwerks zu erweitern. Die Sigmoidfunktion ist eine häufig verwendete nichtlineare Funktion, die reelle Zahlen auf Werte zwischen 0 und 1 abbildet. Durch die Verwendung der Sigmoid-Funktion als Aktivierungsfunktion eines einschichtigen neuronalen Netzwerks können wir ein neuronales Netzwerk mit nichtlinearen Approximationsfähigkeiten aufbauen. Dies liegt daran, dass die Sigmoid-Funktion die Eingabedaten in einen nichtlinearen Raum abbilden kann, sodass das neuronale Netzwerk die nichtlineare Funktion annähern kann. Der Vorteil der Verwendung der Sigmoid-Funktion als Aktivierungsfunktion besteht darin, dass sie glatte Eigenschaften aufweist und starke Schwankungen im Ausgabewert des neuronalen Netzwerks vermeiden kann. Darüber hinaus ist die Sigmoidfunktion relativ einfach zu berechnen und kann effizient berechnet werden. Daher ist die Sigmoidfunktion eine häufig verwendete und effektive Aktivierungsfunktion, die sich zur Erweiterung der Approximationsfähigkeit eines einschichtigen neuronalen Netzwerks eignet.

Neben der Sigmoid-Funktion sind auch die ReLU-Funktion und die Tanh-Funktion häufig verwendete Aktivierungsfunktionen. Sie haben alle nichtlineare Eigenschaften und können die Approximationsfähigkeit eines einschichtigen neuronalen Netzwerks verbessern.

Für sehr komplexe Funktionen kann ein einschichtiges neuronales Netzwerk jedoch eine große Anzahl von Neuronen erfordern, um zu passen. Dies schränkt die Anwendbarkeit einschichtiger neuronaler Netze bei der Bewältigung komplexer Probleme ein, da zur Bewältigung dieser Probleme häufig eine große Anzahl von Neuronen erforderlich ist, was zu einer Überanpassung und einem übermäßigen Rechenaufwand führen kann.

Um dieses Problem zu lösen, können wir ein mehrschichtiges neuronales Netzwerk verwenden. Ein mehrschichtiges neuronales Netzwerk ist ein neuronales Netzwerk, das aus mehreren Neuronen besteht, von denen jedes seine eigene Aktivierungsfunktion und sein eigenes Gewicht hat. Mehrschichtige neuronale Netze umfassen normalerweise eine Eingabeschicht, eine verborgene Schicht und eine Ausgabeschicht. Eine verborgene Schicht besteht aus einer oder mehreren Schichten von Neuronen, die sich zwischen der Eingabeschicht und der Ausgabeschicht befinden. Versteckte Schichten können die Approximationsfähigkeiten neuronaler Netze erhöhen und nichtlineare Probleme effektiv bewältigen.

Mit mehrschichtigen neuronalen Netzen können komplexe Probleme effektiv gelöst werden, die einschichtige neuronale Netze nicht bewältigen können. Mehrschichtige neuronale Netze können ihre Approximationsfähigkeiten durch das Hinzufügen verborgener Schichten erweitern. Jedes Neuron in der verborgenen Schicht kann bestimmte Merkmale oder Muster lernen, die zur besseren Annäherung an die Zielfunktion verwendet werden können. Darüber hinaus können mehrschichtige neuronale Netze den Backpropagation-Algorithmus verwenden, um die Gewichte zwischen Neuronen anzupassen, um Fehler zu minimieren und die Vorhersagegenauigkeit zu verbessern.

Kurz gesagt, ein einschichtiges neuronales Netzwerk kann zu jeder einwertigen kontinuierlichen Funktion passen, aber für nichtlineare Funktionen und sehr komplexe Probleme reicht die Approximationsfähigkeit eines einschichtigen neuronalen Netzwerks möglicherweise nicht aus. Durch die Verwendung mehrschichtiger neuronaler Netze können diese Probleme effektiv gelöst und die Approximationsfähigkeit und Vorhersagegenauigkeit neuronaler Netze verbessert werden.

Das obige ist der detaillierte Inhalt vonJede kontinuierliche einwertige Funktion kann mit einem einschichtigen neuronalen Netzwerk angenähert werden. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

Entdecken Sie die Konzepte, Unterschiede, Vor- und Nachteile von RNN, LSTM und GRU

Jan 22, 2024 pm 07:51 PM

Entdecken Sie die Konzepte, Unterschiede, Vor- und Nachteile von RNN, LSTM und GRU

Jan 22, 2024 pm 07:51 PM

In Zeitreihendaten gibt es Abhängigkeiten zwischen Beobachtungen, sie sind also nicht unabhängig voneinander. Herkömmliche neuronale Netze behandeln jedoch jede Beobachtung als unabhängig, was die Fähigkeit des Modells zur Modellierung von Zeitreihendaten einschränkt. Um dieses Problem zu lösen, wurde das Recurrent Neural Network (RNN) eingeführt, das das Konzept des Speichers einführte, um die dynamischen Eigenschaften von Zeitreihendaten zu erfassen, indem Abhängigkeiten zwischen Datenpunkten im Netzwerk hergestellt werden. Durch wiederkehrende Verbindungen kann RNN frühere Informationen an die aktuelle Beobachtung weitergeben, um zukünftige Werte besser vorherzusagen. Dies macht RNN zu einem leistungsstarken Werkzeug für Aufgaben mit Zeitreihendaten. Aber wie erreicht RNN diese Art von Gedächtnis? RNN realisiert das Gedächtnis durch die Rückkopplungsschleife im neuronalen Netzwerk. Dies ist der Unterschied zwischen RNN und herkömmlichen neuronalen Netzwerken.

Berechnung von Gleitkommaoperanden (FLOPS) für neuronale Netze

Jan 22, 2024 pm 07:21 PM

Berechnung von Gleitkommaoperanden (FLOPS) für neuronale Netze

Jan 22, 2024 pm 07:21 PM

FLOPS ist einer der Standards zur Bewertung der Computerleistung und dient zur Messung der Anzahl der Gleitkommaoperationen pro Sekunde. In neuronalen Netzen wird FLOPS häufig verwendet, um die Rechenkomplexität des Modells und die Nutzung von Rechenressourcen zu bewerten. Es ist ein wichtiger Indikator zur Messung der Rechenleistung und Effizienz eines Computers. Ein neuronales Netzwerk ist ein komplexes Modell, das aus mehreren Neuronenschichten besteht und für Aufgaben wie Datenklassifizierung, Regression und Clustering verwendet wird. Das Training und die Inferenz neuronaler Netze erfordert eine große Anzahl von Matrixmultiplikationen, Faltungen und anderen Rechenoperationen, sodass die Rechenkomplexität sehr hoch ist. Mit FLOPS (FloatingPointOperationsperSecond) kann die Rechenkomplexität neuronaler Netze gemessen werden, um die Effizienz der Rechenressourcennutzung des Modells zu bewerten. FLOP

Definition und Strukturanalyse eines Fuzzy-Neuronalen Netzwerks

Jan 22, 2024 pm 09:09 PM

Definition und Strukturanalyse eines Fuzzy-Neuronalen Netzwerks

Jan 22, 2024 pm 09:09 PM

Das Fuzzy-Neuronale Netzwerk ist ein Hybridmodell, das Fuzzy-Logik und neuronale Netzwerke kombiniert, um unscharfe oder unsichere Probleme zu lösen, die mit herkömmlichen neuronalen Netzwerken nur schwer zu bewältigen sind. Sein Design ist von der Unschärfe und Unsicherheit der menschlichen Wahrnehmung inspiriert und wird daher häufig in Steuerungssystemen, Mustererkennung, Data Mining und anderen Bereichen eingesetzt. Die Grundarchitektur eines Fuzzy-Neuronalen Netzwerks besteht aus einem Fuzzy-Subsystem und einem Neuronalen Subsystem. Das Fuzzy-Subsystem verwendet Fuzzy-Logik, um Eingabedaten zu verarbeiten und in Fuzzy-Sätze umzuwandeln, um die Unschärfe und Unsicherheit der Eingabedaten auszudrücken. Das neuronale Subsystem nutzt neuronale Netze zur Verarbeitung von Fuzzy-Sets für Aufgaben wie Klassifizierung, Regression oder Clustering. Durch die Interaktion zwischen dem Fuzzy-Subsystem und dem neuronalen Subsystem verfügt das Fuzzy-Neuronale Netzwerk über leistungsfähigere Verarbeitungsfähigkeiten und kann

Eine Fallstudie zur Verwendung des bidirektionalen LSTM-Modells zur Textklassifizierung

Jan 24, 2024 am 10:36 AM

Eine Fallstudie zur Verwendung des bidirektionalen LSTM-Modells zur Textklassifizierung

Jan 24, 2024 am 10:36 AM

Das bidirektionale LSTM-Modell ist ein neuronales Netzwerk, das zur Textklassifizierung verwendet wird. Unten finden Sie ein einfaches Beispiel, das zeigt, wie bidirektionales LSTM für Textklassifizierungsaufgaben verwendet wird. Zuerst müssen wir die erforderlichen Bibliotheken und Module importieren: importosimportnumpyasnpfromkeras.preprocessing.textimportTokenizerfromkeras.preprocessing.sequenceimportpad_sequencesfromkeras.modelsimportSequentialfromkeras.layersimportDense,Em

Bildrauschen mithilfe von Faltungs-Neuronalen Netzen

Jan 23, 2024 pm 11:48 PM

Bildrauschen mithilfe von Faltungs-Neuronalen Netzen

Jan 23, 2024 pm 11:48 PM

Faltungs-Neuronale Netze eignen sich gut für Aufgaben zur Bildrauschunterdrückung. Es nutzt die erlernten Filter, um das Rauschen zu filtern und so das Originalbild wiederherzustellen. In diesem Artikel wird die Methode zur Bildentrauschung basierend auf einem Faltungs-Neuronalen Netzwerk ausführlich vorgestellt. 1. Überblick über das Convolutional Neural Network Das Convolutional Neural Network ist ein Deep-Learning-Algorithmus, der eine Kombination aus mehreren Faltungsschichten, Pooling-Schichten und vollständig verbundenen Schichten verwendet, um Bildmerkmale zu lernen und zu klassifizieren. In der Faltungsschicht werden die lokalen Merkmale des Bildes durch Faltungsoperationen extrahiert und so die räumliche Korrelation im Bild erfasst. Die Pooling-Schicht reduziert den Rechenaufwand durch Reduzierung der Feature-Dimension und behält die Hauptfeatures bei. Die vollständig verbundene Schicht ist für die Zuordnung erlernter Merkmale und Beschriftungen zur Implementierung der Bildklassifizierung oder anderer Aufgaben verantwortlich. Das Design dieser Netzwerkstruktur macht das Faltungs-Neuronale Netzwerk für die Bildverarbeitung und -erkennung nützlich.

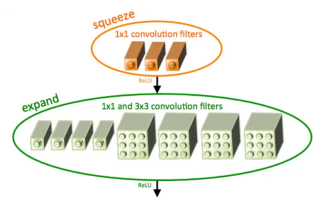

Einführung in SqueezeNet und seine Eigenschaften

Jan 22, 2024 pm 07:15 PM

Einführung in SqueezeNet und seine Eigenschaften

Jan 22, 2024 pm 07:15 PM

SqueezeNet ist ein kleiner und präziser Algorithmus, der eine gute Balance zwischen hoher Genauigkeit und geringer Komplexität schafft und sich daher ideal für mobile und eingebettete Systeme mit begrenzten Ressourcen eignet. Im Jahr 2016 schlugen Forscher von DeepScale, der University of California, Berkeley und der Stanford University SqueezeNet vor, ein kompaktes und effizientes Faltungs-Neuronales Netzwerk (CNN). In den letzten Jahren haben Forscher mehrere Verbesserungen an SqueezeNet vorgenommen, darunter SqueezeNetv1.1 und SqueezeNetv2.0. Verbesserungen in beiden Versionen erhöhen nicht nur die Genauigkeit, sondern senken auch die Rechenkosten. Genauigkeit von SqueezeNetv1.1 im ImageNet-Datensatz

Twin Neural Network: Prinzip- und Anwendungsanalyse

Jan 24, 2024 pm 04:18 PM

Twin Neural Network: Prinzip- und Anwendungsanalyse

Jan 24, 2024 pm 04:18 PM

Das Siamese Neural Network ist eine einzigartige künstliche neuronale Netzwerkstruktur. Es besteht aus zwei identischen neuronalen Netzen mit denselben Parametern und Gewichten. Gleichzeitig teilen die beiden Netzwerke auch die gleichen Eingabedaten. Dieses Design wurde von Zwillingen inspiriert, da die beiden neuronalen Netze strukturell identisch sind. Das Prinzip des siamesischen neuronalen Netzwerks besteht darin, bestimmte Aufgaben wie Bildabgleich, Textabgleich und Gesichtserkennung durch den Vergleich der Ähnlichkeit oder des Abstands zwischen zwei Eingabedaten auszuführen. Während des Trainings versucht das Netzwerk, ähnliche Daten benachbarten Regionen und unterschiedliche Daten entfernten Regionen zuzuordnen. Auf diese Weise kann das Netzwerk lernen, verschiedene Daten zu klassifizieren oder abzugleichen, um entsprechende Ergebnisse zu erzielen

Schritte zum Schreiben eines einfachen neuronalen Netzwerks mit Rust

Jan 23, 2024 am 10:45 AM

Schritte zum Schreiben eines einfachen neuronalen Netzwerks mit Rust

Jan 23, 2024 am 10:45 AM

Rust ist eine Programmiersprache auf Systemebene, die sich auf Sicherheit, Leistung und Parallelität konzentriert. Ziel ist es, eine sichere und zuverlässige Programmiersprache bereitzustellen, die für Szenarien wie Betriebssysteme, Netzwerkanwendungen und eingebettete Systeme geeignet ist. Die Sicherheit von Rust beruht hauptsächlich auf zwei Aspekten: dem Eigentumssystem und dem Kreditprüfer. Das Besitzsystem ermöglicht es dem Compiler, den Code zur Kompilierungszeit auf Speicherfehler zu überprüfen und so häufige Speichersicherheitsprobleme zu vermeiden. Indem Rust die Überprüfung der Eigentumsübertragungen von Variablen zur Kompilierungszeit erzwingt, stellt Rust sicher, dass Speicherressourcen ordnungsgemäß verwaltet und freigegeben werden. Der Borrow-Checker analysiert den Lebenszyklus der Variablen, um sicherzustellen, dass nicht mehrere Threads gleichzeitig auf dieselbe Variable zugreifen, wodurch häufige Sicherheitsprobleme bei der Parallelität vermieden werden. Durch die Kombination dieser beiden Mechanismen ist Rust in der Lage, Folgendes bereitzustellen