Backend-Entwicklung

Backend-Entwicklung

Python-Tutorial

Python-Tutorial

Das Prinzip und die Implementierungsmethode zur Implementierung des Entscheidungsbaumalgorithmus in Python

Das Prinzip und die Implementierungsmethode zur Implementierung des Entscheidungsbaumalgorithmus in Python

Das Prinzip und die Implementierungsmethode zur Implementierung des Entscheidungsbaumalgorithmus in Python

Der Entscheidungsbaumalgorithmus gehört zur Kategorie der überwachten Lernalgorithmen, eignet sich für kontinuierliche und kategoriale Ausgabevariablen und wird normalerweise zur Lösung von Klassifizierungs- und Regressionsproblemen verwendet.

Ein Entscheidungsbaum ist eine Baumstruktur ähnlich einem Flussdiagramm, in der jeder interne Knoten einen Test eines Attributs darstellt, jeder Zweig das Ergebnis des Tests darstellt und jeder Knoten einer Klassenbezeichnung entspricht.

Idee für den Entscheidungsbaumalgorithmus

Behandeln Sie zunächst den gesamten Trainingssatz als Wurzel.

Zur Informationsgewinnung wird davon ausgegangen, dass die Attribute kategorisch sind, und für den Gini-Index wird davon ausgegangen, dass die Attribute kontinuierlich sind.

Datensätze werden basierend auf Attributwerten rekursiv verteilt.

Verwenden Sie statistische Methoden, um Attribute nach Wurzelknoten zu sortieren.

Finden Sie das beste Attribut und platzieren Sie es im Wurzelknoten des Baums.

Teilen Sie nun den Trainingssatz des Datensatzes in Teilmengen auf. Stellen Sie beim Erstellen von Teilmengen sicher, dass jede Teilmenge des Trainingsdatensatzes dieselben Attributwerte haben sollte.

Finden Sie Blattknoten in allen Zweigen, indem Sie 1 und 2 für jede Teilmenge wiederholen.

Die Implementierung des Entscheidungsbaumalgorithmus in Python

erfordert zwei Phasen der Konstruktion und des Betriebs:

Konstruktionsphase und Vorverarbeitungsdatensatz. Teilen Sie den Datensatz mithilfe des Python-Sklearn-Pakets aus Training und Tests auf. Trainieren Sie den Klassifikator.

Treffen Sie in der Operationsphase Vorhersagen. Berechnungsgenauigkeit.

Datenimport: Um Daten zu importieren und zu bearbeiten, verwenden wir das in Python bereitgestellte Pandas-Paket.

Hier verwenden wir die URL, um den Datensatz direkt von der UCI-Website abzurufen, ohne den Datensatz herunterzuladen. Wenn Sie versuchen, diesen Code auf Ihrem System auszuführen, stellen Sie sicher, dass das System über eine aktive Internetverbindung verfügt.

Da der Datensatz durch "," getrennt ist, müssen wir den Wert des sep-Parameters als übergeben.

Außerdem ist zu beachten, dass der Datensatz keine Header enthält, daher übergeben wir den Wert des Header-Parameters als „none“. Wenn wir den Header-Parameter nicht übergeben, wird die erste Zeile des Datensatzes als Header betrachtet.

Datenaufteilung: Vor dem Training des Modells müssen wir den Datensatz in Trainings- und Testdatensätze aufteilen.

Um den Datensatz für Training und Tests aufzuteilen, haben wir das Sklearn-Modul train_test_split verwendet.

Zuerst müssen wir die Zielvariable von den Attributen im Datensatz trennen.

X=balance_data.values[:,1:5] Y=balance_data.values[:,0]

Oben sind die Codezeilen, die den Datensatz trennen. Variable X enthält die Attribute, während Variable Y die Zielvariable des Datensatzes enthält.

Der nächste Schritt besteht darin, den Datensatz für Trainings- und Testzwecke aufzuteilen.

X_train,X_test,y_train,y_test=train_test_split( X,Y,test_size=0.3,random_state=100)

Die vorherige Zeile teilt den Datensatz für Training und Tests auf. Da wir den Datensatz im Verhältnis 70:30 zwischen Training und Test aufteilen, übergeben wir den Wert des Parameters test_size als 0,3. Die Variable „random_state“ ist der Status des Pseudozufallszahlengenerators, der für die Zufallsstichprobe verwendet wird.

Das obige ist der detaillierte Inhalt vonDas Prinzip und die Implementierungsmethode zur Implementierung des Entscheidungsbaumalgorithmus in Python. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1382

1382

52

52

Eine eingehende Analyse des Grey Wolf Optimization Algorithm (GWO) und seiner Stärken und Schwächen

Jan 19, 2024 pm 07:48 PM

Eine eingehende Analyse des Grey Wolf Optimization Algorithm (GWO) und seiner Stärken und Schwächen

Jan 19, 2024 pm 07:48 PM

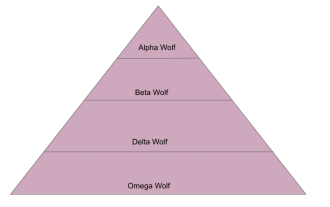

Der Grey Wolf Optimization Algorithm (GWO) ist ein bevölkerungsbasierter metaheuristischer Algorithmus, der die Führungshierarchie und den Jagdmechanismus grauer Wölfe in der Natur simuliert. Inspiration zum Grauwolf-Algorithmus 1. Graue Wölfe gelten als Spitzenprädatoren und stehen an der Spitze der Nahrungskette. 2. Graue Wölfe leben gerne in Gruppen (Gruppenleben), mit durchschnittlich 5-12 Wölfen in jedem Rudel. 3. Graue Wölfe haben eine sehr strenge soziale Dominanzhierarchie, wie unten gezeigt: Alpha-Wolf: Alpha-Wolf nimmt eine dominante Position in der gesamten Gruppe grauer Wölfe ein und hat das Recht, die gesamte Gruppe grauer Wölfe zu befehligen. Bei der Anwendung von Algorithmen ist Alpha Wolf eine der besten Lösungen, die vom Optimierungsalgorithmus erzeugte optimale Lösung. Beta-Wolf: Beta-Wolf berichtet regelmäßig an Alpha-Wolf und hilft Alpha-Wolf, die besten Entscheidungen zu treffen. In Algorithmusanwendungen kann Beta Wolf

Erkunden Sie die Grundprinzipien und den Implementierungsprozess verschachtelter Sampling-Algorithmen

Jan 22, 2024 pm 09:51 PM

Erkunden Sie die Grundprinzipien und den Implementierungsprozess verschachtelter Sampling-Algorithmen

Jan 22, 2024 pm 09:51 PM

Der verschachtelte Stichprobenalgorithmus ist ein effizienter Bayes'scher statistischer Inferenzalgorithmus, der zur Berechnung des Integrals oder der Summation unter komplexen Wahrscheinlichkeitsverteilungen verwendet wird. Dabei wird der Parameterraum in mehrere Hyperwürfel mit gleichem Volumen zerlegt und schrittweise und iterativ einer der Hyperwürfel mit dem kleinsten Volumen „herausgeschoben“ und dann der Hyperwürfel mit Zufallsstichproben gefüllt, um den Integralwert der Wahrscheinlichkeitsverteilung besser abzuschätzen. Durch kontinuierliche Iteration kann der verschachtelte Stichprobenalgorithmus hochpräzise Integralwerte und Grenzen des Parameterraums erhalten, die auf statistische Probleme wie Modellvergleich, Parameterschätzung und Modellauswahl angewendet werden können. Die Kernidee dieses Algorithmus besteht darin, komplexe Integrationsprobleme in eine Reihe einfacher Integrationsprobleme umzuwandeln und sich dem wahren Integralwert zu nähern, indem das Volumen des Parameterraums schrittweise verringert wird. Bei jedem Iterationsschritt werden zufällig Stichproben aus dem Parameterraum entnommen

Analysieren Sie die Prinzipien, Modelle und Zusammensetzung des Sparrow Search Algorithm (SSA)

Jan 19, 2024 pm 10:27 PM

Analysieren Sie die Prinzipien, Modelle und Zusammensetzung des Sparrow Search Algorithm (SSA)

Jan 19, 2024 pm 10:27 PM

Der Sparrow Search Algorithm (SSA) ist ein metaheuristischer Optimierungsalgorithmus, der auf dem Anti-Raub- und Futtersuchverhalten von Spatzen basiert. Das Futtersuchverhalten von Spatzen kann in zwei Haupttypen unterteilt werden: Produzenten und Aasfresser. Produzenten suchen aktiv nach Nahrungsmitteln, während Aasfresser um Nahrungsmittel von Produzenten konkurrieren. Prinzip des Sparrow-Suchalgorithmus (SSA) Beim Sparrow-Suchalgorithmus (SSA) achtet jeder Spatz genau auf das Verhalten seiner Nachbarn. Durch den Einsatz verschiedener Futtersuchstrategien sind Einzelpersonen in der Lage, die gespeicherte Energie effizient zu nutzen, um mehr Nahrung zu suchen. Darüber hinaus sind Vögel in ihrem Suchraum anfälliger für Raubtiere und müssen daher sicherere Orte finden. Vögel in der Mitte einer Kolonie können ihren eigenen Gefahrenbereich minimieren, indem sie in der Nähe ihrer Nachbarn bleiben. Wenn ein Vogel ein Raubtier entdeckt, alarmiert er es

Detaillierte Erläuterung des Bellman-Ford-Algorithmus und der Implementierung in Python

Jan 22, 2024 pm 07:39 PM

Detaillierte Erläuterung des Bellman-Ford-Algorithmus und der Implementierung in Python

Jan 22, 2024 pm 07:39 PM

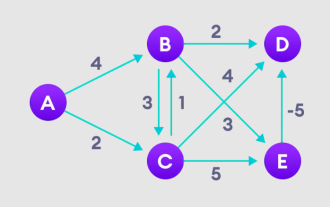

Der Bellman-Ford-Algorithmus kann den kürzesten Weg vom Zielknoten zu anderen Knoten im gewichteten Diagramm finden. Dies ist dem Dijkstra-Algorithmus sehr ähnlich. Der Bellman-Ford-Algorithmus kann Diagramme mit negativen Gewichten verarbeiten und ist hinsichtlich der Implementierung relativ einfach. Ausführliche Erläuterung des Prinzips des Bellman-Ford-Algorithmus: Der Bellman-Ford-Algorithmus findet iterativ neue Pfade, die kürzer als die überschätzten Pfade sind, indem er die Pfadlängen vom Startscheitelpunkt zu allen anderen Scheitelpunkten überschätzt. Da wir die Pfadentfernung jedes Knotens aufzeichnen möchten, können wir sie in einem Array der Größe n speichern, wobei n auch die Anzahl der Knoten darstellt. Beispiel Abbildung 1. Wählen Sie den Startknoten aus, weisen Sie ihn unbegrenzt allen anderen Scheitelpunkten zu und zeichnen Sie den Pfadwert auf. 2. Besuchen Sie jede Kante und führen Sie Entspannungsoperationen durch, um den kürzesten Pfad kontinuierlich zu aktualisieren. 3. Wir brauchen

Einführung in den Wu-Manber-Algorithmus und Python-Implementierungsanweisungen

Jan 23, 2024 pm 07:03 PM

Einführung in den Wu-Manber-Algorithmus und Python-Implementierungsanweisungen

Jan 23, 2024 pm 07:03 PM

Der Wu-Manber-Algorithmus ist ein String-Matching-Algorithmus zur effizienten Suche nach Strings. Es handelt sich um einen Hybridalgorithmus, der die Vorteile der Boyer-Moore- und Knuth-Morris-Pratt-Algorithmen kombiniert, um einen schnellen und genauen Mustervergleich zu ermöglichen. Schritt 1 des Wu-Manber-Algorithmus: Erstellen Sie eine Hash-Tabelle, die jede mögliche Teilzeichenfolge des Musters der Musterposition zuordnet, an der diese Teilzeichenfolge auftritt. 2. Diese Hash-Tabelle wird verwendet, um mögliche Startpositionen von Mustern im Text schnell zu identifizieren. 3. Durchlaufen Sie den Text und vergleichen Sie jedes Zeichen mit dem entsprechenden Zeichen im Muster. 4. Wenn die Zeichen übereinstimmen, können Sie zum nächsten Zeichen wechseln und den Vergleich fortsetzen. 5. Wenn die Zeichen nicht übereinstimmen, können Sie mithilfe einer Hash-Tabelle das nächste mögliche Zeichen im Muster ermitteln.

Numerische Optimierungsprinzipien und Analyse des Whale Optimization Algorithm (WOA)

Jan 19, 2024 pm 07:27 PM

Numerische Optimierungsprinzipien und Analyse des Whale Optimization Algorithm (WOA)

Jan 19, 2024 pm 07:27 PM

Der Whale Optimization Algorithm (WOA) ist ein von der Natur inspirierter metaheuristischer Optimierungsalgorithmus, der das Jagdverhalten von Buckelwalen simuliert und zur Optimierung numerischer Probleme eingesetzt wird. Der Whale Optimization Algorithm (WOA) beginnt mit einer Reihe zufälliger Lösungen und optimiert basierend auf einem zufällig ausgewählten Suchagenten oder der bisher besten Lösung durch Positionsaktualisierungen des Suchagenten in jeder Iteration. Inspiration für den Waloptimierungsalgorithmus Der Waloptimierungsalgorithmus ist vom Jagdverhalten von Buckelwalen inspiriert. Buckelwale bevorzugen oberflächennahe Nahrung wie Krill und Fischschwärme. Daher sammeln Buckelwale Nahrung und bilden ein Blasennetzwerk, indem sie bei der Jagd Blasen in einer Spirale von unten nach oben blasen. Bei einem „Aufwärtsspiral“-Manöver taucht der Buckelwal etwa 12 m tief, beginnt dann, eine spiralförmige Blase um seine Beute zu bilden und schwimmt nach oben

Welche Rolle spielt der Informationsgewinn im ID3-Algorithmus?

Jan 23, 2024 pm 11:27 PM

Welche Rolle spielt der Informationsgewinn im ID3-Algorithmus?

Jan 23, 2024 pm 11:27 PM

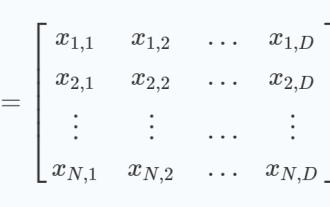

Der ID3-Algorithmus ist einer der grundlegenden Algorithmen beim Lernen von Entscheidungsbäumen. Es wählt den besten Teilungspunkt aus, indem es den Informationsgewinn jedes Features berechnet, um einen Entscheidungsbaum zu erstellen. Der Informationsgewinn ist ein wichtiges Konzept im ID3-Algorithmus, der zur Messung des Beitrags von Merkmalen zur Klassifizierungsaufgabe verwendet wird. In diesem Artikel werden das Konzept, die Berechnungsmethode und die Anwendung des Informationsgewinns im ID3-Algorithmus ausführlich vorgestellt. 1. Das Konzept der Informationsentropie Informationsentropie ist ein Konzept der Informationstheorie, das die Unsicherheit von Zufallsvariablen misst. Für eine diskrete Zufallsvariablenzahl stellt p(x_i) die Wahrscheinlichkeit dar, dass die Zufallsvariable X den Wert x_i annimmt. Brief

SIFT-Algorithmus (Scale Invariant Features).

Jan 22, 2024 pm 05:09 PM

SIFT-Algorithmus (Scale Invariant Features).

Jan 22, 2024 pm 05:09 PM

Der Scale Invariant Feature Transform (SIFT)-Algorithmus ist ein Merkmalsextraktionsalgorithmus, der in den Bereichen Bildverarbeitung und Computer Vision verwendet wird. Dieser Algorithmus wurde 1999 vorgeschlagen, um die Objekterkennung und die Matching-Leistung in Computer-Vision-Systemen zu verbessern. Der SIFT-Algorithmus ist robust und genau und wird häufig in der Bilderkennung, dreidimensionalen Rekonstruktion, Zielerkennung, Videoverfolgung und anderen Bereichen eingesetzt. Es erreicht Skaleninvarianz, indem es Schlüsselpunkte in mehreren Skalenräumen erkennt und lokale Merkmalsdeskriptoren um die Schlüsselpunkte herum extrahiert. Zu den Hauptschritten des SIFT-Algorithmus gehören die Skalenraumkonstruktion, die Erkennung von Schlüsselpunkten, die Positionierung von Schlüsselpunkten, die Richtungszuweisung und die Generierung von Merkmalsdeskriptoren. Durch diese Schritte kann der SIFT-Algorithmus robuste und einzigartige Merkmale extrahieren und so eine effiziente Bildverarbeitung erreichen.