Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Analyse künstlicher neuronaler Netzlernmethoden im Deep Learning

Analyse künstlicher neuronaler Netzlernmethoden im Deep Learning

Analyse künstlicher neuronaler Netzlernmethoden im Deep Learning

Deep Learning ist ein Zweig des maschinellen Lernens, der darauf abzielt, die Fähigkeiten des Gehirns bei der Datenverarbeitung zu simulieren. Es löst Probleme durch den Aufbau künstlicher neuronaler Netzwerkmodelle, die es Maschinen ermöglichen, ohne Aufsicht zu lernen. Dieser Ansatz ermöglicht es Maschinen, komplexe Muster und Merkmale automatisch zu extrahieren und zu verstehen. Durch Deep Learning können Maschinen aus großen Datenmengen lernen und hochpräzise Vorhersagen und Entscheidungen liefern. Dadurch konnte Deep Learning große Erfolge in Bereichen wie Computer Vision, Verarbeitung natürlicher Sprache und Spracherkennung erzielen.

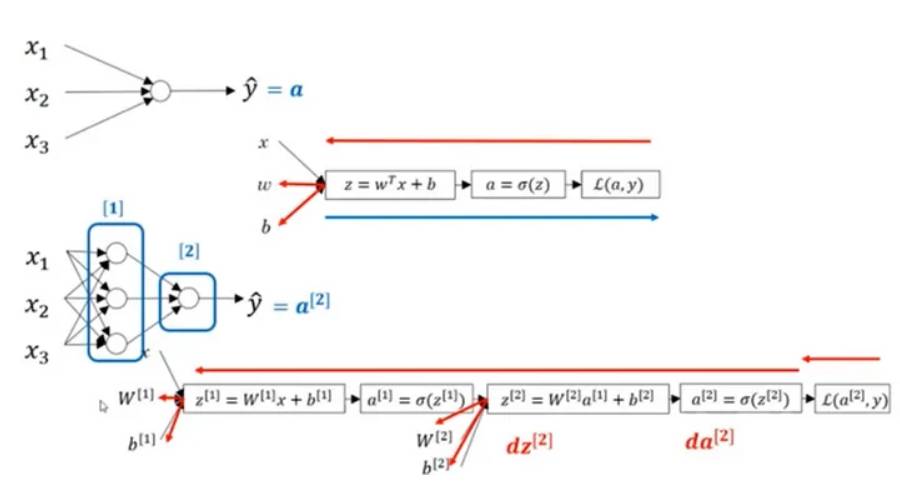

Um die Funktion neuronaler Netze zu verstehen, betrachten Sie die Übertragung von Impulsen in Neuronen. Nachdem Daten vom Dendritenterminal empfangen wurden, werden sie im Zellkern gewichtet (mit w multipliziert) und dann entlang des Axons weitergeleitet und mit einer anderen Nervenzelle verbunden. Axone (x) sind der Ausgang eines Neurons und werden zum Eingang eines anderen Neurons, wodurch die Informationsübertragung zwischen den Nerven sichergestellt wird.

Um am Computer zu modellieren und zu trainieren, müssen wir den Algorithmus der Operation verstehen und durch Eingabe des Befehls die Ausgabe erhalten.

Hier drücken wir es mathematisch wie folgt aus:

In der obigen Abbildung ist ein zweischichtiges neuronales Netzwerk dargestellt, das eine verborgene Schicht aus 4 Neuronen und eine Ausgabeschicht mit einem einzelnen Neuron enthält. Es ist zu beachten, dass die Anzahl der Eingabeschichten keinen Einfluss auf den Betrieb des neuronalen Netzwerks hat. Die Anzahl der Neuronen in diesen Schichten und die Anzahl der Eingabewerte werden durch die Parameter w und b dargestellt. Insbesondere ist die Eingabe in die verborgene Ebene x und die Eingabe in die Ausgabeebene ist der Wert von a.

Hyperbolischer Tangens, ReLU, Leaky ReLU und andere Funktionen können Sigmoid als differenzierbare Aktivierungsfunktion ersetzen und in der Schicht verwendet werden, und die Gewichte werden durch die Ableitungsoperation bei der Backpropagation aktualisiert.

Die ReLU-Aktivierungsfunktion wird häufig beim Deep Learning verwendet. Da die Teile der ReLU-Funktion, die kleiner als 0 sind, nicht differenzierbar sind, lernen sie während des Trainings nicht. Die Leaky-ReLU-Aktivierungsfunktion löst dieses Problem. Sie ist in Teilen kleiner als 0 differenzierbar und lernt auf jeden Fall. Dies macht Leaky ReLU in einigen Szenarien effektiver als ReLU.

Das obige ist der detaillierte Inhalt vonAnalyse künstlicher neuronaler Netzlernmethoden im Deep Learning. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1384

1384

52

52

Jenseits von ORB-SLAM3! SL-SLAM: Szenen mit wenig Licht, starkem Jitter und schwacher Textur werden verarbeitet

May 30, 2024 am 09:35 AM

Jenseits von ORB-SLAM3! SL-SLAM: Szenen mit wenig Licht, starkem Jitter und schwacher Textur werden verarbeitet

May 30, 2024 am 09:35 AM

Heute diskutieren wir darüber, wie Deep-Learning-Technologie die Leistung von visionbasiertem SLAM (Simultaneous Localization and Mapping) in komplexen Umgebungen verbessern kann. Durch die Kombination von Methoden zur Tiefenmerkmalsextraktion und Tiefenanpassung stellen wir hier ein vielseitiges hybrides visuelles SLAM-System vor, das die Anpassung in anspruchsvollen Szenarien wie schlechten Lichtverhältnissen, dynamischer Beleuchtung, schwach strukturierten Bereichen und starkem Jitter verbessern soll. Unser System unterstützt mehrere Modi, einschließlich erweiterter Monokular-, Stereo-, Monokular-Trägheits- und Stereo-Trägheitskonfigurationen. Darüber hinaus wird analysiert, wie visuelles SLAM mit Deep-Learning-Methoden kombiniert werden kann, um andere Forschungen zu inspirieren. Durch umfangreiche Experimente mit öffentlichen Datensätzen und selbst abgetasteten Daten demonstrieren wir die Überlegenheit von SL-SLAM in Bezug auf Positionierungsgenauigkeit und Tracking-Robustheit.

Verstehen Sie in einem Artikel: die Zusammenhänge und Unterschiede zwischen KI, maschinellem Lernen und Deep Learning

Mar 02, 2024 am 11:19 AM

Verstehen Sie in einem Artikel: die Zusammenhänge und Unterschiede zwischen KI, maschinellem Lernen und Deep Learning

Mar 02, 2024 am 11:19 AM

In der heutigen Welle rasanter technologischer Veränderungen sind künstliche Intelligenz (KI), maschinelles Lernen (ML) und Deep Learning (DL) wie helle Sterne und führen die neue Welle der Informationstechnologie an. Diese drei Wörter tauchen häufig in verschiedenen hochaktuellen Diskussionen und praktischen Anwendungen auf, aber für viele Entdecker, die neu auf diesem Gebiet sind, sind ihre spezifische Bedeutung und ihre internen Zusammenhänge möglicherweise noch immer rätselhaft. Schauen wir uns also zunächst dieses Bild an. Es ist ersichtlich, dass zwischen Deep Learning, maschinellem Lernen und künstlicher Intelligenz ein enger Zusammenhang und eine fortschreitende Beziehung besteht. Deep Learning ist ein spezifischer Bereich des maschinellen Lernens und des maschinellen Lernens

Super stark! Top 10 Deep-Learning-Algorithmen!

Mar 15, 2024 pm 03:46 PM

Super stark! Top 10 Deep-Learning-Algorithmen!

Mar 15, 2024 pm 03:46 PM

Fast 20 Jahre sind vergangen, seit das Konzept des Deep Learning im Jahr 2006 vorgeschlagen wurde. Deep Learning hat als Revolution auf dem Gebiet der künstlichen Intelligenz viele einflussreiche Algorithmen hervorgebracht. Was sind Ihrer Meinung nach die zehn besten Algorithmen für Deep Learning? Im Folgenden sind meiner Meinung nach die besten Algorithmen für Deep Learning aufgeführt. Sie alle nehmen hinsichtlich Innovation, Anwendungswert und Einfluss eine wichtige Position ein. 1. Hintergrund des Deep Neural Network (DNN): Deep Neural Network (DNN), auch Multi-Layer-Perceptron genannt, ist der am weitesten verbreitete Deep-Learning-Algorithmus. Als er erstmals erfunden wurde, wurde er aufgrund des Engpasses bei der Rechenleistung in Frage gestellt Jahre, Rechenleistung, Der Durchbruch kam mit der Datenexplosion. DNN ist ein neuronales Netzwerkmodell, das mehrere verborgene Schichten enthält. In diesem Modell übergibt jede Schicht Eingaben an die nächste Schicht und

Eine Fallstudie zur Verwendung des bidirektionalen LSTM-Modells zur Textklassifizierung

Jan 24, 2024 am 10:36 AM

Eine Fallstudie zur Verwendung des bidirektionalen LSTM-Modells zur Textklassifizierung

Jan 24, 2024 am 10:36 AM

Das bidirektionale LSTM-Modell ist ein neuronales Netzwerk, das zur Textklassifizierung verwendet wird. Unten finden Sie ein einfaches Beispiel, das zeigt, wie bidirektionales LSTM für Textklassifizierungsaufgaben verwendet wird. Zuerst müssen wir die erforderlichen Bibliotheken und Module importieren: importosimportnumpyasnpfromkeras.preprocessing.textimportTokenizerfromkeras.preprocessing.sequenceimportpad_sequencesfromkeras.modelsimportSequentialfromkeras.layersimportDense,Em

AlphaFold 3 wird auf den Markt gebracht und sagt die Wechselwirkungen und Strukturen von Proteinen und allen Lebensmolekülen umfassend und mit weitaus größerer Genauigkeit als je zuvor voraus

Jul 16, 2024 am 12:08 AM

AlphaFold 3 wird auf den Markt gebracht und sagt die Wechselwirkungen und Strukturen von Proteinen und allen Lebensmolekülen umfassend und mit weitaus größerer Genauigkeit als je zuvor voraus

Jul 16, 2024 am 12:08 AM

Herausgeber | Rettichhaut Seit der Veröffentlichung des leistungsstarken AlphaFold2 im Jahr 2021 verwenden Wissenschaftler Modelle zur Proteinstrukturvorhersage, um verschiedene Proteinstrukturen innerhalb von Zellen zu kartieren, Medikamente zu entdecken und eine „kosmische Karte“ jeder bekannten Proteininteraktion zu zeichnen. Gerade hat Google DeepMind das AlphaFold3-Modell veröffentlicht, das gemeinsame Strukturvorhersagen für Komplexe wie Proteine, Nukleinsäuren, kleine Moleküle, Ionen und modifizierte Reste durchführen kann. Die Genauigkeit von AlphaFold3 wurde im Vergleich zu vielen dedizierten Tools in der Vergangenheit (Protein-Ligand-Interaktion, Protein-Nukleinsäure-Interaktion, Antikörper-Antigen-Vorhersage) deutlich verbessert. Dies zeigt, dass dies innerhalb eines einzigen einheitlichen Deep-Learning-Frameworks möglich ist

So verwenden Sie CNN- und Transformer-Hybridmodelle, um die Leistung zu verbessern

Jan 24, 2024 am 10:33 AM

So verwenden Sie CNN- und Transformer-Hybridmodelle, um die Leistung zu verbessern

Jan 24, 2024 am 10:33 AM

Convolutional Neural Network (CNN) und Transformer sind zwei verschiedene Deep-Learning-Modelle, die bei verschiedenen Aufgaben eine hervorragende Leistung gezeigt haben. CNN wird hauptsächlich für Computer-Vision-Aufgaben wie Bildklassifizierung, Zielerkennung und Bildsegmentierung verwendet. Es extrahiert lokale Merkmale auf dem Bild durch Faltungsoperationen und führt eine Reduzierung der Merkmalsdimensionalität und räumliche Invarianz durch Pooling-Operationen durch. Im Gegensatz dazu wird Transformer hauptsächlich für Aufgaben der Verarbeitung natürlicher Sprache (NLP) wie maschinelle Übersetzung, Textklassifizierung und Spracherkennung verwendet. Es nutzt einen Selbstaufmerksamkeitsmechanismus, um Abhängigkeiten in Sequenzen zu modellieren und vermeidet so die sequentielle Berechnung in herkömmlichen rekurrenten neuronalen Netzen. Obwohl diese beiden Modelle für unterschiedliche Aufgaben verwendet werden, weisen sie Ähnlichkeiten in der Sequenzmodellierung auf

TensorFlow Deep-Learning-Framework-Modell-Inferenzpipeline für Porträtausschnitt-Inferenz

Mar 26, 2024 pm 01:00 PM

TensorFlow Deep-Learning-Framework-Modell-Inferenzpipeline für Porträtausschnitt-Inferenz

Mar 26, 2024 pm 01:00 PM

Übersicht Um ModelScope-Benutzern die schnelle und bequeme Nutzung verschiedener von der Plattform bereitgestellter Modelle zu ermöglichen, wird eine Reihe voll funktionsfähiger Python-Bibliotheken bereitgestellt, die die Implementierung offizieller ModelScope-Modelle sowie die erforderlichen Tools für die Verwendung dieser Modelle für Inferenzen umfassen , Feinabstimmung und andere Aufgaben im Zusammenhang mit der Datenvorverarbeitung, Nachverarbeitung, Effektbewertung und anderen Funktionen und bietet gleichzeitig eine einfache und benutzerfreundliche API und umfangreiche Anwendungsbeispiele. Durch den Aufruf der Bibliothek können Benutzer Aufgaben wie Modellinferenz, Schulung und Bewertung erledigen, indem sie nur wenige Codezeilen schreiben. Auf dieser Basis können sie auch schnell eine Sekundärentwicklung durchführen, um ihre eigenen innovativen Ideen zu verwirklichen. Das derzeit von der Bibliothek bereitgestellte Algorithmusmodell ist:

Bildrauschen mithilfe von Faltungs-Neuronalen Netzen

Jan 23, 2024 pm 11:48 PM

Bildrauschen mithilfe von Faltungs-Neuronalen Netzen

Jan 23, 2024 pm 11:48 PM

Faltungs-Neuronale Netze eignen sich gut für Aufgaben zur Bildrauschunterdrückung. Es nutzt die erlernten Filter, um das Rauschen zu filtern und so das Originalbild wiederherzustellen. In diesem Artikel wird die Methode zur Bildentrauschung basierend auf einem Faltungs-Neuronalen Netzwerk ausführlich vorgestellt. 1. Überblick über das Convolutional Neural Network Das Convolutional Neural Network ist ein Deep-Learning-Algorithmus, der eine Kombination aus mehreren Faltungsschichten, Pooling-Schichten und vollständig verbundenen Schichten verwendet, um Bildmerkmale zu lernen und zu klassifizieren. In der Faltungsschicht werden die lokalen Merkmale des Bildes durch Faltungsoperationen extrahiert und so die räumliche Korrelation im Bild erfasst. Die Pooling-Schicht reduziert den Rechenaufwand durch Reduzierung der Feature-Dimension und behält die Hauptfeatures bei. Die vollständig verbundene Schicht ist für die Zuordnung erlernter Merkmale und Beschriftungen zur Implementierung der Bildklassifizierung oder anderer Aufgaben verantwortlich. Das Design dieser Netzwerkstruktur macht das Faltungs-Neuronale Netzwerk für die Bildverarbeitung und -erkennung nützlich.