Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

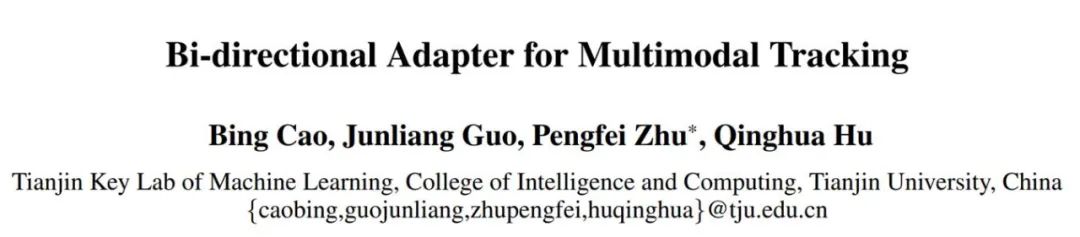

BAT-Methode: AAAI 2024s erster multimodaler universeller bidirektionaler Zielverfolgungsadapter

BAT-Methode: AAAI 2024s erster multimodaler universeller bidirektionaler Zielverfolgungsadapter

BAT-Methode: AAAI 2024s erster multimodaler universeller bidirektionaler Zielverfolgungsadapter

Jan 24, 2024 pm 03:33 PMObjektverfolgung ist eine der grundlegenden Aufgaben der Computer Vision. In den letzten Jahren hat die Objektverfolgung mit Einzelmodalität (RGB) erhebliche Fortschritte gemacht. Aufgrund der Einschränkungen eines einzelnen Bildsensors müssen wir jedoch multimodale Bilder (wie RGB, Infrarot usw.) einführen, um diesen Mangel auszugleichen und eine Zielverfolgung bei jedem Wetter in komplexen Umgebungen zu erreichen. Die Anwendung solcher multimodaler Bilder kann umfassendere Informationen liefern und die Genauigkeit und Robustheit der Zielerkennung und -verfolgung verbessern. Die Entwicklung der multimodalen Zielverfolgung ist von großer Bedeutung für die Realisierung übergeordneter Computer-Vision-Anwendungen.

Bestehende multimodale Verfolgungsaufgaben stehen jedoch auch vor zwei großen Problemen:

- Aufgrund der hohen Kosten für die Datenannotation für die multimodale Zielverfolgung sind die meisten vorhandenen Datensätze nur begrenzt skalierbar und nicht ausreichend für die Unterstützung Erstellen Sie einen effektiven multimodalen Tracker.

- Da unterschiedliche Bildgebungsmethoden unterschiedliche Empfindlichkeiten gegenüber Objekten in sich ändernden Umgebungen aufweisen, ändert sich die vorherrschende Modalität in der offenen Welt dynamisch und die vorherrschende Korrelation zwischen multimodalen Daten und Geschlecht ist nicht festgelegt.

Viele multimodale Tracking-Bemühungen, die RGB-Sequenzen vorab trainieren und dann vollständig auf multimodale Szenen abstimmen, haben Zeit- und Effizienzprobleme sowie eine begrenzte Leistung.

Neben der vollständigen Feinabstimmungsmethode ist es auch von effizienten Feinabstimmungsmethoden für Parameter im Bereich der Verarbeitung natürlicher Sprache (NLP) inspiriert. Einige neuere Methoden haben eine Parameter-effiziente Prompt-Feinabstimmung in der multimodalen Verfolgung eingeführt. Diese Methoden tun dies, indem sie die Parameter des Backbone-Netzwerks einfrieren und einen zusätzlichen Satz lernbarer Parameter hinzufügen.

Normalerweise konzentrieren sich diese Methoden auf eine Modalität (normalerweise RGB) als primäre Modalität und die andere Modalität als Hilfsmodalität. Diese Methode ignoriert jedoch die dynamische Korrelation zwischen multimodalen Daten und kann daher die komplementären Effekte multimodaler Informationen in komplexen Szenen nicht vollständig nutzen, wodurch die Trackingleistung eingeschränkt wird.

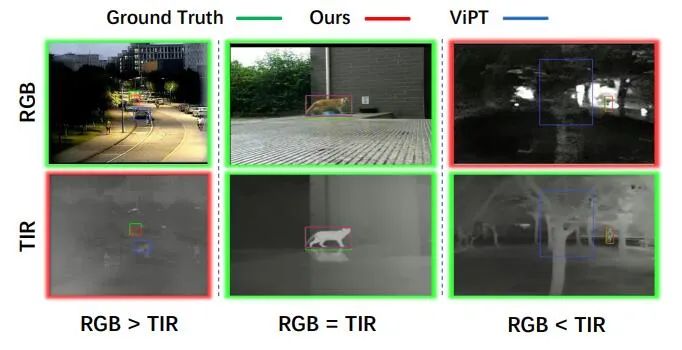

Bild 1: Verschiedene dominante Modi in komplexen Szenarien.

Um die oben genannten Probleme zu lösen, schlugen Forscher der Universität Tianjin eine Lösung namens Bidirektionaler Adapter für multimodales Tracking (BAT) vor. Im Gegensatz zu herkömmlichen Methoden basiert die BAT-Methode nicht auf einem festen dominanten Modus und einem Hilfsmodus, sondern erzielt durch den Prozess der dynamischen Extraktion effektiver Informationen eine bessere Leistung beim Wechsel vom Hilfsmodus in den dominanten Modus. Die Innovation dieser Methode besteht darin, dass sie sich an unterschiedliche Dateneigenschaften und Aufgabenanforderungen anpassen kann und dadurch die Darstellungsfähigkeit des Basismodells in nachgelagerten Aufgaben verbessert. Durch den Einsatz der BAT-Methode hoffen die Forscher, eine flexiblere und effizientere multimodale Tracking-Lösung bereitzustellen, die bessere Ergebnisse für Forschung und Anwendungen in verwandten Bereichen bringt.

BAT besteht aus zwei Basismodell-Encodern mit gemeinsamen Parametern speziell für Modalzweige und einem allgemeinen bidirektionalen Adapter. Während des Trainingsprozesses hat BAT das Grundmodell nicht vollständig verfeinert, sondern eine schrittweise Trainingsmethode übernommen. Jeder spezifische Modalitätszweig wird unter Verwendung des Basismodells mit festen Parametern initialisiert und nur die neu hinzugefügten bidirektionalen Adapter werden trainiert. Jeder Modalzweig lernt Hinweisinformationen von anderen Modalitäten und kombiniert sie mit den Merkmalsinformationen der aktuellen Modalität, um die Darstellungsmöglichkeiten zu verbessern. Zwei modalitätsspezifische Zweige interagieren über einen universellen bidirektionalen Adapter, um dominante und zusätzliche Informationen dynamisch miteinander zu verschmelzen und sich so an das Paradigma der multimodalen, nicht festen Assoziation anzupassen. Dieses Design ermöglicht es BAT, den Inhalt zu verfeinern, ohne die Bedeutung des ursprünglichen Inhalts zu ändern, wodurch die Darstellungsfähigkeit und Anpassungsfähigkeit des Modells verbessert wird.

Der universelle bidirektionale Adapter verfügt über eine leichte Sanduhrstruktur und kann in jede Schicht des Transformator-Encoders des Basismodells eingebettet werden, um die Einführung einer großen Anzahl lernbarer Parameter zu vermeiden. Durch das Hinzufügen nur einer kleinen Anzahl von Trainingsparametern (0,32 Millionen) verursacht der universelle bidirektionale Adapter geringere Trainingskosten und erreicht eine bessere Tracking-Leistung im Vergleich zu vollständig fein abgestimmten Methoden und auf Cue-Learning basierenden Methoden.

Papier „Bidirektionaler Adapter für multimodales Tracking“:

Papier-Link: https://arxiv.org/abs/2312.10611

Code-Link: https://github .com/SparkTempest/BAT

Hauptbeiträge

- Wir haben zunächst ein adaptorbasiertes, multimodales Tracking-Framework für visuelle Hinweise vorgeschlagen. Unser Modell ist in der Lage, die dynamischen Veränderungen dominanter Modalitäten in offenen Szenen wahrzunehmen und multimodale Informationen auf adaptive Weise effektiv zu verschmelzen.

- Nach unserem besten Wissen schlagen wir erstmals einen universellen bidirektionalen Adapter für das Basismodell vor. Es verfügt über eine einfache und effiziente Struktur und kann eine multimodale Cross-Cue-Verfolgung effektiv realisieren. Durch das Hinzufügen von nur 0,32 Millionen lernbaren Parametern ist unser Modell robust gegenüber multimodaler Verfolgung in offenen Szenarien.

- Wir haben eine eingehende Analyse der Auswirkungen unseres Universaladapters bei verschiedenen Schichttiefen durchgeführt. Wir erforschen in Experimenten auch eine effizientere Adapterarchitektur und überprüfen unsere Vorteile anhand mehrerer RGBT-Tracking-bezogener Datensätze.

Kernmethode

Wie in Abbildung 2 gezeigt, schlagen wir ein multimodales Tracking-Visual-Cue-Framework (BAT) vor, das auf einem bidirektionalen Adapter basiert. Das Framework verfügt über einen Dual-Stream-Encoder mit RGB-Modalität und thermischem Infrarot Modalitätsstruktur verwendet jeder Stream die gleichen zugrunde liegenden Modellparameter. Der bidirektionale Adapter wird parallel zur Dual-Stream-Encoderschicht eingerichtet, um multimodale Daten aus den beiden Modalitäten zu kreuzen. Die

-Methode führt keine vollständige Feinabstimmung des Grundmodells durch, sondern lernt nur einen leichten bidirektionalen Adapter, um den vorab trainierten RGB-Tracker effizient auf multimodale Szenen zu übertragen und so eine hervorragende multimodale Komplementarität und hervorragende Tracking-Genauigkeit zu erreichen.

Abbildung 2: Gesamtarchitektur von BAT.

Konvertieren Sie zunächst den  Vorlagenrahmen (den Anfangsrahmen des Zielobjekts im ersten Rahmen

Vorlagenrahmen (den Anfangsrahmen des Zielobjekts im ersten Rahmen ) und den

) und den  Suchrahmen (späteres Tracking-Bild) jeder Modalität in

Suchrahmen (späteres Tracking-Bild) jeder Modalität in  , Sie werden zusammengefügt und jeweils an den N-Layer-Dual-Stream-Transformator-Encoder weitergeleitet.

, Sie werden zusammengefügt und jeweils an den N-Layer-Dual-Stream-Transformator-Encoder weitergeleitet.

Der bidirektionale Adapter wird parallel zur Dual-Stream-Encoderschicht eingerichtet, um Funktionshinweise von einer Modalität zur anderen zu lernen. Zu diesem Zweck werden die Ausgabemerkmale der beiden Zweige addiert und in den Vorhersagekopf H eingegeben, um das endgültige Tracking-Ergebnisfeld B zu erhalten.

Der bidirektionale Adapter ist modular aufgebaut und in die Multi-Head-Selbstaufmerksamkeitsstufe bzw. die MLP-Stufe eingebettet. Die detaillierte Struktur des bidirektionalen Adapters ist auf der rechten Seite von Abbildung 1 dargestellt dient dazu, Funktionshinweise von einem Modell in einen anderen Modus zu übertragen. Es besteht aus drei linearen Projektionsschichten. tn stellt die Anzahl der Token in jeder Modalität dar. Der Eingabetoken wird zunächst durch Abwärtsprojektion auf de reduziert und durchläuft eine lineare Projektionsschicht. Anschließend wird er auf die ursprüngliche Dimension dt nach oben projiziert und zurückgekoppelt als Feature-Prompt-Transformer-Encoder-Ebenen für andere Modalitäten.

Durch diese einfache Struktur kann der bidirektionale Adapter Funktionsaufforderungen zwischen  Modi effektiv durchführen, um eine multimodale Verfolgung zu erreichen.

Modi effektiv durchführen, um eine multimodale Verfolgung zu erreichen.

Da der Transformator-Encoder und der Vorhersagekopf eingefroren sind, müssen nur die Parameter des neu hinzugefügten Adapters optimiert werden. Insbesondere fungiert unser bidirektionaler Adapter im Gegensatz zu den meisten herkömmlichen Adaptern als modalübergreifender Funktionshinweis für die dynamische Änderung dominanter Modalitäten und gewährleistet so eine gute Tracking-Leistung in der offenen Welt.

Experimentelle Ergebnisse

Wie in Tabelle 1 gezeigt, zeigt der Vergleich der beiden Datensätze von RGBT234 und LasHeR, dass unsere Methode sowohl hinsichtlich der Genauigkeit als auch der Erfolgsquote den modernsten Methoden überlegen ist. Wie in Abbildung 3 dargestellt, zeigt der Leistungsvergleich mit modernsten Methoden unter verschiedenen Szeneneigenschaften des LasHeR-Datensatzes auch die Überlegenheit der vorgeschlagenen Methode.

Diese Experimente beweisen voll und ganz, dass unser Dual-Stream-Tracking-Framework und unser bidirektionaler Adapter Ziele in den komplexesten Umgebungen erfolgreich verfolgen und effektiv Informationen aus sich dynamisch ändernden Dominant-Auxiliary-Modi extrahieren können, um die besten Ergebnisse zu erzielen.

Tabelle 1 Gesamtleistung bei RGBT234- und LasHeR-Datensätzen.

Abbildung 3 Vergleich von BVT und konkurrierenden Methoden unter verschiedenen Attributen im LasHeR-Datensatz.

Experimente beweisen unsere Wirksamkeit bei der dynamischen Herbeiführung wirksamer Informationen aus sich ändernden Dominant-Hilfs-Mustern in komplexen Szenarien. Wie in Abbildung 4 gezeigt, kann unsere Methode im Vergleich zu verwandten Methoden, die den dominanten Modus festlegen, das Ziel auch dann effektiv verfolgen, wenn RGB überhaupt nicht verfügbar ist. Wenn sowohl RGB als auch TIR effektive Informationen in nachfolgenden Szenen liefern können, ist der Tracking-Effekt viel besser . Unser bidirektionaler Adapter extrahiert dynamisch effektive Merkmale des Ziels sowohl aus RGB- als auch IR-Modalitäten, erfasst genauere Zielreaktionsorte und eliminiert Störungen durch die RGB-Modalität.

Abbildung 4 Visualisierung der Tracking-Ergebnisse.

Wir evaluieren unsere Methode auch anhand des RGBE-Tracking-Datensatzes. Wie in Abbildung 5 dargestellt, liefert unsere Methode im Vergleich zu anderen Methoden des VisEvent-Testsatzes die genauesten Tracking-Ergebnisse in verschiedenen komplexen Szenarien, was die Wirksamkeit und Verallgemeinerung unseres BAT-Modells beweist.

Abbildung 5 Tracking-Ergebnisse unter dem VisEvent-Datensatz.

Abbildung 6 Aufmerksamkeitsgewichtsvisualisierung.

Wir visualisieren die Aufmerksamkeitsgewichte verschiedener Ebenen, die Ziele verfolgen, in Abbildung 6. Im Vergleich zur Baseline-Dual-Methode (Dual-Stream-Framework für die Initialisierung grundlegender Modellparameter) treibt unser BAT den Hilfsmodus effektiv an, um mehr komplementäre Informationen aus dem dominanten Modus zu lernen, während die Wirksamkeit des dominanten Modus mit zunehmender Netzwerktiefe erhalten bleibt. Leistung und verbessert so die Gesamtleistung des Trackings.

Experimente zeigen, dass BAT erfolgreich multimodale Komplementärinformationen erfasst und eine probenadaptive dynamische Verfolgung ermöglicht.

Das obige ist der detaillierte Inhalt vonBAT-Methode: AAAI 2024s erster multimodaler universeller bidirektionaler Zielverfolgungsadapter. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heißer Artikel

Hot-Tools-Tags

Heißer Artikel

Heiße Artikel -Tags

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

Deepseek Web Version Offizieller Eingang

Mar 12, 2025 pm 01:42 PM

Deepseek Web Version Offizieller Eingang

Mar 12, 2025 pm 01:42 PM

Deepseek Web Version Offizieller Eingang

Eingehende Suche in Deepseek Offizieller Website Eingang

Mar 12, 2025 pm 01:33 PM

Eingehende Suche in Deepseek Offizieller Website Eingang

Mar 12, 2025 pm 01:33 PM

Eingehende Suche in Deepseek Offizieller Website Eingang

So lösen Sie das Problem vielbeschäftigter Server für Deepseek

Mar 12, 2025 pm 01:39 PM

So lösen Sie das Problem vielbeschäftigter Server für Deepseek

Mar 12, 2025 pm 01:39 PM

So lösen Sie das Problem vielbeschäftigter Server für Deepseek

Ein weiteres nationales Produkt aus Baidu ist mit Deepseek verbunden.

Mar 12, 2025 pm 01:48 PM

Ein weiteres nationales Produkt aus Baidu ist mit Deepseek verbunden.

Mar 12, 2025 pm 01:48 PM

Ein weiteres nationales Produkt aus Baidu ist mit Deepseek verbunden.

Top 10 für Crypto Digital Asset Trading App (2025 Global Ranking) empfohlen

Mar 18, 2025 pm 12:15 PM

Top 10 für Crypto Digital Asset Trading App (2025 Global Ranking) empfohlen

Mar 18, 2025 pm 12:15 PM

Top 10 für Crypto Digital Asset Trading App (2025 Global Ranking) empfohlen

Top 10 Cryptocurrency -Handelsplattformen, Top Ten empfohlene Apps für Währungshandelsplattformen

Mar 17, 2025 pm 06:03 PM

Top 10 Cryptocurrency -Handelsplattformen, Top Ten empfohlene Apps für Währungshandelsplattformen

Mar 17, 2025 pm 06:03 PM

Top 10 Cryptocurrency -Handelsplattformen, Top Ten empfohlene Apps für Währungshandelsplattformen

Nubia Flip 2 wird gestartet: Tiefe integrieren Sie das Deepseek Big Model, das ab 3.399 Yuan abgebildet ist

Mar 12, 2025 pm 01:21 PM

Nubia Flip 2 wird gestartet: Tiefe integrieren Sie das Deepseek Big Model, das ab 3.399 Yuan abgebildet ist

Mar 12, 2025 pm 01:21 PM

Nubia Flip 2 wird gestartet: Tiefe integrieren Sie das Deepseek Big Model, das ab 3.399 Yuan abgebildet ist

Was sind die sicheren und zuverlässigen digitalen Währungsplattformen?

Mar 17, 2025 pm 05:42 PM

Was sind die sicheren und zuverlässigen digitalen Währungsplattformen?

Mar 17, 2025 pm 05:42 PM

Was sind die sicheren und zuverlässigen digitalen Währungsplattformen?